0-Primeras

12/5/05

17:09

Página iii

Sistemas operativos

Aspectos internos y principios de diseño

Quinta Edición

WILLIAM STALLINGS

Traducción y revisión técnica

José María Peña Sánchez

Fernando Pérez Costoya

María de los Santos Pérez Hernández

Víctor Robles Forcada

Francisco Javier Rosales García

Departamento de Arquitectura y Tecnología de Sistemas Informáticos

Facultad de Informática

Universidad Politécnica de Madrid

Madrid • México • Santafé de Bogotá • Buenos Aires • Caracas • Lima

Montevideo • San Juan • San José • Santiago • Sâo Paulo • White Plains

0-Primeras

12/5/05

17:09

Página iv

Datos de catalogación bibliográfica

SISTEMAS OPERATIVOS

William Stallings

Pearson Educación, S.A., Madrid, 2005

ISBN: 978-84-205-5796-0

Materia: Informática 681.3

Formato: 195 x 250 mm.

Páginas: 872

Todos los derechos reservados.

Queda prohibida, salvo excepción prevista en la Ley, cualquier forma

de reproducción, distribución, comunicación pública y transformación

de esta obra sin contar con autorización de los titulares de propiedad

intelectual. La infracción de los derechos mencionados puede ser

constitutiva de delito contra la propiedad intelectual

(arts. 270 y sgts. Código Penal).

DERECHOS RESERVADOS

© 2005 respecto a la primera edición en castellano por:

PEARSON EDUCACIÓN, S.A.

C/ Ribera del Loira, 28

28042 Madrid (España)

SISTEMAS OPERATIVOS

William Stallings

ISBN: 84-205-4462-0

Depósito Legal:

PEARSON PRENTICE HALL es un sello editorial autorizado de PEARSON EDUCACIÓN S.A.

Authorized translation from the English language edition, entitled OPERATING SYSTEMS, 5th

Edition by STALLINGS, WILLIAM, published by Peason Education, Inc, publishing as Prentice

Hall, Copyright© 2005.

ISBN: 0-13-147954-7

All rights reserved. No part of this book may be reproduced or transmitted in any from or by any

means, elecronic or mechanical, including photocopying, recording or by any information

storage retrieval system, without permission from Pearson Education, Inc.

Equipo editorial

Editor: Miguel Martín-Romo

Técnico editorial: Marta Caicoya

Equipo de producción

Director: José A. Clares

Técnico: Isabel Muñoz

Diseño de cubierta

Equipo de diseño de Pearson Educación, S.A.

Impreso por

IMPRESO EN ESPAÑA - PRINTED IN SPAIN

Este libro ha sido impreso con papel y tintas ecológicos

0-Primeras

vi

12/5/05

17:09

Página vi

Contenido

PÁGINA WEB PARA SISTEMAS OPERATIVOS:

ASPECTOS INTERNOS Y PRINCIPIOS DE DISEÑO,

QUINTA EDICIÓN

La página web en WilliamStallings.com/OS/OS5e.html proporciona apoyo a profesores y estudiantes

que utilicen este libro. Incluye los siguientes elementos.

MATERIAL PARA APOYO DE CURSOS

El material para apoyo de los cursos incluye:

• Copia de las figuras del libro en formato PDF.

• Copia de las tablas del libro en formato PDF.

• Un conjunto de transparencias PowerPoint para utilizarlas como ayuda en clase.

• Notas de clase en HTML que pueden servir como material de ayuda para el estudio.

• Página de Recursos del Estudiante de Informática (Computer Science Student Resource

Site): contienen gran número de enlaces y documentos que los estudiantes pueden encontrar útiles para su formación en informática. Esta página incluye una revisión de las matemáticas básicas relacionadas; consejos para la búsqueda de información, redacción, y realización de problemas en casa; enlaces a repositorios de información de informática, tales como informes y

bibliografías; y otros enlaces de interés.

• Una hoja de erratas del libro, actualizada casi mensualmente.

DOCUMENTOS COMPLEMENTARIOS

Los documentos complementarios incluyen:

• Una copia en PDF de todos los algoritmos del libro en un pseudo-código de tipo Pascal de fácil

lectura.

• Material del libro relativo a Windows, UNIX, y Linux; reproducido en tres documentos PDF de

fácil referencia.

• Varios documentos que amplían lo tratado en el libro. Incluye aspectos relativos a la complejidad de los algoritmos, estándares de Internet y Sockets.

CURSOS DE SISTEMAS OPERATIVOS

La página web de OS5e incluye enlaces a otras páginas de cursos impartidos usando este libro. Estas

páginas pueden proporcionar guías útiles sobre cómo planificar y ordenar los temas tratados, así como

un gran número de anotaciones y material diverso.

0-Primeras

12/5/05

17:09

Página vii

Contenido

vii

PÁGINAS WEB ÚTILES

La página web de OS5e incluye también enlaces a otras páginas de interés. Los enlaces cubren un amplio espectro de temas y permitirán a los estudiantes explorar aspectos concretos con gran profundidad.

LISTA DE CORREO ELECTRÓNICO

Se mantiene una lista de correo para que los profesores que utilicen este libro puedan intercambiar información, sugerencias, y preguntas entre ellos y con el autor. La información de suscripción se proporciona

en la página web del libro.

PROYECTOS DE SISTEMAS OPERATIVOS

La página web incluye enlaces a las páginas de Nachos y BACI, que son dos paquetes software que sirven como entornos para implementación de proyectos. Cada página incluye software para descargar

con información de apoyo. Véase el Apéndice C para más información.

0-Primeras

12/5/05

17:09

Página ix

Contenido

ix

Contenido

Prólogo

Capítulo 0

0.1

0.2

0.3

xvii

Guía del lector

1

Organización del libro 2

Orden de presentación de los temas 3

Recursos en Internet y en la Web 4

PRIMERA PARTE: ANTECECENTES

Capítulo 1

1.1

1.2

1.3

1.4

1.5

1.6

1.7

1.8

1.9

Capítulo 2

2.1

2.2

2.3

2.4

2.5

2.6

2.7

2.8

2.9

2.10

7

Introducción a los computadores

9

Elementos básicos 10

Registros del procesador 11

Ejecución de instrucciones 14

Interrupciones 17

La jerarquía de memoria 27

Memoria cache 30

Técnicas de comunicación de E/S 34

Lecturas y sitios web recomendados 37

Términos clave, cuestiones de repaso y problemas 38

Apéndice 1A Características de rendimiento de las memorias de dos niveles

Apéndice 1B Control de procedimientos 48

Introducción a los sistemas operativos

53

Objetivos y funciones de los sistemas operativos 54

La evolución de los sistemas operativos 58

Principales logros 67

Desarrollos que han llevado a los sistemas operativos modernos

Descripción global de Microsoft Windows 82

Sistemas UNIX tradicionales 91

Sistemas UNIX modernos 94

Linux 95

Lecturas y sitios web recomendados 101

Términos clave, cuestiones de repaso y problemas 103

79

41

0-Primeras

x

12/5/05

17:09

Página x

Contenido

SEGUNDA PARTE: PROCESOS

Capítulo 3

3.1

3.2

3.3

3.4

3.5

3.6

3.7

3.8

105

Descripción y control de procesos

107

¿Qué es un proceso? 108

Estados de procesos 110

Descripción de los procesos 126

Control de procesos 135

Gestión de procesos en UNIX SVR4 143

Resumen 149

Lecturas recomendadas 149

Términos clave, cuestiones de repaso y problemas

150

Proyecto de programación uno. Desarrollo de un intérprete de mandatos

Capítulo 4

4.1

4.2

4.3

4.4

4.5

4.6

4.7

4.8

4.9

Capítulo 5

5.1

5.2

5.3

5.4

5.5

5.6

5.7

5.8

5.9

Capítulo 6

6.1

6.2

Hilos, SMP y micronúcleos

154

157

Procesos e hilos 158

Multiprocesamiento simétrico 172

Micronúcleos 176

Gestión de hilos y SMP en Windows 181

Gestión de hilos y SMP en Solaris 187

Gestión de procesos e hilos en Linux 193

Resumen 196

Lecturas recomendadas 196

Términos clave, cuestiones de repaso y problemas

Concurrencia. Exclusión mutua y sincronización

Principios de la concurrencia 203

Exclusión mutua: soporte hardware 212

Semáforos 215

Monitores 229

Paso de mensajes 235

El problema de los Lectores/Escritores 241

Resumen 245

Lecturas recomendadas 247

Términos clave, cuestiones de repaso y problemas

Concurrencia. Interbloqueo e inanición

Fundamentos del interbloqueo 258

Prevención del interbloqueo 267

257

197

201

248

0-Primeras

12/5/05

17:09

Página xi

Contenido

6.3

6.4

6.5

6.6

6.7

6.8

6.9

6.10

6.11

6.12

6.13

Predicción del interbloqueo 269

Detección del interbloqueo 273

Una estrategia integrada de tratamiento del interbloqueo 277

El problema de los filósofos comensales 277

Mecanismos de concurrencia de UNIX 280

Mecanismos de concurrencia del núcleo de Linux 284

Funciones de sincronización de hilos de Solaris 291

Mecanismos de concurrencia de Windows 294

Resumen 296

Lecturas recomendadas 297

Términos clave, cuestiones de repaso y problemas 297

TERCERA PARTE: MEMORIA

Capítulo 7

7.1

7.2

7.3

7.4

7.5

7.6

7.7

Capítulo 8

8.1

8.2

8.3

8.4

8.5

8.6

8.7

8.8

305

Gestión de memoria

Requisitos de gestión de memoria 308

Particionamiento de la memoria 311

Paginación 321

Segmentación 325

Resumen 327

Lecturas recomendadas 327

Términos clave, cuestiones de repaso y problemas

Apéndice 7A Carga y enlace 331

Memoria virtual

9.1

9.2

328

339

Hardware y estructuras de control 340

Software del sistema operativo 358

Gestión de memoria de UNIX y Solaris 378

Gestión de memoria en Linux 384

Gestión de memoria en Windows 386

Resumen 388

Lectura recomendada y páginas web 389

Términos clave, cuestiones de repaso y problemas

Apéndice 8A Tablas Hash

395

CUARTA PARTE: PLANIFICACIÓN

Capítulo 9

307

399

Planificación uniprocesador

401

Tipos de planificación del procesador

Algoritmos de planificación 406

402

390

xi

0-Primeras

xii

12/5/05

17:09

Página xii

Contenido

9.3

9.4

9.5

9.6

Planificación UNIX tradicional 427

Resumen 429

Lecturas recomendadas 431

Términos clave, cuestiones de repaso y problemas

Apéndice 9A Tiempo de respuesta 436

Apéndice 9B Sistemas de colas 438

Proyecto de programación dos. El planificador de HOST

431

444

Capítulo 10

Planificación multiprocesador y de tiempo real

451

10.1

10.2

10.3

10.4

10.5

10.6

10.7

10.8

Planificación multiprocesador 452

Planificación de tiempo real 463

Planificación en Linux 477

Planificación en UNIX SVR4 480

Planificación en Windows 482

Resumen 484

Lecturas recomendadas 485

Términos clave, cuestiones de repaso y problemas

485

QUINTA PARTE: ENTRADA/SALIDA Y FICHEROS

Capítulo 11

11.1

11.2

11.3

11.4

11.5

11.6

11.7

11.8

11.9

11.10

11.11

11.12

11.13

Capítulo 12

12.1

12.2

489

Gestión de la E/S y planificación del disco

491

Dispositivos de E/S 492

Organización del sistema de E/S 493

Aspectos de diseño del sistema operativo 496

Utilización de buffers de E/S 500

Planificación del disco 503

RAID

511

Cache de disco 520

E/S de UNIX SVR4 522

E/S de Linux 527

E/S de Windows 530

Resumen 532

Lecturas y sitios web recomendados 532

Términos clave, cuestiones de repaso y problemas 534

Apéndice 11A Dispositivos de almacenamiento en disco

Gestión de ficheros

547

Descripción básica 548

Organización y acceso a los ficheros

553

537

0-Primeras

12/5/05

17:09

Página xiii

Contenido

12.3

12.4

12.5

12.6

12.7

12.8

12.9

12.10

12.11

12.12

Directorios 559

Compartición de ficheros 563

Bloques y registros 564

Gestión de almacenamiento secundario 566

Gestión de ficheros de UNIX 574

Sistema de ficheros virtual Linux 578

Sistema de ficheros de Windows 582

Resumen

587

Lecturas recomendadas 588

Términos clave, cuestiones de repaso y problemas

SEXTA PARTE: SISTEMAS DISTRIBUIDOS Y SECURIDAD

Capítulo 13

13.1

13.2

13.3

13.4

13.5

13.6

13.7

Capítulo 14

14.1

14.2

14.3

14.4

14.5

14.6

14.7

14.8

14.9

14.10

Capítulo 15

15.1

15.2

15.3

Redes

589

591

595

La necesidad de una arquitectura de protocolos 597

La arquitectura de protocolos TCP/IP 599

Sockets 605

Redes en Linux 609

Resumen 611

Lecturas y sitios web recomendados 611

Términos clave, cuestiones de repaso y problemas 612

Apéndice 13A El Protocolo simple de transferencia de ficheros

Procesamiento distribuido, cliente/servidor y clusters

Computación cliente/servidor 620

Paso de mensajes distribuido 630

Llamadas a procedimiento remoto 633

Clusters 636

Servidor Cluster de Windows 642

Sun Cluster

643

Clusters de Beowulf y Linux 646

Resumen 648

Lecturas recomendadas y sitios web

648

Términos clave, cuestiones de repaso y problemas

Gestión de procesos distribuidos

Migración de procesos 654

Estados globales distribuidos 660

Exclusión mutua distribuida 665

653

650

619

614

xiii

0-Primeras

xiv

12/5/05

17:09

Página xiv

Contenido

15.4

15.5

15.6

15.7

Capítulo 16

16.1

16.2

16.3

16.4

16.5

16.6

16.7

16.8

16.9

APÉNDICES

Apéndice A

A.1

A.2

A.3

A.4

Apéndice B

B.1

B.2

B.3

B.4

B.5

Apéndice C

C.1

C.2

C.3

C.4

C.5

Interbloqueo distribuido 675

Resumen 685

Lecturas recomendadas 685

Términos clave, cuestiones de repaso y problemas

Seguridad

686

689

Amenazas de seguridad 690

Protección 695

Intrusos 701

Software malicioso 713

Sistemas confiables 722

Seguridad en Windows 725

Resumen 731

Lecturas recomendadas y sitios web

732

Términos clave, cuestiones de repaso y problemas

Apéndice 16A Cifrado 736

733

743

Temas de concurrencia

743

Exclusión mutua. Técnicas de software 744

Condiciones de carrera y semáforos 748

El problema de la barbería 758

Problemas 763

Diseño orientado a objetos

765

Motivación 766

Conceptos de orientación a objetos 767

Beneficios del diseño orientado a objetos 771

CORBA

772

Lecturas y sitios web recomendados 775

Proyectos de programación y de sistemas operativos

Proyectos para la enseñanza de sistemas operativos

NACHOS 779

Proyectos de investigación 780

Proyectos de programación 780

Tareas de lectura y de análisis 781

778

777

0-Primeras

13/5/05

17:21

Página xv

Contenido

Apéndice D

OSP. Un entorno para proyectos de sistemas operativos

D.1

D.2

D.3

Introducción 784

Aspectos innovadores de OSP 785

Comparación con otras herramientas docentes de sistemas operativos

Apéndice E

BACI. El Sistema de programación concurrente de Ben-Ari

E.1

E.2

E.3

E.4

E.5

Introducción 790

BACI 790

Ejemplos de programas BACI 793

Proyectos BACI 797

Mejoras al Sistema BACI 800

Glosario

801

Referencias

811

Acrónimos

827

Índice

783

829

789

786

xv

0-Primeras

12/5/05

17:09

Página xvi

0-Primeras

12/5/05

17:09

Página xvii

Contenido

xvii

Prólogo

OBJETIVOS

Este libro se ocupa de los conceptos, la estructura y los mecanismos de los sistemas operativos. Su propósito es presentar, de la manera más clara y completa posible, la naturaleza y las características de los

sistemas operativos de hoy en día.

Esta tarea es un reto por varios motivos. En primer lugar, los computadores para los que se diseñan

los sistemas operativos presentan una enorme variedad. Esta diversidad incluye desde estaciones de

trabajo y computadores personales para un único usuario, pasando por sistemas compartidos de tamaño medio, hasta grandes sistemas mainframe y supercomputadores, así como máquinas especializadas

tales como los sistemas de tiempo real. La variedad no está sólo en la capacidad y la velocidad de las

máquinas, sino también en los requisitos de las aplicaciones y del sistema. En segundo lugar, el rápido

ritmo de cambios que ha caracterizado siempre a los sistemas informáticos continúa sin remitir. Diversas áreas fundamentales en el diseño de sistemas operativos son de reciente aparición, estando todavía

activa la investigación sobre las mismas, así como sobre otras nuevas áreas.

A pesar de esta variedad y de este ritmo de cambios incesante, ciertos conceptos fundamentales siguen siendo aplicables en todo momento. Evidentemente, su aplicación depende del estado actual de la

tecnología y de los requisitos particulares de la aplicación. El objetivo de este libro es proporcionar un

estudio profundo de los fundamentos del diseño de sistemas operativos y relacionarlos con aspectos de

diseño contemporáneos y con las tendencias actuales en el desarrollo de sistemas operativos.

SISTEMAS DE EJEMPLO

Este libro está destinado a dar a conocer al lector los principios de diseño y los aspectos de implementación de los sistemas operativos contemporáneos. Por consiguiente, un tratamiento puramente conceptual o teórico sería inadecuado. Para mostrar los conceptos y asociarlos a alternativas de diseño del

mundo real, se han seleccionado tres sistemas operativos como ejemplos reales:

• Windows XP y Windows 2003. Un sistema operativo multitarea para computadores personales, estaciones de trabajo y servidores. Al tratarse de un nuevo sistema operativo, incorpora de

una manera nítida muchos de los últimos desarrollos en la tecnología de sistemas operativos.

Además, Windows es uno de los primeros sistemas operativos comerciales importantes que está

estrechamente basado en principios de diseño orientado a objetos. Este libro se ocupa de la tecnología utilizada en las versiones más recientes de Windows, XP para estaciones de trabajo y computadores personales, y 2003 para servidores.

• UNIX. Un sistema operativo multiusuario, originalmente destinado a minicomputadores, pero

implementado en un amplio rango de máquinas desde poderosos microcomputadores a supercomputadores. Se incluyen dos versiones de UNIX. UNIX SVR4 es un sistema muy usado que

incorpora muchas características avanzadas. Solaris es la versión comercial más utilizada de

UNIX. Incluye procesamiento multihilo y otras características que no se encuentran en SVR4 ni

en la mayoría de las otras versiones de UNIX.

• Linux. Una versión de UNIX cuyo código fuente está disponible libremente, que es muy utilizada actualmente.

0-Primeras

12/5/05

xviii

17:09

Página xviii

Prólogo

Estos sistemas se seleccionaron por su relevancia y representatividad. El estudio de los sistemas de

ejemplo se distribuye a lo largo del texto en vez de agruparlos en un solo capítulo o apéndice. Así, durante el estudio de la concurrencia, se describen los mecanismos de concurrencia de cada sistema de ejemplo, y se explica la motivación de las diversas opciones de diseño individuales. Con este enfoque, los

conceptos de diseño estudiados en cualquier capítulo se refuerzan inmediatamente con ejemplos del

mundo real.

AUDIENCIA A LA QUE ESTÁ DESTINADO

Este libro está destinado tanto a una audiencia de carácter académico como a una de perfil profesional. Como libro de texto, está pensado para un curso de sistemas operativos de un semestre para las

titulaciones de Informática, Ingeniería de Computadores e Ingeniería Eléctrica. Incluye los temas recomendados por el Computer Curricula 2001 para programas universitarios de informática, realizado

por el equipo de trabajo conjunto para planes de estudio de informática (Joint Task Force on Computing Curricula) de la sociedad informática (Computer Society) de IEEE y ACM. El libro también trata los temas recomendados por Guidelines for Associate-Degree Curricula in Computer Science 2002,

también del equipo de trabajo conjunto para planes de estudio de informática de la sociedad informática de IEEE y ACM. El libro sirve igualmente como un volumen de referencia básico, adecuado para

el estudio personal.

ORGANIZACIÓN DEL LIBRO

Este libro se divide en seis partes (véase el Capítulo 0 para una visión general):

• Antecedentes.

• Procesos.

• Memoria.

• Planificación.

• Entrada/salida y ficheros.

• Sistemas distribuidos y seguridad.

Este libro incluye diversas características pedagógicas, como el uso de numerosas figuras y tablas

para facilitar el estudio. Cada capítulo incluye una lista de términos clave, preguntas de repaso, problemas,

propuestas de lecturas adicionales y direcciones de sitios web relevantes. Además, está disponible para

los profesores una batería de preguntas de test.

SERVICIOS DE INTERNET PARA PROFESORES Y ESTUDIANTES

Hay un sitio web asociado a este libro que proporciona apoyo a los estudiantes y a los profesores. El sitio incluye enlaces a otros sitios relevantes, copias originales de las transparencias de las figuras y tablas del libro en formato PDF (Adobe Acrobat), transparencias en PowerPoint e información para darse de alta en la lista de correo de Internet del libro. La página web está en

WilliamStallings.com/OS/OS5e.html. Véase la Sección “Sitio web de sistemas operativos. Aspectos internos y principios de diseño” anterior a este prólogo para más información. Se ha establecido una lista de correo para que los profesores que usan este libro puedan intercambiar información, sugerencias

y preguntas entre sí y con el propio autor. En cuanto se descubran errores tipográficos o de otro tipo, se

0-Primeras

12/5/05

17:09

Página xix

Prólogo

xix

publicará una lista de erratas en WilliamStallings.com. Por último, hay que resaltar que el autor mantiene un sitio para el estudiante de informática en WilliamStallings.com/StudentSupport.html.

PROYECTOS DE SISTEMAS OPERATIVOS

Para muchos instructores, un elemento importante de un curso de sistemas operativos es un proyecto o

un conjunto de proyectos mediante los cuales el estudiante obtiene una experiencia práctica que le permite reforzar los conceptos del libro. Este libro proporciona un incomparable grado de apoyo en ese aspecto, incluyendo un componente de proyectos en el curso. En el interior del libro se definen dos proyectos de programación principales. El sitio web del profesor ofrece referencias en línea que pueden utilizar

los estudiantes para abordar estos proyectos de forma gradual. Se proporciona información sobre tres

paquetes de software que sirven como entornos de trabajo para la implementación de proyectos: OSP

y NACHOS para desarrollar componentes de un sistema operativo, y BACI para estudiar los mecanismos de concurrencia. Además, el sitio web del profesor incluye una serie de pequeños proyectos de

programación, cada uno pensado para desarrollarse en una o dos semanas, que cubre un amplio rango

de temas y que pueden implementarse en cualquier lenguaje apropiado y sobre cualquier plataforma, así

como proyectos de investigación y tareas de lectura y análisis. Véase los apéndices para más detalles.

NOVEDADES DE LA QUINTA EDICIÓN

En esta nueva edición, el autor ha intentado recoger las innovaciones y mejoras que ha habido en esta disciplina durante los cuatro años que han transcurrido desde la última edición, manteniendo un tratamiento amplio y completo de esta materia. Asimismo, varios profesores que imparten esta disciplina, así como

profesionales que trabajan en este campo, han revisado en profundidad la cuarta edición. Como consecuencia de este proceso, en muchas partes del libro, se ha mejorado la claridad de la redacción y de las

ilustraciones que acompañan al texto. Además, se han incluido varios problemas de carácter realista.

Además de mejoras pedagógicas y en su presentación de cara al usuario, el contenido técnico del

libro se ha actualizado completamente, para reflejar los cambios actuales en esta excitante disciplina.

El estudio de Linux se ha extendido significativamente, basándose en su última versión: Linux 2.6. El

estudio de Windows se ha actualizado para incluir Windows XP y Windows Server 2003. Se ha revisado y extendido el material dedicado a la concurrencia para mejorar su claridad, moviendo parte del mismo a un apéndice, e incluyendo un estudio sobre condiciones de carrera. El tratamiento de la planificación en esta nueva versión incluye un estudio de la inversión de prioridades. Hay un nuevo capítulo

sobre redes, presentándose el API de Sockets. Además, se ha ampliado el tratamiento del diseño orientado a objetos.

AGRADECIMIENTOS

Esta nueva edición se ha beneficiado de la revisión realizada por diversas personas, que aportaron generosamente su tiempo y experiencia. Entre ellos se incluyen Stephen Murrell (Universidad de Miami),

David Krumme (Universidad de Tufts), Duncan Buell (Universidad de Carolina), Amit Jain (Universidad de Bosie State), Fred Kuhns (Universidad de Washington, St.Louis), Mark McCullen (Universidad

de Michigan State), Jayson Rock (Universidad de Wisconsin-Madison), David Middleton (Universidad

de Arkansas Technological) y Binhai Zhu (Universidad de Montana State), todos revisaron la mayor parte o todo el libro.

El autor da las gracias también a mucha gente que realizó revisiones detalladas de uno o más capítulos: Javier Eraso Helguera, Andrew Cheese, Robert Kaiser, Bhavin Ghandi, Joshua Cope, Luca Ve-

0-Primeras

xx

12/5/05

17:09

Página xx

Prólogo

nuti, Gregory Sharp, Marisa Gil, Balbir Singh, Mrugesh Gajjar, Bruce Janson, Mayan Moudgill, Pete

Bixby, Sonja Tideman, Siddharth Choudhuri, Zhihui Zhang, Andrew Huo Zhigang, Yibing Wang, Darío Álvarez y Michael Tsai. Asimismo, al autor le gustaría agradecer a Tigran Aivazian, autor del documento sobre los aspectos internos del núcleo de Linux (Linux Kernel Internals), que es parte del proyecto de documentación de Linux (Linux Documentation Project), por su revisión del material sobre Linux

2.6. Ching-Kuang Shene (Universidad de Michigan Tech) proporcionó los ejemplos usados en la sección sobre condiciones de carrera y revisó dicha sección.

Asimismo, Fernando Ariel Gont contribuyó con diversos ejercicios para el estudiante y llevó a cabo

revisiones detalladas de todos los capítulos.

El autor querría también dar las gracias a Michael Kifer y Scott A. Smolka (SUNY–Stony Brook)

por contribuir al Apéndice D, a Bill Bynum (College of William and Mary) y Tracy Camp (Colorado

School of Mines) por prestar su ayuda en el Apéndice E; Steve Taylor (Worcester Polytechnic Institute) por colaborar en los proyectos de programación y en las tareas de lectura y análisis del manual del

profesor, y al profesor Tan N. Nguyen (Universidad de George Mason) por contribuir a los proyectos

de investigación del manual del profesor. Ian G.Graham (Universidad de Griffith) colaboró con los dos

proyectos de programación del libro. Oskars Rieksts (Universidad de Kutztown) permitió de forma generosa que se hiciera uso de sus notas de clase, ejercicios y proyectos.

Por último, el autor querría dar las gracias a las numerosas personas responsables de la publicación

del libro, todas realizaron como de costumbre un excelente trabajo. Esto incluye al personal de Prentice Hall, particularmente a los editores Alan Apt y Toni Holm, su ayudante Patrick Lindner, la directora de producción Rose Kernan, y la directora de suplementos Sarah Parker. Este agradecimiento se extiende también a Jake Warde de Warde Publishers que dirigió el proceso de revisión, y a Patricia M. Daly

que realizó la edición de la copia.

00-Capitulo 0

12/5/05

16:15

Página 1

CAPÍTULO

0

Guía del lector

0.1.

Organización del libro

0.2.

Orden de presentación de los temas

0.3.

Recursos en Internet y en la Web

00-Capitulo 0

2

12/5/05

16:15

Página 2

Sistemas operativos. Aspectos internos y principios de diseño

◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆

Este libro, junto con su sitio web asociado, cubre una gran cantidad de material. A continuación, se

le proporciona al lector una visión general del mismo.

◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆

0.1. ORGANIZACIÓN DEL LIBRO

El libro está organizado en siete partes:

Primera parte. Antecedentes. Proporciona una introducción a la arquitectura y organización

del computador, haciendo énfasis en aquellos aspectos relacionados con el diseño de sistemas

operativos, presentando, asimismo, una visión general de los temas de sistemas operativos tratados en el resto del libro.

Segunda parte. Procesos. Presenta un análisis detallado de los procesos, el procesamiento

multihilo, el multiprocesamiento simétrico (Symmetric Multiprocessing, SMP) y los micronúcleos. En esta parte se estudian también los aspectos principales de la concurrencia en un sistema uniprocesador, haciendo hincapié en los temas de la exclusión mutua y de los interbloqueos.

Tercera parte. Memoria. Proporciona un extenso estudio de las técnicas de gestión de memoria, incluyendo la memoria virtual.

Cuarta parte. Planificación. Ofrece un estudio comparativo de diversas estrategias de planificación de procesos. Se examinará también la planificación de hilos, de SMP y de tiempo

real.

Quinta parte. Entrada/salida y ficheros. Examina los aspectos involucrados en el control de

las operaciones de E/S por parte del sistema operativo. Se dedica especial atención a la E/S del

disco, que es fundamental para el rendimiento del sistema. Asimismo, proporciona una visión

general de la gestión de ficheros.

Sexta parte. Sistemas distribuidos y seguridad. Estudia las principales tendencias en redes

de computadores, incluyendo TCP/IP, procesamiento cliente/servidor y clusters. Asimismo,

describe algunas áreas de diseño fundamentales en el desarrollo de los sistemas operativos distribuidos. El Capítulo 16 proporciona un estudio de las amenazas y los mecanismos para proporcionar seguridad al computador y a la red.

Este libro está dedicado a dar a conocer a los lectores los principios de diseño y los aspectos de

implementación de los sistemas operativos contemporáneos. Por tanto, sería inadecuado un tratamiento puramente teórico o conceptual. Para mostrar los conceptos y asociarlos a opciones de diseño que se deben tomar en la vida real, se han seleccionado dos sistemas operativos como ejemplos

reales:

• Windows. Un sistema operativo multitarea diseñado para ejecutar en diversos computadores

personales, estaciones de trabajo y servidores. Es uno de los pocos sistemas operativos comerciales recientes diseñado esencialmente desde cero. Debido a esto, está en una buena posición

para incorporar de una manera nítida los más recientes desarrollos en la tecnología de sistemas

operativos.

• UNIX. Un sistema operativo multitarea destinado originalmente a minicomputadores pero implementado en un amplio rango de máquinas desde poderosos microprocesadores a supercomputadores. Dentro de esta familia de sistemas operativos, se incluye Linux.

00-Capitulo 0

12/5/05

16:15

Página 3

Guía del lector

3

El estudio de los sistemas de ejemplo está distribuido a través del libro en vez de agrupado en un

único capítulo o apéndice. Así, durante el estudio de la concurrencia, se describe el mecanismo de

concurrencia de cada sistema de ejemplo y se discute la motivación de las opciones de diseño particulares. Con esta estrategia, los conceptos de diseño estudiados en un determinado capítulo son inmediatamente reforzados con los ejemplos del mundo real.

0.2. ORDEN DE PRESENTACIÓN DE LOS TEMAS

Sería natural que los lectores cuestionaran el orden particular de presentación de los temas en este libro. Por ejemplo, el tema de planificación (Capítulos 9 y 10) está muy relacionado con los dedicados

a la concurrencia (Capítulos 5 y 6) y el tema general de procesos (Capítulo 3), por lo que podría ser

razonable tratarlo inmediatamente después de estos temas.

La dificultad reside en que los diversos temas están estrechamente interrelacionados. Por ejemplo, para tratar la memoria virtual, es útil hacer referencia a los aspectos de planificación relacionados con un fallo de página. Por otro lado, también es útil referirse a algunos aspectos de gestión de

memoria cuando se estudian decisiones de planificación. Este tipo de ejemplo se puede repetir indefinidamente: El estudio de la planificación requiere algunos conocimientos de la gestión de E/S

y viceversa.

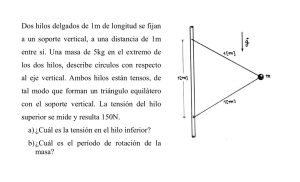

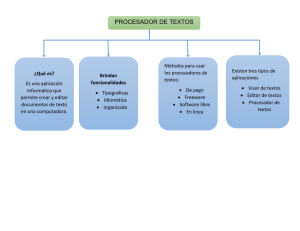

La Figura 0.1 sugiere algunas relaciones importantes entre los temas. Las líneas continuas indican relaciones muy estrechas, desde el punto de vista de las decisiones de diseño y de implementación. Basados en este diagrama, es razonable comenzar con una discusión básica de procesos, que corresponde con el Capítulo 3. Después de eso, el orden puede ser un poco arbitrario. Muchos tratados

de sistemas operativos reúnen todo el material sobre procesos al principio y después tratan otros te-

Descripción

y control

de procesos

Gestión

de memoria

Planificación

Concurrencia

Gestión de

ficheros

Gestión

de E/S

Redes

Seguridad

Figura 0.1.

Temas de sistemas operativos.

00-Capitulo 0

4

12/5/05

16:15

Página 4

Sistemas operativos. Aspectos internos y principios de diseño

mas. Esto es ciertamente válido. Sin embargo, la importancia fundamental de la gestión de memoria,

que en opinión del autor es tan importante como la gestión de procesos, ha llevado a la decisión de

presentar este tema antes de profundizar en la planificación.

La solución ideal es que el estudiante, después de completar los Capítulos del 1 al 3 en ese orden,

lea y asimile los capítulos siguientes en paralelo: el 4 seguido (opcionalmente) del 5; el 6 seguido por

el 7; el 8 seguido (opcionalmente) del 9; y el 10. Por último, se pueden estudiar los siguientes capítulos en cualquier orden: el 11; el 12 seguido del 13; el 14; y el 15. Sin embargo, aunque el cerebro humano puede llevar a cabo un procesamiento paralelo, al estudiante le resulta imposible (y caro) trabajar con éxito simultáneamente con cuatro copias del mismo libro abiertas en cuatro capítulos

diferentes. Dada la necesidad de un orden lineal, el autor considera que el orden utilizado en este libro es el más efectivo.

0.3. RECURSOS EN INTERNET Y EN LA WEB

Hay diversos recursos disponibles en Internet y en la Web para apoyar a este libro y ayudar al lector a

mantenerse al día con los avances en este campo.

SITIOS WEB DE ESTE LIBRO

Se ha creado una página web especial para este libro en WilliamStallings.com/OS/OS5e.html. Consulte el diagrama de dos páginas al principio de este libro para obtener una descripción detallada de este sitio web. De especial interés son los dos documentos disponibles en el sitio web para el estudiante:

• Pseudo-código. Para los lectores no acostumbrados al lenguaje C, se reproducen todos los algoritmos también en un pseudo-código similar al Pascal. Este lenguaje de pseudo-código es

intuitivo y particularmente fácil de seguir.

• Descripciones de Windows, UNIX y Linux. Como se ha mencionado previamente, se utilizan Windows y diversas versiones de UNIX como ejemplos de casos reales, estando este estudio distribuido a través del texto en vez de agrupado en un único capítulo o apéndice. Algunos

lectores preferirían tener todo este material en un único sitio para usarlo como referencia. Por

tanto, todo el material de Windows y UNIX del libro se reproduce en tres documentos en el sitio web.

En cuanto se detecte cualquier error tipográfico o de otro tipo, se publicará una lista de erratas de

este libro en el sitio web. Por favor, informe de cualquier error que detecte en el libro. En William

Stallings.com se encuentran las hojas de erratas de los otros libros publicados por el autor, así como

información sobre descuentos en pedidos de libros.

También se mantiene un sitio con recursos para el estudiante de informática (Computer Science

Student Resource Site), en WilliamStallings.com/StudentSupport.html; el objetivo de este sitio es

proporcionar documentos, información y enlaces para estudiantes de informática. Los enlaces se organizan en cuatro categorías:

• Matemáticas. Incluye un repaso sobre matemáticas básicas, una introducción al análisis de

colas y a los sistemas númericos, así como enlaces a numerosos sitios con información sobre

matemáticas.

• How-to. Aconseja y guía al estudiante para resolver sus ejercicios, escribir informes técnicos y

preparar presentaciones técnicas.

00-Capitulo 0

12/5/05

16:15

Página 5

Guía del lector

5

• Recursos de investigación. Proporciona enlaces a recopilaciones importantes de artículos, informes técnicos y referencias bibliográficas.

• Misceláneos. Incluye diversos documentos y enlaces útiles.

OTROS SITIOS WEB

Hay numerosos sitios web que proporcionan información relacionada con los temas tratados en este

libro. En los siguientes capítulos, pueden encontrarse referencias a sitios web específicos en la Sección «Lecturas recomendadas». Debido a que el URL de un sitio web particular puede cambiar, este

libro no incluye direcciones URL. En el sitio web de este libro puede encontrarse el enlace apropiado

de todos los sitios web nombrados en el libro.

GRUPOS DE NOTICIAS DE USENET

Diversos grupos de noticias de USENET se dedican a algún tema relacionado con los sistemas operativos o con un determinado sistema operativo. Como ocurre prácticamente con todos los grupos de

USENET, hay un alto porcentaje de ruido en la señal, pero es un experimento valioso comprobar si

alguno satisface las necesidades del lector. Los más relevantes son los siguientes:

• comp.os.research. El grupo que más interesa seguir. Se trata de un grupo de noticias moderado que se dedica a temas de investigación.

• comp.os.misc. Un foro de discusión general sobre temas de sistemas operativos.

• comp.unix.internals

• comp.os.linux.development.system

00-Capitulo 0

12/5/05

16:15

Página 6

01-Capitulo 1

16/5/05

17:03

Página 7

PA RT E

I

ANTECEDENTES

E

n esta primera parte se proporcionan los antecedentes necesarios y se establece el contexto

para el resto de este libro, presentando los conceptos fundamentales sobre arquitectura de computadores y sobre los aspectos internos de los sistemas operativos.

GUÍA DE LA PRIMERA PARTE

CAPÍTULO 1. INTRODUCCIÓN A LOS COMPUTADORES

Un sistema operativo hace de intermediario entre, por un lado, los programas de aplicación, las herramientas y los usuarios, y, por otro, el hardware del computador. Para apreciar cómo funciona el sistema operativo y los aspectos de diseño involucrados, se debe tener algún conocimiento de la organización y la arquitectura de los computadores. El Capítulo 1 proporciona un breve estudio del

procesador, la memoria y los elementos de E/S de un computador.

CAPÍTULO 2. INTRODUCCIÓN A LOS SISTEMAS OPERATIVOS

El tema del diseño de un sistema operativo (S.O.) abarca un enorme campo, resultando fácil enredarse en los detalles, perdiendo el contexto general durante el estudio de un tema en particular. El Capítulo 2 proporciona una visión general a la que el lector puede volver en cualquier punto del libro para

recuperar el contexto global. Se comienza con una exposición de los objetivos y funciones del sistema operativo. A continuación, por su relevancia histórica, se describen algunos sistemas y funciones

del S.O. Este estudio permite presentar algunos principios de diseño del S.O. fundamentales en un

entorno sencillo, de manera que queden claras las relaciones entre varias funciones del S.O. A continuación, el capítulo resalta las características más importantes de los sistemas operativos modernos.

A lo largo de este libro, cuando se presentan diversos temas, es necesario hablar tanto de principios

fundamentales y bien consolidados como de las más recientes innovaciones en el diseño de SS.OO.

El análisis de este capítulo hace notar al lector que se debe de abordar esta mezcla de técnicas de diseño ya consolidadas con otras recientes. Finalmente, se presenta una introducción de Windows y

UNIX; este estudio establece la arquitectura general de estos sistemas, proporcionando un contexto

para las discusiones detalladas que se realizan más adelante.

01-Capitulo 1

16/5/05

17:03

Página 8

01-Capitulo 1

16/5/05

17:03

Página 9

CAPÍTULO

1

Introducción a

los computadores

1.1.

Elementos básicos

1.2.

Registros del procesador

1.3.

Ejecución de instrucciones

1.4.

Interrupciones

1.5.

La jerarquía de memoria

1.6.

Memoria cache

1.7.

Técnicas de comunicación de E/S

1.8.

Lecturas y sitios web recomendados

1.9.

Términos clave, cuestiones de repaso y problemas

Apéndice 1A Características de rendimiento de las memorias de dos niveles

Apéndice 1B Control de procedimientos

01-Capitulo 1

10

16/5/05

17:03

Página 10

Sistemas operativos. Aspectos internos y principios de diseño

◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆

Un sistema operativo explota los recursos hardware de uno o más procesadores para proporcionar

un conjunto de servicios a los usuarios del sistema. El sistema operativo también gestiona la memoria secundaria y los dispositivos de E/S (entrada/salida) para sus usuarios. Por tanto, es importante

tener algunos conocimientos del hardware del computador subyacente antes de iniciar el estudio de

los sistemas operativos.

Este capítulo proporciona una visión general del hardware del computador. En la mayoría de las

áreas, el estudio es breve, asumiendo que el lector ya está familiarizado con este tema. Sin embargo, se estudiarán con cierto detalle varios aspectos por su repercusión en los temas tratados más

adelante en el libro.

◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆ ◆

1.1. ELEMENTOS BÁSICOS

A

l más alto nivel, un computador consta del procesador, la memoria y los componentes de E/S,

incluyendo uno o más módulos de cada tipo. Estos componentes se interconectan de manera

que se pueda lograr la función principal del computador, que es ejecutar programas. Por tanto,

hay cuatro elementos estructurales principales:

• Procesador. Controla el funcionamiento del computador y realiza sus funciones de procesamiento de datos. Cuando sólo hay un procesador, se denomina usualmente unidad central de

proceso (Central Processing Unit, CPU).

• Memoria principal. Almacena datos y programas. Esta memoria es habitualmente volátil; es

decir, cuando se apaga el computador, se pierde su contenido. En contraste, el contenido de la

memoria del disco se mantiene incluso cuando se apaga el computador. A la memoria principal se le denomina también memoria real o memoria primaria.

• Módulos de E/S. Transfieren los datos entre el computador y su entorno externo. El entorno

externo está formado por diversos dispositivos, incluyendo dispositivos de memoria secundaria (por ejemplo, discos), equipos de comunicaciones y terminales.

• Bus del sistema. Proporciona comunicación entre los procesadores, la memoria principal y los

módulos de E/S.

La Figura 1.1 muestra estos componentes de más alto nivel. Una de las funciones del procesador

es el intercambio de datos con la memoria. Para este fin, se utilizan normalmente dos registros internos (al procesador): un registro de dirección de memoria (RDIM), que especifica la dirección de

memoria de la siguiente lectura o escritura; y un registro de datos de memoria (RDAM), que contiene los datos que se van a escribir en la memoria o que recibe los datos leídos de la memoria. De manera similar, un registro de dirección de E/S (RDIE/S) especifica un determinado dispositivo de E/S,

y un registro de datos de E/S (RDAE/S) permite el intercambio de datos entre un módulo de E/S y el

procesador.

Un módulo de memoria consta de un conjunto de posiciones definidas mediante direcciones numeradas secuencialmente. Cada posición contiene un patrón de bits que se puede interpretar como

una instrucción o como datos. Un módulo de E/S transfiere datos desde los dispositivos externos hacia el procesador y la memoria, y viceversa. Contiene buffers (es decir, zonas de almacenamiento internas) que mantienen temporalmente los datos hasta que se puedan enviar.

01-Capitulo 1

16/5/05

17:03

Página 11

Introducción a los computadores

CPU

11

Memoria principal

PC

RDIM

IR

RDAM

0

1

2

Bus del

sistema

Instrucción

Instrucción

Instrucción

RDI E/S

Unidad de

ejecución

RDA E/S

Datos

Datos

Datos

Datos

Módulo de E/S

Buffers

Figura 1.1.

n2

n1

PC Contador de programa

IR Registro de instrucción

RDIM Registro de dirección de memoria

RDAM Registro de datos de memoria

RDI E/S Registro de dirección de entrada/salida

RDA E/S Registro de datos de entrada/salida

Componentes de un computador: visión al más alto nivel.

1.2. REGISTROS DEL PROCESADOR

Un procesador incluye un conjunto de registros que proporcionan un tipo de memoria que es más rápida y de menor capacidad que la memoria principal. Los registros del procesador sirven para dos

funciones:

• Registros visibles para el usuario. Permiten al programador en lenguaje máquina o en ensamblador minimizar las referencias a memoria principal optimizando el uso de registros. Para

lenguajes de alto nivel, un compilador que realice optimización intentará tomar decisiones inteligentes sobre qué variables se asignan a registros y cuáles a posiciones de memoria principal. Algunos lenguajes de alto nivel, tales como C, permiten al programador sugerir al compilador qué variables deberían almacenarse en registros.

• Registros de control y estado. Usados por el procesador para controlar su operación y por rutinas privilegiadas del sistema operativo para controlar la ejecución de programas.

No hay una clasificación nítida de los registros entre estas dos categorías. Por ejemplo, en algunas máquinas el contador de programa es visible para el usuario, pero en muchas otras no lo es. Sin

embargo, para el estudio que se presenta a continuación, es conveniente utilizar estas categorías.

01-Capitulo 1

12

16/5/05

17:03

Página 12

Sistemas operativos. Aspectos internos y principios de diseño

REGISTROS VISIBLES PARA EL USUARIO

A un registro visible para el usuario se puede acceder por medio del lenguaje de máquina ejecutado

por el procesador que está generalmente disponible para todos los programas, incluyendo tanto programas de aplicación como programas de sistema. Los tipos de registros que están normalmente disponibles son registros de datos, de dirección y de códigos de condición.

El programador puede utilizar los registros de datos para diversas funciones. En algunos casos, son, en esencia, de propósito general y pueden usarse con cualquier instrucción de máquina

que realice operaciones sobre datos. Sin embargo, frecuentemente, hay restricciones. Por ejemplo, puede haber registros dedicados a operaciones de coma flotante y otros a operaciones con

enteros.

Los registros de dirección contienen direcciones de memoria principal de datos e instrucciones, o una parte de la dirección que se utiliza en el cálculo de la dirección efectiva o completa.

Estos registros pueden ser en sí mismos de propósito general, o pueden estar dedicados a una forma, o modo, particular de direccionamiento de memoria. A continuación, se incluyen algunos

ejemplos:

• Registro índice. El direccionamiento indexado es un modo común de direccionamiento que

implica sumar un índice a un valor de base para obtener una dirección efectiva.

• Puntero de segmento. Con direccionamiento segmentado, la memoria se divide en segmentos, que son bloques de palabras1 de longitud variable. Una referencia de memoria

consta de una referencia a un determinado segmento y un desplazamiento dentro del segmento; este modo de direccionamiento es importante en el estudio de la gestión de memoria

que se realizará en el Capítulo 7. En este modo de direccionamiento, se utiliza un registro

para mantener la dirección base (posición de inicio) del segmento. Puede haber múltiples

registros; por ejemplo, uno para el sistema operativo (es decir, cuando el código del sistema

operativo se está ejecutando en el procesador) y otro para la aplicación que se está ejecutando actualmente.

• Puntero de pila. Si hay direccionamiento de pila2 visible para el usuario, hay un registro dedicado que apunta a la cima de la pila. Esto permite el uso de instrucciones que no contienen

campo de dirección, tales como las que permiten apilar (push) y extraer (pop).

En algunas máquinas, una llamada a una subrutina o a un procedimiento implica salvar automáticamente todos los registros visibles para el usuario, que se restaurarán al retornar. El procesador realiza estas operaciones de salvar y restaurar como parte de la ejecución de las instrucciones de llamada

y de retorno. Esto permite que cada procedimiento use estos registros independientemente. En otras

máquinas, el programador es el responsable de guardar el contenido de los registros visibles para el

usuario antes de una llamada a un procedimiento, incluyendo instrucciones para ello en el programa.

Por tanto, las funciones de salvar y restaurar se pueden realizar en hardware o en software, dependiendo del procesador.

1

No hay una definición universal del término palabra. En general, una palabra es un conjunto ordenado de bytes o bits que es

la unidad normal con la que se almacena, transmite, u opera la información dentro de un determinado computador. Normalmente, si

un computador tiene un juego de instrucciones de longitud fija, la longitud de las instrucciones es igual a la de la palabra.

2

Una pila se almacena en la memoria principal y es un conjunto secuencial de posiciones a las que se hace referencia de manera similar a como ocurre con una pila física de papeles, insertando y extrayendo elementos de la cima de la misma. Véase el Apéndice 1B donde se incluye una explicación sobre la gestión de la pila.

01-Capitulo 1

16/5/05

17:03

Página 13

Introducción a los computadores

13

REGISTROS DE CONTROL Y ESTADO

Se emplean varios registros del procesador para controlar el funcionamiento del mismo. En la mayoría de las máquinas, muchos de ellos no son visibles para el usuario. A algunos de ellos se puede acceder mediante instrucciones de máquina ejecutadas en lo que se denomina modo de control o de sistema operativo.

Por supuesto, diferentes máquinas tendrán distintas organizaciones de registros y utilizarán diferente terminología. A continuación, se proporcionará una lista razonablemente completa de tipos de

registros, con una breve descripción de cada uno de ellos. Además de los registros RDIRM, RDAM,

RDIE/S y RDAE/S mencionados anteriormente (Figura 1.1), los siguientes son esenciales para la ejecución de instrucciones:

• Contador de programa (Program Counter, PC). Contiene la dirección de la próxima instrucción que se leerá de la memoria.

• Registro de instrucción (Instruction Register, IR). Contiene la última instrucción leída.

Todos los diseños de procesador incluyen también un registro, o conjunto de registros, conocido

usualmente como la palabra de estado del programa (Program Status Word, PSW), que contiene información de estado. La PSW contiene normalmente códigos de condición, además de otra información de estado, tales como un bit para habilitar/inhabilitar las interrupciones y un bit de modo usuario/supervisor.

Los códigos de condición (también llamados indicadores) son bits cuyo valor lo asigna normalmente el hardware de procesador teniendo en cuenta el resultado de las operaciones. Por ejemplo, una operación aritmética puede producir un resultado positivo, negativo, cero o desbordamiento. Además de almacenarse el resultado en sí mismo en un registro o en la memoria, se fija también

un código de condición en concordancia con el resultado de la ejecución de la instrucción aritmética. Posteriormente, se puede comprobar el código de condición como parte de una operación de

salto condicional. Los bits de código de condición se agrupan en uno o más registros. Normalmente, forman parte de un registro de control. Generalmente, las instrucciones de máquina permiten

que estos bits se lean mediante una referencia implícita, pero no pueden ser alterados por una referencia explícita debido a que están destinados a la realimentación del resultado de la ejecución de

una instrucción.

En máquinas que utilizan múltiples tipos de interrupciones, se puede proporcionar un conjunto de

registros de interrupciones, con un puntero a cada rutina de tratamiento de interrupción. Si se utiliza

una pila para implementar ciertas funciones (por ejemplo llamadas a procedimientos), se necesita un

puntero de pila de sistema (véase el Apéndice 1B). El hardware de gestión de memoria, estudiado en

el Capítulo 7, requiere registros dedicados. Asimismo, se pueden utilizar registros en el control de las

operaciones de E/S.

En el diseño de la organización del registro de control y estado influyen varios factores. Un aspecto fundamental es proporcionar apoyo al sistema operativo. Ciertos tipos de información de control son útiles específicamente para el sistema operativo. Si el diseñador del procesador tiene un conocimiento funcional del sistema operativo que se va a utilizar, se puede diseñar la organización de

registros de manera que se proporcione soporte por parte del hardware de características particulares

de ese sistema operativo, en aspectos tales como la protección de memoria y la multiplexación entre

programas de usuario.

Otra decisión de diseño fundamental es el reparto de la información de control entre los registros

y la memoria. Es habitual dedicar las primeras (las de direcciones más bajas) cientos o miles de palabras de memoria para propósitos de control. El diseñador debe decidir cuánta información de control

01-Capitulo 1

14

16/5/05

17:03

Página 14

Sistemas operativos. Aspectos internos y principios de diseño

debería estar en registros, más rápidos y más caros, y cuánta en la memoria principal, menos rápida y

más económica.

1.3. EJECUCIÓN DE INSTRUCCIONES

Un programa que va a ejecutarse en un procesador consta de un conjunto de instrucciones almacenado en memoria. En su forma más simple, el procesamiento de una instrucción consta de dos pasos: el procesador lee (busca) instrucciones de la memoria, una cada vez, y ejecuta cada una de

ellas. La ejecución del programa consiste en repetir el proceso de búsqueda y ejecución de instrucciones. La ejecución de la instrucción puede involucrar varias operaciones dependiendo de la naturaleza de la misma.

Se denomina ciclo de instrucción al procesamiento requerido por una única instrucción. En la Figura 1.2 se describe el ciclo de instrucción utilizando la descripción simplificada de dos pasos. A estos dos pasos se les denomina fase de búsqueda y de ejecución. La ejecución del programa se detiene

sólo si se apaga la máquina, se produce algún tipo de error irrecuperable o se ejecuta una instrucción

del programa que para el procesador.

BÚSQUEDA Y EJECUCIÓN DE UNA INSTRUCCIÓN

Al principio de cada ciclo de instrucción, el procesador lee una instrucción de la memoria. En un procesador típico, el contador del programa (PC) almacena la dirección de la siguiente instrucción que se

va a leer. A menos que se le indique otra cosa, el procesador siempre incrementa el PC después de

cada instrucción ejecutada, de manera que se leerá la siguiente instrucción en orden secuencial (es decir, la instrucción situada en la siguiente dirección de memoria más alta). Considere, por ejemplo, un

computador simplificado en el que cada instrucción ocupa una palabra de memoria de 16 bits. Suponga que el contador del programa está situado en la posición 300. El procesador leerá la siguiente instrucción de la posición 300. En sucesivos ciclos de instrucción completados satisfactoriamente, se

leerán instrucciones de las posiciones 301, 302, 303, y así sucesivamente. Esta secuencia se puede alterar, como se explicará posteriormente.

La instrucción leída se carga dentro de un registro del procesador conocido como registro de instrucción (IR). La instrucción contiene bits que especifican la acción que debe realizar el procesador.

El procesador interpreta la instrucción y lleva a cabo la acción requerida. En general, estas acciones

se dividen en cuatro categorías:

• Procesador-memoria. Se pueden transferir datos desde el procesador a la memoria o viceversa.

• Procesador-E/S. Se pueden enviar datos a un dispositivo periférico o recibirlos desde el mismo, transfiriéndolos entre el procesador y un módulo de E/S.

Inicio

Fase de búsqueda

Fase de ejecución

Busca la

siguiente

instrucción

Ejecuta la

instrucción

Figura 1.2.

Ciclo de instrucción básico.

Parada

01-Capitulo 1

16/5/05

17:03

Página 15

Introducción a los computadores

15

• Procesamiento de datos. El procesador puede realizar algunas operaciones aritméticas o lógicas sobre los datos.

• Control. Una instrucción puede especificar que se va a alterar la secuencia de ejecución. Por

ejemplo, el procesador puede leer una instrucción de la posición 149, que especifica que la siguiente instrucción estará en la posición 182. El procesador almacenará en el contador del programa un valor de 182. Como consecuencia, en la siguiente fase de búsqueda, se leerá la instrucción de la posición 182 en vez de la 150.

Una ejecución de una instrucción puede involucrar una combinación de estas acciones.

Considere un ejemplo sencillo utilizando una máquina hipotética que incluye las características

mostradas en la Figura 1.3. El procesador contiene un único registro de datos, llamado el acumulador

(AC). Tanto las instrucciones como los datos tienen una longitud de 16 bits, estando la memoria organizada como una secuencia de palabras de 16 bits. El formato de la instrucción proporciona 4 bits para el

código de operación, permitiendo hasta 24 = 16 códigos de operación diferentes (representados por un

único dígito hexadecimal3). Con los 12 bits restantes del formato de la instrucción, se pueden direccionar directamente hasta 212 = 4.096 (4K) palabras de memoria (denotadas por tres dígitos hexadecimales).

La Figura 1.4 ilustra una ejecución parcial de un programa, mostrando las partes relevantes de la

memoria y de los registros del procesador. El fragmento de programa mostrado suma el contenido de

la palabra de memoria en la dirección 940 al de la palabra de memoria en la dirección 941, almacenando el resultado en esta última posición. Se requieren tres instrucciones, que corresponden a tres

fases de búsqueda y de ejecución, como se describe a continuación:

0

3 4

15

Código-de-op

Dirección

(a) Formato de instrucción

0

15

1

S

Magnitud

(b) Formato de un entero

Contador de programa (PC) = Dirección de la instrucción

Registro de instrucción (IR) = Instrucción que se está ejecutando

Acumulador (AC) = Almacenamiento temporal

(c) Registros internos de la CPU

0001 = Carga AC desde la memoria

0010 = Almacena AC en memoria

0101 = Suma a AC de la memoria

(d) Lista parcial de códigos-de-op

Figura 1.3.

Características de una máquina hipotética.

3

Puede encontrar un repaso básico de los sistema numéricos (decimal, binario y hexadecimal) en el Computer Science Student

Resource Site en WilliamStallings.com/StudentSupport.html.

01-Capitulo 1

16

16/5/05

17:03

Página 16

Sistemas operativos. Aspectos internos y principios de diseño

Fase de búsqueda

Fase de ejecución

Memoria

Registros de la CPU

Memoria

Registros de la CPU

300 1 9 4 0

300 1 9 4 0

3 0 0 PC

3 0 1 PC

301 5 9 4 1

AC 301 5 9 4 1

0 0 0 3 AC

302 2 9 4 1

1 9 4 0 IR 302 2 9 4 1

1 9 4 0 IR

940 0 0 0 3

941 0 0 0 2

940 0 0 0 3

941 0 0 0 2

Paso 1

Paso 2

Memoria

Memoria

Registros de la CPU

Registros de la CPU

300 1 9 4 0

300 1 9 4 0

3 0 1 PC

3 0 2 PC

301 5 9 4 1

0 0 0 3 AC 301 5 9 4 1

0 0 0 5 AC

302 2 9 4 1

5 9 4 1 IR 302 2 9 4 1

5 9 4 1 IR

940 0 0 0 3

941 0 0 0 2

940 0 0 0 3

941 0 0 0 2

Paso 3

Paso 4

3+2=5

Memoria

Memoria

Registros de la CPU

Registros de la CPU

300 1 9 4 0

300 1 9 4 0

3 0 2 PC

3 0 3 PC

301 5 9 4 1

0 0 0 5 AC 301 5 9 4 1

0 0 0 5 AC

302 2 9 4 1

2 9 4 1 IR 302 2 9 4 1

2 9 4 1 IR

940 0 0 0 3

941 0 0 0 2

940 0 0 0 3

941 0 0 0 5

Paso 5

Paso 6

Figura 1.4. Ejemplo de ejecución de un programa

(contenido de la memoria y los registros en hexadecimal).

1. El PC contiene el valor 300, la dirección de la primera instrucción. Esta instrucción (el valor 1940 en hexadecimal) se carga dentro del registro de instrucción IR y se incrementa el

PC. Nótese que este proceso involucra el uso del registro de dirección de memoria (RDIM)

y el registro de datos de memoria (RDAM). Para simplificar, no se muestran estos registros

intermedios.

2. Los primeros 4 bits (primer dígito hexadecimal) en el IR indican que en el AC se va a cargar

un valor leído de la memoria. Los restantes 12 bits (tres dígitos hexadecimales) especifican la

dirección de memoria, que es 940.

3. Se lee la siguiente instrucción (5941) de la posición 301 y se incrementa el PC.

4. El contenido previo del AC y el contenido de la posición 941 se suman y el resultado se almacena en el AC.

5. Se lee la siguiente instrucción (2941) de la posición 302 y se incrementa el PC.

6. Se almacena el contenido del AC en la posición 941.

En este ejemplo, se necesitan tres ciclos de instrucción, de tal forma que cada uno consta de una

fase de búsqueda y una fase de ejecución, para sumar el contenido de la posición 940 al contenido de

la 941. Con un juego de instrucciones más complejo, se necesitarían menos ciclos de instrucción. La

mayoría de los procesadores modernos incluyen instrucciones que contienen más de una dirección.

Por tanto, la fase de ejecución de una determinada instrucción puede involucrar más de una referencia a memoria. Asimismo, en vez de referencias a memoria, una instrucción puede especificar una

operación de E/S.

01-Capitulo 1

16/5/05

17:03

Página 17

Introducción a los computadores

17

SISTEMA DE E/S

Se pueden intercambiar datos directamente entre un módulo de E/S (por ejemplo, un controlador de

disco) y el procesador. Al igual que el procesador puede iniciar una lectura o una escritura en memoria, especificando la dirección de una posición de memoria, también puede leer o escribir datos en un

módulo de E/S. En este caso, el procesador identifica un dispositivo específico que está controlado por

un determinado módulo de E/S. Por tanto, podría producirse una secuencia de instrucciones similar a

la de la Figura 1.4, con instrucciones de E/S en vez de instrucciones que hacen referencia a memoria.

En algunos casos, es deseable permitir que los intercambios de E/S se produzcan directamente

con la memoria para liberar al procesador de la tarea de E/S. En tales casos, el procesador concede a

un módulo de E/S la autorización para leer o escribir de la memoria, de manera que la transferencia

entre memoria y E/S puede llevarse a cabo sin implicar al procesador. Durante dicha transferencia, el

módulo de E/S emite mandatos de lectura y escritura a la memoria, liberando al procesador de la responsabilidad del intercambio. Esta operación, conocida como acceso directo a memoria (Direct Memory Access, DMA) se examinará al final de este capítulo.

1.4. INTERRUPCIONES

Prácticamente todos los computadores proporcionan un mecanismo por el cual otros módulos (memoria y E/S) pueden interrumpir el secuenciamiento normal del procesador. La Tabla 1.1 detalla los

tipos más comunes de interrupciones.

Básicamente, las interrupciones constituyen una manera de mejorar la utilización del procesador.

Por ejemplo, la mayoría de los dispositivos de E/S son mucho más lentos que el procesador. Supóngase que el procesador está transfiriendo datos a una impresora utilizando el esquema de ciclo de instrucción de la Figura 1.2. Después de cada instrucción de escritura, el procesador debe parar y permanecer inactivo hasta que la impresora la lleve a cabo. La longitud de esta pausa puede ser del orden de

muchos miles o incluso millones de ciclos de instrucción. Claramente, es un enorme desperdicio de la

capacidad del procesador.

Tabla 1.1.

Clases de interrupciones.

De programa

Generada por alguna condición que se produce como resultado de la ejecución de una instrucción, tales como un desbordamiento aritmético, una división por cero, un intento de ejecutar una instrucción de máquina ilegal, y

las referencias fuera del espacio de la memoria permitido para un usuario.

Por temporizador

Generada por un temporizador del procesador. Permite al sistema operativo realizar ciertas funciones de forma regular.

De E/S

Generada por un controlador de E/S para señalar la conclusión normal de

una operación o para indicar diversas condiciones de error.

Por fallo del hardware

Generada por un fallo, como un fallo en el suministro de energía o un

error de paridad en la memoria.

Para dar un ejemplo concreto, considere un computador personal que operase a 1GHz, lo que le

permitiría ejecutar aproximadamente 109 instrucciones por segundo4. Un típico disco duro tiene una

4

Una discussion de los usos de prefijos numéricos, tales como giga y tera, está disponible en un documento de apoyo en el

Computer Science Student Resource Site en WilliamStallings.com/StudentSupport.html.

01-Capitulo 1

18

16/5/05

17:03

Página 18

Sistemas operativos. Aspectos internos y principios de diseño

velocidad de rotación de 7200 revoluciones por minuto, que corresponde con un tiempo de rotación

de media pista de 4 ms., que es 4 millones de veces más lento que el procesador.

La Figura 1.5a muestra esta cuestión. El programa de usuario realiza una serie de llamadas de

ESCRITURA intercaladas con el procesamiento. Los segmentos de código 1, 2 y 3 se refieren a secuencias de instrucciones que no involucran E/S. Las llamadas de ESCRITURA invocan a una rutina

de E/S que es una utilidad del sistema que realizará la operación real de E/S. El programa de E/S

consta de tres secciones:

• Una secuencia de instrucciones, etiquetada como 4 en la figura, para preparar la operación real

de E/S. Esto puede incluir copiar los datos de salida en un buffer especial y preparar los parámetros de un mandato para el dispositivo.

• El mandato real de E/S. Sin el uso de interrupciones, una vez que se emite este mandato, el

programa debe esperar a que el dispositivo de E/S realice la función solicitada (o comprobar

periódicamente el estado, o muestrear, el dispositivo de E/S). El programa podría esperar simplemente realizando repetidamente una operación de comprobación para determinar si se ha

realizado la operación de E/S.

• Una secuencia de instrucciones, etiquetada como 5 en la figura, para completar la operación.

Esto puede incluir establecer un valor que indique el éxito o el fallo de la operación.

Debido a que la operación de E/S puede tardar un tiempo relativamente largo hasta que se

completa, el programa de E/S se queda colgado esperando que se complete; por ello, el programa

de usuario se detiene en el momento de la llamada de ESCRITURA durante un periodo de tiempo

considerable.

Programa de

usuario

Programa Programa de

de E/S

usuario

4

1

Mandato

de E/S

ESCRITURA

1

ESCRITURA

Programa Programa de

de E/S

usuario

4

Mandato

de E/S

1

ESCRITURA

Programa

de E/S

4

Mandato

de E/S

5

2a

FIN

2

2

2b

ESCRITURA

ESCRITURA

3a

3

Manejador de

interrupción

Manejador de

interrupción

5

ESCRITURA

FIN

5

FIN

3

3b

ESCRITURA

ESCRITURA

(a) Sin interrupciones

Figura 1.5.

ESCRITURA

(b) Interrupciones; espera de E/S breve (c) Interrupciones; espera de E/S larga

Flujo de programa del control sin interrupciones y con ellas.

01-Capitulo 1

16/5/05

17:03

Página 19

Introducción a los computadores

19

INTERRUPCIONES Y EL CICLO DE INSTRUCCIÓN

Gracias a las interrupciones, el procesador puede dedicarse a ejecutar otras instrucciones mientras

que la operación de E/S se está llevando a cabo. Considere el flujo de control mostrado en la Figura

1.5b. Como anteriormente, el programa de usuario alcanza un punto en el que hace una llamada al

sistema que consiste en una llamada de ESCRITURA. El programa de E/S que se invoca en este caso

consta sólo del código de preparación y el mandato real de E/S. Después de que se ejecuten estas pocas instrucciones, se devuelve el control al programa de usuario. Mientras tanto, el dispositivo externo está ocupado aceptando datos de la memoria del computador e imprimiéndolos. La operación de

E/S se lleva a cabo de forma concurrente con la ejecución de instrucciones en el programa de usuario.

Cuando el dispositivo externo está listo para ser atendido, es decir, cuando está preparado para

aceptar más datos del procesador, el módulo de E/S de este dispositivo externo manda una señal de

petición de interrupción al procesador. El procesador responde suspendiendo la ejecución del programa actual, saltando a la rutina de servicio específica de este dispositivo de E/S, conocida como manejador de interrupción, y reanudando la ejecución original después de haber atendido al dispositivo. En

la Figura 1.5b se indican con una X los puntos en los que se produce cada interrupción. Téngase en

cuenta que se puede producir una interrupción en cualquier punto de la ejecución del programa principal, no sólo en una determinada instrucción.

De cara al programa de usuario, una interrupción suspende la secuencia normal de ejecución.

Cuando se completa el procesamiento de la interrupción, se reanuda la ejecución (Figura 1.6). Por

tanto, el programa de usuario no tiene que contener ningún código especial para tratar las interrupciones; el procesador y el sistema operativo son responsables de suspender el programa de usuario y,

posteriormente, reanudarlo en el mismo punto.

Para tratar las interrupciones, se añade una fase de interrupción al ciclo de instrucción, como se

muestra en la Figura 1.7 (compárese con la Figura 1.2). En la fase de interrupción, el procesador

comprueba si se ha producido cualquier interrupción, hecho indicado por la presencia de una señal de

interrupción. Si no hay interrupciones pendientes, el procesador continúa con la fase de búsqueda y

lee la siguiente instrucción del programa actual. Si está pendiente una interrupción, el procesador suspende la ejecución del programa actual y ejecuta la rutina del manejador de interrupción. La rutina

del manejador de interrupción es generalmente parte del sistema operativo. Normalmente, esta rutina

Programa de usuario

Manejador de interrupción

1

2

i

La interrupción

se produce

en este punto

i1

M

Figura 1.6.

Transferencia de control mediante interrupciones.

01-Capitulo 1

20

16/5/05

17:03

Página 20

Sistemas operativos. Aspectos internos y principios de diseño

Fase de búsqueda

Fase de ejecución

Fase de interrupción

Interrupciones

inhabilitadas

Inicio

Búsqueda de

la siguiente

instrucción

Ejecuta la

instrucción

Comprueba si hay

una interrupción;

inicia el manejador

Interrupciones de interrupción

habilitadas

Parada

Figura 1.7.

Ciclo de instrucción con interrupciones.

determina la naturaleza de la interrupción y realiza las acciones que se requieran. En el ejemplo que

se está usando, el manejador determina qué módulo de E/S generó la interrupción y puede dar paso a

un programa que escriba más datos en ese módulo de E/S. Cuando se completa la rutina del manejador de interrupción, el procesador puede reanudar la ejecución del programa de usuario en el punto

de la interrupción.

Es evidente que este proceso implica cierta sobrecarga. Deben ejecutarse instrucciones adicionales (en el manejador de interrupción) para determinar la naturaleza de la interrupción y decidir sobre

la acción apropiada. Sin embargo, debido a la cantidad relativamente elevada de tiempo que se gastaría simplemente a la espera de una operación de E/S, el procesador se puede emplear mucho más eficientemente con el uso de interrupciones.

Para apreciar la ganancia en eficiencia, considere la Figura 1.8, que es un diagrama de tiempo basado en el flujo de control de las Figuras 1.5a y 1.5b. Las Figuras 1.5b y 1.8 asumen que el tiempo requerido para la operación de E/S es relativamente corto: inferior al tiempo que tarda en completarse la

ejecución de instrucciones entre las operaciones de escritura del programa de usuario. El caso más típico, especialmente para un dispositivo lento como una impresora, es que la operación de E/S tarde mucho más tiempo que la ejecución de una secuencia de instrucciones de usuario. La Figura 1.5c ilustra

este tipo de situación. En este caso, el programa de usuario alcanza la segunda llamada de ESCRITURA antes de que se complete la operación de E/S generada por la primera llamada. El resultado es que

el programa de usuario se queda colgado en ese punto. Cuando se completa la operación de E/S precedente, se puede procesar la nueva llamada de ESCRITURA y se puede empezar una nueva operación

de E/S. La Figura 1.9 muestra la temporización de esta situación con el uso de interrupciones o sin

ellas. Se puede observar que hay una ganancia en eficiencia debido a que parte del tiempo durante el

que se realiza la operación de E/S se solapa con la ejecución de las instrucciones del usuario.

PROCESAMIENTO DE INTERRUPCIONES

La aparición de una interrupción dispara varios eventos, tanto en el hardware del procesador como en

el software. La Figura 1.10 muestra una secuencia típica. Cuando un dispositivo de E/S completa una

operación de E/S, se produce la siguiente secuencia de eventos en el hardware: