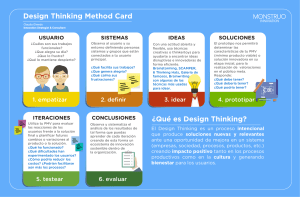

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE ESCUELA DE INGENIERIA MODELO DE EVALUACIÓN Y DISEÑO DE TEST DE PENSAMIENTO CRÍTICO EN EL DOMINIO DE LENGUAJE Y COMUNICACIÓN PARA EDUCACIÓN PRIMARIA RODRIGO DEL RÍO JOGLAR Tesis para optar al grado de Magister en Ciencias de la Ingeniería Profesor Supervisor: MIGUEL NUSSBAUM Santiago de Chile, (Agosto, 2015) © 2015, Rodrigo del Río PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE ESCUELA DE INGENIERIA MODELO DE EVALUACIÓN Y DISEÑO DE TEST DE PENSAMIENTO CRÍTICO EN EL DOMINIO DE LENGUAJE Y COMUNICACIÓN PARA EDUCACIÓN PRIMARIA RODRIGO DEL RÍO JOGLAR Tesis presentada a la Comisión integrada por los profesores: MIGUEL NUSSBAUM (SUPERVISOR) YADRÁN ETEROVIC (INTEGRANTE) PABLO CHIUMINATTO (INVITADO) DAVID PREISS (INVITADO) YADRÁN ETEROVIC (REPRESENTANTE POSGRADO) Para completar las exigencias del grado de Magíster en Ciencias de la Ingeniería Santiago de Chile, (Agosto, 2015) A mis padres, al futuro de estas tierras, a Nicole. ii AGRADECIMIENTOS Quisiera agradecer primero a la Pontificia Universidad Católica de Chile por abrir sus puertas a investigaciones interdisciplinarias y dotar a los académicos de un ambiente propicio para resolver los problemas más urgentes de nuestro país. Además, quisiera recalcar la fundamental labor que realiza el Departamento de Ciencias de la Computación de la Facultad de Ingeniería por expandir el horizonte de sus estudiantes y promover el diálogo crítico, siempre en una atmósfera de respeto y compañerismo. Especialmente, quisiera agradecer al profesor Pablo Chiuminatto, por su fe, su amistad y por invitarme a imaginar nuevos terrenos para el desarrollo intelectual. También a Miguel Nussbaum, por la confianza de recibirme en su grupo de investigación, invitarme a compartir su visión sobre el problema educacional chileno y guiar la presente tesis a buen puerto. No puedo dejar de agradecer a mis compañeros Damián Gelerstein y Martín Cáceres, con quienes trabajé codo a codo por develar el significado de nuestra investigación. Debo mencionar aquí también al profesor Cristián Opazo, quien me ha acompañado y aconsejado con sabiduría en el curso de mis estudios en esta universidad. Quisiera agradecer también a mis padres por su apoyo incondicional en mis derivas profesionales e intelectuales, además de su afecto y alegría para acompañarme siempre en nuevos desafíos. Finalmente, a Nicole; por su amor, por su paciencia, por enaltecer lo mejor en mí. Bajo su mirada atenta se gestó todo lo que hay de virtud en este trabajo. Los vicios, por supuesto, son absoluta responsabilidad mía. iii INDICE GENERAL AGRADECIMIENTOS ....................................................................................................... iii INDICE DE TABLAS ......................................................................................................... vi INDICE DE FIGURAS ....................................................................................................... vii RESUMEN ......................................................................................................................... viii ABSTRACT ......................................................................................................................... ix PRÓLOGO ............................................................................................................................ 1 1. MOTIVACIÓN: HACIA UN MODELO DE EVALUACIÓN DE PENSAMIENTO CRÍTICO ............................................................................................................................... 3 1.1 Habilidades del siglo XXI ..................................................................................................... 3 1.2 Nuevo paradigma de evaluación ............................................................................................... 6 1.3 Pensamiento crítico ................................................................................................................... 9 1.3.1 Importancia de pensamiento crítico en la educación contemporánea ............................... 9 1.3.2 Evaluación del pensamiento crítico ................................................................................. 13 1.4 Cultura .................................................................................................................................... 16 1.5 Modelo de evaluación de pensamiento crítico y cultura ......................................................... 20 1.5.1 Relación entre pensamiento crítico y cultura .................................................................. 20 1.5.2 Modelo de mediación ...................................................................................................... 23 2. TAREAS IMPLEMENTADAS. DISEÑO Y VALIDACIÓN DE TEST DE PENSAMIENTO CRÍTICO................................................................................................ 27 2.1 Test de pensamiento crítico. ............................................................................................... 27 2.1.1 Introducción ..................................................................................................................... 27 2.1.2 Metodología ..................................................................................................................... 31 2.1.2.1 Definición del test......................................................................................................... 31 2.1.2.2 Criterios de validación del instrumento. ....................................................................... 36 2.1.2.3 Trabajo Experimental ................................................................................................... 38 2.1.3 Resultados ............................................................................................................................ 39 2.1.3.1 Validez del constructo .................................................................................................. 39 iv 2.1.3.2 Validez del contenido ................................................................................................... 40 2.1.3.3 Validez de criterio y Pearson product-moment correlation .......................................... 40 2.1.3.4 Confiabilidad ................................................................................................................ 40 2.1.3.5 Análisis de ítems........................................................................................................... 41 2.1.3.4 Diferencias entre colegios ............................................................................................ 42 2.1.4 Conclusiones ........................................................................................................................ 44 CONCLUSIONES FINALES ............................................................................................. 47 BIBLIOGRAFIA................................................................................................................. 50 ANEXOS............................................................................................................................. 68 Anexo A. Tablas ........................................................................................................................... 69 Anexo B. Paper en ingles .............................................................................................................. 74 Anexo C. Recepción del Paper en Revista Académica............................................................... 107 v INDICE DE TABLAS Tabla 1: Participantes en el estudio según nivel socioeconómico y género ....................... 39 Tabla 2: Resumen discriminación y Dificultad por pregunta ............................................. 42 Tabla 3: Promedios por curso y tipo de colegio .................................................................. 43 Tabla 4: : Resumen puntajes y dimensiones ....................................................................... 69 Tabla 5: Valores promedio de Dificultad y Discriminación para el pre y post Análisis de Ítems. .. 74 vi INDICE DE FIGURAS Figura 1: Modelo de mediación .......................................................................................... 24 Figura 2: Modelo de mediación aplicado a las variables de pensamiento crítico y cultura................ 25 Figura 3: Método de testeo de un modelo de mediación. ................................................... 25 Figura 4: Ejemplo de pregunta ............................................................................................ 36 vii RESUMEN La actual tendencia en la investigación en educación escolar reconoce la necesidad de la integración de las llamadas “habilidades del siglo XXI” al currículum y a la instrucción escolar. Una de las habilidades centrales, en este sentido, es el pensamiento crítico, que es reconocido al interior del currículum nacional. La consecuencia de cambiar la orientación curricular hacia este nuevo paradigma implica una transformación de la evaluación de estas competencias. Sin embargo, hoy no se dispone de instrumentos específicos que cumplan este propósito para los niveles de educación primaria. Esta investigación plantea un modelo de evaluación y el diseño de un test de pensamiento crítico para estudiantes de tercer y cuarto grado. El test se diseñó específicamente en el dominio de lenguaje y comunicación mediante la utilización de una novela gráfica. El test fue validado por medio del análisis de: validez del constructo, del contenido, del criterio, además de un análisis de la confiabilidad y de ítems. El instrumento presenta un diseño adecuado a modelos multidimensionales de la habilidad evaluada, que entrega una imagen más detallada y completa del aprendizaje del estudiante. Una vez validado el instrumento, los datos permitieron examinar la diferencia en el nivel de pensamiento crítico de los estudiantes de acuerdo a su estrato socioeconómico. Se encontraron diferencias significativas en el nivel de pensamiento crítico entre los grupos. Estas diferencias deberían ser consideradas en futuras investigaciones dadas las posibles influencias del factor socioeconómico sobre la evaluación de pensamiento crítico en estudiantes de educación primaria. Esta tesis contó con el apoyo de CONICYT-FONDECYT 1150045 y del Proyecto Interdisciplinario de Investigación VRI Nº13/2014. Palabras Claves: pensamiento crítico, modelos de evaluación, habilidades del siglo XXI, cultura, narrativa gráfica y textual viii ABSTRACT The current trend in educational research recognizes the necessity to integrate the so called “21st century skills” into the school curriculum. One of the most important skills, in this sense, is critical thinking, which is recognized in the national curriculum. The consequence to change the curricular orientation to this new paradigm implies a transformation of the assessment of these competences. However, there are not available instruments that fit this purpose for primary education. This research is directed towards the cosntruction of an assessment model and the design of a test of critical thinking for students in 3rd and 4th grade. The test was specifically in the domain of language and communication by means of a graphic novel. The validity of the test was determined by analyzing the construct, content and criterion validity, as well as its reliability and performing an item analysis. The instrument shows an adequate design according to a multidimensional model of the assessed skill, which delivers a more detailed and complete picture of the student’s learning. Once it was validated, the collected data allowed us to examine differences in the level of critical thinking according to the student’s socioeconomic status. Significant differences were found between the groups. These differences should be considered in future research due to possible influences of the socioeconomic fator over the assessment of skills in primary education contexts. This thesis had the support of CONICYT-FONDECYT 1150045, and of the VRI Interdisciplina Research Project N° 13/2014. Keywords: Critical Thinking, Assessment models, 21st Century Skills, Culture, Graphic and Textual Narrative ix 1 PRÓLOGO La actual tendencia en la investigación en educación escolar reconoce la necesidad de la integración de las llamadas “habilidades del siglo XXI” al currículum y a la instrucción escolar. Una de las habilidades centrales, en este sentido, es el pensamiento crítico, que es reconocido al interior del currículum nacional. El Ministerio de Educación de nuestro país expresa en un reciente reporte que el pensamiento crítico ha cobrado “mayor importancia que nunca”, por la influencia de la gran cantidad de selección, lectura y evaluación de información provocada por los nuevos medios de comunicación digital (Mineduc, OCDE & SIMCE, 2011, p.21). Una instrucción adecuada de esta habilidad requiere que los profesores y los establecimientos tengan un panorama adecuado del nivel de pensamiento crítico de los estudiantes (Ennis, 1993). Sin embargo, los actuales modelos de evaluación entregan una imagen parcial o distorsionada del aprendizaje de los estudiantes, ya que utilizan métodos reduccionistas para evaluar competencias de carácter multidimensional (Conley, 2015). En este sentido, el objetivo de este trabajo es diseñar un test que evalúe pensamiento crítico para lograr a través de datos una imagen más acabada del aprendizaje de los estudiantes chilenos en educación primaria. Por lo tanto, es necesario revisar el modo en que se puede diseñar de manera apropiada un instrumento de evaluación de pensamiento crítico para luego implementarlo y probar su rendimiento en contextos educacionales reales. 2 El primer capítulo presenta el marco general de la evaluación de “habilidades del siglo XXI”, al que se ciñe este trabajo. Luego, se especifican los conceptos que guiarán la construcción de un modelo de evaluación integrado, en particular, los conceptos de pensamiento crítico y cultura. Finalmente, se describe un modelo estadístico de mediación mediante el cual es posible implementar un test que integre factores culturales en la evaluación del pensamiento crítico. El segundo capítulo es un paper que describe el diseño, validación e implementación de un test de pensamiento crítico basado en una novela gráfica para estudiantes de tercer y cuarto grado. Además, se analiza la posible influencia del estrato socioeconómico sobre el nivel de pensamiento crítico de los estudiantes. El tercer capítulo revisa las conclusiones generales del trabajo realizado en la construcción del modelo y diseño del test de pensamiento crítico. Finalmente, en los anexos, se encuentra la versión en inglés del paper enviado junto a la carta de recepción a la revista académica Thinking Skills and Creativity. 3 1. MOTIVACIÓN: HACIA UN MODELO DE EVALUACIÓN DE PENSAMIENTO CRÍTICO 1.1 Habilidades del siglo XXI Los últimos años han visto levantarse una enérgica demanda de la ciudadanía por una mejor educación para nuestro país. En general, el problema se ha centrado en el financiamiento de los establecimientos educacionales, cuya máxima expresión es una reforma en curso por parte del gobierno de Michelle Bachelet centrada en superar la segregación en los colegios. Sin embargo, este énfasis ha oscurecido en buena medida el debate sobre calidad en la educación. En este trabajo propongo revisar un aspecto de este espinoso problema y volver a cuestionarnos qué necesidades plantean nuestros tiempos a nuestros estudiantes. Un reciente reporte conjunto de la UNESCO y la UNICEF llama a los estudiantes del mundo a convertirse en ‘‘self-directed learners who can address their own wants and concerns and can advocate for their goals and aspirations’’ (Sayed, 2013). Este llamado responde a un reclamo general por una enseñanza más relevante y significativa para el nuevo contexto económico y social. En la actual sociedad del conocimiento, la división del trabajo gracias a la tecnología ha hecho que se le otorgue un menor énfasis al intercambio de la información y se privilegian las competencias que apuntan a la comprensión de la información (Levy & Murnane, 2012). 4 Para responder a este reclamo se han desarrollado diversos frameworks alrededor del movimiento llamado “habilidades del siglo XXI”, cuyo impacto en educación ha sido fundamental para volver a pensar las necesidades educacionales de nuestra sociedad. En contraposición a los requerimientos del currículum tradicional, basados fundamentalmente en alfabetización, matemáticas y ciencias, se propone integrar una serie de habilidades que traspasan las categorizaciones cerradas de las disciplinas. Por tanto, se construye desde esta posición la idea de habilidades transversales (que funcionen en más de un dominio del conocimiento), multidimensionales (que incluyan tanto la dimensión cognitiva como actitudinal) y asociadas a habilidades de orden superior (Voogt & Pareja, 2012). Si bien no existe consenso absoluto sobre qué habilidades o competencias se requieren para una educación significativa, se han identificado tendencias generales en los catálogos de los investigadores y agencias educacionales. Voogt & Pareja (2012) efectuaron un análisis comparativo de los distintos marcos disponibles de habilidades del siglo XXI. Se encontró una gran variedad entre los modos de categorización y agrupación de estas habilidades. No obstante, detrás de esta aparente dispersión, se logró identificar que la mayoría de los marcos consideraban centrales la habilidades en el área de comunicación, colaboración, TICs, consciencia social y cultural, así como las habilidades de creatividad, resolución de problemas y pensamiento crítico. Se puede notar que si bien el discurso de las habilidades del siglo XXI nace de la necesidad integrar la educación a los nuevos avances tecnológicos y culturales, el tipo de competencias que promueve es bastante más antiguo. 5 Silva (2009) reconoce que muchas de las mismas necesidades educacionales fueron exigidas por pensadores clásicos como Sócrates o, en su versión más contemporánea, John Dewey. Sin embargo, lo verdaderamente inédito es el énfasis que estas habilidades adquieren por las transformaciones en el trabajo y la economía contemporáneas. En este sentido, resulta sintomático un estudio del World Economic Forum y el Boston Consultancy Group (2015) en más de 91 países que señala que para la utilización exitosa de las herramientas tecnológicas por parte de los estudiantes se necesitan conocimientos más allá de los clásicos contenidos curriculares en lenguaje, matemáticas y ciencia, en particular, considera relevante las habilidades de pensamiento crítico, resolución de problemas, persistencia, colaboración y curiosidad. Sin embargo, indica el reporte, “All too often (...) students in many countries are not attaining these skills”(WEF & BCG, 2015, p.1). Esta situación está marcada, además, por la desigualdad. El mismo informe advierte que existen amplias diferencias en el desempeño promedio de tests para este tipo especial de habilidades entre países de la OECD de alto ingreso en contraposición con aquellos en vías de desarrollo (WEF & BCG, 2015). Esta diferencia ni siquiera pudo ser establecida respecto a los países de bajo ingreso, puesto que muy pocos participan en tests que permitan la comparación como la PISA. La situación se vuelve más urgente si se piensa en que los mayores esfuerzos por reducir la brecha educacional entre los países ricos y los pobres, como el caso de Education for All de la UNESCO, han sido incapaces de 6 mejorar los niveles de competencias mínimas en países de bajos ingresos (Filmer, et al., 2006). Ante este escenario conviene preguntarse dónde vale la pena dedicar trabajo para reducir la brecha e insertar de manera adecuada estas habilidades fundamentales en la enseñanza de los estudiantes. 1.2 Nuevo paradigma de evaluación Pensar nuevas habilidades junto a los contenidos tradicionales en el currículum implica un cambio de paradigma que aún no ha sido completamente recibido por las distintas comunidades. Explica Dede (2010) que una de las mayores complicaciones en la inserción de las habilidades del siglo XXI es el intento de que tanto los educadores y los estudiantes, así como los diseñadores de políticas públicas, dejen atrás cierto tipo de prejuicios pertenecientes al paradigma anterior, como la hora de clases de 45 minutos, o que las preguntas en una prueba deben tener una única pregunta. Este tipo de resistencia no solo ha llevado a distorsionar la actividad pedagógica diaria, sino que además se ha promovido una interpretación errónea de los resultados de pruebas como la PISA. En lugar de concluir en políticas de mejoras de habilidades del siglo XXI, se ha llegado al diagnóstico de que se necesita devolver la atención a habilidades de lectura y matemáticas básicas (Voogt & Pareja, 2012). Lo que se necesita es entender que cambiar la orientación del currículum hacia nuevos objetivos presupone cambiar la manera en que se implementa. 7 Probablemente, el caso más patente de la necesidad de esta reforma sea el de la evaluación. Según Dochy (2001) existen dos paradigmas sobre el que se construyen las políticas de evaluación. Primero, el paradigma tradicional, al que Dochy (2001) denomina la “cultura de la prueba” (testing culture). Según Dochy, en la “cultura de la prueba” el estudiante es imaginado como un recipiente pasivo que debe memorizar los contenidos de la clase narrados por el profesor. Tanto la enseñanza como el aprendizaje son pensados como procesos individuales. La evaluación sigue la misma lógica. Se sustenta principalmente en evaluar un supuesto conocimiento básico adquirido a través de tediosas prácticas y repeticiones de ejercicios. Por tanto, el centro está en evaluar el producto y no el proceso. De esta manera, la instrucción y la evaluación se comprenden como etapas separadas en la enseñanza del estudiante. El típico mecanismo de evaluación será, por tanto, la pregunta con respuesta única, con el fin de cuantificar fácilmente el nivel de aprendizaje del contenido por parte del estudiante. El segundo paradigma descrito por Dochy (2001) es aquel que denomina la “cultura de la evaluación” (assessment culture). A diferencia del paradigma anterior, sustentado en la memorización de los contenidos, la “cultura de la evaluación” busca que el estudiante adquiera habilidades cognitivas, metacognitivas y sociales específicas. Lo que retiene el estudiante no son los contenidos aislados, sino una red de conceptos y principios desde los que interpreta su realidad y opera con ella. El estudiante se torna un participante activo en el proceso de aprendizaje, tomando parte tanto en las actividades de 8 instrucción como de evaluación. El objetivo de esta perspectiva es evaluar tanto el producto como el proceso. Por lo tanto, el contexto se vuelve un elemento fundamental al construir las evaluaciones. Las tareas intentan ser interesantes, emanadas de situaciones concretas y significativas para el mundo del estudiante. La evaluación no tomará una forma canónica, sino que se evaluará de las maneras que las habilidades a enseñar lo exijan. Así, muchas veces se desarrollarán evaluaciones que contengan preguntas sin una única respuesta correcta, o más difíciles de estandarizar, lo que impacta en la complejidad de cuantificar sus resultados. La prevalencia actual del primer paradigma no solo se explica por la persistencia de ciertos prejuicios sobre el sistema educativo. La facilidad de cuantificar el desempeño de los estudiantes es una característica atractiva para los diseñadores de políticas públicas. Es frecuente la utilización de tests que aportan muy poca información, por ejemplo, tests de opción múltiple, ante la presión por mostrar resultados ante el foro público (Conley, 2015). De esta forma, la instrucción de los estudiantes se adapta a la evaluación de este tipo de pruebas. Los efectos negativos de esta política de evaluación no se han hecho esperar. Por ejemplo, en los Estados Unidos ha existido una baja sostenida entre el 2010 y el 2012 en la prueba PISA, que basa su evaluación en habilidades de nivel superior y transferencia (Darling-Hammond, 2014). Este panorama no es desconocido para Chile, cuyo sistema educacional cuenta con medidas estandarizadas para la medición de la calidad en la educación, en particular, la prueba SIMCE, que se aplica a la totalidad de los alumnos de un nivel desde 1987 (Basualdo, 2007). Si bien la prueba SIMCE ha sido 9 importante para el desarrollo de una institucionalidad e investigación en torno a la calidad de la educación chilena, su implementación ha acarreado algunos déficits (Ramírez, 2011). Similar al caso de los Estados Unidos, Chile ha sido incapaz de remontar en la prueba PISA, con el resultado de que los escolares chilenos están entre los puntajes más bajos entre los países de la OCDE (Moreno, 2014). Bajo este panorama, es razonable pensar en el diseño de nuevas evaluaciones que sirvan para adaptar nuestro sistema educativo a las necesidades de la época en que vivimos. Conley (2015) sugiere que en lugar de construir evaluaciones aisladas que se preocupen solo de un aspecto del aprendizaje se haga el intento de coordinar sistemas de evaluaciones que aporten con un panorama más amplio del conocimiento y aprendizaje de los estudiantes. Tal como afirma Silva (2009), un nuevo modelo de evaluación no solucionará todos los problemas de la educación, pero permite volver a preguntarse qué resultados importan realmente para nuestros estudiantes. 1.3 Pensamiento crítico 1.3.1 Importancia de pensamiento crítico en la educación contemporánea Muchas son las vías que la evaluación de las habilidades del siglo XXI ofrecen a los investigadores en educación. El asunto de la presente investigación es avanzar en la evaluación de la que, en opinión del autor, es la más urgente de desarrollar en el contexto de la educación chilena. Me refiero, por supuesto, al 10 pensamiento crítico. Esta preocupación se refleja, incluso, en el curículum nacional, tanto de Lenguaje y comunicación como de Matemática, que exige a los profesores el desarrollo de esta habilidad desde el tercer grado (Mineduc, 2013ª; Mineduc, 2013b). El interés por el pensamiento crítico tiene antiguos antecedentes en la Grecia clásica, especialmente en el modelo educativo atribuido a Sócrates (Colaiaco, 2013), quien promulgaba el ideal de que todos los valores debían ser examinados por cada ciudadano por su propio juicio racional. Con diferentes matices, este ideal se proyectó históricamente en occidente, cuyo punto cúlmine se encuentra en el ideal ilustrado que Immanuel Kant resumió diciendo “ ¡Ten el valor de servirte de tu propia razón! : he aquí el lema de la ilustración” (1994/1784). ¿Cuál es el valor específico de integrar el pensamiento crítico como habilidad fundamental en la educación contemporánea? La defensa más robusta y coherente ha sido establecida por Martha Nussbaum, quien en su libro Not for Profit (2012) arguye que cultivar la habilidad de pensar críticamente es crucial para mantener la vitalidad de las democracias multiculturales. Según la filósofa, las sociedades actuales están compuestas por una gran diversidad de personas con diferentes parámetros de evaluación. Explica Martha Nussbaum que la habilidad de pensar críticamente “about a wide range of cultures, groups, and nations in the context of a grasp of the global economy and of the history of many national and group interactions is crucial in order to enable democracies to deal responsibly with the problems we currently face as members of an interdependent world” (2012, p.10). 11 Si estas personas viven en una comunidad democrática, se considera que la opinión de cada una debe ser valorada por los mismos estándares de racionalidad. Por esta razón, la presuposición de que tienen la habilidad de pensar críticamente justifica que están capacitados para participar activa y responsablemente como ciudadanos en las decisiones de su comunidad. De esta manera, el pensamiento crítico permite un modelo de democracia que admite modos de participación inclusiva a través de la deliberación pública (Grossman, 2008). Además de su valor democrático, el pensamiento crítico provee numerosas ventajas en el contexto actual de aprendizaje. Por una parte, Paul (1992) explica que la integración de habilidades de pensamiento crítico en la sala de clases permite a los estudiantes comprender la lógica detrás de los contenidos curriculares y, por tanto, hacer más probable la adaptación y transferencia de lo aprendido a nuevos contextos. Por otra parte, Heyman (2008) declara que el pensamiento crítico es fundamental para los estudiantes a la hora de aprender de otros. Según la investigadora, el pensamiento crítico desde edades muy tempranas permite distinguir en qué situaciones se enfrentan a información poco precisa o poco confiable. También Weiler (2005) describe la importancia del pensamiento crítico a la hora de obtener y recuperar información. Esto es especialmente notorio al nivel universitario, donde, según Weiler (2005), los estudiantes presentan gran disparidad en su uso de buscar información, siendo un típico obstáculo para el pensamiento crítico el prejuicio que provoca el conocimiento desde la experiencia personal. Estas ventajas han probado su practicidad en el progreso futuro del estudiante, puesto que se ha mostrado que 12 el nivel de pensamiento crítico permite predecir el desempeño académico del estudiante (Jenkins, 1998; Williams, et al., 2003; Facione, 2007). Una vez explorado el valor del pensamiento crítico en la educación contemporánea, se necesita pensar la manera más adecuada de integrarlo al modelo educativo. En principio, el lugar más adecuado para esta intervención es el currículum. Tal como explica Presseissen (1987), cuando se intenta construir un modelo educacional basado en habilidades, es el currículum el espacio en el que se vinculan los procesos de cognición con los objetivos instruccionales del diseño institucional. En este sentido, es fundamental cuidarse de que esta implementación no sea una mera extensión inorgánica, sino que funcione como el núcleo sobre el que se construya el currículum (Presseissen, 1987). Esta misma recomendación está contenida en Facione (1990), en el que se sugiere una atención explícita en el desarrollo de habilidades de pensamiento crítico como un objetivo instruccional en todos los niveles del currículum de enseñanza escolar. Por sobre todo, la inclusión del pensamiento en el currículum escolar apunta a transformar intelectualmente a los estudiantes, en palabras de Maiorana (1992), rescatándolos de una aceptación pasiva de los contenidos para convertirlos en analistas activos de su realidad. Tal como lo adelantamos en la primera sección, adoptar habilidades, en este caso, el pensamiento crítico como objetivo instruccional del currículum, implica preguntarse seriamente por su implementación. Una de las barreras actuales más importantes es la posibilidad de evaluar adecuadamente el nivel 13 de pensamiento crítico de los estudiantes En la siguiente sección se darán lineamientos apropiados para la evaluación del pensamiento crítico. 1.3.2 Evaluación del pensamiento crítico La evaluación del pensamiento crítico en el currículum es un primer paso para superar la separación entre el estudiante y el conocimiento obtenido, tan propio de la que llamamos “cultura de la prueba”. Esta superación se obtiene al concentrar la evaluación no en los contenidos que adquiere el estudiante, sino en la calidad de su conocimiento, basada principalmente en actividades con propósito (Higgins, 2014). Para lograr esta interacción significativa con el conocimiento del estudiante se requiere que el modelo se mueva de sistemas unidimensionales de evaluación hacia evaluaciones que den una imagen más completa de lo que efectivamente sabe el estudiante (Conley, 2015). A continuación, se delinearán las características que hacen posible construir un test de pensamiento crítico bajo los principios de lo que hemos llamado “nueva evaluación” en la sección 1.2. Brown et al. (2014) explican que todo sistema de evaluación de pensamiento crítico consta tanto de la formulación de un constructo a evaluar elaborado en base a un modelo de cognición específico como de tareas que estén específicamente destinadas a elicitar conductas observables en el desempeño de los estudiantes. La formulación del constructo es una de las tareas más fundamentales y, al mismo tiempo, una de las más complejas en la evaluación de habilidades del 14 siglo 21. La tendencia histórica ha sido fijarse más en la confiabilidad del test que en su validación (Conley, 2015), lo que ha impactado en la construcción de una serie de tests que miden partes discretas de las habilidades en cuestión en lugar del pensamiento crítico como una habilidad compleja compuesta de diversas subdimensiones integradas (Ennis, 1993). Esta dispersión en la evaluación se asocia, en buena medida, a la gran diversidad de definiciones de pensamiento crítico disponibles en la literatura (Kennedy, Fisher & Ennis,1991; Pithers & Soden, 2000; Lai, 2011; Dwyer, 2014). En este sentido, es útil establecer una definición operativa desde un inicio. Una aproximación común al pensamiento crítico es definirlo en relación a las habilidades que lo componen. Van Gelder (2005) arguye que la idea que el pensamiento crítico es una habilidad de nivel superior implica que está compuesto de sub-habilidades más simples y fáciles de adquirir. El intento más serio de establecer un consenso respecto de las habilidades esenciales que componen el pensamiento crítico se encuentra en el Reporte Delphi (Facione, 1990) en el que se determina que las habilidades principales que debiese contener todo concepto de pensamiento crítico son: interpretación, inferencia, análisis, evaluación y explicación. Es importante señalar que gracias a las investigaciones en estas habilidades en particular se ha podido demostrar empíricamente que el pensamiento crítico puede ser evaluado y enseñado operativamente en salas de clases (Butler, et al., 2012; Niu, et al., 2013; Reid & Anderson, 2012). Además, la práctica pedagógica y evaluativa muestran que una comprensión adecuada del pensamiento crítico necesita destacar su aspecto metacognitivo 15 (Halpern, 1998; Ku & Ho, 2010). Se puede describir la metacognición como “the monitoring and control of thought” (Martínez, 2006). Kuhn (1999) explica que la evaluación del pensamiento de acuerdo a criterios presupone la metacognición, ya que en la metacognición el pensamiento se vuelve objeto de nuestro conocimiento. De esta manera, mediante la metacognición podemos monitorear nuestro pensamiento y decidir críticamente qué estrategias desplegar para cada problema concreto (Willingham, 2008). Por lo demás, se ha mostrado a través de análisis de factores que la inclusión de la metacognición en modelos de pensamiento crítico mejora el desempeño experimental de esos modelos (Magno, 2010). Por esta razón, la mejor definición disponible en la actualidad la aportan Dwyer, Hogan & Stewart (2014), quienes componen su concepto de pensamiento crítico en referencia a las habilidades que lo integran y su componente metacognitivo. De esta manera, escriben que el pensamiento crítico es “a metacognitive process, consisting of a number of sub-skills (e.g. analysis, evaluation and inference) that, when used appropriately, increases the chances of producing a logical conclusion to an argument or solution to a problem” (Dwyer, Hogan & Stewart, 2014, p.43) La decisión del tipo de tarea incurre en problemas similares. Uno de los aspectos más difíciles es sobre si las tareas deben desarrollarse en el contexto de un dominio específico o si las tareas deben ser construidas independiente del dominio. Una posición es pensar que el pensamiento crítico es una habilidad general y que, por tanto, su evaluación e instrucción puede practicarse independiente del dominio específico en el que se desarrolla. Este argumento es defendido principalmente por Ennis (1992), Paul (1992), Halpern 16 (1998) y Glaser (1984). La posición contraria se sustenta en que el pensamiento crítico no es tanto una habilidad general, sino una habilidad que se desarrolla en dominios específicos del conocimiento y es, por tanto, altamente dependiente del contexto. Esta idea ha sido expuesta fundamentalmente por McPeck (1981), Bailin (2002) y Willingham (2008). Ku et al. (2014) aclaran que el debate ha tendido a solucionarse mediante un consenso en el que tanto el conocimiento específico juega un rol en el pensamiento crítico, así como también ciertas habilidades transversales. En el caso de la evaluación, sin embargo, existe un menor desarrollo de evaluaciones basadas en dominios específicos (Ennis, 1993). Además, bajo los principios de la nueva evaluación antes mencionados, las evaluaciones deben centrarse en el proceso (Dochy, 2001) y, por tanto, en su construcción se requiere tomar en cuenta el contexto del dominio en el que se desenvuelven (Brown et al., 2014). Por último, se requiere que los evaluadores tengan marcos adecuados a su disposición que les permitan interpretar las respuestas de los estudiantes, es decir, rúbricas. Brown et al. (2014) sugieren que estas rúbricas que no estén construidas desde adjetivos que expresen sus apreciaciones subjetivas, sino que estén basados en características debidamente operacionalizadas del concepto en cuestión (Brown et al., 2014). 1.4 Cultura Los factores culturales condicionan las capacidades de desarrollo de las personas, tanto en su aspecto cognitivo como social (Nussbaum, 2011). La 17 cultura de una comunidad puede ser definida como los valores, reglas y actitudes que definen la particularidad de cada organización (Bordieu, 1993). Estudiar los factores culturales permite observar las maneras en las que las sociedades resuelven problemas y dilemas (Trompenaars & Hampden-Turner, 1998; Schein, 1993). Sin embargo, aunque hay una gran variedad de estudios sobre cultura (Munn, 1992), la particularidad de sus metodologías no los hace siempre apropiados para estudiar la masiva complejidad de las instituciones modernas (Hofstede 2001). Salili, et al. (2001) describen la gran cantidad de estudios empíricos que justifican la influencia de la cultura en el desempeño escolar de los estudiantes. Desde los estudios inaugurales de Pierre Bordieu (2011) se sabe que el capital económico puede ser transformado en capital cultural y ser transmitido por la familia a los estudiantes, lo que provoca muchas veces diferencias en el logro escolar de los estudiantes (Sullivan, 2001). Además, se ha probado que la cultura influye en la cognición más allá del estado neurofisiológico de la persona (Pérez-Arce, 1999). Rueda (2006) sugiere que la cultura da forma a las maneras en que los estudiantes realizan su aprendizaje cognitivo. Bajo esta premisa, Gruenert & Whitaker (2015) sugieren que establecer políticas que tomen en cuenta la cultura en la sala de clases puede mejorar los logros educacionales y enriquecer la vida de los estudiantes en la sala de clases. La investigación de factores culturales en la sala de clases ha sido en su mayor parte de carácter cualitativo (Hofstede, 1986; Deal, et al., 1999; Lieberman, 1988; Lipka & Ilutsik, 2014). La medición de factores culturales en la escuela a través de una metodología cuantitativa permitiría tener tanto información 18 agregada como particular de las dimensiones que constituyen el entramado cultural de cada colegio. Por lo anterior, se requiere crear un instrumento de medición adaptado al contexto escolar que permita su evaluación cuantitativa. El investigador Geert Hofstede ha creado un marco metodológico cuantitativo para poder medir los factores culturales a nivel nacional y organizacional. Hofstede catalogó distintas culturas bajo un número de dimensiones valóricas (Hofstede, 2001). El marco de Hofstede se sustenta en el principio que la cultura es la programación colectiva de la mente (Hofstede & Minkov, 2010). Esta programación ocurre durante toda nuestra vida (Hofstede, 2001). Las personas van adquiriendo poco a poco los valores que determinarán, así como, la manera en que se relacionan con el resto de la comunidad (Hofstede, 2001). Según Hofstede (2001), los valores de una cultura se pueden describir en cinco dimensiones medibles: (1) alta o baja distancia hacia el poder, (2) alta o baja evasión de la Incertidumbre, (3) individualismo o colectivismo, (4) orientación femenina o masculina, (5) orientación a largo o corto plazo (Hofstede & Minkov, 2010). A partir de estos indicadores, Hofstede confeccionó un test para medir estas dimensiones. Este marco teórico, así como el test derivado de dicho marco, sirve de referencia para investigaciones cuya finalidad sea la medición de factores culturales por diversas razones. En primer lugar, este modelo ha sido probado en más de 50 países, por lo que está validado a través de una gran variedad de culturas (Hofstede, 2001). En segundo lugar, tanto el modelo como los test basados en ese marco se encuentran en constante revisión por lo que se 19 mantiene relativamente actualizado (Hofstede, 2001). En tercer lugar, la investigación de Hofstede fue basada en un diseño riguroso y validado durante los años con una colección de datos coherentes (Jones, 2007). En cuarto lugar, Søndergaard (1994) declara que el test de Hofstede es bastante preciso al momento de medir las distintas dimensiones que lo integran. En quinto lugar, es el test de cultura más utilizado por investigadores actualmente a nivel internacional (Jones, 2007). La limitación, en este caso, del test de Hofstede es que, a pesar de la amplia repercusión que ha tenido, solo ha sido aplicado en adultos. No obstante, la edad escolar resulta especialmente interesante para el estudio de la cultura desde este marco, puesto que según explica Hofstede hay una división que ocurre aproximadamente a la edad de 10 años y que marcaría las diferencias de aprendizaje de elementos culturales, tanto en la forma como en el contenido (Hofstede, 2008; Hofstede & Minkov, 2010). Antes de los 10 años, se desarrolla un periodo en el que el aprendizaje cultural ocurre para los niños de forma “rápida y altamente inconsciente”, absorbiendo “la información necesaria del ambiente” (Hofstede & Minkov, 2010, p. 8). En este período, el colegio juega un rol crucial, ya que además de su familia cercana, es el otro espacio de socialización en el que los niños están expuestos a valores socialmente relevantes. Es decir, hasta los 10 años los niños estructuran el conjunto de valores que luego permitirán explicar su acción en sociedad. Al final de este período, el aprendizaje pasa a ser gradualmente consciente y su contenido pasa a estar enfocado principalmente en nuevas prácticas. Los valores, en cambio, serán una estructura relativamente estable (Hofstede, 20 2001; Hofstede, 2008). Es el propio Hofstede (1986) quien puntualizó que estas dimensiones podían ser estudiadas en organizaciones educativas (Hofstede, 1986). Dicho estudio se basó en la observación en colegios y encuestas a profesores de variadas regiones del mundo (Hofstede, 1986). Hofstede indagó en las diferencias que implica la cultura en la sala de clases y cómo ésta puede causar, entre otros problemas, grandes desigualdades entre los patrones esperados de interacción entre profesor/alumno y alumno/alumno; además de disparidades en la relevancia del currículum educativo (Hofstede, 1986). Por las razones previamente mencionadas, es razonable pensar que una adaptación del test de Hofstede al contexto escolar podría medir factores culturales en la sala de clases y permitir su integración a los modelos de evaluación de habilidades cognitivas. 1.5 Modelo de evaluación de pensamiento crítico y cultura 1.5.1 Relación entre pensamiento crítico y cultura Cuando se estudia pensamiento crítico y sus relaciones con otros factores, en general la investigación se ha centrado en sus efectos en aspectos académicos, de instrucción, plan de estudios, y diferentes campos disciplinarios (McMillan, 1987; Tsui, 1998; Tsui, 2000). Sin embargo, se le ha dado poco énfasis a temas como la relación del desarrollo cognitivo, el pensamiento crítico y las relaciones entre alumno/alumno y profesor alumno (Ennis, 1998; Tsui, 2000). Estas relaciones están directamente vinculadas con la cultura de la institución a la cual los estudiantes pertenecen (Hofstede, 2001). 21 Cole (1971) explica que el desarrollo cognitivo está influenciado por las demandas del ambiente en el que el alumno se desenvuelve. En buena medida, las habilidades cognitivas de los individuos se basan en los patrones totales de una sociedad, por lo tanto, de su cultura (Hofstede, 1986). Así, estudios han encontrado diferencias significativas en el grado en que personas de diferentes culturas procesan la información y complementan ésta con conjeturas determinadas por el propio entorno (Sckade et al., 1978; Bennett, 1997). Por tanto, muchas veces resulta problemático enseñar a un estudiante con un perfil de habilidades cognitivas distintas de aquella a las que el profesor está acostumbrado (Hofstede, 1986). Según Hofstede (1986), no hay otra solución para disminuir esta brecha cultural sino aumentar la conciencia sobre estas diferencias, en un esfuerzo sostenido por ambas partes, centrándose especialmente en las nuevas capacidades demandadas por los cambios sociales del momento. Así, vale la pena vincular el problema de la influencia de la cultura sobre el desarrollo de habilidades, para facilitar su implementación en el aula. En particular, con habilidades de pensamiento crítico que permitieran educar acerca de las brechas culturales antes mencionadas. Se reconoce que la educación — y en particular los tipos de habilidades y valores que se nutren de dicho entorno — tiene una influencia en el uso del pensamiento crítico de los estudiantes (Manalo et al., 2013). Pensar críticamente está profundamente entrelazado con los antecedentes culturales de un individuo y lo que tenemos que hacer frente a las diferencias culturales (Hill & Shadija, 2010). Sin embargo, si se sostiene que la cultura del alumno afecta directamente en su proceso de aprendizaje y su desarrollo cognitivo (Kuh, 22 1990; Tsui, 2000), entonces es necesario establecer el modo específico en que esta influencia opera. Esto se vuelve urgente si se toma en cuenta que la evaluación e instrucción de pensamiento crítico puede ser afectada por ciertos prejuicios culturales (Bailin, 1995). Urdan & Giancarlo (2000) sugieren que todavía no está claramente establecido el grado en que los factores culturales afectan el pensamiento crítico, aunque luego recopilan una serie de estudios incipientes en esta dirección. Un ejemplo más reciente se encuentra en Bates (2001) y Bates & Poole (2003) quienes describen la manera en que provenir de una cultura diferente a la del profesor y el resto de los compañeros puede afectar el nivel en que un estudiante utiliza sus habilidades de pensamiento crítico. Manalo et al. (2013) realizaron un experimento cuyos resultados sugieren que existe una influencia de la cultura en el pensamiento crítico, pero que, sin embargo, esta influencia no es directa ni está necesariamente vinculada al origen geográfico del estudiante. Kurtz (1990) en particular propone que la cultura funciona como un mediador tanto los procesos cognitivos como metacognitivos en los niños. Esta mediación, según Kurtz (1990), se despliega en factores motivacionales y ambientales, en particular aquellos que se desarrollan en la familia y la escuela. La idea de que la cultura media los procesos cognitivos de nivel superior está en plena concordancia con el paradigma de la sicología cognitiva y educacional de Vygotsky. Según esta tradición, el ser humano interactúa con su ambiente utilizando los signos y herramientas creados por su sociedad. Sin embargo, tal como la comunidad que los crea, estos mediadores cambian con el tiempo (Vygotsky, 1980). Esta mediación, en el caso de las funciones mentales 23 superiores, pasa necesariamente por las relaciones sociales que la persona tiene con el resto de la comunidad y está, por tanto, en constante relación con la cultura de la sociedad específica en la que emerge (Wertsch, 2009). De esta manera, la cultura se constituye en el principal mediador de las funciones cognitivas superiores, entre las que podemos contar, por supuesto, al pensamiento crítico. 1.5.2 Modelo de mediación La consecuencia metodológica de seguir esta línea teórica es, entonces, la construcción de un modelo que tome en cuenta el carácter mediador de la cultura en el pensamiento crítico. Tal como Mackinnon et al. (2007) lo consideran, gran parte de los modelos de investigación se centran en relaciones entre dos variables. Los modelos de mediación, en cambio, permiten explicar la influencia de una tercera variable sobre la relación entre las dos variables previas. Para comprender el análisis de mediación podemos recurrir a un ejemplo presente en Fairchild & McQuillin (2010). El ejemplo supone la implementación de un programa de mejora de la lectura en un colegio (variable independiente, X) para incrementar el rendimiento en un test de competencia lectora (variable dependiente, Y). Siguiendo este modelo, se podría medir el efecto de dicho programa (X) en la competencia lectora (Y) comparando la diferencia en el rendimiento de la competencia lectora antes y después de la aplicación del programa. Pero, quizás, este no es el panorama completo. En este caso, se podría complejizar el modelo al introducir como variable 24 mediadora la fluidez oral en la lectura del estudiante (variable mediadora, M). De esta manera, tendríamos acceso a la variable que, en realidad, está causando la mejoría en la competencia lectora. Un modelo de mediación consta, por lo tanto, de tres tipos de variables como se muestra en la figura 1. Una variable independiente, una variable dependiente y una variable mediadora. Figura 1: Modelo de mediación Al aplicar el modelo de mediación a las variables de nuestro interés se deriva la siguiente hipótesis de mediación: la cultura media la relación positiva entre pensamiento crítico y comprensión lectora. De esta manera, el pensamiento crítico actuará de variable independiente, el desempeño en un test de comprensión escrita actuará de variable dependiente y la cultura actuará de variable mediadora, tal como lo muestra la figura 2. 25 Figura 2: Modelo de mediación aplicado a las variables de pensamiento crítico y cultura Para probar la mediación que efectúa la cultura entre el pensamiento crítico y la comprensión resulta adecuado utilizar el método tradicional de testeo desarrollado por Baron & Kenny (1986). Este método consta de cuatro pasos, ilustrados en la figura 2 y explicados a continuación. Figura 3: Método de testeo de un modelo de mediación. Primero, se realiza una regresión (τ) para saber si la variable independiente (X) predice la variable dependiente (Y). 26 Segundo, se realiza una regresión (α) para saber si la variable independiente (X) predice la variable mediadora (M). Tercero, se realiza una regresión (β) para saber si la variable mediadora (M) predice la variable dependiente (Y). Cuarto, se realiza una regresión (τ’) para saber si la variable independiente (X) no predice la variable dependiente (Y), mientras se controla por la variable mediadora (M). Si todos los pasos tienen resultados significativos, entonces la mediación es total. Si, en cambio, en el paso cuarto la regresión entre la variable independiente (X) y la variable dependiente (Y) sigue siendo significativa, mientras se controla por la variable mediadora (M), entonces la mediación es parcial. 27 2. TAREAS IMPLEMENTADAS. DISEÑO Y VALIDACIÓN DE TEST DE PENSAMIENTO CRÍTICO Para implementar el modelo de mediación de pensamiento crítico y cultura es necesario la construcción y validación de instrumentos que midan los factores indicados. En lo que sigue se explicará cuál fue el proceso de construcción del test de pensamiento crítico y su posterior validación, es decir, un vértice del triángulo que constituye el modelo. El test de cultura aún está en proceso a la fecha de la escritura de esta tesis. 2.1 Test de pensamiento crítico. 2.1.1 Introducción La inclusión del pensamiento crítico en la educación escolar es uno de los aspectos centrales en la discusión sobre las principales habilidades identificadas como necesarias para el siglo XXI (Greenhill, 2009). Se ha dicho que el pensamiento crítico es un prerrequisito esencial para la actividad humana responsable (Marques, 2012), y fundamental para el desempeño social, laboral y ético de los ciudadanos (Griffin, McGaw & Care, 2012; Greenhill, 2009). El desarrollo de habilidades de pensamiento crítico provee a los individuos con las herramientas necesarias para tomar decisiones por sí mismos y no dejarse convencer por creencias que carezcan de evidencias sólidas (Halpern, 2003; Mulnix, 2012). Existe una amplia gama de definiciones de pensamiento crítico desde posturas más filosóficas vinculadas al pensamiento clásico y al desarrollo humano (Nussbaum, 2011) hasta perspectivas destinadas a su recepción y desarrollo en 28 las disciplinas educativas (Facione, 1990; Halpern, 2003; Bailin, 2002). No obstante las distintas tendencias, se puede identificar que uno de los componentes esenciales del pensamiento crítico está centrado en que se trata de un proceso metacognitivo. El pensamiento crítico involucra competencias que nos permiten no solo pensar sobre el mundo (habilidades de primer orden), sino pensar sobre el pensamiento (habilidades de segundo orden) (Kuhn, 1999; Halpern, 2003). El carácter metacognitivo tiene consecuencias instruccionales y está en directa relación con la percepción y comprensión del contexto (Halpern, 2003). Así, por ejemplo, se ha establecido que los procesos metacognitivos vinculados al pensamiento crítico son un componente fundamental en la transferencia del conocimiento obtenido (Nickerson, 1988). En este trabajo se utilizará una definición que haga explícito este vínculo con la metacognición definiendo el pensamiento crítico como "a metacognitive process, consisting of a number of sub-skills (e.g. analysis, evaluation and inference) that, when used appropriately, increases the chances of producing a logical conclusion to an argument or solution to a problem" (Dwyer, Hogan & Stewart, 2014, p.43). La importancia del pensamiento crítico en el ámbito educacional está justificada por décadas de desarrollo teórico y práctico (Lai, 2011). Su inclusión en los currículum escolares es ampliamente reconocida, al menos, a partir de la influencia de John Dewey en la primera mitad del siglo XX (Bean, 2011). Facione (1990) recomienda que el desarrollo del pensamiento crítico sea un objetivo en todos los niveles del currículum K-12. En este sentido, la instrucción del pensamiento crítico en la educación escolar debería incluir la instrucción de estas habilidades integradas a las actividades en el aula (Bailin, 29 et al. 1999). Es importante que la inclusión del pensamiento crítico sea a una edad temprana, puesto que se han revelado diferencias significativas entre los alumnos con educación temprana y los que no (Osakwe, 2009). Sin embargo, aunque la relevancia del pensamiento crítico se haya defendido sostenidamente en materias educacionales a nivel mundial, no hay un desarrollo suficiente de su medición por medio de actividades en la sala de clases. Según la UNESCO (2000), se necesita la medición de los resultados del aprendizaje de esta habilidad para mejorar la calidad de la educación. Yeh (2001) ha declarado que si se acepta que los test guían el currículum y la instrucción, una manera eficiente de mejorar la calidad de la educación en pensamiento crítico es construir mejores test. La literatura ha reconocido que para medir el pensamiento crítico de manera relevante se requiere conocimiento específico del dominio en el que se desenvuelve (Facione, 1990; Ennis 1989; McPeck 1981; Bailin, 2002; Willingham, 2008). Esto es especialmente relevante porque para evaluar a los niños en la sala de clase, tal como explica Whitcomb & Merrell (2013), la evaluación debe ser situada y tomar en cuenta el dominio específico. Esto se deriva del peso que los distintos dominios dan a diferentes evidencias o explicaciones según los objetivos de la tarea que se requiera realizar (Bailin, 1999). De esta manera, aunque se pueda conceder un cierto nivel de generalidad a las habilidades de pensamiento crítico, su utilidad depende de su conexión con un dominio específico de conocimiento (McPeck, 1981). Ennis (1989) recomienda que el mejor nivel para enseñar crítico es durante los primeros años de la enseñanza básica. Esta recomendación es coherente con 30 estudios que concluyen que los niños en edad temprana se benefician de su instrucción y evaluación (Kennedy et al, 1991). Sin embargo, los test disponibles no están diseñados para niños en edades tempranas ni tampoco para dominios específicos sino que solo miden el pensamiento crítico como una habilidad general (Ennis & Millman, 1985; Watson & Glaser, 1980; Facione, 1990; Ennis & Weir, 1985; Halpern, 2003). Por tanto, al enfrentar este problema, emerge la primera pregunta de investigación ¿Cómo diseñar y validar un test que distinga el nivel de pensamiento crítico en niños de educación primaria en un dominio específico? La relación entre el estrato socioeconómico y la adquisición de habilidades tiene su mejor representante en Bourdieu, quien indica que la acumulación de capital económico puede transferirse al interior de la sociedad en la forma de capital cultural acumulado en la forma de habilidades y competencias educacionales (Bourdieu, 2011). Se ha identificado que el estrato socioeconómico del estudiante influye substancialmente en sus logros educacionales (Breen & Goldthorpe, 1997); asi en tercer grado se ha visto que la pobreza y las habilidades lectoras impactan en el éxito de los estudiantes en niveles educacionales más avanzados (Hernández, 2011). Hay autores que plantean que existe una influencia plausible del estrato socioeconómico de proveniencia del estudiante respecto de su nivel de pensamiento crítico (Cheung et al., 2001). Así es como surge la segunda pregunta de investigación, ¿Qué diferencias existen en el nivel de pensamiento crítico, en estudiantes de tercer y cuarto grado, según su nivel socioeconómico? 31 2.1.2 Metodología 2.1.2.1 Definición del test. En una primera etapa se realizó un estudio bibliográfico en el que se determinó el modelo de pensamiento crítico. Este modelo tiene por objetivo generar un scaffolding adecuado de las habilidades que componen el pensamiento crítico. Se considera que un scaffolding apropiado es fundamental para promover el pensamiento crítico (Kim et al., 2013), ya que permite la enseñanza explícita de dichas habilidades en el contexto del aula (Halpern, 2003) y ayuda al profesor a monitorear la manera en que esas habilidades son aprendidas. Se considera que al enseñar habilidades de nivel superior, especialmente la construcción de explicaciones, necesita la guía de un scaffolding apropiado para su exitosa realización por niños en los últimos niveles de escuela primaria (Songer & Gotwals, 2012). Este modelo se basó en el Reporte Delphi (Facione, 1990), en el que un grupo de expertos definió que las habilidades principales de un pensador crítico son interpretación, análisis, inferencia, evaluación, explicación y auto-regulación. Además, el modelo integra los conceptos de transferencia y metacognición (Halpern, 2003). El modelo propuesto se sustenta en un scaffolding secuencial en el que los estudiantes se enfrentan a la elaboración de sus pensamientos (interpretación), evalúan soluciones (evaluación), exploran y clarifican inconsistencias o faltas de información (análisis e inferencia), y, finalmente, explican los resultados de su proceso mental (explicación). La secuencia integra habilidades de nivel superior (análisis, interpretación e inferencia) con procesos metacognitivos 32 (evaluación y explicación), producido por la formación explícita de argumentos sobre la narrativa propuesta. Se le otorga un peso especial a la explicación, puesto que las estrategias cognitivas que los estudiantes utilizan al explicar están fuertemente guiadas por la metacognición (McNamara & Magliano, 2009). Para rastrear los procesos explicativos, se integraron preguntas que exigen argumentación, pues según muestran Berland & Mcneill (2012) los procesos de explicación ocurren en conjunto con los procesos de argumentación. Operativizar el pensamiento crítico en términos de argumentación simplifica la implementación de la medición de esta habilidad (Yeh, 2001). La argumentación es relevante, especialmente, a la hora de medir pensamiento crítico, puesto que es una de las herramientas más efectivas para discriminar entre proposiciones sostenidas en evidencias y meras opiniones (JiménezAleixandre & Puig, 2012). En una segunda etapa se definió el dominio en el que se construiría el test. La posibilidad de integrar habilidades de pensamiento crítico tempranamente se justifica en experimentos que demuestran que los niños pueden realizar actividades que impliquen este tipo de habilidades con igual éxito que los adultos (Gelman & Markman, 1987; Willinghman, 2008). Bajo esta perspectiva, se estimó que la edad más temprana posible para ser efectivo el test es el tercer grado, porque entre 3 y 5 grado la mayoría de los estudiantes son capaces de decodificar y usar la mayoría de las palabras (Swaggerty, 2015). 33 El pensamiento crítico tiene un impacto importante en el aprendizaje de habilidades asociadas al ámbito del lenguaje. Por ejemplo, Nippold, et al. (2015) demostraron que las tareas basadas en pensamiento crítico elicitan oraciones de mayor complejidad sintáctica que tareas basadas en conversaciones. Chapman (2014) sugiere que el aprendizaje de habilidades de pensamiento crítico mejora el desempeño de estudiantes en el TOEIC (Test of English for International Communication). Además, O’Flahavan & Tierney (2013) sugieren que la lectura y la escritura son herramientas muy productivas para la promoción del pensamiento critico. Es por esto que el dominio estudiado fue lenguaje y comunicación. Así, se decidió elaborar una adaptación de la trama de una historia culturalmente conocida. Como criterios para la selección de la historia se tuvo en cuenta que entre los 8 y los 10 años el pensamiento de los estudiantes se vuelve más lógico, mejora su memoria y sus habilidades intelectuales y aprecia el humor (Das, 2013). En este sentido, se siguió la recomendación de Moore & Zigo (2005) de utilizar el género de la ciencia ficción, ya que fomenta la lectura crítica y creativa. Por esta razón, se utilizó la novela clásica de Julio Verne La vuelta al mundo en 80 días, adaptada para niños de tercer grado. Esta adaptación se utilizó de soporte para integrar las preguntas del test de pensamiento crítico. En una tercera etapa, se estimó necesario utilizar una narrativa gráfica y textual para favorecer la aplicación del test. Esta decisión se basa en el lugar privilegiado que tienen los formatos visuales en nuestra cultura (Emmison & Smith, 2000; Sturken & Cartwright, 2001), cuya consecuencia es que los 34 estudiantes, especialmente en los primeros años de formación, aprenden básicamente a través de recursos visuales (Downey, 2009). Frey & Fisher (2004) reconocen que el uso de narrativas gráficas y textuales puede estimular el interés de estudiantes desalentados por los formatos tradicionales de lectura. Además, se considera que este tipo de narrativa fomenta aspectos tradicionales del currículum de lenguaje y comunicación, como la alfabetización (Schwarz, 2006). Otro argumento por el que se consideró este formato se debe a que es el soporte adecuado para la inclusión de elementos de alfabetización visual asociado a los estándares de evaluación de pensamiento critico (Facione, 1990; Lazo & Smith, 2014). Hassett & Schleble (2007) sugieren que al leer narrativas gráficas y textuales los estudiantes no solo mejoran sus habilidades lectoras básicas, sino que encuentran nuevas formas de pensar en la articulación de la imagen y el texto. Luego, se definieron una serie de criterios de desempeño para cada habilidad establecida en el marco teórico (tabla 4 del anexo 1) (Facione, 1990). La evaluación de estos criterios, a través de la construcción de actividades de lecto-escritura, sirvieron para determinar el nivel de pensamiento crítico y, por tanto, la narrativa tiene que estar estructurada en torno a dichos criterios. Para cada uno de estos criterios de desempeño, se crearon preguntas de forma tal que cubrieran todas las habilidades (interpretación, análisis, inferencia, evaluación y explicación). Hubo una mayor concentración de preguntas en la habilidad de explicación. Esta decisión se justifica en que, las estrategias cognitivas que utilizan los estudiantes al explicar, están fuertemente guiadas por la metacognición (McNamara & Magliano, 2009). Este vínculo es 35 especialmente importante en la construcción de preguntas de pensamiento crítico, ya que al explicar el estudiante no solo elabora sobre los contenidos de la pregunta, sino que la explicación también puede derivar en consideraciones metacognitivas como analizar el tipo de tarea y distintas estrategias de solución (Flavell, 1979). Este énfasis en la metacognición se debe a que este proceso articula el pensamiento crítico (Dwyer, 2014). De esta manera, se estimó que utilizar actividades cortas de escritura basadas en preguntas era lo más provechoso, por ser una estrategia instruccional particularmente efectiva en la evaluación del pensamiento, ya que proveen una aproximación a los procesos mentales del estudiante a través de materializar su argumentación (Bean, 2011). Además, se decidió que las preguntas aparecerían en el transcurso de la historia, ya que se ha comprobado que el uso de esta estrategia es más efectiva que preguntar al final de la historia (Van Den Broek, et al., 2011). Por ejemplo, en la figura 4 se muestra una de las escenas de la narrativa gráfica y textual acompañada de una pregunta para el estudiante. En esta escena uno de los personajes (el Detective) intenta engañar a otro personaje (Martín) mediante el uso de un disfraz basado en un bigote falso. La interacción entre la acción de disfrazarse y su despliegue visual en el bigote permite medir los siguientes factores: primero, interpretación al determinar el papel de las imágenes visuales en una narración, ya que el estudiante tiene que ser capaz de entender cuál es la función del objeto como parte del disfraz y no una característica innata del personaje; segundo, evaluación, al determinar los beneficios y dificultades de una opción. En este caso, el estudiante evalúa si el bigote cuenta como un buen o un mal disfraz para el propósito de engañar. Tercero, 36 explicación, al explicitar los estándares utilizados para evaluar en la escritura, en el ejemplo, el estudiante no solo necesita decidir por una opción u otra sino además fundamentar cuál es la razón de su evaluación (Facione, 1990). Los correctores evaluarán si la respuesta cumplía o no con los criterios propuestos y asignarán un puntaje de 1 si consideraba que se cumplían y 0 en caso contrario. Las pautas de corrección se definieron con la asesoría de dos expertos en educación y lenguaje, con el fin de comprobar que los ejercicios concordaban con la habilidad que se pretendía medir. Figura 3: Ejemplo de pregunta 2.1.2.2 Criterios de validación del instrumento. Para validar el instrumento, se utilizaron los criterios de validez del constructo, validez del contenido y validez de criterio (Brown, 2000; Wolming, 1998), además de la medición de la confiabilidad mediante Alpha de Cronbach 37 (Cronbach, 1971). Estos análisis fueron acompañados con un análisis de ítems, cuyo propósito es obtener datos que señalen la necesidad de revisar, seleccionar y eliminar ítems muy difíciles, muy fáciles o que no discriminan (Nitko 1996). Como evidencia para la validez del constructo, se realizó un ANOVA bajo la hipótesis de que existirían diferencias significativas de pensamiento crítico entre el tercer y el cuarto grado (Brown, 2000). La presencia de esta diferencia valida el constructo, puesto que es coherente con las investigaciones que identifican que el nivel de pensamiento crítico vinculado a la metacognición aumenta con la edad (Veenman, Wilhelm, & Beishuizen, 2004). Esto se explicaría porque mientras que en tercer grado los estudiantes pueden realizar explicaciones causales, predicciones simples (Hapgood, et al., 2004) y analogías parcialmente correctas (May, et al., 2006), desde el cuarto grado en adelante ya son capaces de diseñar estrategias para resolver problemas, definir tareas y monitorear sus pensamientos (Hudgins, et al., 1989). Para demostrar la validez del contenido se utilizó un panel de expertos (Rubio et al., 2003), conformado por un experto en el área de educación y otro experto en el área de filosofía y lenguaje, de los cuales se obtuvo el grado de concordancia con el de los desarrolladores del instrumento (Dillashaw and Okey, 1980; Nitko. 1996). Además, se agregaron para la validez del contenido cuatro sesiones de think aloud con estudiantes de las edades en estudio (Ericsson & Simon, 1993; Flaherty, 1974), tal como se recomienda en Facione (1990). 38 Considerando que se han encontrado correlaciones entre tests de pensamiento crítico y las notas escolares de estudiantes secundarios chilenos (Santelices et al., 2011) se utilizó el Pearson product moment correlation entre los resultados del test y las notas en lenguaje con el fin de examinar la criterion validity. Se utilizó esta estrategia de muestreo por conveniencia debido a que, no estuvo la posibilidad de acceder al registro de notas de todos los estudiantes (Ary et al, 2013). Además, se condujo un análisis de la confiabilidad del test a través del Alpha de Cronbach, índice que mide la consistencia interna del test (Cronbach, 1971). Luego, se aplicó un análisis de ítems a los resultados con el fin de identificar a través de datos objetivos, en este caso, los índices de dificultad y discriminación de cada ítem, señales que indiquen la necesidad de revisar, eliminar o modificar ítems (Nitko, 1996). Estos índices por ítems fueron clasificados según la dimensión de pensamiento crítico que medían para luego observar qué área fue más y menos difícil para los estudiantes. 2.1.2.3 Trabajo Experimental Para estudiar la relación entre pensamiento crítico y nivel socioeconómico se eligió un muestreo estratificado de acuerdo a los tres tipos de establecimientos que se encuentran en el sistema educacional chileno (público, particular subvencionado y particular). Cada establecimiento corresponde a un nivel socioeconómico: bajo, medio y alto, respectivamente (Gallego, 2002). Por otro lado, para estudiar la validez de constructo se trabajó con dos grados, 3º y 4º. Los participantes de la muestra, Tabla 1, incluyeron 301 estudiantes de terceros y cuartos básicos de los tres tipos de colegios. Se decidió utilizar un diseño de 39 ANOVA para comprobar la existencia de diferencias significativas entre los distintos grupos. Tabla 1: Participantes en el estudio según nivel socioeconómico y género Tercer grado Género / Nivel socioeconómico Alto Medio Bajo Masculino 55 13 17 Femenino 47 17 14 Total 102 30 31 Género / Nivel socioeconómico Alto Medio Bajo Masculino 40 14 18 Femenino 42 14 10 Total 82 28 28 Fourth Grade 2.1.3 Resultados 2.1.3.1 Validez del constructo El test de Shapiro-Wilk indicó que no había normalidad en la distribución de los alumnos de tercer y cuarto grado, (valor de 3.246e-06 pata tercero y 1.613e-07 para cuarto). Por su parte, el test de Barlett indicó que las varianzas de los grupos en estudio eran homogéneas (valor de 0.3007). Aunque el supuesto de normalidad de las distribuciones no se cumplió, según Sheng (2008) el ANOVA es un test robusto, por tanto, es posible utilizarlo aunque algunos supuestos fueron violados. Para esto se utilizó el test de Kruskal- 40 Wallis como una alternativa no paramétrica ante la violación del supuesto de normalidad (Osborne, 2008). El test para identificar la validez del constructo del instrumento indicó que hay diferencias significativas entre los niveles de tercer y cuarto grado con un p<0.001. 2.1.3.2 Validez del contenido Un panel de expertos que examinó la correspondencia entre las preguntas y los objetivos planteados según el marco de pensamiento crítico tuvo más de 70% de acuerdo con el instrumento creado, lo que está dentro de los valores aceptados. Los Think Alouds sirvieron, además, para identificar incomprensiones y distorsiones en la redacción de las preguntas que fueron corregidas en la versión final aplicada a la muestra grande. 2.1.3.3 Validez de criterio y Pearson product-moment correlation La Pearson product-moment correlation entre los resultados del test y las notas de los estudiantes fueron 0.805 para el tercer grado y 0.732 para el cuarto grado, que Dancey & Reidy (2004) clasifican como una correlación fuerte (<0.7), lo que constituye una evidencia robusta para la validez de criterio. 2.1.3.4 Confiabilidad Se encontró un Alpha de Cronbach de 0.917 para el test antes del análisis de ítems. Luego de realizado el análisis, el Alpha de Cronbach final resultó en un valor de 0.909, lo que muestra que el test es confiable (George & Mallery, 2003). Este segundo valor corresponde al resultado después de analizar los 41 ítems de acuerdo a su nivel de dificultad y discriminación como se muestra en la sección siguiente. 2.1.3.5 Análisis de ítems. Los resultados del análisis de ítems se organizaron de acuerdo a la dimensión de pensamiento crítico medida, con respecto a su dificultad y discriminación tal como lo muestra la tabla 2. Para este estudio se seleccionó un rango entre 0.4 y 0.6, ya que, siguiendo a Womer (1968), este rango determina que una pregunta es apropiada para ser incluida como parte de un instrumento de medición. Además, Nitko (1996) explica que aquellos ítems con índice de dificultad menor a 0.2 y mayor a 0.8 deben ser rechazados por ser muy fáciles o muy difíciles, recomendación que seguimos en este instrumento. Por último, se decidió que los ítems con índice de dificultad entre 0.2 y 0.4, y aquellos con índice de dificultad entre 0.6 y 0.8 se integrarían siempre que aportaran con la coherencia de la narrativa sobre la que estaba construido el test y aportaran mayor información. Por otro lado, se consideró que un índice de discriminación era aceptable para un ítem si es mayor a 0.3, por tanto, aquellos ítems sobre 0.3 se consideraron buenos y aquellos con una discriminación bajo 0.3 se consideraron malos (Adkins, 1974; Hinkle, et al, 2003; Nitko, 1996). Un resumen de la distribución de todas las preguntas de acuerdo a su dificultad y su discriminación, indicando la dimensión y sub-dimensión a la que pertenecen se encuentra en tabla 4 en el Anexo. Al observar los resultados de la Tabla 5 (anexo) se aprecia que Análisis es la dimensión con mayor dificultad y menor discriminación con un índice de 42 dificultad promedio de 0.36 y un índice de discriminación promedio de 0.38. Por otro lado, la dimensión con menor dificultad fue Interpretación con un índice de dificultad promedio de 0.62. Se definió según los criterios de Womer (1968) de dificultad y discriminación de los ítems, aquellos que, en primera instancia, formarían parte del test (ítems 2a, 3, 4, 6a, 10, 14b, 22, 23b, 27a). Por otro lado, siguiendo los criterios de Nitko (1996), se determinó que se incluirían tambien los ítems (1a, 2b, 7, 8, 11, 12, 13, 14a, 16, 17a, 17,b, 18, 19a, 19b, 21, 26, 28a, 28b, 29a, 29b), con el fin de obtener mayor información, mientras preservaran la coherencia total del test. Por último, se eliminó un ítem(6b) que tenía correlación 1 con otro que apuntaban al mismo indicador de logro. De esta manera, como se muestra en la tabla 5 (anexo), se obtuvieron valores de dificultad y discriminación dentro de los rangos sugeridos arriba por Womer (1968) y Nitko (1996). Tabla 2: Resumen discriminación y Dificultad por pregunta Discriminación/ Difícil (<0.2) Dificultad (0.2-0.4) Apropiado (0.4-0.6) (0.6-0.8) Fácil (>0.8) Malos (<0.3) 2 ítems 2 ítems 0 ítems 0 ítems 2 ítems Buenos (>0.3) 1 ítem 5 ítems 10 ítems 18 ítems 2 ítems 2.1.3.4 Diferencias entre colegios Se realizó una comparación entre los grupos de los distintos establecimientos educacionales. Esto fue posible, ya que aunque la distribución de uno de los grupos no cumplía con el supuesto de normalidad para el test de Shapiro-Wilk 43 (alto: 3.208e-05, medio: 0.07288, bajo: 0.0207) y las varianzas no eran homogéneas con un test de Bartlett de 1.063e-07, el ANOVA es un test robusto y permite la violación de supuestos (Sheng, 2008). Por tanto, se utilizó el test de Kruskal-Wallis, una alternativa no paramétrica al test de ANOVA (Osborne, 2008). Se identificaron diferencias significativas entre los grupos de estratos socioeconómicos con un p<0.001. Luego, un test de Tukey post hoc mostró que las diferencias eran significativas at p >0.05 entre todos los grupos entre sí. Para analizar más detalladamente estas diferencias, en la Tabla 3 se muestran los puntajes promedio del test por establecimiento, además de la desviación estándar. Se ve claramente que en el colegio de estrato socioeconómico más alto, los puntajes son considerablemente más altos (22.15 para cuartos y 19.3 para terceros) que los colegios de estrato medio (14.75 para 4 y 10.73 para terceros) y bajo (10.61 para cuartos y 6.97 para terceros). Por otro lado, uno de los resultados relevantes en este aspecto es que la desviación estándar del colegio de estrato socioeconómico alto, baja considerablemente del tercero al cuarto básico un 28% (de 4.55 a 3.27 puntos), en el colegio de nivel medio, la desviación se mantiene prácticamente igual (6.95 comparado a 6.97 en estudiantes de tercer grado). Por último, el colegio de nivel bajo muestra un retroceso, demostrando un aumento en la desviación estándar de sus puntajes de 6.2 a 6.06 puntos. Esto, podría sugerir que en el colegio de sector socioeconómico alto se reduce la diferencia entre el rendimiento, mientras que en los otros colegios, esto no sucede. Tabla 3: Promedios por curso y tipo de colegio 44 Estrato socioeconómico Curso Promedio Alto Alto Medio Medio Bajo Bajo 22.15 19.3 14.75 10.73 10.61 6.97 4 3 4 3 4 3 Desviación estándar 3.27 4.55 6.95 6.97 6.20 6.06 2.1.4 Conclusiones El objetivo de este artículo fue responder las siguientes dos preguntas de investigación. Primero, ¿ Cómo diseñar y validar un test que distinga el nivel de pensamiento crítico en niños de educación primaria en un dominio específico? Para eso se efectuó el diseño y validación de un test de pensamiento crítico para el dominio de lenguaje y comunicación mediante el uso de una narrativa gráfica y textual. Se cumplió este desafío, validando el test para tercero y cuarto grado. Es interesante notar que no existen otros tests que hayan utilizado el formato de la narrativa gráfica con apoyo textual para medir el nivel de pensamiento crítico en estudiantes en los niveles de tercer y cuarto grado. El desarrollo de test que integren narrativas gráficas y textuales tiene ventajas instruccionales en términos de la motivación e interés de los estudiantes (Chase, et al., 2014), el desarrollo de habilidades de nivel superior (Pantaleo, 2014), su efectividad para la enseñanza de la alfabetización (Jennings, et al., 2014) y el soporte para lectores con dificultad de visualizar historias (Lyga, 2006). Queda como trabajo futuro validar instrumentos en otros dominios específicos, como en ciencias y matemáticas, La principal limitación del instrumento es el contexto cultural donde se desarrolló. Considerando que los factores culturales son especialmente 45 importantes en el desarrollo del pensamiento crítico en clases de lenguaje (Guo, 2013), por ejemplo, el registro de efectos significativos de la cultura en el pensamiento crítico de estudiantes de educación superior en actividades de escritura de blogs (Shahsavar, 2014) o la influencia de la cultura institucional sobre el pensamiento crítico de los estudiantes (Tsui, 2000). Es importante recalcar también que, como el marco conceptual se realizó dentro de un contexto cultural específico, un grupo de estudiantes podría estar en una desventaja respecto a otro grupo por la estructura del test y no por una diferencia en su nivel de pensamiento crítico (Howe, 1995; Childs, 1990). Es necesario como trabajo futuro estudiar cómo afecta la cultura local este marco conceptual de pensamiento crítico. Adicionalmente, es necesario estudiar cómo afecta la cultura local tanto la comprensión de imágenes como la estructura narrativa en el desempeño del instrumento. La cuantificación de factores culturales ha sido estudiada por Hofstede (2001) en adultos, pero es incipiente su medición en niños (Hofstede, 1986). El desarrollo de una herramienta en este sentido colaboraría con la robustez del desarrollo de un instrumento de pensamiento crítico para niños en distintas realidades culturales. Segundo, una vez validado el test, se resolvió indagar la pregunta sobre ¿Qué diferencias existen en el nivel de pensamiento crítico dependiendo del tipo de colegio al que asiste el alumno? En este sentido, se encontraron diferencias significativas entre los grupos socioeconómicos por establecimiento educacional. Esto sugiere que podría haber una relación entre el estrato socioeconómico y el desarrollo de la habilidad de pensamiento crítico. Esto es especialmente notorio al observar que mientras que en el colegio de estrato 46 socioeconómico alto la desviación estándar se reduce, aumentando la homogeneidad de los estudiantes, en los otros establecimientos la desviación estándar se mantiene. Aunque se necesitan más resultados en esta dirección, cabría preguntarse si es posible recuperar esta diferencia mediante la instrucción en las habilidades de pensamiento crítico que se miden en este instrumento. Este trabajo es un primer paso para que las instituciones educacionales en primaria cuenten con un instrumento que les permita conocer el estado del desarrollo del pensamiento crítico en sus estudiantes. Este test es una mejora en las evaluaciones disponibles al desplazarce de modelos unidimensionales de medición a modelos que entreguen una imagen más detallada y múltiple del aprendizaje del estudiante (Conley, 2015). Las limitaciones de este trabajo es tanto el rango escolar, el contexto cultural y el dominio estudiado. En un trabajo futuro es necesario trabajar las limitantes indicadas. 47 CONCLUSIONES FINALES El objetivo principal de este trabajo fue la construcción de un modelo de evaluación y el diseño de un test de pensamiento crítico para niños en educación primaria. El desarrollo del test siguió las indicaciones recomendadas por los nuevos paradigmas de evaluación educacional de habilidades del siglo XXI. De esta manera, se consiguió elaborar un instrumento de evaluación que presenta una imagen más completa del nivel de pensamiento crítico de los estudiantes. El uso de este instrumento puede beneficiar dos áreas del sector educacional a los que afecta directamente. Por una parte, el instrumento puede integrarse a nivel local en colegios chilenos para evaluar el nivel de pensamiento crítico en niños de tercer y cuarto grado. El formato de la narrativa gráfica utilizado hace más amigable su implementación en las salas de clases. De esta manera, los profesores adquieren una guía sobre el impacto que sus clases tienen en el desarrollo de pensamiento crítico en sus estudiantes. Por otra parte, este instrumento permite recolectar importante información sobre el estado del pensamiento crítico para los investigadores educacionales en Chile, tanto en el área de pensamiento crítico mismo como en su posible relación con la comprensión lectora y el desarrollo de la escritura. Además, el proceso de diseño de este test, así como el instrumento mismo, puede utilizarse para la creación de nuevos instrumentos de pensamiento crítico, tanto en el dominio de lenguaje y comunicación como en otras áreas relevantes para el currículum. 48 Un paso necesario en la continuación de esta línea de trabajo es el desarrollo de nuevas herramientas instruccionales coherentes con el tipo de habilidad evaluada por el instrumento diseñado en esta investigación. Tal como sugiere Dochy (2001), es conveniente que los instrumentos de evaluación y la instrucción sean diseñados coordinadamente para que el proceso de aprendizaje sea efectivo y relevante. Adicionalmente, la investigación da un primer paso al explorar la relación entre el pensamiento crítico y el estrato socioeconómico en estudiantes chilenos. Explorar este vínculo con mayor profundidad podría explicar cómo el aprendizaje de habilidades de nivel superior, exigidas cada vez más en el contexto laboral contemporáneo, sustenta lógicas de diferenciación social que, según Van Zanten (2005), impactan en la reproducción de privilegios de clase al interior de las comunidades. Queda pendiente aún la implementación del test de cultura con el que el modelo propuesto podría aplicarse íntegramente. Una vez validado este test, se podrá obtener información relevante sobre el impacto que tienen los factores culturales sobre la relación entre el pensamiento crítico y otras competencias educacionales. En particular, como se sugiere en esta investigación, sobre la competencia lectora. Una limitación adicional del test es el formato de libro de texto utilizado en su primera implementación. En el futuro, sería deseable considerar la integración de un argumentador digital, lo que permitiría utilizar los medios tecnológicos para mejorar la manipulación práctica del instrumento en cuestión y medir otros factores no disponibles en un formato análogo. 49 Si bien algunos aspectos de la investigación pueden ser perfeccionados, es presumible que, al menos, se han establecido bases sólidas para el desarrollo de los estudios de pensamiento crítico en la educación chilena. 50 BIBLIOGRAFIA Adkins, D. C. (1974). Test construction: Development and interpretation of achievement tests. Columbus, Ohio: Merrill Publishing Company. Alexander, P. A., & Judy, J. E. (1988). The interaction of domain-specific and strategic knowledge in academic performance. Review of Educational research,58(4), 375-404. Ary, D., Jacobs, L., Sorensen, C., & Walker, D. (2013). Introduction to research in education. Cengage Learning. Bailin, S. (1995). Is critical thinking biased? Clarifications and implications.Educational Theory, 45(2), 191-197. Bailin, S. (2002). Critical thinking and science education. Science & Education, 11(4), 361–375. Bailin, S., Case, R., Coombs, J. R., & Daniels, L. B. (1999). Conceptualizing critical thinking. Journal of Curriculum Studies, 31(3), 285–302. Baron, R. M., & Kenny, D. A. (1986). The moderator–mediator variable distinction in social psychological research: Conceptual, strategic, and statistical considerations. Journal of personality and social psychology, 51(6), 1173. Basualdo, C. (2007). La Evaluación del Sistema Educativo en Chile: Una aproximación contextual. Proyecto de Investigación, Universidad Nacional de Salta. Bates, T. (2001). International distance education: Cultural and ethical issues.Distance Education, 22(1), 122-136. Bates, A. W., & Poole, G. (2003). Effective Teaching with Technology in Higher Education: Foundations for Success. Jossey-Bass, An Imprint of Wiley. 10475 Crosspoint Blvd, Indianapolis, IN 46256. 51 Bean, J. C. (2011). Engaging ideas: The professor's guide to integrating writing, critical thinking, and active learning in the classroom. San Francisco: John Wiley & Sons. Bennett, M. J. (1997). How not to be a fluent fool: Understanding the cultural dimension of language. New ways in teaching culture, 16-21. Berland, L. K., & McNeill, K. L. (2012). For whom is argument and explanation a necessary distinction? A response to Osborne and Patterson. Science Education, 96(5), 808-813. Bourdieu, P. (1993). The field of cultural production: Essays on art and literature. New York: Columbia University Press. Bourdieu, P. (2011). The forms of capital. (1986). Cultural theory: An anthology, 8193. Breen, R., & Goldthorpe, J. H. (1997). Explaining educational differentials towards a formal rational action theory. Rationality and society, 9(3), 275-305. Brown, J. D. (2000). What is construct validity? JALT Testing and Evaluation SIG Newsletter, 4(2), 7-10. Brown, N. J., Afflerbach, P. P., & Croninger, R. G. (2014). Assessment of criticalanalytic thinking. Educational Psychology Review, 26(4), 543-560. Butler, H. A., Dwyer, C. P., Hogan, M. J., Franco, A., Rivas, S. F., Saiz, C., & Almeida, L. S. (2012). The Halpern Critical Thinking Assessment and real-world outcomes: cross-national applications. Thinking Skills and Creativity, 7(2), 112-121. Chapman, J. (2014). Critical Thinking and TOEIC: Advanced Skills for Teachers and Test-Takers. The 2013 PanSIG Proceedings, 102. 52 Chase, M., Son, E. H., & Steiner, S. (2014). Sequencing and Graphic Novels With Primary‐Grade Students. The Reading Teacher, 67(6), 435-443. Cheung, C. K., Rudowicz, E., Lang, G., Yue, X. D., & Kwan, A. S. (2001). Critical thinking among university students: does the family background matter? College Student Journal, 35(4), 577. Childs, R. (1990). Gender bias and fairness. Practical Assessment, Research & Evaluation, 2(3). Colaiaco, J. A. (2013). Socrates against Athens: philosophy on trial. New York: Routledge. Cole, M. (1971). The Cultural Context of Learning and Thinking: An Exploration in Experimental Anthropology. London: Methuen. Conley, D. (2015). A New Era for Educational Assessment. education policy analysis archives, 23, 8. Cronbach, L. J. (1971). Test validation. In R. L. Thorndike (Ed.). Educational Measurement (2nd Ed.). Washington, D. C.: American Council on Education. Dancey C., Reidy J. (2004). Statistics Without Maths for Psychology: Using SPSS for Windows. London: Prentice Hall Darling-Hammond, L., Wilhoit, G., & Pittenger, L. (2014). Accountability for college and career readiness: Developing a new paradigm. education policy analysis archives, 22(86), 1. Das, A. (2013). The Impact of Children’s Literature in the Teaching of English to Young Learners. International Journal of English: Literature, Language & Skills. Deal, T. E., & Peterson, K. D. (1999). Shaping school culture: The heart of leadership. San Francisco: Jossey-Bass Inc. 53 Dede, C. (2010). Comparing frameworks for 21st century skills. 21st century skills: Rethinking how students learn, 20, 51-76. Dillashaw, F.G. & Okey, J. R. (1980). Test of Integrated Science Process Skills for Secondary Students. Science Education, 64, 601-608. Dochy, F. (2001). A new assessment era: different needs, new challenges.Learning and Instruction, 10, 11-20. Downey, E. M. (2009). Graphic novels in curriculum and instruction collections.Reference & User Services Quarterly, 49(2), 181-188. Dwyer, C. P., Hogan, M. J., & Stewart, I. (2014). An integrated critical thinking framework for the 21st century. Thinking Skills and Creativity, 12, 43-52. Emmison, M., & Smith, P. (2000). Researching the Visual: Images, Objects, Contexts and Interactions in Social and Cultural Inquiry: Introducing Qualitative Methods. London: Sage. Ennis, R. H. (1989). Critical thinking and subject specificity: Clarification and needed research. Educational researcher, 18(3), 4-10. Ennis, R. (1992) Conflicting Views on Teaching Critical Reasoning, in: R. Talaska (ed.), Critical Reasoning in Contemporary Culture (Albany, SUNY Press). Ennis, R. H. (1993). Critical thinking assessment. Theory into practice, 32(3), 179186. Ennis, R. H. (1998). Is critical thinking culturally biased?. Teaching Philosophy,21(1), 15-33. Ennis, R.H. & Millman, J. (1985). Cornell Critical Thinking Test-Level X. Pacific Grove, CA: Midwest Publications. 54 Ennis, R.H. & Weir, E. (1985). The Ennis-Weir essay test: An instrument for testing and teaching. Midwest Publications: Pacific Grove, CA. Ericsson, K. A., & Simon, H. A. (1993). Protocol Analysis: Verbal reports on data. Cambridge, MA: MIT Press. Facione, P. A. (1990). Critical Thinking: A Statement of Expert Consensus for Purposes of Educational Assessment and Instruction. Research Findings and Recommendations. http://assessment.aas.duke.edu/documents/Delphi_Report.pdf, downloaded Feb 3, 2014. Facione, P. A. (2007). Critical thinking: What it is and why it counts. Insight Assessment, 2007, 1-23. Fairchild, A. J., & McQuillin, S. D. (2010). Evaluating mediation and moderation effects in school psychology: A presentation of methods and review of current practice. Journal of school psychology, 48(1), 53-84. Filmer, D., Hasan, A., & Pritchett, L. (2006). A millennium learning goal: Measuring real progress in education. Center for Global Development Working Paper, (97). Flaherty, E. G. (1974). The thinking aloud technique and problem-solving ability. Journal of Educational Research, 68, 223-225. Flavell, J. H. (1979). Metacognition and cognitive monitoring: A new area of cognitive–developmental inquiry. American psychologist, 34(10), 906. Frey, N., & Fisher, D. (2004). Using graphic novels, anime, and the Internet in an urban high school. English Journal, 19-25. Gallego, F. A. (2002). Competencia y resultados educativos: teoría y evidencia para Chile. cuadernos de economía, 39(118), 309-352. 55 Gelman, S. A., & Markman, E. M. (1987). Young children's inductions from natural kinds: The role of categories and appearances. Child development, 1532-1541. George, D and Mallery, P. (2003). SPSS for Windows step by step: a simple guide and reference. Boston, MA: Allyn and Bacon. Glaser, R. (1984). Education and thinking: The role of knowledge. American psychologist, 39(2), 93. Greenhill, V. (2009). P21 framework definitions document, Retrieved December 15, 2010, from, http://www.21stcenturyskills.org/documents/p21_framework_definitions_052909.pd f. Griffin, P., McGaw, B., & Care, E. (2012). Assessment and Teaching of 21st Century Skills. New York: Springer Grossman, D. L. (2008). Democracy, citizenship education and inclusion: a multidimensional approach. Prospects, 38(1), 35-46. Gruenert, S., & Whitaker, T. (2015). School Culture Rewired: How to Define, Assess, and Transform It. ASCD. Guo, M. (2013). Developing Critical Thinking in English Class: Culture-based Knowledge and Skills. Theory and Practice in Language Studies, 3(3), 503-507. Halpern, D. F. (1998). Teaching critical thinking for transfer across domains: Disposition, skills, structure training, and metacognitive monitoring. American Psychologist, 53(4), 449. Halpern, D. (2003). Thought and knowledge: An introduction to critical thinking (4th ed.). Mahwah, NJ: Lawrence Erlbaum Associates. 56 Hapgood, S., Magnusson, S. J., & Sullivan-Palincsar, A. (2004). Teacher, text, and experience: A case of young children's scientific inquiry. Journal of the Learning Sciences, 13(A), 455-505. Hassett, D. D., & Schleble, M. B. (2007). Finding Space and Time for the Visual in K-12 Literacy Instruction. English Journal, 97(1). Hernandez, D. J. (2011). Double Jeopardy: How Third-Grade Reading Skills and Poverty Influence High School Graduation. Annie E. Casey Foundation. Heyman, G. D. (2008). Children's critical thinking when learning from others. Current Directions in Psychological Science, 17(5), 344-347. Higgins, S. (2014). Critical thinking for 21st-century education: A cyber-tooth curriculum?. Prospects, 44(4), 559-574. Hill, R., & Shadija, D. (2010). Culture, Critical Thinking and Computing. Proceedings of the International Workshop CS-LTA 2010, 26 July 2010, Kuching, Malaysia, 21-26. Hinkle, D. E., Wiersma, W., & Jurs, S. G. (2003). Applied statistics for the behavioral sciences. Boston: Houghton Mifflin. Hofstede, G. (1986). Cultural differences in teaching and learning. International Journal of intercultural relations, 10(3), 301-320. Hofstede, G. (2001). Culture's consequences: Comparing values, behaviors, institutions and organizations across nations. Thousand Oaks, California: Sage. Hofstede, G. (2008, August). Cultural Differences in Teaching and Learning. Retrieved 12 11, 2013, from, fuhu.dk: http://fuhu.dk/filer/FBE/Arrangementer/Denmark%20Unlimited%20080508/FBE_ge ert_hofstede_teaching_learning.pdf 57 Hofstede, G., & Minkov, M. (2010). Cultures and Organizations: Software of the Mind. United States of America: McGraw-Hill. Hong-Nam, K., Leavell, A. G., & Maher, S. (2014). The Relationships among Reported Strategy Use, Metacognitive Awareness, and Reading Achievement of High School Students. Reading Psychology, 35(8), 762-790. Howe, K. (1995). Validity, Bias and Justice in Educational Testing: The Limits of Consequensialist Conception. In A. Neiman, Ed., Philosophy of education. Normal, ILL: Philosophy of Education Society, pp. 295-302. Hudgins, B. B., et al. (1989). Children's critical thinking: A model for its analysis and two examples. Journal of Educational Research, 82(6), 327-338. Jenkins, E. K. (1998). The significant role of critical thinking in predicting auditing students' performance. Journal of Education for Business, 73(5), 274-279. Jennings, K. A., Rule, A. C., & Zanden, S. M. V. (2014). Fifth Graders’ Enjoyment, Interest, and Comprehension of Graphic Novels Compared to Heavily-Illustrated and Traditional Novels. International Electronic Journal of Elementary Education, 6(2), 257. Jiménez-Aleixandre, M. P., & Puig, B. (2012). Argumentation, evidence evaluation and critical thinking. In Second international handbook of science education (pp. 1001-1015). Netherlands: Springer. Jones, M. L. (2007, June). Hofstede—cultural questionable? Paper presented at Oxford: Business and Economic Conference, Oxford, UK. Retrieved from http://ro.uow.edu.au/commpapers/370 Kant, I. (1994). ¿Qué es la ilustración? Revista colombiana de psicología, 3, 7-10. 58 Kennedy, M., Fisher, M. B., & Ennis, R. H. (1991). Critical thinking: Literature review and needed research. Educational values and cognitive instruction: Implications for reform, 2, 11-40. Kim, K., Sharma, P., Land, S. M., & Furlong, K. P. (2013). Effects of active learning on enhancing student critical thinking in an undergraduate general science course. Innovative Higher Education, 38(3), 223-235. Ku, K. Y., & Ho, I. T. (2010). Metacognitive strategies that enhance critical thinking. Metacognition and learning, 5(3), 251-267. Ku, K. Y., Ho, I. T., Hau, K. T., & Lai, E. C. (2014). Integrating direct and inquirybased instruction in the teaching of critical thinking: an intervention study. Instructional Science, 42(2), 251-269. Kuh, G. D. (1990). Assessing student culture. New Directions for Institutional Research, 1990(68), 47-60. Kuhn, D. (1999). A developmental model of critical thinking. Educational researcher, 28(2), 16-46. Kurtz, B. E. (1990). Cultural influences on children’s cognitive and metacognitive development. In Interactions among aptitudes, strategies, and knowledge in cognitive performance (pp. 177-199). Springer New York. Lai, E. R. (2011). Critical thinking: A literature review. Pearson's Research Reports, 6, 40-41. Lazo, V. G., & Smith, J. (2014). Developing thinking skills through the visual: An a/r/tographical journey. International Journal of Education through Art, 10(1), 99116. 59 Levy, F., & Murnane, R. J. (2012). The new division of labor: How computers are creating the next job market. Princeton University Press. Lieberman, A. (1988). Building a professional culture in schools. New York: Teachers College Press, Teachers College. Lipka, J., & Ilutsik, E. (2014). Transforming the Culture of Schools: Yupi’k Eskimo. New York: Routledge. Lyga, A. A. (2006). Graphic Novels for (Really) Young Readers: Owly, Buzzboy, Pinky and Stinky. Who Are These Guys? And Why Aren't They Ever on The Shelf?. School Library Journal, 52(3), 56. MacKinnon, D. P., Fairchild, A. J., & Fritz, M. S. (2007). Mediation analysis.Annual review of psychology, 58, 593. Magno, C. (2010). The role of metacognitive skills in developing critical thinking.Metacognition and learning, 5(2), 137-156. Maiorana, V. P. (1992). Critical Thinking across the Curriculum: Building the Analytical Classroom. ERIC Clearinghouse on Reading and Communication Skills, 2805 E. 10th St., Suite 150, Bloomington, IN 47408-2698. Manalo, E., Kusumi, T., Koyasu, M., Michita, Y., & Tanaka, Y. (2013). To what extent do culture-related factors influence university students’ critical thinking use?. Thinking Skills and Creativity, 10, 121-132. Marques, J.F., (2012), Moving from trance to think: why we need to polish our critical thinking skills, International Journal of Leadership Studies, Vol. 7 Iss. 1, 2012, 87-95 Martinez, M. E. (2006). What is metacognition? Phi Delta Kappan, 87(9), 696–699. 60 May, D. B., Hammer, D., & Roy, P. (2006). Children's analogical reasoning in a third grade science discussion. Science Education, 90(2), 316-330. McNamara, D. S., & Magliano, J. P. (2009). 5 Self-Explanation and Metacognition. Handbook of metacognition in education, 60. McMillan, J. (1987). Enhancing college students’ critical thinking: A review of studies. Research in Higher Education, 26 (1), 3-29. McPeck, J. (1981). Critical Thinking and Education. Oxford: Martin Robertson. Mineduc. (2013a). Matemática programa de estudio 3° Básico. Retrieved from http://www.curriculumenlineamineduc.cl/605/articles-18978_programa.pdf Mineduc. (2013b). Lenguaje y comunicación. Programa de estudio 3° Básico. Retrieved from http://www.curriculumenlineamineduc.cl/605/articles- 18962_programa.pdf Mineduc, OCDE & SIMCE. PISA Evaluación de las competencias lectoras para el siglo XXI. Marco de evaluación y preguntas de la prueba. http://www.agenciaeducacion.cl/wpcontent/files_mf/pisa_evaluacion_de_las_competencias_lectoras_para_el_siglo_xxi_ final.pdf Moore, M.& Zigo, D. (2005). Chicken Soup for the Science Fiction Soul: Breaking the Genre Lock in the High School Literacy Experience. Journal of Curriculum. 21(3), 29-45. Moreno, G. (2014, Abril 1). Prueba PISA: escolares chilenos están entre los más bajos de la OCDE en solución de problemas. La Tercera [en línea]. Consultado 22 de Abril, 2015. 61 Mulnix, J. W. (2012). Thinking critically about critical thinking. Educational Philosophy and Theory, 44(5), 464-479. Munn, N. D. (1992). The cultural anthropology of time: a critical essay. Annual Review of Anthropology, 93-123. Nickerson, R. (1988). On improving thinking through instruction. Review of Research in Education, 15(3), 3-57. Nippold, M. A., Frantz-Kaspar, M. W., Cramond, P. M., Kirk, C., HaywardMayhew, C., & MacKinnon, M. (2015). Critical Thinking about Fables: Examining Language Production and Comprehension in Adolescents. Journal of Speech, Language, and Hearing Research. Nitko, A. J. (1996). Educational Assessment of Students. 2nd ed. New Jersey: Prentice-Hall. Niu, L., Behar-Horenstein, L. S., & Garvan, C. W. (2013). Do instructional interventions influence college students’ critical thinking skills? A metaanalysis.Educational Research Review, 9, 114-128. Nussbaum, M. C. (2011). Creating capabilities. Boston: Harvard University Press. Nussbaum, M. C. (2012). Not for profit: Why democracy needs the humanities. NJ: Princeton University Press. O’Flahavan, J. & Tierney, R. (2013). Reading, Writing, and Critical Thinking. Educational Values and Cognitive Instruction: Implications for Reform, 41. Osakwe, R. N. (2009). The effect of early childhood education experience on the academic performances of primary school children. Stud Home Comm Sci,3(2), 143147. 62 Osborne, J. W. (Ed.). (2008). Best practices in quantitative methods. Thousands Oaks: Sage. Palincsar, A. S. (2005). Social constructivist perspectives on teaching and learning. An introduction to Vygotsky, 285. Pantaleo, S. (2014). Reading images in graphic novels: Taking students to a greater thinking level. English in Australia, 49(1), 38. Paul, R. (1992). Critical thinking: What, why, and how. New Directions for Community Colleges, 1992(77), 3-24. Pérez-Arce, P. (1999). The influence of culture on cognition. Archives of Clinical Neuropsychology, 14(7), 581-592. Pithers, R. T., & Soden, R. (2000). Critical thinking in education: A review.Educational Research, 42(3), 237-249. Presseisen, B. Z. (1987). Thinking and curriculum: Critical crossroads for educational change. In M. Heiman & J. Slomianko (Eds.). Thinking skills instruction: Concepts and techniques (pr. 31-39). Washington, DC: National Educational Association. Ramírez, M. J. (2011). El SIMCE en el contexto de la ley de aseguramiento de la calidad de la educación. Opciones para mejorar nuestro sistema de evaluación. Estudios públicos (Santiago), (123), 213-235. Reid, J., & Anderson, P. (2012). Critical thinking: The foundation of education in a technological world. Education in a technological world: Communicating current and emerging research and technological efforts, 1, 120-126. 63 Rubio, D. M., Berg-Weger, M., Tebb, S. S., Lee, E. S., & Rauch, S. (2003). Objectifying content validity: Conducting a content validity study in social work research. Social Work Research, 27(2), 94-104. Rueda, R. (2006). Motivational And Cognitive Aspects Of Culturally Accommodated Instruction. Effective schools, 6, 135. Salili, F., Chiu, C. Y., & Lai, S. (2001). The influence of culture and context on students’ motivational orientation and performance (pp. 221-247). Springer US. Santelices, M. V., Ugarte, J. J., Flotts, P., Radovic, D., & Kyllonen, P. (2011). Measurement of New Attributes for Chile's Admissions System to Higher Education. ETS Research Report Series, 2011(1), i-44. Sayed, Y. (2013). Making education a priority in the post-2015 development agenda: report of the Global Thematic Consultation on Education in the Post-2015 Development Agenda. Schein, E. H. (1993). How can organizations learn faster? The challenge of entering the green room. Sloan Management Review, 34(2), 85-92. Schkade, L. L., Roman S. & Uzawa, M. (1978). Human Information Processing and Environmental Complexity--An Experiment in Four Cultures: India, Japan, Mexico and the USA. Journal of Management (ACS, India), 8 (1), 56-63. Schwarz, G. (2006). Expanding literacies through graphic novels. English Journal, 58-64. Shahsavar, Z. (2014). The Impact Of Culture On Using Critical Thinking Skills Through The Blog. Media & Mass Communication, 3, 99-105. Sheng, Y. (2008). Testing the assumptions of analysis of variance, In Osborne, J.W. (Ed.) 64 Siegel, H. (1992). The generalizability of critical thinking skills, dispositions and epistemology. In S. Norris (Ed.), The generalizability of critical thinking (pp. 97108). New York: Teachers College Press. Silva, E. (2009). Measuring skills for 21st-century learning. Phi Delta Kappan, 630634. Søndergaard, M. (1994). Hofstede's consequences: A study of reviews, citations and replications. Organization Studies 15(3): 447. Songer, N. B., & Gotwals, A. W. (2012). Guiding explanation construction by children at the entry points of learning progressions. Journal of Research in Science Teaching, 49(2), 141-165. Sturken, M., Cartwright, L., & Sturken, M. (2001). Practices of looking: An introduction to visual culture. Oxford: Oxford University Press Sullivan, A. (2001). Cultural Capital and Educational Attainment. Sociology. 35(4) 893-912. Swaggerty, E. A. (2015). Selecting Engaging Texts for Upper Elementary Students Who Avoid Reading or Find Reading Difficult. Children's Literature in the Reading Program: Engaging Young Readers in the 21st Century, 150. Trompenaars, F., & Hampden-Turner, C. (1998). Riding the waves of culture. New York: McGraw-Hill. Tsui, L. (1998). A review of research on critical thinking. Paper presented at the annual meeting of the Association for the Study of Higher Education, Miami, FL Tsui, L. (2000). Effects of campus culture on students' critical thinking. The Review of Higher Education, 23(4), 421-441. 65 UNESCO. (2000). Dakar Framework for Action. Education for All: Meeting Our Collective Commitments. Adopted by the World Education Forum, Dakar, Senegal, April 26–28, 1999. Paris: UNESCO. http://unesdoc.unesco.org/images/0012/001211/121147e.pdf Urdan, T., & Giancarlo, C. (2000). A Comparison of Motivational and Critical Thinking Orientations Across Ethnic Groups. Research on Sociocultural Influences on Motivation and Learning, 1, 37. Van Den Broek, P., Kendeou, P., Lousberg, S., & Visser, G. (2011). Preparing for reading comprehension: Fostering text comprehension skills in preschool and early elementary school children. International Electronic Journal of Elementary Education, 4(1), 259-268. Van Gelder, T. (2005). Teaching critical thinking: Some lessons from cognitive science. College teaching, 53(1), 41-48. Van Zanten, A. (2005). New modes of reproducing social inequality in education: the changing role of parents, teachers, schools and educational policies. European Educational Research Journal, 4(3), 155-169. Veenman, M. V. J., Wilhelm, P., & Beishuizen, J. J. (2004). The relation between intellectual and metacognitive skills from a developmental perspective. Learning and Instruction, 14(1), 89-109. Voogt J. & Pareja N. (2012). A comparative analysis of international frameworks for 21st century competences: Implications for national curriculum policies, Journal of Curriculum Studies, 44:3, 299-321 Vygotsky, L. S. (1980). Mind in society: The development of higher psychological processes. Harvard university press. 66 Watson, G. B., & Glaser, E. M. (1980). WGCTA Watson-Glaser critical thinking appraisal manual: Forms A and B. San Antonio: The Psychological Corporation. WEF & BCG (2015). New Vision for Education Unlocking the Potential of Technology. Cologny / Geneva: World Economic Forum. Weiler, A. (2005). Information-seeking behavior in Generation Y students: Motivation, critical thinking, and learning theory. The Journal of Academic Librarianship, 31(1), 46-53. Wertsch, J. V. (2009). Voices of the Mind: Sociocultural Approach to Mediated Action. Harvard University Press. Whitcomb, S., & Merrell, K. W. (2013). Behavioral, social, and emotional assessment of children and adolescents. New York: Routledge. Williams, R. L., Oliver, R., Allin, J. L., Winn, B., & Booher, C. S. (2003). Psychological critical thinking as a course predictor and outcome variable. Teaching of Psychology, 30(3), 220-223. Willingham, D. T. (2008). Critical thinking: Why is it so hard to teach?. Arts Education Policy Review, 109(4), 21-32. Wolming , S. (1998). Validitet. Ett traditionellt begrepp i modern tillämpning [Validity: A modern approach to a traditional concept]. Pedagogisk Forskning i Sverige, 3(2): 81–103. Womer, F. B. (1968). Basic concepts in testing. Boston: Houghton Mifflin. Yeh, S. S. (2001). Tests worth teaching to: Constructing state-mandated tests that emphasize critical thinking. Educational Researcher, 30(9), 12-17. 67 68 ANEXOS 69 Anexo A. Tablas Tabla 4: : Resumen puntajes y dimensiones Habilidad Interpretación Definición Indicadores de logro Sub dimensiones Comprender y expresar el significado o importancia de una gran variedad de experiencias, situaciones, Categorización datos eventos, juicios, convenciones, creencias, reglas, procedimientos o criterios. Clasificar elementos según ciertas reglas, criterios o procedimientos 0,7 Identificar qué elementos son relevantes para resolver un problema Decodificar la relevancia Determinar el papel de las imágenes visuales en una narración (*) Aclarar significado Dificultad Discriminación Representar un resultado o una operación de diferentes formas Aclarar el uso de una 0,48 0,65 0,34 0,8 0,35 0,48 0,64 0,49 0,38 70 convención Aclarar una idea a través de un ejemplo. Examinar ideas Análisis Identificar las relaciones inferenciales convencionales y reales entre declaraciones, preguntas, conceptos, Detectar argumentos descripciones u otras formas de representación para expresar creencias, juicios, experiencias, razones, información u opiniones Analizar argumentos 0,39 0,37 0,72 0,51 0,21 0,33 0,35 0,42 0,35 0,42 0,46 0,42 Juzgar si una conclusión es correcta a partir de las premisas utilizadas. 0,28 0,28 Evaluar la fuerza lógica de una objeción dado un argumento. 0,63 0,37 Comparar conceptos o afirmaciones determinando similitudes y diferencias. Identificar si un argumento está a favor o en contra de una afirmación dada. Identificar el punto principal de un argumento. (*) Identificar las razones que apoyan un argumento. (*) Evaluación Evaluar la credibilidad de las declaraciones u otras representaciones que son cuentas o descripciones de la percepción, experiencia, situación, juicio, creencia u opinión de una persona; y para evaluar la lógica de las relaciones deductivas entre las declaraciones, descripciones, preguntas u otras formas de representación. Evaluar afirmaciones Evaluar argumentos Reconocer los factores relevantes para determinar el grado de credibilidad de una fuente de información u opinión. 71 Juzgar si un argumento es pertinente, aplicable o tiene implicancias para una situación. Evaluar alternativas Evaluar los beneficios y dificultades de diferentes alternativas. (*) Discriminar si una información es útil para construir un argumento Identificar si un inferencia viene desde la evidencia. Inferencia Identificar y ratificar elementos requeridos para deducir conclusiones Cuestionar evidencia razonables; elaborar conjeturas e hipótesis; considerar información pertinente y deducir consecuencias a partir de datos, afirmaciones, principios, evidencias, juicios, creencias, opiniones, conceptos, descripciones, cuestionamientos u otras formas de representación Proponer alternativas Identificar qué información adicional es necesaria para decidir entre dos opiniones contradictorias Aceptar o rechazar una hipótesis a partir de la evidencia empírica Dado un conjunto de prioridades con el cual se puede o no estar de acuerdo, visualizar los beneficios y las dificultades que resultarán de su aplicación al tomar 0,65 0,52 0,67 0,62 0,81 0,23 0,43 0,31 0,36 0,33 0,46 0,3 0,6 0,61 72 decisiones. (*) Usa distintas estrategias para resolver problemas. (*) Sacar conclusiones 0,81 0,55 0,69 0,52 0,67 0,68 0,46 0,45 0,82 0,35 0,75 0,64 0,18 0,41 Llegar a una conclusión válida a partir de las evidencias. Comunicar las conclusiones de un procedimiento. (*) Argumentación / Explicación Ordenar y comunicar a otros los resultados de nuestro razonamiento; justificar el Indicar resultados razonamiento y sus conclusiones en términos de evidencias, conceptos, metodologías, criterios y consideraciones del contexto y presentar el razonamiento en una forma clara, convincente y persuasiva. Justificar procedimientos Comunicar en forma gráfica las relaciones entre conceptos e ideas Elaborar una narración en la que se examine, en relación a un tema, el cambio a través del tiempo Explicitar los estándares utilizados para evaluar una obra literaria Describir la estrategia utilizada para tomar una 73 decisión en una forma razonable Presentar argumentos Argumenta a favor o en contra de un punto de vista 0,63 0,65 Explicar la comprensión de un concepto. (*) 0,35 0,14 Identificar y expresar evidencias y posibles contra evidencias como una contribución dialéctica a la forma en que piensan otras personas y para su propio pensamiento. 0,72 0,66 (*) Ítems basados en el Delphi Report. (**) Indicadores que se midieron en más de una ocasión. Tabla 5: Valores promedio de Dificultad y Discriminación para el pre y post Análisis de Ítems. Habilidad Interpretación Análisis Inferencia Evaluación Explicación Pre Análisis de Ítems Dificultad Discriminación Post Análisis de Ítems Dificultad Discriminación 0,62 0,43 0,6 0,45 0,36 0,38 0,47 0,45 0,58 0,41 0,57 0,44 0,47 0,4 0,6 0,48 0,41 0,47 0,59 0,57 Anexo B. Paper en ingles Designing and implementing a test for measuring critical thinking in primary school Abstract The importance of critical thinking in education is underpinned by decades of theoretical and practical work. Differences have been demonstrated between students who receive education in this area from an early age and those who do not. However, not enough work has been done to measure these skills in a classroom setting. Given that the best time to teach critical thinking is during the first years of primary education, we designed a test to determine the level of critical thinking among 3rd and 4th grade students in Language Arts using a graphic novel. We showed the legitimacy of the instrument through Construct Validity, Content Validity, Pearson product-moment correlation, Reliability and Item Analysis. Using the instrument we studied how critical thinking skills differ among 3rd grade students, according to their socioeconomic status (SES), studying schools with low, middle and high SES. We found significant differences between the schools, which suggest that there may be a relationship between socioeconomic status and the development of critical thinking skills. The test presented in this study is an improvement on existing assessment tools as it replaces unidimensional models with models that provide a more detailed and multidimensional picture of student learning. Keywords: Critical Thinking, Assessment models, 21st Century Skills, Culture, Graphic and Textual Narrative 1. - Introduction Teaching critical thinking in schools is one of the main topics in the discussion regarding so-called 21st Century skills (Greenhill, 2009). Critical thinking has been regarded as an essential requirement for responsible human activity (Marques, 2012). It is also considered fundamental if citizens are to perform their social, professional and ethical duties (Griffin, McGaw & Care, 2012; Greenhill, 2009). Critical thinking skills allow individuals to make autonomous decisions and to question beliefs when these are not based on solid evidence (Halpern, 2003; Mulnix, 2012). There is a wide range of definitions of critical thinking. Some of these definitions are more philosophical, relating to classical thought and human development (Nussbaum, 2011); others are more focused on how critical thinking is received and developed in education (Facione, 1990; Halpern, 2003; Bailin, 2002). Despite these divergent approaches, one essential element of critical thinking is that it is a metacognitive process. Critical thinking allows us to think not just about the world around us (firstorder skills), but also about the thought process itself (second-order skills) (Kuhn, 1999; Halpern, 2003). This element of metacognition has consequences in teaching, relating directly to how the context is perceived and understood (Halpern, 2003). For example, it has been established that metacognitive processes linked to critical thinking are fundamental to the transfer of acquired knowledge (Nickerson, 1988). This study will use a definition of critical thinking that explicitly states its link to metacognition. It is therefore defined as "a metacognitive process, consisting of a number of sub-skills (e.g. analysis, evaluation and inference) that, when used appropriately, increases the chances of producing a logical conclusion to an argument or solution to a problem" (Dwyer, Hogan & Stewart, 2014, p.43). The importance of critical thinking in education is underpinned by decades of theoretical and practical work (Lai, 2011). The inclusion of critical thinking in school curriculums has been widely reported since at least the first half of the 20th Century, influenced by John Dewey (Bean, 2011). Facione (1990) suggests that developing critical thinking skills should be an objective for every grade level in the K-12 curriculum. In this sense, teaching critical thinking in schools should be integrated into regular classroom activities (Bailin et al., 1999). It is also important to teach critical thinking from early childhood. This is because significant differences have been demonstrated between students who receive education in this area from an early age and those who do not (Osakwe, 2009). However, although the importance of critical thinking to global education has been defended repeatedly, not enough work has been done to measure these skills in a classroom setting. According to UNESCO (2000), measuring improvements in critical thinking skills is essential for improving the quality of education. If tests are understood to shape both the curriculum and teaching, then an efficient way to improve the quality of education in critical thinking is to develop better tests (Yeh, 2001). The literature reports that specific knowledge of the subject in which critical thinking skills are being taught is needed if these skills are to be measured properly (Facione, 1990; Ennis 1989; McPeck 1981; Bailin, 2002; Willingham, 2008). In order to assess children’s critical thinking skills in the classroom, the assessment must therefore be situated and take into account the specific subject in which these skills are being taught (Merrel, 2003). This is because of the influence that different subjects can have on the findings or conclusions of a study, depending on the objectives of the task (Bailin, 1999). Therefore, although a certain level of generality can be assigned to critical thinking skills, their use depends on their connection to a specific subject (McPeck, 1981). Ennis (1989) suggests that the best time to teach critical thinking is during the first years of primary education. This suggestion is coherent with other studies, which conclude that young children benefit from being taught and assessed on critical thinking (Kennedy et al., 1991). However, the critical thinking tests that are available are not designed for young children and do not focus on a specific subject. Instead, they only measure critical thinking as a general skill (Ennis & Millman, 1985; Watson & Glaser, 1980; Facione, 1990; Ennis & Weir, 1985; Halpern, 2003). Faced with this problem, our first research question asks: “How can we design and validate a test that determines the level of critical thinking among primary school children in a specific subject?” The relationship between socioeconomic status and the acquirement of skills is best expressed by Bourdieu (1986). In his study, the author shows that the accumulation of economic capital can be transferred to society as cultural capital, in the form of educational skills and abilities (Bourdieu, 1986). It has been revealed that a student’s socioeconomic status substantially influences their achievements in education (Breen & Goldthorpe, 1997). It has also been shown that levels of poverty and reading skills among third grade students have an impact on their performance in higher levels of education (Hernández, 2011). Some authors suggest that a student’s socioeconomic status could also plausibly influence their level of critical thinking (Cheung et al., 2001). Our second research question therefore asks: “How do critical thinking skills differ among 3rd grade students, according to their socioeconomic status?” 2.- Methodology 2.1. Designing the test A literature review was conducted during the first stage of this study in order to define a model of critical thinking. The aim of this model is to provide suitable scaffolding of the skills required by critical thinking. Suitable scaffolding is considered to be essential for promoting critical thinking (Kim et al., 2013), especially in order to successfully teach upper-elementary school students higher-order skills (Songer & Gotwals, 2012). This is because it allows the aforementioned skills to be taught explicitly in a classroom setting (Halpern, 2003) and helps the teacher monitor how the skills are learned . This is particularly true when teaching explanation construction. The proposed model was based on the Delphi Report (Facione, 1990), in which a group of experts defined the principal skills of a critical thinker. These skills include interpretation, analysis, evaluation, inference, explanation, and self-regulation. Furthermore, the proposed model also incorporates the concepts of transferability and metacognition (Halpern, 2003). The model proposed in this study is based on sequential scaffolding. During this sequence, the students address how their thoughts are formulated (interpretation), evaluate solutions (evaluation), explore and clarify inconsistencies or missing information (analysis and inference), and, finally, explain the results of their mental process (explanation). The sequence successively infuses higher-order thinking skills (analysis, interpretation and inference) with the metacognitive process (evaluation, explanation and self-regulation). This is done by explicitly forming arguments in response to a given narrative. Special weighting is given to the explanation as the cognitive strategies used by students when constructing an explanation are heavily influenced by metacognition (McNamara & Magliano, 2009). Questions requiring reasoning were included in the model so as to track the explanatory process. According to Berland & Mcneill (2012), the explanatory and reasoning processes occur simultaneously. Using reasoning to put critical thinking into operation makes measuring this skill much simpler (Yeh, 2001). Reasoning is particularly important when it comes to measuring critical thinking as it is one of the most effective tools for discriminating between ideas based on evidence and those that are merely opinions (Jiménez-Aleixandre & Puig, 2012). In a second phase of the design process, the subject matter for the test was defined. The potential for integrating critical thinking skills from an early age is demonstrated by studies which show that children can carry out activities involving such skills as successfully as adults (Gelman & Markman, 1986; Willinghman, 2008). In this sense, it was estimated that the earliest possible age for the test to be effective is 3rd grade. This is because between 3rd and 5th grade the majority of students are capable of decoding and using most words (Swaggerty, 2015). Critical thinking has a significant impact on the learning skills that are associated with language. For example, Nippold et al. (2015) show that tasks based on critical thinking require sentences with more complex syntax than tasks based on conversations. Chapman (2014) suggests that learning critical thinking skills improves student performance on the TOEIC (Test of English for International Communication). Furthermore, the literature reports that the use of critical thinking strategies is one of the most important factors in the development of reading skills (Hong-Nam et al., 2014. Additionally, O’Flahavan & Tierney (2013) suggest that reading and writing are both highly productive tools for promoting critical thinking. Given the above, Language Arts was chosen as the subject matter to be used in this study. In order to do so, an adaptation of the plot of a well-known story was developed. The selection criteria for choosing the story took into account that, between the ages of 8 and 10, students’ thinking becomes more logical, their memory and intellectual skills improve, and they appreciate humour (Das, 2013). In this sense, the recommendation by Moore & Zigo (2005) to use science fiction was followed. This is because, as a genre, science fiction encourages the use of critical and creative reading. For this reason, the classic novel by Jules Verne, Around the World in 80 Days, was selected and adapted for children from 3rd grade. This adapted novel was used as a means to introduce the questions from the critical thinking test. In a third phase of the design process, it was felt that a graphic novel, i.e., a narrative based on both text and images, was needed in order to help deliver the test. This decision was based on the privileged position enjoyed by visual media in our culture (Emmison & Smith, 2000; Sturken & Cartwright, 2009). The consequence of this is that students basically learn from visual resources, especially during their first years of school (Downey, 2009). Frey & Fisher (2004) acknowledge that the use of graphic novels can stimulate interest in reading among students who are unmotivated by more traditional formats. Furthermore, this type of narrative is considered to boost traditional elements of the Language Arts curriculum, such as literacy (Schwarz, 2006). Another argument in favour of choosing this format is that it allows for the inclusion of elements of visual literacy that are associated with critical thinking assessment standards (Facione, 1990; Lazo & Smith, 2014). Hassett & Schleble (2007) suggest that when reading graphic novels students do not only improve their basic reading skills; they also discover new ways to think about the interaction between the image and text. Following this, a series of performance criteria were defined for each of the skills included in the theoretical framework (Table 4 in Annex 1) (Facione, 1990). The assessment of these criteria, using reading-writing activities, allowed the level of critical thinking to be determined. The narrative therefore had to be structured around these criteria. Questions were developed for each of the performance criterion so as to cover all of the skills (interpretation, analysis, inference, evaluation and explanation). There was a higher percentage of questions related to the skill of constructing explanations. This decision is justified by the fact that the cognitive strategies used by students when constructing explanations are heavily influenced by metacognition (McNamara & Magliano, 2009). This link is particularly important when developing critical thinking questions. When constructing an explanation, the student’s answer is not only based on the contents of the question; their explanation may also come from metacognitive considerations, such as analysing the type of task at hand and different strategies for completing the task (Flavell, 1979). Such emphasis is placed on metacognition because it is this process that articulates critical thinking (Dwyer, 2014). Given the above, it was decided that using short written activities based on questions would be most beneficial. This is a particularly effective teaching strategy for assessing thinking as it provides an idea of the student’s mental process when developing an argument (Bean, 2011). It was also decided to have the questions appear throughout the story, as this has been proven to be a more effective strategy than asking the questions at the end of the story (Van Den Broek et al., 2011). An example of this can be seen in Figure 1, which shows one of the scenes from the graphic novel, together with a question for the student. In this scene one of the characters (the Detective) tries to fool another character (Martin) by using a disguise consisting of a fake moustache. The interaction between the act of wearing a disguise and the visual display of the moustache allows a series of factors to be measured. The first of these is interpretation, by determining the role of visual images in a narrative. Here, the student has to be capable of understanding the role of the object as part of the disguise and not as an innate characteristic of the character. The second factor that is measured is evaluation, by weighing up the pros and cons of a given alternative. In this case, the student assesses whether the moustache is a good or bad disguise with which to fool the other character. The third factor is explanation, as the students not only have to decide whether or not it is a good disguise, they also have to give their reasons (Facione, 1990). The criteria used to evaluate their written responses are also made explicit. The markers must therefore decide whether or not the student’s response meets these criteria. If it does they are awarded 1 point; if it does not they are awarded 0 points. The marking guidelines were developed with the guidance of two experts in education and Language Arts, with the aim of ensuring that the exercises were in line with the skill that was supposedly being measured. Figure 1. Example question. 2.2- Criteria used to validate the test Construct validity, content validity and criterion validity were all analysed in order to validate the test (Brown, 2000; Wolming, 1998). Cronbach’s alpha was also used for this purpose (Cronbach, 1971). These analyses were supplemented by an item analysis. The aim of this analysis was to gather data in order to highlight the need to review, select and remove any questions that were very difficult, very easy, or that failed to discriminate (Nitko 1996). An ANOVA was conducted to provide evidence of the construct validity. The hypothesis of the ANOVA is that there would be significant differences in critical thinking skills between students in 3rd and 4th grade (Brown, 2000). The presence of this difference validates the construct as it is coherent with the literature, which shows that the level of critical thinking linked to metacognition increases with age (Veenman, Wilhelm, & Beishuizen, 2004). This is explained by the fact that in 3rd grade students can give causal explanations, make simple predictions (Hapgood et al., 2004) and partially correct analogies (May et al., 2006). From 4th grade on, they are capable of developing problem solving strategies, defining tasks and monitoring their thoughts (Hudgins et al., 1989). A panel of experts was used to demonstrate content validity (Rubio et al., 2003). The panel included an expert in education, as well as an expert in philosophy and language arts. The panel’s opinions were then compared with the test developers’ opinions in order to judge the level of consistency between the two (Dillashaw & Okey, 1980; Nitko, 1996). Four think aloud sessions were also included in the study to analyse content validity (Ericsson & Simon, 1993; Flaherty, 1974). These sessions were conducted using students of a similar age to those used in the study, as suggested by Facione (1990). Correlations have been detected between critical thinking test scores and school grades among Chilean high school students (Santelices et al., 2011). Pearson’s product moment correlation was therefore used to detect correlations between the test scores and Language Arts grades so as to analyse criterion validity. This sample strategy was used as it was not possible to access the full report cards for all of the students (Ary et al., 2013). Furthermore, Cronbach’s alpha was also used to analyse the test’s reliability. This index is used to measure the internal consistency of the test (Cronbach, 1971). An item analysis was then conducted using the test results. The aim of this was to use objective data, i.e. difficulty and discrimination indices for each question, to identify the need to review, remove or modify any of the questions (Nitko, 1996). These indices were classified according to the area of critical thinking measured by each question so as then to observe which areas the students found the most and least difficult. 2.3.- Experimental work To study the relationship between critical thinking and socioeconomic status, a stratified sample was selected based on the three types of schools that are found in the Chilean education system (state, state-subsidized and private). Each type of establishment corresponds to a different socioeconomic status: low, middle and high, respectively (Gallego, 2002). Furthermore, to analyse construct validity, the study was conducted with students from two grade levels: 3rd and 4th. The participants in the sample, Table 1, included 301 students from 3rd and 4th grade from the three types of schools. It was decided to use an ANOVA in order to prove the existence of significant differences between the different groups. 3rd Grade Gender / Socioeconomic status High Middle Low Male 55 13 17 Female 47 17 14 Total 102 30 31 th 4 Grade Gender/ Socioeconomic status High Middle Low Male 40 14 18 Female 42 14 10 Total 82 28 28 Table 1. Participants in the study by socioeconomic status and gender. 3.- Results 3.1- Construct Validity The results of the Shapiro-Wilk test suggest that the students from 3rd and 4th grade were not normally distributed (3.246e-06 for 3rd grade and 1.613e-07 for 4th grade). Furthermore, the Bartlett test shows that variances within the study groups were homogeneous (a value of 0.3007). Although the normality assumption was not met, Sheng (2008) suggests that ANOVA is a robust test. It is therefore possible to use this analysis, even though some of the assumptions were violated. In order to do so, the Kruskal-Wallis test was used as a non-parametric alternative to address the violation of the normality assumption (Osborne, 2008). The test used to analyse the construct validity of the test suggests that there are significant differences between 3rd and 4th grade, at p<0.001. 3.2- Content Validity A panel of experts examined the relationship between the questions on the test and the objectives that were established for measuring critical thinking. This panel was more than 70% in agreement with the test that had been developed, which is an acceptable level. The think aloud sessions also allowed questions that were misunderstood or unclear to be corrected in the final version of the test. 3.3- Pearson product-moment correlation The Pearson product-moment correlation between the test scores and the students’ grades was 0.805 for 3rd grade and 0.723 for 4th grade. Dancey & Reidy (2004) classify strong correlation as being greater than 0.7. The results of this analysis therefore provide strong evidence of the criterion validity. 3.4- Reliability Before the item analysis, Cronbach’s alpha for the test was 0.917. Following the item analysis, Cronbach’s alpha was 0.909, which shows that the test is reliable (George & Mallery, 2003). The latter value is the result that was obtained having analysed the items according to their level of difficulty and discrimination, as detailed in the following section. 3.5- Item analysis The results from the item analysis were organized according to the area of critical thinking that was measured, and measured the level of difficulty and discrimination of each item (Table 2). A range of between 0.4 and 0.6 was chosen for this study as Womer (1968) suggests that this range can determine whether or not a question should be included on a test. Nitko (1996) also suggests that items with a difficulty index of less than 0.2 or 0.8 should also be rejected as they are too easy or too difficult. This recommendation was taken into account for the test used in this study. Finally, it was decided that questions with a difficulty index between 0.2 and 0.4 or between 0.6 and 0.8 would also be included, so long as they added to the coherence of the narrative and provided further information. Furthermore, a discrimination index greater than 0.3 was considered acceptable for any item on the test. Therefore, items with an index greater than 0.3 were considered good and items with an index less than 0.3 were considered bad (Adkins, 1974; Hinkle et al., 2003; Nitko, 1996). A summary of the distribution for all of the questions according to their level of difficulty and discrimination can be found in Table 4 in the Annex. This table also shows the skill and sub-skill to which each question belongs. The results in Table 5 reveal that Analysis was the area with the highest level of difficulty (0.36) and lowest level of discrimination (0.38). The area with the lowest level of difficulty was Interpretation, with an average of 0.62. By following Womer’s (1968) criteria regarding difficulty and discrimination, a selection was made of the items that would initially be included on the test (items 2a, 3, 4, 6a, 10, 14b, 22, 23b and 27a). Nitko’s (1996) criteria were then used to select additional items for the test (1a, 2b, 7, 8, 11, 12, 13, 14a, 16, 17a, 17,b, 18, 19a, 19b, 21, 26, 28a, 28b, 29a and 29b). The aim of this was to obtain more information, while preserving the overall coherence of the test. Finally, one item (6b) was removed from the test as it had a correlation of 1 with another item and both items targeted the same performance indicator. By doing so, the difficulty and discrimination levels for all of the items fell within the aforementioned ranges suggested by Womer (1968) and Nitko (1996) (Table 4, Annex). Discrimination/ Difficulty Difficult (<0.2) (0.2-0.4) Suitable (0.4-0.6) (0.6-0.8) Easy (>0.8) Good (<0.3) 2 items 2 items 0 items 0 items 2 items Bad (>0.3) 1 item 5 items 10 items 18 items 2 items Table 2. Summary of difficulty and discrimination levels per question. 3.6- Differences between schools A comparison was made between the groups from the different types of schools (state, state-subsidized and private). The distribution for one of the groups did not meet the normality assumption for the Shapiro-Wilk test (high: 3.208e-05, middle: 0.07288, low: 0.0207). The Bartlett test also revealed that the variances within the groups were not homogeneous (1.063e-07). However, this comparison was still possible as ANOVA is a robust test and allows assumptions to be violated (Sheng, 2008). The Kruskal-Wallis test was therefore used as a non-parametric alternative to the ANOVA test (Osborne, 2008). Significant differences were identified between socioeconomic statuses (SES), at p<0.001. Tukey’s test then revealed that the differences between the groups were significant at p >0.05. To analyse these differences in more detail, Table 3 shows the average test score for each school, as well as the standard deviation. The results clearly show that test scores in high SES schools (22.15 for 4th grade and 19.3 for 3rd grade) are considerably higher than in middle SES schools (14.75 for 4th grade and 10.73 for 3rd grade) and low SES schools (10.61 for 4th grade and 6.97 for 3rd grade). It is also important to highlight that the standard deviation between test scores in the high SES school decreases considerably (28%) from 3rd grade to 4th grade (from 4.55 to 3.27 points). In the middle SES school, the standard deviation remains practically the same (6.95 in 4th grade and 6.97 in 3rd grade), while in the low SES school there is an increase in the standard deviation (from 6.06 to 6.2). This suggests that differences in student performance are reduced over time in the high SES school, which is not the case in the other schools. School SES Grade Average Standard Score Deviation High 4 22.15 3.27 High 3 19.3 4.55 Middle 4 14.75 6.95 Middle 3 10.73 6.97 Low 4 10.61 6.20 Low 3 6.97 6.06 Table 3. Average scores by school and grade. 4.- Conclusions The aim of this study was to answer the two research questions stated above. The first question asked “How can we design and validate a test that determines the level of critical thinking among primary school children in a specific subject?” To answer this question, a critical thinking test was designed and validated within the context of Language Arts, using a graphic novel. The challenge highlighted in the research question was overcome as the test was validated for both 3rd and 4th grade students. It is interesting to note that no other test has used a graphic novel to measure the level of critical thinking among 3rd and 4th grade students. There are several benefits to designing a test using a graphic novel. These include the impact it has on student motivation and interest (Chase et al., 2014), the opportunity it provides for developing higher-order skills (Pantaleo, 2014), their effectiveness for teaching literacy (Jennings et al., 2014) and the support they provide to readers who have difficulty visualizing stories (Lyga, 2006). It remains as future work to validate tests in other areas of the curriculum, such as science and mathematics. The main limitation of the test that was used is the cultural context in which it was designed. Cultural factors are particularly important when developing critical thinking skills in Language Arts classes (Guo, 2013). Examples of this include the significant effect of culture on critical thinking among university students when writing blogs (Shahsavar, 2014) and the influence of institutional culture on critical thinking among students (Tsui, 2000). It is also important to highlight that, as the theoretical framework was developed within a specific cultural context, students may be at a disadvantage because of the structure of the test and not because of their level of critical thinking (Howe, 1995; Childs, 1990). Further study is required to analyse how local culture affects the theoretical framework for critical thinking described in this study. It is also necessary to study how local culture affects the performance of the test, in terms of both how the images are understood, as well as the structure of the narrative. Quantification of cultural factors has been studied among adults (Hofstede, 2001), but is only incipient among children (Hofstede, 1986). Developing a tool in this sense would help with the robustness of a critical thinking test for children from different cultural backgrounds. Once the test had been validated, it was decided to answer the second research question, which asked “How do critical thinking skills differ among 3rd grade students, according to their socioeconomic status?” In this sense, significant differences were found between the schools with different socioeconomic statuses. This suggests that there may be a relationship between socioeconomic status and the development of critical thinking skills. This is particularly evident when observing that the standard deviation among students in the high SES school decreases over time, increasing homogeneity among students, while the standard deviation remains the same in the other schools. Although further findings are needed in this area, it would be worth asking whether this difference can be reduced by teaching the critical thinking skills that are measured by this test. This study is a first step towards giving primary schools access to a test that allows them to measure the development of their students’ critical thinking skills. This test is an improvement on existing assessment tools as it replaces unidimensional models with models that provide a more detailed and multidimensional picture of student learning (Conley, 2015). The limitations of this study include the range of grade levels that were covered, the cultural context in which it took place, and the area of the curriculum for which the test was developed. Future work is required in order to overcome these limitations. Acknowledgements This research was funded by CONICYT-FONDECYT grant 1150045, and by the VRI Interdisciplina Research Project N° 13/2014. 5.- References Adkins, D. C. (1974). Test construction: Development and interpretation of achievement tests. Columbus, Ohio: Merrill Publishing Company. Ary, D., Jacobs, L., Sorensen, C., & Walker, D. (2013). Introduction to research in education. Cengage Learning. Bailin, S. (2002). Critical thinking and science education. Science & Education, 11(4), 361– 375. Bailin, S., Case, R., Coombs, J. R., & Daniels, L. B. (1999). Conceptualizing critical thinking. Journal of Curriculum Studies, 31(3), 285–302. Bean, J. C. (2011). Engaging ideas: The professor's guide to integrating writing, critical thinking, and active learning in the classroom. San Francisco: John Wiley & Sons. Berland, L. K., & McNeill, K. L. (2012). For whom is argument and explanation a necessary distinction? A response to Osborne and Patterson. Science Education, 96(5), 808-813. Breen, R., & Goldthorpe, J. H. (1997). Explaining educational differentials towards a formal rational action theory. Rationality and society, 9(3), 275-305. Bourdieu, P. (2011). The forms of capital.(1986). Cultural theory: An anthology, 81-93. Brown, J. D. (2000). What is construct validity. JALT Testing and Evaluation SIG Newsletter, 4(2), 7-10. Chase, M., Son, E. H., & Steiner, S. (2014). Sequencing and Graphic Novels With Primary‐ Grade Students. The Reading Teacher, 67(6), 435-443. Chapman, J. (2014). Critical Thinking and TOEIC: Advanced Skills for Teachers and TestTakers. The 2013 PanSIG Proceedings, 102. Cheung, C. K., Rudowicz, E., Lang, G., Yue, X. D., & Kwan, A. S. (2001). Critical thinking among university students: does the family background matter?. College Student Journal, 35(4), 577. Childs, R. (1990). Gender bias and fairness. Practical Assessment, Research & Evaluation, 2(3). Conley, D. (2015). A New Era for Educational Assessment. Education Policy Analysis Archives, 23, 8. Cronbach, L. J. (1971). Test validation. In R. L. Thorndike (Ed.). Educational Measurement (2nd Ed.). Washington, D. C.: American Council on Education. Dancey C., Reidy J. (2004). Statistics Without Maths for Psychology: Using SPSS for Windows. London: Prentice Hall Das, A. (2013). The Impact of Children’s Literature in the Teaching of English to Young Learners. International Journal of English: Literature, Language & Skills. Dillashaw, F.G. & Okey, J. R. (1980). Test of Integrated Science Process Skills for Secondary Students. Science Education, 64, 601-608. Downey, E. M. (2009). Graphic novels in curriculum and instruction collections.Reference & User Services Quarterly, 49(2), 181-188. Dwyer, C. P., Hogan, M. J., & Stewart, I. (2014). An integrated critical thinking framework for the 21st century. Thinking Skills and Creativity, 12, 43-52. Emmison, M., & Smith, P. (2000). Researching the Visual: Images, Objects, Contexts and Interactions in Social and Cultural Inquiry: Introducing Qualitative Methods. Ennis, R. H. (1989). Critical thinking and subject specificity: Clarification and needed research. Educational researcher, 18(3), 4-10. Ennis, R.H. & Millman, J. (1985). Cornell Critical Thinking Test-Level X. Pacific Grove, CA: Midwest Publications. Ennis, R.H. & Weir, E. (1985). The Ennis-Weir essay test: An instrument for testing and teaching. Midwest Publications: Pacific Grove, CA. Ericsson, K. A., & Simon, H. A. (1993). Protocol Analysis: Verbal reports on data. Cambridge, MA: MIT Press. Facione, P. A. (1990). Critical Thinking: A Statement of Expert Consensus for Purposes of Educational Assessment and Instruction. Research Findings and Recommendations. http://assessment.aas.duke.edu/documents/Delphi_Report.pdf, downloaded Feb 3, 2014. Flavell, J. H. (1979). Metacognition and cognitive monitoring: A new area of cognitive– developmental inquiry. American psychologist, 34(10), 906. Flaherty, E. G. (1974). The thinking aloud technique and problem-solving ability. Journal of Educational Research, 68, 223-225. Frey, N., & Fisher, D. (2004). Using graphic novels, anime, and the Internet in an urban high school. English Journal, 19-25. Gallego, F. A. (2002). Competencia y resultados educativos: teoría y evidencia para Chile. cuadernos de economía, 39(118), 309-352. Gelman, S. A., & Markman, E. M. (1987). Young children's inductions from natural kinds: The role of categories and appearances. Child development, 1532-1541. George, D and Mallery, P. 2003. SPSS for Windows step by step: a simple guide and reference, Boston, MA: Allyn and Bacon. Greenhill, V. (2009). P21 framework definitions document, Retrieved December 15, 2010, from, http://www.21stcenturyskills.org/documents/p21_framework_definitions_052909.pdf. Griffin, P., McGaw, B., & Care, E. (2012). Assessment and Teaching of 21st Century Skills. New York: Springer Guo, M. (2013). Developing Critical Thinking in English Class: Culture-based Knowledge and Skills. Theory and Practice in Language Studies, 3(3), 503-507. Halpern, D. (2003). Thought and knowledge: An introduction to critical thinking (4th ed.). Mahwah, NJ: Lawrence Erlbaum Associates. Hapgood, S., Magnusson, S. J., & Sullivan-Palincsar, A. (2004). Teacher, text, and experience: A case of young children's scientific inquiry. Journal of the Learning Sciences, 13(A), 455-505. Hassett, D. D., & Schleble, M. B. (2007). Finding Space and Time for the Visual in K-12 Literacy Instruction. English Journal, 97(1). Hernandez, D. J. (2011). Double Jeopardy: How Third-Grade Reading Skills and Poverty Influence High School Graduation. Annie E. Casey Foundation. Hinkle, D. E., Wiersma, W., & Jurs, S. G. (2003). Applied statistics for the behavioral sciences. Boston: Houghton Mifflin. Hofstede, G. (1986). Cultural differences in teaching and learning. International Journal of intercultural relations, 10(3), 301-320. Hofstede, G. (2001). Culture's consequences: Comparing values, behaviors, institutions and organizations across nations. Geert Hofstede (Ed.). Thousand Oaks, California: Sage. Hong-Nam, K., Leavell, A. G., & Maher, S. (2014). The Relationships among Reported Strategy Use, Metacognitive Awareness, and Reading Achievement of High School Students. Reading Psychology, 35(8), 762-790. Howe, K. (1995). Validity, Bias and Justice in Educational Testing: The Limits of Consequensialist Conception. In A. Neiman, Ed., Philosophy of education 1995. Normal, ILL: Philosophy of Education Society, pp. 295-302. Hudgins, B. B., et al. (1989). Children's critical thinking: A model for its analysis and two examples. Journal of Educational Research, 82(6), 327-338. Jennings, K. A., Rule, A. C., & Zanden, S. M. V. (2014). Fifth Graders’ Enjoyment, Interest, and Comprehension of Graphic Novels Compared to Heavily-Illustrated and Traditional Novels. International Electronic Journal of Elementary Education, 6(2), 257. Jiménez-Aleixandre, M. P., & Puig, B. (2012). Argumentation, evidence evaluation and critical thinking. In Second international handbook of science education (pp. 1001-1015). Springer Netherlands. Kennedy, M., Fisher, M. B., & Ennis, R. H. (1991). Critical thinking: Literature review and needed research. Educational values and cognitive instruction: Implications for reform, 2, 11-40. Kim, K., Sharma, P., Land, S. M., & Furlong, K. P. (2013). Effects of active learning on enhancing student critical thinking in an undergraduate general science course. Innovative Higher Education, 38(3), 223-235. Kuhn, D. (1999). A developmental model of critical thinking. Educational Researcher, 28(2), 16–26. Lai, E. R. (2011). Critical thinking: A literature review. Pearson's Research Reports, 6, 4041. Lyga, A. A. (2006). Graphic Novels for (Really) Young Readers: Owly, Buzzboy, Pinky and Stinky. Who Are These Guys? And Why Aren't They Ever on The Shelf?. School Library Journal, 52(3), 56. Marques, J.F., (2012), Moving from trance to think: why we need to polish our critical thinking skills, International Journal of Leadership Studies, Vol. 7 Iss. 1, 2012, 87-95 May, D. B., Hammer, D., & Roy, P. (2006). Children's analogical reasoning in a third grade science discussion. Science Education, 90(2), 316-330. McNamara, D. S., & Magliano, J. P. (2009). 5 Self-Explanation and Metacognition. Handbook of metacognition in education, 60. McPeck, J. (1981). Critical Thinking and Education. Oxford: Martin Robertson. Moore, M.& Zigo, D. (2005). Chicken Soup for the Science Fiction Soul: Breaking the Genre Lock in the High School Literacy Experience. Journal of Curriculum. 21(3), 29-45. Mulnix, J. W. (2012). Thinking critically about critical thinking. Educational Philosophy and Theory, 44(5), 464-479. Nickerson, R. (1988). On improving thinking through instruction. Review of Research in Education, 15(3), 3-57. Nippold, M. A., Frantz-Kaspar, M. W., Cramond, P. M., Kirk, C., Hayward-Mayhew, C., & MacKinnon, M. (2015). Critical Thinking about Fables: Examining Language Production and Comprehension in Adolescents. Journal of Speech, Language, and Hearing Research. Nitko, A. J. (1996). Educational Assessment of Students. 2nd ed. New Jersey: Prentice-Hall. Nussbaum, M. C. (2011). Creating capabilities. Harvard University Press. O’Flahavan, J. & Tierney, R. (2013). Reading, Writing, and Critical Thinking. Educational Values and Cognitive Instruction: Implications for Reform, 41. Osakwe, R. N. (2009). The effect of early childhood education experience on the academic performances of primary school children. Stud Home Comm Sci,3(2), 143-147. Osborne, J. W. (Ed.). (2008). Best practices in quantitative methods. Thousands Oaks: Sage. Pantaleo, S. (2014). Reading images in graphic novels: Taking students to a'greater thinking level'. English in Australia, 49(1), 38. Rubio, D. M., Berg-Weger, M., Tebb, S. S., Lee, E. S., & Rauch, S. (2003). Objectifying content validity: Conducting a content validity study in social work research. Social Work Research, 27(2), 94-104 Santelices, M. V., Ugarte, J. J., Flotts, P., Radovic, D., & Kyllonen, P. (2011). Measurement of New Attributes for Chile's Admissions System to Higher Education. ETS Research Report Series, 2011(1), 1-44. Schwarz, G. (2006). Expanding literacies through graphic novels. English Journal, 58-64. Shahsavar, Z. (2014). The Impact Of Culture On Using Critical Thinking Skills Through The Blog. Media & Mass Communication, 3, 99-105. Sheng, Y. (2008). Testing the assumptions of analysis of variance, In Osborne, J.W. (Ed.) Best Practices in Quantitative Methods. California: Sage. Songer, N. B., & Gotwals, A. W. (2012). Guiding explanation construction by children at the entry points of learning progressions. Journal of Research in Science Teaching, 49(2), 141165. Sturken, M., Cartwright, L., & Sturken, M. (2001). Practices of looking: An introduction to visual culture (p. 385). Oxford: Oxford University Press Swaggerty, E. A. (2015). Selecting Engaging Texts for Upper Elementary Students Who Avoid Reading or Find Reading Difficult. Children's Literature in the Reading Program: Engaging Young Readers in the 21st Century, 150. Tsui, L. (2000). Effects of campus culture on students' critical thinking. The Review of Higher Education, 23(4), 421-441. UNESCO. (2000). Dakar Framework for Action. Education for All: Meeting Our Collective Commitments. Adopted by the World Education Forum, Dakar, Senegal, April 26–28, 1999. Paris: UNESCO. http://unesdoc.unesco.org/images/0012/001211/121147e.pdf Van Den Broek, P., Kendeou, P., Lousberg, S., & Visser, G. (2011). Preparing for reading comprehension: Fostering text comprehension skills in preschool and early elementary school children. International Electronic Journal of Elementary Education, 4(1), 259-268. Veenman, M. V. J., Wilhelm, P., & Beishuizen, J. J. (2004). The relation between intellectual and metacognitive skills from a developmental perspective. Learning and Instruction, 14(1), 89-109. Watson, G. B., & Glaser, E. M. (1980). WGCTA Watson-Glaser critical thinking appraisal manual: Forms A and B. San Antonio: The Psychological Corporation. Willingham, D. T. (2008). Critical thinking: Why is it so hard to teach?. Arts Education Policy Review, 109(4), 21-32. Wolming , S. (1998). Validitet. Ett traditionellt begrepp i modern tillämpning [Validity: A modern approach to a traditional concept]. Pedagogisk Forskning i Sverige, 3(2): 81–103. Womer, F. B. (1968). Basic concepts in testing. Boston: Houghton Mifflin. Yeh, S. S. (2001). Tests worth teaching to: Constructing state-mandated tests that emphasize critical thinking. Educational Researcher, 30(9), 12-17. ANNEX Skill Definition1 Sub-­‐Skill Categorize Interpretation Understanding and expressing the meaning or Decode significance importance of a wide variety of experiences, situations, data, events, judgements, conventions, beliefs, rules, procedures or criteria. Performance Indicators Classifying elements according to certain rules, criteria or procedures. Identifying which elements are important for solving a problem. Clarify meaning Clarifying the use of a convention. Clarifying an idea by The definitions of the skills are taken from the Delphi Report (Facione, 1990) 0.7 0.48 0.65 0.34 0.8 0.35 0.48 0.49 0.64 0.39 0.38 0.37 Determining the role of images in a narrative. (**) Representing a result or operation in different ways. 1 Difficulty Discrimination giving an example. Examine ideas Analysis Evaluation Identifying the intended and actual inferential relationships among statements, questions, Identify arguments concepts, descriptions, or other forms of representation intended to express belief, judgment, experiences, reasons, information, or opinions. Analyse arguments Assessing the credibility of statements or other representations that are Assess claims accounts or descriptions of a person's perception, experience, situation, judgment, belief, or opinion; also assessing the logical strength of the actual or intended inferential relationships among Assess arguments statements, descriptions, questions, or other forms of representation. Comparing concepts or statements by determining similarities and differences. 0.72 0.51 0.21 0.33 0.35 0.42 0.35 0.42 0.46 0.42 Judging whether a conclusion is correct based on the premises adopted. 0.28 0.28 Assessing the strength of the logic of an objection to an argument. 0.63 0.37 Identifying whether an argument is in favour of or against a given statement. Identifying the main point of an argument. (**) Identifying the reasons that support an argument. (**) Recognizing the important factors for determining the degree of credibility of a source of information or opinion. Judging whether an argument is relevant, applicable or has any implication on a situation. Assess alternatives Inference Identifying and securing elements needed to draw reasonable conclusions; forming conjectures and Query evidence hypotheses, considering relevant information and reducing the consequences flowing from data, statements, principles, evidence, judgments, beliefs, opinions, concepts, descriptions, questions, or other forms of representation. Propose alternatives 0.65 0.52 0.67 0.62 Determining whether information is useful for building an argument. 0.81 0.23 Identifying whether an inference comes from evidence. 0.43 0.31 0.36 0.33 0.46 0.3 0.6 0.61 Assessing the advantages and disadvantages of different alternatives. (**) Identifying what additional information is needed to decide between two contradicting opinions. Accepting or rejecting a hypothesis based on empirical evidence. Given a set of priorities with which one may or may not agree, seeing the advantages and disadvantages that will come from implementing a decision once it has been made. (**) Using different strategies to solve problems. (**) Draw conclusions Reasoning / Explanation Stating and justifying reasoning in terms of the evidential, conceptual, methodological, criteriological, and State results contextual considerations upon which one's results were based; also presenting one's reasoning in the form of cogent arguments. 0.81 0.55 0.69 0.52 0.67 0.68 0.46 0.45 0.82 0.35 Arriving at a valid conclusion based on evidence. Communicating the conclusions reached by following a procedure. (**) Graphically communicating the relationship between concepts and ideas. Developing a narrative which examines the changes in a topic over time. Stating the standards used to assess a literary work. Justify procedures Describing the strategy used to make a reasonable decision. Arguing in favour of or against a point of view. Present arguments Explaining the comprehension of a concept. (**) Identifying and expressing evidence as part of reasoning for and against other people’s and one’s own way of thinking. Table 4. Summary of scores and skills. (*) Items based on the Delphi Report. (**) Indicators that were measured on more than one occasion. 0.75 0.64 0.18 0.41 0.63 0.65 0.35 0.14 0.72 0.66 Skill Pre-­‐Item Analysis Difficulty Discrimination Interpretation Analysis Inference Evaluation Explanation Post-­‐Item Analysis Difficulty Discrimination 0.62 0.43 0.6 0.45 0.36 0.38 0.47 0.45 0.58 0.41 0.57 0.44 0.47 0.4 0.6 0.48 0.41 0.47 0.59 0.57 Table 5. Average scores for Difficulty and Discrimination, before and after the Item Analysis. Anexo C. Recepción del Paper en Revista Académica Dear Dr. Rodrigo Del Rio, You have been listed as a Co-Author of the following submission: Journal: Thinking Skills and Creativity Corresponding Author: Damian Gelerstein Co-Authors: Rodrigo Del Rio; Miguel Nussbaum, Ph.D; Pablo Chiuminatto, Ph.D Title: Designing and implementing a test for measuring critical thinking in primary school If you did not co-author this submission, please contact the Corresponding Author of this submission [email protected];[email protected]; do not follow the link below. An Open Researcher and Contributor ID (ORCID) is a unique digital identifier to which you can link your published articles and other professional activities, providing a single record of all your research. We would like to invite you to link your ORCID ID to this submission. If the submission is accepted, your ORCID ID will be linked to the final published article and transferred to CrossRef. Your ORCID account will also be updated. To do this, visit our dedicated page in EES. There you can link to an existing ORCID ID or register for one and link the submission to it: http://ees.elsevier.com/tsc/l.asp?i=7055&l=UUAIE5G1 More information on ORCID can be found on the ORCID website, http://www.ORCID.org, or on our help page: http://help.elsevier.com/app/answers/detail/a_id/2210/p/7923 Like other Publishers, Elsevier supports ORCID - an open, non-profit, community based effort - and has adapted its submission system to enable authors and co-authors to connect their submissions to their unique ORCID IDs. Thank you, Thinking Skills and Creativity