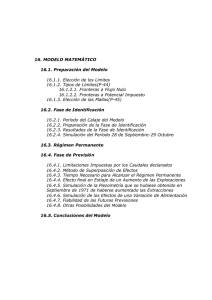

Tarea Extraclase de la Asignatura: Simulación Ejercicio No. 2 Integrantes: Ceidy Marian Ravelo Peña María Fernanda Díaz Ramírez Grether Suárez Garzón Dairon Delgado Mora Chalem Martínez Díaz Introducción: Desde hace mucho tiempo, la técnica de simulación ha sido una herramienta importante para el diseñador. Por ejemplo, la simulación del vuelo de un avión en un túnel de viento es una práctica normal con los nuevos diseños. En teoría, se podrían usar las leyes de la física para obtener la misma información sobre los cambios en el desempeño del avión si cambian los parámetros, pero en sentido práctico, el análisis sería muy complejo. Otra alternativa sería construir aviones reales para cada diseño y probarlos en vuelos reales para elegir el diseño final, pero este recurso sería demasiado costoso (al igual que peligroso). Por lo tanto, después de realizar un análisis teórico preliminar para desarrollar un diseño básico, la herramienta viable para experimentar con los diseños específicos es la simulación del vuelo en un túnel de viento. Esta actividad implica imitar el desempeño de un avión real en un medio controlado con el fin de estimar cuál sería su desempeño real. Después de desarrollar un diseño detallado de esta manera, es posible construir un prototipo y probarlo en un vuelo real para ajustar los últimos detalles del diseño final. Un modelo de simulación sintetiza el sistema con su construcción de cada componente y de cada evento. Después, el modelo corre el sistema simulado para obtener observaciones estadísticas del desempeño del sistema como resultado de los diferentes eventos generados de manera aleatoria. Debido a que las corridas de simulación, por lo general, requieren la generación y el procesado de una gran cantidad de datos, es inevitable que estos experimentos estadísticos simulados se lleven a cabo en una computadora. La simulación casi siempre se usa cuando el sistema estocástico en cuestión es demasiado complejo para que su análisis con los modelos analíticos (como modelos de colas) descritos en los capítulos anteriores, sea satisfactorio. Lo más importante del enfoque analítico es que abstrae la esencia del problema, revela su estructura fundamental y proporciona una visión de las relaciones causa-efecto dentro del sistema. La simulación es una de las técnicas que más se emplean en investigación de operaciones debido a que es una herramienta flexible, poderosa e intuitiva. En cuestión de segundos o minutos, puede simular incluso años de operación de un sistema común mientras genera una serie de observaciones estadísticas sobre el desempeño del sistema en este periodo. Debido a su excepcional versatilidad, la simulación se ha aplicado en una amplia variedad de áreas. Problemática: Ray y Bob trabajan en una línea de producción de dos etapas, donde la estación de Ray está a continuación de la estación de Bob. Se conoce que el tiempo que demora Bob en realizar las operaciones de su puesto de trabajo siguen una distribución normal con media de 15 minutos y desviación típica de 5 minutos, mientras que en el caso de Ray solo se dispone de un conjunto de observaciones sobre su desempeño, según se muestra a continuación: Observaciones realizadas sobre el tiempo que demora Ray en ejecutar las operaciones correspondientes a su puesto de trabajo: 17.48 15.06 18.23 13.23 15.68 12.36 14.93 17.29 18.11 10.78 11.77 11.71 11.34 10.88 19.25 14.21 19.80 10.72 16.64 18.03 11.40 19.42 10.50 19.90 15.94 15.28 17.73 10.42 12.23 17.15 17.88 11.71 14.18 11.10 13.33 15.30 10.55 12.67 17.56 16.18 15.12 19.05 12.28 17.00 12.31 18.37 16.13 19.68 17.68 13.08 17.49 15.45 13.55 13.27 15.44 18.61 Conociendo que el tiempo entre arribos de las partes a la primera estación es exponencial con media 12 minutos. a). Realice una simulación de una jornada laboral (8 horas) del funcionamiento del sistema descrito para estimar los tiempos en cada una de las colas, el tiempo total en sistema, el número promedio de unidades en cada cola y la utilización de los recursos. Diagrama de Flujo de la problemática: Resultados del Input Analyzer Distribution Summary Distribution: Uniform Expression: UNIF(10, 20) Square Error: 0.008929 Los datos que se obtienen en el Input Analyzer se utilizan para comprobar que distribución siguen los datos sobre el tiempo que demora Ray en ejecutar las operaciones correspondientes a su puesto de trabajo, en este caso la distribución con menor error es la Distribución Uniforme. Descripción de los módulos que componen el modelo implementado en Arena. Módulos utilizados: Create: es el punto de inicio del modelo de simulación, es el que da entrada a las entidades y registra las características de sus arribos. Assign: es donde se asignan nuevos valores a entidades, variables, atributos, etc,(en este caso el atributo se utiliza para marcar el Tiempo de llegada al sistema).Al colocar como nuevo valor la denominación tnow actúa como un reloj donde se registran todos los tiempos de llegada. Process: representa la máquina, incluyendo el recurso, la cola y el tiempo de procesamiento. Es el responsable de capturar, retener y liberar las entidades, en dependencia de las especificaciones del problema a simular. Record: sirve para recolectar información de contadores de tiempos, tiempo de ciclo, intervalos de tiempos, etc. En este caso recolecta tiempos con el tnow (reloj de la simulación), marcando el tiempo de salida del sistema. Dispose: representa las entidades abandonando el sistema. Es imprescindible en la simulación. Configuración de cada módulo: Configuración de Statistics Los resultados obtenidos para las primeras 30 réplicas, no permiten ver si los resultados alcanzados son realmente confiables, por tanto, se debe calcular la cantidad de réplicas realmente necesarias para tener resultados realmente confiables para emitir un juicio final. Para ello se precisa calcular el tamaño de muestra o número de réplicas necesario para un error (h) de, por ejemplo, un 10% respecto al valor esperado de cada magnitud, el cual se puede estimar con ayuda de la siguiente expresión. Se necesita calcular el error permitido (h) para cada magnitud, o sea, el 10% del valor medio para cada magnitud, para esto se utilizan los datos que se muestran a continuación. Estos datos son el resultado de procesar en el Output Analyzer los datos guardados en los ficheros creados en el módulo Statistics. Antes de realizar el análisis de estos resultados, resulta necesario transformar el formato de las magnitudes que son del tipo TimePersistent, y para ello se utiliza la opción Batch/Truncate del Menú Analyze de este programa Una vez transformados los ficheros ya se pueden analizar para ello se selecciona la opción Conf. Int. (Mean) IDENTIFIER AVERAGE STANDARD 0.950 C.I. MINIMUM DEVIATION HALF-WIDTH VALUE Longitud de la cola Estación Bob Longitud de la cola Estación Ray Utilización Bob 2.55 0.514 0.358 0.305 0.667 Utilización Ray 0.367 MAXIMUM VALUE NUMBER OF OBS. 1.28 3.02 0.219 0.103 0.924 0.577 1.43 0 1 3 0.5 0.519 0.3 0 1 14 W1(T. en el sistema) 1.51 0.687 0.249 3.84 854 0.0461 10 10 Tiempo en cola Estación Bob 0.52 0.196 0.131 0.0251 0.687 11 Tiempo en cola Estación Ray 0.09 0.0769 0.055 0.0167 0.235 10 Los resultados expuestos anteriormente muestran el valor medio, la desviación estándar, la amplitud del intervalo de confianza, y el valor mínimo y máximo registrados durante la simulación para cada una de las tres magnitudes bajo estudio, para las 30 réplicas o repeticiones que se han realizado. Así, se observa que como promedio el tiempo de una entidad en el sistema es de 1.51 horas, con una desviación estándar de 0.687 horas, por ejemplo. A continuación, se calcula el error permitido (h) para cada magnitud, 10% del valor medio h(LqBob)=2.55*0.10=0.255 h(LqRay)=0.358*0.10=0.0358 h(W)=1.51*0.10=0.151 h(WqBob)=0.52*0.10= 0.052 h(WqRay)=0.09*0.10= 0.009 h(UBob)=0.667*0.10=0.0667 h(URay)=0.5*0.10=0.05 Sustitución para un nivel de significación α =0.05, con lo cual 𝒁1−𝛂=1.96 n(LqBob)= (1.96 * (0.514)/ (0.255))2= 15.61 n(LqRay)= (1.96 * (0.305)/ (0.0358)2=278.83 n(W)= (1.96 * (0.687)/ (0.151))2=79.52 n(WqBob)= (1.96 * (0.196)/ (0.052)2= 54.58 n(WqRay)= (1.96 * (0.0769)/ (0.009)2= 280.47 n(UBob)= (1.96 * (0.577)/ (0.0667)2= 287.48 n(URay)= (1.96 * (0.519) / (0.05)2= 413.91 De lo anterior se tiene que el tamaño de muestra mínimo para que los resultados de las tres magnitudes bajo observación tengan como máximo un error de 0.1 es de 414 (el mayor) con un nivel de significación a=0.05, o sea que resulta necesario ejecutar 414 réplicas como mínimo para tener resultados con la precisión deseada. Ahora se debe modificar el Number of Replications en la opción Replication Parameters del Run Setup de 30 a 414 o más. A partir de este cambio, los resultados se vuelven a procesar en el Output Analyzer, y se ofrece el siguiente resumen: IDENTIFIER W1 AVERAGE STANDARD 0.950 C.I. MINIMUM MAXIMUM NUMBER DEVIATION HALF-WIDTH VALUE VALUE OF OBS. 1.63 0.834 0.0152 0.212 5.22 11630 IDENTIFIER Longitud de la cola Estación Bob IDENTIFIER Longitud de la cola Estación Ray IDENTIFIER Utilización Bob IDENTIFIER Utilizacion Ray AVERAGE STANDARD 0.950 C.I. MINIMUM MAXIMUM NUMBER DEVIATION HALF-WIDTH VALUE VALUE OF OBS. 2.55 0.514 0.367 1.28 3.02 10 AVERAGE STANDARD 0.950 C.I. MINIMUM MAXIMUM NUMBER DEVIATION HALF-WIDTH VALUE VALUE OF OBS. 0.358 0.305 0.219 0.103 0.924 10 AVERAGE STANDARD 0.950 C.I. MINIMUM MAXIMUM NUMBER DEVIATION HALF-WIDTH VALUE VALUE OF OBS. 0.667 0.577 1.43 0 1 3 AVERAGE STANDARD 0.950 C.I. MINIMUM MAXIMUM DEVIATION HALF-WIDTH VALUE VALUE 0.5 0.519 0.3 0 1 NUMBER OF OBS. 14 IDENTIFIER Tiempo en cola Estación Bob IDENTIFIER Tiempo en cola Estación Ray AVERAGE STANDARD 0.950 C.I. MINIMUM MAXIMUM DEVIATION HALF-WIDTH VALUE VALUE 0.52 0.196 0.131 0.0251 0.687 NUMBER OF OBS. 11 AVERAGE STANDARD 0.950 C.I. MINIMUM MAXIMUM NUMBER DEVIATION HALF-WIDTH VALUE VALUE OF OBS. 0.09 0.0769 0.055 0.0167 0.235 10 Al analizar los datos obtenidos se detectan variables que pudieran mejorar sus valores, a partir de la percepción del equipo las variables que pueden mejorarse son: Tiempo en el sistema -1.63h Tiempo de espera en la Estación Bob -0.52h Las propuestas de mejora son las siguientes: -Aumentar a 2 recursos en la Estación de Bob para así disminuir el tiempo de espera en esta, y el tiempo en el sistema. (Escenario 2) -Aumentar a 2 recursos cada Estación, Bob y Ray respectivamente. (Escenario 3) A continuación, en el Process Analyzer se demuestran los resultados de utilizar esta propuesta A continuación, se muestra un gráfico donde se puede apreciar visualmente las respuestas a los cambios en cada escenario y como resultado el mejor escenario es el 3. Para poner en práctica la propuesta se debe consultar con el centro si posee condiciones para aumentar a 2 los recursos de sus procesos Conclusiones La cantidad de réplicas necesarias para desarrollar la simulación de la problemática es 414, análisis que resulta del procesamiento de las primeras 30 réplicas en el Output Analyzer Se proponen como posibles alternativas -Aumentar a 2 recursos en la Estación de Bob para así disminuir el tiempo de espera en esta, y el tiempo en el sistema. (Escenario 2) -Aumentar a 2 recursos cada Estación, Bob y Ray respectivamente. (Escenario 3) Las propuestas se analizan sin tener en cuenta el costo de los recursos, de ahí que la mejor sea el Escenario 3 La simulación permite el análisis de una problemática, encontrar sus deficiencias y mejorar las variables necesarias para optimizar el proceso. Bibliografía Argon, N. T. y S. Andradóttir: “Replicated Batch Means for Steady-State Simulations”, Naval Research Logistics, septiembre de 2006. Hillier F.S y Lieberman G.J: Introducción a la Investigación de Operaciones 9na Edición. 2010 by The McGraw-Hill Companies, Inc. Fishman, G. S.: Discrete-Event Simulation: Modeling, Programming and Analysis, Springer, Nueva York, 2001. Anexos Entidad Queue Uso Statistics