![Econometria con Excel 29[1]](http://s2.studylib.es/store/data/009030294_1-ddbfafcf0709caadf4132e179561c4ed-768x994.png)

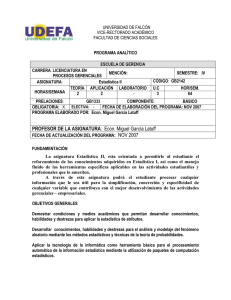

ECONOMETRÍA PRÁCTICA

CON EXCEL

SERGIO ZÚÑIGA

Universidad Católica del Norte

Julio, 2004

PRESENTACION

Es sabido que el estudio de la econometría requiere, en apoyo al estudio de los aspectos

conceptuales, la estimación empírica de los modelos econométricos para análisis, contrastación

y predicción. Para esto el estudiante debe estar familiarizado con un buen programa de

ordenador, de los cuales existen en el mercado muchas alternativas, como por ejemplo RATS,

E-Views, Limdep, Gauss, Stata o SAS, cada uno de ellos con características especiales. Este

libro se ocupa de introducir al lector en el programa Excel.

Si bien Excel no es el programa preferido por los econometristas, a través de este libro

mostramos la forma en que éste puede ayudar a alcanzar la mayor parte de los objetivos

planteados para una asignatura de econometría de pregrado.

Como se verá, este libro es un texto de apoyo en los laboratorios computacionales de

econometría, es decir tiene un objetivo netamente práctico, por lo cual hemos intentado

presentar y resolver gran número de ejemplos numéricos, a costa de centrarnos solo en los

aspectos fundamentales de la teoría subyacente, la que asumimos será estudiada en alguno de

los númerosos libros de texto introductorio existentes, tales como “Introducción a la

Econometría” de Maddala, “Análisis Econométrico” de Green, “Introduction to the Theory and

Practice of Econometrics” de Judge et al., y “Econometría” de Gujarati.

INDICE

PRESENTACION ............................................................................................................................................................. 1

CAPÍTULO 1..................................................................................................................................................................... 1

EL PROGRAMA EXCEL ................................................................................................................................................ 1

1.1.

ESTADISTICA DESCRIPTIVA CON EXCEL ................................................................................................ 1

1.2.

SESGO, CURTOSIS Y NORMALIDAD.......................................................................................................... 4

1.3.

GRAFICOS DE PROBABILIDAD NORMAL................................................................................................. 6

1.4.

HISTOGRAMA ................................................................................................................................................ 9

1.5.

OPERACIONES CON ESCALARES Y MATRICES .................................................................................... 11

a) Crear una fórmula matricial.................................................................................................................................. 11

b) Calcular un único resultado .................................................................................................................................. 11

c) Calcular varios resultados ..................................................................................................................................... 11

d) Operaciones Matriciales........................................................................................................................................ 12

1.6.

DISTRIBUCIONES DE PROBABILIDAD.................................................................................................... 13

1.7.

POTENCIA DE UN TEST .............................................................................................................................. 15

1.7.1. APLICACIÓN: SELECCIÓN ENTRE TESTS ALTERNATIVOS ................................................................. 16

1.8.

NIVEL DE SIGNIFICANCIA MARGINAL: CDF O P-VALUE.................................................................... 17

1.8.1. Distribución Normal......................................................................................................................................... 17

1.8.2. Distribución t.................................................................................................................................................... 18

1.8.3. Distribución F .................................................................................................................................................. 19

1.8.4. Distribución Chi cuadrado............................................................................................................................... 20

1.9. PRUEBAS SOBRE LA MEDIA EN EXCEL ......................................................................................................... 21

1.9.1. Inferencia respecto a una Media...................................................................................................................... 21

1.9.2. Diferencia de dos Medias (Univariado)........................................................................................................... 22

1.9.3. Inferencia En Excel .......................................................................................................................................... 23

1.10.

SERIES DE DATOS........................................................................................................................................ 26

CAPÍTULO 2................................................................................................................................................................... 28

EL MODELO DE REGRESIÓN LINEAL................................................................................................................... 28

2.1.

INTRODUCCIÓN: ¿QUE ES LA ECONOMETRÍA? .................................................................................... 28

2.2.

ESTIMACIÓN DE MODELOS DE REGRESIÓN ......................................................................................... 28

2.2.1. EL MÉTODO DE MÍNIMOS CUADRADOS ................................................................................................... 29

2.2.2. IMPLEMENTACIÓN DE MCO ....................................................................................................................... 31

2.3.

PRUEBA DE HIPÓTESIS............................................................................................................................... 33

2.3.2. LA DISTRIBUCIÓN DE b Y SUS PROPIEDADES ..................................................................................... 33

2.3.3. LA MATRIZ DE COVARIANZAS DE LOS ERRORES ................................................................................ 34

2.3.4. UNA MEDIDA DEL ÉXITO DE AJUSTE.................................................................................................... 36

2.4. CASO DE ESTUDIO .............................................................................................................................................. 38

2.4.1. Describiendo los Datos .................................................................................................................................... 38

2.4.2. Calculando Estadísticas ................................................................................................................................... 39

2.4.3. Transformación de datos y creación de nuevas series ..................................................................................... 39

2.4.5. Gráficos de Series de Tiempo........................................................................................................................... 40

2.4.6. Gráficos X-Y (Scatter) ...................................................................................................................................... 40

2.4.7. CASO DE ESTUDIO: Corriendo la Regresión 1 ............................................................................................. 42

2.4.8. CASO DE ESTUDIO: Corriendo la Regresión 2 ............................................................................................. 43

2.5.

INTERPRETACION DE LOS COEFICIENTES DE REGRESIÓN............................................................... 45

i

2.5.1. INTRODUCCIÓN ........................................................................................................................................ 45

2.5.2. FORMA DOBLE LOGARÍTMICA ............................................................................................................... 46

2.5.3

MODELO LOGARÍTMICO LINEAL (DE CRECIMIENTO CONSTANTE) ................................................ 46

2.5.4. OTRA VISIÓN DE LOS COEFICIENTES DE PENDIENTE....................................................................... 47

2.6 RESUMEN: UNA CRÍTICA AL MODELO....................................................................................................... 50

CAPÍTULO 3................................................................................................................................................................... 51

MÍNIMOS CUADRADOS RESTRINGIDOS (INFERENCIA) ................................................................................. 51

3.1.

MCO CON ERRORES NORMALES ............................................................................................................. 51

3.2.

PRUEBAS SOBRE UN COEFICIENTE......................................................................................................... 53

3.3.

TRES TESTS EQUIVALENTES .................................................................................................................... 54

3.4.

TEST DE RAZON DE VEROSIMILITUD (LR) ............................................................................................ 54

3.4.1. LR BAJO ESPECIFICACION LINEAL-LINEAL ............................................................................................. 55

3.5. TEST DE WALD .................................................................................................................................................... 57

3.5.1. WALD BAJO ESPECIFICACION LINEAL-LINEAL ....................................................................................... 57

3.5.2. EJEMPLO NUMERICO DEL TEST DE WALD .............................................................................................. 58

3.6. TEST DEL MULTIPLICADOR DE LAGRANGE................................................................................................. 59

3.7.

PRUEBA DE SIGNIFICANCIA GLOBAL .................................................................................................... 60

3.8.

PRUEBA DE EXCLUSION DE VARIABLES............................................................................................... 61

3.9.

PRUEBA DE CAUSALIDAD (GRANGER, 1969) ........................................................................................ 62

3.10.

TEST DE ESTABILIDAD (CAMBIO ESTRUCTURAL).............................................................................. 65

3.11.

ESTIMANDO REGRESIÓNES RESTRINGIDAS ........................................................................................ 66

CAPÍTULO 4................................................................................................................................................................... 67

VIOLACIÓN DE ALGUNOS SUPUESTOS ................................................................................................................ 67

4.1.

MÍNIMOS CUADRADOS GENERALIZADOS............................................................................................ 68

4.2.

HETEROCEDASTICIDAD............................................................................................................................ 69

4.2.1. CORRECCIÓN CON MCG (ϕ CONOCIDA) ............................................................................................. 70

4.2.2. DETECCION DE LA HETEROCEDASTICIDAD ....................................................................................... 72

1.- Test de Goldfeld y Quandt (1972) ........................................................................................................................................ 72

2.- Arch Test de White (1980): .................................................................................................................................................. 73

3.- Arch Test de Engle (1982):................................................................................................................................................... 74

4.2.3. CORRIGIENDO POR HETEROCEDASTICIDAD: MC PONDERADOS................................................... 75

4.3.

CORRELACIÓN SERIAL .............................................................................................................................. 77

4.3.1. CORRECCIÓN CON MCG (ϕ CONOCIDA) ............................................................................................. 78

4.3.2. DETECCION DE AR(1): DURBIN-WATSON (1951) ................................................................................. 80

4.3.3. DETECCION EN MODELOS CON Y REZAGADA: Test h de Durbin ....................................................... 83

4.3.4. DETECCIÓN DE LA AUTOCORRELACIÓN DE ORDEN SUPERIOR..................................................... 84

a) Test de BREUSCH (1978) Y GODFREY (1978) .................................................................................................................. 84

b) Test Q de Ljung y Box (1978) (Box-Jenkins model identification) ....................................................................................... 85

4.3.4.

CORRIGIENDO LA AUTOCORRELACION EN EXCEL............................................................................ 87

4.3.4.1. Primeras Diferencias ..................................................................................................................................................... 87

4.3.4.2. PDG: Métodos Alternativos .......................................................................................................................................... 89

4.4.

ESTIMACION ROBUSTA ............................................................................................................................ 91

4.4.1. CORRECCION DE WHITE (1980) ............................................................................................................. 92

4.4.2. CORRECCION DE NEWEY Y WEST (1987) .............................................................................................. 93

4.4.

MULTICOLINEALIDAD............................................................................................................................... 95

4.4.1. MULTICOLINEALIDAD PERFECTA......................................................................................................... 95

4.4.2. MULTICOLINEALIDAD MUY ALTA.......................................................................................................... 95

4.5.3. SOLUCIONES A LA MULTICOLINEALIDAD ........................................................................................... 96

CAPÍTULO 5................................................................................................................................................................... 97

ESTACIONARIEDAD Y COINTEGRACIÓN............................................................................................................ 97

ii

5.1.

REGRESIONES ESPUREAS ......................................................................................................................... 97

5.2.

ESTACIONARIEDAD ................................................................................................................................... 99

5.2.1. DEFINICIÓN ................................................................................................................................................... 99

5.2.2. SERIE ESTACIONARIA ................................................................................................................................... 99

5.2.3. SERIE NO ESTACIONARIA .......................................................................................................................... 101

5.3. PRUEBAS DE ESTACIONARIEDAD ................................................................................................................ 103

5.3.1. CORRELOGRAMA Y TEST Q ....................................................................................................................... 103

5.3.2. PRUEBAS DE RAICES UNITARIAS: Dickey y Fuller .............................................................................. 105

5.3.3. PRUEBAS DE RAICES UNITARIAS: Augmented Dickey Fuller (ADF) Test ........................................... 106

5.3.

DIFERENCIACION DE SERIES I(1)........................................................................................................... 108

5.4.

COINTEGRACIÓN: PRUEBA DE ENGLE-GRANGER ............................................................................ 110

5.4.1. INTRODUCCIÓN ...................................................................................................................................... 110

5.4.2. DEFINICIÓN FORMAL DE COINTEGRACION...................................................................................... 111

5.4.3. PRUEBA DE ENGLE-GRANGER (1987).................................................................................................. 113

5.4.4. TEOREMA DE REPRESENTACION DE GRANGER.................................................................................... 114

5.5. COMENTAROS FINALES .................................................................................................................................. 116

CAPÍTULO 6................................................................................................................................................................. 117

INTRODUCCIÓN A LA PREDICCIÓN EN EXCEL............................................................................................... 117

6.1.

EL ERROR DE PREDICCIÓN ..................................................................................................................... 119

6.2.

PREDICCIÓN ESTATICA ........................................................................................................................... 119

6.3.

CASO PRÁCTICO........................................................................................................................................ 122

a) Tasa de Ocupación (OCCUP) ............................................................................................................................. 123

b) Ingreso por Habitación (Room Rate)................................................................................................................... 125

c) Número de Habitaciones (ROOMS)..................................................................................................................... 126

d) Predicción Final .................................................................................................................................................. 127

6.4. MEDIDAS DE ERROR DE PREDICCION.......................................................................................................... 128

6.4.1. Error Cuadrático Medio (Mean Squared Error, MSE).................................................................................. 128

6.4.2. Promedio del Error Absoluto (Mean Absolute Error, MAE) ......................................................................... 128

6.4.3. Promedio del Porcentaje de Error Absoluto (Mean Absolute Percentage Error, MAPE)............................. 128

6.4.4. Ejemplo de Cálculo ........................................................................................................................................ 129

CAPÍTULO 7................................................................................................................................................................. 130

MODELOS ARIMA...................................................................................................................................................... 130

7.1.

9.2.

9.2.1.

9.2.2.

9.3.

9.3.1.

9.3.2.

9.3.

7.4.

9.4.1.

9.4.2.

9.4.3.

9.4.4.

AUTOCORRELACIONES SIMPLES Y PARCIALES................................................................................ 130

PROCESOS AUTORREGRESIVOS (AR) ................................................................................................... 131

SIMULACION DE PROCESOS AR(1) ...................................................................................................... 132

ESTIMACION DE UN PROCESO AUTOREGRESIVO ............................................................................ 133

PROCESOS DE MEDIAS MOVILES .......................................................................................................... 134

SIMULACION DE PROCESOS MA(1) ..................................................................................................... 134

ESTIMACION DE UN PROCESO DE MEDIAS MOVILES...................................................................... 134

PROCESOS ARIMA..................................................................................................................................... 136

EL ENFOQUE DE BOX Y JENKINS ........................................................................................................... 138

PASO 1: IDENTIFICACIÓN ..................................................................................................................... 139

PASO 2: ESTIMACIÓN ............................................................................................................................. 140

PASO 3: VERIFICACIÓN / DIAGNÓSTICO ............................................................................................ 143

PASO 4: PREDICCIÓN............................................................................................................................. 144

CAPÍTULO 8................................................................................................................................................................. 147

ERROR EN LAS VARIABLES: INSTRUMENTOS................................................................................................. 147

8.1. VARIABLES INSTRUMENTALES.................................................................................................................... 147

8.2.

ESTIMACIÓN CON INSTRUMENTOS EN SPSS ...................................................................................... 148

8.3.

EL ESTIMADOR DE VARIABLES INSTRUMENTALES......................................................................... 150

iii

REFERENCIAS ............................................................................................................................................................ 151

ANEXO: DATOS UTILIZADOS EN EL LIBRO ....................................................................................................... 153

iv

CAPÍTULO 1

EL PROGRAMA EXCEL

1.1. ESTADISTICA DESCRIPTIVA CON EXCEL

Microsoft Excel ofrece un conjunto de herramientas para el análisis de los datos (Herramientas

para Análisis) lo que permite efectuar análisis estadístico de una manera simple. Algunas herramientas

generan gráficos además de tablas de resultados.

Para ver una lista de las herramientas de análisis disponibles, elija 'Análisis de Datos' en el menú

Herramientas. Si este comando no está en el menú, en el menú Herramientas, elija Complementos, y allí

seleccione Herramientas para Análisis. Si no aparece la opción Herramientas para Análisis, necesita el CD

de instalación de Excel.

Para usar el análisis de datos, vaya ahora a Herramientas, y allí seleccione 'Análisis de Datos'

(Herramientas / Análisis de datos). Aparecerá la lista de opciones en donde seleccionamos Estadística

Descriptiva:

En el cuadro de diálogo de Estadística descriptiva, lo único que és "obligatorio" suministrar son los

datos a analizar (Rango de entrada) y el lugar en donde se desea escribir los resultados (Rango de

salida).

1

Ejemplo. Se tienen datos de la cantidad de producción (kg), capital ($)y de trabajo (horas) de 10

empresas:

Comenzaremos calculando estadística de la serie 'capital'. El "Rango de entrada" es $B$1:$B$11, es decir

seleccionando los títulos como promera observación, de modo que se debe activar la opción 'Rótulos en la

primera fila'. A continuación debemos activar la selección del rango de salida, por ejemplo la celda $A$13,

como se muestra acontinuación:

El resultado es el siguiente:

CAPITAL

Media

Error típico

Mediana

Moda

Desviación estándar

Varianza de la muestra

Curtosis

Coeficiente de asimetría

Rango

Mínimo

Máximo

Suma

Cuenta

Mayor (2)

Menor(2)

Nivel de confianza(95,0%)

5,6

0,733333333

6

6

2,319003617

5,377777778

-1,11811742

-0,058802684

7

2

9

56

10

8

3

1,658915249

Nota: Muchos de estos resultados anteriores pueden obtenerse individualmente a través del menú

Insertar/Función, y allí ir dentro de las funciones estadísticas.

2

Media: Devuelve el promedio (media aritmética) de los argumentos. PROMEDIO(número1;número2;...)

Error típico (de la media): (Desviación estándar)/raiz(T)

Mediana: Devuelve la mediana de los números. La mediana es el número que se encuentra en medio de

un conjunto de números, es decir, la mitad de los números es mayor que la mediana y la otra mitad

es menor. MEDIANA(número1;número2; ...)

Moda: Devuelve el valor que se repite con más frecuencia en una matriz o rango de datos. Al igual que

MEDIANA, MODA es una medida de posición.

Desviación estándar: Calcula la desviación estándar en función de un ejemplo. La desviación estándar es

la medida de la dispersión de los valores respecto a la media (valor promedio). DESVEST(número1;

número2; ...)

Varianza de la muestra: Calcula la varianza en función de una muestra (con n-1 g.l.).

VAR(número1;número2; ...)

Curtosis: Devuelve la curtosis de un conjunto de datos. La curtosis caracteriza la elevación o el

achatamiento relativos de una distribución, comparada con la distribución normal. Una curtosis

positiva indica una distribución relativamente elevada, mientras que una curtosis negativa indica

una distribución relativamente plana. CURTOSIS(número1;número2; ...)

Coeficiente de asimetría: Devuelve la asimetría de una distribución. Esta función caracteriza el grado de

asimetría de una distribución con respecto a su media. La asimetría positiva indica una distribución

unilateral que se extiende hacia valores más positivos. La asimetría negativa indica una distribución

unilateral que se extiende hacia valores más negativos.

COEFICIENTE.ASIMETRIA(número1;número2; ...)

Rango: MAX(Rango) – MIN(Rango).

Mínimo: Devuelve el valor mínimo de un conjunto de valores. MIN(número1;número2; ...)

Máximo: Devuelve el valor máximo de un conjunto de valores. MAX(número1;número2; ...)

Suma: La sumatora de las observaciones

Cuenta: El número de observaciones (T)

Mayor (2): Késimo mayor. Devuelve el valor késimo mayor de cada rango de datos en la tabla de

resultados. En el cuadro, escriba el número que va a utilizarse para k. Si escribe 1, esta fila

contendrá el máximo del conjunto de datos.

Menor (2): Késimo menor. Devuelve el valor késimo menor de cada rango de datos en la tabla de

resultados. En el cuadro, escriba el número que va a utilizarse para k. Si escribe 1, esta fila

contendrá el mínimo del conjunto de datos.

Nivel de confianza (95,0%): Nivel de confianza para la media. Devuelve el nivel de confianza de la media

en la tabla de resultados. En el cuadro, escriba el nivel de confianza que desee utilizar. Por ejemplo,

un valor de 95 % calculará el nivel de confianza de la media con un nivel de importancia del 5 %.

3

1.2. SESGO, CURTOSIS Y NORMALIDAD

Existen 4 formas comunes de estimar la normalidad:

1.2.3.4.-

Histograma de residuos

Normal Probability Plot

Anderson-Darling normality test (A2 stat)

Jarque-Bera (JB) test of Normality (asintótico)

Por ahora estamos interesados en la prueba de Jarque Bera, la que tiene la siguiente

specificación:

⎡ S2 K2 ⎤

⎥ ≈a

JB = T ⎢

+

24 ⎥

⎢⎣ 6

⎦

χ 2 ( 2)

donde S es el coeficiente de Sesgo y K es el coeficiente de curtosis. Para una variable distribuída

normalmente, S=0 y K=3. Luego, el test JB de normalidad es una prueba conjunta de si S=0 y K=3. Si el

valor p es suficientemente bajo, se puede rechazar la hipótesis que la variable está normalmente

distribuída.

Ejemplo: Chi-Squared(2)= 1.061172 with Significance Level 0.58826017, donde Ho: Normalidad. Luego,

no podemos rechazar en este caso la hipótesis de normalidad (la conclusión es no rechazar normalidad).

Las definiciones y pruebas estadísticas para el sesgo y la curtosis son las siguientes:

a) Sesgo:

En Excel: =coeficiente.asimetria( )

La prueba estadística de que el sesgo es cero se basa en una Normal, y es:

b) Curtosis:

En Excel: =curtosis( )

La prueba estadística de que la curtosis es cero se basa en una Normal, y es:

4

Ejemplo: Siguiendo el ejemplo de la serie CAPITAL anterior mostramos el cálculo de éstas. Los

resultados a obtener son los siguientes:

Observaciones

Media Muestral

Desv estandar

Varianza

Error est de la media

Estadistico t

Sesgo

Curtosis

Jarque Bera

10

5,6

2,319003617

5,377777778

0,733333333

7,636363636 Pruebas de Hipotesis Significancia a 1 cola

-0,058802684

-0,064415113

0,948639697

-1,11811742

-0,488540664

0,62516693

0,526673995

0,526673995

0,768482877

Las fórmulas usadas en cada caso se muestran a continuación:

5

1.3. GRAFICOS DE PROBABILIDAD NORMAL

Los gráficos de probabilidad normal (normal probability plot) son una técnica gráfica para valorar

si los datos son o no aproximadamente normalmente distribuñidos. Los datos son graficados contra una

distrinución normal teórica de tal forma que los puntos deben formar aproximadamente una línea recta.

Las desviaciones de la línea recta indican desviaciones de la normalidad. El gráfico de probabilidad normal

es un caso especial de los gráficos de probabilidad.

Existen varios tipos de gráficos de probabilidad normal 1. Aquí nos referimos solamente al tipo más

simple de ellos: Percentiles vs Datos.

Los pasos para construir un gráfico de probabilidad normal son:

1

1.

Las observaciones son rankeadas (ordenadas) de la menor a la mayor, x(1), x(2), . . ., x(n).

2.

Las observaciones ordenadas x(j) son graficadas contra su frecuencia acumulativa observada,

tipicamente; j/(n + 1)) sobre un gráfico con el eje Y apropiadamente escalado para la distribución

hipotetizada.

3.

Si la distribución hipotetizada describe adecuadamente los datos, los puntos graficados se ubican

aproximadamente sobre una línea recta. Si los puntos se desvían significativamente de la

lñinearecta, especialmente en las puntas, entonces la distribución hipotetizada no es apropiada.

Vease por ejemplo www.itl.nist.gov/div898/handbook/eda/section3/probplot.htm.

6

4.

Para valorar la cercanía de los ountos a la línea recta, la prueba del grosor de un lápiz se usa

comunmente. Si todos los puntos se encuentran dentro del lapis imaginario, entonces la

distribución hipotetizada es probablemente la apropiada.

Ejemplo: Los siguientes datos representan el grosor de una hoja plástica, en micrones: 43, 52, 55, 47,

47, 49, 53, 56, 48, 48

Ordered data Rank order Cumulative Frequency

(j)

( j/(n + 1))

43

1

1/11 = .0909

47

2

2/11 = .1818

47

3

3/11 = .2727

48

4

4/11 = .3636

48

5

5/11 = .4545

49

6

6/11 = .5454

52

7

7/11 = .6363

53

8

8/11 = .7272

55

9

9/11 = .8181

56

10

10/11 = .9090

Los datos ordebados son graficados contra su respectiva frecuencia acumulada. Note como el eje Y es

escalado tal que una línea recta resultará para datos normales.

Basados en el gráfico, parece que los datos se encuentran normalmente distribuídos. Sin embargo

se requieren otras pruebas estadísticas para concluir que el supuesto de normlidad es apropiado.

7

En Excel puede obtenerse este gráfico en Herramientas / Analisis de Datos / Regresion / y allí

seleccionando la opcion Grafico de probabilidad normal.

Para el caso de la serie 'Capital' del ejemplo que se ha estado analizando, se tiene el siguiente

resutado a partir de Excel.

8

1.4. HISTOGRAMA

Un histograma es un gráfico para la distribución de una variable cuantitativa continua que

representa frecuencias mediante el volumen de las áreas. Un histograma consiste en un conjunto de

rectángulos con (a): bases en el eje horizontal, centros en las marcas de clase y longitudes iguales a los

tamaños de los intervalos de clase y (b): áreas proporcionales a las frecuencias de clase.

Si en la distribución se toman clases de la misma longitud, las frecuencias son proporcionales a las

alturas de los rectángulos del histograma ya que el área se obtiene multiplicando la base por la altura por

lo que queda similar a un diagrama de barras, solo que ahora las barras van una junto a otra por tratarse

de una variable continua.

En Excel, la herramienta para histogramas se encuentra en Herramientas / Análisis de Datos /

Histograma. Antes de ejecutarla se puede (es opcional) definir el 'Rango de Clases', a fin de definir las

divisiones para cada rango del histograma. El 'Rango de Clases' son valores límite que definen rangos de

clase, los que deberán estar en orden ascendente. Si se omite el rango de clase, Excel creará un conjunto

de clases distribuidas uniformemente entre los valores mínimo y máximo de los datos.

Ejemplo: En el ejemplo de la serie 'Capital' un histograma es obtenido de la siguiente forma:

9

Histograma

120,00%

3,5

3

100,00%

2,5

Frecuencia

80,00%

2

60,00%

Frecuencia

% acumulado

1,5

40,00%

1

20,00%

0,5

0

0,00%

2

4,333333333

6,666666667

y mayor...

Clase

10

1.5. OPERACIONES CON ESCALARES Y MATRICES

Excel permite realizar operaciones matriciales con facilidad. En Excel, las fórmulas que hacen

referencia a matrices se encierran entre corchetes {}. Al trabajar con matrices en Excel hay que tener en

cuenta lo siguiente:

•

•

•

No se puede cambiar el contenido de las celdas que componen la matriz

No se puede eliminar o mover celdas que componen la matriz

No se puede insertar nuevas celdas en el rango que compone la matriz

a) Crear una fórmula matricial

Una fórmula matricial es una fórmula que lleva a cabo varios cálculos en uno o más conjuntos de

valores y devuelve un único resultado o varios resultados. Las fórmulas matriciales se encierran entre

llaves { } y se especifican presionando CTRL+MAYÚS+ENTRAR. Cuando se introduce una fórmula

matricial Microsoft Excel inserta de forma automática la fórmula entre llaves ({}).

b) Calcular un único resultado

Puede utilizar una fórmula matricial para realizar varios cálculos que generen un único resultado.

Este tipo de fórmula matricial permite simplificar un modelo de hoja de cálculo sustituyendo varias

fórmulas distintas por una sola fórmula matricial.

Por ejemplo, la siguiente calcula el valor total de una matriz de precios de cotización y acciones, sin

utilizar una fila de celdas para calcular y mostrar los valores individuales de cada cotización.

- Haga clic en la celda en que desee introducir la fórmula matricial (en B5).

- Escriba la fórmula matricial. Cuando se escribe la fórmula ={SUMA(B2:C2*B3:C3)} como fórmula

matricial, se multiplica las acciones y el precio correspondiente a cada cotización, y luego se suma los

resultados de estos cálculos.

- Presione CTRL+MAYÚS+ENTRAR.

c) Calcular varios resultados

- Seleccione el rango de celdas en que desee introducir la fórmula matricial.

- Escriba la fórmula matricial. Por ejemplo, dada un serie de tres cifras de ventas (columna B) para una

serie de tres meses (columna A), la función TENDENCIA determinará los valores de la línea recta para las

cifras de ventas. Para mostrar todos los resultados de la fórmula, se escribe en tres celdas en la columna

C (C1:C3). Al introducir la fórmula =TENDENCIA(B1:B3,A1:A3) como fórmula matricial, generará tres

resultados separados (22196, 17079 y 11962) basados en las tres cifras de ventas y en los tres meses.

11

Presione CTRL+MAYÚS+ENTRAR.

d) Operaciones Matriciales

Existen una serie de operaciones matriciales en Excel, siendo las más usadas las siguientes:

MDETERM Devuelve la matriz determinante de una matriz

MINVERSA Devuelve la matriz inversa de una matriz

MMULT Devuelve la matriz producto de dos matrices

Veámos un ejemplo para el caso de una multiplicación.

- Seleccione el rango de celdas en que desee introducir la fórmula matricial. Para esto debe calcularse la

dimensión resultante de la operación matricial. Por ejemplo, si se multiplican dos matrices de dimensiones

2x3, y 3x4 respectivamente, las celdas de la formula matricial que deben seleccionarse es de dimensión

2x4.

Presione CTRL+MAYÚS+ENTRAR. Con esto se tiene la matriz resultante, dada por:

19

29

28

42

44

66

46

69

12

1.6. DISTRIBUCIONES DE PROBABILIDAD

En econometría, para efectos de inferencia acerca de los coeficientes estimados, es necesario

trabajar con un número de distribuciones de probabilidad. A continuación recordamos las más

importantes: la distribución Normal, Chi-cuadrado, t y F.

La siguiente es la función de densidad normal para una variable aleatoria X con una distribución

normal con media μ y varianzas σ2:

f (x / μ,σ 2 ) =

1

⎧ 1 SCErrt ⎫

EXP ⎨−

⎬

2

σ 2π

⎩ 2 σ

⎭

donde SCErr representa la suma cuadrada de errores, es decir de desviaciones respecto a la media.

Cuando se tienen n variables aleatorias normales Z distribuidas independiente e idénticamente,

entonces la distribución conjunta multivariada con media μ y matriz de covarianza 2 ∑ es:

g ( x) = 2π − n / 2 Σ

1/ 2

⎧ 1

⎫

EXP ⎨− ( x − μ )' Σ −1 ( x − μ )⎬

⎩ 2

⎭

Si Z es una variable aleatoria normal estándar ( Z

1)

≈ N (0,1) ), entonces puede mostrarse que:

Z

t (r ) =

χ 2 (r )

r

Es decir, una variable aleatoria normal estándar dividida por la raíz cuadrada de una variable

aleatoria chi cuadrada con r grados de libertad dividida por r, se distribuye como una t con r grados de

libertad (gl).

χ 2 (r1)

2)

F (r1, r 2) =

r1

χ ( r 2)

2

r2

Es decir, una variable F con r1 gl en el numerador y r2 gl en el denominador corresponde a una

chi-cuadrada con r1 gl dividida por r1, dividida por otra chi-cuadrada con r2 gl dividida por r2.

3)

Z2 ≈

χ

2

(1)

Es decir, una variable aleatoria normal estándar al cuadrado se distribuye chi-cuadrado con 1

grado de libertad.

4)

2

Z 12 + Z 22 + ... + Z n2 ≈

χ

2

( n)

No confundir el símbolo de la matriz de covarianza ∑, con el operador de sumatorias.

13

Es decir, la suma de n variables aleatorias normales estándar al cuadrado se distribuye chicuadrado con n grados de libertad. Este resultado puede generalizarse cuando se trata de variables

normales no estandarizadas

X ≈ N ( μ , Σ) :

( X − μ )' Σ −1 ( X − μ ) ≈ χ 2 (n)

14

1.7. POTENCIA DE UN TEST

Hay dos formas en que un test nos puede llevar a cometer un error:

-

Error del tipo I: Rechazar Ho cuando es verdadera, y

Error del tipo II: No rechazar Ho cuando es Falsa.

El punto es que en la práctica no es posible hacer ambos errores arbitrariamente pequeños, pues

reduciendo la probabilidad de cometer un error aumenta la probabilidad de cometer el otro error. Sin

embargo es más grave el Error del tipo I que el Error del tipo II: es peor condenar a una persona inocente

que dejar libre a un culpable, y por este motivo se trata que la magnitud del error del tipo I sea fijado

usualmente a un valor pequeño, es decir queda bajo control del analista:

Error tipo I :

Rechazar Ho cuando es verdadera (gravísimo)

Error tipo II:

No rechazar Ho cuando es Falsa (grave)

P(Error tipo I) = α = Tamaño del test (size) o nivel de

significancia.

P(Error tipo II) = β

La forma de medir la calidad de un test estadístico es a través de su potencia.

La Potencia de un test es la probabilidad de que correctamente rechacemos Ho cuando es falsa (la

probabilidad de detectar que Ho es falsa).

Potencia = 1 − β = 1 − P ( Error tipo II )

Un test “perfecto” tendrá una potencia de 1.0, pues siempre llevará a una decisión correcta. Esto

puede lograrse, para un nivel dado de significancia, cuando el tamaño de la muestra aumenta (a infinito).

Así, la evaluación de un buen test debe hacerse en base a su función de potencia. En general el

procedimiento óptimo es seleccionar con anticipación el tamaño máximo del error del tipo I que podemos

aceptar, y después se intenta construir una prueba que minimice el tamaño del error del tipo II. Cuando

Ho es falsa, la potencia puede ser calculada asumiendo varios valores críticos para el parámetro

desconocido.

15

1.7.1. APLICACIÓN: SELECCIÓN ENTRE TESTS ALTERNATIVOS

En el siguiente ejemplo σ=1.4 (desviación estándar), T=25 (número de observaciones); y se

desea probar la hipótesis Ho:μ=10 versus H1:μ>10.

Asumiendo que se desea un tamaño de error (α) de hasta 0.06, escogeremos entre 3 distintas

regiones críticas a una cola, sabiendo que las medias muestrales son: Prueba A: 10.65, Prueba B: 10.45 y

Prueba C: 10.25.

Para las diferentes medias muestrales verificamos el cumplimiento del tamaño del test requerido:

A

B

C

P(Error Tipo I)=α=Tamaño del test

P[z> (10.65-10)/0.28 3]=P[z>2.32]=0.0102

P[z> (10.45-10)/0.28]=P[z>1.61]=0.0537

P[z> (10.25-10)/0.28]=P[z>0.89]=0.1867 (no cumple)

Repitiendo para diferentes valores supuestos de μ calculamos la potencia del test:

A

B

P(Error Tipo II) con μ=10.4

P[z> (10.65-10.4)/0.28]=P[z≤0.89]=0.8133

P[z> (10.45-10.4)/0.28]=P[z≤0.18]=0.5714

μ=10.4

μ=10.2

μ=11.0

Potencia Potencia Potencia

0.19

0.05

0.89

0.43

0.98

0.19

Luego:

Al aumentar el tamaño del error del tipo I de 0.0102 a 0.0537, el error del tipo II disminuye de

0.8133 a 0.5714, y viceversa (no es posible eliminar ambos errores).

Puesto que puede tolerarse un error del tipo I de 0.06, entonces la prueba B es mejor que la A,

debido a que su potencia es mayor para distintos valores de μ.

El análisis de potencia permite determinar el tamaño muestral apropiado para cumplir ciertos

niveles predefinidos de α y β.

3

Recuerde que el error estándar para la media en este caso seá 1.4/(25)**0.5=0.28

16

1.8. NIVEL DE SIGNIFICANCIA MARGINAL: CDF O P-VALUE

Hemos dicho anteriormente que la magnitud del error del tipo I queda bajo el control del analista,

quien lo fija en un valor relativamente pequeño, usualmente 5%. Así, la probabilidad de cometer un error

del tipo I es justamente el Nivel de Significancia Marginal (NSM).

Decimos que un resultado es estadísticamente significativo cuando el NSM es menor que el nivel

deseado (generalmente 5%), es decir se tiene suficiente evidencia para rechazar Ho. Si es mayor,

entonces es estadísticamente no significativo (no podemos rechazar Ho). Es decir, bajos niveles de P

llevan a rechazar Ho.

1.8.1. Distribución Normal

Excel entrega los valores críticos de la normal acumulando la probabilidad de izquierda a derecha y

a 1 cola (ej. si decimos al 5%, asignará 5% en 1 cola, la cola izquerda).

Ejemplo: El valor crítico a 2 colas al 95% es:

=DISTR.NORM.ESTAND.INV(0,975) = 1,95996

Ejemplo (significancia): Si el valor Z calculado es 2,0, entonces la significancia (p-value) es:

=DISTR.NORM.ESTAND(2) = 0,97724987

Sin embargo en este caso es más conveniente leer la significancia como

=1-DISTR.NORM.ESTAND(2) = DISTR.NORM.ESTAND(-2) = 0,0228. Puesto que 0,0228 es < que 5%, se

rechaza Ho a 2 colas y también a 1 cola.

17

1.8.2. Distribución t

Excel solo puede entregar los valores críticos de la t de la derecha (los positivos), y lo hace

acumulando la probabilidad de derecha a izquierda a 2 colas (ej. si decimos al 5%, distribuirá 2,5% en cada

cola).

DISTR.T.INV(probabilidad de 2 colas;grados_de_libertad)

Ejemplo: los valores críticos de la t con 4 gl, y al 95% a 2 colas son: -2,776 y 2,776

=DISTR.T.INV(0,05;4) = 2,776

Nota: Puede obtenerse un valor t crítico de 1 cola reemplazando p por 2*probabilidad.

Ejemplo (significancia): Si el valor t calculado es 3,69, con 4 gl, y al 95% a 2 colas, entonces la

significancia (p-value) es:

=DISTR.T(3,69;4;2) = 0,02101873

lo que implica que Ho es rechazado al 2,1% (a 2 colas), y también al 5%.

Es importante notar que la función =DISTR.T(.) no acepta argumentos negativos, es decir, solamente puede

buscarse la significancia en el lado derecho de la distribución.

18

1.8.3. Distribución F

Excel entrega los valores críticos de la F acumulando la probabilidad de derecha a izquierda y a 1

cola.

DISTR.F.INV(probabilidad de 1 cola;gl Num;gl Denom)

Ejemplo: El valor crítico de una F(1,4) a 1 cola al 95% es:

=DISTR.F.INV(0,05;1;4) = 7,70864742

Ejemplo (significancia): Si el valor F(3,30) calculado es 3,0, entonces la significancia (p-value) a 1 cola es:

=DISTR.F(3;3;30) = 0,04606

lo que implica que Ho es rechazado al 5% a 1 cola.

19

1.8.4. Distribución Chi cuadrado

Excel entrega los valores críticos de la Chi acumulando la probabilidad de derecha a izquierda y a 1

cola.

PRUEBA.CHI.INV(probabilidad;grados_de_libertad)

Ejemplo: El valor crítico de la Chi cuadrado con 10 grados de libertad a 1 cola, al 95% es:

=PRUEBA.CHI.INV(0,05; 10) = 18,307

20

1.9. PRUEBAS SOBRE LA MEDIA EN EXCEL

1.9.1. Inferencia respecto a una Media

Ejemplo: Se tiene información de producción de 10 empresas. Un intervalo de confianza al 95% para la

media de la producción en Excel se desarrolla como sigue:

Sabemos que se trata de 9 grados de libertad, por lo que:

a) el estadístico t es = DISTR.T.INV(0,05;9) = 2,262

b) el error típico de la media es = desvest(…)/Raiz(10) = 20,29477/Raiz(10) = 6,41777

Y el intervalo viene dado por = (Media +/- 2,262*6,41777) = (88,9 +/- 14,518). Es decir, (74,382 ;

103,418).

En Excel, aparece en la última fila:

PRODUCCION

Media

Error típico

Mediana

Moda

Desviación estándar

Varianza de la muestra

Curtosis

Coeficiente de asimetría

Rango

Mínimo

Máximo

Suma

Cuenta

Nivel de confianza(95,0%)

88,9

6,417770468

90

#N/A

20,29477218

411,8777778

-1,230556217

-0,154506756

61

57

118

889

10

14,5180054

Note que al aumentar la confianza, se amplía el Intervalo de Confianza (verifíquelo).

21

1.9.2. Diferencia de dos Medias (Univariado)

Para comparar 2 grupos de datos, se tienen básicamente dos enfoques:

- Datos son Normales: Test t

- Datos solo tienen una distribución ordinal (no paramétrica): Test U y Test de Wilcoxon)

A continuación nos referiremos solamente a las comparaciones del primer tipo.

El estadístico:

Z =

X − Y − (μ 1 −μ 2 )

σ

2

1

m

+

σ

2

≈ N (0,1)

2

n

Ejemplo: El análisis de una muestra de m = 20 personas arrojó una edad media de 29.8 años. Una

segunda muestra de n = 25 tuvo un promedio de 34.7 años. Las distribuciones de la edad son normales

con

σ 1 = 4.0 y σ 2 = 5.0. ¿Son las edades diferentes: Ho:μ1=μ2? Realice el test con un α = 0.01

Solución: Ho: μ1 - μ2, test de dos colas: Zona de rechazo: +/- 2.58

Z =

29.8 − 34.7

− 4.9

=

− 3.65

16 25 1.3416

+

20 25

se rechaza Ho ⇒ las edades son diferentes.

IC es (-4.9 +/- 2.58*1.3416) = (-4.9 - 3.46 , -4.9 + 3.46) = (-8.36 , -1.43)

puesto que 0 se ubica fuera del IC, la diferencia de edades es significativamente diferente de cero (los

promedios de cada grupo son diferentes).

Ejemplo: Se realizaron test de resistencia en dos tipos de alambres:

Tamaño de la muestra

Media

M = 129

X = 107.6

Y = 123.6

N = 129

μ1 - μ2 = 107.6 – 123.6 ± 1.96

Conclusiones:

Kg mm 2

(1.3)2

129

+

(2.0)2

129

Desviación Estándar

S1 = 1.3

S2 = 2.0

= -16 ± 0.4116 = (-16.4116; -15.5884)

μ2 > μ1. μ2 es aproximadamente 16

⎡ Kg ⎤

⎢⎣ mm 2 ⎥⎦

más grande que μ1

22

“Problema de Behrens-Fisher”

La solución más simple al caso de varianzas desiguales es llamada “la aproximación a la t de

Welch”, la que corrige los grados de libertad de la t como sigue:

2

⎛ s12 s 22 ⎞

⎜⎜ + ⎟⎟

n n

gl = ⎝ 12 2 ⎠ 2

⎛ s 22 ⎞

⎛ s12 ⎞

⎜⎜ ⎟⎟

⎜⎜ ⎟⎟

n

⎝ 1 ⎠ + ⎝ n2 ⎠

n1 − 1 n2 − 1

El resultado puede ser no entero, y entonces se lo aproxima al entero más cercano.

1.9.3. Inferencia En Excel

Ejemplo: Supóngase que se desea comparar las medias de salario inicial de los dos grupos de

trabajadores (474 observaciones) definidos por la variable sexo (h=hombres y m=mujeres). “Employee

data.xls”

a) Varianzas Conocidas: Prueba Z para medias de dos muestras.

Debe ingresarse las varianzas conocidas.

b) Varianzas Desconocidas. Prueba t para dos muestras suponiendo varianzas iguales.

(Muestras Independientes)

Prueba t para dos muestras suponiendo varianzas iguales

Media

Varianza

Observaciones

Varianza agrupada

Diferencia hipotética de las medias

Grados de libertad

Estadístico t

P(T<=t) una cola

Valor crítico de t (una cola)

P(T<=t) dos colas

Valor crítico de t (dos colas)

Variable 1

13091,9676

8617742,74

216

49131619

0

472

-11,1523866

4,2491E-26

1,64808834

8,4981E-26

1,96500259

Variable 2

20301,3953

83024550,6

258

La prueba t arroja un valor de 11,152 para 472 grados de libertad. La significancia estadística a

dos colas es prácticamente cero, y se rechaza la igualdad de medias de salarios.

La diferencia de las medias es 7.209,43 y el error estandar de la diferencia es 646,45. Un

intervalo de confianza para la diferencia de media es (5.939,16 ; 8.479,70).

23

c) Varianzas Desconocidas. Prueba t para dos muestras suponiendo varianzas desiguales.

(Muestras Independientes)

Prueba t para dos muestras suponiendo varianzas desiguales

Media

Varianza

Observaciones

Diferencia hipotética de las medias

Grados de libertad

Estadístico t

P(T<=t) una cola

Valor crítico de t (una cola)

P(T<=t) dos colas

Valor crítico de t (dos colas)

Variable 1

13091,9676

8617742,74

216

0

319

-11,9874833

6,9028E-28

1,64964432

1,3806E-27

1,96742832

Variable 2

20301,3953

83024550,6

258

La prueba t arroja un valor de 11,987 para 318,818 grados de libertad. La significancia estadística

a dos colas es prácticamente cero.

La diferencia de las medias es 7.209,43 y el error estandar de la diferencia es 601,41. Un

intervalo de confianza para la diferencia de media es (6.026,19 ; 8.392,67).

t=

20301,4 − 13091,97

2

9111 2935

+

258

216

2

=

7209.4

= 11.987

601.4

vs =distr.t.inv(0,05;319)=1.967, se rechaza la igualdad de

medias de salarios.

El IC es: 7209,43 +/- 1.96*601,412

24

d) Varianzas Desconocidas. Prueba t para medias de dos muestras emparejadas (relacionadas

o pareadas). En este caso los rangos de las variables deben contener el mismo número de

observaciones.

Cuando no hay completa independencia entre los pares de las muestras, posiblemente debido a

un origen común, por ejemplo el caso de el ingreso y el tamaño de las casa de las familias.

Lo que se hace es trabajar con las diferencias entre cada par de observaciones, de modo que el

procedimiento puede ser llamado una prueba t de una sola muestra como vimos anteriormente.

Ejemplo: Comparar las medias de las series Salario Actual y Salario Inicial.

Prueba t para medias de dos muestras emparejadas

Media

Varianza

Observaciones

Coeficiente de correlación de Pearson

Diferencia hipotética de las medias

Grados de libertad

Estadístico t

P(T<=t) una cola

Valor crítico de t (una cola)

P(T<=t) dos colas

Valor crítico de t (dos colas)

Variable 1

34419,5675

291578214

474

0,88011747

0

473

35,0359608

8,051E-134

1,64808148

1,61E-133

1,96499192

Variable 2

17016,0865

61946945

474

La media es 17.403,48, la desviación estándar es 10.814,62, y el error estándar de la media es

496,73. El intervalo de confianza es (16.427,41 ; 18.379,56). El estadístico t es de 35,036 para 473

grados de libertad, lo que arroja una significancia a dos colas cercana a cero.

25

1.10. SERIES DE DATOS

Las Series son los datos más importantes en cualquier investigación, pues contienen la

información que ha sido recopilada acerca de las variables de interés. Son esencialmente arreglos de

elementos de una dimensión, como los vectores, pero tienen una estructura mucho más compleja, puesto

que, por ejemplo, pueden tener elementos definidos y no definidos. Por ejemplo, en una serie “Consumo

Nacional Anual” es posible que no dispongamos del dato de un año en particular, pero aún así podemos

construir la serie.

Operacionalmente las series siempre tienen la estructura de una matriz rectangular, en que las

columnas contienen las variables, y las filas representan los casos o sujetos, y además no hay elementos

vacíos.

En econometría las series de datos pueden ser de 3 tipos: corte transversal (cross section), series

de tiempo (time series) y del tipo panel o combinadas (panel data).

tiempo.

Las series de corte transversal son observaciones de determinadas variables en un momento del

Ejemplo: Las series Capital y Reservas (en millones de pesos) de los bancos nacionales,

en enero de 1990, constituyen una serie de corte transversal.

Banco

1

2

3

4

5

6

7

Capital y Reservas

3.661

5.590

3.047

9.296

6.604

6.908

8.122

Las series de tiempo están constituidas por observaciones de un número de variables a través del

tiempo (diarias, mensuales, anuales, etc.).

Ejemplo: La serie Producto Interno Bruto anual de Chile en $ reales de 1986 entre 1972 y

1976 es una serie de tiempo.

AÑO

1972

1973

1974

1975

1976

PIB ($ reales 1986)

2.659.800

2.544.814

1.864.085

2.341.477

2.329.343

Los datos de panel están constituidos por combinaciones de datos de corte transversal y series de

tiempo.

26

Ejemplo: La siguiente tabla muestra 3 series de colocaciones de 3 bancos entre enero y

julio de 1990, por lo que se trata de un panel de datos.

Fecha

90.01

90.02

90.03

90.04

90.05

90.06

90.07

Colocaciones Colocaciones Colocaciones

Banco 1

Banco 2

Banco 3

5132

2525

507

4704

3223

518

4941

2200

517

4806

3012

527

4943

2553

535

4566

3101

541

4167

3176

550

Hemos señalado que los datos econométricos pueden ser de 3 tipos: corte transversal, series de

tiempo y datos de panel. Excel no está diseñado especialmente para trabajar con datos de panel.

27

CAPÍTULO 2

EL MODELO DE REGRESIÓN LINEAL

2.1. INTRODUCCIÓN: ¿QUE ES LA ECONOMETRÍA?

Diccionarios especializados definen econometría como “la aplicación de técnicas matemáticas y

estadísticas a la economía en el estudio de problemas, análisis de datos, el desarrollo y la prueba de

teorías y modelos."

En efecto, cuando un economista plantea un determinado modelo en el cual existe una variable

dependiente de otras variables explicativas a través de una determinada especificación funcional, esta es

susceptible de ser estimada con datos de la realidad. En casos simples, el modelo no requiere estar

especificado demasiado formalmente, pues en muchos casos es aceptada cierta relación ente variables,

por ejemplo Ventas-Publicidad, Ingreso-Consumo, Nivel de tasas de interés-Inversión, etcétera. Esto es

en breve lo que se entiende por econometría.

Así como iremos viendo a través de este libro, los tres principales usos de la econometría

incluyen:

1)

2)

3)

Medición de Parámetros (estimación de modelos)

Prueba de Hipótesis

Predicción

2.2. ESTIMACIÓN DE MODELOS DE REGRESIÓN

El análisis de regresión estudia la relación de dependencia de una variable dependiente en una o

más variables explicativas, con el objetivo de estimar y/o predecir resultados promedio o poblacionales de

la primera, en términos de valores conocidos o fijos (en muestras repetidas) de las últimas. El aspecto

común de todos los modelos de regresión es entonces la existencia de variables dependientes (Y) que son

explicadas por una serie de variables independientes (X’s). De todos los modelos de regresión el más

común es del tipo lineal múltple (uniecuacional), en el cual Y es función lineal de las diferentes X’s. Como

veremos, esta especificación posee una serie de ventajas respecto, por ejemplo, a los modelos no

lineales. Nótese también que existen diferencias entre el análisis de regresión y el de correlación, pues la

primera de ellas asume un tratamiento asimétrico de las variables (separándolas en dependientes e

independientes) y asumiendo un comportamiento aleatorio (estocástico) de la variable dependiente. En el

análisis de correlación las variables tienen un tratamiento simétrico (no existe distinción entre variables

dependientes e independientes).

28

Los modelos econométricos pueden ser lineales o no lineales en los parámetros 4. Son lineales

cuando la variable explicada (dependiente) puede ser escrita como una combinación lineal de las variables

explicativas (independientes). Por ahora trabajaremos solamente con modelos lineales.

Ejemplo: Modelo Lineal:

Yt = β 0 + β 1Yt −1 + β 2 X t + ε t

;* es un modelo lineal en los parámetros. Los

parámetros a estimar o incógnitas son los coeficientes β, mientras que las

variables explicativas son X e Y rezagada. La variable explicada o endógena es Y.

Ejemplo: Modelo no Lineal:

Yt = β 0 + β 1Yt −1 + β 22 X t + ε t

;* es un modelo no lineal en los parámetros, pues

hay un coeficiente β que se encuentra al cuadrado, y no hay forma de eliminar ese

exponente sin afectar la linealidad de los restantes parámetros.

La segunda clasificación importante es la de modelos de regresión simples o múltiples, de acuerdo

al número de variables que explican a la variable dependiente. Cuando solamente existe una variable

explicativa se llama a éste un modelo de regresión simple y cuando son varias se le llama modelo de

regresión múltiple.

Ejemplo:

VENTAS t = β 0 + β 1 PUBLICIDADt + ε t

;* es un modelo de regresión simple:

La relación lineal entre las ventas (y) y los gastos en publicidad (x)

Ejemplo:

CONSUMOt = β 0 + β 1 INGRESOS t + β 2 ACTIVOS t + β 3TAMAÑOt + ε t

;* es

un modelo de Regresión Múltiple. La relación lineal entre el gasto en consumo de las

familias (y) en función del ingreso (x1), los activos financieros de la familia (x2) y

del tamaño de la familia (x3).

2.2.1. EL MÉTODO DE MÍNIMOS CUADRADOS

Supongamos que disponemos de información de Ingreso (variable exógena) y de Consumo

(variable endógena) de 20 familias en un determinado periodo (ver datos en archivo 'Tabla 04.xls'). Esta

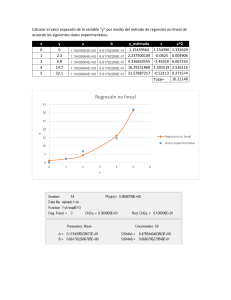

información es mostrada en el siguiente gráfico (scatter).

4

La no linealidad se refiere a los parámetros, puesto que la no linealidad de las variables consiste simplemente en una

transformación de éstas.

29

Consumo

Relacion Ingreso-Consumo

45,0

40,0

35,0

30,0

25,0

20,0

15,0

10,0

5,0

0,0

0,0

10,0

20,0

30,0

40,0

50,0

Ingreso

Al obtener la información real, esta no se ajustará exactamente al modelo (que suponemos en

este caso es lineal), pues algunos puntos se ubican sobre y otros por debajo de la recta. Las

observaciones parecen una nube de puntos, y nuestro objetivo es determinar el mejor ajuste a la línea, lo

que implica estimar el intercepto y la pendiente de la recta de mejor ajuste a la nube de puntos. Puesto

que existe una desviación o error entre cada valor observado de Y y cada valor predicho por la recta

( Yˆ ), entonces el mejor ajuste será el que minimice tales errores 5.

Puesto que habrá errores positivos y negativos, una posibilidad es encontrar la recta óptima (es

decir el parámetro de intercepto y pendiente) minimizando la suma cuadrara de los errores (SCErr),

procedimiento llamado Mínimos Cuadrados Ordinarios. Estos parámetros de intercepto y pendiente son

llamados también parámetros de posición.

Variable endógena Y

Es conveniente suponer que Y es una variable aleatoria, es decir las observaciones de Y son

sucesos observados en un experimento, y que éstos tienen alguna distribución como se muestra a

continuación:

Valores posibles de Y

dado un valor de X

Y=a+bX

Variable Exogena X

5

Se agrega un término de Error (e) pues la relación entre X e Y es estocástica, lo que se puede deber a:

- Elementos impredecibles (aleatorios) del comportamiento humano.

- Gran número de variables omitidas, algunas no cuantificables.

- Errores de medición en y.

30

Así, si efectivamente la relación subyacente es lineal, uno esperaría que a través de repeticiones

sucesivas de Y (experimentos repetidos) se obtendría observaciones con frecuencias como las descritas

en cada distribución de la ilustración, de modo que el error esperado de cada observación sea cero.

Un supuesto importante en esta parte es que si bien Y y X son observables, X está fijo es decir es

una variable completamente definida por el investigador. Por el contrario Y es estocástico, producto que

existe el error en el modelo, y este error es estocástico, efecto que se transmite a Y.

2.2.2. IMPLEMENTACIÓN DE MCO

Hemos dicho que un modelo del tipo lineal simple contiene una sola variable explicativa (X). La

especificación general es un modelo lineal múltiple con muchas variables explicativas. Considerando todas

las observaciones (supongamos que se trata de T observaciones disponibles), esta relación puede

escribirse entonces de un modo matricial como sigue:

YTx1 = X TxK β Kx1 + ε Tx1

es decir:

⎡ Y1 ⎤

⎢Y ⎥

⎢ 2⎥

Y =⎢ . ⎥

⎢ ⎥

⎢ . ⎥

⎢⎣YT ⎥⎦

⎡1

⎢

⎢1

X =⎢ .

⎢

⎢.

⎢

⎣1

X X

X X

11

12

21

.

.

22

.

.

X X

T1

T2

.

.

.

.

.

.

.

.

.

.

X ⎤⎥

X⎥

ik

2k

. ⎥

⎥

. ⎥

XTk⎥⎦

⎡β 0 ⎤

⎢β ⎥

⎢ 1⎥

β =⎢ . ⎥

⎢ ⎥

⎢ . ⎥

⎢⎣ β k ⎥⎦

⎡ε1 ⎤

⎢ε ⎥

⎢ 2⎥

ε =⎢ . ⎥

⎢ ⎥

⎢ . ⎥

⎢⎣ε T ⎥⎦

donde Y es el vector de variables explicadas por el modelo, X es una matriz de valores conocidos de

variables explicatorias fijas o no estocásticas 6, ε es un vector tal que (X,ε) es una secuencia de vectores

aleatorios independientes 7, y β es un vector de K parámetros desconocidos. Para efectos de notación

matricial, el primer subíndice de X indica el número de la observación y el segundo identifica la variable.

El método de mínimos cuadrados (MCO) para encontrar los coeficientes β que proporcionan el

mejor ajuste consiste en minimizar la suma cuadrada de errores, S. Esta suma cuadrada de errores

resulta más sencilla de expresar en términos matriciales como sigue:

Expresemos el vector de errores como la siguiente diferencia:

ε = ( y − Xβ )

luego, la suma cuadrada de errores es:

6

Más adelante veremos que este supuesto de X fijas puede ser levantado.

El caso en que X contiene algún tipo de información acerca del valor esperado en el error, se produce sesgo e

inconsistencia. Otros supuestos relevantes se relacionan con la necesidad de que las varianzas de los errores estén

uniformemente acotadas y que la matriz promedio de covarianza de los regresores sea no singular.

7

31

S = ( y − Xβ )' ( y − Xβ )

= ( y '− β ' X ' )( y − Xβ )

= y ' y − β ' X ' y − y ' Xβ + β ' X ' Xβ

= y ' y − 2 β ' X ' y + β ' X ' Xβ

El objetivo de MCO es encontrar el valor del vector de coeficientes que minimice S, para lo cual

debe derivarse S respecto a b (el estimador de MCO), es decir:

∂S

= −2 X ' y + 2 X ' Xβ = 0

∂β

⇒ X ' Xb = X ' y

⇒ b = ( X ' X ) −1 X ' y

Luego, el estimador de MCO de β es b y viene dado por:

b = ( X ' X ) −1 X ' y

que es un vector aleatorio puesto que, como se ve, es una función lineal de Y. Nótese que b tiene

dimensión Kx1, de modo que para el caso de un modelo lineal simple, K=2, y el elemento (1,1) de b será

el intercepto, y el elemento (2,1) será la pendiente.

Así hemos mostrado que el estimador de MCO de los coeficientes de regresión (b) viene dado por

el producto de la matriz X y del vector Y. Luego, el procedimiento para calcular b es meramente

matemático.

32

2.3. PRUEBA DE HIPÓTESIS

2.3.2. LA DISTRIBUCIÓN DE b Y SUS PROPIEDADES

Hemos señalado que b (el estimador de β) es también una variable aleatoria, de modo que si se

conoce su distribución seremos capaces de hacer inferencias de éstos, tales como intervalos de confianza

y pruebas de hipótesis. Veamos entonces la distribución del estimador b, en cuanto a su valor esperado y

su varianza.

Puede mostrarse que el valor esperado y la varianza de b vienen dadas respectivamente por 8:

E (b) = β + ( X ' X ) −1 X ' E (ε )

V (b) = E [(b − β )(b − β )'] = ( X ' X ) −1 X ' E (εε ' ) X ( X ' X ) −1

donde E(εε’) corresponde a la matriz de varianzas y covarianzas de los errores.

La matriz de varianzas y covarianzas de los coeficientes es cuadrada y simétrica de dimensiones

KxK, es decir:

Cov (b1 , b2 )

⎡ Var (b1 )

⎢Cov (b , b )

Var (b2 )

2

1

E [(b − β )(b − β )'] = ⎢

⎢

⎢

⎣

⎤

⎥

⎥

⎥

⎥

Var (bk )⎦

donde los elementos de la diagonal son las varianzas de cada coeficiente, los que se encuentran fuera de

la diagonal son las covarianzas.

Así, b tiene la siguiente distribución general 9:

[

b ≈ β + ( X ' X ) −1 X ' E (ε ) , ( X ' X ) −1 X ' E (εε ' ) X ( X ' X ) −1

]

Nótese también que el comportamiento de los errores (ε), es decir la matriz de varianzas y

covarianzas de los errores, E(εε’), tiene gran importancia en la esperanza y la varianza de b. En efecto,

para que b sea un estimador insesgado de β (es decir E(b)=β) se requiere que X’E(ε)=0, es decir que los

errores sean independientes de las variables explicativas X, lo que se lograría siempre en el caso que X

fuera fija, y también en algunos casos cuando X es estocástica (véase regresores estocásticos).

Respecto a la varianza de b, cuando E(εε’)=σ2I, lo que significa que los errores están distribuidos

independiente y constantemente, V(b) es mínima, es decir, el estimador b es eficiente (de varianza

mínima), y en este caso la varianza de b viene dada por:

V (b) = ( X ' X ) −1 X 'σ 2 X ( X ' X ) −1 = σ 2 ( X ' X ) −1

Es decir:

8

Véase ecuación 5.6.8.a) en página 201 de Judge et al. (1988).

Note que no especificamos aún, pues no lo requerimos, la distribución específica de b, es decir si por ejemplo se trata

de una distribución Normal o no.

9

33

[

b ≈ β , σ 2 ( X ' X ) −1

]

Donde la matriz X' tiene dimensión KxT, X tiene dimensión TxK, (X'X)-1 es una matriz inversa simétrica de

dimensión KxK y σ2 es un escalar.

Teorema de Gauss-Markov

Así, bajo condiciones ideales (errores bien comportados) el estimador lineal de MCO es insesgado

y eficiente. Esto es resumido por el Teorema de Gauss-Markov, en cuanto a que puede mostrarse10 que b

es MELI, es decir, es el mejor estimador insesgado de entre la clase de los estimadores lineales de β.

Para entender la importancia del Teorema de Gauss-Markov debemos notar primero que b es un

estimador lineal, en vista que puede escribirse como una combinación lineal de la variable dependiente Y,

y que no se requiere normalidad de los errores (más adelante tomaremos este supuesto, y como

resultado, la variable Y transmite sus propiedades aleatorias (estocásticas) al estimador b). Nótese que

este teorema no dice que b son los mehjores de todos los posibles estimadores. Esto pues existen varias

clases de estimadores lineales que podrían usarse para estimar los parámetros de intercepto y pendiente

del modelo, y una porción de estos incluso será insesgados. Sin embargo, b tiene la propiedad adicional

que tiene una varianza menor que todos los estimadores lineales que sean insesgados, lo que lo convierte

en MELI, es decir el mejor estimador lineal insesgado de entre todas las clases de estimadores lineales

(estimador de varianza mínima).

Para que el teorema sea verdadero deben cumplirse los primeros 5 supuestos que siguen:

1.

2.

3.

4.

5.

6.

Modelo de Regresión Lineal

Error tiene media cero (el método de MCO asegura este resultado)

El término de error tiene varianza constante para todas las observaciones (homocedasticidad)

Los términos de error son estadísticamente independientes entre sí (no autocorrelación serial)

Las X son variables no estocásticas, o alternativamente las X no están correlacionadas con el

término de error (ambas son ortogonales): Cov(X,e) = E(Xe) = 0

(Optional) Error tiene una distribución normal: E~N(0, σ2)

Errores bien comportados en un modelo de regresión lineal se refiere a los supuestos 3), 4) y 5).

A continuación explicams esto con mayor detalle.

2.3.3. LA MATRIZ DE COVARIANZAS DE LOS ERRORES

La matriz de varianzas y covarianzas de los errores tiene la siguiente forma:

⎡ ε 1ε 1 ε 1ε 2

⎢ε ε

E [εε '] = E ⎢ 2 1

⎢

⎢

...

⎣

Cov(ε 1ε 2 )

⎤

⎤ ⎡ V (ε 1 )

⎥

⎥ ⎢Cov(ε ε )

2 1

⎥

⎥=⎢

...

... ⎥

... ... ⎥ ⎢

⎥

⎥ ⎢

εTεT ⎦ ⎣

V (ε T )⎦

...

donde los elementos de la diagonal representan la varianza de cada error, y los elementos fuera de la

diagonal son las covarianzas respectivas entre errores. Puesto que la covarianza entre el error 4 y el error

6 es la misma que la covarianza entre el error 6 y el error 4, entonces ésta matriz es simétrica y cuadrada

de dimensión TxT.

Esta matriz no es posible de observar ni estimar completamente con los datos, por la sencilla

razón de que existen solamente T observaciones o grados de libertad inicialmente, y E(εε’) contiene

10

Véase sección 5.7 en Judge et al.

34

T(T+1)/2 incógnitas 11. Por este motivo deben hacerse supuestos simples acerca de su comportamiento, y

el más sencillo es asumir que los errores están idealmente bien comportados, lo que quiere decir que

éstos errores se distribuyen independiente e idénticamente.

Veamos esto con algún detalle.

Cuando los errores se distribuyen idénticamente significa que tienen igual varianza (sabemos que

tienen media cero). En econometría a esta propiedad se le llama homocedasticidad, o inexistencia de

heterocedasticidad. Esto significa que la matriz de varianzas y covarianzas de los errores debe tener a lo

largo de toda su diagonal el mismo elemento, es decir una constante, reflejando que la varianza del error

de cada observación es el mismo para las T observaciones.

Cuando los errores se distribuyen independientemente quiere decir que éstos no están

correlacionados entre sí. En econometría a esta propiedad se le llama no-autocorrelación serial, o errores

no correlacionados serialmente. En este caso la matriz de varianzas y covarianzas de los errores debe

presentar que todos los elementos fuera de la diagonal (es decir las covarianzas) sean cero.

Así, en el caso de errores bien comportados, esto se traduce en homocedasticidad y no

autocorrelación, lo que significa que la matriz de varianzas y covarianzas de los errores debe ser igual a:

⎡σ 2

⎢

0

E [εε '] = ⎢

⎢ ...

⎢

⎣⎢ 0

0

σ

2

0⎤

⎡ 1 0 ... 0⎤

⎥

⎢

⎥

⎥ = σ 2 ⎢0 1

⎥ =σ 2I

⎥

⎢...

...

... ⎥

⎢

⎥

2⎥

σ ⎦⎥

1⎦

⎣0

...

es decir σ2 veces la matriz identidad. De este modo, en adelante, cuando nos referimos a errores bien

comportados queremos decir errores con varianzas del tipo escalar-identidad o σ2I, donde I es la matriz

identidad. Por el contrario, cuando los errores están mal comportados se dice que su matriz de varianzas

y covarianzas tiene la forma de σ2ψ, donde ψ es una matriz cuadrada simétrica TxT pero distinta de la

matriz identidad.

En cualquier caso, si bien ψ no puede estimarse a partir de los datos, sí puede obtenerse un

estimador de σ2, la varianza de los errores (σ es conocida el error estándar de la estimación) que

denominamos s2, el que puede mostrarse, viene dado por:

t =T

s2 =

∑ε

2

t

SCErr t =1

ε 'ε

=

=

T −K T −K T −K

Puede apreciarse que s2 proviene de la fórmula tradicional de varianza de una serie, es decir la

suma cuadrada de las desviaciones de cada observación respecto a la media (la media de los errores es

cero) dividido por el número de grados de libertad, en este caso T menos el número de parámetros

estimados en la regresión previa a la estimación de s2.

La forma de efectuar pruebas de hipótesis sobre coeficientes se mostrará en el capítulo siguiente.