- Ninguna Categoria

Historia de Internet y TCP/IP: Material del Curso SENA

Anuncio

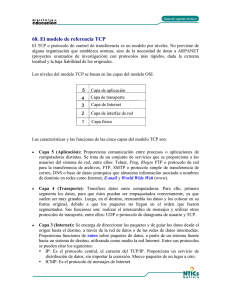

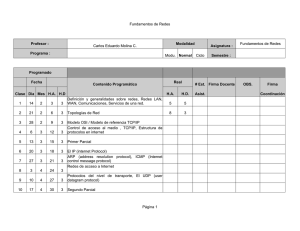

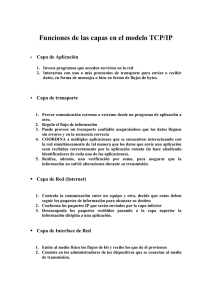

CURSO SENA VIRTUAL 2014 ASESORIA PARA EL USO DE LAS TIC EN LA FORMACIÓN ACTIVIDAD UNIDAD 3 Nombre de la Actividad: Taller Construcción de un PLE Aprendiz: Wilson Alvarado Barraza CAPÍTULO 1. CONCEPTOS BÁSICOS SOBRE TECNOLOGÍA E INTERNET 1.1 HISTORIA DE INTERNET El Departamento de Defensa de los Estados Unidos, a través de D.A.R.P.A (Defense Advanced Research Projects Agency) patrocinó diferentes iniciativas en el campo de la telemática durante las cuatro últimas décadas, que en su momento resultaron en la creación y desarrollo de una super-red enormemente redundante y distribuida en todo el territorio de los Estados Unidos, que debía proporcionar un medio eficaz de comunicación digital para las necesidades gubernamentales y militares (ArpaNet en 1969). ArpaNet dio al mundo científico y al público el impulso necesario: puso grandes sumas de dinero en investigación y desarrollo, cuyos resultados quedaron en el nivel del conocimiento público, lo que generó grandes cantidades de interés e inversión complementaria. Los resultados en 1984 se fraccionó ArpaNet en dos, ArpaNet para investigación y desarrollo y MilNet para uso operacional militar, dos super-redes para el servicio de los militares norteamericanos y toda la gama de protocolos y estándares técnicos desarrollados. Lo anterior en unos pocos años dio origen a lo que hoy conocemos como Internet El principio básico de funcionamiento de Internet era la colaboración cooperativa; no contaba con ninguna entidad especial que la manejara, pero si con el continuo soporte de algunos organismos de los Estados Unidos como el Departamento de Defensa y la National Science Foundation (NSF). En Colombia hace algunos años la Universidad de los Andes logró conectarse a la red Bitnet (red que intercomunica las universidades norteamericanas pero está fue desplazada por Internet) en lo que se llamó el proyecto Runcol, aprovechando la infraestructura de Coldapac (la red de conmutación de paquetes de Telecom.), varias universidades del país hicieron uso del servicio de forma experimental, esto permitió acumular conocimientos y experiencias para que en 1992, otra vez por iniciativa de la Universidad de los Andes se lograra una conexión viable a Internet con la participación de las universidades de Eafit y del Valle En 1993 el proyecto recibe impulso de Colciencias e ICFES, mediante un acuerdo especial de cooperación con el objeto de aunar esfuerzos técnicos, administrativos y económicos para gestionar la implantación y funcionamiento de una infraestructura de comunicación de datos para uso del sistema nacional de información científica y tecnológica y el sistema nacional de la educación superior. Internet ha experimentado un ritmo de crecimiento asombroso en los últimos dieciséis años. En 1984 había aproximadamente 1,000 servidores en Internet. En 1989, este número había crecido a más de 100,000 y, tres años después, en 1992, se contabilizaban un total de más de un millón de computadoras conectada a Internet. En julio de 1994 había más de 3 millones de sistemas informáticos conectados a la red, con unos 20 millones de usuarios. Con el desarrollo de herramientas de recuperación de información de fácil manejo, como Mosaic y la World Wide Web, muchos usuarios normales empezaron a descubrir los muchos recursos accesibles de información que incorpora Internet. Internet es una gran interconexión de redes, físicamente distribuidas por todo el mundo, y que funciona como una unidad coordinada, la información fluye en paquetes conmutados que son transportados a su destino por los diferentes computadores y enlaces de la red. La infraestructura de Internet de hoy es el progreso desde una red principal (NSFNET) a una arquitectura más distribuida operada por proveedores comerciales, conectados mediante grandes puntos de intercambio de red, así como interconexiones directas de red. El backbone actual de Internet es un conjunto de proveedores de servicios que tienen puntos de conexión llamados POP (punto de presencia) sobre múltiples regiones. Para permitir que los clientes de un proveedor alcancen a los clientes conectados a otro proveedor, el tráfico se intercambia en Punto de Acceso a la Red (NAP) públicos, o a través de interconexiones directas. El termino ISP (Proveedor de Servicios de Internet) se utiliza comúnmente para referirse a cualquiera que proporciona servicio de conectividad a Internet, tanto al usuario final directamente como a otros proveedores de servicio. El termino NSP (Proveedor de Servicios de Red) se utilizan tradicionalmente para referirse a los proveedores de backbone de red. El uso de Internet como herramienta educativa y de investigación científica ha crecido aceleradamente debido a la ventaja que representa el poder acceder a grandes bases de datos, la capacidad de compartir información entre colegas y facilitar la coordinación de grupos de trabajo. 1.2 PROTOCOLO TCP/IP 1.2.1 Historia del TCP/IP. El TCP/IP fue originado con los experimentos de intercambio de paquetes dirigido por el U.S. Department of Defense Advanced Research Projects Agency (DARPA) durante la década de 1960 a 1970. Hay varios hitos importantes en la historia del TCP/IP: 1970: Los ordenadores de la Advanced Research Agency Network (ARPANET) comienzan a utilizar el NCP (Network Control Protocolo). 1972: La primera especificación Telnet. adhoc telnet protocol se define como una RFC, la 318. 1973: RFC 454. Se introduce el FTP (File Transport Protocol). 1974: El TCP (Transmisión Control Protocol) se especifica detalladamente. 1981: El estándar IP se publica en la RFC 791. 1982: La Defense Communications Agency (DCA) y ARPA establecen a la Transmision Control Protocol (TCP) y al Internet Protocol (IP) como la colección de protocolos TCP/IP. 1983: ARPANET cambia de NCP a TCP/IP. 1984: Se define el concepto de DNS (Domain Name System). 1.2.2 El Modelo de Capa de TCP/IP. La Agencia de Proyectos de Investigación Avanzada del Departamento de Defensa de los Estados Unidos de Norteamérica definió un conjunto de reglas que establecieron cómo conectar computadores entre si para lograr el intercambio de información, soportando incluso desastres mayores en la subred. Fue así como se definió el conjunto de protocolos de TCP/IP (TCP/IP Internet Suite Protocols). La suite de TCP/IP consta de 4 capas principales que se han convertido en un estándar a nivel mundial. 1.2.3 Capas del modelo TCP/IP. Las capas de la Suite TCP/IP son menos que las del modelo de referencia OSI. 1.2.3.1 Capa de Red. La base de este modelo de capas de interfase de red. Esta capa es la responsable de enviar y recibir frames, los cuales son los paquetes de información que viajan en una red como una unidad simple. La capa de red, envía frames a la red, y recupera frames de la red. 1.2.3.2 Capa de Internet. Esta capa encapsula paquetes en datagramas Internet y además esta capa ejecuta todos los algoritmos de enrutamiento (routing) de paquetes. Los cuatro protocolos Internet son: Internet Protocol (IP), Address Resolution Protocol (ARP), Internet Control Message Protocol (ICMP) y Internet Group Management Protocol (IGMP). La responsabilidad de este protocolo es entregar paquetes en los destinos indicados, realizando las operaciones de enrutado apropiadas y la resolución de congestionamientos o caídas de rutas. · IP: Es el responsable del envío y enrutamiento de paquetes entre máquinas y redes. · ARP: Obtiene las direcciones de hardware de las maquinas situadas en la misma red física. · ICMP: Envía mensajes e informa de errores en el envío de paquetes. · IGMP: Se utiliza para la comunicación entre routers (Enrutadores de Internet). 1.2.3.3 Capa de Transporte. La capa de transporte, nos da el nivel de sesión en la comunicación. Los dos protocolos posibles de transporte son TCP (Transmisión Control Protocol) y UDP (User Datagram Protocol). El primero es un protocolo confiable y orientado a conexiones, lo cual significa que nos ofrece un medio libre de errores para enviar paquetes. El segundo es un protocolo no orientado a conexiones y no es confiable. El TCP se prefiere para la transmisión de datos a nivel de red de área amplia y el otro para redes de área local. Se puede utilizar uno u otro protocolo dependiendo del método preferido de envío de datos. El TCP nos da un tipo de conectividad orientado a conexión. Típicamente se utiliza para transferencia de largas cantidades de datos de una sola vez. Se utiliza también en aplicaciones que requieren un reconocimiento o validación (ACK : acknowledgment) de los datos recibidos. El UDP proporciona conexión de comunicación y no garantiza la entrega de paquetes. Las aplicaciones que utilicen UDP normalmente envían pequeñas cantidades de datos de una sola vez. La aplicación que lo utilice, es la responsable en este caso de la integridad de los paquetes y debe establecer sus propios mecanismos para pedir repetición de mensaje, seguimiento, etc. No existiendo ni garantía de entrega ni garantía del orden de entrega en la maquina destino. 1.2.3.4 Capa de Aplicación. En la cima de este modelo, está la capa de aplicación. Esta es la capa que las aplicaciones utilizan para acceder a la red. Existen muchas utilidades y servicios en la capa de aplicación, por ejemplo: FTP, Telnet, SMTP, NTP, DNS entre otros. Aplicacio nes Windows Socket Aplicaciones NetBios Sockets NetBios NetBios sobre TCP/IP NetBios NetBios sobre TCP/IP TCP UDP TRANSPORTE ICMP, GMP IP ARP ICMP, GMP IP ARP INTERNET Ethernet, Token Ring FDDI Frame Relay, ATM,etc. RED APLICACIÓN Tabla 1.1. Modelo de capas TCP/IP 1.2.4 Protocolo de Internet (IPv4). IP es el protocolo primario de conexión responsable del envío y enrutamiento de paquetes entre maquinas (hosts). IP no establece una sesión antes de intercambiar datos. IP no es fiable debido a que trabaja sin garantía de entrega. A lo largo del camino, un paquete puede perderse, cambiarse de secuencia, duplicarse, retrasarse, o incluso dividirse. IP no requiere una comunicación ACK cuando se reciben los datos. El Emisor o el receptor no son informados cuando un paquete se pierde o se envía fuera de secuencia. El ACK de los paquetes es responsabilidad de una capa de más alto nivel de transporte como por ejemplo el TCP. Si el IP identifica una dirección de destino como una dirección local, el IP envía el paquete directamente a la máquina. Si el destino es identificado como un destino remoto, el IP chequea sus tablas de rutas. paquete utilizando esa ruta. Si encuentra una ruta, el IP envía el Si no encuentra una ruta, el IP envía el paquete al gateway por defecto (tan bien llamado router). 1.2.4.1 Estructura del paquete IP. Los campos del paquete IP en la versión 4 del TCP/IP (versión actual) son los siguientes: Campo Función Versión Son utilizados 4 bits para indicar la versión del IP. La versión actual es la versión 4. La siguiente versión del IP es la versión 6. Longitud de la cabecera Se utilizan 4 bits que indican el número de palabras de 32 bits en la cabecera IP. La cabecera IP tiene un mínimo de 20 bytes. Tipo de Servicio Se utilizan 8 bits para indicar la calidad del servicio esperado por este datagrama para entrega a través de los routers en la red IP. Especifican procedencia, demora, y tipo de entrega. Longitud Total 16 bits son utilizados para indicar la longitud total incluida cabecera del datagrama IP. Identificación 16 bits son utilizados para identificar este paquete. Si el paquete fuese fragmentado, todos los segmentos que tuviesen esta misma identificación serán usados para reensamblarlos en la maquina destino. Flags de Fragmentación 3 bits son reservados como indicadores del proceso de fragmentación. Sin embargo únicamente 2 bits están definidos para el proceso en curso. Uno de ellos es para indicar cuando el datagrama puede ser fragmentado y el otro para indicar que hay más fragmentos que lo siguen. Offset del fragmento 13 bits se utilizan como un contador del desplazamiento para indicar la posición del fragmento relativo al paquete IP original. Si el paquete no estuviese fragmentado este campo contendrá un cero. Tiempo de Vida (TTL) 8 bits se utilizan para indicar la cantidad de vida o de saltos que un paquete IP puede realizar antes de ser descartado. Protocolo 8 bits se utilizan como un identificador del protocolo. Checksum de la cabecera. 16 bits son usados como checksum de la cabecera IP únicamente. El cuerpo del mensaje IP no está incluido, y deberá ser incluido en él, su propio checksum para evitar errores. Dirección Origen 32 bits que almacenan la dirección IP del origen. Dirección Destino 32 bits que almacenan la dirección IP del destino. Opciones y Relleno Un múltiplo de 32 bits es utilizado para almacenar las opciones IP. Si las opciones IP no utilizan los 32 bits, se rellenan con bits adicionales a ceros para que la longitud de la cabecera IP sea un número entero de palabras de 32 bits. Tabla 1.2. Campos del paquete IP 1.2.4.2 IP en el Router. Cuando un router recibe un paquete, el paquete es pasado a la capa IP la cual realiza lo siguiente: ü Decrementa el campo TTL al menos en 1. Puede ser disminuido en una cantidad mayor si el router estuviese congestionado. Si el TTL alcanza el valor de cero, el paquete será descartado. ü El IP puede fragmentar el paquete en paquetes más pequeños si el paquete fuese demasiado largo para las líneas de salida del router. ü Si el paquete es fragmentado, el IP crea una nueva cabecera para cada nuevo paquete la cual incluye: · · Un flag (indicador) de que le siguen nuevos fragmentos. Un número de fragmento (Fragment ID) para identificar todos los fragmentos que continúan. · Un desplazamiento (Fragment Offset) para permitir que la maquina que lo va a recibir sea capaz de reensamblar el paquete. · El IP calcula los nuevos cheksum. · El IP obtiene la dirección hardware del siguiente router. · Envía el paquete. En el siguiente host, el paquete subirá en el stack (pila o capa de protocolos) hasta el TCP o el UDP. Este proceso se repite en cada router hasta que el paquete encuentra su destino final. Cuando el paquete llega a su destino final el IP ensamblará las piezas tal y como estaba el paquete original. 1.2.4.3 Direccionamiento IP. La dirección IP identifica la localización de un sistema en la red. Equivale a una dirección de una calle y número de portal. Es decir, es única. No pueden existir en la misma ciudad dos calles con el mismo nombre y número de portal. Cada dirección IP tiene dos partes. Una de ellas, identifica a la red y la otra identifica a la maquina dentro de esa red. Todas las maquinas que pertenecen a la misma red requieren el mismo número de red el cual debe ser además único en Internet. El número de máquina, identifica a una workstation, servidor, router o cualquier dispositivo con soporte TCP/IP conectado a la red. El número de maquina (número de host) debe ser único para esa red. Cada host TCP/IP, por tanto, queda identificado por una dirección IP que debe ser única. 1.2.4.4 Identificación de red e Identificación de host.. Hay dos formatos para referirnos a una dirección IP, formato binario y formato decimal con punto. Cada dirección IP es de 32 bits de longitud y está compuesto por 4 campos de 8 bits, llamados bytes u octetos. Estos octetos están separados por puntos y cada uno de ellos representa un número decimal entre cero y 255. Los 32 bits de una dirección IP contienen tanto la identificación de red como la identificación de hosts dentro de la red. La manera más fácil de leer para los humanos una dirección IP es mediante la notación decimal con puntos. Vamos a ver a continuación un ejemplo de una dirección IP en binario y decimal con punto: 10011001.11011100.00110101.00001111 ? 153.220.53.15 1.3 APLICACIONES DE INTERNET 2 Dentro de toda la serie de aplicaciones prácticas que Internet2 trae consigo, las directamente relacionadas con servicios para la investigación, la educación resaltan como objetivos fundamentales del proyecto. Además se encuentran las siguientes: 1.3.1 Tecnología de redes de telecomunicaciones. ·Voz sobre IP.- VoIP. La voz sobre IP es una tecnología que permite transmisión de la voz a través de redes IP en forma de paquetes de datos. La telefonía IP es una aplicación inmediata de esta tecnología, de forma que permite la realización de llamadas telefónicas ordinarias sobre redes IP u otras redes de paquetes utilizando un pc, gateways y teléfonos estándares. 1.3.2 Multicasting. Este término de multidifusión es para referirse a la emisión de información en Internet a múltiples usuarios sin necesidad de enviar los paquetes uno a uno a cada usuario concreto. Es una técnica de transmisión a través de Internet que permite enviar información (como video en el caso de video-conferencia) a varios lugares al mismo tiempo. De igual manera esta técnica permite recibir transmisiones de host que utilicen multicasting, sin tener que solicitárselo a este directamente. Esta técnica permite ahorrar ancho de banda. Redes avanzadas de investigación como Internet2 están implementando sistemas de multidifusión para distribuir fundamentalmente seminarios y conferencias. Parecida a la televisión abierta en que se envía una señal por aire, con multidifusión se distribuye un flujo a lo largo de la red y los usuarios conectados recogen esta emisión. Por lo tanto, evita que cientos o miles de computadores vayan a un servidor central ocupando ancho de banda. Una aplicación inicial en Internet de este tipo fue Mbone. Hoy día se experimenta con codificación MPEG, con lo cual esta tecnología de distribución alcanza calidades similares a la televisión. 1.3.3 Educación a Distancia. Experiencias en Educación a Distancia en las diferentes universidades Plataforma Educativa para fortalecer el Sistema de Educación Superior. Objetos de aprendizaje que son una tecnología instruccional, es decir, sirven para que los alumnos aprendan, dicha tecnología está basada en el paradigma de cómputo orientado a objetos, el cual se refiere a crear componentes o módulos que puedan ser reutilizables en otros programas. Estos objetos de aprendizajes se hacen bajo Internet, porque éste nos permite una gran riqueza de representación, sobre todo en áreas de ciencias, física, química, en las cuales las imágenes y el video son indispensables para comprender muchos conceptos. Internet me permite incorporar a un objeto prácticamente lo que yo quiera, video, multimedia, simuladores, de tal manera que tendría objetos muy completos. Creaciones Artísticas con alta fidelidad, vídeo y audio con miles de canales y múltiples participantes, con interactividad para realizar conciertos e improvisaciones musicales y de baile, así como sincronización de vídeo, audio y anotaciones. En un entorno Internet, por otra parte, la enseñanza de la música en estudio podría tener nuevas oportunidades. Se podría invitar a músicos mundialmente reconocidos a ofrecer lecciones magistrales y a aportar sus puntos de vista. Por ejemplo, una conexión bidireccional vídeo-audio podría poner en contacto a una banda de jazz de una escuela superior con un artista residente en la universidad. La alta calidad del enlace podría permitir demostraciones y juicios críticos. Además, los alumnos podrían participar, literalmente, en una "improvisación" junto a su profesor de la universidad. Esta conexión podría extenderse a otros músicos (tanto alumnos como profesionales) de otras localidades. La enseñanza podría enriquecerse con la incorporación de actuaciones grabadas en audio y vídeo extraídas de un servidor de la red. La interacción entre el alumno y el profesor podría, asimismo, grabarse para una revisión posterior, tanto por parte del maestro como en las prácticas de los alumnos. Figura 1.1. Educación a distancia 1.3.4 Bibliotecas digitales. Son espacios virtuales que facilitan el acceso, el uso, la difusión y la generación de conocimiento. En estas actividades es fundamental la disponibilidad de una red de alto desempeño, como lo es de Internet que proporciona a sus usuarios un ambiente lo suficientemente versátil y potente. Bibliotecas Digitales, librerías digitales con audio y vídeo de alta fidelidad, e imágenes escaneadas de gran tamaño y resolución que aparecen inmediatamente en la pantalla del ordenador, así como nuevas formas de visualizar datos. La biblioteca digital puede almacenar una gran cantidad de documentos en diferentes formatos, así como hacer búsquedas en el texto completo de los documentos, una vez se encuentra el documento deseado por medio de una búsqueda o navegando en un repositorio, la plataforma de biblioteca digital ofrece la facilidad de almacenar o visualizar el documento, y éste pude verse en formato PDF, RTF o HTML. 1.3.5 Telemedicina y Salud. Con todos los servicios tecnológicos de Internet la salud como partícipe de estos, encuentra en la telemedicina una de sus mayores aplicaciones a las actuales demandas de lo referente a la asistencia. Se entiende telemedicina como la provisión de servicios, educación y cuidados de la salud a distancia a través de medios de comunicación e información de alta tecnología. Ejemplos de telemedicina se encuentran las exploraciones y diagnósticos remotos y telemonitorización (manejo a distancia de, por ejemplo, equipos quirúrgicos). Figura 1.2. Telemedicina 1.3.6 Ciencias de la tierra. El uso de Internet en apoyo al grupo de estudio de la profundad de los océanos. Análisis multiescala del clima urbano. Figura 1.3. Aplicación en ciencias de la tierra 1.3.7 Astronomía. Construcción del gran telescopio milimétrico y sus necesidades de transmisión de datos. Aplicaciones con uso intensivo de datos y recursos informáticos, como las que se pueden usar para cálculos complejos necesarios en astronomía, para medir movimientos migratorios de población, en procesos meteorológicos asociados al cambio climático, etc. Figura 1.4. Aplicaciones en astronomía [12] 1.3.8 Súper computo compartido. El Grand Challenge Computational Cosmology Consortium está formado por un grupo de astrónomos teóricos y de informáticos, comprometidos en una investigación y trabajando en colaboración sobre el origen del universo y la emergencia de estructuras a gran escala. Este grupo incluye a científicos de la Universidad de Indiana, INICSA, Princeton, MIT, UC-SC y el Centro de Supercomputación de Pittsburgh. Su trabajo precisa de simulaciones masivas por medio de múltiples supercomputadores que funcionan simultáneamente; grandes bases de datos con los resultados de la simulación; visualizaciones extensas que muestran la evolución de estrellas y galaxias, y un amplio repositorio de software compartido que hace posible todo lo anterior. Si bien algunos experimentos se realizan de forma aislada, la mayor parte de los mismos requiere una estrecha colaboración entre equipos de personas distribuidos por múltiples zonas. Cada miembro de un equipo es un experto en un componente particular de la heterogénea mezcla formada por la simulación, el análisis de los datos y la visualización. El equipo debe poder compartir una visión común de la simulación y participar de forma interactiva en la computación colectiva. Figura 1.5. Nano-manipulador 1.3.9 Laboratorios Virtuales. Un laboratorio virtual es un entorno distribuido heterogéneo de resolución de problemas que permite a un grupo de investigadores esparcidos por todo el mundo trabajar juntos en un conjunto común de proyectos. Como en cualquier otro laboratorio, las herramientas y técnicas son específicas del dominio de investigación, pero los requisitos de infraestructura básica se comparten entre las distintas disciplinas. Interacción multilateral vía Internet2 con robots cooperativos Nanotecnología, Control a distancia. Figura 1.6. Nanotecnología 1.3.10 Teleinmersión. Realidad Virtual. Ambientes de "inmersión" (Teleinmersión), en los que se utilizan nuevas formas de colaboración: se mantienen reuniones virtuales, en tres dimensiones, entre varios participantes. Ambientes de colaboración, donde se usan conjuntamente laboratorios virtuales, con manejo remoto de instrumentos, sesiones de grabación y reproducción automáticas, conversaciones en tiempo real con vídeo, audio, texto y realidad virtual, etcétera. La teleinmersión tiene el potencial de cambiar significativamente los paradigmas educativos, científicos y de fabricación. Un sistema de teleinmersión permitiría a personas situadas en distintos lugares compartir el mismo entorno virtual. Por ejemplo, los participantes en una reunión podrían interactuar con un grupo virtual, casi de la misma forma como lo harían si estuvieran en la misma habitación. Los individuos podrían compartir y manipular datos, simulaciones y modelo de moléculas; construcciones físicas o económicas; y participar juntos en la simulación revisión de diseños o procesos de evaluación. Como ejemplo, piénsese en alumnos de ingeniería mecánica o industrial trabajando juntos para diseñar un nuevo puente o brazo de robot mediante la teleinmersión. Los miembros del grupo podrían interactuar con otros miembros del grupo mientras comparten el objeto virtual que está siendo modelado. Figura 1.7. Aplicaciones de teleinmersión Entre las aplicaciones que están hoy más allá del campo de investigación de la Internet actual, está la teleinmersión y diversos proyectos de laboratorio virtual. La teleinmersión podría ir más lejos al permitir a sus participantes compartir un común entorno virtual realista que les permitiera además la comunicación humana de forma natural dentro de un entorno virtual y la interacción dentro de una aplicación común. 1.3.11 Software educativo. Este tipo de aplicación que facilita y dinamiza los entornos educativos. Los profesores diseñan los módulos de contenidos, que será administrado por software, que finalmente compartido a alumnos y entidades interesados en estos. Diferentes estándares de módulos permiten interactuar en aspectos tales como seguimiento al progreso de los alumnos, incorporación automática de los módulos en marcos más amplios, interacción conjunta y flujos entre módulos. Un ejemplo de software educativo es: El software educativo (learningware) y el Instructional Management System (IMS). Hay muy poco software de alta calidad disponible en el área de la enseñanza distribuida. La mayoría del software educativo ha sido diseñado para su uso autónomo, especialmente el que incorpora sonido, imagen y vídeo. Por otra parte, buena parte del mismo depende de un único sistema operativo. Internet2 es una oportunidad para trabajar en una arquitectura de desarrollo de aplicaciones que cree un software educativo (learningware) con sus correspondientes aplicaciones que pueda proporcionarse y usarse dentro de la enseñanza distribuida. Como por ejemplo crear materiales para la enseñanza en red de tal manera que el usuario pueda recoger y analizar datos de forma interactiva, inclusión de modelos gráficos en 2D o 3D, esquemas de modelación matemática, mecanismos de computación y manipulación simbólica, esquemas de modelación molecular, tablas periódicas inteligentes, bases de datos léxicas bilingües y herramientas de búsquedas para el desarrollo del aprendizaje de una segunda lengua, así como otras funcionalidades genéricas. En el entorno educativo tradicional, este proceso es diseñado, controlado y llevado a cabo por los profesores. En un entorno educativo distribuido en red, este proceso debería ser diseñado por los mismos profesores, pero manejado por el software, que debería ser, a menudo compartido por alumnos, profesores y por otras entidades como editores y proveedores de información. A este sistema de dirección educativa basada en red se le denomina IMS. El IMS se compone de servicios y estándares. Los estándares permitirán a los módulos educativos distribuidos ínteroperar en lo que respecta a aspectos tales como el seguimiento del progreso de los alumnos, incorporación automática de los módulos en marcos más amplios, interacción colaborativa y flujos entre los módulos. Los estándares crearán también un mecanismo común para la organización y recuperación de los objetos educativos basados en red al reflejar la relación entre los módulos educativos individuales y los objetivos específicos de aprendizaje. Mientras algunas de las tecnologías de IMS podrían ser desarrolladas en el entorno de la Internet actual, los componentes síncronos de comunicación y las tecnologías para enlazar y proporcionar materiales multimedia de aprendizaje requerirán servicios de red todavía no disponibles. 1.3.12 Videoconferencia. Sistemas de videoconferencia permiten que personas en lugares diferentes realicen reuniones en tiempo real, con transmisión y recepción simultáneas de audio, video y datos. Adicionalmente, pueden ofrecerse facilidades telemáticas o de otro tipo como el intercambio de informaciones gráficas, imágenes fijas, transmisión de ficheros desde el pc, etc. La videoconferencia proporciona importantes beneficios como el trabajo colaborativo entre personas geográficamente distantes y una mayor integración entre grupos de trabajo. Figura 1.8. Aplicación de videoconferencia

Anuncio

Documentos relacionados

Descargar

Anuncio

Añadir este documento a la recogida (s)

Puede agregar este documento a su colección de estudio (s)

Iniciar sesión Disponible sólo para usuarios autorizadosAñadir a este documento guardado

Puede agregar este documento a su lista guardada

Iniciar sesión Disponible sólo para usuarios autorizados