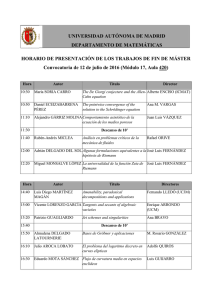

See discussions, stats, and author profiles for this publication at: https://www.researchgate.net/publication/44343683

Redes neuronales artificiales : fundamentos, modelos y aplicaciones / José

Ramón Hilera González, Victor José Martínez Hernando

Book · January 1995

Source: OAI

CITATIONS

READS

0

4,001

2 authors:

José R. Hilera

Victor Martinez Hernando

University of Alcalá

Universidad Politécnica de Madrid

153 PUBLICATIONS 826 CITATIONS

4 PUBLICATIONS 127 CITATIONS

SEE PROFILE

Some of the authors of this publication are also working on these related projects:

Publications of José R. Hilera View project

Accesibilidad e inclusión en E-learning - Observatorio virtual accesible View project

All content following this page was uploaded by José R. Hilera on 23 January 2017.

The user has requested enhancement of the downloaded file.

SEE PROFILE

PROLOGO

Existe actualmente una tendencia a establecer un nuevo campo de las ciencias de la

computación que integraría los diferentes métodos de resolución de problemas que no pueden

ser descritos fácilmente mediante un enfoque algorítmico tradicional. Estos métodos, de una

forma u otra, tienen su origen en la emulación, más o menos inteligente, del comportamiento

de los sistemas biológicos.

Aunque este nuevo campo todavía no está perfectamente definido, ya se han acuñado

diferentes terminos para denotarlo. Así, algunos autores se refieren a él como Computación

Cognitiva (Cognitive Computing), otros lo denominan Computación del mundo real (Real-World

Computing), y también se utiliza la expresión Computación Soft (Soft Computing), para

distinguirlo del enfoque algorítmico tradicional que sería, en este caso, la Computación Hard.

Aunque su uso no se ha extendido todavía, otro término alternativo sería el de Brainware.

En cualquier caso, se trata de una nueva forma de computación que es capaz de

manejar las imprecisiones e incertidumbres que aparecen cuando se trata de resolver

problemas relacionados con el mundo real (reconocimieto de formas, toma de decisiones, etc.),

ofreciendo soluciones robustas y de fácil implementación. Para ello, se dispone de un conjunto

de metodologías, como son la Lógica Borrosa, las Redes Neuronales, el Razonamiento

Aproximado, los Algoritmos Genéticos, la Teoría del Caos y la Teoría del Aprendizaje.

Aunque, en principio, se trata de enfoques diferentes, existe una tendecia a buscar

combinaciones entre ellos, para lo cual son cada vez más frecuentes los encuentros entre

expertos en cada una de estas disciplinas, lo cual permitirá una consolidacién de este campo de

las ciencias de la computación y, en consecuencia, el progreso en el desarrollo de nuevas

tecnologías de procesamiento de la información.

En este libro se tratará de introducir precisamente una de estas formas de computación,

la basada en la utilización de Redes Neuronales Artificiales; aunque también se dedicará

atención (capítulo 9) a su posible combinación con otra de las mencionadas, la Lógica Borrosa.

Con las Redes Neuronales se intentará expresar la solución de problemas complejos, no como

una secuencia de pasos, sino como la evolución de unos sistemas de computación, inspirados

en el funcionamiento del cerebro humano y dotados, por tanto, de una cierta "inteligencia"; los

cuales, no son sino la combinación de una gran cantidad de elementos simples de proceso

(neuronas) interconectados que, operando de forma masivamente paralela, consiguen resolver

problemas relacionados con el reconocimieto de formas o patrones, predicción, codificación,

clasificación, control y optimización.

Aunque con el texto se introduce al lector en el ámbito general de las redes neuronales,

también se pretende el estudio con cierto detalle de algunos importantes tipos particulares de

estos sistemas, con una descripción detallada de su funcionamiento y mecanismo de

aprendizaje que permitirá, al lector que lo desee, ralizar la emulación de estas redes, para

resolver diferentes problemas, mediante la codificación, utilizando un lenguaje de

programación cualquiera, de los algoritmos que se presentan a lo largo del texto.

En el primer capítulo se realiza una panorámica histórica de la evolución de las redes

neuronales, su relación con la Inteligencia Artificial y sus posibles aplicaciones. También se

aborda, de forma general, el tema de la implementación práctica de las redes neuronales,

desde los neurocomputadores de propósito general y especial hasta los chips neuronales VLSI.

En este sentido es importante destacar que, aunque se pueden desarrollar aplicaciones

mediante programas de simulación, codificando algoritmos de funcionamiento y aprendizaje,

la verdadera potencia de las redes neuronales se pone de manifiesto precismanete mediante su

implementacion física en hardware con multiples elementos de proceso que permitan explotar

masivamente el paralelismo inherente a estos sistemas de computación.

En el segundo capítulo se analizan los fundamentos de las redes, partiendo del modelo

biológico de neurona hasta llegar a la descripción de la estructura de las redes de neuronas

artificiales para, en el capítulo siguiente (3), estudiar las características que diferencian los

diferentes modelos de redes neuronales: su topología, mecanismo de aprendizaje y naturaleza

de la información "aprendida". En este capítulo se hace referencia a la práctica totalidad de

modelos de redes existentes, presentanto al final una completa tabla resumen donde se

encuadran todos ellos junto con sus características más significativas.

Los cinco siguientes capítulos (4, 5, 6, 7 y 8) se dedican al estudio, con cierto detalle, de

algunos modelos de redes que se han elegido por su importancia y por reperesentar cada uno

de ellos un posible ámbito de aplicación de estos sistemas de computación. Las redes que se

analizan son: Perceptrón, ADALINE y MADALINE, BackPropagation, Redes de Hopfield, ART,

Redes de Kohonen, Counterpropagation y las redes estocásticas conocidas como Máquinas de

Boltzmann y de Cauchy. En todos los casos se presenta su arquitectura, funcionamiento,

mecanismo de aprendizaje, limitaciones del modelo y posibles aplicaciones.

Así, en el capítulo 4 se tratan las cuatro primeras, que se caracterizan por tener una

arquitectura similar, con unas conexiones entre neuronas orientadas en el mismo sentido

(hacia delante), y un mecanismo de aprendizaje supervisado, precisando de un ente externo a

la red que determine cuándo ésta ha aprendido correctamente lo que se le quería enseñar. La

presentación de los modelos es cronológica, comenzando por el Perceptrón y las redes

ADALINE y MADALINE, que presentan serias limitaciones respecto a sus posibles

aplicaciones, que son resueltas con la aparición de la red Backpropagation, la más ampliamante

utilizada hasta la actualidad.

En el capítulo 5 se analiza el modelo de red ideado por J. Hopfield, uno de los

principales responsables del desarrollo de la computación neuronal. El modelo que lleva su

nombre tiene una arquitectura y aprendizaje muy diferentes al de las redes anteriores, siendo

especialmente adecuado como memoria de acceso por contenido y, sobre todo, para sresolver

una gran variedad de problemas de optimización, como el de la bipartición de grafos, el del

viajante y del emparejamiento ponderado, que serán tratados con detalle en este capítulo.

El Modelo de Resonancia Adaptativa (ART) se presenta en el capítulo 6, donde se

describe un nuevo tipo de redes que "aprenden" de la experiencia, mientras funcionan

(aprendizaje on-line), sin necesidad de supervisión, que además están compuestas de unas

neuronas entre las que se establece una cierta competición por conseguir activarse. Se analizan

en este capítulo las dos variantes del modelo, conocidas como red ART1, que opera con datos

binarios, y ART2, que mejora la anterior, procesando todo tipo de datos.

En el capítulo 7 se presenta el modelo de red ideado por T. Kohonen, basado en la

hipotética capacidad inherente del cerebro de formar "mapas topológicos" de las informaciones

recibidas del exterior. En este sentido, la red analizada es capaz de organizar por si misma

mapas que reflejan las características comunes de las informaciones aprendidas, garantizando

que las neuronas topológicamente próximas sean sensibles a entradas físicamenete similares.

Las redes estocásticas también tienen cabida en el libro, dedicando el capítulo 8 a tales

sistemas, que pretenden mejorar el funcionamiento de las redes clásicas o deterministas

mediante la utilización de neuronas con comportamiento probabilístico, recurriendo a un símil

termodinámico de la mecánica estadística considerando una red como si de un cuerpo o

material real compuesto de partículas elementales (átomos, moléculas, etc.) se tratara. La redes

de este tipo que se analizan son la Máquina de Boltzmann y la Máquina de Cauchy,

El libro concluye con un último capítulo (9) en el que se analizan algunas posibles

combinaciones de la capacidad de aprendizaje de las Redes Neuronales Artificiales con la de

procesamiento de información imprecisa de la Lógica Borrosa, otro de los pilares, como se

comentó al comienzo de este prólogo, de la emergente Computación Cognitiva, Soft o del

mundo real. En este capítulo se describe un modelo de neurona y aprendizaje borrosos, y se

analiza la posibilidad de utilizar redes en el diseño de sistemas de control borroso.

Finalmente, resaltar la significación e importancia que las Redes Neuronales están

adquiriendo en la actualidad, como lo evidencia el hecho de formar parte de las materias

troncales de los nuevos Planes de Estudio correspondientes a las Titulaciones Universitarias de

Ingeniería en Informática e Ingeniería Técnica en Informática de Sistemas. Este ha sido el

principal motivo que nos ha impulsado a escribir un texto, con el objetivo de que pueda ser útil

en el desarrollo de estos estudios, sumándose así al reducido número de libros que sobre el

tema han sido editados en español.

Julio, 1994

Universidad de Alcalá de Henares

Universidad Politécnica de Madrid

José R. Hilera

Víctor J. Martínez

I. Introducción a la computación neuronal

1.1

I.- UNA INTRODUCCIÓN A LA COMPUTACIÓN NEURONAL

El principal propósito de todos los sistemas neuronales es el control centralizado de

varias funciones biológicas. Algunas de ellas son responsables del abastecimiento de energía;

el sistema neuronal está conectado con el metabolismo, control cardiovascular y la respiración.

Hay mecanismos neuronales para los ritmos biológicos, funciones de emergencia , etc.

Las funciones anteriores son comunes a la mayoría de los animales y en las estructuras

biológicas neuronales es posible incluso discernir varios "sedimentos" de las diferentes fases de

la evolución. Por otro lado, en los animales superiores, la mayor capacidad del sistema

nervioso central está relacionado con el comportamiento, esto es, control del estado del

organismo con respecto a su entorno, el cual implica muchas tareas diferentes gracias al

encadenamiento de acciones elementales para conseguir un comportamiento social

complicado.

No obstante, cuando se habla de computación neuronal, normalmente sólo se tiene en

mente las funciones sensoriales y motoras, así como algún tipo de "proceso interno" llamado

pensamiento. Todas estas funciones son interdependientes en un sentido u otro, pero puede

ser posible conceptualizar alguna de ellas de una forma idealizada.

En el desarrollo de la tecnología de la información, actualmente parece existir una

nueva fase donde el objetivo es reproducir muchas de estas funciones neuronales

artificialmente. No obstante, no está siempre claro a cuales de los aspectos arriba indicados se

refiere. El motivo principal parece ser el desarrollo de nuevos tipos de ordenadores. Por

ejemplo, un objetivo puede ser la implementación de funciones sensoriales artificiales para

hacer "ver" u "oír" a las máquinas; esta es una extensión de las más tradicionales técnicas de

instrumentación.

Aunque el potencial de los métodos de Inteligencia Artificial, por medio de los cuales

éstos problemas fueron abordados, han sido conocidos desde hace 25 años, todavía se espera

que nuevas vías para la Inteligencia Artificial se puedan abrir cuando el paralelismo masivo de

los circuitos computacionales y las nuevas tecnologías sean desarrolladas y la capacidad de

computación se incremente en órdenes de magnitud. Sin embargo, antes que ésto, será

necesario encontrar qué se quiere computar. Hay, al menos, una nueva dimensión de

computación que ha sido muy difícil de alcanzar con los ordenadores digitales [Kohonen 88c].

1.1.- PANORAMA HISTÓRICO

Conseguir diseñar y construir máquinas capaces de realizar procesos con cierta

"inteligencia" ha sido uno de los principales objetivos y preocupaciones de los científicos a lo

largo de la historia. De los intentos realizados en este sentido se ha llegado a definir las líneas

fundamentales para la obtención de máquinas inteligentes: En un principio los esfuerzos

estuvieron dirigidos a la obtención de AUTÓMATAS, en el sentido de máquinas que

realizaran, con más o menos éxito, alguna función típica de los seres humanos. Pero esto no era

más que el resultado del desarrollo técnico de la habilidad mecánica de los constructores de

I. Introducción a la computación neuronal

1.1

tales artefactos. Sin embargo, en esta misma línea se sigue investigando hoy en día con

herramientas enormemente sofisticadas y con resultados realmente sorprendentes: la

habilidad mecánica ha pasado a convertirse en disponibilidad microinformática (lenguajes

Lisp y Prolog, sistemas expertos, etc.), de forma que, actualmente, existen diversas maneras de

realizar procesos similares a los inteligentes y que podemos encuadrar dentro de la

denominada INTELIGENCIA ARTIFICIAL (IA).

Sin embargo, a pesar de disponer de herramientas y de lenguajes de programación

diseñados expresamente para el desarrollo de "máquinas inteligentes", existe un problema de

fondo que limita enormemente los resultados que se pueden obtener: estas "máquinas" se

implementan sobre ordenadores basados en la filosofía de funcionamiento expuesta

inicialmente por Von Neumann, y se apoyan en una descripción secuencial del proceso de

tratamiento de la información. El elevado nivel y desarrollo de éstos ordenadores por

espectacular y complejo que haya llegado a ser, no deja de seguir la línea antes expuesta: una

máquina puramente mecánica que es capaz de realizar tareas mecánicas (de cálculo,

ordenación o control) de forma increíblemente rápida, pero incapaz de obtener resultados

aceptables cuando se trata de tareas sencillas, por ejemplo, para un ser humano de corta edad

(reconocimiento de formas, habla, etc.).

La otra línea de investigación ha tratado, desde los orígenes de la humanidad, de

aplicar los principios físicos que rigen en la naturaleza para obtener máquinas que realizaran

los trabajos pesados en nuestro lugar. Así, por ejemplo, los motores de vapor o explosión,

emplean un determinado tipo de combustión para obtener la energía que necesitan, al igual

que lo hacen los seres vivos. De igual manera se puede pensar respecto a la forma y capacidad

de razonamiento del ser humano; se puede intentar obtener máquinas con esta capacidad

basadas en el mismo principio de funcionamiento (o en algo que tenga una cierta similitud con

dicho principio).

No se trata de construir máquinas que compitan con los seres humanos, sino que

realicen ciertas tareas de "rango intelectual" con que ayudarle, lo que supone un principio

básico de la inteligencia artificial. Por otro lado, los sistemas que se lleguen a desarrollar no

van a suponer la desaparición de los ordenadores, tal como hoy los entendemos, por lo menos

en aquellas tareas en las que están mejor dotados incluso que los seres humanos.

Las primeras explicaciones teóricas sobre el cerebro y el pensamiento ya fueron dadas

por algunos antiguos filósofos griegos como Platón (427-347 a.C.) y Aristóteles (384-422 a.C.).

Las mismas ideas sobre el proceso mental también las mantuvo Descartes (1596-1650) y los

filósofos empiristas del siglo XVIII.

La clase de las llamadas máquinas cibernéticas, a la cual la computación neuronal

pertenece, tiene más historia de lo que generalmente se cree: Heron el Alejandrino construyó

un autómata hidráulico sobre el 100 a.C. Además, se han construido numerosos modelos de

animales para demostrar el comportamiento necesidad-adaptación sobre diferentes

condiciones de vida como, por ejemplo, las numerosas versiones del "ratón en el laberinto"

[Nemes 69].

Alan Turing, en 1936, fue el primero en estudiar el cerebro como una forma de ver el

mundo de la computación; sin embargo, los primeros teóricos que concibieron los

fundamentos de la computación neuronal fueron Warren McCulloch, un neurofisiólogo, y

Walter Pitts, un matemático, quienes, en 1943, lanzaron una teoría acerca de la forma de

trabajar de las neuronas [McCulloch 43]. Ellos modelaron una red neuronal simple mediante

circuitos eléctricos. Otro importante libro en los inicios de la teoría de redes neuronales fue el

I. Introducción a la computación neuronal

1.1

escrito en 1949 por Donald Hebb: La organización del comportamiento, en el que se establece una

conexión entre psicología y fisiología [Hebb 49].

En 1957, Frank Rosenblatt comenzó el desarrollo del Perceptrón, un modelo de red

neuronal del cual hablaremos más adelante. El perceptrón es la más antigua red neuronal y se

usa hoy en día de varias formas para la aplicación como reconocedor de patrones; este modelo

era capaz de generalizar, es decir, después de haber aprendido una serie de patrones era capaz

de reconocer otros similares aunque no se le hubieran presentado anteriormente. Sin embargo,

tenía una serie de limitaciones, quizá la más conocida era su incapacidad para resolver el

problema de la función OR-exclusiva y, en general, no era capaz de clasificar clases no

separables linealmente [Rosenblatt 58].

En 1959, Bernard Widrow y Marcial Hoff, de Stanford, desarrollaron el modelo

ADALINE (ADAptative LINear Elements). Esta fue la primera red neuronal aplicada a un

problema real (filtros adaptativos para eliminar ecos en las líneas telefónicas) y se ha usado

comercialmente durante varias décadas [Widrow 60].

Uno de los mayores investigadores de las redes neuronales desde los años 60 hasta

nuestros días es Stephen Grossberg (Universidad de Boston). A partir de su extenso

conocimiento fisiológico, ha escrito numeros libros y desarrollado modelos de redes

neuronales. Estudió los mecanismos de la percepción y la memoria. Grossberg realizó en 1967

una red, Avalancha, que consistía en elementos discretos con actividad que varía con el tiempo

que satisface ecuaciones diferenciales continuas, para resolver actividades tales como

reconocimiento continuo del habla y aprendizaje del movimiento de los brazos de un robot

[Grossberg 82].

En 1969 surgieron numerosas críticas que frenaron, hasta 1982, el crecimiento que

estaban experimentando las investigaciones sobre redes neuronales. Marvin Minsky y

Seymour Papert, del Instituto Tecnológico de Massachusetts (MIT) publicaron un libro:

Perceptrons [Minsky 69], que, además de contener un análisis matemático detallado del

perceptrón, consideraban que la extensión a perceptrones multinivel (el perceptrón original

solo poseía una capa) era completamente estéril. Las limitaciones del perceptrón eran

importantes, sobre todo, su incapacidad para resolver muchos problemas interesantes. Muchas

de las investigaciones dieron un giro hacia la Inteligencia Artificial, que prometía más por

aquel entonces.

A pesar del libro Perceptrons, algunos investigadores continuaron su trabajo. Tal fue el

caso de James Anderson que desarrolló un modelo lineal llamado Asociador Lineal que

consistía en unos elementos integradores lineales (neuronas) que sumaban sus entradas. Este

modelo se basa en el principio de que las conexiones entre neuronas son reforzadas cada vez

que están activadas. Anderson diseñó una potente extensión del Asociador Lineal llamado

"Brain-State-in-a-Box" (BSB) [Anderson 77].

En Europa y Japón las investigaciones también continuaron. Kunihiko Fukushima

desarrolló el Neocognitrón, un modelo de red neuronal para el reconocimiento de patrones

visuales [Fukushima 80]. Teuvo Kohonen, un ingeniero eléctronico de la universidad de

Helsinki, desarrolló un modelo similar al de Anderson pero independientemente [Kohonen

77].

En 1982, numerosos eventos coincidieron que hicieron resurgir el interés por las redes

neuronales. John Hopfield presentó su trabajo sobre redes neuronales en la Academia

Nacional de las Ciencias [Hopfield 82]. En el trabajo describe con claridad y rigor matemático

I. Introducción a la computación neuronal

1.1

una red a la que ha dado su nombre, que es una variación del Asociador Lineal, pero además

mostró como tales redes pueden trabajar y qué pueden hacer. Además, en 1982 se celebró la

U.S.-Japan Joint Conference on Cooperative/Competitive Neural Networks y Fujitsu comenzó el

desarrollo en "computadores pensantes" para aplicaciones en robótica.

En 1985, el Instituto Americano de Física comenzó lo que ha sido la reunión anual

Neural Networks for Computing. Esta ha sido la primera de muchas otras. En 1987, el IEEE

celebró la primera conferencia internacional sobre redes neuronales con más de 1.800 asistentes

y 19 nuevos productos mostrados. En el mismo año se formó la Internatonal Neural Network

Society (INNS) bajo la iniciativa y dirección de Grossberg en U.S.A., Kohonen en Finlandia y

Amari en Japón; en menos de dos años, la INNS tenía más de 3.000 socios. A partir de este

momento, el interés por este área de la I+D se ha ido incrementando de forma notable, como lo

demuestran tanto el número de congresos y reuniones científicas especializadas, como la

aparición de revistas científicas de calidad contrastada dentro del área, así como el interés

demostrado por diversos tipos de empresas en utilizar esta tecnología para desarrollar

aplicaciones concretas.

En 1988, del espíritu de cooperación en esta nueva tecnología resultó la unión del IEEE

y de la INNS; la International Joint Conference on Neural Networks (IJCNN) produjo, en 1989,

430 artículos, 63 de los cuales enfocados a una aplicación. La IJCNN de Enero de 1990, en

Washington, incluyó una hora de concierto de música realizada por redes neuronales. La

alternativa europea es la International Conference on Artificial Neural Networks (ICANN),

que comenzó su andadura en Septiembre de 1991 y, actualmente, está organizada por la

Sociedad Europea de Redes Neuronales. También merece una referencia aparte la reunión

anual Neural Information Processing Systems (NIPS) celebrada en Denver (Colorado) desde

1987 y que probablemente represente el nivel más alto de calidad desde el punto de vista

científico.

Estado actual de la tecnología [Sigüenza 93]

Actualmente, son numerosos los trabajos que se realizan y publican cada año, las

aplicaciones nuevas que surgen así como las empresas que lanzan al mercado productos

nuevos tanto hardware como software (sobre todo para simulación). En relación con la

información que se publica en las revistas especializadas en el área de redes neuronales cabe

destacar como las más interesantes: Neural Networks, revista oficial de la Sociedad Internacional

de Redes Neuronales (INNS); Network, Computation in Neural System; IEEE Transactions on

Neural Networks, publicada por IEEE Neural Networks Council; Neural Computation; e International

Journal of Neural Systems.

Como ejemplo del resurgir de la investigación sobre redes neuronales podemos

destacar la labor patrocinada por la Oficina de Tecnología Táctica de la Agencia de Proyectos

de Investigación Avanzada del Departamento de Defensa de los Estados Unidos

(DARPA/TTO) y llevada a cabo en el Instituto Tecnológico de Massachussets (MIT) de octubre

de 1987 a febrero de 1988. El resultado de dicho estudio apareció en el libro Neural Network

Study [DARPA 88], el cuál constituye una revisión del estado del arte de la tecnología de redes

neuronales hasta febrero de 1988 así como sus posibles aplicaciones al área de defensa y otras

áreas tales como clasificación de patrones, robótica (especialmente control de trayectorias),

visión artificial, procesamiento de señales y aplicaciones al habla.

Dentro del entorno europeo señalar las dos citas anuales de la Sociedad Europea de

Redes Neuronales (ENNS) y, como fuente de planificación política de investigación (por medio

de la financiación selectiva de proyectos de investigación), el programa ESPRIT que, durante

I. Introducción a la computación neuronal

1.1

los últimos años ha financiado una veintena de proyectos que podrían enmarcarse dentro del

área de las redes neuronales y sus aplicaciones. La participación española en estos proyectos

ha sido reducida, quedando limitada a las Universidades Politécnica y Autónoma de Madrid,

Universidad Politécnica del País Vasco, Centro de Estudios Avanzados de Blanes, Instituto de

Cibernética del CSIC, Instituto de Ingeniería del Conocimiento (IIC) y a la empresa Software

de Base, S.A.

Respecto a la situación del mercado de redes neuronales, en la figura 1.1 se muestra

como estaba repartido el mercado de las redes neuronales en el año 1989 y cúales son las

previsiones de evolución de dicho mercado.

Figura 1.1 El mercado de las redes neuronales [Sigüenza 93].

I. Introducción a la computación neuronal

1.1

1.2.- DEFINICIÓN DE RED NEURONAL.

Existen numerosas formas de definir lo que son las redes neuronales; desde las

definiciones cortas y genéricas hasta las que intentan explicar más detalladamente lo que

significa "red neuronal" o "computación neuronal". Veamos algunos ejemplos de ambos casos:

Una nueva forma de computación, inspirada en modelos biológicos.

niveles.

Un modelo matemático compuesto por un gran número de elementos procesales organizados en

"... un sistema de computación hecho por un gran número de elementos simples, elementos de

proceso altamente interconectados, los cuales procesan información por medio de su estado dinámico

como respuesta a entradas externas." [Hecht-Niesen 88a].

"Redes neuronales artificiales son redes interconectadas masivamente en paralelo de elementos

simples (usualmente adaptativos) y con organización jerárquica, las cuales intentan interactuar con los

objetos del mundo real del mismo modo que lo hace el sistema nervioso biológico". [Kohonen 88c].

Es necesario destacar que tales "computadores neuronales" no ejecutan las

típicas instrucciones máquina de los computadores digitales, a menos que estén hechos para

emular el comportamiento de las redes neuronales físicas. En principio, la operación de

proceso básico realizada por todos los procesadores elementales es una operación análoga de

transformación de sus señales de entrada.

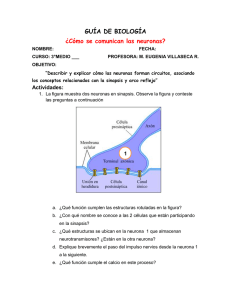

En las redes neuronales biológicas, las células neuronales (neuronas) corresponden a

los elementos de proceso anteriores. Las interconexiones se realizan por medio de las ramas de

salida (axones) que producen un número variable de conexiones (sinapsis) con otras neuronas

(o quizá con otras partes como músculos y glándulas). Las redes neuronales son sistemas de

simples elementos de proceso fuertemente interconectados.

La compleja operación de las redes neuronales es el resultado de abundantes lazos de

realimentación junto con "no linealidades" de los elementos de proceso y cambios adaptativos

de sus parámetros, que pueden definir incluso fenómenos dinámicos muy complicados.

Una peculiaridad de las redes neuronales biológicas es su tamaño: en todo el sistema

nervioso central hay del orden de 1011 neuronas, pero el número de interconexiones es aun

mayor, probablemente sobre las 1015. No parece posible programar las funciones de dicho

sistema de acuerdo con un plan principal, además teniendo en cuenta que el tamaño y la

estructura de la red está cambiando radicalmente durante y después de la niñez, cuando está

ya en uso.

Es verdad que ciertos caracteres textuales de la red son inherentes y durante la

ontogénesis las proyecciones neuronales crecen aproximadamente hacia aquellos lugares en

los cuales serán necesitados más tarde. En otras palabras, la distribución de los recursos y los

caminos de comunicación más importantes, están formados de acuerdo con un plan genético,

mientras que el resto del "programming" en especial la memoria, debe ser adquirida después

de nacer.

Programar tal red puede significar sólo dos cosas: a) Las estructuras de interconexión

entre las células son alteradas, y b) Las "fuerzas" de estas interconexiones son cambiadas.

I. Introducción a la computación neuronal

1.1

Parece que existen bastantes estrategias claras de como cambiar las fuerzas en la dirección

correcta, mientras que cambios en las interconexiones son más difíciles de definir porque

suelen tener efectos radicales en el comportamiento de la red, especialmente en lo concerniente

a la operación secuencial y las funciones jerárquicas.

Es muy difícil imaginar cómo una red tan enorme puede ser programada. Una

posibilidad, con relación a los subsistemas sensoriales podría ser que la estructura del sistema,

o el proceso dinámico definido por él, de alguna forma tiende a imaginar las experiencias

sensoriales de otros acontecimientos.

Otra función importante del sistema nervioso es definir acciones que son parte del

comportamiento, y controlar el estado del organismo en relación con su entorno.

Mientras que las representaciones internas en las cuales está basado el comportamiento

pueden ser derivadas de las entradas de forma bastante directa, las definiciones de las salidas

deben ser basadas en estrategias completamente diferentes. De hecho, apenas existe otra

posibilidad para programar las acciones que aplicar el principio de "retroceso y empuje" para

alterar los mecanismos que son responsables de ellas. Algún tipo de "backpropagation" de la

información es, por tanto, necesario.

Por otro lado, el significado y la calidad de las acciones deben ser juzgados no desde

los movimientos inmediatos, sino desde la realización de criterios que tienen en cuenta el

resultado requerido, a veces bastante indirectamente. A menudo, las acciones son solamente

corregidas si se realizan con cierta frecuencia, donde el mecanismo que lo provoque debe

contener circuitos que definan tales frecuencias y que se cambien en relación con los resultados

aprendidos. Está claro que programar las acciones es un proceso mucho más indirecto que

programar las representaciones internas; el factor aleatorio no puede ser evitado.

Programando las funciones de entrada y de salida nos lleva sólo a una operación de

comportamiento en la que el estímulo y la respuesta son consideradas muy relevantes.

Ciertamente es posible realizar autómatas bastante complejos y comportamientos "necesidadconducta" de este modo. Sin embargo, se mantiene la expectativa sobre la posibilidad de que

las redes neuronales puedan actuar como ordenadores para algunos problemas abstractos y

también donde la computación se realice en el estado interno de la red.

1.3.- VENTAJAS DE LAS REDES NEURONALES.

Debido a su constitución y a sus fundamentos, las redes neuronales artificiales

presentan un gran número de características semejantes a las del cerebro. Por ejemplo, son

capaces de aprender de la experiencia, de generalizar de casos anteriores a nuevos casos, de

abstraer características esenciales a partir de entradas que representan información irrelevante,

etc. Esto hace que ofrezcan numerosas ventajas y que este tipo de tecnología se esté aplicando

en múltiples áreas. Estas ventajas incluyen [Maren 90]:

* Aprendizaje adaptativo. Capacidad de aprender a realizar tareas basada en un

entrenamiento o una experiencia inicial.

* Autoorganización. Una red neuronal puede crear su propia organización o

representación de la información que recibe mediante una etapa de aprendizaje.

* Tolerancia a fallos. La destrucción parcial de una red conduce una degradación de su

estructura, sin embargo, algunas capacidades de la red se pueden retener incluso sufriendo un

I. Introducción a la computación neuronal

1.1

gran daño.

* Operación en tiempo real. Los computadores neuronales pueden ser realizados en

paralelo y máquinas con especial hardware se diseñan y fabrican para obtener esta capacidad.

* Fácil inserción dentro de la tecnología existente. Se pueden obtener chips especializados

para redes neuronales que mejoran su capacidad en ciertas tareas. Ello facilitará la integración

modular en los sistemas existentes.

1.3.1.- Aprendizaje adaptativo.

La capacidad de aprendizaje adaptativo es una de las características más atractivas de

las redes neuronales. Esto es, aprenden a llevar a cabo ciertas tareas mediante un

entrenamiento con ejemplos ilustrativos. Como las redes neuronales pueden aprender a

diferenciar patrones mediante ejemplos y entrenamiento, no es necesario que elaboremos

modelos a priori ni necesitamos especificar funciones de distribución de probabilidad.

Las redes neuronales son sistemas dinámicos autoadaptativos. Son adaptables debido a

la capacidad de autoajustarse de los elementos procesales (neuronas) que componen el

sistema. Son dinámicos pues son capaces de estar constantemente cambiando para adaptarse a

las nuevas condiciones.

En el proceso de aprendizaje, los enlaces ponderados de las neuronas, se ajustan de

manera que se obtengan unos resultados específicos. Una red neuronal no necesita un

algoritmo para resolver un problema, ya que ella puede generar su propia distribución de los

pesos de los enlaces mediante el aprendizaje. También existen redes que continúan

aprendiendo a lo largo de su vida después de completado el período inicial de entrenamiento

La función del diseñador es únicamente la obtención de la arquitectura apropiada. No

es problema del diseñador el cómo la red aprenderá a discriminar; sin embargo, si es necesario

que desarrolle un buen algoritmo de aprendizaje que proporcionará la capacidad de discriminar

de la red mediante un entrenamiento con patrones.

1.3.2.- Autoorganización.

Las redes neuronales usan su capacidad de aprendizaje adaptativo para

autoorganizarse la información que reciben durante el aprendizaje y/o la operación. Mientras

que el aprendizaje es la modificación de cada elemento procesal, la autoorganización consiste

en la modificación de la red neuronal completa para llevar a cabo un objetivo específico.

Cuando las redes neuronales se usan para reconocer ciertas clases de patrones, ellas se

autoorganizan la información usada. Por ejemplo, la red llamada back-propagation se creará su

propia representación característica mediante la cual puede reconocer ciertos patrones.

Esta autoorganización provoca la generalización: facultad de las redes neuronales de

responder apropiadamente cuando se les presenta datos o situaciones a los que no habían sido

expuestas anteriormente. El sistema puede generalizar la entrada para obtener una respuesta.

Esta característica es muy importante cuando se tienen que solucionar problemas en los cuales

la información de entrada es poco clara; además, permite que el sistema de una solución

incluso cuando la información de entrada está especificada de forma incompleta.

I. Introducción a la computación neuronal

1.1

1.3.3.- Tolerancia a fallos.

Las redes neuronales son los primeros métodos computacionales con la capacidad

inherente de tolerancia a fallos. Comparados con los sistemas computacionales tradicionales,

los cuáles pierden su funcionalidad en cuanto sufren un pequeño error de memoria, en las

redes neuronales, si se produce un fallo en un pequeño número de neuronas, aunque el

comportamiento del sistema se ve influenciado, sin embargo, no sufre una caída repentina.

Hay dos aspectos distintos respecto a la tolerancia a fallos: primero, las redes pueden

aprender a reconocer patrones con ruido, distorsionados o incompletos, esta es una tolerancia

a fallos respecto a los datos. Segundo, ellas pueden seguir realizando su función (con cierta

degradación) aunque se destruya parte de la red.

La razón por la que las redes neuronales son tolerantes a los fallos es el que tienen su

información distribuida en las conexiones entre neuronas, existiendo un cierto grado de

redundancia en este tipo de almacenamiento. La mayoría de los ordenadores algorítmicos y

sistemas de recuperación de datos, almacenan cada pieza de información en un espacio único,

localizado y direccionable. Las redes neuronales almacenan información no localizada. Por

tanto, la mayoría de las interconexiones entre los nodos de la red tendrán unos valores en

función de los estímulos recibidos y se generará un patrón de salida que represente la

información almacenada.

1.3.4.- Operación en tiempo real.

Una de las mayores prioridades de la mayoría de las áreas de aplicación es la

necesidad de realizar grandes procesos con datos de forma muy rápida. Las redes neuronales

se adaptan bien a esto debido a su implementación paralela. Para que la mayoría de las redes

puedan operan en un entorno de tiempo real, la necesidad de cambio en los pesos de las

conexiones o entrenamiento es mínima. Por tanto, de todos los métodos posibles, las redes

neuronales son la mejor alternativa para reconocimiento y clasificación de patrones en tiempo

real.

1.3.5.- Fácil inserción dentro de la tecnología existente.

Una red individual puede ser entrenada para desarrollar una única y bien definida

tarea (tareas complejas, que hagan múltiples selecciones de patrones, requerirán sistemas de

redes interconectadas). Debido a que una red puede ser rápidamente entrenada, testeada,

verificada y trasladada a una implementación hardware de bajo coste, es fácil insertar redes

neuronales para aplicaciones específicas dentro de sistemas existentes. De esta manera, las

redes neuronales se pueden utilizar para mejorar sistemas de forma incremental, y cada paso

puede ser evaluado antes de acometer un desarrollo más amplio.

1.4.- REDES NEURONALES Y COMPUTADORES DIGITALES

Para entender el potencial real de la computación neuronal, será necesario hacer una

clara distinción entre sistemas de computación neuronales y digitales:

I. Introducción a la computación neuronal

1.1

Los sistemas neurológicos biológicos no aplican principios de circuitos lógicos o digitales.

Un sistema de computación digital debe ser síncrono o asíncrono. Si fuera asíncrono, la

duración de los impulsos neuronales debería ser variables para mantener uno de los valores

binarios por períodos de tiempo indefinidos, lo cual no es el caso. Si el principio fuera

síncrono, se necesitaría un reloj global al cual los pulsos estén sincronizados. Este tampoco es

el caso. Las neuronas no pueden ser circuitos de umbral lógico porque hay miles de entradas

variables en la mayoría de las neuronas y el umbral es variable con el tiempo, siendo afectado

por la estimulación, atenuación, etc. La precisión y estabilidad de tales circuitos no es suficiente

para definir ninguna función "booleana". Los procesos colectivos que son importantes en

computación neuronal no pueden implementarse por computación digital. Por todo ello, el

cerebro debe ser un computador analógico.

Ni las neuronas ni la sinapsis son elementos de memoria biestables.

Todos los hechos fisiológicos hablan a favor de las acciones de las neuronas como

integradores analógicos, y la eficiencia de la sinapsis cambia de forma gradual.

En la computación neuronal no hay instrucciones máquina ni códigos de control.

Debido a los problemas de estabilidad discutidos anteriormente, el formato de estos

códigos no puede ser mantenido por períodos significativos de tiempo, en particular, durante

el período de crecimiento.

Los circuitos del cerebro no implementan computación recursiva y, por tanto, no son

algorítmicos.

Debido a los problemas de estabilidad, los circuitos neuronales no son suficientemente

estables para definiciones recursivas de funciones como en computación digital. Un algoritmo,

por definición, define una función recursiva.

Incluso en el nivel más alto, la naturaleza del proceso de información es diferente en el cerebro y

en los computadores digitales.

Para emular una con otra, al menos a cierto nivel de abstracción, los estados internos de

dos sistemas de computación deben ser igualmente accesibles. Esta equivalencia no existe

entre el cerebro y los sistemas de programación. Las computadoras artificiales no pueden

adquirir ni interpretar todas las experiencias humanas en las cuales se basa el asentamiento de

valores.

1.5.- REDES NEURONALES E INTELIGENCIA ARTIFICIAL

Dentro de lo que se entiende por Inteligencia Artificial (I.A.), una de las ramas más

prometedoras es la que corresponde a las denominadas redes de autoproceso, entendiendo

como tales aquellas formadas por nodos en los que hay elementos procesadores de información de cuyas

interacciones locales depende el comportamiento del conjunto del sistema.

I. Introducción a la computación neuronal

1.1

Figura 1.2 Situación de las redes neuronales en el campo de la Inteligencia Artificial [López

89].

Como indica la figura 1.2, dentro del campo de la inteligencia artificial, existen dos

grandes ramas de las redes de autoproceso:

a) Procesamiento numérico: Reciben directamente la señal de entrada desde el exterior

y operan sobre ella. Esta rama se dedica a los sistemas constituidos por nodos hardware

interconectados entre sí formando una red. También se les suele llamar sistemas conectivistas o

conexionistas.

Si la conexión entre los nodos se realiza de forma global bajo unas reglas de

composición, estamos ante los llamados Sistemas Distribuidos, mientras que si la conexión se

realiza agrupando en subredes, se denominan Sistemas Asociativos o "Redes de Redes".

Dentro de los sistemas distribuidos, si realizamos agrupaciones locales de los nodos

para representar conceptos, estaríamos ante las denominadas Redes Subsimbólicas; mientras

que si lo que realiza es una distribución en la que cada nodo funciona corporativamente, se

denomina Red Neuronal o Neurocomputador (cada nodo está constituido por una neurona).

b) Procesamiento simbólico: estas redes están constituidas por "conceptos" (NODOS

de la red) y por "reglas sintácticas" (lazos de INTERCONEXION); ambas forman las

denominadas bases de conocimiento. La simulación de estas redes es casi exclusivamente

software.

Como se vio en la panorámica histórica de la evolución de las redes neuronales,

durante toda la década de los 70, hasta el resurgimiento con los trabajos de Hopfield, decayó el

I. Introducción a la computación neuronal

1.1

estudio de las redes neuronales y las investigaciones se orientaron al campo de la I.A., gracias a

lo cual, se ha desarrollado una extensa teoría y unas aplicaciones que tienen una gran

importancia actualmente.

Por otro lado, esto no quiere decir que las teorías de redes neuronales y de I.A. estén

separadas; de hecho, ya se ha visto cómo se pueden situar e interconectar la teoría de las redes

neuronales dentro del campo de la I.A. Sin embargo, existen unas diferencias de las redes

neuronales con respecto a lo que se entiende como inteligencia artificial clásica muy relevantes

y que destacamos a continuación:

* Representación del Conocimiento:

En I.A. se utilizan métodos de representación del conocimiento (Reglas de Producción,

marcos, esquemas, reglas semánticas, etc.) generalmente localizados: átomos de conocimiento,

concepto asociado a una regla, etc. Esto hace que la gestión de las bases de conocimiento sea

problemática: añadir una regla o suprimir un dato puede tener consecuencias imprevisibles

sobre los demás datos.

Actualmente se piensa que los conocimientos se representan de forma distribuida en el

cerebro: la "memoria" de un hecho corresponderá a la activación de una familia específica de

neuronas. De esto se pueden deducir algunas consecuencias:

a) La red puede crear su propia organización de la información.

b) Como se dispone de un número finito de neuronas, varios hechos se memorizan por

la activación de clases de neuronas no disjuntas.

c) Mejor tolerancia a fallos, la pérdida de neuronas no implica que se deje de recordar,

por tanto, debe existir información redundante.

* Mecanismos de Inferencia:

Los mecanismos de inferencia (razonamiento) utilizados en I.A. están basados en la

lógica (lenguaje PROLOG, por ejemplo).

Sin embargo, el cerebro humano no realiza un razonamiento necesariamente lógico;

utiliza la imprecisión y la contradicción parcial. El modo de funcionamiento del cerebro es la

evolución dinámica de las actividades neuronales.

* Aprendizaje:

El aprendizaje en I.A. consiste simplemente en añadir nuevos átomos de conocimiento

(nuevos hechos, reglas, etc.).

En el cerebro, el aprendizaje de un hecho parecido a otro del que ya tenemos

conocimiento, se hace por refuerzo de las conexiones entre neuronas y esta actividad conjunta

es necesaria para memorizarlo. Se ha demostrado que si un sujeto no está expuesto a ciertos

estímulos al comienzo de su vida, no podrá detectar más estos estímulos debido a la

degeneración de las conexiones necesarias.

* Paralelismo:

I. Introducción a la computación neuronal

1.1

Es una característica innata de los sistemas conexionistas. Aunque un ordenador

realiza cálculos mucho más deprisa que un ser humano, no es capaz de desarrollar procesos

que éste realiza de forma sencilla (comprensión de una frase, analizar una imagen, reconocer

un rostro, movimiento en un espacio determinado, etc.). Esto es debido a que el cerebro

humano, para hacerlo, pone en marcha simultáneamente a millones de neuronas.

Para terminar de situar la teoría de redes neuronales dentro del mundo de la

"computación" en general, y frente a la I.A. en particular, en la tabla 1.1 se resume y sintetiza

parte de las ideas vistas hasta ahora acerca de las redes neuronales y las diferencias existentes

respecto a la computación "convencional" (máquinas tipo Von Neumann) y a la computación

"simbólica" (I.A.). Se muestran las diferencias en función de la teorías en las que se basan; en

los campos para las que son y no son apropiadas, el tipo de memoria que utilizan, cómo se

construyen y qué tipo de soporte utilizan.

Computación

"Convencional"

Computación

"Simbólica"

Computación

"Neuronal"

Basado en:

Arquitectura Von

Neumann

Lógica Cognitiva

Neurobiología

Apropiada para:

Algoritmos conocidos

Heurística

Adaptación

Pero no para:

Condiciones "difusas"

Causalidad desconocida

Cálculos precisos

Memoria:

Precisa,

estática

Bases de conocimiento

Distribuida

Construida mediante:

Diseño, programación y

prueba

Representación del

conocimiento + motor de

inferencia

Configuración

y

"aprendizaje"

Soporte:

Ordenadores

secuenciales

Máquinas

LISP

Procesadores paralelos

Tabla 1.1. Formas básicas de computación [Rubio 90].

I. Introducción a la computación neuronal

1.1

1.6.- APLICACIONES DE LAS REDES NEURONALES.

Las redes neuronales son una tecnología computacional emergente que puede utilizarse en un

gran número y variedad de aplicaciones tanto comerciales como militares. Se pueden desarrollar redes

neuronales en un período de tiempo razonable y pueden realizar tareas concretas mejor que otras

tecnologías convencionales, incluyendo los sistemas expertos. Cuando se implementan mediante

hardware (redes neuronales en chips VLSI), presentan una alta tolerancia a fallos del sistema y

proporcionan un grado de paralelismo en el proceso de datos muy grande. Eso hará posible insertar redes

neuronales de bajo coste en sistemas existentes y recientemente desarrollados.

Hay muchos tipos diferentes de redes neuronales, cada uno de los cuáles tiene una aplicación

particular más apropiada. Empezaremos relacionando ejemplos de algunas aplicaciones comerciales

separándolas en grupos según las distintas disciplinas:

Biología

Aprender más acerca del cerebro y otros sistemas.

Obtención de modelos de la retina.

Empresa

Evaluación de probabilidad de formaciones geológicas y petrolíferas.

Identificación de candidatos para posiciones específicas.

Explotación de bases de datos.

Optimización de plazas y horarios en líneas de vuelo.

Reconocimiento de caracteres escritos.

Medio Ambiente

Analizar tendencias y patrones.

Previsión del tiempo.

Financias

Previsión de la evolución de los precios.

Valoración del riesgo de los créditos.

Identificación de falsificaciones.

Interpretación de firmas.

Manufacturación

Robots automatizados y sistemas de control (visión artificial y sensores de presión, temperatura,

gas, etc.)

Control de producción en líneas de proceso.

Inspección de la calidad.

Medicina

Analizadores del habla para la ayuda de audición de sordos profundos.

Diagnóstico y tratamiento a partir de síntomas y/o de datos analíticos (Electrocardiograma,

encefalograma, análisis saguíneo, etc.).

I. Introducción a la computación neuronal

1.1

Monitorización en cirugía.

Predicción de reacciones adversas a los medicamentos.

Lectores de rayos X.

Entendimiento de la causa de los ataques epilépticos.

Militares

Clasificación de las señales de radar.

Creación de armas inteligentes.

Optimización del uso de recursos escasos.

Reconocimiento y seguimiento en el tiro al blanco.

Podemos buscar hechos comunes en esta lista de aplicaciones; la mayoría de ellas consisten en

realizar un reconocimiento de patrones: buscar un patrón en una serie de ejemplos, clasificar patrones,

completar una señal a partir de valores parciales o reconstruir el patrón correcto partiendo de uno

distorsionado. Muchos de los ejemplos tienen que trabajar con datos sensoriales y de percepción (señales

visuales, auditivas y otras) y otros realizan filtrado o mapeo de señales de entrada. En general, los

ejemplos mostrados indican que son característicos más de las personas que de los ordenadores

convencionales.

A continuación se describe con más detalle aquellas áreas de aplicación más importantes para las

cuáles los computadores neuronales, en general, se están utilizando o pueden ser utilizados y los

problemas particulares encontrados en cada una de ellas.

1.6.1.- Reconocimiento de Patrones

El término "Reconocimiento de Patrones" originalmente se refería a la detección de formas

simples tales como caracteres escritos a mano, mapas del tiempo y espectros del lenguaje. Sin embargo,

un objetivo más ambicioso ha sido durante todo el tiempo implementar la percepción artificial, es decir,

imitar las funciones de los sistemas sensoriales biológicos en su forma más completa.

Los primeros experimentos, alrededor de 1960 estaban basados en redes neuronales elementales,

como Perceptron [Rosenblatt 58], Adaline [Widrow 60], y Matrices de Aprendizaje [Steinbuch 61].

Los primeros pasos, como siempre, fueron fáciles, pero pronto se vio que la realización de los sistemas

biológicos era muy difícil de alcanzar. Incluso, la alta capacidad de computación, alcanzable por

circuitos de computación paralela, no resolvían los problemas.

Especialmente, en el análisis de imágenes, existen requerimientos que son muy difíciles de

alcanzar: a) Invariabilidad de la detección con respecto ala traslación, rotación, escala, perspectiva,

oclusión parcial y casamiento simple de los objetos, especialmente bajo condiciones de iluminación

variables y b) relación de observaciones de varios contextos a niveles diferentes de abstracción, en orden

a distinguir los eventos más selectivamente. Destacar que los animales son capaces de prestar atención a

objetos individuales en una escena, por cada uno de los cuales la invariabilidad de percepción debe ser

válida separadamente. Esto debe mostrar que debe ser fácil con un preproceso de la escena completa por

medio de la transformada de Fourier o Mellin, por lo que habría que tenerlo en cuenta para obtener la

solución deseada.

Lo que también era ignorado es que incluso el más desarrollado sistema sensorial biológico no

opera de forma autónoma: la percepción sensorial está siempre muy unida con el proceso cognitivo

global. Para la replicación de las funciones sensoriales, no es suficiente imitar el sistema sensorial, sino

que se tiene que replicar todo el cerebro con todas sus capacidades de pensamiento, y precisar la

I. Introducción a la computación neuronal

1.1

capacidad de reconocimiento por el alto grado de aprendizaje.

No sería razonable esperar la solución de todos estos problemas antes de proceder a la obtención

de las posibles aplicaciones. En ingeniería, los problemas son generalmente simplificados. Tomemos por

ejemplo la locomoción: es difícil implementar el movimiento coordinado de los miembros, pero un

método más directo es aplicar ruedas y modificar el terreno construyendo carreteras. Igualmente existen

multitud de aplicaciones para las cuales soluciones artificiales, no naturales, pueden ser incluso más

eficaces.

El desarrollo del reconocimiento de patrones (especialmente en visión computerizada) tomó este

camino a mediados de los 60. Destacar que la agudeza espacial de la visión de los mamíferos varía por

un factor de veinte cuando se compara las áreas foveales y periféricas de la retina; además el globo del

ojo está en continuo movimiento espasmódico. Aun así, mediante una delicada reconstrucción de la

información visual, se hace posible una percepción clara y firme. Nada comparable ha sido logrado, ni

siquiera probado, en visión computerizada, donde el campo de imagen, primeramente, está separado en

un conjunto regular de elementos de pintura, los cuáles están medidos y agrupados en áreas homogéneas

(segmentadas), sus contornos son analizados y sus realizaciones topológicas y geométricas son descritas

por "gramáticas de imagen". Sin embargo, es evidente que es posible llegar a ciertos niveles de

invariabilidad con respecto a las señales de imagen, si simplemente tenemos en cuenta las relaciones

topológicas.

Estos métodos, no obstante, tienen muy poco en común con los principios de operación de las

funciones sensoriales biológicas, y , por tanto queda abierto el problema básico de la percepción en

computación neuronal. Si en la actualidad los métodos de redes neuronales artificiales se están

desarrollando para el mismo propósito, será necesario desarrollar métodos de reconocimiento de patrones

para que los circuitos aprendan por si mismos las funciones y caracteres elementales y lleguen a hacerse

auto-organizados sin utilizar ningún tipo de programación heurística.

Las áreas de aplicación más importantes del "reconocimiento de patrones neuronal" serían las

mismas que aquellas para las cuales los métodos convencionales y heurísticos han sido desarrollados

durante los pasados 30 años:

a) Sensación remota.

b) Análisis de imágenes médicas.

c) Visión en computadores industriales (especialmente para robots).

d) Elementos de proceso de las entradas para computadores.

Tareas más concretas para las cuales se han desarrollado ya equipos de computadores especiales

son:

a) Segmentación y clasificación de regiones de imágenes.

b) Reconocimiento de caracteres escritos (manuales y texto impreso).

c) Reconocimiento del habla y

d) Procesamiento y restauración de imágenes con ruido.

En un nivel más ambicioso se puede intentar lograr capacidades como:

a) Análisis de imágenes (en lo referente a diferentes niveles temáticos de abstracción, tales como

monitorización de uso terrestre en las bases de imágenes por satélite).

b) Reconocimiento de imágenes (interpretación de escenas) y

c) Reconocimiento del habla (análisis e interpretación de frases habladas).

I. Introducción a la computación neuronal

1.1

Para implementar estas tareas existen todavía ciertos problemas básicos pendientes de solución;

por ejemplo aquellos referentes a las propiedades intrínsecas de la información de entrada tales como:

a) Los patrones primitivos más naturales (líneas, sus curvaturas y puntos final, bordes,

estadísticas de grupos de puntos).

b) Información visual que describen las curvaturas de las superficies.

c) Textura e

d) Invariantes fonológicas en el habla.

Por otro lado, la integración de estas funciones en un sistema de conocimiento de alto nivel es un

objetivo cuya complejidad es de un orden de magnitud mayor de lo que generalmente se cree. Por tanto,

parecen existir multitud de aplicaciones potenciales pero todavía existen problemas no resueltos. No

parece razonable continuar el desarrollo de métodos heurísticos sofisticados: se estima que sobre 30.000

artículos y unos 200 libros de texto se han escrito ya sobre técnicas de reconocimiento de patrones y

visión artificial en los últimos 30 años y si las soluciones hubieran estado al alcance por este camino, ya

hubieran sido visibles.

1.6.2.- Bases de Datos de Conocimiento para Información Estocástica.

Una amplia capacidad de memoria y rapidez en recordar unidades relevantes de ella son

normalmente signos de inteligencia. Para formar el conocimiento es necesario almacenar en la mente un

gran número de relaciones, lo que forma la base del pensamiento y la solución de problemas. La noción

de que la mente humana opera de acuerdo a asociar principios es un muy antigua: Aristóteles publicó

algunos tratados teóricos donde estos principios ya fueron cualitativamente expuestos.

Aunque es claro que la mayoría de los objetos del mundo exterior son distintos y discretos, y sus

acontecimientos pueden ser descritos con relaciones lógicas, la información primaria obtenida de ellos en

forma de señales sensoriales es estocástica, no clara, y raramente expresable en términos de caracteres

distintivos. Si la descripción del mundo exterior pudiera hacerse verbalmente, estas relaciones podrían

expresarse fácilmente en forma concisa y discreta, pero tal operación no es posible sin un sujeto "que

piense y que entienda".

Cuando definimos los problemas de forma lógica u otros formalismos discretos (técnicas de

I.A.) es muy difícil que un sistema artificial sea capaz de formar conceptos automáticamente, atributos

distintos y otras representaciones abstractas a partir de señales sensoriales confusas, no distintivas y

estocásticas.

Veamos con más detalle en qué consiste la lógica de la búsqueda: La Información Semántica

consiste normalmente en unidades de datos y sus enlaces (relaciones, asociaciones) con otras unidades.

El Conocimiento adquirido en dicha base de datos puede ser conducido a través de largas cadenas de

dichos enlaces, los cuales se realizan cuando las asociaciones se hacen parcialmente. Posiblemente sea

ilustrativo comparar una base de datos y el proceso de búsqueda con un sistema de ecuaciones y sus

soluciones. Cuando representamos una cuestión estamos introduciendo una o varias ecuaciones que

contienen variables desconocidas. Por ejemplo, podemos especificar un número de relaciones parciales

en las cuales algunos miembros son desconocidos, el sistema tiene que encontrar en la memoria todas las

relaciones que casen con las ecuaciones en sus partes especificadas, de forma las variables desconocidas

se hagan conocidas.

Se está hablando hasta ahora de las bases de datos relacionales que son ampliamente utilizadas

actualmente. La búsqueda de información en ellas conlleva las siguientes operaciones elementales: a)

combinaciones muy rápidas en paralelo de un gran número de argumentos de búsqueda, los cuáles son

I. Introducción a la computación neuronal

1.1

los elementos almacenados en memoria y b) análisis y presentación de los resultados que satisfacen todas

las condiciones.

Para buscar soluciones a una tarea de búsqueda que es definida en términos de multitud de

preguntas incompletas y simultáneas, como suele ser el caso de este tipo de tareas, no es suficiente

implementar una memoria direccionable por contenido (autoasociativa).

En las redes neuronales, los argumentos de búsqueda están generalmente impuestos en las

condiciones iniciales de la red y la solución a las "preguntas" se obtiene cuando el estado de actividad de

la red llega a alguna clase de "mínimo de energía".

Las características de estos sistemas son las siguientes: a) sus elementos de red son elementos

analógicos, b) se pueden activar un gran número de relaciones en al memoria, las cuáles sólo se

emparejan de forma aproximada con los argumentos de búsqueda y c) no es seguro que el sistema

converja a un óptimo global, es más usual que la respuesta corresponda a uno de los óptimos locales los

cuales pueden ser una solución aceptable en la práctica.

1.6.3.- Control de Robots.

El control adaptativo en tiempo real es primordial en muchas de las aplicaciones de control de

procesos, como puede ser el guiado del movimiento de un robot. Hay dos categorías importantes de

robots: los de "trayectoria programada" y los denominados "robots inteligentes". Para programar los

primeros, lo que supone controlar sus movimientos y acciones de la forma deseada, hay que almacenar

en memoria una secuencia de coordenadas y comandos. Durante su uso se definen idénticas trayectorias

y comandos por medio de la información memorizada.

Los robots inteligentes se supone que pueden planear sus acciones. La inteligencia exhibida por

los robots ha sido ampliamente implementada por programas de I.A., lo cuál significa que las estrategias

han de ser inventadas y programadas heurísticamente por el ser humano. A menudo es deseable tener un

nivel más alto de aprendizaje en tales robots, lo que apunta al uso de los sistemas neuronales. Por

ejemplo, aprender a moverse en un entorno desconocido es una tarea que difícilmente puede ser

formalizada por programación lógica, y la coordinación de las funciones sensoriales con las funciones

motoras no puede resolverse de forma analítica. Se han realizado ya algunas simulaciones por ordenador

que han demostrado tales capacidades de aprendizaje autónomo [Barto 83].

1.6.4.- Toma de Decisiones.

En las implementaciones de I.A. convencional, las condiciones y acciones que entran en el

problema son descritas como "decisión árbol" y la evaluación es un problema de combinatoria. Sin

embargo, este no es exactamente el camino mediante el que piensa un ser natural. Éste debe realizar

análisis formales similares para evitar malas soluciones, pero cuando se llega a la estrategia formal,

entonces otras razones, basadas en presentimientos e instintos intuitivos sobre la situación, adquieren

más importancia. Estas capacidades pueden, no obstante, realizarse en sistemas de aprendizaje artificial

suficientemente grandes que operen con principios de computación neuronal. El criterio de operación

aplicado en éstos casos es más complejo y será aprendido automáticamente de ejemplos de algún tipo de

descripción estadística.

Se puede decir que las estrategias de toma de decisiones están almacenadas en la forma de las

reglas, mientras que estas reglas se establecen automáticamente, y sólo existen en forma implícita como

un estado colectivo de las interconexiones adaptativas.

I. Introducción a la computación neuronal

1.1

1.6.5.- Filtrado de señales.

Las redes neuronales se usan como filtros para la eliminación de ruidos y desórdenes en señales,

o para la reconstrucción de patrones a partir de datos parciales; por ejemplo, la red back-propagation se

usa a menudo para obtener una versión de ruido-reducido a partir de una señal de entrada y la red

MADALINE se ha usado cerca de dos décadas comercialmente para mejorar la transmisión telefónica.

1.6.6.- Segmentación, Comprensión y Fusión de Datos.

La segmentación de datos, sobre todo en señales de variación temporal (p.ej., datos sísmicos) o

en imágenes, es una tarea muy solicitada. La mayoría de los algoritmos de segmentación no

proporcionan completamente los resultados deseables. Por ejemplo, en imágenes, las líneas que limitan

las regiones están a menudo mezcladas con ruido u otras interferencias de pequeña escala. Dificultades

similares se encuentran en la segmentación de datos en el habla, retornos sísmicos y otros datos de

sensores complejos. Actualmente existen numerosas aproximaciones de redes neuronales habilitadas

para segmentación de imágenes, la mayoría de los cuáles presentan una capacidad superior en

comparación con alguno de los más complejos algoritmos de segmentación.

Por otro lado, en algunos campos como la medicina, testeo de componentes aeroespaciales y

telemetría, se producen, transmiten y almacenan enormes cantidades de datos; por lo que el costo con

elementos de almacenamiento masivo se hace prohibitivo. Se necesita dar prioridad al desarrollo de

metodologías de comprensión de datos. Para resolver este problema ya se han aplicado diferentes tipos

de redes neuronales con prometedores resultados.

1.6.7.- Interfaces Adaptativas para Sistemas Hombre/Máquina.

Las interfaces hombre/máquina están empezando a considerarse como uno de los aspectos más

importantes en la mayoría de los sistemas computacionales. Esto es especialmente cierto en aquellos

sistemas diseñados para facilitar algunos procesos humanos, tales como el aprendizaje, la manipulación

de datos o en los sistemas de control.

Recientes estudios indican cómo la carga de trabajo debe estar dividida entre la persona y el

computador. La relación hombre/máquina puede ser mejorada significativamente mediante la adaptación

de la interface al usuario. Este tipo de tareas incluye reconocimiento y control de patrones multiescala.

Las redes neuronales proporcionan la tecnología ideal para facilitar la relación entre el usuario y sistemas

complejos.

I. Introducción a la computación neuronal

1.1

1.7.- TIPOS DE REDES NEURONALES MÁS IMPORTANTES.

En capítulos posteriores estudiaremos en profundidad algunos modelos de redes neuronales que,

por su importancia histórica y su gran difusión, se han considerado de interés general. Sin embargo, a

continuación, se muestra una tabla resumen de los tipos de red más conocidos, comentando

esquemáticamente las aplicaciones más importantes de cada una, sus ventajas e inconvenientes y quién o

quienes fueron sus creadores y en qué año.

I. Introducción a la computación neuronal

Nombre de la red

Año

Aplicaciones más

Comentarios

1.1

Limitaciones

importantes

Avalancha

1967

desarrollada por

Reconocimiento de

Ninguna red sencilla

No es fácil alterar la

Stephen

habla continua. Control

puede hacer todo esto.

velocidad o interpolar el

Grossberg.

brazos robot.

movimiento.

Reconocimiento de

Sofisticada.

Sensible a la translación,

Gail Carpenter,

Resonancia

patrones (radar, sonar,

Poco utilizada.

distorsión y escala.

Stephen

Adaptativa

etc.).

Teoría

1986

Inventada/

Grossberg.

(ART)

ADALINE/

1960

MADALINE

Filtrado de señales.

Rápida, fácil de

Sólo es posible clasificar

Ecualizador adaptativo.

implementar con

espacios linealmente

Modems.

circuitos analógicos o

separados.

Bernand Widrow.

VLSI.

Back

1974-85

propagation.

Red más popular.

Necesita mucho tiempo

Paul Werbos,

texto. Control de

Numerosas

para el aprendizaje y

David Parker,

robots. Predicción.

aplicaciones con

muchos ejemplos .

David Rumelhart.

Reconocimiento de

éxito. Facilidad de

patrones.

aprendizaje. Potente.

Bart Kosko.

Memoria

Aprendizaje y

Baja capacidad de

Asociativa

heteroasociativa de

arquitectura simples.

almacenamiento. Los

Bidireccional

acceso por contenido.

Memoria

1985

Síntesis de voz desde

datos deben ser

codificados.

Reconocimiento de

Redes simples.

La máquina de Boltmann

Jeffrey Hinton,

Boltzmann y

patrones (imágenes,

Capacidad de

necesita un tiempo muy

Terry Sejnowski,

Cauchy

sonar y radar).

representación óptima

largo de aprendizaje.

Harold Szu.

Optimización.

de patrones.

Extracción de

Posiblemente mejor

Realización y potenciales

James Anderson

conocimiento de bases

realización que las

aplicaciones no

de datos

redes de Hopfield

estudiadas totalmente

Control del

Semejante a

Requiere complicadas

David Marr,

movimiento de los

Avalancha.

entradas de control

James Albus,

Máquinas de

Brain-Estate-in-a-

1985-86

1977

Box.

Cerebellatron

1969

brazos de un robot.

Counter-

1986

propagation

Hopfield

Neocognitron

Perceptron

1982

1978-84

1957

Comprensión de

Combinación de

Numerosas neuronas y

Robert Hecht-

imágenes;

Perceptron y TPM

conexiones

Nielsen

Reconstrucción de

Puede implementarse

Capacidad y estabilidad.

John Hopfield

patrones y

en VLSI. Fácil de

optimización.

conceptualizar

Reconocimineto de

Insensible a la

Requiere muchos

K. Fukushima

caracteres manuscritos

translación , rotación

elementos de proceso,

y escala

niveles y conexiones

Reconocimiento de

La red más antigua.

No puede reconocer

carácteres impresos

Construida en HW.

caracteres complejos

Reconocimiento de

Realiza mapas de

Requiere mucho

Map (SOM).

patrones, codificación

características

entrenamiento

Topology-

de datos; optimización

comunes de los datos

Self-Organizing-

Preserving-Map

1980-84

Andres Pellionez

aprendidos.

Frank Rosenblatt

Teuvo Kohonen

I. Introducción a la computación neuronal

Nombre de la red

Año

Aplicaciones más

Comentarios

1.1

Limitaciones

importantes

Inventada/

desarrollada por

(TPM).

Tabla 1.2. Características de los tipos de redes neuronales más importantes (Adaptada de [Hecht-Nielsen 88a]).

1.8.- IMPLEMENTACIÓN DE LAS REDES NEURONALES.

En la búsqueda de sistemas inteligentes en general, se ha llegado a un importante

desarrollo del software (en la actualidad ya existen lenguajes de procesamiento simbólico de la

información), sin embargo, generalmente estos lenguajes se apoyan en arquitecturas

convencionales de ordenadores.

Actualmente, las direcciones de investigación consisten

en la búsqueda de nuevas arquitecturas más adecuadas para este tipo de tareas. Dentro de esta

línea se encuentran alguno de los neurocomputadores más conocidos [AEIA 91].

Un neurocomputador es básicamente un conjunto de procesadores conectados con una

cierta regularidad, que operan concurrentemente. En la actualidad ya existen una serie de

neurocomputadores comerciales destinados a la realización de redes neuronales; podemos

citar el Mark III y IV, el ANZA y ANZA Plus o el Delta-Sigma. A pesar de los logros

alcanzados en este campo, está muy lejos que estas estructuras alcancen el nivel de desarrollo y

difusión de los ordenadores convencionales.

Por otro lado, otra forma totalmente distinta de realizar redes neuronales consiste en la

implementación de éstas por medio de uno o varios circuitos integrados específicos, para así

poder obtener una estructura que se comporte lo más similar posible a como lo haría una red

neuronal. Aunque esta segunda aproximación se halla básicamente en manos de las

universidades y centros de investigación, existen algunos productos comerciales como el N64

de Intel, chip que incluye 64 neuronas y 10.000 sinapsis, y que puede procesar 2.500 conexiones

por segundo; o el MB4442 de Fujistsu, con una sola neurona y capaz de procesar 70.000

conexiones por segundo; o el MD1220 de Micro Devices, con estructura bit slice; o el conjunto

NU3232 y N32 de Neural Semiconductors.

Como diferencias con respecto a los neurocomputadores cabría resaltar el menor

número de neuronas de los chips neuronales, consecuencia del hecho de que dentro del

propio chip se incluyen todas las interconexiones, y, por tanto, su velocidad resulta varios

órdenes de magnitud superior que para los neurocomputadores. En la actualidad, estos chips

se utilizan para aplicaciones en las que la red neuronal ya se ha diseñado y probado por otros

métodos y lo que se requiere es una mayor velocidad para poder trabajar en tiempo real.

Aunque la tecnología microelectrónica parece que es, actualmente, la más adecuada para

la realización de redes neuronales, existen varios problemas sin resolver, como es la dificultad

de obtener el alto grado de interconexionado propio de estas redes, o el problema de la

entrada/salida masiva de datos, condicionada por el número de pines, o, por último, el poder

conseguir sinapsis con pesos variables, necesarias si se quiere que la red tenga una verdadera

capacidad de aprendizaje.

Otra tecnología que podría ser apropiada en la implementación de las redes neuronales

es la tecnología electroóptica, con la ventaja de utilizar la luz como medio de transporte de la

I. Introducción a la computación neuronal

1.1

información, permitiendo la transmisión masiva de datos. Los intentos de aplicación de esta

tecnología en la realización de redes neuronales, se encuentran todavía en estados de

investigación muy básicos.

1.8.1 REALIZACIÓN DE REDES NEURONALES

1. La realización más simple e inmediata consiste en simular la red sobre un ordenador

convencional mediante un software específico. Es un procedimiento rápido, poco costoso e

insustituible por el momento para realizar el entrenamiento y evaluación de las redes; pero

cuya mayor desventaja radica en el hecho de que se intenta simular redes con un alto grado de

paralelismo sobre máquinas que ejecutan secuencialmente las operaciones. Valores intrísicos

de las redes neuronales no pueden obtenerse de esta forma.

2. Realización de redes neuronales a través de arquitecturas orientadas a la ejecución de

procesos con un alto grado de paralelismo, tales como redes de transputers, arquitecturas

sistólicas, etc. El objetivo de tales redes es acelerar la simulación de la red neuronal

permitiendo, si es posible, una respuesta en tiempo real. Esta segunda línea puede verse como

una optimización de la anterior en lo que respecta al tiempo de proceso, pero subsiste el hecho