1. Noción de Proceso Estocástico. 2. Definición de Cadena de

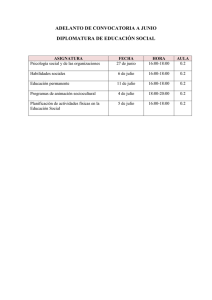

Anuncio

SESIÓN 2.a

CADENAS DE MARKOV. INTRODUCCIÓN

1. Noción de Proceso Estocástico.

Definición. P.E. asociados a un sistema.

2. Definición de Cadena de Markov

Propiedad Markoviana y estacionariedad

3. Matriz de Probabilidades de transición y

Diagrama de estados.

4. Ejemplos de Cadenas de Markov.

Cap. 14 Hillier F.S., Lieberman G.J. “Introduction to Operations Research” Holden day Inc. 1986.

I.O.E. Diplomatura de Estadística

Cadenas de Markov. Introducción. SEMANA 1

UPC

Ciclo metodológico de la I.O.

Identificar el

problema

Planificación del

estudio

SISTEMA REAL

Implementar las

soluciones

Recogida de datos

Formular e

Implementar el

modelo

Pruebas

del

modelo

Resultados

Insatisfactorios

I.O.D.

Diplomatura de

de Estadística

Estadística

I.O.E. Diplomatura

Validar el

modelo

Ensayo de

alternativas

Análisis de

resultados

MODELO(s)

UPC

Definición de proceso estocástico.

Es una colección indexada de variables aleatories

{X

t

t ∈ T },

t pertenece a un conjunto T conocido.

Espacio de Estados I : Conjunto de valores que puede tomar cada Xt

Conjunto de Índices T

Discreto

Espacio Discreto

de

Estados I

Continuo

Cadena de

Cadena de

parámetro discreto

parámetro continuo

Proceso estocástico de

Continuo parámetro discreto y de

estados continuo

Proceso estocástico de

paràmetre continuo y

estados continuo

Clasificación de los procesos estocásticos

I.O.E. Diplomatura de Estadística

Cadenas de Markov. Introducción

UPC

SISTEMA FÍSICO. PROCESOS ESTOCÁSTICOS INVOLUCRADOS

COLA

CLIENTES

EMPLEADO

TIENDA

-

{N

{X

t

k

k =1, 2,K } Número de clientes en la cola al salir de la tienda el k-ésimo. I = {0,1, 2, K },.

t ∈T } Número de clientes en el instante t.

I = {0,1, 2,K },

T = {t 0 ≤ t < ∞ } ,

- {Wk k ∈T } Tiempo que espera el cliente k antes de ser atendido:

I = { w 0 ≤ w < ∞ } , T = {1, 2, 3, K}

- {Yt t ∈T } Tiempo total de trabajo del empleado hasta el instante t :

I = [0, ∞) ,

I.O.E. Diplomatura de Estadística

T = { t 0 ≤ t < ∞ }.

Cadenas de Markov. Introducción

UPC

y

Se registra su posición

cada 0,5 seg.

(xk-1,yk-1)

(xk,yk)

(xk+1,yk+1) ??

P(xk+1=x , yk+1=y | (xk , yk), (xk-1 , yk-1), … )

I.O.E. Diplomatura de Estadística

Cadenas de Markov. Introducción

x

UPC

CADENA de MARKOV FINITA ( I Finito )

1. Propiedad Markoviana:

El proceso ha tomado una secuencia de valores: x0 , x1, x2,

… xk-1=j ∈ I

X k +1 = j

Ρ

=

K

=

=

=

=

=

,

,

,

,

,

X

i

X

x

X

x

X

x

X

x

1

1

0

0

k

k −1

k −1

k −2

k −2

X =j

= Ρ k +1

=

X

i

k

para todo valor k y toda secuencia de estados x0 , x1, x2,

… xk-1= j , xk= i ∈ I.

2. Estacionariedad:

Para todo par de estados

i, j ∈ I se cumple:

X k +1 = j

=

X

j

=

1

Ρ

=

Ρ

=

=

X

i

X

i

0

k

I.O.E. Diplomatura de Estadística

p ij

Cadenas de Markov. Introducción

, k = 0,1, 2,K

UPC

CADENA de MARKOV FINITA.

Las probabilidades pij forman una matriz de Probabilidades de Transición:

Para I={0,1,2,3,…M}

p00 L p0 M

O

M ,

Ρ= M

pM 0 L pMM

M

∑

j =0

pij = 1, pij ≥ 0, i = 0,1,2,...M

(Matriz estocástica)

pji = 0

.

Diagrama de transiciones:

j

i

pij > 0

I.O.E. Diplomatura de Estadística

Cadenas de Markov. Introducción

UPC

CADENA de MARKOV FINITA. (Ejemplos)

Aprobar una asignatura

Xk = Resultado del examen final en el k-ésimo intento.

1= suspender, 0= aprobar.

Si Xk-1=1

Si Xk-1=0

presenta una distribución de Bernuoilli: P(Xk =0| Xk-1=1 )=α

P(Xk =1| Xk-1=1 )=1-α

P(Xk =0| Xk-1=0 )=1

P(Xk =1| Xk-1=0 )=0

p11

P=

p21

p12 1

0

=

p22 α 1 − α

I.O.E. Diplomatura de Estadística

α

1

0

Cadenas de Markov. Introducción

1

1−α

UPC

CADENA de MARKOV FINITA. (Ejemplos)

Ejemplo de la Ruina del jugador.

Dos jugadores A, B de poker. A tiene una probabilidad p de ganar una mano (q de perder)

Apuestan 1 € en cada mano. Entre los dos tienen 4 €

{Xk}, Colección de variables aleatorias.

Xk = cantidad en el bolsillo del jugador A tras la k-ésima mano.

q

A pierde

la partida

Inicio de partida X0 =2

q

q

1

1

0

1

2

p

Supongamos que en la mano k, Xk = 2,

P(Xk+1=4| Xk = 2) = 0

P(Xk+1=3| Xk = 2) = p

P(Xk+1=2| Xk = 2) = 0

P(Xk+1=1| Xk = 2) = q

P(Xk+1=0| Xk = 2) = 0

I.O.E. Diplomatura de Estadística

3

p

4

A gana la

partida

p

1

q

P = 0

0

0

0

0

0

0

q

p

0

0

p

0

q

0

0

0

0

Cadenas de Markov. Introducción

0

0

0

p

1

UPC

CADENA de MARKOV FINITA. (Ejemplos)

Tiempo de funcionamiento de un aparato. ( Limitada a < k+1 periodos )

Avería

segura

0

0

1

2

P=

M

M

k −1

k

1

q0

q

1

q2

M

M

q k −1

1

2

p0

0

0

M

M

0

0

3

0

p1

0

M

M

0

0

k-1 k

0

0

L

L

p2 0

O O

O

L L

L L

I.O.E. Diplomatura de Estadística

O

0 p k −1

0

0

L

L

L

0

0

0

M

M

k+1

q0

p0

0

p1

1

q1

p2

pk-1

3

2

q2

…

q3

Cadenas de Markov. Introducción

k1q

k-1

(pk=0)

kk

kk

qk=1

UPC

Siguiente Tema ECUACIONES DE CHAPMAN KOLMOGOROV

Probabilidades condicionales en n transiciones:

Xn = j

= p (n

Ρ

ij

X

i

=

0

p ≥ 0 para

(n

ij

P (n

M

n = 0, 1, 2, K ∀ i,j

p11( n

= M

p M( n1

L

O

L

p1(Mn

M

(n

p MM

p =1 para n = 0, 1, 2, K ∀ i.

j =1

∑

(n

ij

FORMA MATRICIAL DE LAS EC. DE CHAPMAN KOLMOGOROV:

P = P ⋅ PLP = P = P

(n

I.O.E. Diplomatura de Estadística

n

( n −1

Clasificación de Cadenas de Markov

⋅P

UPC

CLASES DE EQUIVALENCIA DE UNA CADENA DE MARKOV

.

(n

p

Accesibilidad: un estado j es accesible desde el i si ∃ n tal que ij

( Notación: i → j )

>0

Es posible encontrar un paso que conecte i con j sobre el diagrama de transiciones.

Ejemplo: 2 → 7, pero 7 → 2

Dos estados i, j comunican entre sí si i → j & j → i ( Notación: i ↔ j )

• ↔ es relación de equivalencia: a) i ↔j ⇒ j ↔i b) i ↔ j , j ↔ k ⇒ i ↔ k

(Se admite i ↔i )

Definición de clase:

4

.4

C(i )={ j | i ↔ j }

.6

1

j ∈ C(i) ⇒ C(i) = C(j)

j ∉ C(i) ⇒ C(i) ∩ C(j) =Ø

.6

.4

.2

9

3

.6

1.

.6

.6

.2

1.

.3

2

.6

.1

.6

5

.4

8

7

.8

6

.3

I.O.E. Diplomatura de Estadística

Clasificación de Cadenas de Markov

.

UPC

PROBABILIDADES DE ABSORCIÓN

Presencia de clases absorbentes.

Estructura de la matriz de probabilidades de transición.

B

A

Estados 1, 2

Estado 3

Estados 4,5

Estado 6

Contrato eventual

Despedido

Contrato fijo

Excedencia.

1

4

3

6

5

2

0

0

0

0

0

3 1

0

4 0 1 / 3 1 / 3 1 / 3 0

P A

0

5 0 1/ 3 1/ 3 1/ 3 0

P=

=0

0

1/ 2 0

0

6 0 1/ 2

R A

0

0 . 2 0 .2

1 0 .5 0 .08 0.02

0

0 .1 0 .6

2 0.2 0 .08 0.02

I.O.E. Diplomatura de Estadística

0

PB

RB

0

0

Q

PAbs 0

P=

R Q

Clasificación de Cadenas de Markov

UPC

PROBABILIDADES A LARGO TÉRMINO

Para los estados i,j dentro de una clase C cerrada se verifica:

limn→∞

No depende de i

E[Y ij( n ]

1 n (k

= limn→∞ ∑ pij = π j , j ∈ C

n

n k =1

Interpretación:πj = fracción de los periodos en que se visita j.

1/πj = µjj = tiempo medio de recurrencia del estado j

verifican:

∑

i∈C

π i =1, π i ≥ 0, i ∈ C

.

Ejemplo:

1.

1.

1

2

1.

I.O.E. Diplomatura de Estadística

3

π1 =1/3

π2 =1/3

π3 =1/3

Estado Estacionario en C. de M. SEMANA 3

UPC

CADENAS ERGÓDICAS.

Definición. Sólo hay una clase y ésta es aperiódica.

2

1

Ejemplo de la tienda de cámaras:

Tras 8 transiciones, las probabilidades

(n

p

condicionales ij de los estados no

3

4

dependen de la situación inicial.

Las filas de la matriz

P(8 son idénticas

(a 3 dígitos de precisión).

El estado inicial es irrelevante:

p(8)

T

0.286

= p(0 ) ⋅ P (8 ) = [* * * *] 00..286

0.286

286

T

I.O.E. Diplomatura de Estadística

0.285

0.285

0.285

0.285

0.286

0.286

(8

(4

(4

8

P = P ⋅P = P =

0.286

0.286

0.264

0.264

0.264

0.264

0.166

0.166

0.166

0.166

0.285 0.264 0.166

0.285 0.264 0.166

0.285 0.264 0.166

0.285 0.264 0.166

= [0.286 0.285 0.264 0.166]

Estado Estacionario en C. de M. SEMANA 3

UPC

SESION DE PROBLEMAS

Una tienda de fotografía almacena un modelo particular de cámaras. Para reponer el

stock puede efectuar pedidos semanales a su distribuidor. La demanda Dk de unidades

del modelo en la semana k es una v.a. Poisson con E[Dk] = 1.

Sea Y0=3 el número inicial de cámaras, Y1 el número de cámaras al final de la 1ª

semana, Y2 al final de la segunda etc.

Los sábados por la noche se efectúa un pedido de S = 3 cámaras al distribuidor si la

tienda el nivel de existencias es <s (=1). El pedido es servido puntualmente el lunes

por la mañana.

Si durante una semana no pueden satisfacerse las demandas de los clientes, éstas se

pierden.

I.O.E. Diplomatura de Estadística

Cadenas de Markov. Introducción

UPC

1k −1

p00 = P(Dt ≥ 3) =1 − P({Dt < 3}) =1 − FD (2 ) =1 − ∑ e = 1 − e −1 (1 + 1 + 12 ) = 0.080

k =0 k !

k

k

2 1 −1

1 1 −1

p01 = P(Dt = 2) = FD (2) − FD (1) = ∑ e − ∑ e = 0.184

k =0 k !

k =0 k !

k

k

1 1 −1

0 1 −1

p02 = P(Dt = 1) = FD (1) − FD (0 ) = ∑ e − ∑ e = 0.368

k =0 k !

k =0 k !

k

0 1 −1

p03 = P(Dt = 0 ) = FD (0) = ∑ e = 0.368

k =0 k !

2

t

t

t

t

t

t

p10 = P(Dt ≥ 1) = 1 − FD (0 ) = 0.632

t

1k −1

p11 = P(Dt = 0) = FD (0) = ∑ e = 0.368 , p12 = p13 = p23 = 0

k =0 k !

0

t

1k −1

p20 = P(Dt ≥ 2 ) = 1 − FD (1) = 1 − ∑ e = 0.264

k =0 k !

k

k

1 1 −1

0 1 −1

p21 = P(Dt = 1) = FD (1) − FD (0 ) = ∑ e − ∑ e = 0.368

k =0 k !

k =0 k !

k

0 1 −1

p22 = P(Dt = 0) = FD (0 ) = ∑ e = 0.368

k =0 k !

1

t

t

t

t

1k −1

p30 = P(Dt ≥ 3) =1 − P({Dt < 3}) =1 − FD (2 ) =1 − ∑ e = 1 − e −1 (1 + 1 + 12 ) = 0.080

k =0 k !

2

t

I.O.E. Diplomatura de Estadística

Cadenas de Markov. Introducción

UPC

1k −1 1 1k −1

p31 = P(Dt = 2 ) = FD (2 ) − FD (1) = ∑ e − ∑ e = 0.184

k =0 k !

k =0 k !

2

t

t

1k −1 0 1k −1

p32 = P(Dt = 1) = FD (1) − FD (0 ) = ∑ e − ∑ e = 0.368 ,

k =0 k !

k =0 k !

1

t

t

1k −1

p33 = P({Dt = 0}) = FD (0) = ∑ e = 0.368

k =0 k !

0

t

p00

p

P = 10

p20

p30

p01

p02

p11

p21

p12

p22

p31

p32

p03 0.080

p13 0.632

=

p23 0.264

p33 0.080

1

0.184 0.368 0.368

0.368

0

0

0.368 0.368

0

0.184 0.368 0.368

2

3

4

I.O.E. Diplomatura de Estadística

Cadenas de Markov. Introducción

UPC