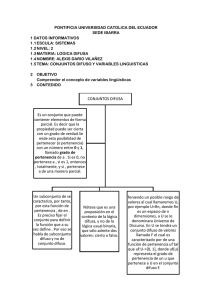

capitulo ii

Anuncio