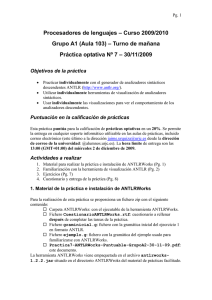

Guía práctica de ANTLR 2.7.2 - Departamento de Lenguajes y

Anuncio