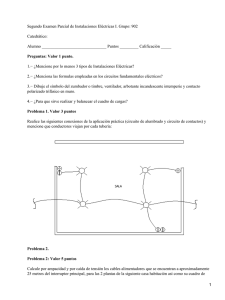

Componentes de una CPU y circuitos eléctricos

Anuncio