datacenter - Discover. Share. Present

Anuncio

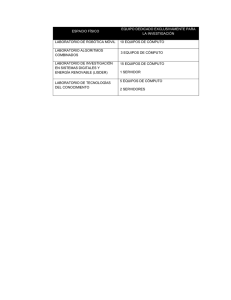

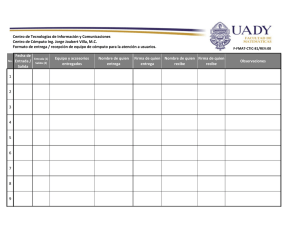

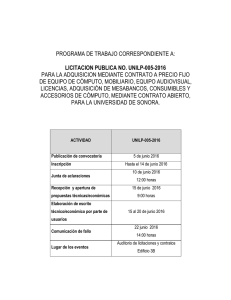

DATACENTER viernes, 8 de marzo de 2013 DATA CENTER Buenos días instructor Sergio Arango descripción: DATACENTER CASO DE ESTUDIO Según los conocimientos adquiridos en nuestra investigación sobre un Data Center, vamos a resolver la siguiente solicitud: 1. Establecer una guía para el montaje de un centro de cómputo, permitiendo a la empresa obtener una visión futurista para plantear y lograr objetivos 2. información técnica sobre cómo montar correctamente un centro de cómputo 3. equipos y materiales que deben usarse para la implementación y de las normas que deben aplicarse Desarrollo 1. GUIA/ O ESTANDARES PARA EL MONTAJE DE UN CENTRO DE CÓMPUTO Existen una gran variedad de organizaciones que emiten periódicamente Nuevos estándares para la edificación de centros de cómputos. Las principales Organizaciones como el ANSI, TIA, EIA, BICSI, IEEE y el NFPA entre otras, Mejoran a diario sus estándares entre los que citamos: • Estándar ANSI/TIA/EIA-568A de alambrado de telecomunicaciones para Edificios comerciales. • Estándar ANSI/TIA/EIA-569 de rutas y espacios de telecomunicaciones Para edificios comerciales. • Estándar ANSI/TIA/EIA-606 de administración para la infraestructura de Telecomunicaciones de edificios comerciales. • Estándar ANSI/TIA/EIA-607 de requerimientos de puesta a tierra y Punteado de telecomunicaciones de edificios comerciales. • Building Industry Consulting Service International, manual de métodos De distribución de telecomunicaciones. • ISO/IEC 11801 cableado genérico. • Código Eléctrico Nacional 1992 (CODEC). Establece normas para la Manipulación de conductores y equipos eléctricos. CARACTERÍSTICAS FÍSICAS Se definen seis componentes principales en un centro de cómputo: • Instalaciones de entrada. • Sala de equipos. • Canalizaciones de montantes o backbone. • Armarios de telecomunicaciones o salas de telecomunicaciones. • Canalizaciones horizontales. • Áreas de trabajo. En la figura 1 se muestra la ubicación de los seis componentes principales. Figura 1. Componentes principales de un centro de cómputo La ubicación de un centro de cómputo debe ser lo más cerca posible al centro Del área a ser atendida y cumplir con una serie de requisitos, entre los que Podemos mencionar los siguientes: • Estar situado donde no pueda acceder personal no autorizado. • Que no entre luz natural. • Permitir la instalación de algún sistema acondicionador de aire. • No debe haber entradas de aire natural. • Tener una apropiada ubicación para los extinguidores. • Poseer ruta de evacuación. Se debe tomar los siguientes requerimientos en el dimensionamiento del centro De cómputo: • El centro de cómputo en donde se instale los equipos del sistema debe ser Lo suficientemente amplio y accesible. En ningún caso conviene que la Superficie sea menor de 20 m2. • Lugar suficiente para los equipos actuales y para los futuros crecimientos. • El tamaño mínimo recomendado para el área de trabajo es de 10 m 2. • Para la sala de equipos se recomienda un tamaño de 0.07 m 2 por cada 10 m2 de área utilizable. Las puertas de acceso deben ser de apertura completa con llave y como Mínimo 91 centímetros de ancho y 2 metros de alto. El cuarto debe ser Completamente cerrado; es decir, los rayos solares no deben entrar al cuarto De cómputo, por lo que se recomienda la no utilización de ventanas. Figura 2. Esquema de un centro de cómputo SISTEMAS DE DISTRIBUCIÓN DE CABLEADO Los sistemas de distribución de cableado especifican la forma como es Canalizado y distribuido el cableado en un centro de cómputo. Pueden ser: Suelo falso, techo falso y escalerillas. CARACTERÍSTICAS ELÉCTRICAS Existen dos sistemas de distribución de energía; el AC y el DC, pero para Energizar un centro de cómputo se debe usar un sistema AC. El centro de Cómputo deberá constar con un sistema de respaldo de energía. En caso de Fallo de energía eléctrica un GENERADOR entrará en funcionamiento. Una Parte esencial son los sistemas de aterrizamientos. Este sistema estará Compuesto por barras estandarizadas como el TMGB, el TGB y el cable TBB. Figura 3. Sistema de Aterrizamiento CONDICIONES AMBIENTALES Un centro de cómputo deberá mantenerse a una climatización adecuada para Equipos de telecomunicaciones. Equipos acondicionadores de aire deberán Usarse para regular temperatura y humedad dentro de la sala. CABLEADO ESTRUCTURADO Para el cableado estructurado dentro del centro de cómputo, los cables usados Son: UTP, STP, F.O., como los más principales. Estos serán configurados para Transmitir datos mediante el uso del estándar de códigos de colores. Estándares importantes al momento del cablear redes de datos son el T568B y El T568A.Figura 4. Configuraciones de red. La seguridad es esencial dentro y fuera del centro de cómputo, equipos y Normas, además de procedimientos de seguridad deberán ser celosamente Ejecutados. DISEÑO DEL CENTRO DE CÓMPUTO Requerimientos • La sede del centro de cómputo será en Bogotá • Se realizarán procesos para los CAC’s. • Se manejarán procesos de varios departamentos. • El acceso a cada uno de los departamentos será a través de la red LAN Propia de la empresa. • Control de todos los servicios a los que tienen acceso los clientes de Telefonía móvil junto con la tarifación. ESTUDIO PRELIMINAR DEL DISEÑO El centro de cómputo cumplirá con las siguientes características: Características Físicas.- Las dimensiones de la sala son 10.40 x 7.70 metros. (Área de trabajo de 80.04 m2). Una única puerta de ingreso al centro de Cómputo ubicado en la parte central de la pared frontal del cuarto. No habrá Ventanas. La altura desde el piso al techo será de tres metros. Características Eléctricas.- Estará constituido básicamente por un generador, UPS' s y tableros de distribución de energía. La transferencia automática la Realizará el equipo TTA-Kohler. La iluminación será mediante 6 puntos cada Uno con 4 tubos fluorescentes. Para el aterrizamiento se usará el cable AWG Calibre 6 conectada a la malla del edificio. Características Seguridad.- Se realizará mediante cámaras dentro del Edificio. ANALISIS TECNICO Direccionamiento IP Para la asignación de direcciones IP se tomarán en cuenta los siguientes Puntos: • Dirección IP asignada al departamento de sistemas clase C 192.168.10.0 • La máscara de Subnet para la red del centro de cómputo será la 255.255.255.192 con la que se tendrán 62 direcciones de host disponibles. • Todos los servidores instalados en el centro de cómputo estarán en una Misma subred de sistemas. • La red de sistemas estará formada por el centro de cómputo y una subred Conformada por las PC. • El centro de cómputo estará formado por 34 servidores y 9 routers. • Los 9 routers estarán ubicados fuera del centro de cómputo por razones de Seguridad y política de la empresa. • El backbone estará formado por un switch cisco 4506. • En el interior del centro de cómputo van a existir 3 servidores públicos por lo Que será necesaria la realización de redes virtuales LAN (VLAN). Dado estos requerimientos se decidieron tomar la dirección IP asignada y dividirla En dos subredes tomando dos bits de la parte local de la dirección, de esta Forma se tiene 62 direcciones de host disponibles. Luego, se tomó la primera De las subredes y se realizó un subnetting variable (VLSM), es decir se dividió En dos volviendo a tomar un BIT de la parte de host. Para el acceso a los diferentes equipos deberá establecerse una sesión telnet A través del programa emulador Power Term / 32. ESQUEMA DEL CENTRO DE CÓMPUTO El centro de cómputo estará conformado por 3 bloques de equipos: IBM, SUN, HP, OTROS. Habrá 4 Tableros de Distribución de energía: 1 TD principal y 1 para cada Bloque de rack manejado cada uno por su propio UPS. Mediante este arreglo Eléctrico se establece independencia en los circuitos eléctricos. Determinación del Generador y UPS Tabla I Carga Total del Centro de Cómputo Vatios Carga Instalada 36290,00 Holgura 30% 1,3 Sub total 47177,00 Carga Total 47177,00 Tomado en consideración la carga instalada 47.177 KW y el consumo de los Acondicionadores de aire 92180.40 BTU/h lo que equivale a 36.736 KW (1KW = 2509.56 BTU/h) el generador debe ser capaz de manejar una carga de 84 KW. Se utilizarán tres UPS’s repartiendo la carga entre ellos. Los UPS's Deberán ser capaces de proporcionar un respaldo mínimo de energía de una Hora por lo que se instalarán con un banco de baterías externo. Determinación del Acondicionador de Aire Tabla II Disipación de los equipos BTU/h Potencia Disipada 70908,00 Holgura 30% 1,3 Sub total 92180,40 Capacidad del AA. 92180,40 Se utilizarán dos acondicionadores de aire para la climatización del centro de Cómputo con una capacidad de 60000 BTU/h cada uno, cada equipo será Alimentado de manera individual para que su funcionamiento no afecte a los Equipos de comunicaciones del centro de cómputo. Determinación de la Acometida Tabla III Carga total de energía Carga de Equipos (W) 47177,00 Carga de A .A (W) 36736,09 Carga Total (W) 83913,09 Carga Total (A) 381,42 La corriente que circulará por cada conductor es de 381.42 amperios y Considerando que la acometida irá por ductos el calibre recomendado para el Conductor es el AWG # 500 el cual soporta un máximo de 430 amperios en Ductos. Este valor de corriente determina también un breaker principal de 400 Amperios. DESARROLLO DEL CENTRO DE CÓMPUTO PARA TELEFONIA CLARO Cronograma de Actividades 1. Reconocimiento del sitio donde se ubicará el centro de cómputo. 2. Acondicionamiento del lugar de acuerdo a los requerimientos físicos Establecidos. 3. Instalación de alimentación principal de energía eléctrica y UPS. 4. Instalación de los tableros de distribución de energía eléctrica 5. Instalación de Racks de comunicaciones 6. Montaje de los equipos en los Racks correspondientes 7. Colocación del cable UTP (desde las tomas para RJ-45 hasta los paneles de Interconexión en los racks). 8. Pruebas de certificación del cableado de datos (verificación técnica con Instrumentos). 9. Configuración de los equipos mediante la carga de software. 10. Pruebas y diagnósticos de los equipos instalados. Cada actividad se realizará en tiempos específicos. Y llevados a cabo mediante Un software como el MS Project. Montaje El centro de cómputo está formado por los siguientes sistemas: • Infraestructura • Sistema de Climatización • Sistema Eléctrico • Sistema de Datos El sistema de datos estará constituido por routers y servidores que serán Conectados a un switch cisco 4506, que servirá como concentrador. El Recorrido del cableado será realizado por canaletas instaladas en el piso falso. Esquema Final A continuación presentamos el esquema final del centro de cómputo para En la que se podrá la distribución de los equipos. El sistema de Aire instalado. El acceso al centro de cómputo. Todo esto cumpliendo con los Requerimientos y normas establecidos. TELEFONIA CLARO Figura 5. Esquema Final del Centro de Cómputo . PRUEBAS Y DIAGNOSTICOS Para la verificación del funcionamiento de los equipos instalados será Necesario hacer un conjunto de pruebas. Las siguientes son las pruebas que se realizarán: • Pruebas unitarias y de conectividad. • Pruebas de seguridad. • Pruebas de configuración. • Pruebas de mantenimiento. • Pruebas de correo electrónico. • Pruebas del funcionamiento de los back-up de energía y su restauración Se realizarán “fichas de prueba” para todos los elementos y servicios que el Centro de cómputo brinda. La siguiente es una ficha realizada al sistema de datos: La certificación final para una correcta instalación del centro de cómputo será la Realización de un check list. Al realizar el chequeo por categorías se podrá Analizar falencia en áreas específicas y así poder determinar la mejor solución. 1. ASPECTOS FUNDAMENTALES A TENER EN CUENTA PARA CONSTRUIR UN DATACENTER Es realmente muy difícil resumir, en sólo 10 pasos, algo tan complejo como la construcción de un centro de cómputos. El primer hito fundamental es una buena planificación, que incluye un sin número de actividades que confluyen en la obtención de un proyecto de construcción. El armado del proyecto es válido para un diseño nuevo o una remodelación, no importa su tamaño ni el nivel de disponibilidad de servicios que se le quiera dar al proyecto (Tier); el secreto del éxito está en prever cada una de las tareas e inversiones que se realicen. Por más que hoy no se pretenda obtener una certificación del datacenter, es fundamental que su diseño y especificaciones técnicas se base en las normas nacionales e internacionales de construcción como TIA, EIA, NFPA, USGBC, RoHS, ASHRAE, NFPA, ANSI, IRAM, IEC, IEEE, CENELEC, AEA, ICREA, Uptime Institute y BICSI. Como consejo final para este primer ítem de planificación y proyecto es recomendable que sea realizado por especialistas, que su tarea diaria sea la de construir datacenters, ya que estarán familiarizados con la aplicación de las normas y asegurarán el éxito del proyecto. Los 10 aspectos fundamentales a tener en cuenta: 1.- Tipo de datacenter a construir. Aquí tomaremos como base la norma ANSI/TIA-942 que divide a los datacenter en 4 Tiers. Esta norma es muy completa y establece las características y niveles de redundancia que deben poseer cada uno de los Tier en aspectos fundamentales como aspectos eléctricos, termomecánicos, edilicios, cableado y comunicaciones entre otros. En esta etapa, debemos determinar a qué nivel de redundancia pretendemos llevar el centro de datos y cuánto tiempo de inactividad estamos dispuestos a tolerar. Un punto fundamental para decidir el nivel del datacenter es cuánto representa en términos económicos para el negocio una caída del procesamiento; dicho número nos ayudará a establecer el nivel de inversión y redundancia a proyectar. 2.- Equipamiento informático a instalar, presente y futuro. En esta etapa, debemos tener muy en claro cuáles serán los equipos que se instalarán dentro del datacenter, entre servidores, storage, librerías de backup, switches de core, etc. Es un error muy común calcular el consumo eléctrico sumando directamente lo que marca el manual de cada equipo e indica el fabricante, por lo general éstas indicaciones corresponden a la máxima configuración y carga del equipo en sus picos de arranque y en situaciones de extrema exigencia, si solo tomamos esto para dimensionar el consumo eléctrico seguramente sobredimensionemos la potencia. El paso correcto sería poder medir el consumo eléctrico directamente con una pinza amperométrica en cada rack u obtener este dato si tenemos instalados medidores de consumos en los tableros o en las unidades de distribución de energía individuales que permitan obtener el consumo real. Para las proyecciones de los nuevos racks en donde no tenemos claro que equipos instalaremos estamos en la actualidad calculando un consumo entre 5Kw y 7Kw. Lo importante de este punto es armar un sistema de energía que sea escalable y flexible, que si en poco tiempo instalamos un rack en donde el consumo real esté en 10Kw y nosotros previmos 7Kw, rápidamente podamos adaptar la instalación sin necesidad de costosas modificaciones o desechando las obras que se hicieron en el pasado y haciendo todo de nuevo. Distribución del consumo de energía en el data center 3.- Cálculo de refrigeración. En la actualidad, esta etapa es uno de los pasos más complejos y delicados de diseñar. Equipos con elevados consumos de energía, gran disipación de calor, horas pico de procesamiento y dificultades de instalación de los sistemas termomecánicos son algunos de los desafíos con los que nos cruzamos durante el diseño. Tenemos diversas topologías para refrigerar un centro de cómputos, dentro de las cuales se destacan los sistemas de refrigeración perimetral que inyectan aire por debajo del piso técnico, los de refrigeración por hilera que extraen el calor de los pasillos calientes e inyectan frio por delante de los racks, los de enfriamiento por rack que inyectan el aire frio desde la parte superior del rack, o los sistemas que simplemente prevén la inyección de aire frio en toda la sala. Lo importante es poder armar un sistema flexible y escalable que permita refrigerar las necesidades actuales y soportar las posibles exigencias a futuro. Deberemos también establecer el nivel de redundancia deseado, si será agregando equipamiento de backup para la inyección de aire bajo piso, o logrando una redundancia N+1 en las filas más críticas del datacenter si optamos por una refrigeración por hilera. El mayor consejo que podemos dar es el de armar distintas zonas dentro del data center, ya sea que armemos un centro de datos con varias hileras o por el contrario en una sola fila, deberíamos prever zonas para alta densidad donde podamos instalar un consumos de 7Kw o superiores y otras con 2Kw o 3Kw de consumo por rack, como por ejemplo para comunicaciones. Los sistemas de refrigeración son los que se llevan la mayor parte del consumo eléctrico de un data center, como se ve en el gráfico 1, diversos estudios afirman que el 38% del consumo eléctrico del data center es consumido por el sistema de refrigeración, basándonos en este dato resulta relevante el tipo de tecnología que seleccionemos para refrigerar, ya que nos encontramos frente al principal ítem en donde podemos realizar la optimización del ahorra de energía. Una vez seleccionada la topología de refrigeración debemos elegir con que tecnología refrigeraremos, hay varios métodos, hoy aquí solo mencionaremos el de expansión directa y el de chilled water, que son los más aplicables a nuestro mercado latinoamericano. Sistema de agua enfriada De ambas alternativas, la más utilizada en la actualidad es la de expansión directa que presenta ventajas de instalación con respecto al sistema de chilled water. La decisión de elección de un sistema u otro dependerá mucho de la proyección de crecimiento del consumo de energía, para los centros de datos con consumos de energía elevados es recomendable la instalación de sistemas de chilled water, ya que en el tiempo termina siendo más eficiente y económica la refrigeración por agua helada. Aquí deberemos vencer el mito de ‘agua en el data center’, que logrando instalaciones profesionales, seguras y bien diseñadas no debería generar ningún inconveniente adicional la adopción de este sistema. Por último, debemos asegurarnos que los sistemas de refrigeración contemplen un control permanente de la temperatura y humedad del ambiente y tengan incorporado ventiladores de velocidad variable que inyecten frio y flujo de aire de acuerdo a las necesidades que se plantean a lo largo del día. Este método nos permitirá optimizar el consumo de energía. Mapa térmico de un centro de datos 4.- Cálculo de potencia requerida. Definidos los principales componentes, como el sistema de refrigeración y la potencia deseada por rack, procedemos a calcular el resto de los consumos del centro de cómputos. Cabe aclarar que, al asignar un consumo por rack, aquí están incluidos los consumos de servers, storage y comunicaciones. Nos quedaría dimensionar iluminación, refrigeración de confort, sistemas de extracción de aire, bombas de extracción de agua si las hubiera o sistemas de detección y extinción de incendios. Aquí estimaremos la potencia total de la UPS, que como venimos destacando no es necesario que al inicio instalamos la potencia total requerida en los próximos 5 o 10 años, sino que de acuerdo al plan de crecimiento e inversiones lo ideal sería armar un sistema modular y escalable que vaya creciendo a medida que lo hace el negocio. Es fundamental establecer el nivel de redundancia eléctrica requerido, podremos pensar en sistemas N, N+1 o 2N+1, con esta definición terminaremos de diseñar el sistema eléctrico, podrá implicar que lleguemos a alimentar cada rack con doble acometida eléctrica de distintos tableros y distintas UPS, o un sistema mas simple con una sola alimentación y una UPS, aunque esta última opción elevará la probabilidad de fallas del sistema. Una vez establecida la potencia total requerida debemos cotejar la disponibilidad de la misma, ya sea dentro del edificio en el cual se emplazará el datacenter o la disponibilidad directa de la compañía eléctrica en el caso de mayores consumos. Por último el sistema de energía deberá prever la instalación de un grupo generador que actúe en los casos que la compañía eléctrica interrumpa el servicio, el mismo deberá posibilitar que el 100% del data center pueda funcionar y ser abastecido por el generador. La norma TIA942 establece para los data center Tier 4 que la generación de emergencia debe ser concebida con la instalación de 2 grupos generadores que cada uno por si solo pueda abastecer en 100% de la potencia requerida. 5.- Conectividad. Independientemente del tamaño del centro de datos debemos pensar cómo estarán conectados e integrados a la red los servidores, storage o cualquier dispositivo que instalaremos en cada rack. Existe la posibilidad de instalar y dejar previsto en los racks una cantidad determinada de cables de cobre y/o fibras que confluyan todos al área de comunicaciones del data center, en la cual se encontrarán instalados los switches que nos proveerán de conectividad. El sistema opuesto al descripto anteriormente prevé la instalación de switches individuales por rack y éstos conectados por fibra o cobre al switch principal. La elección de una u otra topología dependerá del tipo y cantidad de dispositivos que instalemos, requerimientos en cuanto a velocidad, performance y características de crecimiento. 6.- Layout y espacios requeridos. Con todas las definiciones y premisas que hemos establecido en los puntos anteriores, estamos en condiciones de establecer el layout del centro de datos con los espacios y salas que necesitaremos. Si aspiramos estrictamente a cumplir con las normas deberíamos pensar en armar un espacio exclusivo para el alojamiento de los racks de servidores, un espacio diferente para los de comunicaciones, otro para la sala de UPS, uno para la sala de tableros, un espacio previo a la sala de servidores para el desembalaje y preparación de equipos, sala para el ingreso de los carriers de comunicaciones, y una sala de operadores y monitoreo. Si nos adaptamos a un mercado latinoamericano donde los espacios son mas reducidos y a proyectos de menor envergadura podemos unificar en un mismo espacio los racks de servidores y comunicaciones, y en algunos casos las UPS pueden también instalarse dentro de la fila de racks. En otra alternativa las UPS y sala de tableros pueden instalarse en un mismo espacio, permitiendo concentrar así todo lo referente a energía en la misma sala. Con respecto a la distribución de la sala de servidores, es de suma importancia establecer el concepto de pasillos fríos y calientes, de esta forma se evita las mezclas de los distintos aires, (fríos y calientes), permitiendo una mejor refrigeración y eficiencia. Layout de un centro de datos 7.- Elección del Lugar. Establecidas las medidas mínimas requeridas, debemos seleccionar el lugar de emplazamiento que dependerá del nivel seleccionado. La norma ANSI/TIA-942, por ejemplo, establece para un Tier4 la utilización de un edificio en forma exclusiva destinado al datacenter. Si pensamos en un Tier2 o Tier3, se establecen distintas normas de seguridad y requerimientos que pueden ser cumplimentadas en edificios prexistentes. Cuando nos encontramos frente a la remodelación de un centro de cómputos ya existente y en funcionamiento, debemos evaluar seriamente si es mas conveniente la construcción de una sala nueva en un lugar diferente, ya que en las remodelaciones se deberá trabajar, por lo general sin interrumpir las operaciones, con muy poca ‘ventana’ de corte de energía, y con el riesgo de provocar alguna interrupción involuntaria del servicio durante la obra. Esta ecuación muchas veces nos orienta al armado de un nuevo datacenter y la posterior migración de los equipos de procesamiento. Es fundamental acercarnos a cumplir con los 1200Kg por metro cuadrado que solicita la norma en cuestión de la resistencia de la losa del datacenter. En la actualidad, equipos de UPS, racks de servidores y storage están superando los 1000Kg de peso en una superficie de 0,60 m2 que ocupa un rack. 8.- Sistemas de control y seguridad. Para resguardar el valor patrimonial y, aún más importante, el valor de los datos, debemos establecer sistemas de control y seguridad que protejan al datacenter. Sistemas de detección y extinción de incendios, cámaras de seguridad, controles de acceso a salas, control de acceso a nivel de racks, detección de fluidos, control de temperatura y humedad, BMS, etc, son algunos de los ítems a tener en cuenta para lograr el nivel de seguridad adecuado del edificio. 9.- Valorización del Proyecto y Presupuesto. Una vez definidos los puntos anteriores, procedemos a la valorización total del proyecto, en donde estimamos el valor de construcción, provisión e instalación de cada componente definido, estableciendo y valorizando por cada ítem distintas alternativas. En esta valorización, no sólo es importante determinar el valor actual de construcción, sino el valor futuro de mantenimiento, ya sea el costo del mantenimiento preventivo, correctivo o el consumo eléctrico, de esta ecuación saldrá la alternativa más conveniente a adoptar. Con la estimación de los valores de construcción establecidos, debemos cotejarlos con el presupuesto asignado a la obra. Por lo general, las primeras comparaciones siempre arrojan un valor superior de obra al presupuesto asignado para el proyecto. De ser así, debemos ir repasando y ajustando al presupuesto cada uno de los puntos mencionados en este artículo de manera de llegar al presupuesto establecido sin resignar prestaciones y niveles de confiabilidad. En ciertas obras, hemos tenido que ajustar el proyecto y los costos más de 15 veces para lograr el mejor proyecto de acuerdo al presupuesto asignado. 10.- Confección del Proyecto Final de Construcción. El proyecto final de construcción debe contener la ingeniería de detalle que establezca los parámetros y condiciones con las que deberán cotizar los oferentes las distintas alternativas solicitadas. Debe estar acompañado, no sólo con una descripción técnica del equipamiento, sino con planos de construcción civil, tendido de cañerías y bandejas, layout de salas, diseño unifilar y topográfico de tableros, planos termomecánicos, disposición de cámaras y puntos de control, detalle de sistemas de incendios, y todos aquellos planos que faciliten el correcto entendimiento de la obra en cuestión. Debe contemplarse la mayor cantidad de detalles posibles con el fin de evitar olvidos o adicionales de obra que surjan por la no especificación de algún parámetro. 1. EQUIPOS Y MATERIALES PARA MONTAR UN DATACENTER Diseño del Centro de Datos Para el diseño se debe saber los equipos que van a ser instalados a fin De poder ubicarlos correctamente. Los equipos que estarán ubicados en el cuarto de equipos son: - Un Gabinete estándar de 34 RU para el servicio de voz (1,7x0, 9x0, 6 m.) - Un Gabinete estándar de 34 RU para el servicio de datos (1,7x0, 9x0, 6 m.) - Un Gabinete de Servidores de 34 RU (1,1x0, 7x0, 6 m.) - Una centralita telefónica (PBX, no apta para montaje en bastidores) (0,3x0, 3x0, 4x m.) - Un Switch de Central (7 RU) - Un Switch de 24 puertos (1 RU) - Un Switch de 48 puertos (2 RU) - Un Router (1 RU) 49 - Tres equipos Gateway GSM (0,21x0, 15x0, 55 m.) (No apto para Montaje en bastidores) - Un CPU que alojará a los servidores WEB y Correo (0,38x0, 18x0, 41 m.) (No apto para montaje en bastidores) - Un CPU que será el servidor de Intranet (0,38x0, 18x0, 41 m.) (No Apto para montaje en bastidores) - Dos Servidores de Almacenamiento de Información (SQL y FTP) (C/u de 2 RU) Aparte se tendrá una zona delimitada para poder ubicar los equipos Que no brindan servicios de telecomunicaciones pero que son Necesarios para la infraestructura del Data Center: - Dos unidades UPS (salida de 2,9 KW) (0,11x0, 5x0,6 m.) – Se Instalarán dos porque la empresa ya contaba con estos equipos y La carga que ofrecen es suficiente para el consumo de todo el Centro de datos ya que haciendo un cálculo general con todos los Equipos mencionados se requerirá una carga aproximada de 2 KW. - Un tablero eléctrico (adosable: 0,25x0, 09x0, 34 m.) - Un equipo de aire acondicionado y su controlador (Unidad tipo Ventana empotrado a la pared, control adosable: 0,3 x 0,09 0,2 x m.) El cuarto de entrada de servicios ha sido contemplado dentro del cuarto De equipos. Aquí estará ubicada la entrada de fibra óptica que le Brindará a la empresa servicio telefónico a través de un E1 con lo cual Serán posibles las llamadas hacia la red de telefonía pública (PSTN). Además, otros dos hilos más les darán conexión de datos de alta Velocidad en la red de acceso a Internet. Por lo tanto el equipo considerado es: 50 - Gabinete de empalmes de fibra óptica (adosable: 0,3x0, 5x0,2 m.) - 2 Convertidor de Medios (M/C) (no apto para montaje en Bastidores) (0,2x0, 1 m.) Se construirá un gabinete metálico pasacable por donde pasarán los Cables que bajan desde las bandejas que sirven el segundo piso hasta Las bandejas colocadas por debajo del falso piso del data center. A este Gabinete se le llama montante y su objetivo es el de proteger los cables (No dejarlos al descubierto) y dar mayor estética y orden al cuarto de Equipos. El montante tendrá una dimensión de 0,7 x 0,9 m. Dado que en el centro de datos se debe establecer un área de trabajo, Se ha considerado cerrar el área donde están los equipos mediante el Uso de una mampara. Escoger mamparas por lo inseguro, dentro del centro de datos sí es Permisible porque el administrador estará en contacto visual con Equipos y con cualquier operación que se deba realizar ahí. Por otro Lado, la división entre el área de trabajo y el cuarto de equipos se hace Para mejorar las condiciones de trabajo de la persona que estará en Dicho cuarto ya que la temperatura ambiental que debe mantenerse en El cuarto de equipos es fija y muchas veces no coincidirá con las Preferencias de una persona. Es por esta razón que el sistema HVAC Del cuarto de equipos debe ser independiente del sistema HVAC que Sirve a cada piso. Otra razón para delimitar esta área, es que el ruido Que generan los equipos y la ventilación de los gabinetes es Perturbador para estar en una zona de trabajo. Por otro lado, gracias a La mampara se da un grado más de seguridad a los equipos pues se Requerirá tener un doble acceso para poder llegar a ellos. Pasos para construir un data center Para quien no lo sepa, un data center (centro de datos) es un espacio habilitado para almacenar los recursos de hardware necesarios para el almacenamiento de datos, o sea, los servidores, pero también toda una serie de complementos que permiten garantizar la seguridad y buen funcionamiento de los mismos. Tipos de data center según su finalidad Existen empresas de data center que se dedican a alquilar la infraestructura como servicio (IaaS) y de cuidar todos los aspectos de hardware, pero ellos no se ocupan de alquilar alojamiento web directamente. Son proveedores que trabajan con las empresas de hosting; éstas pueden utilizar servidores para alquilar alojamiento web, crear varios VPS en ellos, o bien alquilar el servidor entero a un cliente. Cuando esto se hace, hablamos de servidores dedicados baratos, ya que el cliente no se tiene que preocupar de crear las instalaciones necesarias en su empresa para montar su servidor. En otras muchas ocasiones, los data center también actúan como empresas de alojamiento web y venden al cliente final. Otras veces, hablamos de data center privados, que forman parte de la estructura específica de una gran empresa, y sólo utilizan el hardware para su propio negocio, o bien tienen una línea de negocio en la que también alquilan alojamiento web. Cómo construir un data center Hay toda una serie de elementos fundamentales que hay que tener en cuenta para construir un data center. Lo primero sin duda es planificar bien el proyecto y realizar un presupuesto, ya que un error de planificación puede llevarnos a un malgaste de recursos innecesario. Hay que prever también un calendario de acción, señalando fechas en las que se pondrán en marcha las distintas fases del proyecto: compra de los recursos, adquisición o habilitación de un espacio físico, instalación del hardware y el software, personal que se necesita para llevarlo a cabo, etc. Dicho esto, conviene tener en cuenta los siguientes puntos. Determinar el tipo de data center que se va a crear. Nos guiaremos por la norma ANSI/TIA-942. Se trata de un estándar que clasifica los data center en 4 TIER. Cada Tier tiene un plazo de implementación distinto, un tiempo de inactividad anual estándar, un porcentaje de disponibilidad. El Tier 1 (el más básico) requiere un mínimo de 3 meses para su implementación. Elegir el equipo que se va a utilizar, presente y futuro. Debemos determinar los servidores, storages, switches de core, librerías de backup y todo el equipamiento necesario. Además, debemos medir el consumo eléctrico de cada pieza, por ejemplo a través de medidores de consumo en las unidades de distribución de la energía. Analizar la refrigeración. Hay múltiples topologías de refrigeración y es quizás la parte más difícil para diseñar un data center. Hay que tener claro que estos sistemas no se pueden implementar en cualquier sala, debe tener unas características concretas. Calcular la potencia necesaria. Cuando ya tenemos claro tanto el equipamiento necesario, como los sistemas de refrigeración utilizado, calcularemos el consumo de potencia necesario. Análisis de conectividad. Sea cual sea el tipo de data center que hagamos, todos los elementos tendrán que seguir una estructura de conectividad. Debemos planificar la red y el conjunto de dispositivos que vamos a instalar en cada rack. Establecer el layout necesario. Cuando hemos planificado los puntos anteriores, ya estamos en condiciones de saber los espacios que vamos a necesitar: una parte exclusiva para los racks de los servidores, una sala UPS, un espacio para las comunicaciones, otra sala para la preparación de equipos… Elección del lugar de emplazamiento. Como puedes ver, no es nada fácil tener tu propio data center en cualquier edificio. Si quieres crear un data center tipo Tier 4, la norma ANSI/TIA-942 te obliga a tener un edificio entero. Los Tier 3, 2 y 1 sí pueden establecerse dentro de un edificio, aunque ateniéndose a unas normas de seguridad y requisitos concretos. Establecer sistemas de control y seguridad. Vas a invertir un alto precio en hardware, pero no sólo eso. Eres responsable de una enorme cantidad de datos de clientes externos (o de tu empresa), almacenados en tus servidores. Por tanto, deberás implementar un sistema de seguridad que proteja tanto el hardware como el software de tu data center. Presupuestar el proyecto. Habida cuenta de todo lo anterior, hay que crear una relación con todos los costes que va a tener el data center, incluyendo los gastos de personal externo y especializado, así como remodelaciones de las salas o edificios, etc. Confeccionar el proyecto de construcción. El proyecto incluirá la descripción técnica de todo el equipo que se va a necesitar, pero también por planos de construcción, sistema eléctrico, cañerías, ventilación, etc. Aunque necesitas mucha más información que lo que te hemos dado aquí, estos pasos te ayudarán a tener una idea más clara de cómo se monta un data center. Muchas empresas tienen claro que es una inversión demasiado elevada y fuera de sus posibilidades, aparte de que incluso el data center más básico puede superar mucho las necesidades de cierto tipo de negocios. La opción más habitual para la inmensa mayoría de empresas que no se dedican a vender espacio web o aplicaciones en la nube es sin duda trabajar con proveedores de alojamiento. Boletín Electrónico Nº 002 Un Data Center también es llamado sala de servidores, infosala, centro de datos, nic, sala de máquinas, centro de cómputo, entre otras. Es el sitio más importante de una red de datos. No es construido de cualquier manera, sino, hay estándares que hay que tener en cuenta a la hora implementarlo. Introducción El diseño de un data center involucra varias especialidades, como: Ingeniería de redes, electricidad, cableado estructurado, seguridad de acceso y ambiental, entre los principales. El datacenter es el lugar donde se instalan todos equipos de comunicaciones, servidores, sistemas de almacenamiento de una empresa. No es simplemente una sala de equipo electrónicos, es un lugar que hay que diseñarlo siguiendo los estándares internacionales. Directo a la Sangre ¿Qué son los Tiers? El concepto de Tier nos indica el nivel de fiabilidad de un centro de datos asociados a cuatro niveles de disponibilidad definidos. A mayor número en el Tier, mayor disponibilidad, y por lo tanto mayores costes asociados en su construcción y más tiempo para hacerlo. Al día de hoy se han definido cuatro Tier diferentes, y ordenados de menor a mayor son: Tier1, Tier2, Tier3, Tier4. Este sistema de clasificación fue inventado por el Uptime Institute para clasificar la fiabilidad (y también para hacer negocio certificando los centros de datos, claro está). Si estás buscando un servicio de alojamiento de servidores, colocación, etc. verás que los diferentes proveedores te ofrecen información de lo más variada sobre sus características y te ofrecen datos interesantes como niveles de redundancia, tamaño del centro de datos, tiempos de respuesta y demás. Existe un estándar llamado ANSI/TIA-942 Telecommunications Infrastructure Standard for Data Centers, creado por miembros de la industria, consultores y usuarios, que intenta estandarizar el proceso de diseño de los centros de datos. El estándar está orientado a ingenieros y expertos en la materia. Informe Técnico Tier 1: Centro de datos Básico: Disponibilidad del 99.671%. El servicio puede interrumpirse por actividades planeadas o no planeadas. No hay componentes redundantes en la distribución eléctrica y de refrigeración. Puede o no puede tener suelos elevados, generadores auxiliares o UPS. Tiempo medio de implementación, 3 meses. La infraestructura del datacenter deberá estar fuera de servicio al menos una vez al año por razones de mantenimiento y/o reparaciones. Tier 2: Centro de datos Redundante: Disponibilidad del 99.741%. Menos susceptible a interrupciones por actividades planeadas o no planeadas. Componentes redundantes (N+1) Tiene suelos elevados, generadores auxiliares o UPS. Conectados a una única línea de distribución eléctrica y de refrigeración. De 3 a 6 meses para implementar. El mantenimiento de esta línea de distribución o de otras partes de la infraestructura requiere una interrupción de las servicio. Tier 3: Centro de datos Concurrentemente Mantenibles: Disponibilidad del 99.982%. Permite planificar actividades de mantenimiento sin afectar al servicio de computación, pero eventos no planeados pueden causar paradas no planificadas. Componentes redundantes (N+1) Conectados múltiples líneas de distribución eléctrica y de refrigeración, pero únicamente con una activa. De 15 a 20 meses para implementar. Hay suficiente capacidad y distribución para poder llevar a cabo tareas de mantenimiento en una línea mientras se da servicio por otras. Tier 4: Centro de datos Tolerante a fallos: Disponibilidad del 99.995%. Permite planificar actividades de mantenimiento sin afectar al servicio de computación críticos, y es capaz de soportar por lo menos un evento no planificado del tipo ‘peor escenario’ sin impacto crítico en la carga. Conectados múltiples líneas de distribución eléctrica y de refrigeración con múltiples componentes redundantes (2 (N+1) significa 2 UPS con redundancia N+1). De 15 a 20 meses para implementar. Por ejemplo, si en la publicidad de un proveedor presume de ser Tier 3, lo que nos está diciendo es que su infraestructura no fallará más de 1.6 horas al año, que no hay interrupciones por mantenimientos planificados y que puede haber eventos inesperados que causen interrupciones del servicio. Hay que recalcar que se refiere a la infraestructura del centro de datos, y que otros aspectos como la disponibilidad de los equipos que van dentro del datacenter se gestionan aparte. Claro está, es lo que dicen en la publicidad. Ahora, ¿podemos exigir en nuestro SLA un Tier determinado? Pues me temo que la cosa no es tan sencilla, ya que el uso de los Tiers se está usando para publicitar capacidades sin que haya una certificación oficial de ello en la mayoría de los casos. De hecho, el Uptime Institute solo ha certificado unos cuantos Centros de Datos en todo el mundo en los niveles 3 y 4. Por cierto ninguno en España. Así que dudo que un proveedor pueda o quiera realmente garantizar un Tier determinado por contrato. Además, muchos consideran inflexible esta clasificación por ser demasiado cerrada. ¿Ahora te has pregunta que Tier tiene el data center que administras? Consultas On-Line ¿Cómo se puede monitorear el consumo de ancho de banda? El consumo de ancho de banda se puede monitorear en tiempo real utilizando la herramienta mrtg. Esta herramienta se puede instalar en una PC bajo Windows o Linux, yo recomiendo sobre Linux. La instalación es fácil. En esta dirección URL puedes encontrar el instalador: http://oss.oetiker.ch/mrtg/doc/index.en.html Preguntas ¿Qué institución invento el sistema de clasificación TIER? ¿Qué estándar se utiliza para el diseño de datacenter? Respuestas Boletín 001: ¿En que nivel del modelo OSI trabaja un switch? El switch trabaja en el nivel 2 del modelo OSI ¿Si la máscara de una sub red es 27 bits, cuantas direcciones IP tiene la subred? Para una máscara de 27 bits existen 2^5-2=30 IPs Glosario RACK: Un rack es un soporte metálico destinado a alojar equipamiento electrónico, informático y de comunicaciones. Las medidas para la anchura están normalizadas para que sean compatibles con equipamiento de cualquier fabricante. También son llamados bastidores, cabinets o armarios.