INTRODUCCION - Biblioteca Central de la Universidad Nacional

Anuncio

Universidad Nacional del Santa

Curso: Teoría de Compiladores

INTRODUCCION

La computadora es la máquina más versátil concebida por el hombre. Aunque inicialmente es

construida como un mecanismo de cálculo de prestaciones superiores a los primeros dispositivos mecánicos

y electromecánicos, con el paso del tiempo se le incorporaron capacidades para la realización de operaciones

lógicas y para la manipulación de datos no numéricos. Un largo proceso evolutivo ha llevado a este

dispositivo calculador de la aritmética de cifras a la generación de información, teniendo como meta

inmediata la manipulación del conocimiento y como objetivo futuro la generación de conciencia.

Las actuales computadoras son capaces de realizar los más complejos cálculos aritméticos, lógicos y

simbólicos, de emular los más elaborados mecanismos (incluyendo a otros computadores), de simular

eventos naturales y de crear mundos virtuales. Las crecientes capacidades con que se presentan generación

tras generación acercan a los nuevos computadores cada vez más a la realización de tareas mucho más

complejas y que se antojan imposibles, como pueden ser la emulación de la mente y el pensamiento.

Todo esto se sustenta, por supuesto, en la electrónica y en la capacidad de programación del computador.

Sabemos que la electrónica del computador se denomina digital y que funciona con base en valores

discretos. Sabemos que es a través de códigos y estrategias de representación de datos como podemos

alimentar al computador con nuestras ideas y las expresiones con que identificamos a los objetos en nuestro

mundo análogo y tridimensional. También sabemos que mediante reglas de operación perfectamente

definidas podemos instruir al computador en la manipulación de dichos datos que llevarán a la generación

de otros y a la obtención de información en la resolución de problemas. La forma de expresar dicha

instrucción y la manera de llevar a cabo su traducción a lo que el computador es realmente capaz de

procesar son el tema de este curso.

El tema del diseño de compiladores es usualmente visto como uno de los más complejos, áridos y

abstractos. Adicionalmente suele considerarse que estos temas no dejan de ser de un interés meramente

académico, a menos que se trate de una enorme compañía de software dedicada a la creación de

herramientas de desarrollo. Tales creencias han dado lugar a una enorme variedad de mitos, algunos de

estos por ejemplo son:

"Para competir con productos de calidad en un mercado tan dinámico, amplio e internacional como

es el de la informática y computación, se requiere de una enorme cantidad de recursos humanos,

materiales y económicos. El desarrollo de herramientas de programación como intérpretes y

compiladores, ya sea para uso propio o comercialización, está reservado para las empresas que

disponen de dichos recursos. La mediana y pequeña empresa no cuenta con los recursos necesarios

para desarrollos internos de esta naturaleza, además de que no los necesita; si se trata de empresas

dedicadas al desarrollo de programas su mercado o está únicamente en el campo de la consultoría y

el desarrollo de sistemas a la medida o programación por contrato."

"El conocimiento teórico asociado con el diseño y creación de compiladores y lenguajes de

programación no son necesarios para un gerente de sistemas o líder de proyecto, esto es sólo para

el académico, lo importante es estar al día en lo que a tendencias y productos de hardware y

software se refiere."

Docente: Ing. Mirko Manrique Ronceros

~1~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

"Las actividades en informática y computación en nuestro país están dedicadas al desarrollo de

software administrativo en su mayoría. Es poco probable que los profesionistas en estas áreas se

enfrenten al reto del desarrollo de un compilador o de un lenguaje de programación."

"Es más barato comprar software que desarrollarlo. Desarrollar software es lento y caro, es más

rápido comprar algo hecho."

"El diseño de compiladores y lenguajes de programación es una actividad reservada para

investigadores y catedráticos en ciencias computacionales."

"Siempre hay que usar un compilador, el código fuente queda seguro y la ejecución es más rápida.

Los intérpretes no son adecuados para el desarrollo de sistemas de información, estos son sólo un

recurso para la programación de computadoras pequeñas y para el usuario final."

"Los compiladores son hechos por nerds o gurús de la computación que dominan obscuros

lenguajes de programación, programan en lenguaje máquina y tienen un profundo conocimiento de

la arquitectura del computador."

Aunque al final del curso se darán cuenta el porqué las aseveraciones anteriores deben ser consideradas

como falsas o imprecisas.

Lenguaje

C++,

Fortran,

COBOL,

Pascal

Java

Modelo

Compilado

AWK, Basic,

SQL, Lisp,

Forth

Interpretado

Pseudo

Compilado

Características

Sintaxis específica para tipos de datos. Ideal para el desarrollo de

programas veloces o de tamaño reducido. Permiten la explotación de

instrucciones especiales del microprocesador. Mayor seguridad para evitar

alteración o robo de código fuente.

Transportabilidad absoluta. Requiere de una máquina virtual para ser

ejecutado. Mejor desempeño que un programa interpretado pero más

lento que uno compilado. Lenguajes de sintaxis rigurosa.

Requiere del intérprete para su ejecución. Desempeño lento. Ideal para

desarrollos rápidos (prototipos), operaciones no planeadas y programas

pequeños y simples. Lenguajes de sintaxis más relajadas y mayor libertad

para la conversión de datos.

Con el paso del tiempo los diversos lenguajes de programación han madurado. Hoy en día es posible

categorizarlos por las características que han venido exhibiendo con dicha maduración. De manera que

tenemos:

1GL o lenguajes de primera generación.- Esta fue (y continua siendo) aquella a la que pertenece el

Lenguaje Máquina, el nivel en el que datos instrucciones son dados como una serie de códigos

(binarios, octales, decimales o hexadecimales).

2GL o lenguajes de segunda generación.- Todos aquellos lenguajes ensambladores.

3GL o lenguajes de tercera generación.- También conocidos como lenguajes de nivel alto.

4GL o lenguajes de cuarta generación.- Generalmente un lenguaje 4GL es un lenguaje de propósito

específico, que proveen un lenguaje muy cercano al lenguaje natural o simbólico manejado en un

ámbito específico. Muchos lenguages son llamados 4GL cuando en realidad sólo son una mezcla de

3GL y 4GL o 3GL con extensiones de de dominio especícifico. Por ejemplo, el comando list en dBASE

es un comando propio de un 4GL pero las aplicaciones programadas en dBASE son 3GL. El siguiente

Docente: Ing. Mirko Manrique Ronceros

~2~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

ejemplo ilustra la diferencia de una sintaxis 3GL y 4GL para abrir un registro de clientes y mostrar su

contenido en pantalla.

5GL o lenguajes de quinta generación.- Estos lenguajes comienzan a ser identificados como

aquellos que hacen uso de los ambientes gráficos para llevar a cabo la programación del

computador a través de iconos o elementos gráficos similares.

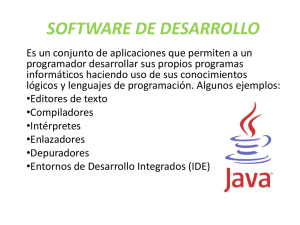

COMPILADORES Y PROGRAMAS RELACIONADOS: DEFINICIONES Y CONCEPTOS

Aunque es equivocado, es común encontrar referencias en documentación de productos, publicidad

y textos (e inclusive escuchar a la gente del medio informático) utilizando los términos traductor,

compilador e intérprete de una forma libre e indistinta. Estas palabras no se utilizan para identificar de

manera genérica a un programa que nos permitiría poder programar una computadora. Debemos ser

precisos al emplear estas palabras, ya que se refieren a programas de distinta naturaleza que realizan

labores encaminadas a un objetivo específico y particular. Aunque la conducta manifestada pueda ser

similar, su comportamiento interno definitivamente es diferente.

Genéricamente hablando, en ciencias de la computación, los procesadores de lenguajes son aquellos

programas destinados a trabajar sobre una entrada que, por la forma como ha sido elaborada, pertenece a

un lenguaje en particular reconocido o aceptado por el programa en cuestión. Los procesadores de

lenguajes se clasifican como traductores o intérpretes.

TRADUCTOR

Un traductor es un programa que recibe una entrada escrita en un lenguaje (el lenguaje fuente) a una salida

perteneciente a otro lenguaje (el lenguaje objeto), conservando su significado. En términos computacionales

esto significa que tanto la entrada como la salida sean capaces de producir los mismos resultados.

INTERPRETE

Un intérprete, por otra parte, no lleva a cabo tal transformación; en su lugar obtiene los resultados conforme

va analizando la entrada.

Los intérpretes son útiles para el desarrollo de prototipos y pequeños programas para labores no previstas.

Presentan la facilidad de probar el código casi de manera inmediata, sin tener que recurrir a la declaración

previa de secciones de datos o código, y poder hallar errores de programación rápidamente. Resultan

inadecuados para el desarrollo de complejos o grandes sistemas de información por ser más lentos en su

ejecución.

Los traductores son clasificados en compiladores, ensambladores y preprocesadores.

Compiladores

Un compilador es un programa que recibe como entrada un programa escrito en un lenguaje de nivel medio

o superior (el programa fuente) y lo transforma a su equivalente en lenguaje ensamblador (el programa

objeto), e inclusive hasta lenguaje máquina (el programa ejecutable) pero sin ejecutarlo. Un compilador es

un traductor. La forma de como llevará a cabo tal traducción es el objetivo central en el diseño de un

compilador.

Docente: Ing. Mirko Manrique Ronceros

~3~

Universidad Nacional del Santa

Programa

Fuente

Curso: Teoría de Compiladores

Compilado

r

Programa

Objeto

Un compilador es un programa muy complejo con un número de líneas de código que puede variar de

10,000 a 1,000.000. Escribir un programa de esta naturaleza o incluso comprenderlo, no es tarea fácil, y la

mayoría de los científicos y profesionales de la computación nunca escribirán un compilador completo.

Ensamblador

Un ensamblador es el programa encargado de llevar a cabo un proceso denominado de ensamble o

ensamblado. Este proceso consiste en que, a partir de un programa escrito en lenguaje ensamblador, se

produzca el correspondiente programa en lenguaje máquina (sin ejecutarlo), realizando:

La integración de los diversos módulos que conforman al programa.

La resolución de las direcciones de memoria designadas en el área de datos para el almacenamiento

de variables, constantes y estructuras complejas; así como la determinación del tamaño de éstas.

La identificación de las direcciones de memoria en la sección de código correspondientes a los

puntos de entrada en saltos condicionales e incondicionales junto con los puntos de arranque de las

subrutinas.

La resolución de los diversos llamados a los servicios o rutinas del sistema operativo, código

dinámico y bibliotecas de tiempo de ejecución.

La especificación de la cantidad de memoria destinada para las áreas de datos, código, pila y

montículo necesarios y otorgados para su ejecución.

La incorporación de datos y código necesarios para la carga del programa y su ejecución.

Precompilador

Un precompilador, también llamado preprocesador, es un programa que se ejecuta antes de invocar al

compilador. Este programa es utilizado cuando el programa fuente, escrito en el lenguaje que el compilador

es capaz de reconocer (de aquí en adelante denominado lenguaje anfitrión-- en inglés host language),

incluye estructuras, instrucciones o declaraciones escritas en otro lenguaje (el lenguaje empotrado-- en

inglés embeded language). El lenguaje empotrado es siempre un lenguaje de nivel superior o especializado

(e.g. de consulta, de cuarta generación, simulación, cálculo numérico o estadístico, etcétera). Siendo que el

único lenguaje que el compilador puede trabajar es áquel para el cual ha sido escrito, todas las instrucciones

del lenguaje empotrado deben ser traducidas a instrucciones del lenguaje anfitrión para que puedan ser

compiladas. Así pu es un precompilador también es un traductor.

Los precompiladores son una solución rápida y barata a la necesidad de llevar las instrucciones de nuevos

paradigmas de programación (e.g. los lenguajes de cuarta generación), extensiones a lenguajes ya

existentes (como el caso de C y C++) y soluciones de nivel conceptual superior (por ejemplo paquetes de

simulación o cálculo numérico) a código máquina utilizando la tecnología existente, probada, optimizada y

confiable (lo que evita el desarrollo de nuevos compiladores). Facilitan la incorporación de las nuevas

herramientas de desarrollo en sistemas ya elaborados (por ejemplo, la consulta a bases de datos

relacionales substituyendo las instrucciones de acceso a archivos por consultas en SQL).

Docente: Ing. Mirko Manrique Ronceros

~4~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

Resulta común encontrar que el flujo de proceso en los lenguajes de cuarta generación o de propósito

especial puede resultar demasiado inflexible para su implantación en los procesos de una empresa, flujos de

negocio o interacción con otros elementos de software y hardware, de aquí que se recurra o prefiera la

creación de sistemas híbridos soportados en programas elaborados en lenguajes de tercera generación con

instrucciones empotradas de nivel superior o propósito especial.

Pseudocompilador

Un pseudocompilador es un programa que actúa como un compilador, salvo que su producto no es

ejecutable en ninguna máquina real sino en una máquina virtual. Un pseudocompilador toma de entrada un

programa escrito en un lenguaje determinado y lo transforma a una codificación especial llamada código de

byte. Este código no tendría nada de especial o diferente al código máquina de cualquier microprocesador

salvo por el hecho de ser el código máquina de un microprocesador ficticio. Tal procesador no existe, en su

lugar existe un programa que emula a dicho procesador, de aquí el nombre de máquina virtual.

La ventaja de los pseudocompiladores que permite tener tantos emuladores como microprocesadores reales

existan, pero sólo se requiere un compilador para producir código que se ejecutará en todos estos

emuladores. Este método es una de las respuestas más aceptadas para el problema del tan ansiado

lenguaje universal o código portable independiente de plataforma.

Un intérprete es un programa que ejecuta cada una de las instrucciones y declaraciones que encuentra

conforme va analizando el programa que le ha sido dado de entrada (sin producir un programa objeto o

ejecutable). La ejecución consiste en llamar a rutinas ya escritas en código máquina cuyos resultados u

operaciones están asociados de manera unívoca al significado de la instrucciones o declaraciones

identificadas.

Ligadores

Tanto los compiladores como los ensambladores a menudo dependen de un programa conocido como

ligador, el cual recopila el código que se compila o ensambla por separado en diferentes archivos objetos, a

un archivo que es directamente ejecutable. En este sentido, puede hacerse una distinción entre código

objeto (código máquina que todavía no se ha ligado) y código de máquina ejecutable. Un ligador también

conecta un programa objeto con el código de funciones de librerías estándar, así como con recursos

suministrados por el sistema operativo de la computadora, tales como asignadotes de memoria y

dispositivos de entrada y salida. Es interesante advertir que los ligadores ahora realizan la tarea que

originalmente era una de las principales actividades de un compilador (de aquí el uso de la palabra

compilador: construir mediante la recopilación o compilación de fuentes diferentes).

Cargadores

Con frecuencia un compilador, ensamblador o ligador producirá un código que todavía no está

completamente organizado y listo para ejecutarse, pero cuyas principales referencias de memoria se hacen

relativas a una localidad de arranque indeterminada que puede estas en cualquier sitio de la memoria. Se

dice que tal código es relocalizable y un cargador resolverá todas las direcciones relocalizables relativas a

una dirección base, o de inicio, dada.

Docente: Ing. Mirko Manrique Ronceros

~5~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

El uso de un cargador hace mas flexible el código ejecutable, pero el proceso de carga con frecuencia ocurre

en segundo plano (como parte del entorno operacional) o conjuntamente con el ligado. Rara vez un

cargador es en realidad un programa por separado.

Editores

Los compiladores por lo regular aceptan programas fuente escritos utilizando cualquier editor que pueda

producir un archivo estándar, tal como un archivo ASCII. Más recientemente, los compiladores han sido

integrados junto con los editores y otros programas en un ambiente de desarrollo interactivo o IDE. En un

caso así, un editor, mientras que aún produce archivos estándar, puede ser orientado hacia el formato o

estructura del lenguaje de programación en cuestión. Tales editores se denominaban basados en estructura

y ya incluyen algunas de las operaciones de un compilador, de manera que, por ejemplo, pueda informarse

al programador de los errores a medida que el programa se vaya escribiendo en lugar de hacerlo cuando

está compilado. El compilador y sus programas acompañantes también pueden llamarse desde el editor, de

modo que el programador pueda ejecutar el programa sin tener que abandonar el editor.

Depuradores

Un depurador es un programa que puede utilizarse para determinar los errores de ejecución en un programa

compilado. A menudo está integrado en un IDE. La ejecución de un programa con un depurador se

diferencia de la ejecución directa en que el depurador se mantiene al tanto de la mayoría o la totalidad de la

información sobre el código fuente, tal como los números de línea y los nombres de las variables y

procedimientos. También

puede

detener la

ejecución en ubicaciones previamente

especificadas

denominadas puntos de ruptura, además de proporcionar información de cuáles funciones se ha invocado y

cuáles son los valores actuales de las variables. Para efectuar estas funciones el compilador debe suministrar

al depurador la información simbólica apropiada, lo cual en ocasiones puede ser difícil, en especial en un

compilador que intente optimizar el código objeto. De este modo, la depuración se convierte en una cuestión

de compilación.

Perfiladores

Es un programa que recolecta estadísticas sobre el comportamiento de un programa objeto durante la

ejecución. Las estadísticas típicas que pueden ser de interés para el programador son el número de veces

que se llama cada procedimiento y el porcentaje de tiempo de ejecución que se ocupa cada uno de ellos.

Tales estadísticas pueden ser muy útiles para ayudar al programador a mejorar la velocidad de ejecución del

programa. A veces el compilador utilizará incluso la salida del perfilador para mejorar de manera automática

el código objeto sin la intervención del programador.

PROCESO DE COMPILACION

Docente: Ing. Mirko Manrique Ronceros

~6~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

Un compilador se compone internamente de varias etapas, o fases que realizan distintas operaciones

lógicas. Es útil pensar en estas fases como piezas separadas dentro del compilador, y pueden en realidad

escribirse como operaciones codificadas separadamente aunque en la práctica a menudo se integren juntas.

Figura 1.- Etapas del proceso de compilación.

Docente: Ing. Mirko Manrique Ronceros

~7~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

La entrada a este proceso es por supuesto el programa fuente. Por lo general éste es un archivo que es

creado por el usuario como un texto ASCII con o sin un formato específico aunque también puede ser el

resultado de algún otro proceso. A partir de este archivo diversos pasos pueden ser llevados a cabo:

Preprocesamiento.- Un preprocesador es la estrategia generalmente adoptada como solución a

lenguajes huéspedes, extensiones, lenguajes 4GL, o lenguajes de dominio específico. El

preprocesador es un traductor encargado de transformar dichas instrucciones a instrucciones del

lenguaje anfitrión (generalmente un tradicional 3GL) sobre las cuales finalmente trabajará el

compilador. Esta etapa es definitivamente opcional.

Análisis Léxico.- En esta fase, la cadena de caracteres que conforma al programa fuente es

despojada de comentarios, espacios en blanco y otros elementos superfluos. El programa encargado

de hacer esto es conocido como un scanner, y de aquí que al proceso se le refiera comúnmente

como scanning (exploración). Durante esta fase se identifican los elementos gramaticales usados en

la creación del programa. Cada elemento identificado es substituido por un código numérico

conocido como token.

Análisis Sintáctico.- La cadena de tokens resultante es alimentada a un programa conocido como

parser. El parser es el encargado de verificar que la secuencia y disposición de los tokens

corresponda con la sintaxis del lenguaje. Este proceso de verificación sintáctica es conocido como

parsing y es completamente guiado por la gramática del lenguaje.

Análisis Semántico y Generación de Código.- Una vez que la secuencia de tokens ha sido

validada, ésta es utilizada para identificar el sentido de la acción a realizar y generar el

correspondiente código en lenguaje máquina. Algunos compiladores recurren a la creación de código

intermedio para posteriormente generar la secuencia de instrucciones máquinas necesarias,

mientras que algunos otros proceden a la generación directa del código máquina.

Optimización de Código.- Esta es otra etapa opcional. La optimización de código es una actividad

que raya en un arte dominado solamente por un experimentado programador de ensamblador y

conocedor de la arquitectura del computador. Existen algunas técnicas desarrolladas al respecto

pero nada supera a la experiencia de un hábil programador. En esta etapa, ya sea posteriormente o

trabajando al unísono con el generador de código, secuencias de instrucciones y estructuras de

datos son examinadas buscando su substitución con secuencias, instrucciones o estructuras más

cortas, rápidas o eficientes.

Ligado.- Como paso final, todas las referencias pendientes de resolver sobre rutinas, módulos,

bibliotecas y dem´s porciones de código necesarias para el funcionamiento del programa son

cubiertas en esta parte. La resolución puede consistir desde el proporcionar meramente una

dirección o llamado a una función hasta la inclusión de enormes porciones de código.

Al final, como producto de todo este proceso, lo que se obtiene es un programa escrito en código máquina

que puede ser cargado en memoria y ejecutado. El proceso seguido por un intérprete es ligeramente

diferente, ya que mientras que cubre todas las etapas de análisis no cuenta con una fase síntesis. Un

intérprete no genera código, se limita a invocar rutinas ya escritas (proceso muchas veces llamado de

interpretación). La siguiente figura ilustra esto.

Docente: Ing. Mirko Manrique Ronceros

~8~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

Figura 2.- Etapas del proceso de interpretación

En el caso de un pseudo-compilador, cuyo caso mejor conocido es el de Java, la diferencia

consiste en el código generado. Mientras que todas las etapas de un compilador son cubiertas, el

programa ejecutable no es creado para ser ejecutado en un procesador "real" sino para uno

"hipotético" o "imaginario" y conocido generalmente como máquina virtual. La máquina virtual es

otro programa cuyo funcionamiento simula al de un procesador. Este procesador recibe de entrada

el pseudo-código creado por el compilador y procede a la ejecución de las instrucciones contenidas

en éste; puede verse que no se trata más que de un intérprete muy sencillo.

Figura 3.- Etapas del proceso de pseudo-compilación.

Docente: Ing. Mirko Manrique Ronceros

~9~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

La siguiente figura ilustra con mayor detalle lo que pasa en cada una de las etapas del proceso de

compilación. El procesamiento de instrucciones de un lenguaje huesped (como puede ser SQL) correría a

cargo del pre-procesador, siendo transformadas instrucciones del lenguaje anfitrión. Durante la fase de

análisis léxico el scanner se encarga de identificar cada uno de los elementos usados para escribir el

programa fuente, substituyendo a cada uno de estos por un código numérico único (tokens). En este

proceso se eliminan comentarios y espacios en blanco. Los tokens son alimentados al analizador sintáctico

que valida que su disposición está acorde a las reglas del lenguaje. Validado este el analizador semántico

procede a identificar el propósito de las diversas secuencias de tokens y buscará generar representaciones

intermedias de cada acción o directamente código máquina. Este posteriormente es optimizado.

Figura 4.- Detalle del flujo de datos y acciones en el proceso de compilación.

Docente: Ing. Mirko Manrique Ronceros

~ 10 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

AMBIENTES DE COMPILACION

Los compiladores a menudo producen como resultado del análisis semántico, una forma de

representación intermedia del código fuente. Hoy en día, es cada vez más común que, en

ambientes de estación de trabajo o de computador central, todos los compiladores de los distintos

lenguajes generen el mismo código intermedio, el cual después, por un generador de código, es

transformado en el código objeto.

Esto tiene una gran ventaja: si se cambia el sistema operativo o alguna otra cosa, solo hay que

reemplazar el generador de código, y no todo todos los compiladores. La generación de códigos

intermedios aumenta la transportabilidad de los compiladores, ya que no es necesario cambiar sus

partes independientes de la máquina para un nuevo hardware distinto.

CODIGO FUENTE

CODIGO INTERMEDIO

CODIGO HEXADECIMAL

Int suma_enteros( int i,j, suma)

*SECTION 9 Define la sección de código.

00000000 222F 0004

{

* SECTION 14 define la sección de Pila

00000004 202F 0008

SECTION 9

00000008 206F 000C

xDEF .suma_enteros

0000000C D081

MOVE.L 4(A7), D1

0000000E 2080

MOVE.L 8(A7), D0

00000010 4E75

suma=i+j;

}

MOVE.L 12(A7).A0

ADD.L D1,D0

MOVE.L D0(A0)

RTS

* SECTION 14

* Asignaciones de suma_enteros

* 4(A7)

.i

* 8(A7)

.j

* 12(a7) .suma

ANALISIS Y SINTESIS

La compilación de un programa consiste en analizar y sintetizar dicho programa, es decir,

determinar la estructura y el significado de un código fuente y traducir ese código fuente a un

código de máquina equivalente.

Las tareas o fases principales de un compilador son:

Análisis léxico.

Análisis sintáctico.

Análisis semántico.

Generación de código.

Podemos considerar a un programa como un flujo de caracteres que sirven como entrada para el

análisis léxico. La tarea del análisis léxico consiste en reconocer los componentes léxicos dentro de

ese flujo, es decir, transformar un flujo de caracteres en un flujo de componentes léxicos (como

Docente: Ing. Mirko Manrique Ronceros

~ 11 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

los textos en lenguaje natural, podemos distinguir entre palabras y componentes léxicos: el

número de palabras determina el tamaño del vocabulario del programa, mientras que el número

de componentes léxicos determina la longitud del programa.

Por ejemplo: La proposición i:= 10;

Producirá lo siguiente:

el identificador i

el símbolo de asignación :=

el número 10

el símbolo delimitador; (punto y coma)

Los identificadores o nombres reconocidos se organizan en una tabla de símbolos, que es una

estructura de datos que contiene registros con campos de atributo para cada nombre.

El contenido de la tabla de símbolos se completa con el análisis léxico y sintáctico y se usará para

el análisis semántico y la generación de código.

El siguiente paso es el análisis sintáctico. La palabra “Sintaxis” significa “estructura del orden de

las palabras en una frase”. Otro término utilizado para el análisis sintáctico es el análisis

jerárquico. La tarea del análisis sintáctico es revisar si los símbolos aparecen en el orden correcto

(es decir, revisar si el programa fuente fue diseñado de acuerdo con la sintaxis del lenguaje de

programación) y combina los símbolos del código fuente para formar unidades gramaticales.

En esta fase se detectan errores de sintaxis como:

h + x := x * y

En general, las unidades gramaticales se organizan y representan con árboles

de análisis

sintáctico o árboles sintácticos.

En la siguiente figura se muestra el árbol de análisis sintáctico de la siguiente proposición:

h:= x + y – x * y

Asignación

identificador

expresión

identificador

expresión

identificador

expresión

identificador

h

:=

x

+

Docente: Ing. Mirko Manrique Ronceros

y

–

x

expresión

*

y

~ 12 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

Después del análisis semantico y el de tipos. El análisis semantico es mucho más difícil que el

sintáctico, pues hay que considerar el significado de una unidad gramatical; es decir hay que

interpretarla. Esto se puede lograr traduciendo la entrada a una forma de representación

intermedia. Por ejemplo, nunca hubiéramos definido la variable h de la figura, la proposición de

asignación no tendría sentido. En forma análoga, la asignación de una variable booleana a una

variable real tampoco tendrá sentido. Este tipo de inconsistencias será reconocido por el análisis

de tipos.

El código objeto se genera en la última fase de la compilación: el generador de código. En esta

fase el código intermedio se transforma en código de maquina y la memoria necesaria quedara

determinada. Obviamente, esta es la única fase que depende del hardware, ya que por lo general,

los conjuntos de instrucciones varían de un computador a otro.

Ambigüedad

Se ha de tener cuidado al considerar la estructura de una cadena según una gramática. Aunque

es evidente que cada árbol de análisis sintáctico deriva exactamente la cadena que leer en sus

hojas, una gramática puede tener más de un árbol de análisis sintáctico que genere una cadena

dada de componentes léxicos. Esta clase de gramática se dice que es ambigua. Para demostrar

que una gramática es ambigua, lo único que se requiere es encontrar una cadena de componentes

léxicos que tenga más de un árbol de análisis sintáctico. Como una cadena que cuenta con más de

un árbol de análisis sintáctico suele tener más de un significado, para aplicaciones de compilación

es necesario diseñar gramáticas no ambiguas o utilizar gramáticas ambiguas con reglas adicionales

para resolver las ambigüedades.

Por ejemplo, si se tiene la expresión 9 – 5 + 2 tiene ahora más de un árbol de análisis sintáctico.

Los dos árboles de 9 – 5 + 2 corresponden a dos formas de agrupamientos entre paréntesis de la

expresión : (9 – 5) + 2 y 9 – (5 + 2). Esta segunda forma de agrupamiento entre paréntesis da a

la expresión el valor de 2, en lugar del valor acostumbrado 6.

Asociatividad de operadores

Por convención, 9 + 5 + 2 es equivalente a (9 + 5) + 2, y 9 – 5 – 2 es equivalente a (9 – 5) – 2.

Cuando un operando con 5 tiene operadores a su izquierda y derecha, se necesitan convenciones

para decidir que operador considera es operando. Se dice que el operador + asocia a la izquierda,

porque un operando que tenga un signo + a ambos lados es tomado por el operador que esté a

su izquierda. En la mayoría de los lenguajes de programación, los cuatro operadores matemáticos,

adición, sustracción, multiplicación y división son asociativos a la izquierda.

Docente: Ing. Mirko Manrique Ronceros

~ 13 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

Algunos operadores comunes, como la exponenciacion son asociativos por la derecha. Otro

ejemplo análogo, el operador de asignación = en C es asociativo por la derecha; en C la expresión

a = b = c; con un operador asociativo por la derecha, son generadas por la siguiente gramática:

derecha

letra = derecha | letra

letra

a|b|...|z

El contraste entre un árbol de análisis sintáctico para un operador asociativo por la izquierda como

– y un árbol de análisis sintáctico para un operador asociativo por la derecha como =, se muestra

la siguiente figura:

expresión

expresión

expresión –

digito

–

digito

derecha

digito

2

5

letra

a

=

derecha

letra

b

9

=

derecha

letra

c

Procedencia de operadores

Considere la expresión 9 + 5 * 2. Hay dos interpretaciones posibles de esta expresión: (9 + 5) * 2

o 9 + (5 * 2). La asociatividad de + y * no resuelve esta ambigüedad. Por esta razón, se necesita

conocer la precedencia relativa de los operadores cuando esté presente más de una clase de

operadores.

Se dice que * tiene mayor precedencia que + si * considera sus operandos antes que lo haga +.

En aritmética elemental, la multiplicación y división tiene mayor precedencia que la adición y

sustracción. Por tanto 5, es considerado por * en 9 + 5 * 2 y en 9 * 5 + 2; es decir las

expresiones son equivalentes a 9 + (5 * 2) y (9 * 5) + 2, respectivamente.

TRADUCCION DIRIGIDA POR LA SINTAXIS

Para traducir una construcción de un lenguaje de programación, un compilador puede necesitar

tener en cuenta muchas características, además del código generado para la construcción. Por

ejemplo, puede ocurrir que el compilador necesite conocer el tipo de la construcción, la posición

de la primera instrucción del código objeto o el numero de instrucciones generadas. Por tanto, los

atributos asociados con las construcciones se mencionan de manera abstracta. Un atributo puede

representar cualquier cantidad, por ejemplo, una expresión, una cadena, una posición de memoria

o cualquier otra cosa.

Docente: Ing. Mirko Manrique Ronceros

~ 14 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

Notación Posfija

La notación posfija de una expresión E se puede definir de manera inductiva como sigue:

Si E es una variable o una constante, entonces la notación posfija de E es también E.

Si E es una expresión de la forma E1 op E2, donde op es cualquier operador binario,

entonces la notación posfija de E es E’1E’2op, donde E’1 y E’2 son las notación posfijas de

E1 y E2 respectivamente.

Si E es una expresión de la forma (E1), entonces la notación posfija de E1 es también la

notación posfija de E.

La notación posfija no necesita paréntesis, porque la posición y la ariedad (numero de

argumentos) de los operadores permiten solo una descodificación de una expresión posfija. Por

ejemplo, la notación posfija de (9 – 5) + 2 es 95-2+ y la notación posfija de 9-(5+2) es 952+-.

Docente: Ing. Mirko Manrique Ronceros

~ 15 ~

Universidad Nacional del Santa

Docente: Ing. Mirko Manrique Ronceros

Curso: Teoría de Compiladores

~ 16 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

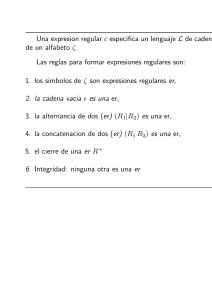

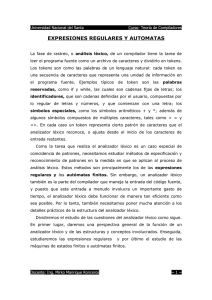

EXPRESIONES REGULARES Y AUTOMATAS

La fase de rastreo, o análisis léxico, de un compilador tiene la tarea de leer el

programa fuente como un archivo de caracteres y dividirlo en tokens. Los tokens son

como las palabras de un lenguaje natural: cada token es una secuencia de caracteres

que representa una unidad de información en el programa fuente. Ejemplos típicos de

token son las palabras reservadas, como if y while, las cuales son cadenas fijas de

letras; los identificadores, que son cadenas definidas por el usuario, compuestas por

lo regular de letras y números, y que comienzan con una letra; los símbolos

especiales, como los símbolos aritméticos + y *; además de algunos símbolos

compuestos de múltiples caracteres, tales como > = y <>. En cada caso un token

representa cierto patrón de caracteres que el analizador léxico reconoce, o ajusta

desde el inicio de los caracteres de entrada restantes.

Como la tarea que realiza el analizador léxico es un caso especial de coincidencia

de patrones, necesitamos estudiar métodos de especificación y reconocimiento de

patrones en la medida en que se aplican al proceso de análisis léxico. Estos métodos

son principalmente los de las expresiones regulares y los autómatas finitos. Sin

embargo, un analizador léxico también es la parte del compilador que maneja la

entrada del código fuente, y puesto que esta entrada a menudo involucra un

importante gasto de tiempo, el analizador léxico debe funcionar de manera tan

eficiente como sea posible. Por lo tanto, también necesitamos poner mucha atención a

los detalles prácticos de la estructura del analizador léxico.

Dividiremos el estudio de las cuestiones del analizador léxico como sigue. En primer

lugar, daremos una perspectiva general de la función de un analizador léxico y de las

estructuras y conceptos involucrados. Enseguida, estudiaremos las expresiones

regulares

y por último el estudio de las máquinas de estados finitos o autómatas

finitos.

EL PROCESO DEL ANÁLISIS LÉXICO

El trabajo del analizador léxico es leer los caracteres del código fuente y formarlos en

unidades lógicas para que lo aborden las partes siguientes del compilador

(generalmente el analizador sintáctico). Las unidades lógicas que genera el

analizador léxico se denominan tokens, y formar caracteres en tokens es muy

parecido a formar palabras a partir de caracteres en una oración en un lenguaje

Docente: Ing. Mirko Manrique Ronceros

~ 17 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

natural como el inglés o cualquier otro y decidir lo que cada palabra significa. En esto

se asemeja a la tarea del deletreo.

Los tokens son entidades lógicas que por lo regular se definen como un tipo

enumerado. Por ejemplo, pueden definirse en C como:

typedef enum

{IF,THEN,ELSE,PLUS,MINUS,NUM,ID,...}

TokenType;

Los tokens caen en diversas categorías, una de ellas la constituyen las palabras

reservadas, como IF y THEN, que representan las cadenas de caracteres "if' y

"then". Una segunda categoría es la de los símbolos especiales, como los símbolos

aritméticos MÁS y MENOS, los que se representan con los caracteres "+" y "—".

Finalmente, existen tokens que pueden representar cadenas de múltiples caracteres.

Ejemplos de esto son NUM e ID, los cuales representan números e identificadores.

Los tokens como entidades lógicas se deben distinguir claramente de las cadenas

de caracteres que representan. Por ejemplo, el token de la palabra reservada IF se

debe distinguir de la cadena de caracteres "if' que representa. Para hacer clara la

distinción, la cadena de caracteres representada por un token se denomina en

ocasiones su valor de cadena o su lexema. Algunos tokens tienen sólo un lexema:

las palabras reservadas tienen esta propiedad. No obstante, un token puede

representar un número infinito de lexemas. Los identificadores, por ejemplo, están

todos representados por el token simple ID, pero tienen muchos valores de cadena

diferentes que representan sus nombres individuales. Estos nombres no se pueden

pasar por alto, porque un compilador debe estar al tanto de ellos en una tabla de

símbolos. Por consiguiente, un rastreador o analizador léxico también debe construir

los valores de cadena de por lo menos algunos de los tokens.

EXPRESIONES REGULARES

Las expresiones regulares representan patrones de cadenas de caracteres. Una expresión

regular r se encuentra completamente definida mediante el conjunto de cadenas con las

que concuerda. Este conjunto se denomina lenguaje generado por la expresión

regular y se escribe como L(r), Aquí la palabra lenguaje se utiliza sólo para definir

"conjunto de cadenas" y no tiene (por lo menos en esta etapa) una relación específica con

un lenguaje de programación. Este lenguaje depende, en primer lugar, del conjunto de

caracteres que se encuentra disponible. En general, estaremos hablando del conjunto de

caracteres ASCII o de algún subconjunto del mismo. En ocasiones el conjunto será más

general que el conjunto de caracteres ASCII, en cuyo caso los elementos del conjunto se

Docente: Ing. Mirko Manrique Ronceros

~ 18 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

describirán como símbolos. Este conjunto de símbolos legales se conoce como alfabeto

y por lo general se representa mediante el símbolo griego Σ (sigma).

Una expresión regular r también contendrá caracteres del alfabeto, pero esos

caracteres tendrán un significado diferente: en una expresión regular todos los símbolos

indican patrones. En este capítulo distinguiremos el uso de un carácter como patrón

escribiendo todo los patrones en negritas. De este modo, a es el carácter a usado como

patrón.

Por último, una expresión regular r puede contener caracteres que tengan

significados especiales. Este tipo de caracteres se llaman metacaracteres o

metasímbolos, y por lo general no pueden ser caracteres legales en el alfabeto,

porque no podríamos distinguir su uso como metacaracteres de su uso como

miembros del alfabeto. Sin embargo, a menudo no es posible requerir tal exclusión,

por lo que se debe utilizar una convención para diferenciar los dos usos posibles de un

metacaracter. En muchas situaciones esto se realiza mediante el uso de un carácter

de escape que "desactiva" el significado especial de un metacaracter. Unos

caracteres de escape comunes son la diagonal inversa y las comillas. Advierta que los

caracteres de escape, si también son caracteres legales en el alfabeto, son por sí

mismos metacaracteres.

Docente: Ing. Mirko Manrique Ronceros

~ 19 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

Definición de expresiones regulares

Expresiones regulares básicas: Estas son precisamente los caracteres simples del

alfabeto, los cuales se corresponden a sí mismos. Dado cualquier carácter a del

alfabeto Σ, indicamos que la expresión regular a corresponde al carácter a escribiendo

L(a) = {a}. Existen otros dos símbolos que necesitaremos en situaciones especiales.

Necesitamos poder indicar una concordancia con la cadena vacía, es decir, la cadena

que no contiene ningún carácter. Utilizaremos el símbolo ε (épsilon) para denotar la

cadena vacía, y definiremos el metasímbolo ε (e en negritas) estableciendo que L(ε) =

{ ε } . También necesitaremos ocasionalmente ser capaces de describir un símbolo que

corresponda a la ausencia de cadenas, es decir, cuyo lenguaje sea el conjunto vacío,

el cual escribiremos como { }. Emplearemos para esto el símbolo φ y escribiremos

L(φ) = { }. Observe la diferencia entre { } y {ε}: el conjunto { } no contiene ninguna

cadena, mientras que el conjunto {ε} contiene la cadena simple que no se compone

de ningún carácter.

Operaciones de expresiones regulares: Existen tres operaciones básicas en las

expresiones regulares: 1) selección entre alternativas, la cual se indica mediante el

metacaracter

|

(barra

vertical);

2)

concatenación,

que

se

indica

medíante

yuxtaposición (sin un metacaracter), y 3) repetición o "cerradura", la cual se indica

mediante el metacaracter *. Analizaremos cada una por turno, proporcionando la

construcción

del

conjunto

correspondiente

para

los

lenguajes

de

cadenas

concordantes.

Selección entre alternativas: Si r y s son expresiones regulares, entonces r|s es una

expresión regular que define cualquier cadena que concuerda con r o con s. En

términos de lenguajes, el lenguaje de r | s es la unión de los lenguajes de r y s, o L(r

| s) = L(r) u L(s). Como un ejemplo simple, considere la expresión regular a | b: ésta

corresponde tanto al carácter a como al carácter b, es decir, L(a | b) = L(a) U L(b) =

{a} u {b} = {a, b}. Como segundo ejemplo, la expresión regular a | ε corresponde

tanto al carácter simple a como a la cadena vacía (que no está compuesta por ningún

carácter). En otras palabras, L(a | ε) = {a, ε}.

La selección se puede extender a más de una alternativa, de manera que, por

ejemplo, L(a | b | c | d) = {a, b, c, d}. En ocasiones también escribiremos largas secuencias

de selecciones con puntos, como en a | b | ... | z, que corresponde a cualquiera de las

letras minúsculas de la a a la z.

Concatenación: La concatenación de dos expresiones regulares r y s se escribe como rs, y

corresponde a cualquier cadena que sea la concatenación de dos cadenas, con la primera

Docente: Ing. Mirko Manrique Ronceros

~ 20 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

de ellas correspondiendo a r y la segunda correspondiendo a s. Por ejemplo, la expresión

regular ab corresponde sólo a la cadena ab, mientras que la expresión regular (a | b) c

corresponde a las cadenas ac y bc. (El uso de los paréntesis como metacaracteres en

esta expresión regular se explicará en breve).

Podemos describir el efecto de la concatenación en términos de lenguajes generados

al definir la concatenación de dos conjuntos de cadenas. Dados dos conjuntos de

cadenas S1 y S2, el conjunto concatenado de cadenas S1S2 es el conjunto de cadenas

de S1 complementado con todas las cadenas de S2. Por ejemplo, si S1 = {aa, b} y S2 =

{a, bb}, entonces S1S2 = {aaa, aabb, ba, bbb}. Ahora la operación de concatenación para

expresiones regulares se puede definir como sigue: L(rs)=L(r)L(s). De esta manera

(utilizando nuestro ejemplo anterior), L{(a | b) c) = L(a | b)L(c) = {a, b } { c ) = {ac,

bc}.

La concatenación también se puede extender a más de dos expresiones regulares: L(r¡

r2 . . . r„) = L(ri)L(r2) . . . L(rn) = el conjunto de cadenas formado al concatenar todas las

cadenas de cada una de las L(r1), . . . , L(rn).

Repetición: La operación de repetición de una expresión regular, denominada también en

ocasiones cerradura (de Kleene), se escribe r*, donde r es una expresión regular. La

expresión regular r* corresponde a cualquier concatenación finita de cadenas, cada una

de las cuales corresponde a r. Por ejemplo, a* corresponde a las cadenas e, a, aa, aaa,

.... (Concuerda con e porque e es la concatenación de ninguna cadena concordante con

a.) Podemos definir la operación de repetición en términos de lenguajes generados

definiendo, a su vez, una operación similar * para conjuntos de cadenas. Dado un

conjunto S de cadenas, sea:

S* = {e} uSuSSuSSSu...

Ahora podemos definir la operación de repetición para expresiones regulares como

sigue:

L{r*) = L(r)*

Considere como ejemplo la expresión regular (a | bb) *. (De nueva cuenta, la razón

de tener paréntesis como metacaracteres se explicará más adelante.) Esta expresión

regular corresponde a cualquiera de las cadenas siguientes: e, a, bb, aa, abb, bba,

bbbb, aaa, aabb y así sucesivamente. En términos de lenguajes, L( (a | bb) *) = L(a |

bb)* = [a, bb}* = {ε, a, bb, aa, abb, bba, bbbb, aaa, aabb, abba, abbbb, bbaa, . . .}.

Docente: Ing. Mirko Manrique Ronceros

~ 21 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

Precedencia de operaciones y el uso de los paréntesis La descripción precedente

no toma en cuenta la cuestión de la precedencia de las operaciones de elección,

concatenación y repetición. Por ejemplo, dada la expresión regular a | b*,

¿deberíamos interpretar esto como (a | b) * o como a|(b*) ? (Existe una diferencia

importante, puesto que L( (a |b) *) = {ε, a, b, aa, ab, ba, bb, .. .}, mientras que L(a

| (b*)) = {ε, a, b, bb, bbb, . . .}.) La convención estándar es que la repetición debería

tener mayor precedencia, por lo tanto, la segunda interpretación es la correcta. En

realidad, entre las tres operaciones, se le da al * la precedencia más alta, a la

concatenación se le da la precedencia que sigue y a la | se le otorga la precedencia

más baja. De este modo, por ejemplo, a | bc* se interpreta como a|(b (c * ) ),

mientras que ab | c*d se interpreta como (ab) | ( ( c * ) d ) .

Cuando deseemos indicar una precedencia diferente, debemos usar paréntesis para

hacerlo. Ésta es la razón por la que tuvimos que escribir (a|b)c para indicar que la

operación de elección debería tener mayor precedencia que la concatenación, ya que

de otro modo a | bc se interpretaría como si correspondiera tanto a a como a bc. De

manera similar, (a l bb) * se interpretaría sin los paréntesis como a | bb*, lo que

corresponde a a, b, bb, bbb, .... Los paréntesis aquí se usan igual que en aritmética,

donde (3 + 4) * 5 = 35, pero 3 + 4 * 5 = 23, ya que se supone que * tiene

precedencia más alta que +.

Nombres para expresiones regulares A menudo es útil como una forma de simplificar

la notación proporcionar un nombre para una expresión regular larga, de modo que no

tengamos que escribir la expresión misma cada vez que deseemos utilizarla. Por

ejemplo, si deseáramos desarrollar una expresión regular para una secuencia de uno

o más dígitos numéricos, entonces escribiríamos

(0|1|2| ... |9)(0|1|2| ... |9)* o podríamos escribir

dígito dígito* donde

dígito =

0I1I2I...I9

es una definición regular del nombre dígito.

El uso de una definición regular es muy conveniente, pero introduce la complicación

agregada de que el nombre mismo se convierta en un metasímbolo y se deba

encontrar un significado para distinguirlo de la concatenación de sus caracteres. En

nuestro caso hicimos esa distinción al utilizar letra cursiva para el nombre. Advierta

que no se debe emplear el nombre del término en su propia definición (es decir, de

manera recursiva): debemos poder eliminar nombres reemplazándolos sucesivamente

con las expresiones regulares para las que se establecieron.

Docente: Ing. Mirko Manrique Ronceros

~ 22 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

Antes de considerar una serie de ejemplos para elaborar nuestra definición de

expresiones regulares, reuniremos todas las piezas de la definición de una expresión

regular.

Una expresión regular es una de las siguientes:

1. Una expresión regular básica constituida por un solo carácter a, donde a proviene de

un alfabeto Σ de caracteres legales; el metacarácter ε ; o el metacarácter ε. En el primer caso, L(a) = {a}; en el segundo, L(ε) = {ε}; en el tercero, L(φ) = {}.

2. Una expresión de la forma r | s, donde r y s son expresiones regulares. En este caso,

L(r | s) = L(r) u L(s).

3. Una expresión de la forma rs, donde r y s son expresiones regulares. En este caso,

L(rs) = L(r)L(s).

4. Una expresión de la forma r*, donde r es una expresión regular. En este caso,

L(r*)=L(r)*.

5. Una expresión de la forma (r), donde r es una expresión regular. En este caso,

L((r)) = L(r). De este modo, los paréntesis no cambian el lenguaje, sólo se utilizan

para ajustar la precedencia de las operaciones.

Ejemplo1:

Consideremos el alfabeto simple constituido por sólo tres caracteres alfabéticos: Σ= {a,

b,c). También el conjunto de todas las cadenas en este alfabeto que contengan

exactamente una b. Este conjunto es generado por la expresión regular

(alc)*b(alc)*

Advierta que, aunque b aparece en el centro de la expresión regular, la letra b no

necesita estar en el centro de la cadena que se desea definir. En realidad, la repetición de

a o c antes y después de la b puede presentarse en diferentes números de veces. Por

consiguiente, todas las cadenas siguientes están generadas mediante la expresión regular

anterior: b, abc, abaca, baaaac, ccbaca, ccccccb.

Ejemplo2:

Con el mismo alfabeto que antes, considere el conjunto de todas las cadenas que

contienen como máximo una b. Una expresión regular para este conjunto se puede

obtener utilizando la solución al ejemplo anterior como una alternativa (definiendo

aquellas cadenas con exactamente una b) y la expresión regular ( a l c ) * como la otra

alternativa (definiendo los casos sin b en todo). De este modo, tenemos la solución

siguiente:

(alc)*|( a l c ) * b ( a | c ) *

Docente: Ing. Mirko Manrique Ronceros

~ 23 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

Una solución alternativa sería permitir que b o la cadena vacía apareciera entre las

dos repeticiones de a o c:

( a |c )* (b l ε ) (alc)*

Ejemplo3:

Consideremos el conjunto de cadenas S sobre el alfabeto Σ = {a,b} compuesto de

una b simple rodeada por el mismo número de a:

n n

S = {b, aba, aabaa, aaabaaa, . . .} = {a ba |n ≠ 0}

Docente: Ing. Mirko Manrique Ronceros

~ 24 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

AUTÓMATAS FINITOS

Los autómatas finitos, o máquinas de estados finitos, son una manera matemática para

describir clases particulares de algoritmos (o "máquinas"). En particular, los autómatas

finitos se pueden utilizar para describir el proceso de reconocimiento de patrones en

cadenas de entrada, y de este modo se pueden utilizar para construir analizadores

léxicos. Por supuesto, también existe una fuerte relación entre los autómatas finitos y las

expresiones regulares, y veremos en la sección siguiente cómo construir un autómata

finito a partir de una expresión regular. Sin embargo, antes de comenzar nuestro estudio

de los autómatas finitos de manera apropiada, consideraremos un ejemplo explicativo.

El patrón para identificadores como se define comúnmente en los lenguajes de programación está dado por la siguiente definición regular (supondremos que letra y dígito

ya se definieron):

identificador =

letra(letra|dígito)*

Esto representa una cadena que comienza con una letra y continúa con cualquier

secuencia de letras y/o dígitos. El proceso de reconocer una cadena así se puede describir

mediar diagrama de la figura:

En este diagrama los círculos numerados 1 y 2 representan estados, que son localidades

en proceso de reconocimiento que registran cuánto del patrón ya se ha visto. Las líneas

flechas representan transiciones que registran un cambio de un estado a otro en una

coincidencia del carácter o caracteres mediante los cuales son etiquetados. En el

diagrama muestra, el estado 1 es el estado de inicio, o el estado en el que comienza el

proceso de reconocimiento. Por convención, el estado de inicio se indica dibujando una

línea con flecha sin etiqueta que proviene de "de ninguna parte". El estado 2 representa

el punto en el cual se ha igualado una sola letra (lo que se indica mediante la transición

del estado 1 al estado 2 etiquetada con letra). Una vez en el estado 2, cualquier

número de letras y/o dígitos se puede ver, y una coincidencia de éstos nos regresa al

Docente: Ing. Mirko Manrique Ronceros

~ 25 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

estado 2. Los estados que representan el fin del proceso de reconocimiento, en los cuales

podemos declarar un éxito, se denominan estados de aceptación, y se indican

dibujando un borde con línea doble alrededor del estado en el diagrama. Puede haber

más de uno de éstos. En el diagrama de muestra el estado 2 es un estado de aceptación,

lo cual indica que, después que cede una letra, cualquier secuencia de letras y dígitos

subsiguiente (incluyendo la ausencia de todas) representa identificador legal.

El proceso de reconocimiento de una cadena de caracteres real como un identificador

ahora se puede indicar al enumerar la secuencia de estados y transiciones en el diagrama

q se utiliza en el proceso de reconocimiento. Por ejemplo, el proceso de reconocer

xtemp como un identificador se puede indicar como sigue:

Un DFA (por las siglas del concepto autómata finito determinístico en inglés) M se

compone de un alfabeto Σ, un conjunto de estados S, una función de transición T: S X

Σ —> S, un estado de inicio s0 ε S y un conjunto de estados de aceptación A C S. El

lenguaje aceptado por M, escrito como L(M), se define como el conjunto de cadenas

de caracteres C1C2.. .c„ con cada c¡ Σ, tal que existen estados Sj = T(s0, C1), s2 =

T(s1, c2),... ,sn = T(Sn-1, cn), con sn como un elemento de A (es decir, un estado de

aceptación).

Hacemos las anotaciones siguientes respecto a esta definición. S X Σ se refiere al

producto cartesiano o producto cruz de S y Σ: el conjunto de pares (s, c), donde

s S y c Σ La función T registra las transiciones: T(s, c) = s' si existe una transición

del estado S al estado s' etiquetado mediante c. El segmento correspondiente del

diagrama para M tendrá el aspecto siguiente:

La aceptación como la existencia de una secuencia de estados s1 = T(so, c1), s2 =

T(s1, c2),. . . , = T(sn-1, c„), con sn siendo un estado de aceptación, significa

entonces lo mismo que el

Docente: Ing. Mirko Manrique Ronceros

~ 26 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

Advertimos

un número de diferencias entre la definición de un DFA y el diagrama del ejemplo

identificador. En primer lugar, utilizamos los números para los estados en el diagrama

del identificador, mientras la definición no restrinja el conjunto de estados a números.

En realidad, podemos emplear cualquier sistema de identificación que queramos para

los estados, incluyendo nombres. Por ejemplo, podemos escribir un diagrama

equivalente al de la figura como:

donde ahora denominamos a los estados inicio (porque es el estado de inicio) y

entrada_id (porque vimos una letra y estará reconociendo un identificador después de

letras y números subsiguientes cualesquiera). El conjunto de estados para este

diagrama se convierte ahora en {inicio, entrada_jd} en lugar de {1, 2}.

Una segunda diferencia entre el diagrama y la definición es que no etiquetamos las

transiciones con caracteres sino con nombres que representan un conjunto de

caracteres.

El conjunto de cadenas que contienen exactamente una b es aceptado por el siguiente

DFA:

El conjunto de cadenas que contienen como máximo una b es aceptado por el

siguiente DFA:

Docente: Ing. Mirko Manrique Ronceros

~ 27 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

Definiciones regulares para constantes numéricas en notación científica como se

muestra a continuación

Un NFA (por las siglas del término autómata finito no determinístico en inglés) M

consta de un alfabeto Σ, un conjunto de estados S y una función de transición T:S X(Σ

u {ε}) -> φ(S), así como de un estado de inicio s0 de S y un conjunto de estados de

aceptación A de S. El lenguaje aceptado por M, escrito como L(M), se define como el

conjunto de cadenas de caracteres

estados

s1

en T(s0,

c1), s2

c1c2.

en T(s1,

. .cn con cada

c2),.

..,

sn

c¡

de Σ u {ε} tal que existen

en T(sn-1

cn),

con Sn como un

elemento de A.

Considere el siguiente diagrama de un NFA

La cadena abb puede ser aceptada por cualquiera de las siguientes secuencias de

transacciones:

Docente: Ing. Mirko Manrique Ronceros

~ 28 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

En realidad las transiciones del estado 1 al estado 2 en a, y del estado 2 al estado 4 en b,

permiten que la máquina acepte la cadena ab, y entonces, utilizando la transición ε del

estado 4 al estado 2, todas las cadenas igualan la expresión regular ab+. De manera

similar, las transiciones del estado 1 al estado 3 en a, y del estado 3 al estado 4 en ε,

permiten la aceptación de todas las cadenas que coinciden con ab*. Finalmente,

siguiendo la transición e desde el estado 1 hasta el estado 4 se permite la aceptación de

todas las cadenas coincidentes con b*. De este modo, este NFA acepta el mismo

lenguaje que la expresión regular

ab+ l ab* I b*. Una expresión regular más simple

que genera el mismo lenguaje es (a|ε)b*. El siguiente DFA también acepta este

lenguaje:

Considere el siguiente NFA

Docente: Ing. Mirko Manrique Ronceros

~ 29 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

Este acepta la cadena acab al efectuar las transiciones siguientes:

Docente: Ing. Mirko Manrique Ronceros

~ 30 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

LENGUAJES FORMALES

En matemáticas, lógica, y ciencias de la computación, un lenguaje formal es un

conjunto de palabras (cadenas de caracteres) de longitud finita en los casos más

simples o expresiones válidas (formuladas por palabras) formadas a partir de un

alfabeto (conjunto de caracteres) finito. El nombre lenguaje se justifica porque las

estructuras que con este se forman tienen reglas de buena formación (gramática)

e interpretación semántica (significado) en una forma muy similar a los lenguajes

hablados.

Un posible alfabeto sería, digamos,

alfabeto sería, por ejemplo,

, y una cadena cualquiera sobre este

. Un lenguaje sobre este alfabeto, que incluyera

esta cadena, sería: el conjunto de todas las cadenas que contienen el mismo número

de símbolos

que , por ejemplo.

La palabra vacía (esto es, la cadena de longitud cero) se permite en este tipo de

lenguajes, notándose frecuentemente mediante

,

ó

. A diferencia de que ocurre

con el alfabeto (que es un conjunto finito) y con cada palabra (que tiene una longitud

también finita), un lenguaje puede estar compuesto por un número infinito de

palabras.

Ejemplos de lenguajes formales:

El conjunto de todas las palabras sobre

.

El conjunto

El conjunto de todos los programas sintácticamente válidos en un determinado

es un número primo.

lenguaje de programación.

El conjunto de sentencias bien formadas en lógica de predicados.

Especificación de lenguajes formales

Los lenguajes formales se pueden especificar de una amplia variedad de formas, como

por ejemplo:

Cadenas producidas por una gramática formal (véase Jerarquía de Chomsky).

Cadenas producidas por una expresión regular.

Cadenas aceptadas por un autómata, tal como una máquina de Turing.

Docente: Ing. Mirko Manrique Ronceros

~ 31 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

Operaciones

Se pueden utilizar varias operaciones para producir nuevos lenguajes a partir de otros

dados. Supóngase que L1 y L2 son lenguajes sobre un alfabeto común. Entonces:

La concatenación L1L2 consiste de todas aquellas palabras de la forma vw donde

v es una palabra de L1 y w es una palabra de L2

La intersección L1&L2 consiste en todas aquellas palabras que están contenidas

tanto en L1 como en L2

La unión L1|L2 consiste en todas aquellas palabras que están contenidas ya sea

en L1 o en L2

El complemento ~L1 consiste en todas aquellas palabras producibles sobre el

alfabeto de L1 que no están ya contenidas en L1

El cociente L1/L2 consiste de todas aquellas palabras v para las cuales existe

una palabra w en L2 tales que vw se encuentra en L1

La estrella L1* consiste de todas aquellas palabras que pueden ser escritas de la

forma W1W2...Wn donde todo Wi se encuentra en L1 y n ≥ 0. (Nótese que esta

definición incluye a ε en cualquier L*)

La intercalación L1*L2 consiste de todas aquellas palabras que pueden ser

escritas de la forma v1w1v2w2...vnwn; son palabras tales que la concatenación

v1...vn está en L1, y la concatenación w1...wn está en L2

Por contraposición al lenguaje propio de los seres vivos y en especial el lenguaje

humano, considerados lenguajes naturales, se denomina lenguaje formal a los

lenguajes «artificiales» propios de las matemáticas o la informática, los lenguajes

artificiales son llamados lenguajes formales (incluyendo lenguajes de programación).

Sin embargo, el lenguaje humano tiene una característica que no se encuentra en los

lenguajes de programación: la diversidad.

En 1956, Noam Chomsky creó la Jerarquía de Chomsky para organizar los distintos

tipos de lenguaje formal.

Docente: Ing. Mirko Manrique Ronceros

~ 32 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

Verdades concernientes a los lenguajes formales

Teorema 1: El conjunto de lenguajes en general (incluyendo los no-formales) es

incontable.

Lema 1: El conjunto de lenguajes en un alfabeto no vacío dado es incontable

Afirmar que un alfabeto es no-vacío equivale a que ese alfabeto contenga al menos un

símbolo, Basta demostrar que el conjunto de lenguajes en el alfabeto

incontable. Como sabemos, un lenguaje L en

es un subconjunto de

, esto nos

lleva a la conclusión de que, el conjunto de todos los lenguajes en

es justamente

(el conjunto de todos los subconjuntos o conjunto potencia de

evidente que

A

) y es

es infinito (de hecho; contable), también ha sido demostrado que si

A es un conjunto infinito (contable o incontable), entonces 2

2

es

A

es mayor que A porque

pasa a ser un conjunto infinito de ordenes del infinito, al ser mayor, no existirá

A

A

biyección entre A y 2 , lo que hace a 2 un conjunto infinito incontable.

Demostración del Teorema 1: Puede derivarse fácilmente que la aseveración

delineada en el Teorema 1 es verdadera, porque el conjunto de lenguajes en general

A

es justamente una unión infinita de conjuntos del tipo 2 , donde A es un conjunto

infinito contable.

Teorema 2: Los lenguajes son conjuntos contables

Se sabe que un lenguaje L en un alfabeto Σ es un subconjunto de Σ

hizo mención, Σ

*

*

y como ya se

es infinito incontable, por ende, L es como mucho un conjunto

infinito incontable (del mismo tamaño que Σ *.

Teorema 3: El conjunto de lenguajes formales es contable

Como sabemos un lenguaje formal puede ser generado por una gramática formal (o

de estructura de frase), lo cual implica que todo lenguaje formal puede ser aceptado

por una Máquina de Turing(MT), lo que a su vez implica que se puede definir una

biyección entre el conjunto de lenguajes formales y el conjunto de las MT´s (debido a

la propiedad transitiva de la relación "existe biyección entre A y B"). Para demostrar el

teorema se utilizará el concepto de codificación de MT´s que se introduce en el

estudio de las MT´s universales, generalmente se codifica una MT con una función que

Docente: Ing. Mirko Manrique Ronceros

~ 33 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

tiene precisamente como dominio al conjunto de las MT´s (lo llamaremos X) y como

codominio

, esa función puede ser una biyección si el codominio pasa a ser Y

(un subconjunto de

) y como

es contable, ese subconjunto también

será contable y como existe dicha biyección (entre X e Y).

Gramática formal

Una gramática formal es un objeto o modelo matemático que permite especificar un

lenguaje o lengua, es decir, es el conjunto de reglas capaces de generar todas las

posibilidades combinatorias de ese lenguaje, ya sea éste un lenguaje formal o un

lenguaje natural.

Introducción

El elemento en mayúsculas es el símbolo inicial. Los elementos en minúsculas son

símbolos terminales. Las cadenas de la lengua son aquellas que solo contienen

elementos terminales, como por ejemplo:

bbbdeccc, de, bdec, ... Estas serían tres posibles realizaciones del lenguaje cuya

gramática hemos definido con dos reglas.

Para comprender mejor el concepto pondremos algunas reglas de la gramática

castellana:

Una

FRASE

se

puede

componer

de

SUJETO

+

PREDICADO

O = SN + SV

Un SUJETO se puede componer de un ARTÍCULO + NOMBRE o SUSTANTIVO

(núcleo) + Complementos

SN = Det + N + C

Un

PREDICADO

se

puede

componer

de

un

VERBO

conjugado

SV = Aux + GV

Un ARTICULO puede ser la palabra "el"

Un NOMBRE o SUBSTANTIVO puede ser "niño"

Vemos que existen unas definiciones especiales como FRASE, SUJETO, etc. que no

aparecen en la frase final formada. Son unas entidades abstractas denominadas

Categorías Sintácticas que no son utilizables en una frase.

Docente: Ing. Mirko Manrique Ronceros

~ 34 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

Las categorías sintácticas definen la estructura del lenguaje representando porciones

más o menos grandes de las frases. Existe una jerarquía interna entre las categorías

sintácticas.

La categoría superior sería la FRASE que representa una oración válida en lengua

castellana.

Por debajo de ella se encuentran sus componentes. Ninguna de estas categorías da

lugar a frases válidas solo la categoría superior.

Al finalizar toda la jerarquía llegamos a las palabras que son las unidades mínimas con

significado que puede adoptar una frase.

Aplicando las jerarquías y sustituyendo elementos, llegamos al punto en donde todas

las categorías sintácticas se han convertido en palabras, obteniendo por tanto una

oración VÁLIDA. (Como por ejemplo: El niño corre). Este proceso se llama producción

o generación.

En resumen:

Elementos constituyentes

Una gramática formal es un modelo matemático compuesto por una serie de

categorías sintácticas que se combinan entre sí por medio de unas reglas

sintácticas que definen cómo se crea una categoría sintáctica por medio de

otras o símbolos de la gramática.

Existe una única categoría superior que denota cadenas completas y válidas.

Mecanismos de especificación

Por medio de estos elementos constituyentes se define un mecanismo de

especificación consistente en repetir el mecanismo de sustitución de una

categoría por sus constituyentes en función de las reglas comenzando por la

categoría superior y finalizando cuando la oración ya no contiene ninguna

categoría.

De esta forma, la gramática puede generar o producir cada una de las cadenas del

lenguaje correspondiente y solo estas cadenas.

Docente: Ing. Mirko Manrique Ronceros

~ 35 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

Definición

Una Gramática Formal es una cuádrupla

donde:

N es un alfabeto de símbolos no terminales (variables).

T es un alfabeto de símbolos terminales (constantes).

Debe cumplirse que

. denotaremos con

el alfabeto de

la gramática.

es el símbolo inicial o axioma de la gramática.

es el conjunto de reglas de producción, de la forma

β

{ α → β | α

}

Es decir, la cadena α debe contener al menos una variable, que puede estar rodeada

de un contexto.

Derivaciones

Sea G = (N,T,P,S) una gramática, y sean α, β, δ, φ, ρ, ... palabras de Σ

*

. Entonces

β se deriva de α en un paso de derivación, y lo denotamos con α

dos cadenas

β si existen

, y una producción δ → ρ tales que α = φ1 δ φ2, y β =

φ1 ρ φ2

Notamos con

al cierre reflexivo y transitivo de

. Es decir α

β denota a

una secuencia de derivaciones en un número finito de pasos desde α hasta β.

es una forma sentencial de G, si puede obtenerse la siguiente

secuencia de derivaciones

. En el caso particular de que

se dice

que x es una sentencia

Se

denomina

lenguaje

Docente: Ing. Mirko Manrique Ronceros

formal

generado

por

G

al

conjunto

~ 36 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

EXPRESIÓN REGULAR

Una expresión regular, a menudo llamada también patrón, es una expresión que

describe un conjunto de cadenas sin enumerar sus elementos. Por ejemplo, el grupo

formado por las cadenas Handel, Händel y Haendel se describe mediante el patrón

"H(a|ä|ae)ndel". La mayoría de las formalizaciones proporcionan los siguientes

constructores: una expresión regular es una forma de representar a los lenguajes

regulares (finitos o infinitos) y se construye utilizando caracteres del alfabeto sobre el

cual se define el lenguaje. Específicamente, las expresiones regulares se construyen

utilizando los operadores unión concatenación y clausura de Kleene.

alternación

Una barra vertical separa las alternativas. Por ejemplo, "marrón|castaño" casa

con marrón o castaño.

cuantificación

Un cuantificador tras un carácter especifica la frecuencia con la que éste puede

ocurrir. Los cuantificadores más comunes son +, ? y *:

+

El signo más indica que el carácter al que sigue debe aparecer al menos una

vez. Por ejemplo, "ho+la" describe el conjunto infinito hola, hoola, hooola,

hoooola, etcétera.

?

El signo de interrogación indica que el carácter al que sigue puede aparecer

como mucho una vez. Por ejemplo, "ob?scuro" casa con oscuro y obscuro.

*

El asterisco indica que el carácter al que sigue puede aparecer cero, una, o más

veces. Por ejemplo, "0*42" casa con 42, 042, 0042, 00042, etcétera.

agrupación

Los paréntesis pueden usarse para definir el ámbito y precedencia de los demás

operadores. Por ejemplo, "(p|m)adre" es lo mismo que "padre|madre", y

"(des)?amor" casa con amor y con desamor.

Los constructores pueden combinarse libremente dentro de la misma expresión, por lo

que "H(ae?|ä)ndel" equivale a "H(a|ae|ä)ndel".

Docente: Ing. Mirko Manrique Ronceros

~ 37 ~

Universidad Nacional del Santa

Curso: Teoría de Compiladores

La sintaxis precisa de las expresiones regulares cambia según las herramientas y

aplicaciones consideradas, y se describe con más detalle a continuación.

Su utilidad más obvia es la de describir un conjunto de cadenas, lo que resulta de

utilidad en editores de texto y aplicaciones para buscar y manipular textos. Muchos

lenguajes de programación admiten el uso de expresiones regulares con este fin. Por

ejemplo, Perl tiene un potente motor de expresiones regulares directamente incluido

en su sintaxis. Las herramientas proporcionadas por las distribuciones de Unix

(incluyendo el editor sed y el filtro grep) fueron las primeras en popularizar el

concepto de expresión regular.

Aplicaciones

Numerosos editores de texto y otras utilidades (especialmente en el sistema operativo

UNIX/linux), como por ejemplo sed y awk, utilizan expresiones regulares para, por