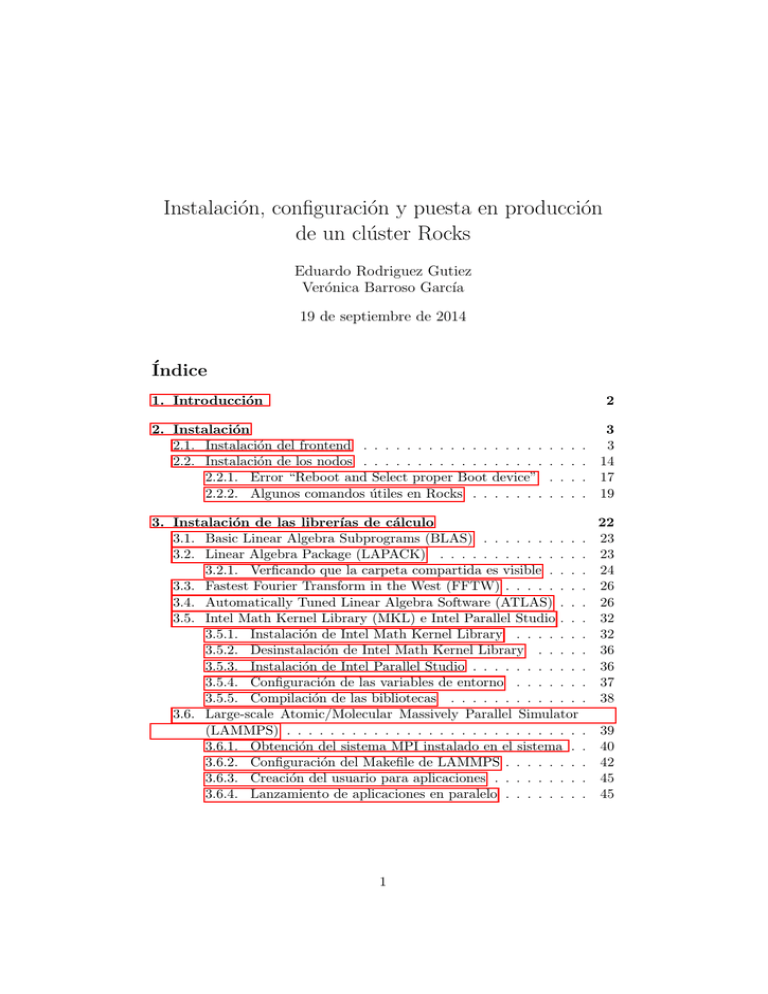

Instalación, configuración y puesta en producción de un clúster Rocks

Anuncio