Número completo - e-Spacio

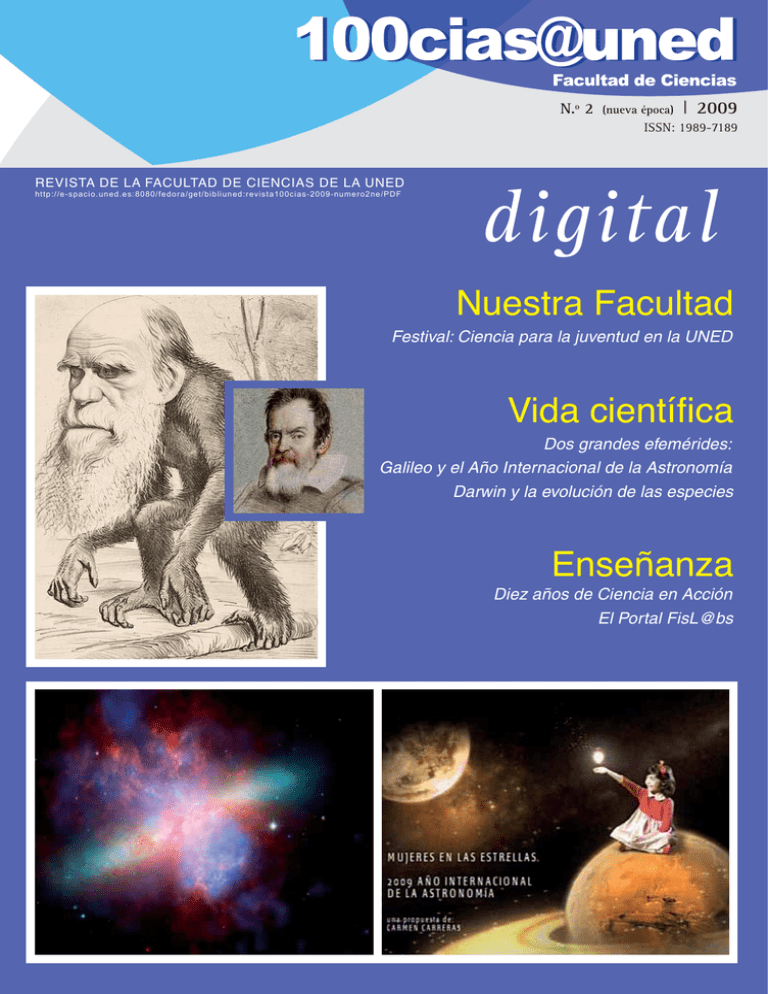

Anuncio