Introducción a R

Anuncio

Introducción a R

Juan Pablo Pérez Grijalbo

9 de febrero de 2007

2

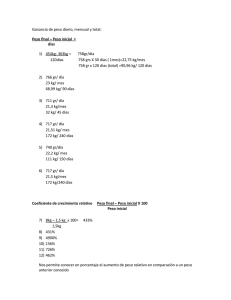

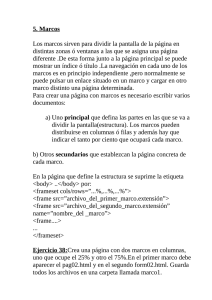

Histograma(velocidad)

Dispersión(vel/dist)

−1

0

1

2

3

0

5

10

15

20

25

5

10

15

20

25

velocidad

velocidad

Histograma(distancia)

Dispersión(dist/vel)

15

velocidad

10

10

0

0.0

5

0.1

5

0.2

frecuencia

0.3

20

0.4

15

25

0.5

Densidad(distancia)

densidad

60

80

−3

0

0

0.0

20

0.1

5

40

distancia

10

frecuencia

0.3

0.2

densidad

0.4

100

15

0.5

120

Densidad(velocidad)

−2

0

1

2

3

4

0

20 40 60 80

distancia

120

0

20

40

60

80

distancia

120

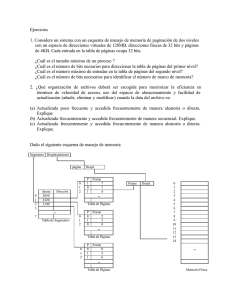

Índice de figuras

3.1. Manual de R en html . . . . . . . . . . . . . . . . . . . . . . . . . .

3.2. Hacer histogramas con hist() . . . . . . . . . . . . . . . . . . . . . .

3.3. Diagrama de dispersión con la función plot . . . . . . . . . . . . . .

17

20

20

5.1. Diagrama de caja con la función boxplot() . . . . . . . . . . .

5.2. Varios diagramas de caja con la función boxplot() . . . . . . .

5.3. Diagramas de caja de anchura variable con el argumento width

5.4. Modificación de las clases del histograma con breaks . . . . .

5.5. Frecuencias relativas con freq=F . . . . . . . . . . . . . . . .

5.6. Histograma con la función hist() . . . . . . . . . . . . . . . .

5.7. Función de densidad con plot(density()) . . . . . . . . . . . .

5.8. Gráfico Q-Q con la función qqnorm() . . . . . . . . . . . . .

5.9. Otro gráfico Q-Q con la función qqnorm . . . . . . . . . . . .

5.10. Gráfico de barras con barplot() . . . . . . . . . . . . . . . . .

5.11. Un gráfico interesante para tablas bidimensionales . . . . . . .

5.12. Representación gráfica de una tabla multidimensional . . . . .

5.13. Representación de parte de una tabla multidimensional . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

39

39

41

41

42

43

43

45

45

54

54

55

56

6.1. Notched boxplots . . . . . . . . . . . . . . . . . . . . . . . . . . . .

63

7.1. Un ejemplo de escasa correlación . . . . . . . . . . . . . . . . . . . .

7.2. En este caso, la correlación es fuerte . . . . . . . . . . . . . . . . . .

7.3. Diagrama de dispersión con dos grupos de datos . . . . . . . . . . . .

7.4. Diagrama mucho más elaborado . . . . . . . . . . . . . . . . . . . .

7.5. Diagrama de dispersión con dos grupos de datos obtenido con coplot()

7.6. Diagrama de dispersión controlando para dos variables . . . . . . . .

7.7. Diagrama de dispersión cruzada entre variables con pairs() . . . . . .

7.8. Relación entre temperatura y distancia . . . . . . . . . . . . . . . . .

7.9. Relación entre temperatura y flujo térmico . . . . . . . . . . . . . . .

7.10. Relación entre las variables de trees . . . . . . . . . . . . . . . . . .

7.11. Inclusión de la recta de regresión con abline() . . . . . . . . . . . . .

7.12. Identificación de casos con identify() . . . . . . . . . . . . . . . . . .

66

66

68

68

69

69

71

75

75

77

79

80

8.1. Personalización de títulos . . . . . . . . . . . . . . . . . . . . . . . .

83

3

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

4

ÍNDICE DE FIGURAS

8.2. Ejes logarítmicos . . . . . . . . . . . . . . . . . . . . . . . . . .

8.3. Modificar etiquetas de ejes con axis() . . . . . . . . . . . . . . .

8.4. Millones de colores con rgb() y hsv() . . . . . . . . . . . . . . . .

8.5. Añadir textos con text() . . . . . . . . . . . . . . . . . . . . . . .

8.6. Utilizar funciones para establecer coordenadas de textos con text()

8.7. Personalización de líneas con lty,lwd,col . . . . . . . . . . . . . .

8.8. Personalización de puntos con pch,cex,col . . . . . . . . . . . . .

8.9. Añadir puntos con points() . . . . . . . . . . . . . . . . . . . . .

8.10. Añadir lineas con abline() . . . . . . . . . . . . . . . . . . . . .

8.11. Añadir curvas con curve() . . . . . . . . . . . . . . . . . . . . . .

8.12. Modificación de parámetros gráficos con par() (I) . . . . . . . . .

8.13. Modificación de parámetros gráficos con par() (II) . . . . . . . .

8.14. Modificación de parámetros gráficos con par() (III) . . . . . . . .

8.15. División de la pantalla gráfica con layout() . . . . . . . . . . . . .

8.16. División desigual de la pantalla gráfica con layout() . . . . . . . .

8.17. Dos histogramas con layout() . . . . . . . . . . . . . . . . . . . .

8.18. Figuras múltiples par(mfrow) . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

83

85

85

86

87

87

89

89

90

91

92

92

93

94

94

96

97

Índice general

1. Introducción

1.1. ¿Por qué escribo este libro? . . . . . . . . . . . . . . . . . . . . . . .

1.2. Características principales de R . . . . . . . . . . . . . . . . . . . . .

1.3. Algunas cuestiones sobre el texto . . . . . . . . . . . . . . . . . . . .

7

7

8

9

2. Obtención e instalación

2.1. Instalación en Linux . . . . . . . . . . . . . . . . . . . . . . . . . .

2.2. Instalación en Windows . . . . . . . . . . . . . . . . . . . . . . . . .

11

11

12

3. Primeros pasos

3.1. Iniciar una sesión de trabajo

3.2. Cómo pedir ayuda . . . . . .

3.3. Manos a la obra . . . . . . .

3.4. Primera sesión . . . . . . . .

3.5. Acabar una sesión de trabajo

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

13

13

14

16

17

21

4. Gestión de objetos y ficheros

4.1. Introducción de datos en R . . . . . . . . . . . . .

4.1.1. Importación de tablas externas: read.table()

4.1.2. Edición de datos en R . . . . . . . . . . .

4.2. Salida de información de R . . . . . . . . . . . . .

4.2.1. Exportación de gráficos . . . . . . . . . . .

4.2.2. Exportación de textos . . . . . . . . . . . .

4.3. Manipulación de data.frames . . . . . . . . . . . .

4.3.1. Selección de variables . . . . . . . . . . .

4.3.2. Extracción de variables . . . . . . . . . . .

4.3.3. Selección de casos . . . . . . . . . . . . .

4.3.4. Extracción de casos . . . . . . . . . . . . .

4.3.5. Introducción de variables . . . . . . . . . .

4.3.6. Incorporación de registros . . . . . . . . .

4.3.7. Ordenación de variables . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

23

23

23

25

26

26

27

27

28

28

29

30

31

33

34

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

5

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

ÍNDICE GENERAL

6

5. Estadística descriptiva

35

5.1. Análisis exploratorio de los datos . . . . . . . . . . . . . . . . . . . . 35

5.1.1. Medidas características . . . . . . . . . . . . . . . . . . . . . 35

5.1.2. El gráfico stem and leaf . . . . . . . . . . . . . . . . . . . . . 37

5.1.3. El gráfico boxplot . . . . . . . . . . . . . . . . . . . . . . . . 38

5.1.4. El histograma . . . . . . . . . . . . . . . . . . . . . . . . . . 40

5.1.5. Contraste de normalidad . . . . . . . . . . . . . . . . . . . . 40

5.2. Cómo resumir la información contenida en un data.frame . . . . . . 46

5.2.1. Tablas de frecuencias absolutas . . . . . . . . . . . . . . . . 46

5.2.2. Tablas con otras medidas estadísticas . . . . . . . . . . . . . 50

5.2.3. Métodos gráficos para presentar la información contenida en tablas 53

6. Pruebas de significación

6.1. Pruebas no paramétricas . . . . . . . . . . . . . . . . . . . . . . . .

6.1.1. Pruebas basadas en la χ2 . . . . . . . . . . . . . . . . . . . .

6.1.2. Test de Wilcoxon, de Mann-Whitney y de Kolmogorov-Smirnov

6.1.3. Test de Kruskal-Wallis . . . . . . . . . . . . . . . . . . . . .

6.2. Pruebas paramétricas . . . . . . . . . . . . . . . . . . . . . . . . . .

6.2.1. Test basados en la t de Student . . . . . . . . . . . . . . . . .

57

57

57

59

60

62

62

7. Correlación y regresión

7.1. Estudio de la correlación bivariada . . . . . . .

7.1.1. Métodos gráficos . . . . . . . . . . . .

7.1.2. Matrices de correlaciones . . . . . . .

7.1.3. Coeficiente de correlación de Spearman

7.1.4. Coeficiente de correlación parcial . . .

7.2. Regresión lineal simple . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

65

65

65

70

72

73

76

8. Personalización de gráficos

8.1. Títulos . . . . . . . . . . . . . . .

8.2. Ejes . . . . . . . . . . . . . . . .

8.3. Colores . . . . . . . . . . . . . .

8.4. Añadir textos a un gráfico . . . . .

8.5. Tipos de puntos y lineas . . . . . .

8.6. Añadir puntos y lineas a un gráfico

8.7. Plantillas gráficas . . . . . . . . .

8.8. Gráficos múltiples . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

81

81

82

84

84

86

88

90

93

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

Capítulo 1

Introducción

1.1. ¿Por qué escribo este libro?

El objetivo de este documento es proporcionar una base en castellano para aquellos

que están interesados, por el motivo que sea, en iniciarse en el uso de R.

Cuando uno se entera de la existencia de R, y se siente interesado por él, lo primero

que necesita es un poco de documentación porque, realmente, no es un programa que

se aprenda a base de trastear. Es entonces cuando se busca por internet.

Por lo general, al que está metido en el mundo de la informática, no le queda otro

remedio que manejarse con el inglés. Es entonces cuando uno siente cierta sana envidia

por esas sociedades que generan tanto conocimiento y, sobre todo, por la gente que

tiene un acceso inmediato a esa información. También es cuando uno se explica que

les haya ido tan bien a algunas naciones en lo que al desarrollo (al menos científico y

tecnológico) se refiere.

Mientras tanto, a los demás no nos queda otra opción que intentar descifrar el lenguaje

imperante; en general porque nos puede más el deseo de saber que la reticencia natural

a aprender un idioma extranjero1

Para los que entienden el inglés hay buenísimos manuales disponibles en la página

oficial de R. Se incluyen, además, documentos de tipo introductorio mucho mejores

que este2 . Sin embargo, hay gente que presenta esas reticencias al inglés y que, por

tanto, no tienen acceso a un entorno estadístico realmente fantástico. Entre esos sectores de población se encuentran especialmente los alumnos de bachillerato e, incluso,

de niveles universitarios. En realidad, este documento fue concebido en principio como

un material de clase para ser utilizado con mis alumnos y alumnas del primer curso de

bachillerato. Decidí entonces redactar un pequeño manual para trabajar con ellos en

el aula cuestiones de estadística básica, puesto que, por un lado, era consciente de lo

1 En realidad, existen algunos documentos en castellano, como la traducción de Introducción a R, del

equipo de desarrollo de R; y Gráficos estadísticos con R, de J.C. Correa y N. González. Ambos están disponibles en la página web de R.

2 En mi opinión, los mejores son simpleR. Using R for introductory statistics de John Verzani y Using R

for data analysis and graphics. An introduction de J.H.Maindonald. Como los anteriores, están disponibles

en la página web de R

7

CAPÍTULO 1. INTRODUCCIÓN

8

inadecuado que podría resultar remitirles a la documentación en inglés pero, por otro,

deseaba introducirles en el mundo del software libre y darles a conocer R.3 .

En fin, espero que estos apuntes sirvan para aquellos hispanoparlantes que se enfrentan por primera vez con R. Para que puedan empezar a descubrir las inmensas

posibilidades que ofrece y, quién sabe, llegar a entusiasmarse con él como lo hace el

que escribe estas lineas.

1.2. Características principales de R

En mi opinión las principales características de R son

1. las operaciones (cálculos estadísticos, gestión de ficheros,. . . ) se realizan tecleando instrucciones en un terminal. No es, por lo tanto, un programa en modo

gráfico

2. hay toda una comunidad internetera girando alrededor de él. En la red podemos

encontrar actualizaciones, paquetes, listas de correo, manuales,. . .

3. además del sistema base, existen paquetes especializados que permiten aplicar R

a campos superespecíficos como la estadística espacial, molecular, social,. . .

4. es un lenguaje de programación, de modo que tenemos la posibilidad de ampliar

su funcionalidad en la medida de nuestros conocimientos sobre programación

5. es un sistema multiplataforma, estando disponible, entre otros, para sistemas Linux, Windows y MacOS

6. es software libre, de modo que podemos adaptar el programa a nuestras necesidades ya que se distribuye con el código fuente

7. es gratuito

Por supuesto, R tiene ventajas e inconvenientes. También por supuesto, qué son

ventajas y qué inconvenientes depende de cada uno, pero (sobretodo) depende de con

qué se compare. R es un entorno estadístico y, por lo tanto, debe ser comparado con

aplicaciones de este tipo no, por ejemplo, con hojas de cálculo o similares.

Para mi son ventajas

1. el no sentirte solo ante el programa. La comunidad R es muy amplia y atenta.

Siempre responde a tus dudas

2. tiene unas capacidades gráficas extraordinarias

3. poder utilizarlo tanto en Linux como en Windows

4. poder definir funciones propias

5. tener acceso a funciones de estadística avazada

3 Sin embargo, a medida que lo he ido escribiendo lo he ido ampliando y, en estos momentos, supera las

posibilidades de aplicación en esos niveles, por lo que a ellos les paso una versión adaptada

1.3. ALGUNAS CUESTIONES SOBRE EL TEXTO

9

6. trabajar con ficheros fácilmente portables

7. aunque parezca extraño, el trabajar en linea de comandos a la larga resulta una

ventaja en muchas ocasiones ya que permite realizar muchas operaciones de forma más rápida que en modo gráfico

8. se actualiza con mucha frecuencia

9. es gratuito, de modo que uno puede responder tranquila y públicamente a la

pregunta ¿con qué programa has hecho esto?, cosa que no pueden hacer muchos

de los usuarios de otras aplicaciones estadísticas

Entre los inconvenientes destacaría

1. al principio, el trabajo en modo texto es incómodo

2. la curva de aprendizaje es, también al principio, algo pendiente, de modo que es

necesario material de apoyo para el aprendizaje

3. el lenguaje del programa es el inglés, y también en inglés está la mayor parte de

la documentación disponible

4. es un programa poco conocido por el usuario normal de estadística ya que no

hay libros de R en las secciones correspondientes de las librerías especializadas

1.3. Algunas cuestiones sobre el texto

En el texto encontraremos en negrita todo aquello que debamos introducir por

teclado en el terminal para realizar alguna operación en R. Por otro lado, aparecerán en

cursiva

1. las salidas por pantalla de las instrucciones que tecleemos

2. los nombres de las funciones y argumentos o parámetros de las mismas

3. los nombres de objetos particulares del espacio de trabajo

4. como sustituto de las comillas allí donde pudieran utilizarse

La operación de asignación puede efectuarse con el signo = o con la combinación de

signos <-. En el texto se utiliza esta última para ser compatible con versiones anteriores

de R.

10

CAPÍTULO 1. INTRODUCCIÓN

Capítulo 2

Obtención e instalación

La versión 1.6.1 de R, de noviembre de 2002, se te proporciona con este documento

en las versiones para Linux y para Windows. Sin embargo, cuando lo leas, casi con

toda seguridad habrá alguna versión más nueva, ya que la intención del equipo que

desarrolla R es liberar dos versiones al año. Por tanto, si deseas lo último en R tendrás

que descargarlo de la página oficial del proyecto CRAN (www.cran.r-project.org).

La instalación difiere si eres usuario de Linux o de Windows.

2.1. Instalación en Linux

Los usuarios habituales de Linux pueden saltarse este apartado (si no lo han hecho

ya) porque no tienen más que obtener R e instalárselo en su ordenador.

Si no lo eres, lo que sigue pretende ayudarte a instalártelo.

Si utilizas una distribución de Linux completa, tal vez se halle incorporada alguna

versión de R en la selección de programas que hayan hecho; en ese caso puedes utilizar

para instalar R la aplicación de gestión de paquetes que te venga con la distribución.

En cualquier caso, no será la última.

Si lo descargas de Internet debes saber que en la página de CRAN vas a encontrar

diferentes versiones del programa. Por un lado están los ficheros con el código fuente y,

por otro, los archivos con ficheros binarios precompilados para las distribuciones más

usuales (Debian, RedHat, Suse y Mandrake). Lo mejor es descargarse el que corresponda a nuestra distribución e instalarlo con la herramienta de gestión de paquetes que

tengamos.

Otra posibilidad es utilizar el CD que te proporciono. En él te encontrarás con un

paquete RPM y varios DEB. Para instalar R desde la linea de comandos sólo tienes que

escribir en un terminal

rpm -i R-1.6.1-2.i386.rpm

lo que instalará R en la mayor parte de las distribuciones. Si tu distribución es Debian

o basada en debian, puedes utilizar los archivos DEB, para lo cual deberás escribir

dpkg -i r-base-core_1.6.1-1_i386.deb

dpkg -i r-recommended_1.6.1-1_all.deb

11

12

CAPÍTULO 2. OBTENCIÓN E INSTALACIÓN

dpkg -i r-doc-pdf_1.6.1-1_i386.deb

Si todo ha ido bien1 , podrás arrancar R desde el terminal simplemente tecleando R.

2.2. Instalación en Windows

Los que utilizan Windows no lo tienen mucho más difícil. Tienen que descargarse

el archivo correspondiente que hay en el directorio base del enlace a Windows de la

página de descarga. Tras descargarlo sólo hay que hacer doble clic sobre el icono del

archivo rw1061.exe e ir superando las pruebas que nos pone el asistente de instalación. Tras concluir y, si así lo queremos, tendremos un icono en el escritorio que nos

permitirá lanzar la aplicación.

1 los problemas más habituales son los de dependencias no satisfechas, en cuyo caso deberás instalar

previamente los paquetes precisos

Capítulo 3

Primeros pasos

3.1. Iniciar una sesión de trabajo

Tras arrancar R nos encontramos con un terminal en el que deberemos teclear los

comandos necesarios para realizar todas las operaciones que vayamos a realizar; desde

la edición y gestión de ficheros de datos, a los análisis estadísticos y generación de

gráficos. Como dijimos en la Introducción, deberemos aprender el idioma de R. Sin

embargo, y aunque es amplio, veremos que con muy poco esfuerzo podremos empezar a trabajar. Además, una característica de R muy útil es que los comandos que se

introducen por teclado se van almacenando en un historial, de manera que podemos

recuperar las órdenes introducidas en un momento anterior con la ayuda de la tecla

flecha-arriba. Esto nos ahorrará mucho trabajo de tecleado y de memorización de la

sintaxis de los comandos ya que una vez introducido podremos recuperarlo posteriormente. Por otro lado, esta facultad nos va a permitir realizar análisis estadísticos de una

manera incluso más rápida de lo que lo haríamos con una aplicación en modo gráfico, en la que deberíamos desplazarnos por diferentes ventanas para realizar un análisis

prácticamente idéntico al realizado en un momento anterior.

En R nos vamos a encontrar con lo que se denomina "espacio de trabajo"(workspace

en inglés). Es una entidad virtual en la que se van a ir almacenando las variables y análisis que vayamos haciendo a lo largo de nuestra sesión de trabajo.

En Linux, el espacio de trabajo se almacena en el directorio desde el que se ha

lanzado R, de modo que al arrancar R se cargará el espacio de trabajo correspondiente

al directorio en el que nos encontremos al lanzar la aplicación. Por ese motivo, antes

de comenzar un estudio estadístico (digamos, Clima de Aragón) es conveniente crear

un directorio (tal vez, Clima de Aragón). Cuando vayamos a trabajar sobre este asunto

acudiremos a ese directorio para, desde allí, arrancar R. Todos los ficheros que vayamos generando (de texto, gráficos,...) en la sesión de R se irán guardando por defecto

en este mismo directorio.

Si no hacemos esto y arrancamos R, sea cual sea el problema estadístico, desde un directorio cualquiera, por ejemplo home, iremos acumulando objetos de diferentes problemas estadísticos en el mismo espacio de trabajo, lo que acabará creando la consi13

14

CAPÍTULO 3. PRIMEROS PASOS

guiente confusión.

Si analizamos los ficheros ocultos contenidos en el directorio de trabajo, vemos que

hay uno llamado .Rhistory que es el que va almacenando el histórico de comandos

introducidos en R. Como es un fichero de texto, podemos visualizarlo con cualquier

editor.

En la versión de R para Windows las cosas son algo distintas porque, aunque el

espacio de trabajo también se guardará en el directorio desde el que se lance la aplicación, lo cierto es que la operación de arranque se suele hacer, bien con un doble clic

sobre el icono colocado en el escritorio o la barra de programas, bien desplegando el

menú de Inicio hasta llegar a la aplicación.

Una vez arrancado R, para saber cuál es el directorio de arranque deberemos teclear

getwd() y anotar la ruta de acceso que nos indica por pantalla que, si hemos hecho una

instalación de Aceptar en Aceptar, estará en C:\Archivos de programa\R\rw1051 .

Cuando hayamos acabado la sesión de trabajo con R y guardado el espacio de trabajo,

nos encontraremos en el directorio que nos haya indicado getwd() con un icono en forma de R. Es conveniente entonces poner un nombre a ese icono (que de momento no

tiene ninguno) y trasladarlo a la carpeta en la que vayamos a guardar todo el material

que vayamos generando en nuestro trabajo estadístico.

Si este procedimiento nos parece demasiado complicado, podemos utilizar el comando /File/Save Workspace, que nos permite guardar una imagen de nuestro espacio

de trabajo en el directorio que deseemos. Tras acabar nuestra sesión de trabajo, deberemos descartar los cambios si queremos que, al abrir de nuevo R desde el icono de la

aplicación, no se cargue ningún workspace.

A partir de ese momento, cuando queramos recuperar ese espacio de trabajo en

concreto, tendremos dos opciones:

1. lanzar R haciendo doble clic sobre el icono situado en la carpeta de trabajo

2. hacer sobre doble clic sobre el icono que abre la aplicación y cargar el espacio

de trabajo desde File/Load workspace. Nos aparecerá una ventana en la que sólo

deberemos indicar la carpeta en la que hemos guardado la imagen del espacio de

trabajo.

Cuando arrancamos R desde el icono de la aplicación, se recupera el último espacio

de trabajo abierto, que puede ser,o no, el que nos interese a nosotros. La mejor manera

de averiguarlo es tecleando ls(); si se ha cargado el que deseamos, es obvio que no es

preciso hacer la operación anterior.

En la versión de R para Windows disponemos de una ventana con menús, una pequeña barra de herramientas y la consola para introducir los comandos por teclado.

Aunque no hay procedimientos estadísticos en modo gráfico, sí que hay algunos comandos útiles, como el que permite la importación de paquetes desde el sitio web de

CRAN o la personalización del entorno.

3.2. Cómo pedir ayuda

R dispone de un sistema de ayuda muy eficaz que nos va a permitir aprender el uso

de los comandos con bastante rapidez. Si conocemos el nombre del comando sobre el

3.2. CÓMO PEDIR AYUDA

15

que deseamos ayuda (p.e. plot) podemos utilizar la función help(). Lo único que debemos teclear es help(plot) o ?plot.

En ese momento, si trabajamos con la versión de Linux, el terminal abandona entorno

de R en el que estamos para arrancar el visualizador de la ayuda. El desplazamiento

por la ayuda se realiza con las teclas de arriba-abajo y de Av.Pag-Re.Pag. Todas las

ayudas suelen acabar con ejemplos de utilización de la función. Para salir de ella sólo

hay que pulsar la tecla q.

Existe la posibilidad de visualizar la ayuda con un navegador web. Para ello, en el caso

anterior se debería teclear help(plot, htmlhelp=T) con lo que arrancaría el navegador

Mozilla. En la página web aparecerá el mismo contenido de la ayuda pero con sus ventajas en cuanto a navegación. Además, en este caso, no se pierde en ningún momento

el controlde edición de comandos en el prompt de R.

El problema viene cuando no conocemos el nombre de los comandos, pero, ni siquiera

en ese caso está todo perdido. Entre otras cosas, tenemos manuales (como este) que nos

van presentando algunos de los comandos más habituales. Sólo es cuestión de empezar

a recordarlos. Además, existen varias posibilidades de ayuda desde R. Si tecleamos

help.start(), arrancará el navegador web en una página de inicio que presenta enlaces

a diferentes documentos. En este momento nos interesa especialmente el enlace a los

paquetes de R (Packages). De este modo podremos obtener una relación de todo lo

que contiene un paquete determinado. De entrada nos viene el nombre del comando

a teclear y una pequeña descripción de lo que hace (si es un procedimiento) o de lo

que contiene (si es un fichero de datos). Aunque tiene infinidad de funciones, es conveniente echar un vistazo al paquete Base porque podremos ir reconociendo las que

utilizaremos con más frecuencia.

Si tenemos alguna idea de cómo puede llamarse la función que queremos emplear podemos utilizar la función apropos(). Por ejemplo, si quiero hacer una media ponderada

pero no sé el nombre exacto de la función que me permita obtenerla, puedo teclear

apropos(mean) cuya salida sería

[1]“mean” “mean.POSIXc” “mean.POSIXl” “mean.default”

[5] “weighted.mean”

Podemos ver entonces que existe una función llamada weighted.mean(). El siguiente

paso sería solicitar ayuda sobre la misma con help(weighted.mean) para aprender a

utilizarla.

Otra herramienta muy útil para pedir ayuda en R es la función help.search(). Esta

nos devuelve todas las entradas de ayuda que presenten en sus tilulos o palabras clave

la cadena de caracteres introducida como argumento de la función. Así,

help.search(“help”)

devuelve

example(base) Run an Examples Section from the Online Help

help(base) Documentation

help.search(base) Search the Help System

help.start(base) Hypertext Documentation

index.search(base) Search Indices for Help Files

Cuando

apropos(help)

devuelve

16

CAPÍTULO 3. PRIMEROS PASOS

[1]“help” “help.search” “help.start”

Otra función muy útil es methods(), que permite conocer diferentes posibilidades de

uso de procedimientos utilizados en R. Por ejemplo, si nos interesa conocer variantes

de uso de la función lines(), podemos teclear

methods(lines)

que nos proporciona la siguiente salida

[1] “lines.default” “lines.formula” “lines.histogram” “lines.ts”.

Tambiém podemos aplicarlo a una clase de objetos, como hacemos en el siguiente

ejemplo con las tablas

methods(class=table)

[1] “pairwise.table” “as.data.frame.table” “as.table”

[4] “is.table” “margin.table” “plot.table”

[7] “print.summary.table” “int.table” “prop.table”

[10] “read.table” “summary.table” “write.table”

Posteriormente, con las funciones normales de ayuda, podemos entrar a estudiar el

funcionamiento de aquellas que nos puedan interesar.

En Windows encontramos en la pantalla un menú de ayuda. Allí nos encontramos

con accesos a las FAQ’s, al manual de R y otras fuentes de documentación. Éstos

están en formato PDF, pero la versión en HTML podemos lanzarla desde la línea de

comandos con la función help.start(). La captura de pantalla de la Figura 3.1 se ha

obtenido de esa manera.

3.3. Manos a la obra

Antes de ponernos a trabajar con nuestros datos, es conveniente echar un vistazo

a alguno de los datos que vienen incorporados con R. Si tecleamos data(), aparecerá

en pantalla una relación de ficheros de datos que podremos cargar en nuestro espacio

de trabajo. Para cargar uno en concreto, debe incluirse como argumento de la función.

Así, data(cars) cargaría el fichero cars.

Para ver qué objetos tenemos en nuestro espacio de trabajo hay que utilizar la función ls() sin argumentos. En este caso el único objeto debe ser el recién cargado fichero

cars.

Para ver el contenido de un objeto de datos tenemos dos posibilidades: la primera

es llamarlo directamente por su nombre. En nuestro caso, si tecleamos cars, aparecerá

por pantalla todo el contenido del fichero. Veremos entonces que consta de cincuenta registros de velocidad y distancia de frenada de otros tantos vehículos. Este modo

de exploración no es conveniente cuando el fichero contiene muchas variables y/o registros. En estos casos es mejor utilizar la función str() para hacernos una idea del

contenido del objeto. Así, str(cars) generaría la siguiente salida

‘data.frame’: 50 obs. of 2 variables:

$ speed: num 4 4 7 7 8 9 10 10 10 11 ...

$ dist : num 2 10 4 22 16 10 18 26 34 17 ...

La función str() nos informa de que cars es un data.frame, es decir, una tabla de datos en la que podemos encontrarnos variables de diferentes tipos. Nos dice que hay 50

observaciones de dos variables que son de tipo numérico y cuyos nombres son speed y

3.4. PRIMERA SESIÓN

17

Figura 3.1: Manual de R en html

dist.

Los data.frame son un tipo de objeto de importancia capital en R ya que en la

mayor parte de los análisis estadísticos los datos serán almacenados en data.frames. La

función str() es la mejor manera de conocer la estructura de un objeto en R.

3.4. Primera sesión

Las estadísticas más básicas que debemos conocer de nuestros datos son las relativas a medidas de tendencia central y de dispersión. La función summary() nos proporciona algunas de ellas. Por ejemplo, summary(cars) nos indica lo siguiente

speed

Min. : 4.0

1st Qu.:12.0

Median :15.0

Mean :15.4

3rd Qu.:19.0

Max. :25.0

dist

Min. : 2.00

1st Qu.: 26.00

Median : 36.00

Mean : 42.98

3rd Qu.: 56.00

Max. :120.00

es decir, proporciona los valores mínimo y máximo de cada variable así como la media

aritmética y los tres cuartiles.

Como veremos, con summary() podemos conocer algunos estadísticos básicos. Las

funciones mean(), median(), max(), min(), sum() y var() aplicadas a una varible proporcionarán por separado la media aritmética, mediana, valor máximo, mínimo, suma

CAPÍTULO 3. PRIMEROS PASOS

18

y varianza respectivamente.

Sin embargo, si nos limitamos a teclear estas funciones, R sólo presentará el valor del

estadístico en la pantalla. Si deseamos almacenar alguno de estos valores para trabajar

con ellos posteriormente (o por el motivo que sea) será preciso guardarlo en nuestro

espacio de trabajo. Para ello debemos hacer una de las operaciones más básicas en R,

que es la asignación.

Llamamos asignación al proceso por el cual almacenamos en un objeto el resultado

obtenido a través de una función de R. El objeto se incorporará automáticamente al

espacio de trabajo. Para llevar a cabo la asignación debemos decidir en primer lugar el

nombre que queremos dar al objeto. Una vez hecho esto, podemos pasar a teclear en

el terminal la orden. Por ejemplo, si quisiéramos almacenar la media de la distancia de

frenado, podríamos teclear lo siguiente

media.frenado<-mean(cars$dist)

Como ya sabemos, mean(cars$dist) le dice a R que obtenga la media de la variable

dist del data.frame cars. La combinación de caracteres < (menor que) y - (guión) indica que el resultado de la función debe asignarse a...1 Finalmente media.frenado es el

nombre que hemos querido dar en este caso al objeto que almacenará la media.

Si hacemos ls() veremos que, efectivamente, el nuevo objeto se ha incorporado al espacio de trabajo. A partir de ahora, para conocer el valor de ese estadistico deberemos

teclear, símplemente, media.frenado y, lo que es más importante, podré manipular el

valor de la media en operaciones algebraicas. Por ejemplo, si desease dividir esa media

entre tres, teclearía media.frenado/3. El proceso sería el siguiente

media.frenado<-mean(cars$dist)

media.frenado

[1] 42.98

media.frenado/3

[1] 14.32667

Como puedes imaginar, el último valor no se almacenará en el espacio de trabajo puesto

que no ha sido asignado a ningún objeto. Sin embargo, si consideras que sería conveniente, ya sabes cómo puedes hacerlo muy rápidamente y casi sin teclear nada. Sólo

debes recuperar con la tecla flecha-arriba la línea en la que introdujiste la orden de

cálculo (en este caso la última), desplazarte en ella con las flechas-derecha-izquierda

hasta el comienzo de la línea y teclear el nombre que quieras dar al objeto seguido del

operador de asignación <-.

La asignación es, como ya hemos dicho, una operación básica en R. En una sesión de

trabajo pueden realizarse multitud de asignaciones. Por ese motivo es muy recomendable que elijamos nombres adecuados para los objetos. Es muy conveniente que el

nombre nos recuerde inmediatamente qué es lo que almacena el objeto, pero tampoco

debe ser excesivamente largo. La experiencia nos irá ayudando en la elección de nombres.

Cuando hacemos ls() y vemos que hay objetos que hemos almacenado, pero que no nos

interesan, podemos quitarlos del espacio de trabajo. Para eso está la función rm(). Así,

rm(media.frenado) haría desaparecer el objeto media.frenado. Si queremos quitar varios objetos, no tenemos más que teclear sus nombres dentro de la función separados

1 recuérdese

que puede sustituirse por el signo = en las versiones 1.5 y posteriores

3.4. PRIMERA SESIÓN

19

por comas. Así, rm(media.frenado,cars) quitaría esos dos objetos que, por el momento, deben ser todo lo que tenemos en el espacio de trabajo.

Podemos comprobarlo con ls():

ls()

[1] “cars” “media.frenado”

rm(cars,media.frenado)

ls()

character(0)

Ese character(0) nos dice que el espacio de trabajo está vacío. De momento, volveremos a cargar el archivo cars.

Aunque estemos en los primeros pasos, seguramente también nos interesará analizar la distribución de frecuencias de las variables. Para generar un histograma de la

variable speed deberemos teclear

hist(cars$speed) lo que viene a traducirse por “coge el data.frame cars, selecciona la

variable speed y haz el histograma con las opciones que tengas por defecto”. El resultado es el que vemos en la Figura 3.2. 2 . Vemos que al pulsar la tecla Intro se abre una

pantalla nueva que R llama Device 2 y dice que está activa.

Si quiero ver el histograma, pero ahora de la variable dist, tengo dos opciones: presentarlo en la pantalla que acaba de abrirse (en cuyo caso desaparecerá el histograma

anterior), o abrir una nueva pantalla. Para ello deberemos teclear, en Linux, X11() y, en

Windows, windows(). En ese momento se abrirá y activará automáticamente un nuevo

dispositivo. Cualquier función gráfica que introduzcamos en R se representará en esa

nueva pantalla.

Abrir dispositivos de esta manera es una de las posibilidades que ofrece R para ver

varios gráficos de forma simultanea. Podemos conocer en cualquier momento cuántos

dispositivos tenemos abiertos tecleando dev.list(). Nos aparecerá por pantalla una lista

que nos informa del tipo de dispositivo, y el número que tiene asignado. El último dispositivo abierto será siempre el que esté en estado activo a no ser que activemos otro.

Esto podemos hacerlo con la función dev.set(). Tecleando dev.set(which=3) activaremos inmediatamente el dispositivo número 3.

Si queremos cerrar un dispositivo, podemos hacerlo con el ratón, pulsando sobre la X

de la esquina superior derecha. Sin embargo, hay dispositivos, como el postscript (que

veremos más adelante), que no presenta ventana alguna. Para cerrarlo en ese caso debemos teclear, por ejemplo, dev.off(4) siendo en este caso 4 el número del dispositivo

a cerrar.

En muchos casos también vamos a interesarnos por la relación existente entre

las distintas variables. Una aproximación gráfica la obtendremos mediante la función plot(). Para ver el gráfico dispersión de speed frente a dist deberemos teclear

plot(cars$speed,cars$dist) lo que genera la Figura 3.3

2 Posteriormente estudiaremos más en profundidad los métodos gráficos y veremos cómo modificar y

personalizar el gráfico resultante

CAPÍTULO 3. PRIMEROS PASOS

20

dist

0

20

40

60

80

100

120

Figura 3.2: Hacer histogramas con hist()

5

10

15

20

25

speed

Figura 3.3: Diagrama de dispersión con la función plot

3.5. ACABAR UNA SESIÓN DE TRABAJO

21

3.5. Acabar una sesión de trabajo

Podemos dar por terminada nuestra primera sesión de R. Para salir sólo hay que

teclear q(). En ese momento nos preguntarán si deseamos guardar los objetos presentes

en el espacio de trabajo que han sido generados en la última sesión. Si pulsamos la tecla

y, se guardarán, y nos los encontraremos de nuevo cuando arranquemos el programa. Si

pulsamos n todos los objetos que no hubieran sido guardados en alguna sesión anterior

de R se perderán sin posibilidad de recuperarlos.

22

CAPÍTULO 3. PRIMEROS PASOS

Capítulo 4

Gestión de objetos y ficheros

Después de conocer las bases de R, estamos en condiciones de comenzar a trabajar

con datos propios y presentar al mundo los resultados de tus análisis. En este capítulo

veremos cómo introducir datos en R, cómo manipularlos y cómo exportar los resultados

para poder incorporarlos a un informe.

4.1. Introducción de datos en R

Al llegar a este punto, podemos encontrarnos con varias situaciones:

1. en algunos casos, los datos los tendremos ya metidos en algún fichero (de hoja

de cálculo, de base de datos,...) bien porque los introdujimos en un momento

anterior, o porque nos los proporcionaron en esos formatos

2. podemos tener datos propios todavía sin digitalizar, y es posible que, después de

conocer las posibilidades que te ofrece R, prefieras introducir los datos en una

aplicación que te permita editarlos de una manera más ágil

3. finalmente, es posible que deseas introducir los datos directamente en R

En primer lugar vamos a ver qué hay que hacer en los dos primeros casos para importar

datos externos.

4.1.1. Importación de tablas externas: read.table()

Por lo general, los datos los tenemos en forma de tablas en las que encontramos

una serie de variables de diferentes tipos dispuestas en columnas; y un número variable

de registros que aparecen ocupando las filas de la tabla.

Sea cual sea la aplicación en la que tengamos la información, siempre podremos exportar la tabla en forma de fichero de texto. Esta es una de las formas más fáciles de

trasladar datos desde cualquier aplicación hacia R. Tal vez lo más frecuente sea exportar las tablas a ficheros de texto en los que cada campo (columna, variable) quede

23

CAPÍTULO 4. GESTIÓN DE OBJETOS Y FICHEROS

24

limitado por tabuladores (tab delimited en inglés). Si tenemos una tabla como la siguiente:

ALTITUD

500

1500

25

ORIENTACIÓN

N

TEMPERATURA

15

6

S

y la exportamos (desde la aplicación en la que la hemos creado) con el nombre datos.txt al directorio de trabajo de R, podremos incorporarla al espacio de trabajo con la

siguiente orden:

datos<-read.table("datos.txt", header=T, sep="\t")

en ella se dice que el fichero (que debe ir entrecomillado) tiene una primera fila en la

que van los nombres de las variables (header=T) y que el separador de columnas es el

tabulador (sep="\t"

). La orden podría funcionar correctamente aun sin colocar esa última opción siempre y cuando no haya ningún valor perdido (celdas en blanco) en la tabla original, pero

como en nuestro caso sí los hay, es preciso introducirla. Si comprobamos el resultado,

obtenemos lo siguiente

datos

ALTITUD

1 500

2 1500

3 25

ORIENTACIÓN

N

S

TEMPERATURA

15

6

NA

vemos que el valor perdido en la variable TEMPERATURA se ha convertido automáticamente en un NA (Not Avalaible en inglés), pero el perdido en la variable ORIENTACIÓN aparece en blanco. Esto se debe a que R transforma en NA’s sólo las varibles

numéricas. Si queremos que los valores perdidos de una variable no numérica se transformen en NA’s para ser tratados como tales en R, debemos indicar a la hora de importar

la tabla qué forma adoptan los valores perdidos en esos casos. Como en el nuestro (y

es lo habitual) son celdas que están en blanco, lo que haremos será introducir la opción

na.strings=""

datos<-read.table("datos.txt", header=T, na.strings=“”, sep="\t")

datos

ALTITUD

1 500

2 1500

3 25

ORIENTACIÓN

N

NA

S

TEMPERATURA

15

6

NA

Con esta orden de importación, las variables numéricas contenidas en la tabla de

origen serán mantenidas como numéricas, pero las variables de tipo carácter serán

transformadas en lo que en R se llama factores. Cuando conozcamos mejor cómo

4.1. INTRODUCCIÓN DE DATOS EN R

25

funciona R podremos decidir si eso nos conviene o no. Cuando deseemos mantener

las variables de tipo carácter como tales, deberemos añadir a la función read.table la

opción as.is=T.

4.1.2. Edición de datos en R

En alguna ocasión es posible que deseemos introducir los datos directamente en R.

Hay dos posibilidades para hacerlo: una es por la línea de comandos, y la otra mediante

una pantalla gráfica.

En la línea de comandos podemos crear un objeto y asignarle al mismo tiempo los

valores que ha de almacenar. Por ejemplo, si quisiéramos introducir directamente los

datos de la tabla anterior podríamos teclear lo siguiente:

ALTITUD<-c(500,1500,25)

ORIENTACIÓN<-c("N",NA,"S")

TEMPERATURA<-c(15,6,NA)

tabla<-data.frame(ALTITUD,ORIENTACIÓN,TEMPERATURA)

En las tres primeras líneas creamos las variables y les asignamos los valores que adoptan. La función c() lo que hace es concatenar los tres valores para crear un vector. Los

valores perdidos los introducimos como NA’s, y los valores de las variables no numéricas deben ir entrecomillados. En la cuarta línea hemos procedido a crear un data.frame

que hemos llamado tabla en el que hemos reunido las tres variables.

También podríamos haber realizado la operación en un sólo paso. Símplemente deberíamos haber tecleado:

tabla<-data.frame(ALTITUD=c(500,1500,25),ORIENTACIÓN=

c( "N",NA,"S"),TEMPERATURA=c(15,6,NA)) Si tecleamos str(tabla) obtenemos:

str(tabla)

‘data.frame’: 3 obs. of 3 variables:

$ALTITUD : num 500 1500 25

$ORIENTACIÓN: Factor w/ 2 levels "N","S": 1 NA 2

$TEMPERATURA: num 15 6 NA

El mensaje nos indica que, efectivamente, hemos generado un data.frame que tiene

tres observaciones y tres variables, dos de las cuales son numéricas y una tercera, la

orientación, es lo que en R se llama un factor; en este caso, el factor presenta sólo dos

modalidades: N y S. También nos advierte de la presencia de valores perdidos.

Este sistema desde luego no es muy práctico si tenemos que introducir muchos

datos. Una alternativa es utilizar un editor tipo hoja de cálculo al que podemos acceder con la función data.entry(). Esta posibilidad sólo está disponible en determinadas

plataformas y GUI’s, por lo que no siempre funciona. Cuando funciona, disponemos

de una herramienta muy útil. La única precaución que debemos guardar es la de crear

previamente el objeto, por ejemplo un data.frame, antes de introducir los datos en él

desde el editor. La secuencia de instrucciones en Windows podría ser la siguiente

datos<-data.frame()

Edit/Data editor...

Con la primera instrucción creamos un data.frame vacío llamado datos. Luego vamos

al menú Edit/Data editor.... Nos saldrá una ventana en la que nos pedirán el nombre

del objeto a editar. Deberemos introducir el nombre, en este caso datos. Tras esta ope-

26

CAPÍTULO 4. GESTIÓN DE OBJETOS Y FICHEROS

ración, se abre una rejilla de filas y columnas en las que podremos introducir nombres

de variables (haciendo clic con el botón izquierdo del ratón en la cabecera de columna)

y los valores que correspondan.

Tras concluir la edición, cerramos la ventana haciendo clic sobre el aspa de la esquina superior derecha. Desde ese momento, podemos ver el contenido del data.frame

tecleando datos.

4.2. Salida de información de R

Como es lógico, parte de la información que obtengamos con R a lo largo de nuestro

análisis (valores de estadísticos, gráficos,...) querremos llevarla fuera para incorporarla

a alguna aplicación que nos permita editarla (por lo general un procesador de texto).

En este apartado veremos algunas funciones que nos van a permitir llevar a cabo estas

operaciones.

4.2.1. Exportación de gráficos

En un apartado anterior hemos visto cómo generar un gráfico con la función plot().

Si quisiéramos exportarlo, podríamos hacerlo con la función dev2bitmap(), que transforma el contenido de la pantalla X11 activa en una imagen en formato bitmap. Lo

único que habría que hacer es decidir con qué nombre quiero guardar el gráfico y teclear

dev2bitmap("GráficoCars", res=300)

con esta función guardamos el gráfico con el nombre de GráficoCars y con una resolución (res de 300 puntos por pulgada. Por supuesto, la resolución puede modificarse. El

fichero gráfico se guarda en el directorio de trabajo, a no ser que en el nombre (que debe

ir entrecomillado) se indique lo contrario. Por ejemplo, dev2bitmap(”/home/pablo/GráficoCars”

, res=150), guardaría el gráfico (siempre que tengamos permiso de escritura) en el directorio /home/pablo. En este caso, lo hará con una resolución de 150 ppp.

En Linux es muy habitual manejar ficheros gráficos en formato PS (Postscript).

Para exportar el gráfico anterior en este formato habría que introducir la orden

dev.print(postscript)

lo que genera un fichero llamado Rplots.ps en la carpeta/directorio de trabajo. Con un

visor PS podremos comprobar que el gráfico es realmente el que nos interesa. Posteriormente deberemos cambiar inmediatamente el nombre del fichero por uno que nos recuerde qué gráfico contiene, porque la próxima vez que ejecutemos dev.print(postscript)

se generará un nuevo fichero Rplots.ps que borrará el contenido del anterior. Como puede apreciarse, este método resulta un poco lioso y arriesgado, de modo que lo habitual

será exportar el gráfico con un nombre ya definido. Esto puede hacerse con la opción

file. Así, si queremos guardar el fichero postscript con el nombre Grafico1, podríamos

teclear

dev.print(postscript, file="Grafico1")

En la versión de Windows podemos acceder al menú para guardar el gráfico sólo

con hacer clic con el botón derecho del ratón sobre la ventana gráfica. Entonces nos

aparecen una serie de opciones y formatos para elegir.

4.3. MANIPULACIÓN DE DATA.FRAMES

27

4.2.2. Exportación de textos

En muchos casos querremos exportar la información obtenida mediante análisis

estadísticos y que R nos presenta por pantalla. Por ejemplo, el resultado de la función

summary(), o de un análisis de regresión entre dos variables. Para ello disponemos de

la función sink(). Esta función lo que hace es dirigir la salida de una orden introducida

en R a un fichero de texto cuyo nombre debemos incluir en la primera llamada a la

función. Tras introducir sink(), todo lo que hagamos en R (salvo gráficos) se almacenará en el fichero externo sin llegar a presentarse por pantalla. Obviamente, hay que

decirle a R cuándo queremos dejar de extaer información. Eso lo haremos con un nueva

llamada a sink(). A continuación se presenta un ejemplo de utilización de esta función

sink(“resultados")

str(cars)

summary(cars)

cor(cars)

sink()

Si exploramos el directorio de trabajo veremos que existe un nuevo fichero, de nombre

resultados, que es el nombre que hemos introducido entrecomillado al llamar a la función. Si lo abrimos con un editor de texto confirmaremos que contiene la información

esperada, en este caso, acerca de la estructura, estadísticas básicas y matriz de correlaciones del data.frame cars. Como hemos cerrado la exportación de resultados son

sink(), los resultados de las operaciones que hagamos en adelante y que tengan salida,

se presentarán en la pantalla. Es muy importante no olvidarse de cerrar la exportación.

De lo contrario iremos llenando el fichero de resultados indeseados.

Cuando queramos exportar un data.frame contenido en nuestro espacio de trabajo,

podremos hacerlo con la función write.table(). La siguiente orden exportaría el data.frame cars al fichero coches

write.table(cars, “coches")

4.3. Manipulación de data.frames

Como hemos comentado anteriormente, los data.frame son un tipo de objeto fundamental en R. La mayor parte de los datos que queramos analizar estadísticamente

estarán almacenados en forma de data.frame ya que, por lo general, tendremos una serie de variables numéricas y otras que no lo serán. Nada impide que en un data.frame

todas las variables sean de un solo tipo. Cuando todas son numéricas, el data.frame

puede transformarse en una matriz, que es otro tipo de objetos presentes en R.

Se entiende, por tanto, que sea imprescindible conocer las técnicas de manipulación

básicas de los data.frame. En unas ocasiones querremos extraer información de ellos;

en otras, eliminar o añadir variables; seleccionar datos;. . . En los siguientes apartados

veremos cómo hacer algunas de estas operaciones.

Para los ejemplos de esta sección utilizaremos los datos contenidos en el fichero

resultados académicos que se adjunta con el CD.

Para cargar esos datos, es recomendable copiar el fichero en nuestro directorio de trabajo. Entonces, sólo con teclear

28

CAPÍTULO 4. GESTIÓN DE OBJETOS Y FICHEROS

resultados<-read.table(resultados.txt",sep=",",header=T)

tendremos en nuestro workspace el data.frame resultados.

Como se puede apreciar, en la instrucción le indicamos a read.table que el fichero es

de tipo delimitado por comas (sep=","

) y que la primera fila contiene el nombre de las variables(header=T). Como este

es el data.frame que vamos a utilizar más a menudo, es una buena idea colocarlo en la

ruta de búsqueda con attach(resultados), de esa manera podremos referirnos a las variables sin necesidad de indicar a R continuamente que se encuentran en el data.frame

resultados. Una vez cargados los datos es conveniente estudiar su estructura con str()

str(resultados)

‘data.frame’: 4838 obs. of 9 variables:

$ Evaluacion: Factor w/ 4 levels "1","2","F","N": 4 3 3 2 2 3 3 3 2 3 ...

$ Curso : num NA 1 2 1 1 1 1 2 2 1 ...

$ B : num NA 0 0 0 0 0 0 0 0 0 ...

$ IN : num NA 0 0 0 0 0 0 0 0 0 ...

$ NT : num NA 0 0 0 1 1 1 1 1 1 ...

$ SB : num NA 9 9 9 8 8 8 8 8 8 ...

$ SF : num NA 0 0 0 0 0 0 0 0 0 ...

$ Año : Factor w/ 9 levels "1994","1995",..: 9 5 6 8 5 7 7 5 6 5 ...

$ Alumno : Factor w/ 4838 levels "1","10","100",..: 4838 4265 374 1973 2200 2431

2593 2598 3310

3311 ...

4.3.1. Selección de variables

Ya sabemos cómo aplicar una función a una variable de un data.frame. Por ejemplo,

length(resultados$NT) nos proporcionará el número de valores (incluidos los perdidos) que tiene la variable NT (número de Notables). Sin embargo, hay otras maneras

equivalentes de obtener el mismo resultado. Entre otras, las siguientes

length(resultados[,6])

length(resultados[[6]])

length(NT)

como puede verse, en los dos primeros casos hemos sustituido el nombre de la variable

(NT) por el número de orden que ocupa en el data.frame (el notable es la variable número 6). En el tercer caso hemos obviado la referencia al nombre del data.frame; esto

sólo funcionará siempre y cuando antes lo hayamos colocado en la ruta de búsqueda

con attach().

4.3.2. Extracción de variables

En ocasiones el fichero de datos original tiene más variables de las que nos interesan

para nuestro análisis. En esos casos, puede interesarnos crear un nuevo data.frame en

el que sólo aparezcan las variables que realmente vayamos a necesitar. Esta operación

puede realizarse con la función subset(). Esta es una función muy útil y la estudiaremos

también en otra sección.

4.3. MANIPULACIÓN DE DATA.FRAMES

29

Para extraer variables hay que indicar a la función el nombre del data.frame y las variables que deseamos extraer. Como queremos generar un data.frame nuevo, deberemos

realizar una operación de asignación. Por ejemplo, para crear un data.frame llamado fracasoescolar con las variables Año, Evaluacion, Curso e IN deberíamos teclear

fracasoescolar<-subset(resultados,select=c(8,1,2,4)). Si solicitamos a R la estructura

del nuevo data.frame con str(fracasoescolar) veremos lo siguiente:

‘data.frame’: 4838 obs. of 4 variables:

$ Año : Factor w/ 8 levels "1994","1995",..: 5 6 8 5 7 7 5 6 5 6 ...

$ Evaluacion: Factor w/ 3 levels "1","2","F": 3 3 2 2 3 3 3 2 3 1 ...

$ Curso : num 1 2 1 1 1 1 2 2 1 2 ...

$ IN : num 0 0 0 0 0 0 0 0 0 0 ...

Como se ve, han desaparecido las variables no deseadas y se han seleccionado las

que queremos, respetando el orden en el que se han introducido en la función subset().

Vamos a estudiar un poco en detalle cómo se indica qué variables se quieren extraer.

Esto de hace con el argumento select. En el ejemplo hemos tecleado select=c(8,1,2,4).

Ese c(8,1,2,4) indica a R que concatene las variables que ocupan el octavo, primero,

segundo y cuarto lugar. La c que precede al paréntesis es imprescindible y se utiliza en

R siempre que se quiere crear lo que se llama un vector.

En lugar de número de orden, podríamos haber utilizado el nombre de las variables,

así

fracasoescolar<-subset(resultados,select=c(Año,Evaluacion,Curso,IN)

habría producido el mismo resultado.

En ocasiones son más las variables que quiero extraer que las que deseo descartar.

En esos casos es más conveniente utilizar otra forma de selección. Por ejemplo

fracasoescolar<-subset(resultados,select=-c(B,NT,SB)

incluiría en el data.frame fracasoescolar todas las notas menos (como le indica el signo

- delante del operador de concatenación) el B, el NT y el SB.

Si, por casualidad, las variables a extraer son consecutivas, podríamos seleccionarlas en bloque. Así,

probatinas<-subset(resultados,select=(1:5))

crearía un data.frame en el que se incluirían las primeras cinco variables. Nótese que,

en este caso, no se introduce la concatenación; R entiende los dos puntos entre el 1 y

el 5 como desde la uno a la cinco, ambas inclusive.

4.3.3. Selección de casos

Al igual que hemos seleccionado variables para aplicarles procedimientos estadísticos, también podemos seleccionar casos para aplicarles funciones. Por lo general, esta

selección se basará en el cumplimiento de determinadas condiciones. Los operadores

habituales en las expresiones condicionales son

1. ==, igual a

2. >=, mayor o igual a

3. <=, menor o igual a

30

CAPÍTULO 4. GESTIÓN DE OBJETOS Y FICHEROS

4. !=, diferente a

5. &, y

6. |, o

En nuestro data.frame sobre resultados académicos se almacenan datos correspondientes a varios cursos escolares. En alguna ocasión, seguro que querremos conocer estadísticas relativas a un año en concreto. Si quisiéramos conocer la mediana del número

de insuficientes en el año 1999, podríamos introducir la siguiente orden

median(IN[Año==1999])

la condición de selección se indica entre corchetes. En este caso se dice: coge los registros correspondientes a 1999, fíjate en la variable IN y calcula su mediana1.

Las condiciones de selección se pueden anidar. Por ejemplo, si queremos analizar

sólo la evaluación final, escribiríamos

median(IN[Año==1999&Evaluación=="F"])

En muchas ocasiones nos interesará (o, incluso, será preciso) eliminar los valores perdidos para efectuar un análisis. Por ejemplo, la función median() no funciona si existen

NA’s en la variable. En muchas ocasiones podemos remediar el problema introduciendo la opción na.rm=T en la función como vemos a continuación.

median(IN)

[1] NA

median(IN,na.rm=T)

[1] 2

En el primer caso la función no actúa correctamente; en el segundo, sí.

4.3.4. Extracción de casos

Esta es otra de las operaciones básicas del análisis estadístico, especialmente cuando tenemos ficheros de datos muy grandes.

Como casi todo en R, hay varias maneras de llevar a cabo tal selección. Una de

ellas es mediante la función subset(). En este caso introduciremos una condición que

afecta a los registros y no a las variables. Por ejemplo, para seleccionar alumnos/as con

más de 3 insuficientes deberíamos proceder de la siguiente manera

granfracasoescolar<-subset(resultados,IN>3)

en este caso, a continuación del nombre del data.frame se introduce el nombre de la

variable, y la condición de selección. Hay que hacer notar que la condición de igualdad

se indica con doble signo igual (==). Para ver el resultado, utilizaremos de nuevo str()

str(granfracasoescolar)

‘data.frame’: 1581 obs. of 9 variables:

$ Evaluacion: Factor w/ 3 levels "1","2","F": 2 1 2 3 1 2 3 3 3 2 ...

$ Curso : num 2 1 1 2 1 2 1 2 1 1 ...

$ B : num 0 0 0 0 0 0 0 0 0 0 ...

$ IN : num 0 0 0 0 0 0 0 0 0 0 ...

$ NT : num 3 3 3 3 3 3 3 3 3 3 ...

1 Como hemos hecho previamente attach(resultados), podemos referirnos directamente a IN. De lo contrario, deberíamos haber tecleado resultados$IN

4.3. MANIPULACIÓN DE DATA.FRAMES

31

$ SB : num 6 6 6 6 6 6 6 6 6 6 ...

$ SF : num 0 0 0 0 0 0 0 0 0 0 ...

$ Año : Factor w/ 8 levels "1994","1995",..: 5 5 8 7 5 8 5 7 6 7 ...

$ Alumno : Factor w/ 4838 levels "1","2","3","4",..: 3117 3208 2692 3834 3619 3896

4024 4188 2693 3835 ...

Podemos ver que el nuevo data.frame sigue teniendo las mismas 9 variables pero el

número de casos se ha reducido de 4838 a 1581.

En muchas ocasiones la condición de selección es múltiple. En ese caso no hay más

que encadenarlas con el signo &. Por ejemplo, para seleccionar el alumnado con más

de tres notables y con tres bienes habría que teclear

selección<-subset(resultados,NT>3 & B==3).

Una manera menos intuitiva de conseguir el mismo resultado es la siguiente

selección<-resultados[resultados$NT>3& resultados$B==3 ]

Combinando las dos posibilidades estudiadas anteriormente, se puede realizar una

extracción simultanea de variables y casos. Así, para crear un data.frame que contenga

sólo el número de caso y el número de insuficientes del alumnado correspondiente al

año 1998 podríamos teclear

otraseleccion<-subset(resultados,Año==1998,select=c(Alumno,IN))

En alguna ocasión puede interesarnos eliminar del análisis todos los datos en los

que haya algún valor perdido. Como veremos, esta puede ser una medida extrema ya

que hay funciones en R que nos permiten ignorar los casos con valores perdidos para

las variables implicadas sin necesidad de eliminarlas del data.frame (ver la sección de

Estadística básica). En cualquier caso, si quisiéramos hacerlo, podríamos teclear

sinNA<-na.omit(resultados)

lo que crearía un nuevo data.frame en el que encontraremos sólo los casos completos.

4.3.5. Introducción de variables

Hay dos situaciones que pueden hacer necesaria la entrada de nuevas variables en

un data.frame.

1. cuando deseamos obtener una nueva variable calculada a partir de variables ya

contenidas en el data.frame

2. cuando necesitamos actualizar los datos que teníamos

El primer problema es de naturaleza matemática; el segundo es un problema más bien

de edición. Veamos cómo podemos afrontar ambas situaciones.

Añadir variables calculadas a un data.frame

Resulta bastante sencillo llevar a cabo esta operación. Supongamos que quisiéramos introducir en nuestro data.frame resultados un índice de resultados académicos

del estilo

indice = (NT + SB/IN + SF + B + NT + SB) ∗ 100

Para llevarlo a cabo deberíamos teclear la siguiente orden

resultados$indice<-(NT+SB)/(IN+SF+B+NT+SB)*100

32

CAPÍTULO 4. GESTIÓN DE OBJETOS Y FICHEROS

que viene a decir calcula la suma de notables y sobresalientes, divídela entre el número total de notas, multiplica el resultado por cien y colócalo en la variable que llamo

indice en el data.frame resultados. (Nótese que, de nuevo, presuponemos que el data.frame resultados está en la ruta de búsqueda. De lo contario, no podríamos llamar

directamente a las variables como hemos hecho en la orden anterior).

Como vemos, el problema se reduce a una operación de asignación; cuestión que ya

hemos analizado anteriormente. El resultado sería el siguiente

str(resultados)

‘data.frame’: 4838 obs. of 10 variables:

$ Evaluacion: Factor w/ 3 levels "1","2","F": 3 3 2 2 3 3 3 2 3 1 ...

$ Curso : num 1 2 1 1 1 1 2 2 1 2 ...

$ B : num 0 0 0 0 0 0 0 0 0 0 ...

$ IN : num 0 0 0 0 0 0 0 0 0 0 ...

$ NT : num 0 0 0 1 1 1 1 1 1 1 ...

$ SB : num 9 9 9 8 8 8 8 8 8 8 ...

$ SF : num 0 0 0 0 0 0 0 0 0 0 ...

$ Año : Factor w/ 8 levels "1994","1995",..: 5 6 8 5 7 7 5 6 5 6 ...

$ Alumno : Factor w/ 4838 levels "1","2","3","4",..: 4838 1334 2774 2979 3186 3331

3336 3978 3979 2607 ...

$ indice : num 100 100 100 100 100 100 100 100 100 100 ...

como podemos observar, en el data.frame resultados aparece en último lugar la nueva

variable indice.

Incorporación de nuevas variables

Puede ocurrir que en un momento determinado de nuestra investigación necesitemos añadir alguna variable a nuestros registros. Como hemos dicho antes, esto es más

bien un problema de edición y, por lo general, resulta mejor idea resolverlo fuera de

R e incorporar el nuevo conjunto de datos por los medios de importación que ya hemos estudiado anteriormente. Sin embargo, vamos a ver algunas maneras de resolver

la cuestión dentro de R.

Si tenemos dos data.frames con uno o varios campos (utilizando la terminología de las

bases de datos) en común, podemos utilizar la función merge() para incorporar campos

(variables) de uno a otro. Como siempre que se desea enlazar dos tablas, debemos indicar sus nombres, y qué campos tienen en común.

Supongamos que tenemos dos data.frame como los siguientes

enfe

Nombre Enero Febrero

1 María 10 20

2 José 20 10

3 Sara 30 40

ma

Nombre Marzo

1 María 13

2 José 45

3 Sara 32

4.3. MANIPULACIÓN DE DATA.FRAMES

33

enfe almacena los puntos acumulados por tres alumnos/as en los meses de enero y febrero. ma almacena los que han almacenado, los mismos alumnos durante marzo. Para

añadir los datos de marzo a los de enero y febrero deberíamos teclear

merge(enfe,ma,by.x="Nombre",by.y="Nombre")

el resultado sería

Nombre Enero Febrero Marzo

1 José 20 10 45

2 María 10 20 13

3 Sara 30 40 32

Como se ve, el resultado es el deseado. En este caso nos ha parecido conveniente

crear un nuevo data.frame (mediante una asignación) con los datos de los tres meses. Si

quisiéramos añadir la variable a un data.frame existente sin crear uno nuevo, lo único

que deberíamos hacer es asignar el resultado de la función merge a dicho data.frame.

En este caso,

enfe<- merge(enfe,ma,by.x="Nombre",by.y="Nombre")

añadiría los datos de marzo al data.frame enfe.

En muchas ocasiones, los data.frames a unir no tienen exactamente los mismos registros. En el caso anterior, por ejemplo, en el mes de marzo podría haberse incorporado

algún alumno nuevo. Para que le resultado de la unión recoja todos los registros contenidos en uno y otro data.frame debemos modificar un poco la orden

merge(enfe,ma,by.x="Nombre",by.y="Nombre",all.x=T,all.y=T)

con esos all.x=T y all.y=T (la T hace referencia al inglés TRUE, VERDAD) le decimos

que incorpore todos los casos (all) del data.frame x (el que ponemos en primer lugar),

y también del data.frame y . Como es natural, en este caso se completarán con NA’s los

valores de las variables para los que no tengamos datos.

Hay que tener en cuenta que sin esos dos argumentos, sólo los casos comunes a ambos

data.frame serían seleccionados.

Finalmente, si sólo quisiéramos considerar los casos incluidos en uno de los data.frame,

deberíamos indicarlo en la orden. Por ejemplo,

merge(enfe,ma,by.x="Nombre",by.y="Nombre",all.y=T)

daría como resultado la unión considerando sólo los alumnos presentes en el mes de

marzo, que es el data.frame y.

4.3.6. Incorporación de registros

Vamos a considerar ahora la posibilidad de añadir a un data.frame nuevos registros

de las mismas variables. En el apartado anterior hemos visto que la función merge()

permitía incorporar casos nuevos cuando añadíamos variables a un data.frame. Sin

embargo, en ese caso, los nuevos registros no presentaban valores para las variables

previas. En el caso de que sí lo hicieran, los valores de los registros nuevos no se

incorporarían a la variable del data.frame previo sino que la variable se duplicaría. Por

lo tanto, para añadir registros a un data.frame utilizaremos otra función: rbind().

Supongamos que al dataframe enfe con el que trabajábamos antes queremos añadirle los casos contenidos en este otro llamado nuevo

Nombre Enero Febrero Marzo

34

CAPÍTULO 4. GESTIÓN DE OBJETOS Y FICHEROS

1 Manuel 45 1 14

2 Aurora 10 2 32

3 Jorge 2 4 20

Si ejecutamos union<-rbind(enfe,nuevo), conseguiremos nuestro cometido. El resultado será:

Nombre Enero Febrero Marzo

1 José 20 10 45

2 María 10 20 13

3 Sara 30 40 32

4 Manuel 45 1 14

5 Aurora 10 2 32

6 Jorge 2 4 20

Hay que hacer notar que no es preciso que el orden de las variables en los dos data.frame sea el mismo, pero sí el nombre de las mismas. Por otro lado, no hay problema

en unir data.frames en los que las variables sean de tipo numérico o de carácter, pero si

alguna de ellas es un factor, de todas las clases contenidas en el data.frame que vamos

a añadir, sólo las que estén presentes en el data.frame de destino serán reconocidas.

Todas las demás serán ignoradas y transformadas en NA’s con la consiguiente pérdida de información. Por lo tanto, si nuestros data.frames contienen factores, puede ser

conveniente transformarlos en vectores (con la función as.vector()) antes de proceder

a incorporar datos de uno a otro. Otra posibilidad sería almacenar las variables de tipo

carácter como tales (sin transformarlas en factores) al leer ficheros externos. Para ello

habría que añadir la opción as.is=T en la función read.table().

4.3.7. Ordenación de variables

En algunas ocasiones es necesario disponer los casos en orden ascendente del valor

de una variable. En R podemos llevar a cabo esta ordenación con la función sort(). Así,

sort(cars$speed) nos devolverá un vector con los valores de la variable de los casos

ordenados de menor a mayor.

La función order() también está relacionada con las operaciones de ordenación de variables. En este caso, la función nos devuelve un vector que nos indica en qué posición

se encuentra el caso con el valor mínimo, el segundo más bajo, el tercero, . . . , hasta

llegar a indicar la posición que ocupa el valor máximo. Obviamente, si la variable está

en orden ascendente, order() proporcionará el vector (1,2,3,....,n) siendo n el número

de casos.

Capítulo 5

Estadística descriptiva

En este capítulo veremos cómo realizar en R una serie de análisis estadísticos básicos. Se da por supuesto que el lector conoce el cometido y significado de todos ellos,

por lo que las referencias en este sentido serán reducidas.

5.1. Análisis exploratorio de los datos

En este apartado vamos a considerar algunas de las posibilidades que ofrece R para

recabar información básica de la naturaleza de las variables que deseamos analizar.

Además estudiaremos algunos procedimientos gráficos: el gráfico stem and leaf, el

boxplot y el histograma.

5.1.1. Medidas características

Como dijimos anteriormente, la función summary() proporciona información básica acerca de una variable. También acepta como argumento un data.frame, en cuyo

caso la salida informará acerca de todas las variables contenidas en el mismo.

Otras funciones nos dan medidas estadísticas de forma aislada. Ya comentamos algunas

de ellas (mean(),median(),max(),min(),sum(), var()). Otras son range(), que nos muestra los valores mínimo y máximo, pero no el rango; sd(), que devuelve la desviación

estandard; y quantile(), que nos va a permitir dividir la variable en partes iguales para

obtener los cuartiles, deciles o percentiles. Veamos su funcionamiento para la variable

IN

quantile(resultados$IN,probs=1:10/10,na.rm=T)

10 % 20 % 30 % 40 % 50 % 60 % 70 % 80 % 90 % 100 %

0

0

0

1

2

3

4

5

7

10

Como vemos, con la función hemos obtenido los diez deciles de la variable.

Sin embargo, no existe ninguna función que nos proporcione un listado o una tabla

con todas las medidas estadísticas que puedan interesarnos. De lo que sí dispone R (por

35

36

CAPÍTULO 5. ESTADÍSTICA DESCRIPTIVA

ser en definitiva un lenguaje de programación) es la posibilidad de editar personalmente operaciones aritméticas y de crear funciones que realicen determinadas operaciones.

En el siguiente ejemplo se puede ver cómo se crea una función que nos devuelva la

media, suma, desviación estandard, variancia y rango de una variable. Una vez creada,

podremos aplicarla a cualquier variable.

estadisticos <-function(x){

+ cat("\n","La media es",mean(x),"\n")

+ cat("\n","La suma es",sum(x),"\n")

+ cat("\n","La desviacion estandard es",sd(x),"\n")

+ cat("\n","La variancia es",var(x),"\n")

+ cat("\n","El rango es","[",range(x),"]","\n") + }1

Las funciones deben tener un nombre, en este caso estadisticos, y su cuerpo va

encerrado entre llaves ({}) . En el ejemplo, la función es una sucesión de funciones

cat() (que encadena secuencias decaracteres) y las funciones estadísticas que queremos

obtener. Por supuesto, pueden añadir todas las que deseen. . .

Una vez creada, se puede aplicar a cualquier variable; por ejemplo cars$speed. Así,

estadisticos(cars$speed)

devuelve

La media es 15.4

La suma es 770

La desviacion estandard es 5.287644

La variancia es 27.95918

El rango es [ 4 25 ]

Esta función estará disponible en el espacio de trabajo siempre y cuando sea guardada