Visualización de Escenas 3D Fotorealistas mediante Hardware

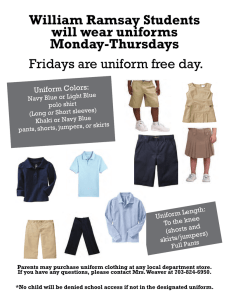

Anuncio