CADENAS DE MARKOV. INTRODUCCION Una cadena de

Anuncio

UNIVERSIDAD NACIONAL ABIERTA Y A DISTANCIA – UNAD

Escuela de Ciencias Básicas, tecnologías e ingeniería

Contenido didáctico del curso Teoría de decisiones

CAPITULO 5. DECISONES BAJO RIESGO – CADENAS DE MARKOV.

INTRODUCCION

Una cadena de Markov es una serie de eventos, en la cual la probabilidad de que

ocurra un evento depende del evento inmediato anterior; En efecto, las cadenas

de este tipo tienen memoria, "recuerdan" el último evento y esto condiciona las

posibilidades de los eventos futuros. Esta dependencia del evento anterior

distingue a las cadenas de Markov de las series de eventos independientes, como

tirar una moneda al aire o un dado.

En los negocios, las cadenas de Markov se han utilizado para analizar los

patrones de compra de los deudores morosos, para planear las necesidades de

personal y para analizar el reemplazo de equipo; El análisis de Markov, llamado

así en honor de un matemático ruso que desarrollo el método en 1907, permite

encontrar la probabilidad de que un sistema se encuentre en un estado en

particular en un momento dado.

Algo más importante aún, es que permite encontrar el promedio a la larga o las

probabilidades de estado estable para cada estado, con esta información se

pueden predecir el comportamiento del sistema a través del tiempo. La tarea más

difícil es reconocer cuándo puede aplicarse.

La característica más importante que hay que buscar en la memoria de un evento

a otro, las cadenas de Markov se incluyen dentro de los denominados procesos

estocásticos, estos procesos estudian el comportamiento de variables aleatorias a

lo largo del tiempo X(t,w), definiéndose como una colección de variables aleatorias

{X(t,w), t ∈ I}, donde X (t,w) puede representar por ejemplo los niveles de

inventario al final de la semana t.

El interés de los procesos estocásticos es describir el comportamiento de un

sistema y su operación durante algunos periodos, se pueden clasificar atendiendo

a dos aspectos: 1.- si el espacio de estados posibles de la variable aleatoria

contiene valores discretos o continuos y 2.- si los valores del tiempo son discretos

o continuos.

Las cadenas de Markov son un proceso estocástico en el que los valores del

tiempo son discretos y los estados posibles de la variable aleatoria contienen

valores discretos, es decir, es una cadena estocástica de tiempo discreto. Las

cadenas de Markov, se clasifican, además, dentro de los procesos estocásticos de

Markov, que son aquellos en el que el estado futuro de un proceso es

80

UNIVERSIDAD NACIONAL ABIERTA Y A DISTANCIA – UNAD

Escuela de Ciencias Básicas, tecnologías e ingeniería

Contenido didáctico del curso Teoría de decisiones

independiente de los estados pasados y solamente depende del estado presente.

Por lo tanto las probabilidades de transición entre los estados para los tiempos k-1

y k solamente depende de los estados que la variable adquiere dichos tiempos.

Lección 21. PROCESOS ESTOCÁSTICOS.

La teoría de los procesos estocásticos se centra en el estudio y modelización de

sistemas que evolucionan a lo largo del tiempo, o del espacio, de acuerdo a unas

leyes no determinísticas, esto es, de carácter aleatorio.

La forma habitual de describir la evolución del sistema es mediante sucesiones o

colecciones de variables aleatorias. De esta manera, se puede estudiar cómo

evoluciona una V.A. a lo largo del tiempo; Por ejemplo, el número de personas que

esperan ante una ventanilla de un banco en un instante t de tiempo; el precio de

las acciones de una empresa a lo largo de un año; el número de parados en el las

estaciones de buses a lo largo de un año.

La primera idea básica es identificar un proceso estocástico con una sucesión de

v.a. {Xn, n ∈ N} donde el subíndice indica el instante de tiempo (o espacio)

correspondiente; Esta idea inicial se puede generalizar fácilmente, permitiendo

que los instantes de tiempo en los que se definen las v.a. sean continuos. Así, se

podrá hablar de una colección o familia de v.a. {Xt, t ∈ R}, que da una idea más

exacta de lo que es un proceso estocástico.

Se tiene que una v.a. X(s) es una función que va desde un espacio muestral S a

la recta real, de manera que a cada punto s ∈ S del espacio muestral se le puede

asociar un número de la recta real. De este modo, la probabilidad de cada suceso

de S se puede trasladar a la probabilidad de que un valor de X (v.a.) caiga en un

cierto intervalo o conjunto de números reales. Si a todo esto se le añade una

dimensión temporal, se obtiene un proceso estocástico.

La definición formal es la siguiente:

Dado el espacio de probabilidad (Ω,a, P ) de modo que para todo t ∈ T ⊂ R fijo

Xt : (Ω,a, P ) −→ (R, B)

w −→ Xt(w) ∈ R

Esto es, Xt es una variable aleatoria y ∀w ∈ Ω fijo, X•(w) es una función del tiempo.

Ejemplos:

Xt: número de personas que esperan un autobús en un instante t donde t ∈ [9, 10]

Xt: precio de una acción de una empresa en un día t del mes (t = 1, 2, . . . , 30).

Xt: número de parados en el mes t (t = 1, 2, . . . , 12).

81

UNIVERSIDAD NACIONAL ABIERTA Y A DISTANCIA – UNAD

Escuela de Ciencias Básicas, tecnologías e ingeniería

Contenido didáctico del curso Teoría de decisiones

Para que un proceso estocástico esté completamente definido hay que determinar

completamente las v.a., es decir, determinar e identificar la distribución de

probabilidad asociada a cada una de ellas y, es más, la distribución conjunta de

todas ellas.

Al conjunto T ⊂ R de subíndices se le denomina conjunto paramétrico y puede

ser continuo o numerable. De este modo aparece una primera clasificación en

procesos estocásticos de parámetro continuo o de parámetro discreto.

Se denomina conjunto de estados E, al conjunto de los posibles valores que

pueden tomar las v.a. {Xt}t∈R; En general, se piensa en el subíndice t como el

indicativo del tiempo y en Xt como el estado o posición del proceso estocástico en

el instante t.

EJEMPLO 15: Se lanza una moneda varias veces. Supóngase que cada vez que

sale cara, un jugador gana 1 unidad y si sale sello pierde 1 unidad. Se puede

definir un proceso estocástico que modeliza la evolución del juego.

Así, si se denomina Xn al número de unidades monetarias que quedan después

de n lanzamientos, el espacio muestral de Xn es

Ω = {n-uplas de cara y sello}

De modo que el cardinal (el número de elementos) del conjunto es

#Ω = 2n

Y el álgebra que se define es a = P (Ω), esto es, las partes de Ω (todos los

posibles subconjuntos que se pueden formar en Ω).

Consideramos a todas las posibles n-uplas equiprobables: P (w) = 1/2n.

Es un proceso discreto, porque el conjunto paramétrico es T = {1, 2, 3,. . .} y el

posible conjunto de estados es

E = {. . ., −3, −2, −1, 0, 1, 2, 3. . .}

Podemos estudiar la trayectoria de X (w):

Sea n = 6 y fijo, por ejemplo, w = (c, c, s, s, s, s) , esto es,

X1(w) = 1

X2(w) = 2

X3(w) = 1

X4(w) = 0

X5(w) = −1

X6(w) = −2

82

UNIVERSIDAD NACIONAL ABIERTA Y A DISTANCIA – UNAD

Escuela de Ciencias Básicas, tecnologías e ingeniería

Contenido didáctico del curso Teoría de decisiones

Ahora, si fijamos t, por ejemplo en t = 3, se puede calcular la distribución de X3. El

conjunto de posibles estados de X3 es:

-1

0

1

1

3

2

1

1

0

0

-1

-3

-1

-2

-1

De modo que E = {−3, −1, 1, 3} y

P {X3 = −3} = 1/ 23 = 1/8

P {X3 = −1} = 3* 1/23 = 3/8

P {X3 = 1} = 3* 1/23 = 3/8

P {X3 = 3} = 1/23 = 1/8

Se puede definir una nueva variable aleatoria:

Y ≡ número de caras obtenidas (éxitos).

Se observa, entonces, que

Y

Bin (3, p =1/2)

Y así

P {Y = 0} = P {X3 = −3} = 1/23 = 1/8

P {Y = 1} = P {X3 = −1} = 3*1/23 = 3/8

P {Y = 2} = P {X3 = 1} = 3*1/23 = 3/8

P {Y = 3} = P {X3 = 3} = 1/23 = 1/8

Luego X3 se distribuye como una Bin=(3, p = ½), aunque tomando otros valores

que los estrictamente igual a 0, 1, 2, 3.

Se identifica así el proceso estocástico, y se puede preguntar uno cuál es la

probabilidad de que a las 10 tiradas se tengan unidades monetarias negativas,

esto es que se arruine el jugador.

- Un proceso estocástico de tiempo discreto es una descripción de la relación

entre las variables aleatorias X0, X1,...que representan alguna característica de un

sistema en puntos discretos en el tiempo.

83

UNIVERSIDAD NACIONAL ABIERTA Y A DISTANCIA – UNAD

Escuela de Ciencias Básicas, tecnologías e ingeniería

Contenido didáctico del curso Teoría de decisiones

Por ejemplo la ruina del jugador: inicialmente tengo $2, en los tiempos

1,2,...participo en un juego en el que apuesto $1 que gano con probabilidad p y

pierdo con probabilidad 1-p; Dejo de jugar cuando mi capital es $4 o he perdido

todo mi capital.

Si Xi es la cantidad de dinero que tengo en el tiempo i, X0, X1,... es un proceso

estocástico.

Un proceso estocástico de tiempo continuo es un proceso estocástico en el que el

estado del tiempo se puede examinar en cualquier momento, por ejemplo el

número de personas en un supermercado a los t minutos de abrir.

Lección 22. CADENAS DE MARKOV.

Una Cadena de Markov es un proceso estocástico de tiempo discreto que para

t=0, 1, 2,.. y en todos los estados se verifica P(Xt+1=it+1 | Xt=it, Xt-1=it-1, ...,

X1=i1,X0=i0)=P(Xt+1=it+1|Xt=it)

La Hipótesis de estabilidad es la probabilidad P (Xt+1=i t+1t=i)=pij (no depende de t)

La probabilidad de transición es pij

La Matriz de probabilidades de transición es

P11 p12 ... p1s

P21 P22 ... P2s

P=

Ps1 Ps2 … 0 Pss

Donde se debe verificar que la Σ pj =1

j=1

Las cadenas de Markov que cumplen la hipótesis de estabilidad se llaman

cadenas estacionarias de Markov.

La distribución inicial de probabilidad de una cadena de Markov es aquella

q = [q1,...,qs] donde qi=P(X0=i)

EJEMPLO 16: la ruina del jugador es una cadena de Markov estacionaria

Estados: 0, 1, 2, 3, 4

Matriz de transición

1

1-p

0

0

0

0

0

1-p

0

0

0 0

p 0

0 p

1-p 0

0 0

0

0

0

p

1

84

UNIVERSIDAD NACIONAL ABIERTA Y A DISTANCIA – UNAD

Escuela de Ciencias Básicas, tecnologías e ingeniería

Contenido didáctico del curso Teoría de decisiones

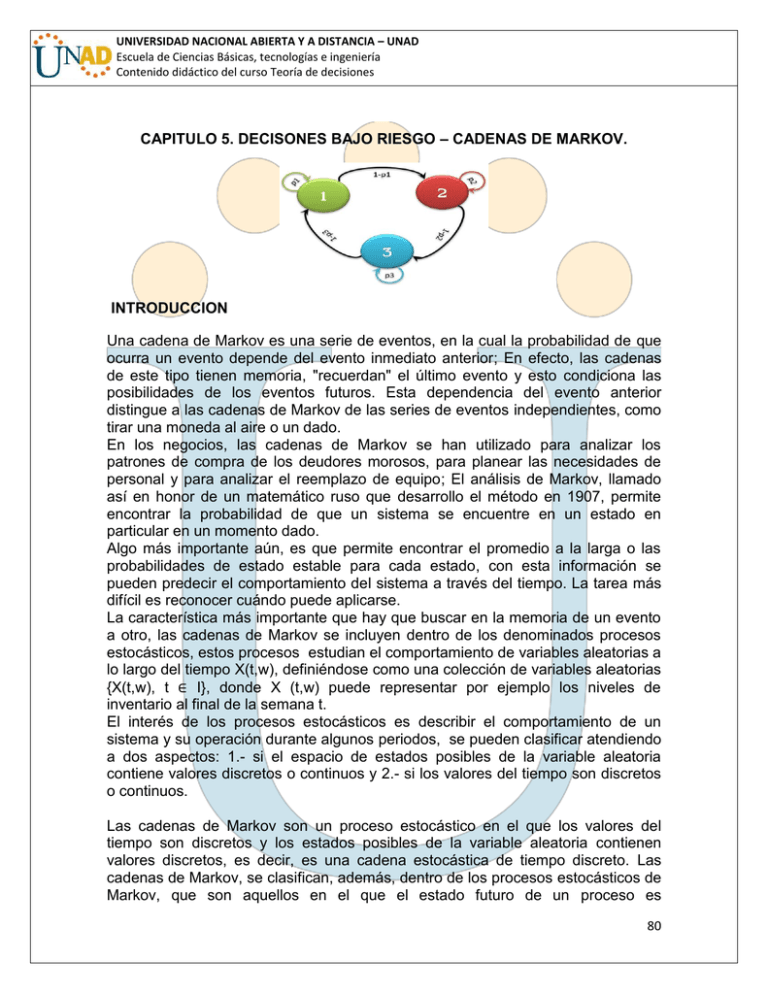

La anterior matriz de transición se puede representar con un grafo en el que cada

nodo representa un estado y cada arco la probabilidad de transición entre estados.

Grafica 12. Esquema de una matriz de transición.

PROBABILIDADES DESPUÉS DE N PASOS.

Si una cadena de Markov estacionaria está en el estado i en el tiempo m, ¿cuál es

la probabilidad de que n períodos después la cadena esté en el estado j?

P (Xm+n =j |Xm= i) = P(Xn= j | X0=i)=Pij(n)

Donde,

Pij(n) es la probabilidad en la etapa n de una transición del estado i al estado j

s

Pij (1)=Pij, Py(2)= Σ Pik PKj

K=1

Pij (n) elemento ij-ésimo de Pn que es la probabilidad de estar en el estado j en el

s

tiempo n = Σ qi py (n)

i=1

EJEMPLO 17. El ascensor de un edificio con bajo y dos pisos realiza viajes de

uno a otro piso. El piso en el que finaliza el viaje n-ésimo del ascensor sigue una

cadena de Markov. Se sabe que la mitad de los viajes que parten del bajo se

dirigen a cada uno de los otros dos pisos, mientras que si un viaje comienza en el

primer piso, sólo el 25% de las veces finaliza en el segundo. Por último, si un

trayecto comienza en el segundo piso, siempre finaliza en el bajo. Se pide:

a) Calcular la matriz de probabilidades de transición de la cadena

b) Dibujar el grafo asociado

c) ¿Cuál es la probabilidad de que, a largo plazo, el ascensor se encuentre en

cada uno de los tres pisos.

SOLUCIÓN:

a) Los estados de la cadena los denotaremos por {0, 1, 2} haciendo corresponder

el 0 al bajo y 1 y 2 al primer y segundo piso respectivamente.

Las probabilidades de transición son:

85

UNIVERSIDAD NACIONAL ABIERTA Y A DISTANCIA – UNAD

Escuela de Ciencias Básicas, tecnologías e ingeniería

Contenido didáctico del curso Teoría de decisiones

p00 = P(Rn=0 / Rn-1=0), esto es la probabilidad de que el ascensor se encuentre

en la planta baja si en la etapa anterior estaba en la planta baja. Obviamente es 0,

porque se supone que de etapa a etapa el ascensor se mueve.

p01 = P(Rn=1 / Rn-1=0), esto es la probabilidad de que el ascensor se encuentre

en la planta primera si en la etapa anterior estaba en la planta baja. Obviamente

es ½. Basta leer el enunciado. Y así sucesivamente vamos obteniendo las

distintas probabilidades de transición cuya matriz es:

c)

Lección 23. CLASIFICACIÓN DE ESTADOS EN UNA CADENA DE MARKOV.

Dados dos estados i y j, la trayectoria de i a j es la sucesión de transiciones que

comienza en i y termina en j, de forma que cada transición de la secuencia tenga

probabilidad positiva.

86

UNIVERSIDAD NACIONAL ABIERTA Y A DISTANCIA – UNAD

Escuela de Ciencias Básicas, tecnologías e ingeniería

Contenido didáctico del curso Teoría de decisiones

Un estado j es alcanzable desde un estado i si hay una trayectoria de i a j, por lo

tanto si dos estados i y j se comunican si i es alcanzable desde j y j es alcanzable

desde

i.

Un conjunto de estados S en una cadena de Markov es cerrado (constituyen una

clase de la cadena) sin ningún estado fuera de S es alcanzable desde un estado

en S.

Un estado i es absorbente si pii=1

Un estado i es transitorio si hay un estado j alcanzable desde i, pero el estado i

no es alcanzable desde j.

Un estado es recurrente si no es transitorio.

Un estado i es periódico con periodo k>1 si k es el menor número tal que todas

las trayectorias que parten del estado i y regresan al estado i tienen una longitud

múltiplo de k.

Si un estado recurrente no es periódico es aperiódico.

Si todos los estados de una cadena son recurrentes, aperiódicos y se comunican

entre sí, la cadena es ergódica.

PROBABILIDADES EN ESTADO ESTACIONARIO.

Si P es la matriz de transición de una cadena ergódica de S estados entonces

existe un vector =[ 1 2 ... 3 ] tal que

n

Lim P

n

∞

=

1

2...

s

1

2...

s

1

2...

s

Es decir,

Lim Pij =(n)= J

n

∞

Se le llama distribución de estado estable o de equilibrio para la cadena de

Markov.

-

se puede determinar a partir de la ecuación:

j

=

Σ Pkj

K=1

- En forma matricial

= p

- Este sistema tiene un número infinito de soluciones porque el rango de P

siempre resulta ser menor o igual que s-1; También se debe verificar que,

87

UNIVERSIDAD NACIONAL ABIERTA Y A DISTANCIA – UNAD

Escuela de Ciencias Básicas, tecnologías e ingeniería

Contenido didáctico del curso Teoría de decisiones

1 +π2 +...

+

s=

1

INTERPRETACIÓN INTUITIVA DE LAS PROBABILIDADES DE ESTADO

ESTABLE.

(1

–Pj

)

=Σ

πκ

Pk

j

j

j

K≠

j

La probabilidad de que una transición determinada deje el estado j es igual a la

probabilidad de que una transición determinada entre al estado j.

La probabilidad de que una transición determinada deje el estado j =

j

(1 − p j j)

La probabilidad de que una transición determinada entre al estado j= Σ π κ Pk j

K≠ j

En el estado estable el flujo de probabilidad hacia cada estado debe ser igual al

flujo de probabilidad que sale de cada estado o sea son las probabilidades de

equilibrio.

ANÁLISIS DE ESTADO TRANSITORIO

El comportamiento de una cadena de Markov antes de alcanzar el estado estable

se llama comportamiento transitorio. Para su estudio se utiliza las fórmulas

dadas anteriormente para Pi j(n).

Lección 24. PROCESO DE DECISIÓN MARKOVIANO

Consiste en la aplicación de la programación dinámica a un proceso de decisión

estocástico, en donde las probabilidades de transición entre estado están

descritas por una cadena de Markov.

La estructura de recompensas del proceso está descrita por una matriz cuyos

elementos individuales son el costo o el beneficio de moverse de un estado a otro.

Las matrices de transición y de recompensas dependen de las alternativas de

decisión. El objetivo es determinar la política óptima que maximice el ingreso

esperado en un número finito o infinito de etapas.

MODELO DE ETAPAS FINITAS

Su objetivo es optimizar el ingreso esperado al final de un período de tamaño N,

donde,

Pk=[pi j k] y Rk=[ri j k] son las matrices de transición y recompensa para la

alternativa k,

88

UNIVERSIDAD NACIONAL ABIERTA Y A DISTANCIA – UNAD

Escuela de Ciencias Básicas, tecnologías e ingeniería

Contenido didáctico del curso Teoría de decisiones

fn(i) es el ingreso esperado óptimo de las etapas n, n+1,...,N si el estado del

sistema al inicio de la etapa n es i.

m

∫fn(i) = max ,

Σ

k

j=1

Pijk [rij k ∫n+1(j) ]

n = 1,2,…, n

∫n+1(j) = 0, j = 1,2, … ,m

EJEMPLO 18. Suponga que toda la industria de refresco produce dos colas: Coca

Cola y Pepsi Cola. Cuando una persona ha comprado Coca Cola hay una

probabilidad de 90% de que siga comprándola la vez siguiente. Si una persona

compró Pepsi, hay 80% de que repita la vez siguiente. Se pide:

a) Si una persona actualmente es comprador de Pepsi. ¿Cuál es la probabilidad

de que compre Coca Cola pasadas dos compras a partir de hoy?

b) Si en la actualidad una persona es comprador de Coca Cola. ¿Cuál es la

probabilidad de que compre Coca Cola pasadas tres compras a partir de ahora?

c) Supongamos que el 60% de toda la gente toma hoy Coca Cola y el 40% Pepsi.

A tres compras a partir de ahora, ¿Qué fracción de los compradores estará

tomando Coca Cola.

d) Determinar el estado estable.

SOLUCIÓN: La situación se puede modelar como una cadena de Markov con dos

estados {Coca-Cola, Pepsi-Cola}= {C, P}. La matriz de transición para el orden C,

P, es:

0,2 0,8

P=

0,9 0,1

a) Se pide la probabilidad de transición en dos pasos, es decir que se pide el valor

en fila 2, columna 1 para la matriz P2, obteniéndose que este es: 0,2.0,9+0,8.0,2

=0,34

b) Al igual que en el apartado anterior se pide el valor de probabilidad de transición

en fila 1 y columna 1 para la matriz P3.

Esto quiere decir que la solución al problema es 0,781.

c) El vector de probabilidad inicial es (0.6, 0.4), por tanto la probabilidad de

consumir ambos estados a partir de tres etapas es: (0.4, 0.6)*P3.

Calculamos primero P2, resultando que

89

UNIVERSIDAD NACIONAL ABIERTA Y A DISTANCIA – UNAD

Escuela de Ciencias Básicas, tecnologías e ingeniería

Contenido didáctico del curso Teoría de decisiones

Por lo tanto,

Entonces el resultado solicitado es 1/10000 *(6438 3562) = (0.6438, 0.3562);

esto es que al cabo de tres compras el 64’38% comprará Coca Cola y el 35’62%

comprará Pepsi Cola.

d) El estado estable se determina resolviendo el sistema de ecuaciones:

Añadiendo la ecuación x+y = 1, siendo x la probabilidad de que una persona

compre Coca Cola a largo plazo e y lo mismo de que compre Pepsi Cola. El

sistema resultante es:

Obsérvese que las dos primeras ecuaciones son la misma por tanto quedémonos

con las dos últimas, obteniendo como solución:

x = 2/3; y = 1/3.

MODELOS DE ETAPAS INFINITAS

Se desarrollaran varios métodos para este modelo de etapas, en el cual se buscan

las políticas para que existan soluciones de estado estable.

Métodos:

• Enumeración exhaustiva: se evalúan todas las políticas estacionarias posibles

del problema de decisión

• Iteración de política: determina la política óptima de forma iterativa

ENUMERACIÓN EXHAUSTIVA

Problema de decisión con S políticas estacionarias

Pasos del método:

1.- Calcular el ingreso de una etapa esperado de la política s dado el estado i,

i = 1,2,...,m:

m

V1s

= Σ Pij rijS

J=i

90

UNIVERSIDAD NACIONAL ABIERTA Y A DISTANCIA – UNAD

Escuela de Ciencias Básicas, tecnologías e ingeniería

Contenido didáctico del curso Teoría de decisiones

2.- Calcular las probabilidades estacionarias de largo plazo de la matriz de

transición asociada a la política s.

3.- Determinar el ingreso esperado de la política s por paso de transición:

m

Es =

Σ

i

s

vis

i=1

4.- La política óptima s* se determina de forma que Es* = max{Es}

Para una política específica el rendimiento total esperado en la etapa n es,

m

∫n(i) = Vi + Σ Pij ∫n+1(j), i= 1,2, ... , m

k j=1

η número de etapas que faltan por considerar:

m

Σ Pij ∫n – 1 (j), i= 1,2, ... , m

∫n(i) = Vi +

j=1

El comportamiento asintótico del proceso se estudia haciendo η→∞

ITERACIÓN DE POLÍTICAS

El ingreso esperado por etapa es E=π1v1 + π2v2 +...+ πmvm

Para η grande donde ∫n(i) ηΕ +∫(i) es un término constante que representa el

efecto sobre el ingreso de comenzar en el estado i.

Sustituyendo en la ecuación recursiva y simplificando

m

E=V1 + Σ Pij ∫ (j) - ∫ (i), i= 1,2, ... , m

J=1

Que es un sistema de m ecuaciones y m+1 incógnitas: E, f(1),...,f(m).

Para determinar el valor máximo de E se sigue un proceso iterativo que termina

cuando dos políticas sucesivas son idénticas:

1.- Determinación del valor: se elige una política arbitraria s. Suponiendo fs(m)=0

se resuelven las ecuaciones:

91

UNIVERSIDAD NACIONAL ABIERTA Y A DISTANCIA – UNAD

Escuela de Ciencias Básicas, tecnologías e ingeniería

Contenido didáctico del curso Teoría de decisiones

m

Es=Vsi +Σ Psij ∫s(j) - ∫ (i), i= 1,2, ... , m

j=1

2.- Mejoramiento de política: Para cada estado i determina la política k que

produce

m

MAX

K

Vi K

Σ PK ij ∫ s(j )

, i= 1,2, ... , m

j=1

Las decisiones óptimas que resultan para los estados 1,2,..., m constituyen la

nueva política t. Si s y t son idénticas, t es óptima. Si no es así, se repite el

proceso con s=t.

EJEMPLO 19.PROBLEMA RATÓN:

Un ratón cambia de habitáculo cada minuto con igual probabilidad a las salas

adyacentes

Donde puede circular en las opciones planteadas en el esquema siguiente;

La matriz de probabilidades de transición es

P=

0

1/2

1/3

1/2

1/3

0

1/3

0

1/3

1/2

0

1/2

1/3

0

1/3

0

92

UNIVERSIDAD NACIONAL ABIERTA Y A DISTANCIA – UNAD

Escuela de Ciencias Básicas, tecnologías e ingeniería

Contenido didáctico del curso Teoría de decisiones

|λI–P|=0

Calculamos el espectro:

Autovalores:

λ=0

λ=1

λ = -1/3

λ = - 2/3

Multiplicidad 1 y único de

módulo 1

Existe distribución final.

P (λ) (I – P) = 0

Sistema de ecuaciones:

( PS , PH , PC ,PE )

1

-1/2

-1/3

-1/2

-1/3 -1/3 -1/3

1

-1/2 0

-1/3 1

-1/3

0

-1/2 1

= (0,0,0,0,0)

PS + P H + PC + P E = 1

Las Probabilidades son

-Salón

-Habitación

-Cocina

-Entrada

PS = 0,3

PH = 0,2

PC = 0,3

PE = 0,2

Existe distribución límite porque:

• El sistema tiene una sola clase final

• Esa clase final es aperiódica

PARA ACABAR CON EL RATÓN

• Se pone queso envenenado en la cocina

• Se abre la puerta de la entrada (S C)

93

UNIVERSIDAD NACIONAL ABIERTA Y A DISTANCIA – UNAD

Escuela de Ciencias Básicas, tecnologías e ingeniería

Contenido didáctico del curso Teoría de decisiones

Grafica 13. Probabilidades del ratón ejemplo 19.

¿Qué probabilidad hay de que el sistema sea absorbido en cada estado final?

• E, S y H son estados transitorios.

• C y SC son estados recurrentes o finales.

• La situación inicial del ratón determinará la situación futura.

• Si inicialmente está en E es más probable que salga de casa.

• Si inicialmente está en H es más probable que se quede en la cocina.

Matriz de transición:

1

0

0

1

0

0

Estructura de P:

0

0

0

0

I

O

R

Q

P=

1/3 0 0 1/3 1/3

0 1/3 1/3 0 1/3

0 1/3 1/3 1/3 0

P=

Matriz identidad (tantas columnas y filas como estados finales) ( I ).

Matriz 2 x 3 (tantas columnas como transitorios y tantas filas como estados finales)

(O).

Matriz 3 x 2 (Probabilidades de absorción en un solo salto) (R).

Matriz 3 x 3 (Probabilidad de transición entre transitorios) (Q).

QIJ es la probabilidad de que el sistema, encontrándose inicialmente en el estado

transitorio i acabe en el estado final j.

i = Entrada, Salón, Habitación (estados transitorios) (3, 4,5)

94

UNIVERSIDAD NACIONAL ABIERTA Y A DISTANCIA – UNAD

Escuela de Ciencias Básicas, tecnologías e ingeniería

Contenido didáctico del curso Teoría de decisiones

j = Cocina, Salir de casa (estados finales) (1,2)

Q31 = 1/3 + 1/3 Q41 + 1/3 Q51

Prob. De que estando en 4 pase a 1

Prob. de que se marche directamente

Q41 = 1/3 Q31 + 1/3 Q51

Q51 = 1/3 Q31 + 1/3 Q41

Resolvemos el sistema:

1 -1/3 -1/3

-1/3 1

-1/3

-1/3 -1/3 1

I-Q

Q31

Q41

Q51

-

Q32

Q42

Q52

1/3 0

0 1/3

0 1/3

=

=

R

Matriz de

absorción

en un salto

Matriz de prob.

Entre

transitorios

La probabilidad de acabar en cada uno de absorción

los estados finales en función de su

en

posición inicial.

Q31 Q32

Q41 Q42

Q51 Q52

=

un solo salto

1/2 1/2

1/4 3/4

1/4 3/4

La suma de los términos de las filas debe ser 1.

O termina en un estado final o en el otro.

La probabilidad de los estados transitorios es cero

Dependiendo de la situación inicial del ratón ¿Cuánto tiempo medio tardará en

desaparecer?

Llamamos mi al número medio de transiciones hasta la absorción si el sistema se

encuentra en el estado transitorio i.

mE Nos encontramos inicialmente en la entrada.

95

UNIVERSIDAD NACIONAL ABIERTA Y A DISTANCIA – UNAD

Escuela de Ciencias Básicas, tecnologías e ingeniería

Contenido didáctico del curso Teoría de decisiones

mi = es una v.a. de tipo discreto.

mi = 1, 2,3 ...

El ratón se va a la 1ª

SISTEMA DE ECUACIONES:

mE = 1 ·1/3 + 1/3 (1 + mS ) + 1/3 (1 + mH)

Pasar de la entrada al dormitorio

Tiempo

mS = 1 ·1/3 + 1/3 (1 + mE ) + 1/3 (1 + mH)

mH = 1 ·1/3 + 1/3 (1 + mE ) + 1/3 (1 + mS)

1 -1/3 -1/3

-1/3 1

-1/3

-1/3 -1/3 1

mS

mE =

mH

1

1

1

mS

mE

mH

3

= 3

3

I-Q

Independientemente de la sala donde se encuentre inicialmente, el tiempo que

transcurre hasta que nos deshacemos del ratón es tres.

EJEMPLO 20. PROBLEMA TELEFONÍA MÓVIL

Una agencia de telefonía móvil está estudiando la demanda presentada por el

Ayuntamiento de una población cercana a Madrid. Esta población se ha querellado

por una cobertura insuficiente del servicio de telefonía móvil. Concretamente

aseguran que el tiempo que tarda una llamada en cortarse es inferior a 10 minutos

cuando las personas que están hablando transitan por la calle o circulan en

vehículos.

Para verificar este hecho dos técnicos de telefonía se han desplazado a esta

localidad y han medido los niveles de calidad en conversaciones en los que ambos

interlocutores hablan manteniéndose quietos en sus sitios (estudio estático), y

también han hecho mediciones cuando ambos interlocutores andan por la calle

(estudio dinámico).

El estudio ha consistido en evaluar cada minuto los niveles de calidad de la

recepción de señal en ambos terminales móviles. En el estudio estático los niveles

de calidad de recepción en cada Terminal son dos, 1 y 2, de menor a mayor

calidad de recepción. En el estudio dinámico los niveles de calidad de recepción

son tres, 0, 1 y 2. El nivel 0 corresponde a la pérdida de la llamada.

96

UNIVERSIDAD NACIONAL ABIERTA Y A DISTANCIA – UNAD

Escuela de Ciencias Básicas, tecnologías e ingeniería

Contenido didáctico del curso Teoría de decisiones

Del resultado del estudio estático ha resultado que la probabilidad de que

cualquiera de los terminales mantenga su nivel de cobertura en el minuto siguiente

es del 80%, la probabilidad de que cada Terminal baje un nivel es de un 10% y de

que suba otro 10%. Por otra parte del estudio dinámico ha resultado que la

probabilidad de que la cobertura de cada Terminal se mantenga es del 70%, de

que cada Terminal suba un nivel es del 20% y de que baje un 10%.

EJEMPLO 21. Los consumidores de café en el área de Pontevedra usan tres

marcas A, B, C. En marzo de 1995 se hizo una encuesta en lo que entrevistó a las

8450 personas que compran café y los resultados fueron:

a) Si las compras se hacen mensualmente, ¿cuál será la distribución del mercado

de café en Pontevedra en el mes de junio?

b) A la larga, ¿cómo se distribuirán los clientes de café?

c) En junio, cual es la proporción de clientes leales a sus marcas de café?

SOLUCIÓN:

a) A la vista de las frecuencias anteriores, las probabilidades de transición,

conservando el mismo orden que la tabla (A, B, C) es:

De marzo a Junio hay 4 etapas por lo que nos piden las probabilidades de

transición al cabo de 4 meses, las que vendrán dada por los coeficientes de P4

97

UNIVERSIDAD NACIONAL ABIERTA Y A DISTANCIA – UNAD

Escuela de Ciencias Básicas, tecnologías e ingeniería

Contenido didáctico del curso Teoría de decisiones

b) A la larga se trata de la situación estable:

Resolviendo se obtiene: x = 5/21; y = 10/21; z = 2/7.

c) En Marzo la proporción de clientes de A es: 2028/8450 = 0,24; para B es

3718/8450 = 0,44 y para C es 2704/8450 = 0,32.

En el mes de junio la proporción es:

Lección 25. PROBLEMA ESTÁTICO Y DINAMICO.

La variable de estado de ambos estudio de ambos estudios es el nivel de

cobertura, y la cadena de Markov asociada será la siguiente:

La matriz de probabilidades de transición será:

98

UNIVERSIDAD NACIONAL ABIERTA Y A DISTANCIA – UNAD

Escuela de Ciencias Básicas, tecnologías e ingeniería

Contenido didáctico del curso Teoría de decisiones

0,81

0,09

0,9

0,01

PEE

0,09

0,81

0,01

0,09

0,09

0,01

0,81

0,09

0,01

0,09

0.09

0,81

La calidad de la conversación se establece como semisuma de los niveles de

cobertura de los terminales operativos. Sería interesante preguntarse si es posible

determinar la calidad media de conversaciones. Para calcularla estudiamos la

distribución límite de los estados, que existe porque hay una única clase final a

periódica.

Autovalores de PEE se obtienen haciendo

λ=1

λ = 0,8 (De multiplicidad 2)

λ = 0,64

λ. I - PEE = 0

La distribución límite existe, porque hay un auto valor λ = 1 de multiplicidad 1

(condición necesaria), y el resto de autovalores no tienen módulo 1 (condición

suficiente).

La distribución límite es la asociada al auto valor λ = 1

(p1, p2, p3, P4)

0,19

- 0,09

- 0,09

- 0,01

- 0,09

- 019

- 0,01

- 0,09

- 0,09 - 0,01

0

- 0,01 - 0,09

0

- 0,09 - 0,09 = 0

- 0,09

0,19

0

P1 +p2 + p3 + p4 = 1

0,19 - 0,09 - 0,09 - 0,01

- 0,09 0,19 - 0,01 - 0,09

- 0,09 - 0,01 - 0,19 - 0,09

1

1

1

1

P1

P2

P3

P4

0

= 0

0

0

(P1 P2 P3 P4) = (0,25 0,25 0,25 0,25)

La calidad media de las conversaciones estáticas:

q =(1+1). P1 + (1+2). P2 +(1+2). P3+(2+2). P4

q =2 * 0,25 +3 0,25 + 3 0,25 +4 *0,25 =1,5

2

99

UNIVERSIDAD NACIONAL ABIERTA Y A DISTANCIA – UNAD

Escuela de Ciencias Básicas, tecnologías e ingeniería

Contenido didáctico del curso Teoría de decisiones

PROBLEMA DINÁMICO.

Considerando variable de estado el nivel de cobertura, la cadena de Markov

asociada será la siguiente:

La matriz de probabilidades de transición será:

PED =

I O

RQ

PED

1

0

0

0

0

0,01

0

0

0

0

1

0

0

0

0,07

0,01

0

0

0

0

1

0

0

0,02

0,09

0

0

0

0

0

1

0

0,07

0

0,01

0

0

0

0

0

1

0,02

0

0,09

0

0

0

0

0

0

0,49

0,07

0,07

0,01

0

0

0

0

0

0

0

0

0

0

0,14 0,14

0,63 0,02

0,02 0,63

0,09 0,09

0

0

0

0

0

0,04

0,18

0,18

0,81

100

UNIVERSIDAD NACIONAL ABIERTA Y A DISTANCIA – UNAD

Escuela de Ciencias Básicas, tecnologías e ingeniería

Contenido didáctico del curso Teoría de decisiones

Donde:

•I

Matriz identidad (tantas columnas y filas como estados finales).

•O

Matriz nula (tantas columnas como transitorias y tantas filas como estados

finales).

•R

Probabilidades de absorción de un solo salto.

•Q

Probabilidades entre transitorios (tantas filas y columnas como estados

transitorios.

• 1, 2, 3, 4, 5 son estados finales.

• 6, 7, 8, 9 son estados transitorios.

Presenta cinco clases finales, luego, no existe una distribución límite de los

estados en este estudio dinámico, luego no podemos determinar la calidad media

del servicio como en el caso anterior. La calidad media del servicio será

independiente del nivel de cobertura inicial de ambos interlocutores.

Ahora calcularemos cuánto tarda en término medio en perderse una llamada que

se realiza andando por la calle y que se inició con ambos terminales a máxima

cobertura.

mi

Tiempo medio hasta que se corta la conversación si el estado inicial es i

I–Q.

0,51 - 0,14

- 0,07 - 0,37

- 0,07 - 0,02

- 0,01 - 0,09

M6

m7

m8

m9

1

1

1

1

- 0,14 - 0,04

- 0,02 - 0,18

- 0,37 - 0,18

- 0,09 0,19

m6

1

m7

1

m8 = 1

m9

1

m6

12,69

m7 = 16,47

m8

16,47

m9

21,53

Luego el ayuntamiento no tendría razón en sus afirmaciones, el tiempo que tarda

en cortarse una llamada es:

21,53 minutos si el nivel inicial de cobertura de ambos interlocutores es 2

16,47 minutos si el nivel inicial de cobertura de un interlocutor es 1 y el otro es 2.

12,69 minutos si el nivel inicial de cobertura de ambos interlocutores.

101

UNIVERSIDAD NACIONAL ABIERTA Y A DISTANCIA – UNAD

Escuela de Ciencias Básicas, tecnologías e ingeniería

Contenido didáctico del curso Teoría de decisiones

TALLER:

1. Las 20 chicas y los 10 chicos de un curso de COU organizan un viaje, para el

cual necesitan dinero. Deciden pedir trabajo por las tardes en una compañía

encuestadora que contrata a equipos jóvenes de dos tipos:

TIPO A: Parejas: una chica y un chico

TIPO B: Equipos de cuatro, formados por tres chicas y un chico

Se paga a 30000 pesos. La tarde a la pareja y a 50000 pesos. La tarde al equipo

de 4.

¿Cómo les conviene distribuirse para sacar la mayor cantidad posible de dinero?

2. Una fábrica de tableros de madera, pintados, produce dos tipos de tableros:

Normales: Llevan una mano de imprimación y otra de pintura.

Extras: Llevan una mano de imprimación y tres manos de pintura.

Disponen de imprimación para 10000 m2, pintura para 20000 m2 y tableros sin

pintar en cantidad ilimitada.

Sus ganancias netas son: 3500 pesos. Por el m2 de tablero normal y 5000 pesos.

Por m2 de tablero extra.

¿Qué cantidad de tablero de cada tipo les conviene fabricar para que las

ganancias sean máximas?

3. María distribuye su tiempo de ocio entre discoteca y cine. Cada vez que va a la

discoteca gasta por término medio 30.000 pesos, mientras que si va al cine su

gasto es de 5000 pesos. En cierto mes su presupuesto para ocio asciende a

220.000 Pesos. Y desea ir a la discoteca al menos tantas veces como al cine.

102