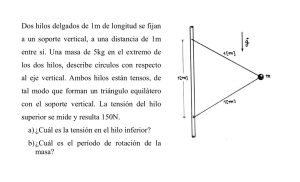

Módulo 2

Anuncio