Ubicación de Actividades - Universidad Veracruzana

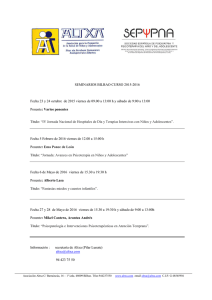

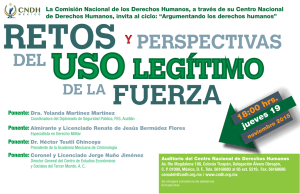

Anuncio