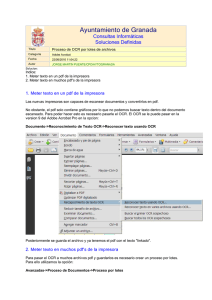

desarrollo de un analizador de imágenes basado en el

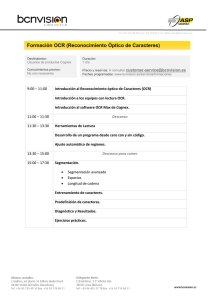

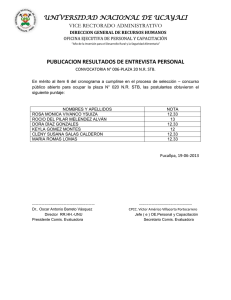

Anuncio