UNIVERSIDAD AUTONOMA METROPOLITANA

Anuncio

UNIVERSIDAD AUTONOMA METROPOLITANA

UNIDAD IZTAPALAPA

División de Ciencias Básicas e Ingeniería

Departamento de Ingeniería Eléctrica

Licenciatura en Computación

“Alternativa Para la solución del problema de clasificación por medio de un Programa Evolutivo”

Trimestre 03-I

Alumno: Fernández trejo Oscar

Mat: 96320368

Asesor

---------------------------------------------Dra Graciela Roman Alonso

Prof. Titular tiempo completo

Núm. Emp. 17161

Lugar de realización: Laboratorio T-169 de la propia unidad

Periodo de Realización: 18/09/2002-10/04/2003

Asesor

----------------------------------------------MC. Alma Martinez Licona

Prof. Titular tiempo completo

Núm. Emp. 20901

Indice

Objetivos…………………………………………………………………………………………………….. 2

Introducción…................................................................................................................................................. 2

Conceptos y mecanismos de base…………………………………………………………………………… 4

Redes Neuronales artificiales…………………………………………………………….. ………..4

Redes Neuronales de tipo biológico……………………………………………………… 5

Funciones de base y activación…………………………………………………. 5

Redes Neuronales para aplicaciones concretas…………………………………………... 6

Estructura de las redes neuronales……………………………………………………….. 7

Tamaño de las redes neuronales………………………………………………… 7

Aproximaciones ACON frente a OCON……………………………………….. 7

Asociación y Clasificación……………………………………………………………….. 9

Optimización………………………………………………………………………..……. 10

Red Neuronal Backpropagation…………………………………………………..……… 10

Algoritmos Genéticos……………………………………………………………………………… 11

Extensiones y modificaciones del Algoritmos Genético Simple………………………… 12

Función Objetivo………………………………………………………………………… 12

Algoritmos Evolutivos…………………………………………………………………… 13

Estructura de datos que representa a un perceptron multicapa……………………………14

La Población……………………………………………………………………………… 14

Función de Evaluación…………………………………………………………………… 14

Algoritmos Genéticos Paralelos…………………………………………………………………… 16

PVM……………………………………………………………………………………………….. 17

Metodología………………………………………………………………………………………………… 18

Esquemas de Apoyo………………………………………………………………………………. 18

Bases de Datos…………………………………………………………………………………….. 18

Acerca de PVM……………………………………………………………………………………. 19

Definición de variables…………………………………………………………………………….. 20

Versión Central…………………………………………………………………………………….. 22

Mejoramiento de Algoritmo Evolutivo………………………………………………………………………23

Criterios de Reemplazo………………………………………………………………………………………24

Conclusiones………………………………………………………………………………………………… 24

Bibliografía………………………………………………………………………………………………….. 26

Anexo A (Bases de Datos)…………………………………………………………………………………...28

Anexo B (Codigo Fuente)……………………………………………………………………………………47

2

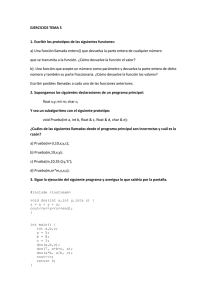

OBJETIVO

Encontrar la alternativa para la solución del problema de clasificación mediante un programa

evolutivo, basándonos en la arquitectura de una red neuronal para problemas de clasificación usando envio de

mensajes como medio de comunicación entre los procesos.

INTRODUCCIÓN

El problema de clasificación agrupa conjuntos de objetos de acuerdo a sus características, si dichas

características son comunes el conjunto de objetos forman una clase. Un ejemplo claro de esto es el

diagnostico medico, en donde el objeto a analizar seria cada una de las enfermedades (clases) y sus atributos

son las características que las definen como los rangos de temperatura, los rangos de presión, niveles de

azúcar, etc. Este problema se encuentra en diferentes áreas (botánica, reconocimiento automático del habla,

etc.) con grandes volúmenes de datos a manejar, lo cual hace imposible su clasificación de forma manual, es

por eso que se han diseñado métodos y herramientas para apoyar el proceso de clasificación buscando que

este se haga de forma automática.

Una alternativa para la solución a este problema es el uso de redes neuronales (perceptron), sin embargo

la definición de la red neuronal es otro problema. Solucionando este aspecto se soluciona el problema de

clasificación. Existen varias alternativas para la definición de una red neuronal perceptron, una de ellas es por

medio de la programación evolutiva, la idea del programa evolutivo es definir una población de cromosomas

en donde cada cromosoma represente una red neuronal perceptron.

El objetivo principal de este proyecto es la paralelización de un programa evolutivo que define la

arquitectura de una red neuronal para problemas de clasificación. Actualmente se cuenta con una versión

funcional del algoritmo en Lenguaje C++ que se ha probado con bases de datos relativamente pequeñas para

las cuales el tiempo de ejecución es razonablemente corto. La naturaleza secuencial (ejecución en un solo

procesador) del algoritmo, impone ciertas limitaciones en cuanto al tamaño de las bases de datos a tratar, el

número de nodos ocultos, el tamaño de la población y el número de generaciones del algoritmo evolutivo.

Una de las posibilidades para solventar estas limitaciones es la utilización del paralelismo, es decir, la

construcción de un programa que explote una arquitectura paralela para resolver el mismo problema en un

menor tiempo.

En este reporte se inicia con un acercamiento teórico a las redes neuronales, algoritmos genéticos y a los

algoritmos genéticos paralelos.

Después se procede a describir la metodología utilizada para implementar los distintos esquemas de

algoritmos evolutivos paralelos propuestos. Se finaliza presentando los resultados obtenidos al ejecutar las

tres versiones existentes con sus distintos esquemas comparándolos con el algoritmo centralizado y la

versión mejorada. De igual manera se presentan los objetivos, metas alcanzadas, y conclusiones.

La red neuronal que se trabajó en paralelo es una red utilizada para la clasificación de

patrones. Los patrones son presentados en una base de datos donde cada patrón tiene un número determinado

de propiedades y una de ellas (pueden ser varios valores) indica(n) a que grupo de patrones pertenece. Lo red

neuronal recibe una base de datos de este tipo dividido en dos partes, primero un 70% del total para (base de

datos de entrenamiento) y después una base mas pequeña con patrones del mismo tipo (el 30% restante) para

ver que tan bien es capaz de seleccionar correctamente o que grupo pertenece cada patrón (base de datos de

prueba).

En un principio se utilizaron como base tres versiones utilizando la consola de PVM cada una

de los cuales se explicara brevemente mas adelante. PVM es un paquete de software para crear aplicaciones

en paralelo y se baso en el modelo de paso de mensajes. Los programas de aplicación son escritos en C y para

tener acceso a PVM se hacen llamadas a rutinas de la biblioteca "pvm3.h" lo cual contiene funciones para

lanzamiento, transmisión y recepción de mensajes, y algo muy importante, la sincronización. En la consola

de PVM un usuario define una colección de computadoras con un solo procesador para simular una gran

memoria distribuida; proporciona las funciones para iniciar tareas en una máquina virtual y permite a éstos

sincronizarse y comunicarse.

El sistema PVM está compuesto por dos partes, la primera parte del sistema la conforma un

demonio (procesos que siempre están ejecutándose) llamado pvmd3. La segunda parte del paquete PVM son

las librerías de rutina de interfaz y son alrededor de 20 rutinas de interfaz.

3

CONCEPTOS Y MECANISMOS DE BASE REDES NEURONALES ARTIFICIALES

Las Redes Neuronales Artificiales (ANN's de Artificial Neural Networks) fueron originalmente una

simulación abstracta de los sistemas nerviosos biológicos, formados por un conjunto de unidades llamadas

"neuronas" o "nodos" conectadas unas con otras. Estas conexiones tienen una gran semejanza con las

dendritas y los axones en los sistemas nerviosos biológicos.

El primer modelo de red neuronal fue propuesto en 1943 por McCulloch y Pitts en términos de un

modelo computacional de "actividad nerviosa". El modelo de McCulloch-Pitts es un modelo binario, y cada

neurona tiene un escalón o umbral prefijado. Este primer modelo sirvió de ejemplo para los modelos

posteriores de Jhon Von Neumann. Marvin Minsky, Frank Rosenblatt, y muchos otros. Una primera

clasificación de los modelos de ANN's podría ser:

1. Los modelos de tipo biológico. Este comprende las redes que tratan de simular los sistemas neuronales

biológicos así como las funciones auditivas o algunas funciones básicas de la visión.

2. EI modelo dirigido a aplicación. Estos modelos no tienen porque guardar similitud con los sistemas

biológicos. Sus arquitecturas están fuertemente ligadas a las necesidades de las aplicaciones para las que son

diseñados.

Redes Neuronales de tipo Biológico

Se estima que el cerebro humano contiene más de cien mil millones de neuronas y sinapsis en el sistema

nervioso humano. Estudios sobre la anatomía del cerebro humano concluyen que hay más de 1000 sinapsis a

la entrada y a la salida de cada neurona. Es importante notar que aunque el tiempo de conmutación de la

neurona (unos pocos milisegundos) es casi un millón de veces menor que en los actuales elementos de las

computadoras, ellas tienen una conectividad miles de veces superior que las actuales supercomputadoras.

El objetivo principal de las redes neuronales de tipo biológico es desarrollar un elemento sintético para

verificar las hipótesis que conciernen a los sistemas biológicos.

Las neuronas y las conexiones entre ellas (sinapsis) constituyen la clave para el procesado de la

información. Observe la figura:

Red neuronal de tipo biológico.

La mayor parte de las neuronas poseen una estructura de árbol llamadas dendritas que reciben las señales

de entrada que vienen de otras neuronas a través de las uniones llamadas sinapsis. Algunas neuronas se

comunican solo con las cercanas, mientras que otras se conectan con miles.

Hay tres partes en una neurona:

1 .el cuerpo de la neurona,

2. ramas de extensión llamadas dendritas para recibir las entradas

3. un axón que lleva la salida de la neurona a las dendritas de otras neuronas.

La forma que dos neuronas interactúan no está totalmente conocida, dependiendo además de cada

neurona. En general, una neurona envía su salida a otras por su axón. El axón lleva la información por medio

4

de diferencias de potencial, u ondas de corriente, que depende del potencial de la neurona. Este proceso es a

menudo modelado como una regla de propagación representada por la función de red u(.).La neurona recoge

las señales por su sinapsis sumando todas las influencias excitadoras e inhibidoras. Si las influencias

excitadoras positivas dominan, entonces la neurona da una señal positiva y manda este mensaje a otras

neuronas por sus sinapsis de salida. En este sentido la neurona puede ser modelada como una simple función

escalón f(.). Como se muestra en la próxima figura, la neurona se activa si la fuerza combinada de la señal de

entrada es superior a un cierto nivel, en el caso general el valor de activación de la neurona viene dado por

una función de activación f(.).

Funciones de Base y Activación

Una red neuronal típica se puede caracterizar por las descripciones funcionales de la red de

conexión y la red de activación. Cada célula (unidad de proceso), suministra un valor a1 a su salida. Este

valor se propaga a través de la red de conexiones unidireccionales hacia otras células de la red.

Asociada a cada conexión hay un peso sináptico Wij, que determina el efecto de la célula j-ésima

sobre la célula i-ésima. Las entradas a la célula i-ésima que provienen de las otras células son acumuladas

junto con el umbral extemo Фi, para dar el valor de red Ui. La forma de hacerlo lo determina

matemáticamente la función de base f para dar un valor de activación a¡. La salida final y se puede expresar

como una función de la entrada y los pesos y=Ф (x,W).

Función de Base (Función de Red)

Para un estudio analítico, las redes de conexión son matemáticamente representadas por la función de base u

(w, x), donde w es la matriz de pesos, y x el vector de entrada. La función de base tiene dos formas típicas:

- Función Lineal de Base (LBF) es una función de tipo hiperplano. Esto es, una función de primer orden. El

valor de red es una combinación lineal de las entradas,

- Función de base Radial (RBF) es una función de tipo hiperesférico. Esto implica una función de base de

segundo orden no lineal. El valor de red representa la distancia a un determinado patrón de referencia,

La función de segundo orden se puede extender a otra más general llamada función de base elíptica.

Función de Activación (Función de neurona)

El valor de red, expresado por la función de base, u(w,x), será inmediatamente transformada por una función

de activación no lineal. Por ejemplo, las funciones de activación más comunes son la función paso, rampa o

sigmoidal y gausiana. En particular,

• Función sigmoidal

• Función gausiana

5

Redes Neuronales para aplicaciones concretas

Las ANN's dirigidas a aplicación están en general poco ligadas a las redes neuronales

biológicas. Ya que el conocimiento que se posee sobre el sistema nervioso en general no es completo, se han

de definir otras funcionalidades y estructuras de conexión distintas a las vistas desde la perspectiva biológica.

Las características principales de este tipo de ANN's son los siguientes:

1 .Auto-Organización y Adaptatividad: Utilizan algoritmos de aprendizaje adaptativo y auto organización, por lo que ofrecen posibilidades de procesado robusto y adaptativo (véase entrenamiento

adaptativo y redes auto - organizativas).

2. Procesado No Lineal: aumenta la capacidad de la red de aproximar, clasificar y su inmunidad

frente al ruido.

3. Procesado paralelo: normalmente se usa un gran número de células de procesado por el alto nivel

de ínter conectividad.

Estas características juegan un importante papel en las ANN's aplicadas al procesado de señal e imagen.

Una red para una determinada aplicación presenta una arquitectura muy concreta, que comprende elementos

de procesado adaptativo masivo paralelo combinadas con estructuras de interconexión de red jerárquica.

Taxonomía de las Redes Neuronales

Existen dos fases en toda aplicación de las redes neuronales: la fase de aprendizaje o entrenamiento y la

fase de prueba. En la fase de entrenamiento, se usa un conjunto de datos o patrones de entrenamiento para

determinar los pesos (parámetros de diseño) que definen el modelo neurona!. Una vez entrenado este modelo,

se usará en la llamada fase de prueba o funcionamiento directo, en la que se procesan los patrones de prueba

que constituyen la entrada habitual de la red, analizándose de esta manera las prestaciones definitivas de la

red.

• Fase de Prueba: los parámetros de diseño de la red neuronal se han obtenido a partir de unos patrones

representativos de las entradas que se denominan patrones de entrenamiento. Los resultados pueden ser tanto

calculados de una vez como adaptada iterativa mente, según el tipo de red neuronal, y en función de las

ecuaciones dinámicas de prueba. Una vez calculados los pesos de la red, los valores de las neuronas de la

última capa, se comparan con la salida deseada para determinar la validez del diseño.

• Fase de Aprendizaje: una característica de las redes neuronales es su capacidad de aprender. Aprenden por la

actualización o cambio de los pesos sinápticos que caracterizan a las conexiones. Los pesos son adaptados de

acuerdo a la información extraída de los patrones de entrenamiento nuevos que se van presentando.

Normalmente, los pesos óptimos se obtienen optimizando (minimizando o maximizando) alguna "función de

energía". Por ejemplo, un criterio popular en el entrenamiento supervisado es minimizar el least-square-error

(error cuadrático medio) entre el valor del maestro y el valor de salida actual.

Las aplicaciones del mundo real deben acometer dos tipos diferentes de requisitos en el procesado. En

un caso, se requiere la prueba en tiempo real pero el entrenamiento ha de realizarse "fuera de línea". En otras

ocasiones, se requieren los dos procesos, el de prueba y el de entrenamiento en tiempo real. Estos dos

requisitos implican velocidades de proceso muy diferentes, que afectan a los algoritmos y hardware usados.

Atendiendo al tipo de entrenamiento, una posible taxonomía de las redes neuronales es:

Fijo

Redes Neuronales

No supervisado

Red de Hamming

Mapa de características

Red de Hopfield

Aprendizaje competitivo

Supervisado

Basadas en decisión

Perceptrón

ADALINE (LMS)

Perceptrón Multicapa

Modelos Temporales Dinámicos

Modelos Ocultos de Markov

6

Estructuras de las Redes Neuronales Artificiales

Los aspectos más característicos de las estructuras son la estructura de conexión, el tamaño de la red y la

elección entre ACÓN (AII-Class-in-On-Metwork) y OCON (One-Class-in-One-Network).

Una red neuronal se determina por la neurona y la matriz de pesos. El comportamiento de la red

depende en gran medida del comportamiento de la matriz de pesos. Hay tres tipos de capas de neuronas: la de

entrada, las ocultas y la de salida. Entre dos capas de neuronas existe una red de pesos de conexión, que puede

ser de los siguientes tipos: Hacia delante, hada atrás, lateral y de retardo, tal como puede verse en la siguiente

figura:

1 .Conexiones hacia delante: para todos los modelos neuronales, los datos de las neuronas de una capa

inferior son propagados hacia las neuronas de la capa superior por medio de las redes de conexiones hacia

adelante. 2. Conexiones hacia atrás: estas conexiones llevan los datos de las neuronas de una capa superior a

otras de la capa inferior. S.Conexiones laterales. Un ejemplo típico de este tipo es el circuito "el ganador toma

todo" (winner-takes-all), que cumple un papel importante en la elección del ganador. 4. Conexiones con

retardo: los elementos de retardo se incorporan en las conexiones para implementar modelos dinámicos y

temporales, es decir, modelos que precisan de memoria. Las conexiones sinápticas pueden ser total o

parcialmente interconectadas, como muestra la figura. También es posible que las redes sean de una capa con

el modelo de pesos hacia atrás o bien el modelo multicapa hacia adelante. Es posible así mismo, el conectar

varias redes de una sola capa para dar lugar a redes más grandes.

Tamaño de las Redes Neuronales

•En una red multicapa de propagación hacia delante, puede haber una o más capas ocultas entre las capas de

entrada y salida. El tamaño de las redes depende del número de capas y del número de neuronas ocultas por

capa.

- Número de capas: en una red multicapa, hay una o más capas de neuronas ocultas entre la entrada y la

salida. El número de capas se cuenta a menudo a partir del número de capas de pesos (en vez de las capas de

neuronas).

- Número de unidades ocultas: El número de unidades ocultas está directamente relacionado con las

capacidades de la red. Para que el comportamiento de la red sea correcto (esto es, generalización), se tiene que

determinar apropiadamente el número de neuronas de la capa oculta.

Aproximaciones ACÓN frente a OCON

Abordamos el problema de cuantas redes son necesarias para la clasificación en multicategorías.

Típicamente, cada nodo de salida se usa para representar una clase. Por ejemplo, en un problema de

reconocimiento alfanumérico, hay 36 clases; así que en total habrá 36 nodos de salida. Dado un patrón de

entrada en la fase de prueba, el ganador (i.e., la clase que gana) es normalmente el nodo que tiene el valor más

alto a la salida.

7

Dos posibles tipos de arquitectura son "AII-Class-in-One-Network" (ACÓN), esto es, todas las clases en

una red y "One-Class-in-One-Network" (OCON), esto es, una red para cada clase. En la aproximación

ACÓN, todas las clases son reconocidas dentro de una única super red. En algunos casos es ventajoso

descomponer esta macro red en varias subredes más pequeñas. Por ejemplo, una red de 36 salidas se puede

descomponer en 12 subredes, cada una responsable de tres salidas. La descomposición mas extrema es la

llamada OCON, donde una subred se dedica para una sola clase. Aunque el número de subredes en la

estructura OCON es relativamente largo, cada subred individual tiene un tamaño menor que la red ACÓN.

Esto se puede explicar con las siguientes figuras

La red entera se divide en varias subredes.

Por conveniencia, supongamos que todas las redes tienen el mismo tamaño, por ejemplo k. El número de

unidades ocultas de las macro - red ACÓN se denota por K. Obviamente, k << K. Las dos estructuras difieren

claramente en tamaño y rapidez, esto es, en el número total de pesos sinápticos y en el tiempo de

entrenamiento. Sean los vectores de entrada y salida de dimensiones n y N respectivamente. El número total

de pesos sinápticos es para la estructura ACÓN (N+n) * K. De la misma forma, el número para la estructura

OCON es N * (n+1) * k aproximadamente N*n * k. Los dos casos extremos son analizados a continuación.

Cuando N es relativamente pequeña (comparado con n), la estructura ACÓN podría tener el mismo número

de pesos o algo menos que la OCON. Si N es muy grande, entonces la OCON podría tener una mayor ventaja

en términos del tamaño de la red. Además, la OCON parece ser que aventaja a la ACÓN en la rapidez de

reconocimiento y entrenamiento cuando el número de clases es grande.

En la estructura ACÓN, la única macro - red tiene que "satisfacer" todas estas clases, así que el número

de unidades ocultas K ha de ser muy grande. Aplicaciones

Con el fín de llegar al entendimiento global de ANN's, adoptamos la siguiente perspectiva llamada topdown que empieza por la aplicación se pasa al algoritmo y de aquí a la arquitectura:

Esta aproximación a las ANN's está motivada por la aplicación, basada en la teoría y orientada hada la

implementación. Las principales aplicaciones son para el procesado de señal y el reconocimiento de patrones.

La primera etapa algorítmica representa una combinación de la teoría matemática y la fundamentación

heurística por los modelos neuronales. El fin último es la construcción de neurocomputadores digitales, con la

ayuda de las tecnologías VLSI y el procesado adaptativo, digital y paralelo.

8

Desde el punto de vista de las aplicaciones, la ventaja de la ANN's reside en el procesado paralelo,

adaptativo y no lineal. Las ANN's han encontrado muchas aplicaciones con éxito en la visión artificial, en el

procesado de señales e imágenes, reconocimiento del habla y de caracteres, sistemas expertos, análisis de

imágenes médicas, control remoto, control de robots, inspección industrial y exploración científica. El

dominio de aplicación de las ANN's se puede clasificar de la siguiente forma: asociación y clasificación,

regeneración de patrones, regresión y generalización, y optimización.

Asociación y Clasificación

En esta aplicación, los patrones de entrada estáticos o señales temporales deben ser clasificados o

reconocidas. Idealmente, un clasificador debería ser entrenado para que cuando se le presente una versión

distorsionada ligeramente del patrón, pueda ser reconocida correctamente sin problemas. De la misma forma,

la red debería presentar cierta inmunidad contra el ruido, esto es, debería ser capaz de recuperar una señal

"limpia" de ambientes o canales ruidosos. Esto es fundamental en las aplicaciones holográficas. Asociativas o

regenerativas.

•Asociación: de especial interés son las dos clases de asociación: autoasociación y heteroasociación. El

problema de la autoasociación es recuperar un patrón enteramente, dada una información parcial del patrón

deseado. La heteroasociación es recuperar un conjunto de patrones B, dado un patrón de ese conjunto. Los

pesos en las redes asociativas son a menudo predeterminados basados en la regla de Hebb. Normalmente, la

autocorrelación del conjunto de patrones almacenado determina los pesos en las redes autoasociativas. Por

otro lado. La correlación cruzada de muchas parejas de patrones se usa para determinar los pesos de la red de

heteroasociación.

•Clasificación no Supervisada: para esta aplicación, los pesos sinápticos de la red son entrenados por la regla

de aprendizaje no supervisado, esto es, la red adapta los pesos y verifica el resultado basándose únicamente en

los patrones de entrada.

•Clasificación Supervisada: esta clasificación adopta algunas formas del criterio de interpolación o

aproximación. En muchas aplicaciones de clasificación, por ejemplo, reconocimiento de voz, los datos de

entrenamiento consisten de pares de patrones de entrada y salida. En este caso, es conveniente adoptar las

redes Supervisadas, como las bien conocidas y estudiadas redes de retropropagación. Este tipo de redes son

apropiadas para las aplicaciones que tienen una gran cantidad de clases con límites de separación complejos.

Completar los patrones

En muchos problemas de clasificación, una cuestión a solucionar es la recuperación de la

información, esto es, recuperar el patrón original dada sola una información parcial. Hay dos clases de

problemas: temporales y estáticos. El uso apropiado de la información contextual es la llave para tener éxito

en el reconocimiento.

Generalización

Se puede extender a un problema de interpolación. El sistema es entrenado por un gran conjunto

de muestras de entrenamiento basados en un procedimiento de aprendizaje supervisado. Una red se considera

que esta entrenada con éxito si puede aproximar los valores de los patrones de entrenamiento y puede dar

interpolaciones "suaves" para el espado de datos no entrenado. El objetivo de la

Generalización es dar una respuesta correcta a la salida para un estímulo de entrada que no ha sido

entrenado con anterioridad. El sistema debe inducir la característica saliente del estímulo a la entrada y

detectar la regularidad. Tal habilidad para el descubrimiento de esa regularidad es crítica en muchas

aplicaciones. Esto hace que el sistema funcione eficazmente en todo el espacio, incluso ha sido entrenado por

un conjunto limitado de ejemplos. Observe la siguiente figura:

9

Optimización

Las ANN's son unas herramientas interesantes para la optimización de aplicaciones, que

normalmente implican la búsqueda del mínimo absoluto de una función de energía:

Una vez que se define la función de energía, entonces la determinación de los pesos sinápticos se

hace rápidamente. Para algunas aplicaciones, la función de energía es fácilmente deducible. En otras, sin

embargo, esta función de energía se obtiene de ciertos criterios de coste y limitaciones especiales. El mayor

problema asociado al problema de optimización es la alta posibilidad de converger hada un mínimo local, en

vez de hacia el mínimo absoluto. Para combatir este problema se utilizan algunas propuestas estadísticas,

como por ejemplo procedimientos estocásticos.

Red Neuronal BackPropagation

En 1986. Rumerhart, Hinton y Williams [Rumerhait 82], basándose en los trabajos de otros

investigadores [Werbos 74] [Parker 82] formalizaron un método para que una red neuronal aprendiera la

asociación que existe entre los patrones de entrada a la misma y las clases correspondientes, utilizando mas

niveles de neuronas que los que utilizo Rosenblatt para desarrollar el Perceptron.

El algoritmo de propagación hacia atrás, o retropropagación, es una regla de aprendizaje que se

puede aplicar en modelos de redes con mas de dos capas de células.

El funcionamiento de una red backpropagation (backpropagation net, BPN) consiste en un

aprendizaje de un conjunto predefinido de pares entradas-salidas dados como ejemplo, empleando un ciclo

propagación-adaptación de dos fases: primero se aplica un patrón de entrada como estimulo para la primera

capa de las neuronas de la red, se va propagando a través de todas las capas superiores hasta generar una

salida, se compara el resultado obtenido en las neuronas de salida con la salida que se desea obtener y se

calcula un valor de error para cada neurona de salida. A continuación, estos errores se transmiten hacia atrás,

partiendo de la capa de salida, hacia todas las neuronas de la capa intermedia que contribuyan directamente a

la salida, recibiendo el porcentaje de error aproximado a la participación de la neurona intermedia en la salida

original. Este proceso se repite, capa por capa, hasta que todas las neuronas de la red hayan recibido un error

que describa su aportación relativa al error total. Basándose en el valor del error recibido, se reajustan los

pesos de conexión de cada neurona, de manera que en la siguiente vez que se presente el mismo patrón, la

salida este mas cercana a la deseada; es decir, el error disminuya.

La importancia de la red backpropagation consiste en su capacidad de autoadaptar los pesos de

las neuronas de las capas intermedias para aprender la relación que existe entre un conjunto de patrones dados

como ejemplo y sus salidas correspondientes. Para poder aplicar esa misma relación, después del

10

entrenamiento, a nuevos vectores de entrada con ruido o incompletas, dando una salida activa si la nueva

entrada es parecida a las presentadas durante el aprendizaje. Esta característica importante que se exige a los

sistemas de aprendizaje, es la capacidad de generalización, entendida como la facilidad de dar salidas

satisfactorias a entradas que el sistema no ha visto nunca en su fase de

entrenamiento.

La técnica backpropagation requiere el uso de neuronas cuya función de activación sea continua,

y, por tanto, diferenciable. Generalmente, la función utilizada será del tipo sigmoidal.

ALGORITMOS GENÉTICOS

Los Algoritmos Genéticos (AG's) son métodos adaptativos que pueden usarse para resolver

problemas de búsqueda y optimización. Están basados en el proceso genético de los organismos vivos.

A lo largo de las generaciones, las poblaciones evolucionan en la naturaleza de acuerdo con los principios

de la selección natural y la supervivencia de los más fuertes, postulados por Darwin [9]. Por imitación de este

proceso, los Algoritmos Genéticos son capaces de ir creando soluciones para problemas del mundo real. La

evolución de dichas soluciones hacia valores óptimos del problema depende en buena medida de una

adecuada codificación de las mismas.

Los principios básicos de los Algoritmos Genéticos fueron establecidos por Holland [22], y se

encuentran bien descritos en varios textos - Goldberg [19], Davis [11], Michalewicz [29], Reeves [32] --.

En la naturaleza los individuos de una población compiten entre sí en la búsqueda de recursos tales

como comida, agua y refugio. Incluso los miembros de una misma especie compiten a menudo en la búsqueda

de un compañero. Aquellos individuos que tienen más éxito en sobrevivir y en atraer compañeros tienen

mayor probabilidad de generar un gran número de descendientes. Por el contrario individuos poco dotados

producirán un menor número de descendientes. Esto significa que los genes de los individuos mejor

adaptados se propagarán en sucesivas generaciones hacia un número de individuos creciente. La combinación

de buenas características provenientes de diferentes ancestros, puede a

veces producir descendientes "súper

individuos", cuya adaptación es mucho mayor que la de cualquiera de sus ancestros. De esta manera, las

especies evolucionan logrando unas características cada vez mejor adaptadas al entorno en el que viven.

Los Algoritmos Genéticos usan una analogía directa con el comportamiento natural. Trabajan con una

población de individuos, cada uno de los cuales representa una solución factible a un problema dado. A cada

individuo se le asigna un valor ó puntuación, relacionado con la bondad de dicha solución.

En la naturaleza esto equivaldría al grado de efectividad de un organismo para competir por unos

determinados recursos. Cuanto mayor sea la adaptación de un individuo al problema, mayor será la

probabilidad de que el mismo sea seleccionado para reproducirse, cruzando su material genético con otro

individuo seleccionado de igual forma. Este cruce producirá nuevos individuos - descendientes de los

anteriores - los cuales comparten algunas de las características de sus padres. Cuanto menor sea la adaptación

de un individuo, menor será la probabilidad de que dicho individuo sea seleccionado para la

reproducción,

y por tanto de que su material genético se propague en sucesivas generaciones.

De esta manera se produce una nueva población de posibles soluciones, la cual reemplaza a la

anterior y verifica la interesante propiedad de que contiene una mayor proporción de buenas características en

comparación con la población anterior. Así a lo largo de las generaciones las buenas características se

propagan a través de la población. Favoreciendo el cruce de los individuos mejor adaptados, van siendo

exploradas las áreas más prometedoras del espacio de búsqueda. Si el Algoritmo Genético ha sido bien

diseñado, la, población convergerá hacia una solución óptima del problema.

El poder de los Algoritmos Genéticos proviene del hecho de que se trata de una técnica robusta, y

pueden tratar con éxito una gran variedad de problemas provenientes de diferentes áreas, incluyendo aquellos

en los que otros métodos encuentran dificultades. Si bien no se garantiza que el Algoritmo Genético encuentre

la solución óptima, del problema, existe evidencia empírica de que se encuentran soluciones de un nivel

aceptable, en un tiempo competitivo con el resto de algoritmos de optimización combinatoria. En el caso de

que existan técnicas especializadas para resolver un determinado problema, lo más probable es que superen al

Algoritmo Genético, tanto en rapidez como en eficacia. El gran campo

de aplicación de los Algoritmos

Genéticos se relaciona con aquellos problemas para los cuales no existen técnicas especializadas. Incluso en

el caso en que dichas técnicas existan, y funcionen bien, pueden efectuarse mejoras de las mismas

hibridándolas con los Algoritmos Genéticos.

11

Extensiones y Modificaciones del Algoritmo Genético Simple

En este apartado se introducirán algunas extensiones y modificaciones del Algoritmo Genético

Simple Se comenzará dando un pseudocódigo para un Algoritmo Genético Abstracto AGA), para a

continuación introducir algunas variantes que se han ido proponiendo en trabajos desarrollados en estos

últimos años.

BEGIN AGA

Obtener la población inicial al azar

WHILE NOT stop Do

BEGIN

Seleccionar padres de la población

Producir hijos a partir de los padres seleccionados

Mutar los individuos hijos

Extender la población añadiendo los hijos

Reducir la población extendida

END

END AGA

Población

Tamaño de la población

Una cuestión que uno puede plantearse es la relacionada con el tamaño idóneo de la población.

Parece intuitivo que las poblaciones pequeñas corren el riesgo de no cubrir adecuadamente el espacio de

busqueda mientras que el trabajar con poblaciones de gran tamaño puede acarrear problemas relacionados con

el excesivo costo computacional. Goldberq [19] efectuó un estudio teórico, obteniendo como conclusión que

el tamaño óptimo de la población para cadenas de longitud I, con codificación binaria, crece

exponencialmente con el tamaño de la cadena. Este resultado traería como consecuencia que la aplicabilidad

de los Algoritmos Genéticos en problemas reales sería muy limitada, ya que resultarían no competitivos con

otros métodos de optimización combinatoria. Alander [4], basándose en evidencia empírica sugiere que un

tamaño de población comprendida entre 1 y 21 es suficiente para atacar con éxito los problemas por el

considerados.

Población inicial

Habitualmente la población inicial se escoge generando cadenas al azar, pudiendo contener

cada quie uno de los posibles valores del alfabeto con probabilidad uniforme. Nos podríamos preguntar que es

lo que sucedería si los individuos de la población inicial se obtuviesen como resultado de alguna técnica

heurística o de optimización local. En los pocos trabajos que existen sobre este aspecto, se constata que esta

inicialización no aleatoria de la población inicial, puede acelerar la convergencia del Algoritmo Genético. Sin

embargo en algunos casos la desventaja resulta ser la prematura convergencia del algoritmo, queriendo

indicar con esto la convergencia hacia óptimos locales.

Función objetivo

Dos aspectos que resultan cruciales en el comportamiento de los Algoritmos Genéticos son la

determinación de una adecuada función de adaptación o función objetivo, así como la codificación utilizada.

Idealmente nos interesaría construir funciones objetivo con "ciertas regularidades", es decir a funciones

objetivo que verifiquen que para dos individuos que se encuentren cercanos en el espacio de búsqueda, sus

respectivos valores en las funciones objetivo sean similares. Por otra parte una dificultad en el

comportamiento del Algoritmo Genético puede ser la existencia de gran cantidad de óptimos locales, así

como el hecho de que el óptimo global se encuentre muy aislado.

La regla general para construir una buena función objetivo es que ésta debe reflejar el valor del

individuo de una manera "real", pero en muchos problemas de optimización combinatoria, donde existe una

12

gran cantidad de restricciones, buena parte de los puntos del espacio de búsqueda representan individuos no

válidos.

Para este planteamiento en el que los individuos están sometidos a restricciones, se han

propuesto varias soluciones. La primera sería la que podríamos denominar absolutista, en la que aquellos

individuos que no verifican las restricciones, no son considerados como tales, y se siguen efectuando cruces y

mutaciones-hasta obtener individuos válidos, o bien, a dichos individuos se les asigna una función objetivo

igual a cero. Otra posibilidad consiste en reconstruir aquellos individuos que no verifican las restricciones.

Dicha reconstrucción suele llevarse a cabo por medio de un nuevo operador que se acostumbra a

denominar reparador.

Otro enfoque está basado en la penalización de la función objetivo. La idea general consiste en

dividir la función objetivo del individuo por una cantidad (la penalización) que guarda relación con las

restricciones que dicho individuo viola. Dicha cantidad puede simplemente tener en cuenta el número de

restricciones violadas ó bien el denominado costo esperado de reconstrucción, es decir el coste asociado a la

conversión de dicho individuo en otro que no viole ninguna restricción.

Otra técnica que se ha venido utilizando en el caso en que la computación de la función

objetivo sea muy compleja es la denominada evaluación aproximada de la función objetivo. En algunos casos

la obtención de n funciones objetivo aproximadas puede resultar mejor que la evaluación exacta de una única

función objetivo (supuesto el caso de que la evaluación aproximada resulta como mínimo n veces más rápida

que la, evaluación exacta).

Un problema habitual en las ejecuciones de los Algoritmos Genéticos surge debido a la

velocidad con la que el algoritmo converge. En algunos casos la convergencia es muy rápida, lo que suele a

denominarse convergencia prematura, en la cual el algoritmo converge hacia óptimos locales, mientras que en

otros casos el problema es justo el contrario, es decir se produce una convergencia lenta del algoritmo. Una

posible solución a estos problemas pasa por efectuar transformaciones en la función objetivo. El problema de

la convergencia prematura, surge a menudo cuando la selección de individuos se realiza de manera

proporcional a su función objetivo. En tal caso, pueden existir individuos con una

adaptación al

problema muy superior al resto, que a medida que avanza el algoritmo "dominan" a la población. Por medio

de una transformación de la función objetivo, en este caso una comprensión del "primer rango de variación de

la función objetivo, se pretende que dichos "súper individuos" no lleguen a dominar a la población.

El problema de la lenta convergencia del algoritmo, se resolvería de manera análoga, pero en

este caso efectuando una expansión del rango de la función objetivo.

La idea de especies de organismos, ha sido imitada en el diseño de los Algoritmos Genéticos

en un método propuesto por Goldberg y Richardson [20], utilizando una modificación de la función objetivo

de cada individuo, de tal manera que individuos que estén muy cercanos entre sí devalúen su función objetivo,

con objeto de que la población gane en diversidad.

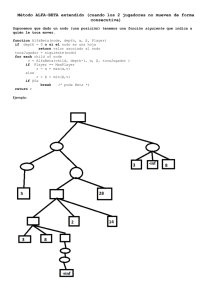

PROGRAMACIÓN EVOLUTIVA

La Programación Evolutiva, se fundamenta en las ideas expresadas por Fogel [16], [17], [18], y

trata de resolver problemas de optimización combinatoria.

A grandes rasgos, la estructura de dichos algoritmos se asemeja a la de los Algoritmos

Genéticos, si bien la diferencia fundamental entre ambos radica en el hecho de que los nuevos individuos son

creados utilizando tan sólo mutación, es decir no existen operadores de cruce. De esta forma la Programación

Evolutiva puede verse como un Algoritmo Genético asexual.

La Codificación del algoritmo de base como vimos anteriormente, antes de crear un programa

evolutivo o algoritmo genético debemos de considerar la estructura que va a tener y como va a funcionar para

obtener resultados de buena calidad. Para los fines que se persiguen en este trabajo lo que se eligió fue

trabajar con redes neuronales tipo Perceptron Multicapa, aplicándoles operadores genéticos. Cada cromosoma

de la población representa un PM el cual contará con una sola capa oculta donde el número de nodos ocultos

puede variar.

13

Cada cromosoma de la población debe generar, codificar y variar, tanto su número de nodos

ocultos como los pesos de conexión entre las entradas con los nodos de la capa oculta y los pesos de los nodos

de la capa oculta con los de las salidas. Con esto tenemos que los cromosomas tienen una longitud variable

por lo que para implementarlos haremos uso de una lista donde cada nodo de la lista representa

conceptualmente un nodo oculto del PM.

Un cromosoma típico se muestra en la siguiente figura junto con el PM que representa.

Perceptron Mulicapa (PM)

En cada nodo de la lista guardamos la información que es importante y que es representativa de

la estructura del PM. Esta información consta de los valores de los pesos numéricos sobre las conexiones que

llegan al nodo oculto de los nodos de entrada y los que salen de los nodos ocultos hacia los nodos de salida.

Para representar toda la población del PE en la memoria de la máquina, se codifica en un arreglo

de estructuras de tamaño n que define n-1 cromosomas de la población. La estructura mantiene información

sobre la aptitud de cada cromosoma, lo cual se explicará más adelante, además de un apuntador a la lista del

cromosoma. La posición n del arreglo se utiliza para dejar el mejor PM encontrado de una generación a otra.

Véase la siguiente figura.

Estructura que representa los cromosomas en una población.

El Algoritmo Principal

El algoritmo principal del PE se muestra a continuación.

Inicio

Generación=0

Inicializar la población

Evaluar cada cromosoma

14

Guardar el mejor cromosoma

Mientras (generación<MAXGENS)

Inicio

Seleccionar la nueva población

Aplicar Mutación Estructural

Aplicar Mutación de los pesos

Evaluar cada cromosoma

Guardar el mejor cromosoma

Generación=Generación+1

Fin

Fin

Lo que hace éste algoritmo es inicializar una población aleatoria de cromosomas los cuales evalúa

utilizando una función de evaluación, a esta población la llamamos generación cero Algo importante que se

debe mencionar es que la población tiene tamaño fijo durante todas las generaciones

Después de evaluados los cromosomas, guarda el mejor en el último elemento del arreglo de

estructuras para después entrar en un ciclo donde la población evoluciona varias generaciones a las cuales se

les aplican los operadores genéticos.

Iniciación de la Población

Una función inicializa cada elemento de la población de la siguiente manera: el número de

nodos ocultos representados en cada cromosoma se genera de manera aleatoria, cuidando que no exceda un

número máximo definido por el usuario. De igual manera los pesos de cada nodo se inicializan de forma

aleatoria con valores entre -1 y 1.

Función de Evaluación

La función de evaluación, como ya vimos anteriormente, es una función que nos indica que tan

apto es un cromosoma para participar en la creación de la siguiente generación. En el caso particular de este

trabajo la aptitud del PM se refiere a qué tan bien clasifica un conjunto de datos.

Para encontrar esta aptitud de los cromosomas lo que se hace es primeramente calcular la

entrada a cada uno de los nodos ocultos del cromosoma y esto se hace mediante el producto interno del vector

de los pesos que entran en el nodo con el vector de los valores de la entrada a la red.

Para el caso del PM de la figura de la página anterior tenemos:

-0.12+0.074*x1+0.017*x2

-0.59+0.146*x1+0.937*x2

La función de transferencia que se ocupa es la función sigmoide, definida de la siguiente

manera:

f(u)=1/(1+exp(-u))

Se aplica esta función de transferencia para calcular la salida de cada uno de los nodos ocultos

dando:

z1=f(-0.12+0.074*x1+0.017*x2)

z2=f(-0.59+0.146*x1+0.937*x2)

Finalmente, para calcular la salida del nodo en la capa de salida, se vuelve a aplicar la función

de transferencia al producto interno del vector de los pesos que entran en el nodo con el vector de las salidas

de los nodos ocultos, dando:

yl=f((0.7-0.7*zl-0.9*z2)

La función de evaluación se basa en el error cuadrático medio, ECM, que comúnmente se usa en

el algoritmo de retropropagación para determinar el error. El ECM se define de la siguiente manera:

ECM=S(yi-di)2

Donde la suma es sobre todos los patrones de los datos, yi es la salida del PM para el patrón

calculado como se describió anteriormente, y di es la salida deseada, que seria el valor que queremos asociar

con el patrón.

Selección de la Nueva Población

15

Para esta parte se eligió utilizar el método de la ruleta el cual se describió anteriormente pero lo

mencionaremos aquí con un poco de más detalle. Este método consiste en particionar un disco en rebanadas o

sectores los cuales dependen en tamaño de la aptitud del cromosoma que representa dicho sector, a mayor

aptitud mayor es el sector o la rebanada y viceversa. Ya que tenemos el disco particionado con todos los

cromosomas participantes (deben de estar todos los de la población) se gira el disco y de acuerdo al sector

donde éste para, se escoge el cromosoma correspondiente para que sea parte de la nueva población. Esto se

repite n-11 veces que es el tamaño de la población. Para hacer la partición del disco y simular el giro de éste

lo que se hace es lo siguiente. Primero encuentra la aptitud total de la población sumando todas las aptitudes

menos el del último cromosoma. Después calcula la aptitud relativa de cada cromosoma dividiendo la aptitud

de ese cromosoma entre la aptitud total. Luego, con la aptitud relativa calcula la aptitud acumulada: se

inicializa la aptitud acumulada del primer cromosoma con su aptitud relativa y se calcula la aptitud acumulada

del siguiente cromosoma sumando su aptitud relativa más la acumulada del cromosoma anterior y así

sucesivamente para cada cromosoma. Esta aptitud acumulada representa la proporción de cada cromosoma.

Para simular el giro del disco se genera un número aleatorio x, entre O y 1, y se elige el

cromosoma cuya aptitud acumulada correspondiente contiene a x. Este proceso se repite el número de

cromosomas existentes. Los cromosomas que ocupan una porción mayor del disco tienen más probabilidad de

ser escogidos para la nueva población, sin embargo, no excluye la elección de cromosomas con peor aptitud.

Al final de este proceso el arreglo que representa la nueva población puede quedar con cromosomas repetidos.

La aptitud relativa y la acumulada son campos de la estructura que se guardan en el arreglo.

Mutación Estructural

Esta mutación se creó para estar modificando el número de nodos ocultos en cada cromosoma

ya que esta variación nos puede ayudar a encontrar el tamaño de la capa oculta necesario para que el

cromosoma logre hacer el mejor porcentaje de clasificación. Para lograr esto el PE utiliza dos operadores ='

los cuales se mencionan y describen a continuación:

1. Adicionar, se encarga de aumentar un nodo oculto al cromosoma en cuestión inicializando sus

pesos con 0. Se valida que al aumentar este nodo no sobrepase el número máximo de nodos permitidos por el

usuario; si ya se tiene ese número máximo no se añade otro nodo. Este nodo se incorpora al final de la lista y

se hace de acuerdo a un número generado de forma aleatoria: si este es menor a una probabilidad de adición

definida por el usuario se adiciona el nodo, en otro caso no se hace ningún cambio al cromosoma.

2. Para equilibrar el efecto que pudiera tener la función Adiciona, y para reducir el número de nodos

ocultos en un cromosoma, se define otro operador de nombre Eliminar. De forma similar se genera un

número aleatorio y se compara con la probabilidad de eliminación definida por el usuario, si dicho

número es menor se elimina el primer nodo de la lista del cromosoma en cuestión.

En los dos casos se reduce linealmente el parámetro de probabilidad de su valor inicial a un

valor pequeño definido por el usuario, conforme evoluciona el algoritmo; con esto, al final de la corrida no

es necesario modificar la arquitectura del PM.

Mutación Paramétrica

En esta parte la mutación se enfoca hacia los pesos de un nodo oculto y esta se realiza a través

de un operador. Esto quiere decir que para cada nodo oculto de un cromosoma se genera un número aleatorio

y si éste número es menor a una probabilidad de mutación, se modifican los pesos agrupados en el nodo; en

caso contrario se conserva el mismo valor de los pesos. Si se va a cambiar el valor de un peso se le agrega el

valor generado por una gaussiana, con media O y varianza definida.

Guardar el mejor cromosoma

En la literatura se han reportado buenos resultados usando un operador llamado elitismo. La

función de éste es asegurar que el mejor cromosoma encontrado sobreviva de una generación a otra. En el PE,

si el cromosoma con mejor aptitud de la población actual supera al seleccionado en la población a anterior,

éste es reemplazado, conservando siempre al mejor cromosoma de una generación a otra. En otro caso

reemplaza el peor cromosoma de la población actual con el mejor de la generación anterior.

16

ALGORITMOS GENÉTICOS PARALELOS

En este apartado se introducirán tres maneras diferentes de explotar el paralelismo de los Algoritmos

Genéticos, por medio de los denominados modelos de islas. Para una profundización sobre el tema puede

consultarse Stender [38]. Modelos de islas

La idea básica consiste en dividir la población total en varias subpoblaciones en cada una de las cuales se

lleva a cabo un Algoritmo Genético. Cada cierto número de generaciones, se efectúa un intercambio de

información entre las subpoblaciones, proceso que se denomina migración. La introducción de la migración

hace que los modelos de islas sean capaces de explotar las diferencias entre las diversas subpoblaciones,

obteniéndose de esta manera una fuente de diversidad genética. Cada subpoblación es una "isla", definiéndose

un procedimiento por medio del cual se mueve el material genético de una "isla" a otra. La determinación de

la 'tasa de migración' es un asunto de capital importancia, ya que de ella puede depender la convergencia

prematura de la búsqueda. Se pueden distinguir diferentes modelos de islas en función de la comunicación

entre las sub-poblaciones. Algunas comunicaciones típicas son las siguientes:

•Comunicación en estrella, en la cual existe una subpoblación que es seleccionada como maestra (aquella que

tiene mejor media en el valor de la función objetivo), siendo las demás consideradas como esclavas. Todas

las subpoblaciones esclavas mandan sus h1 mejores individuos (h1, > 1) a la subpoblación maestra la cual a

su vez manda sus h2 mejores individuos (h2 > 1) a cada una de las subpoblaciones esclavas.

PVM (Paralell Virtual Machine)

PVM es un paquete de software que permite a un programador crear y accesar un sistema de

computo concurrente hecho de una red de elementos de procesamiento libres de conexión. El hardware

coleccionado dentro de la maquina virtual del usuario puede ser estaciones de trabajo con un solo procesador,

"vector machines" o supercomputadoras paralelas.

Los elementos individuales pueden ser de un solo tipo (homogéneos) o todos diferentes

(heterogéneos) o cualquier mezcla, así como las maquinas usadas pueden estar conectadas a una o más tipos

de redes. Estas redes pueden ser pequeñas como una LAN conectada en un solo cuarto, tan grande como la

Internet conectando maquinas alrededor del mundo o cualquier combinación que se quiera.

Esta habilidad de poner juntas diversas arquitecturas bajo un control central permite al usuario

PVM dividir el problema en subtareas y asignar la ejecución de cada una de ellas en la arquitectura del

procesador que mejor convenga para dicha subtarea.

Mientras que no hay restricción en el tamaño de tareas, por el tiempo necesitado para enviar un

mensaje entre dos maquinas en una red externa, es recomendado que las tareas sean de un tamaño moderado

para hacer un uso más efectivo de PVM.

Para ser tan general y flexible como sea posible, PVM esta basado en un modelo de paso de

mensaje paralelo. Los mensajes son pasados entre tareas que no comparten la misma representación de datos.

Las tareas de los usuarios son capaces de inicializar y terminar procesos, compartir datos y sincronizarse con

otra a través de una biblioteca estándar de rutinas de interfase.

El control y dependencia de tareas es arbitrario y bajo el control completo del usuario de

acuerdo a lo dictado por la aplicación.

Hay dos modelos de programación principales que los códigos bajo PVM siguen: master/worker y

hostiess.

Bajo el paradigma master/worker, una tarea es usada como el maestro ("master"). El propósito

de la tarea maestro es crear todas las otras tareas que están designadas a trabajar en el problema ("workers") y

llevar un control general del proceso.

Bajo el modelo hostiess, la tarea inicial crea copias del mismo como tarea y luego comienza a

trabajar en su porción del problema, mientras que las tareas creadas inmediatamente empiezan a trabajar en su

porción. Los requerimientos de entrada/salida son regularmente manejados por las tareas individuales, pero

puede ser benéfico tener algunos resultados recolectados por una sola tarea, específicamente si estos

resultados necesitan ser esparcidos hacia todas las tareas.

Las aplicaciones PVM pueden ser escritas en C o Fortran 77. Para ejecutar un programa bajo

PVM, el usuario agrega llamadas a rutinas de biblioteca de PVM que lanzan tareas a otras maquinas dentro de

la maquina virtual del usuario y permite a las tareas enviar y recibir mensajes.

17

METODOLOGÍA

A continuación se presentan los distintos esquemas del algoritmo evolutivo paralelo planteados

por la Dra. Graciela, se explican también algunas particularidades existentes que conforman las distintas

versiones de los algoritmos desarrollados.

Finalmente se establecen las variables que servirán para comparar las distintas versiones del

algoritmo evolutivo paralelo.

Paralelización de los algoritmos evolutivos

NOTA:

Para codificar cada uno de los esquemas propuestos, se utilizo el modelo de programación

PVM 'master/worker1.

El termino modificar población se refiere a aplicar los operadores genéticos a los individuos de

dicha población.

- Primer esquema (Central i. i=POPSIZE)

Este esquema corresponde al modelo de islas con comunicación en estrella descrito en la

sección de algoritmos genéticos paralelos, como podrá deducirse al comprender la siguiente descripción. En

este esquema el proceso "master":

- Inicialmente crea y lanza los 'workers'."

- Crea su población aleatoria, guarda el mejor individuo en la posición POPSIZE de su arreglo (population),

y pide a cada proceso "worker" crear su propia población aleatoria.

-A continuación recibe las poblaciones de cada "worker", junta todos estos individuos (los creados por él y

por los demás) en un arreglo de Individuos (Array ()).

- Después de hacer esto pide a todos los "workers" modificar su población - que deben conservar- y las recibe

nuevamente, modifica su población - aplicando elitismo nuevamente- y junta todos estos individuos en otro

arreglo de Individuos (Array).

- Repite lo siguiente para el número de generaciones establecidas:

- Selecciona de los dos arreglos (ArrayO y Arrayí) informados en los pasos previos los POPSIZE

mejores individuos, haciéndolos propios del proceso 'master1.

- Después envía a cada "worker" esta población para que la hagan propia, y les pide modificar esta

población. El proceso 'master' modifica su propia población.

- Recibe la población modificada por cada uno de los procesos 'workers'.

- Se aplica Elitismo a los POPSIZE mejores individuos, asegurando que el individuo más apto esta en

la posición POPSIZE del arreglo de Individuos "population".

- Después se guardan todas estas poblaciones en un arreglo de Individuos (ArrayO o Arrayí).

- Finalmente se aplica el algoritmo de Retropropagación al individuo population [POPSIZE].

Para cada esquema descrito anteriormente y el mejorado se usaron las siguientes bases de datos:

Base de datos Iris

Contiene el análisis de una especie de plantas llamada 'iris'. En la base de datos se describe en 3

valores numéricos ciertas características de las plantas las cuales se clasifican en tres clases que son

iris-setosa, iris-versicolor e iris-virginica. Se manejan cuatro características a las que llamamos atributos

y estos son los que se utilizan para obtener la clasificación. Se tienen un total de 119 ejemplos de los

cuales 85 son para entrenamiento y 34 para prueba. Esta es la base de datos más pequeña que se

utilizo.

Base de datos Diabetes

Esta base de datos contiene 768 ejemplos los cuales se dividen en dos clases donde la clase 1

indica que el paciente no dio positivo con la enfermedad y la clase 2 indica que el paciente si dio positivo

con la enfermedad. Se manejan 500 ejemplos de la clase 1 y 268 de la clase 2. Cada ejemplo contiene 8

atributos que son los que se utilizan para hacer la clasificación.

Base de datos Heart

Esta base de datos contiene 270 ejemplos los cuales se dividen en dos clases donde la clase 1

indica que una persona no esta propensa a tener un ataque al corazón y la clase 2 indica que la persona

si es propensa a tener un ataque. Los ejemplos se distribuyen en 150 para la clase 1 y 120 para la clase

Cada ejemplo contiene 13 atributos.

Base de datos DNA

18

Esta base de datos contiene 3186 ejemplos los cuales están clasificados en tres clases. Para su

manejo la base de datos esta dividida en 2000 ejemplos para entrenamiento y 1186 para prueba. La

clase 1 contiene 464 ejemplos de entrenamiento y 303 de prueba, la clase 2 contiene 485 ejemplos de

entrenamiento y 280 de prueba, y por ultimo la clase 3 contiene1051 ejemplos de entrenamiento y 603 •

de prueba. Para la clasificación cada ejemplo contiene 180 atributos.

En cada uno de los esquemas se esta obteniendo un valor llamado calidad (fitness) el cual nos

indica que tan bien clasifica nuestra red en cada una de las bases de datos, este valor se obtiene

después de aplicar el Backpropagation a nuestro mejor individuo. Cada algoritmo nos da el valor calidad

tanto para los ejemplos de entrenamiento como para los de prueba, sin embargo, para efectos de

análisis de resultados, solo se utiliza el de prueba. También se obtiene el tiempo de ejecución da cada

uno de los algoritmos descritos.

ACERCA DE PVM.

Antes de entrar de lleno a lo que son los algoritmos paralelos veremos los elementos básicos

necesarios de PVM que se necesitan para poder correr los programas de una forma correcta.

Primero, antes que nada se necesita crear el archivo hostfíle. Este archivo define la

configuración inicial de los hosts o máquinas, que PVM combina para crear la máquina virtual.

Este archivo también contiene información acerca de los hosts que el usuario desee agregar

posteriormente a la configuración. El archivo hostfile se creo en el directorio raíz del usuario que va a utilizar

PVM y dentro de él lo mínimo que puede contener es una lista de los nombres de los hosts. Un nombre por

línea. Los líneas en blanco son ignoradas, y las líneas que comienzan con un # son líneas de comentario.

Para nuestro caso que se trabajo con el cluster pacífico.uam.mx, nuestro archivo hostfile se veía

más o menos así:

Configuración para pacifico

pacificol.uam.mx

ep

=

/home/ejecutables/pvm3/bin/LINUX

dx

=

/usr/share/pvm3/lib

pacifico2.uam.mx

ep

=

/home/ejecutables/pvm3/bin/LINUX

dx

=

/usr/share/

pvm3/lib

pacifico3.uam.mx

ep

=

/home/ejecutables/pvm3/bin/LINUX

dx

=

/usr/share/

pvm3/lib

pacifico4.uam.mx

ep

=

/home/ejecutables/pvm3/bin/LINUX

dx

=

/usr/share/

pvm3/lib

pacifico5.uam.mx

ep

=

/home/ejecutables/pvm3/bin/LINUX

dx

=

/usr/share/

pvm3/lib

pacifico6.uam.mx

ep

=

/home/ejecutables/pvm3/bin/LINUX

dx

=

/usr/share/

pvm3/lib

pacifico7.uam.mx

ep

=

/home/ejecutables/pvm3/bin/LINUX

dx

=

/usr/share/

pvm3/lib

pacifico8.uam.mx

ep

=

/home/ejecutables/pvm3/bin/LINUX

dx

=

/usr/share/

pvm3/lib

pacifico9.uam.mx

ep

=

/home/ejecutables/pvm3/bin/LINUX

dx

=

/usr/share/

pvm3/lib

pacificol0.uam.mx ep

= /home/ejecutables/pvm3/bin/LINUX

dx = /usr/share/ pvm3/lib

Donde ep permite indicar al usuario una ruta donde se van a encontrar los archivos ejecutables; dx

permite especificar la dirección donde se encuentra el pvmd (el proceso demonio de pvm) para cada máquina.

Ya que se tiene configurado el archivo hostfile se procede o iniciar la consola pvm. Para hacer esto

simplemente en cualquiera de los hosts o maquinas que van a integrar la consola, se obre una sesión y en una

terminal desde la línea de comandos se teclea $pvm hostfile

Esto hace que se entre a lo consola de pvm donde se despliega el prompt

pvm>

La creación y utilización del archivo hostfile se hace para que PVM integre los hosts que se

encuentran dentro de ese archivo. Si se desean agregar mas existe un comando add que agrega hosts a la

máquina virtual. Para ver en detalle los comandos que acepta el pvm simplemente hay que ejecutar el

comando help desde el prompt de pvm. Los comandos más importantes son quit y halt. El primero sale de la

consola dejando a los demonios y tareas pvm en ejecución. El segundo termina todos los procesos pvm

incluyendo la consola y los demonios deteniendo la ejecución de pvm.

A continuación se muestran y describen cada uno de los funciones de PVM que se utilizaron en la

creación de las tres versiones paralelos:

pvm_mytid()

Retorna el tid del proceso.

Sinopsis. int tid = pvm_mytid(void)

Parámetros.

tid : Entero identificador de la tarea es retornado por la llamada a un proceso PVM. Un

valor menor que cero indica error.

19

pvm_parent()

Regresa el tid del proceso que inició al mismo.

Sinopsis. int tid = pvm_parent(void)

Parámetros.

tid : Tipo entero, indica el identificador de tareas, en este caso del proceso padre.

pvm_recv()

Recibe un mensaje.

Sinopsis. int bufid = pvm_recv(int tid. int msgtag)

Parámetros.

tid

:

identificador

de

tareas

tipo

entero

para

mandar

procesos.

msgtag : Etiqueta de mensaje tipo entero dada por el usuario.

bufid : Valor entero que tiene el identificador del búfer activo receptor.

pvm_initsend()

Limpia el búfer de envío y crea uno nuevo para encapsular el nuevo mensaje.

Sinopsis. int bufid = pvm_initsend(int encoding)

Parámetros.

encoding : Entero que especifica alguno de los siguientes mensajes:

PvmDataDefault, PvmDataRaw o Pvm DataInP lace.

bufid : Entero que regresa el contenido del identificador del búfer del

mensaje. Un valor menor que cero indica error.

pvm_send()

Manda datos al búfer de mensajes activo.

Sinopsis.

int info = pvm_send(int tid, int msgtag)

Parámetros.

tid : identificador de tareas tipo entero para mandar procesos.

msgtag : Etiqueta de mensaje tipo entero dada por el usuario.

info : Código de estado, de tipo entero regresado por la rutina.

Pvm_spawn()

Inicia uno o mas nuevos procesos PVM.

Sinopsis. int numt = pvm_spawn(char *task. chor **argv. int flog. char

*where, int ntask, Int *tids)

Parámetros.

task ; Una cadena de caracteres que contiene el nombre del archivo

ejecutable a ejecutarse como proceso PVM.

argv : Apuntador o un arreglo de argumentos para el archivo

ejecutable, al final del arreglo se especifica como NULL.

flag : Valor de tipo entero indicando las opciones del spawn.

where : Cadena de caracteres especificando donde iniciar el proceso de

PVM.

ntask : Entero especificando el número de copias del ejecutable a

iniciar.

tids : Arreglo de enteros de longitud ntask

numt : Valor entero regresado con el número de tareas iniciadas.

pvm_pk*()

Empaqueta el búfer activo de mensajes con el tipo de datos respectivo.

Sinopsis: int info = pvm_pkint(int *ip. int nitem, int stride)

int info = pvm_pkfloat(float *fp. int nitem, int stride)

Parámetros.

ip : Arreglo de enteros.

fp : Arreglo real de punto flotante.

nitem : El total de dotos a empacar (no el número de bytes).

stride : El tipo de empaquetación a ser usado mientras se empacan

los datos.

info : Valor entero que indica estado. regresado por lo rutina, si es

menor de cero indica error.

pvm_upk*0

20

Desempaco a el búfer de mensajes activo a los arreglos del tipo definido.

Sinopsis.

int info = pvm_upkint(int *ip. int nitem, int strid

int info = pvm__upkfloat(float *fp. int nitem, int stride)

Parámetros.

ip : Arreglo de enteros.

fp : Arreglo real de punto flotante.

nitem : El total de datos a desempacar (no el número de bytes).

stride : El tipo de empaquetación a ser usado mientras se

desempacan los datos.

info : Valor entero que indica estado. regresado por la rutina, si

es menor que cero indica error.

Pvm_exit()

Afecta al pvmd local en el que se proceso la salida de PVM.

Sinopsis. int info = pvm_exit(void)

Parámetros.

info : Entero del código de status retornado por la rutina. Un

valor > 0 indica error.

Se presenta sólo una breve descripción, paro más detalles consulte un manual

especializado en rutinas de PVM. para terminar esta parte mostraremos la forma de compilar los programas

paralelos que utilizan las librerías de PVM. La forma de compilación que utilizamos es la siguiente:

$gcc -o ejecutable archivo_fuente.c -I$PVM_HOME/include -lpvm3 -L$PVM_HOME/lib

Esto se hace desde el directorio donde se encuentran los archivos fuente.

La variable de entorno $PVM_HOME debe ser igual al directorio donde se encuentra

instalado PVM. Cabe mencionar que PVM buscará el código de los procesos lanzados con spawn ya sea

en el directorio $PVM_BIN o en el directorio raíz del usuario que esté ejecutando PVM. Así es necesario

definir dicha variable de entorno (PVM_BIN) o copiar los ejecutables al , directorio raíz de nuestra cuenta.

Resta describir un archivo rhosts. que define parámetros para lo ejecución correcta

de PVM en los host remotos. Se trata del archivo .rhosts. en el cual se define para cada máquina el usuario

que ejecutará PVM, ya que si no se hace esto no se podrá iniciar el pvm desde esa máquina. Este archivo de

autorización es necesario para tener acceso a ciertos comandos como rlogin. rcp y rsh. esenciales para el

funcionamiento de PVM.

Un ejemplo de dicho archivo es:

pacificol.uam.mx trejo

pacifico2.uam.mx trejo

pacifico3.uam.mx trejo

pacifico4.uam.mx trejo

pacifico5.uam.mx trejo

pacifico6.uam.mx trejo

Dicho archivo debe estar colocado en el directorio raíz del usuario.

DEFINICIONES Y VARIABLES DE LOS PROGRAMAS DE APOYO

En esta sección se describirán las variables globales y las definiciones que se establecieron para

los programas. Estas variables y definiciones son similares en las tres versiones de apoyo y en la versión final

donde mejoramos los resultados, cabe mencionar que las 3 primeras versiones cambian es en su forma de

comunicación mas no en su estructura básica de código fuente y la versión final cambio radicalmente tanto

en estructura como en código fuente pero siempre utilizando las mismas variables globales. Las definiciones y

variables globales definidas se encuentran en los archivos algor.h. algor2.h y algor3.h los cuales se utilizan en

los archivos maestro, cpp y esclavo, cpp, maestro2.cpp y esclavo2.cpp. y maestro3.cpp y esclavo3.cpp

respectivamente para las versiones de apoyo y en la ver final algor.h, envia.h, Arch.h, hello.c y hello_other.c

A continuación se describen dichas variables y definiciones:

Variables Globales:

- PELIMIN Es la probabilidad de eliminación de un nodo de una red neuronal

(esto es en la capa oculta).

- PADIC Probabilidad de adicionar un nodo a una red neuronal (en la capa oculta).

- PMUTNODO Es la probabilidad de aplicar mutación o uno de los nodos de una

21

de las redes neurona les.

Definiciones:

- NENT Define el número de entradas a la red neuronal (sin contar el sesgo).

- NSAL Define el número de salidas de lo red.

- MaxSize Define el tamaño máximo que puede tener cada cromosoma de la red

neuronal (el mínimo se definió como 3).

- POPSIZE Define el tamaño de lo población (el número de cromosomas).

- MAXGENS Aquí se define el número máximo de generaciones que se deben

entrenar las redes con algoritmos genéticos.

- PXOVER Define la probabilidad de cruzamiento entre dos cromosomas.

- PMUTATION Probabilidad de mutación a un cromosoma.

- n Razón de aprendizaje (es una constante que se uso en el bockpropagation).

- NPROC Define el número de procesos esclavos que se van a generar y a lanzar.

Para poder enviar y recibir toda esta información a través de las funciones de PVM que solo

pueden recibir enteros o flotantes lo que se hizo fue crear dos funciones. La primera se llamo EnviaPob y se

encarga de agrupar la información mas importante necesaria y enviarlo para que quien reciba esta información

a partir de ésta pueda reconstruir la red neuronal. La segunda función se llama RcvPob y se encarga de recibir

toda la información que necesita para después reconstruir la red neuronal. Estas dos funciones se encuentran

declarados en el archivo envía.h.

Finalmente en el archivo algor.h se define ENVÍA como un parámetro el cual indica a cada

proceso cada cuántas generaciones se envía su población a los demás procesos.

Como mencionamos anteriormente se realizaron las tres versiones del algoritmo genético de

apoyo en paralelo. Las tres manejan parámetros semejantes, en lo que realmente cambian es en su arquitectura

y en su forma de comunicación.

El funcionamiento general de las tres versiones es el siguiente: Primero se creo un proceso

maestro el cual va a tener el control del programa paralelo. Este proceso maestro genera un número

determinado de procesos esclavo donde cada uno de estos creará su propia población aleatoria de individuos.

Cada individuo es una red neuronal y éstas son las que tomaran los valores de las bases de datos para hacer la

clasificación de patrones. Todos los esclavos irán mutando o evolucionando sus poblaciones y después de un

tiempo determinado (una iteración) envían sus individuos finales al proceso maestro el cual elige el mejor

individuo de todos los que recibe y este es el que utiliza para aplicarle la retropropagación así como para

hacer la clasificación de los patrones de la base de datos.

A continuación se describen brevemente las características de solo la versión que se denomino

como la mejor y la cual brindo mas información para así mejorarla:

Versión "Central".

El proceso central o maestro es el que tiene el control total del desarrollo de las redes

neuronales. El proceso central es creado y entonces este genera un número determinado de procesos esclavo,

este número está determinado por un valor definido en el archivo algor.h el cual se le llamó NPROC. Ya que

se crean los procesos esclavos, el maestro les indica que generen cada uno su población aleatoria y espera a

recibir las poblaciones de cada esclavo para guardarlos en un arreglo. Cada población de los procesos esclavo

esta compuesta de POPSIZE individuos donde este valor también está definido en el archivo algor.h y se

puede modificar según a las necesidades del usuario.

Ya que recibió las poblaciones aleatorias de los procesos esclavo entonces el proceso maestro

genera su propia población aleatoria y guarda todas estas poblaciones en un arreglo de tamaño POPSIZE *

(NPROC) + 1 , es mas uno porque en el último elemento del arreglo guardo el mejor individuo (la mejor red

neuronal) de los que tiene en ese momento. Ya hecho esto indica otra vez a todos los esclavos crear su

siguiente población y esto lo hacen mutando la población actual que en este momento es la que generaron

aleatoria mente. El proceso maestro cuando recibe las nuevas poblaciones de todos los esclavos también las

guarda en un segundo arreglo y guarda el mejor individuo en el último elemento.

Lo que sigue es una acción iterativa la cual se hace un determinado número de generaciones,

las cuales están limitadas hasta cierto valor definido también el algor.h como MAXGENS y dicho valor

22

también lo puede modificar el usuario para definir cuantas generaciones quiere que se desarrollen las

poblaciones. Esta acción iterativa consiste de lo siguiente:

El proceso maestro elige de todos los individuos que tiene en los dos arreglos los

POPSIZE mejores, esto lo hace viendo el campo del individuo donde tiene el valor obtenido al aplicarle lo

función de evaluación (fitness o calidad). Cuando obtiene los POPSIZE mejores los envía en un arreglo a

coda uno de los procesos esclavo para que sea a esta población a la que le apliquen la mutación y obtengan la

siguiente generación. Ya que el esclavo hizo esto le vuelve a mandar la población generada al proceso

maestro y se queda esperando a que el proceso maestro mande la siguiente población. El proceso maestro

recibe las poblaciones de todos los esclavos y las guarda en el arreglo que tenga las penúltimas poblaciones

recibidas ya que las guarda las compara junto con las del arreglo de las últimas recibidas y vuelve a obtener