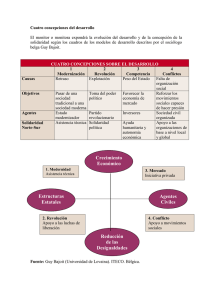

La evaluación en la cooperación española - Informe anual

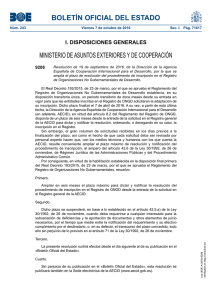

Anuncio