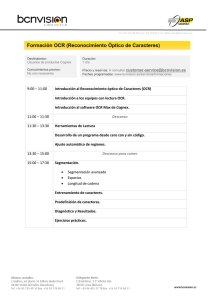

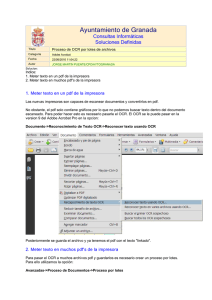

OCR: Análisis i implementación de algoritmos en nuevas

Anuncio