REVISION LITERATURA PER

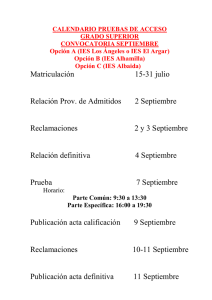

Anuncio