Alta disponibilidad en servidores y optimización de

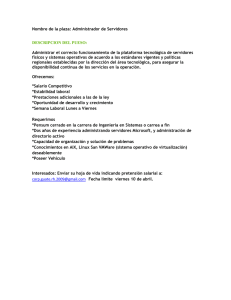

Anuncio