TECNICAS Y ALGORITMOS PARA LA ADQUISICION 29-07-08

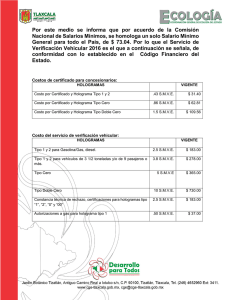

Anuncio