¿Quo vadis ciencia?

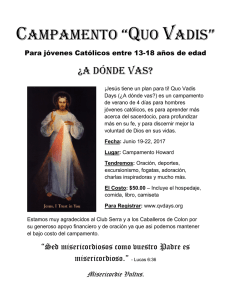

Anuncio