Fotones y núcleos - Libros Maravillosos

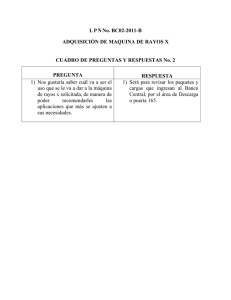

Anuncio