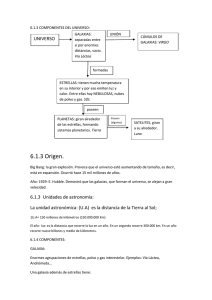

Astrofísica y Cosmología - Agrupación Astronómica de Málaga SIRIO

Anuncio