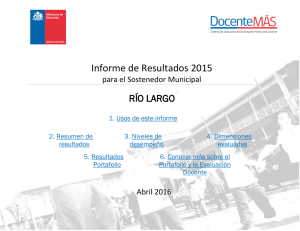

La evaluación docente en Chile

Anuncio