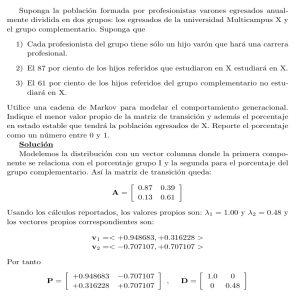

Inferencia Estad´ıstica

Anuncio

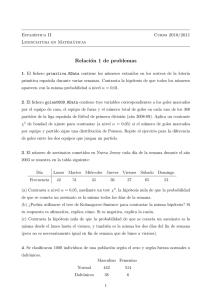

MaMaEuSch Management Mathematics for European Schools http://www.mathematik.unikl.de/˜ mamaeusch Inferencia Estadı́stica Paula Lagares Barreiro* Justo Puerto Albandoz* MaMaEuSch** Management Mathematics for European Schools 94342 - CP - 1 - 2001 - 1 - DE - COMENIUS - C21 * Universidad de Sevilla Este proyecto ha sido llevado a cabo con ayuda parical de la Comunidad Europea en el marco del programa Sócrates. El contenido del proyecto no reflejy necesariamente la posición de la Comunidad Europea, ni implica ninguna responsabilidad por su parte. ** Índice general 1. Inferencia Estadı́stica 1.1. Introducción a la Inferencia Estadı́stica . . . . . . . . . . . . . . . . . . . . . . 1.2. Distribución en el muestreo de un estadı́stico o estimador . . . . . . . . . . . . 1.3. Estimación puntual. Distribución en el muestreo de los principales estimadores 1.4. Estimación por intervalos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1.4.1. Errores de estimación y tamaño de la muestra . . . . . . . . . . . . . . . 1.5. Contrastes de hipótesis . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1.5.1. Relación entre los intervalos de confianza y los contrastes de hipótesis . 1.5.2. Test de la bondad de ajuste . . . . . . . . . . . . . . . . . . . . . . . . . 1.5.3. Contrastes de dependencia o independencia de caracteres . . . . . . . . 1.5.4. Test de homogeneidad de varias muestras . . . . . . . . . . . . . . . . . 1.6. Inferencia bayesiana . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 2 2 3 4 5 7 8 10 11 12 13 14 2. Un ejemplo de aplicación de la inferencia 2.1. Para una población . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 2.2. Para dos poblaciones . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 15 15 18 1 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . Capı́tulo 1 Inferencia Estadı́stica Dedicaremos este capı́tulo a ver de qué manera podemos inferir conclusiones sobre una población a través de los datos obtenidos mediante un muestreo. Haremos un recorrido por los diferentes conceptos que se necesitan conocer, ası́ como las técnicas a nuestro alcance. 1.1. Introducción a la Inferencia Estadı́stica Partimos de una muestra de 60 alumnos de una población de 544 alumnos en un Centro de Enseñanza Secundaria (CES). Una vez que tenemos los datos muestrales nos podemos hacer preguntas sobre el total de la población. Por ejemplo, ¿crees que podemos decir que la media de la altura de los alumnos del CES es mayor de 1’70? ¿Crees que 7 euros es un valor apropiado para representar la media de la paga de los alumnos de todo el centro? ¿Podemos decir que los datos de altura de los alumnos a los que les hemos preguntado son ”normales”? La Inferencia Estadı́stica responderá a estas cuestiones. La Inferencia Estadı́stica se compone de muchos métodos, que responden a preguntas muy variadas, según el objeto del estudio. ¿Cuál es una buena estimación de la altura media de los alumnos del centro? Preguntas como ésta se resuelven mediante métodos paramétricos, en los que supondremos conocida la distribución de la población y estudiaremos sus parámetros. ¿Cómo se distribuyen los datos de paga de los alumnos del centro? La respuesta a este tipo de preguntas, que se refieren a la distribución de la población, se resuelven mediante métodos no paramétricos. También existen diferentes métodos según la información de la que dispongamos y que utilicemos: Supongamos que la media de la altura de los alumnos del centro es un valor fijo que pretendemos conocer a través de la información que nos da la muestra. En este caso hablamos de inferencia clásica. También podemos suponer que la media de las alturas de los alumnos del centro es una variable aleatoria y que podemos conocer información a priori sobre esta variable. En este caso habları́amos de inferencia bayesiana En caso de que decidamos utilizar la inferencia clásica podemos extraer nuestras conclusiones de diferentes maneras. Podemos buscar un valor para la altura media de los alumnos del centro (que calcularemos a través de un estimador o estadı́stico) que consideraremos como valor del parámetro. En este caso harı́amos estimación puntual. Podemos buscar también un intervalo aleatorio dentro del cual podrı́amos encontrar con una determinada ”seguridad” el verdadero valor del parámetro, por ejemplo, el verdadero valor de la media de la paga de los alumnos del centro. En este caso estarı́amos hablando de estimación por intervalos. Imagina que tenemos un posible valor para la media de la altura de los alumnos del centro y queremos probar si este valor es ”aceptable” con una cierta ”confianza”. En este caso harı́amos un contraste de hipótesis. 2 Inferencia según objetivo estudio, métodos paramétricos métodos no paramétricos inferencia clásica según tipo información, inferencia bayesiana 1.2. Estimación puntual por intervalos Contraste de hipótesis Distribución en el muestreo de un estadı́stico o estimador Tenemos, como ya hemos dicho, una muestra de tamaño 60 de nuestra población de alumnos de un CES. Estamos estudiando la paga y la altura de dichos alumnos. Si queremos conocer la media de la paga de los alumnos del centro, podemos utilizar los datos de los 60 alumnos que tenemos para hallar un aproximación a lo que buscamos. ¿Qué podrı́amos usar para ”predecir” el valor de la paga media de la población? Lo lógico es pensar que si hallamos la media de los valores muestrales, nos acercaremos al valor poblacional. La media muestral es para nosotros un estimador. Ahora bien, imaginemos que otro compañero tuyo tiene una muestra de tamaño 60 de la población, que obviamente, debe ser diferente a la que hemos obtenido nosotros. En ese caso, si calcula la media muestral ¿obtendrá el mismo valor que hemos obtenido nosotros? La respuesta es que generalmente no obtendrá el mismo valor. Nos interesa conocer entonces cómo varı́a la media muestral al cambiar los datos muestrales. Nuestro estimador se va a comportar como una variable aleatoria. Vamos a denominar estadı́stico a toda función de los valores muestrales. Dicha función asignará a cada posible muestra un valor numérico, por lo que en realidad, se tiene una variable aleatoria que tendrá una distribución de probabilidad. A la distribución de probabilidad de esta variable aleatoria se le llama distribución en el muestreo del estadı́stico que dependerá, evidentemente, de los parámetros desconocidos de la población y que son objeto de estudio. Se denomina estimador de un parámetro poblacional desconocido a todo estadı́stico que nos da un valor que, para la mayorı́a de las muestras, está próximo a un parámetro poblacional desconocido. Ejemplo 1.2.1 Imagina que tenemos en una bolsa tres papeletas. Vamos a hacer un sorteo en el que habrá dos posibles ganadores, es decir, una persona sacará una papeleta, y luego la volvemos a introducir y otra persona sacará otra papeleta. Una empresa se compromete a darnos para el viaje de fin de curso la media de lo que obtengamos entre las dos papeletas. Las papeletas tienen un valor de 0 euros, 500 euros y 1000 euros. ¿Cómo se comportarı́a la media de estas muestras de tamaño 2 sobre nuestra población de tres papeletas? ¿Qué es lo más probable? Las posibilidades que tenemos son las siguientes: (0, 0), (0, 500), (0, 1000), (500, 0), (500, 500), (500, 1000), (1000, 0), (1000, 500), (1000, 1000). Calculamos la media de todas ellas y vemos con qué probabilidad aparece cada valor X =media Probabilidad 0 1/9 250 2/9 500 3/9 750 2/9 1000 1/9 La media de la población (0, 500, 1000) es 500 y la varianza es 1666660b 6 mientras que para la variable aleatoria media muestral la media es 500 y la varianza es 833330b 3. Como vemos tiene la misma media pero la varianza de la media es algo menor. Si representamos la distribución de la media muestral, vemos que: se acerca a una distribución normal. El Teorema Central del Lı́mite viene a corroborar el hecho que acabamos de observar en el ejemplo anterior. Dada una variable aleatoria con media µ y varianza σ 2 , la distribución de las medias de las√muestras, a medida que n (tamaño muestral) aumenta hacia infinito tiende asintóticamente a una distribución N (µ, σ/ n). En el ejemplo anterior se han hallado todas las muestras posibles, pero imagina lo que supondrı́an los cálculos en caso de que quisiéramos hallar todas las muestras posibles de 60 alumnos para los 544 del centro. Serı́a interminable realizar todos esos cálculos. Por ello, se suele utilizar el método de Montecarlo, que consiste en simular, mediante las tablas de números aleatorios o el ordenador, la obtención de un gran número de muestras y a ellas se les calcula el valor del estadı́stico, con lo que se obtiene una distribución de probabilidad aproximada (tanto más cuanto mayor sea el número de muestras que se generen). 3 1.3. Estimación puntual. Distribución en el muestreo de los principales estimadores Llegó el momento de estimar los valores de los parámetros de la población. Queremos conocer la media y la varianza de la altura de los alumnos del centro y de su paga. Podemos tomar como estimación el valor de la media muestral y de la varianza muestral para nuestra muestra de 60 alumnos de los 544. En este caso, estaremos haciendo una estimación puntual, ya que estimamos el valor del parámetro desconocido a través de un único valor del estimador. Ahora bien ¿coincide la media de la distribución de nuestro estimador con el valor de nuestro parámetro poblacional? Por ejemplo, la media de la varianza muestral no coincide con la varianza poblacional, ası́ que no será un buen estimador de la varianza. ¿Se acerca el valor de la estimación cada vez más al parámetro si aumentamos el tamaño de la muestra? Estas y otras propiedades son deseables en un estimador. A la hora de estimar el valor del parámetro poblacional se exige al estadı́stico una serie de propiedades con el fin de obtener una estimación aceptable: Centrado o insesgado: la media de la distribución muestral del estadı́stico muestral coincide con el parámetro poblacional desconocido. Consistente: al aumentar el tamaño de la muestra, el valor medio de la distribución muestral del estadı́stico muestral tiende al parámetro estimado. Eficiente: que sea el de menor varianza de todos los centrados. Suficiente: facilita toda la información acerca del parámetro que poseen los datos de la muestra. Dada una muestra aleatoria de una población, x1 , x2 , . . . , xk los estimadores puntuales más utilizados son: De la media poblacional, la media muestral Pk xi x = i=1 . n De la proporción poblacional, la proporción muestral: p= valores observados de A . tamaño muestral De la varianza poblacional, la cuasivarianza muestral: Sc2 n = S2 = n−1 Pk − x)2 , n−1 i=1 (xi como ya hemos dicho, no utilizaremos la varianza muestral porque es un estimador no centrado de la varianza poblacional. Se demuestra que dada una variable aleatoria X de una población con media µ y desviación tı́pica σ, se tiene que: 4 En muestreo con reemplazamiento o población infinita σ x tiene como media a µ y desviación tı́pica a √ . n En muestreo sin reemplazamiento o población finita σ x tiene como media a µ y desviación tı́pica a √ n r N −n . N −1 Como se observa, la única diferencia entre el caso en que la población es infinita y el muestreo es con reemplazamiento, con el caso en que el muestreo q sea sin reemplazamiento y la población finita, es que la desviación tı́pica queda multiplicada −n por el factor de corrección N N −1 , donde N es el tamaño de la población y n el tamaño de la muestra. Además, se demuestra que si X es una variable aleatoria que sigue una distribución normal de media µ y desviación tı́pica σ conocida, se tiene que: σ x sigue una distribución N (µ, √ ). n Como se ve en la expresión de la media muestral, mientras mayor sea el valor de n, tamaño de la muestra, menor será la desviación tı́pica y menor será el error que se cometerá al considerar como estimador de la media de la población a la media muestral. Habrá que ver la conveniencia de aumentar el tamaño de la muestra, ajustándose a las necesidades económicas que se dispongan. Se demuestra que si X es una variable aleatoria que sigue una distribución normal de media µ y desviación tı́pica σ desconocida, se tiene que: x−µ Sc √ n sigue una distribución t-Student con (n − 1) grados de libertad. En caso de que el tamaño muestral sea mayor de 30, la distribución t-Student se aproxima por una distribución N (0, 1). Se demuestra que si X sigue una distribución normal de media µ y desviación tı́pica σ, se tiene que: (n − 1)Sc2 nS 2 = sigue una distribución χ2 (n − 1) chi-cuadrado con n − 1 grados de libertad. σ2 σ2 1.4. Estimación por intervalos Hemos visto que podemos estimar puntualmente la media de la altura de los alumnos de un centro mediante la media muestral de los 60 que hemos escogido. Ahora bien, no sabemos si ese valor es válido sin más o si cometemos un determinado error. Decimos que el valor de la media poblacional estará ”próximo” a la media muestral, pero ¿qué quiere decir próximo? ¿Puedo obtener dos valores entre los que esté la media poblacional ”casi seguro”? Si quiero tener un 90 o un 95 % de seguridad de que la media esté en una determinada región ¿puedo construir la región? En esta sección veremos lo que significa la ”estimación por intervalos”, que consiste en proporcionar un intervalo en el que encontraremos el parámetro poblacional que estemos estudiando con una determinada confianza. Salvo que se diga lo contrario, a partir de ahora supondremos que trabajamos con poblaciones normales. Vamos además a especificar la notación que se utilizará en esta sección: µ = media poblacional, σ = desviación tı́pica poblacional, N = tamaño de la población, n = tamaño de la muestra correspondiente, x = media muestral, p es laP proporción muestral (q = 1 − p), Pn n 2 (x − x) (xi − x)2 i S 2 = i=1 varianza muestral, Sc2 = i=1 cuasivarianza muestral. n n−1 Además: zα es el valor de una variable N (0, 1) que deja a su derecha un área (probabilidad) de valor α. tα (n − 1) es el valor de una variable t−Student con (n − 1) grados de libertad que deja a su derecha un área (probabilidad) de valor α. 5 χ2α (n − 1) es el valor de una variable chi-cuadrado con (n − 1) grados de libertad que deja a su derecha un área (probabilidad) de valor α. Fα (m, n) es el valor de una variable F de Snedecor con (m, n) grados de libertad que deja a su derecha un área (probabilidad) de valor α. Los valores de zα más comúnmente utilizados son Valores de α zα 0.0005 3.29 0.005 2.575 0.01 2.3263 0.02 2.05374 0.025 1.96 0.05 1.645 0.1 1.2815 Tratamos entonces a partir de ahora de encontrar un intervalo (a, b) de manera que el parámetro poblacional desconocido se encuentre en dicho intervalo con una determinada precisión o nivel de confianza. Para hallar dicho intervalo se utilizan los datos de una muestra, evidentemente estos datos cambiarán de una muestra a otra, por lo que el valor del intervalo también cambiará. El término grado de confianza (por ejemplo el 90 %) se refiere a que si consideramos un número elevado de muestras, y para cada una de ellas construimos el intervalo de confianza para un parámetro h desconocido de la población, tendremos que el parámetro poblacional h desconocido se encuentra al menos en el 95 % de los intervalos construidos. Este hecho es muy importante, de manera que cuando se construya un intervalo de confianza para una muestra determinada, no caigamos en la tentación de decir que el ”parámetro poblacional se encuentra dentro de dicho intervalo con probabilidad 0.95”puesto que ésta es una interpretación errónea. El intervalo es aleatorio antes de calcular el valor del estadı́stico para cada muestra; una vez calculado su valor para una muestra concreta, deja de ser aleatorio y puede que contenga el parámetro poblacional o no. Para hallar el intervalo de confianza de un parámetro poblacional θ, se partirá de un estimador θb (generalmente insesgado), y a partir de él se construirá el intervalo con una determinada amplitud λb, de manera que el intervalo será (θb − λb, θb + λb), con la condición de que la probabilidad de que el parámetro desconocido θ se encuentre en dicho intervalo sea 1 − α, es decir P [θb − λb ≤ θ ≤ θb + λb] = 1 − α. El término λb es el margen de error o precisión de la estimación del parámetro poblacional desconocido; recibe el nombre de error tı́pico de estimación o error estándar. Vamos a detallar los intervalos de confianza para un nivel de confianza 1 − α, según distintas situaciones y parámetros poblacionales para los que deseemos calcular dichos intervalos. Para el caso de una única población y muestreo aleatorio con reemplazamiento: Población Parámetro Intervalo σ σ x − z α2 √ , x + z α2 √ n n Sc Sc x − t α2 (n − 1) √ , x + t α2 (n − 1) √ n !n Pn Pn 2 2 (x − µ) (x − µ) i=1 i i=1 i , χ2α (n) χ21− α (n) 2 2 ! (n − 1)Sc2 (n − 1)Sc2 , χ2α (n − 1) χ21− α (n − 1) 2 2 ! r r p·q p·q p − z α2 , p + z α2 n n N (µ, σ), σ conocida µ N (µ, σ), σ desconocida µ N (µ, σ), µ conocida σ2 N (µ, σ), µ desconocida σ2 B(n, p), n > 30 p En caso de que el muestreor no sea con reemplazamiento o la población no sea infinita, en general se debe multiplicar N −n el error estándar por el factor . N −1 Como vemos, la estructura de los intervalos de confianza es (θb − λb, θb + λb) donde θb es un estimador del parámetro poblacional del que se desea calcular el intervalo, λ es un valor (punto crı́tico) de una distribución conocida y b depende del tamaño de la muestra n. normal con desviación tı́pica conocida, un intervalo de confianza para la media es: Por ejemplo, en una distribución σ σ x − z α2 √ , x + z α2 √ , donde λ serı́a igual a z α2 , un punto crı́tico de una N (0, 1) que deja a su derecha un área de n n b que es x. valor α/2, b serı́a √σn y el estimador de la media poblacional θ, 6 En el caso de dos poblaciones independientes (y muestreo aleatorio con reemplazamiento), tenemos: Población parámetro Intervalo s N (µ, σ), σ conocidas µx − µy N (µ, σ), σ desc. iguales µx − µy B(n, p), n > 30 px − py N (µ, σ), µ desconocidas σx2 σy2 σy2 σx2 (x − y) ± z α2 + nx ny s s 2 2 (nx − 1)Scx + (ny − 1)Scy 1 1 (x − y) ± t α2 (nx + ny − 2) + nx + ny − 2 nx ny s py q y px q x (px − py ) ± z α2 + nx ny 2 2 1 1 Scx Scx , 2 F α (n − 1, n − 1) S 2 F α Scy x y cy 1− 2 (nx − 1, ny − 1) 2 Para muestras suficientemente grandes se pueden considerar válidos los intervalos construidos aplicando las fórmulas anteriores. En caso de que sin que se verifiquen las condiciones anteriores sigamos queriendo obtener un intervalo de confianza para la media poblacional de una población cualquiera, siempre podemos aplicar el teorema de Tchebycheff: Sea X una variable aleatoria de media µ y desviación tı́pica σ. Se verifica que cualquiera que sea el valor de k > 0: P (|X − µ| ≥ kσ) ≤ k12 . En caso de que x sea la media muestral, se tendrı́a un intervalo para la media de la población, con desviación tı́pica conocida: σ σ x − k√ , x + k√ . n n Los pasos que seguiremos entonces para construir un intervalo de confianza serán los siguientes: 1. Establecer la población y la ley de distribución de dicha población. 2. Fijar dos de los siguientes datos: el nivel de confianza, el tamaño muestral deseado o el error de estimación. 3. Considerar el estimador adecuado para el parámetro poblacional del que se desea calcular el intervalo de confianza. Calcular el valor de dicho estimador. 4. Considerar el punto crı́tico de la distribución del estimador y aplicar la fórmula correspondiente a dicho intervalo de confianza. 1.4.1. Errores de estimación y tamaño de la muestra Hemos estado suponiendo hasta aquı́ que el tamaño de la muestra era conocido. Sin embargo, hemos de determinar el tamaño de la muestra teniendo en cuenta que cuanto mayor sea el tamaño de la muestra, menor será el error que cometeremos al inferir el valor de un determinado parámetro, puesto que estaremos más cerca de examinar a toda la población. Pero habitualmente los costes económicos, el tiempo del que disponemos y otros factores, no nos permiten aumentar el tamaño muestral tanto como desearı́amos. Por otro lado, un tamaño muestral muy pequeño puede no permitirnos obtener el nivel de confianza deseado. Podemos considerar que cuando se realiza una estimación del valor de un parámetro poblacional mediante un intervalo de confianza, cometemos un error tı́pico de estimación igual en valor absoluto a λb, que en general depende de n. Dicho error incorpora la desviación del estimador y el valor del punto crı́tico determinado por la distribución del estimador. Luego podemos: 1. Fijar el nivel de confianza y el error que deseamos tener, calculando el tamaño de muestra necesario. 2. Calcular el error que cometeremos con un tamaño de muestra dado y un nivel de confianza. 3. Dado el tamaño de muestra y el error que deseamos tener, calcular el nivel de confianza que tendremos. 7 1.5. Contrastes de hipótesis Todos tenemos ideas prefijadas sobre lo que creemos que puede ocurrir dentro de una población. Por ejemplo, a alguien se le puede ocurrir pensar que la media de la paga de los alumnos de su centro es superior a 5 euros. O que en general, la media de altura es inferior a 1.80. Pero podemos hacernos también preguntas concretas ¿crees que podemos considerar que un 10 % de los alumnos son zurdos? ¿Crees, en cambio, que es más correcto decir que menos de un 10 % lo son? Este tipo de preguntas pueden ser respondidas a través de un contraste de hipótesis paramétrico. Realmente, para comprobar si las preguntas anteriores son ciertas o falsas, tendrı́amos que observar todos y cada uno de los individuos de la población. Pero como es habitual, eso en principio no estará dentro de nuestras posibilidades, ası́ que intentaremos responder a esas preguntas a través de las observaciones que tengamos de nuestra muestra. Un contraste de hipótesis permite aceptar o rechazar si determinadas afirmaciones son ciertas o falsas en función de los datos observados en una muestra. Obviamente esto conlleva asumir que la conclusión a la que lleguemos podrı́a no ser verdadera, luego debemos intentar asegurar un cierto grado de precisión en el caso de que aceptemos la hipótesis que se proponga. Este grado de precisión es lo que se denomina nivel de confianza. Existen fundamentalmente dos tipos de contrastes de hipótesis: Los que establecen hipótesis sobre los parámetros de la distribución de probabilidad de la población. Por ejemplo, que la media de una población normal sea 7. Los llamaremos contrastes paramétricos. Los que establecen otro tipo de hipótesis. Por ejemplo, que una determinada población sigue una distribución normal o que no existe dependencia entre las variables altura y paga de los alumnos de un centro. Los llamaremos contrastes no paramétricos. Cuando hayamos realizado un test de hipótesis y se acepta la afirmación inicial, no quiere decir que hayamos probado en sentido matemático la afirmación, ya que no hemos examinado todos los elementos de la población e incluso esta afirmación podrı́a ser rechazada por los datos de otra muestra. Lo que tenemos que entender de alguna manera es que con los datos que tenemos no podemos rechazar la hipótesis que hemos propuesto. Vamos a ver a partir de ahora contrastes tanto paramétricos (sobre la media, la varianza y la proporción) como no paramétricos (homogeneidad o heterogeneidad de la población e independencia en tablas de contingencia). Necesitamos previamente algunos conceptos: Hipótesis nula: se simboliza por H0 e indica la afirmación sobre los parámetros poblacionales que se van a contrastar. Por ejemplo, H0 : µ0 = 5 en una población normal, es decir, querrı́amos contrastar si la media de una población normal es 5. Hipótesis alternativa: recoge el suceso complementario a H0 . Se denota por H1 . En el ejemplo anterior serı́a H1 : µ 6= 5, es decir, que la media sea diferente de 5. Estadı́stico de prueba: es una función de los datos muestrales que nos permitirá decidir si aceptamos o rechazamos H0 . Su distribución de probabilidad debe ser conocida bajo H0 . Región de aceptación: conjunto de valores (intervalo) para el estadı́stico muestral que hacen que aceptemos H0 con probabilidad 1 − α, supuesta cierta la hipótesis nula. Región de rechazo o crı́tica: conjunto de valores (intervalo) complementario al anterior, con probabilidad α. Nivel de confianza: representa la probabilidad que deseamos tener de aceptar H0 cuando es cierta. Se representa por 1 − α. Nos da la probabilidad de la región de aceptación bajo la hipótesis nula. Nivel de significación: representa la probabilidad de rechazar H0 cuando es cierta y es la complementaria del nivel de confianza, es decir α. Nos da la probabilidad de la región crı́tica bajo la hipótesis nula. Dentro de los contrastes de hipótesis paramétricos podemos diferenciar entre: Contrastes bilaterales: la hipótesis nula se presenta de manera que los valores de los parámetros poblacionales desconocidos quedan unı́vocamente determinados. Por ejemplo, que la media es igual a 5, o la varianza a 3. 8 Contrastes unilaterales: la hipótesis nula se presenta de tal manera que los valores del parámetro desconocido de la población se encuentran dentro de un intervalo semiabierto. Para conocer la distribución del estadı́stico muestral, se supondrá que el parámetro poblacional toma el valor de uno de los extremos del intervalo. Por ejemplo H0 : µ0 ≥ 3, es decir, la media es mayor o igual que 3, frente a la hipótesis alternativa de H1 : µ0 < 3. A la hora de determinar la distribución del estadı́stico se supondrá que el valor del parámetro bajo la hipótesis nula es µ = 3. Cuando llevamos a cabo el contraste de hipótesis nos basamos en los valores de un estadı́stico cuya función de probabilidad debe ser conocida bajo la hipótesis nula. Luego, los datos de la muestra nos pueden llevar a dos tipos de errores: Error de tipo I: error que se produce cuando rechazamos la hipótesis nula H0 siendo cierta. La probabilidad de dicha decisión es igual al nivel de significación α, es decir a la probabilidad de rechazar la hipótesis nula cuando es cierta. Error de tipo II: error que se produce cuando aceptamos la hipótesis nula siendo falsa, que serı́a lo mismo que rechazar H1 siendo verdadera. La probabilidad de rechazar la hipótesis alternativa cuando es cierta se representa por la letra β Potencia de un contraste: representa la probabilidad de rechazar H0 cuando H1 es verdadera. Podemos resumir las decisiones que se toman y los errores que se cometen en la siguiente tabla Decisión/Realidad Aceptar H0 Rechazar H0 H0 verdadera Decisión correcta (1 − α) Decisión incorrecta. Error tipo I (α) H1 verdadera Decisión incorrecta. Error tipo II (β) Decisión correcta. Potencia (1 − β) Las probabilidades de errores de tipo I y II son funciones complementarias entre sı́, en el sentido de que aumentando una disminuye la otra y viceversa, por lo que se tratará de minimizar el error que se considere más grave a costa de aumentar el otro. Una solución consiste en buscar el tamaño de muestra que hace compatibles los niveles de error de tipo I (α) y de tipo II (β), es decir, fijado unos, hallar el tamaño de muestra de manera que el otro se encuentre dentro de los lı́mites deseados. A la hora de elegir un estadı́stico para realizar un contraste, se elegirá aquél que tenga potencia máxima entre todos los que tienen un determinado nivel de confianza. Los pasos que es necesario seguir para realizar un contraste de hipótesis son: 1. Establecer la distribución de la población, la hipótesis nula H0 y la hipótesis alternativa H1 . 2. Fijar el nivel de confianza, 1 − α, y el tamaño de la muestra, n. 3. Seleccionar una muestra y calcular el valor del estadı́stico correspondiente, cuya distribución será conocida bajo H0 . 4. Determinar la región de aceptación y de rechazo o crı́tica. 5. Aceptamos H0 si el valor del estadı́stico se encuentra dentro de la región de aceptación. En otro caso, se rechaza H0 . 6. Conclusiones de tipo estadı́stico. En la siguiente tabla se reflejan los distintos estadı́sticos que se utilizarán, ası́ como las regiones crı́ticas según el tipo de contraste que se realice. Para el caso de una única población: 9 Población H0 µ = µ0 H1 µ 6= µ0 Estadı́stico N (µ, σ), σ conocida µ ≥ µ0 µ < µ0 T = µ ≤ µ0 µ = µ0 µ > µ0 µ 6= µ0 µ ≥ µ0 µ < µ0 µ ≤ µ0 σ = σ0 µ > µ0 σ 6= σ0 N (µ, σ), σ desconocida x − µ0 N (µ, σ), µ desconocida B(n, p) σ ≥ σ0 σ < σ0 σ ≤ σ0 σ = σ0 σ > σ0 σ 6= σ0 σ ≥ σ0 σ < σ0 σ ≤ σ0 p = p0 σ > σ0 p 6= p0 p ≥ p0 p < p0 p ≤ p0 p > p0 T < z1−α √σ n T > zα |T | ≥ t α2 (n − 1) x − µ0 T = T < t1−α (n − 1) Sc √ n T > tα (n − 1) |T | ≥ χ2α (n) Pn N (µ, σ), µ conocida Región crı́tica |T | ≥ z α2 T = i=1 (xi σ02 2 − µ)2 T < χ21−α (n) T > χ2α (n) |T | ≥ χ2α (n − 1) 2 (n − 1)Sc2 T = σ02 T < χ21−α (n − 1) χ2α (n − 1) T > |T | ≥ z α2 p − p0 T =q T < z1−α p0 (1−p0 ) n T > zα Para el caso de dos poblaciones, tenemos: Poblaciones H0 µx − µy = a H1 µx − µy 6= a N (µ, σ) µx − µy ≥ a µx − µy < a σ conocidas µx − µy ≤ a µx − µy = a µx − µy ≥ a µx − µy > a µx − µy 6= a µx − µy < a N (µ, σ) σ desc iguales N (µ, σ) µx − µy ≤ a σx2 = σy2 σx2 ≥ σy2 Estadı́stico Región crı́tica |T | ≥ z α2 x−y−a T =q 2 σy2 σx nx + n y T = r x−y−a 2 +(ny −1)S 2 (nx −1)Scx cy nx +ny −2 T < z1−α q T > zα |T | ≥ t α2 (nx + ny − 2) T < t1−α (nx + ny − 2) 1 nx µx − µy > a σx2 6= σy2 σx2 < σy2 µ conocidas σx2 ≤ σy2 σx2 = σy2 σx2 > σy2 σx2 6= σy2 N (µ, σ) σx2 ≥ σy2 σx2 < σy2 Pnx (xi − µx )2 T = Pi=1 ny 2 i=1 (yi − µy ) T = 2 Scx 2 Scy + n1y T > tα (nx + ny − 2) T > nnxy F α2 (nx , ny ) ó T < nx α ny F1− 2 (nx , ny ) T < nx ny F1−α (nx , ny ) T > nnxy Fα (nx , ny ) T > F α2 (nx − 1, ny − 1) ó T < F1− α2 (nx −1, ny −1) T < F1−α (nx − 1, ny − 1) µ desc σx2 ≤ σy2 σx2 > σy2 T > Fα (nx − 1, ny − 1) Recordemos que en caso de buscar valores de tα (n−1) con valores de n mayores que 30, dicha distribución se aproxima por la N (0, 1), por lo que se buscarán los valores de zα . 1.5.1. Relación entre los intervalos de confianza y los contrastes de hipótesis Cuando se realiza un contraste de hipótesis bilateral y se rechaza la hipótesis nula, no sabemos qué valor del parámetro estamos considerando, únicamente sabemos qué valor no es, con un determinado nivel de confianza. A veces en vez de realizar un contraste de hipótesis podemos construir el intervalo de confianza para dicho parámetro y con ello podemos rechazar todas aquellas hipótesis nulas de la forma H0 : parámetro = k0 siempre que el valor no se 10 encuentre dentro del intervalo de confianza construido. En el caso de hipótesis unilaterales: H0 : parámetro ≤ k0 frente a H1 : parámetro > k0 a un nivel de significación α, se construye un intervalo de confianza para el parámetro poblacional desconocido a un nivel de confianza 1 − 2α. Si el valor k0 es mayor que el extremo superior de dicho intervalo, debemos rechazar la hipótesis H0 . En general, se rechazará cualquier hipótesis nula de la forma H0 : parámetro=un valor mayor que el extremo superior del intervalo de confianza. H0 : parámetro ≥ k0 frente a H1 : parámetro < k0 a un nivel de significación α, se construye un intervalo de confianza para el parámetro poblacional desconocido a un nivel de confianza 1 − 2α. Si el valor k0 es menor que el extremo inferior de dicho intervalo, debemos rechazar la hipótesis H0 . En general, se rechazará cualquier hipótesis nula de la forma H0 : parámetro=un valor menor que el extremo inferior del intervalo de confianza. Pasamos ahora a ver los contrastes de hipótesis no paramétricos. Los contrastes que veremos están basados en aplicaciones de la distribución χ2 . Veremos contrastes sobre el ajuste de la distribución teórica a una distribución empı́rica, ası́ como la aplicación a tablas de contingencia. 1.5.2. Test de la bondad de ajuste Consideremos una población y el carácter X que presenta las siguientes modalidades x1 , x2 , . . . , xk excluyentes entre sı́, con sus correspondientes probabilidades p1 , p2 , . . . , pk . Tenemos una muestra de tamaño n en la que observamos el carácter X y nos planteamos hasta qué punto esta muestra se puede considerar como perteneciente a una población de distribución teórica ya conocida. Independientemente de la distribución teórica que consideremos siempre existirán diferencias entre los valores teóricos esperados y los valores observados. El problema está en saber en qué medida dichos valores son debidos al azar o a que los datos no se ajustan a la distribución teórica considerada. Si denotamos por: Oi = número de elementos de la muestra con el carácter xi . Pk pi = probabilidad teórica de que la variable aleatoria tome el valor xi , verificándose que i=1 pi = 1. Si tenemos una de tamaño n, el número de elementos que cabe esperar que tomen el valor xi es ei = npi , Pmuestra k verificándose que i=1 npi = n. Podemos formar la siguiente tabla: Variable X Frecuencias observadas Frecuencias esperadas x1 O1 e1 x2 O2 e2 ... ... ... xk Ok ek Consideraremos como hipótesis nula y alternativa a H0 : la distribución empı́rica se ajusta a la distribución teórica considerada. H1 : se rechaza el ajuste. Evidentemente, si aceptamos la hipótesis nula (aceptamos el ajuste), las diferencias entre los valores observados y los valores esperados son debidas al azar y podemos decir que no existen evidencias para rechazar dicha hipótesis; en otro caso, diremos que existen diferencias significativas para el nivel de significación marcado entre ambas distribuciones, no pudiendo atribuirse las diferencias entre las distribuciones empı́ricas y observadas al azar. El estadı́stico que se utilizará para dicho contraste será: T = k X (Oi − ei )2 i=1 ei = k X O2 i i=1 ei − n. Pearson demostró que la distribución de dicho estadı́stico es una χ2 con k − 1 grados de libertad en el caso de no existir discrepancias entre los valores observados y los esperados. Se acepta H0 si T < χ2α (k − 1) REGIÓN DE ACEPTACIÓN. Se rechaza H0 si T ≥ χ2α (k − 1) REGIÓN DE RECHAZO. A la hora de aplicarlo correctamente, tenemos que realizar las siguientes consideraciones: 11 1. Las frecuencias esperadas de las distintas modalidades deben ser superiores a cinco; en caso de no ocurrir se deben agrupar clases contiguas en una sola clase hasta lograr que la nueva frecuencia sea mayor que cinco. Esto supone cambiar la distribución teórica con la consiguiente pérdida de información. 2. Si para obtener las frecuencias esperadas se necesitan estimar p parámetros, entonces los grados de libertad de la χ2 son k − p si son independientes y k − p − 1 si son independientes las modalidades. 3. Se puede aplicar tanto a distribuciones continuas como a las discretas. 1.5.3. Contrastes de dependencia o independencia de caracteres Deseamos saber si dos caracteres X e Y de una población son dependientes o independientes. Suponemos que las modalidades que presentan cada una de las variables X e Y son X : x1 , x2 , . . . , xk , Y : y1 , y 2 , . . . , ym . y se ha tomado una muestra de tamaño n, midiéndose dichas caracterı́sticas X e Y en cada uno de los elementos de la muestra. Si denotamos por: Oij = número de elementos que presentan caracterı́sticas xi e yj . eij = número de elementos esperados que presentan los valores xi e yj si las variables son independientes. Podrı́amos formar la siguiente tabla de contingencia en la que aparecen las frecuencias empı́ricas y teóricas X/Y x1 ... xi ... xk Frecuencias absolutas Y y1 O11 |e11 ... Oi1 |ei1 ... Ok1 |ek1 Oy1 ... ... ... ... ... ... ... yj O1j |e1j ... Oij |eij ... Okj |ekj Oyj ... ... ... ... ... ... ... ym O1m |e1m ... Oim |eim ... Okm |ekm Oym Frecuencias absolutas X Ox1 ... Oxi ... Oxk n Para el cálculo de las frecuencias teóricas podemos utilizar la siguiente fórmula si las variables son independientes: eij = pij n = Oxi Oyj (total de la fila i) · (total de la columna j) n= , n n n i = 1, 2, . . . , k j = 1, 2, . . . , m. Consideraremos como hipótesis nula e hipótesis alternativa a: H0 : X e Y son independientes. H1 : X e Y no son independientes. Si aceptamos la hipótesis nula, podemos considerar que no tenemos evidencias que nos hagan suponer una dependencia entre las dos variables a un nivel de confianza de 1-α. Consideramos como estadı́stico del contraste: T = k X m k X m 2 X X Oij (Oij − eij )2 = − n. eij e i=1 j=1 ij i=1 j=1 La distribución de dicho estadı́stico es una χ2 con (k − 1)(m − 1) grados de libertad en caso de que las variables sean independientes a un nivel de confianza 1 − α Se acepta H0 si T < χ2α (k − 1)(m − 1) REGIÓN DE ACEPTACIÓN. Se rechaza H0 si T ≥ χ2α (k − 1)(m − 1) REGIÓN DE RECHAZO. 12 1.5.4. Test de homogeneidad de varias muestras Se trata de determinar si varias muestras que estudian el mismo carácter A han sido tomadas o no de la misma población, respecto de dicha caracterı́stica A. Supongamos que tenemos k muestras de tamaños n1 , n2 , . . . , nk siendo y1 , y2 , . . . , yk los elementos de cada muestra que presentan una determinada caracterı́stica A y el resto no la presentan. Si suponemos que todas las muestras provienen de la misma población, la proporción de elementos que presentan la caracterı́stica A serı́a: p= y 1 + y2 + · · · + yk . n1 + n2 + · · · + nk Si suponemos que las muestras provienen de la misma población, los valores esperados para la caracterı́stica A en cada muestra serı́an n1 p, n2 p, n3 p, . . . , nk p. Podrı́amos formar la siguiente tabla de contingencia en la que aparecen los valores observados y los valores esperados: Muestras Primera muestra ... i-ésima muestra ... k−ésima muestra Presentan el carácter A Se esperan con el carácter A y1 n1 p ... yi ni p ... yk nk p No presentan el carácter A Se esperan sin el carácter A n1 − y1 n1 (1 − p) ... ni − yi ni (1 − p) ... nk − yk nk (1 − p) Tamaño de las muestras n1 ... ni ... nk Consideramos como hipótesis nula e hipótesis alternativa a: H0 : todas las muestras provienen de la misma población. H1 : se rechaza que provengan de la misma población. Si aceptamos la hipótesis nula, podemos considerar que las muestras provienen de la misma población y las diferencias entre los valores observados y los valores esperados son debidas al azar. El estadı́stico que se utilizará será: k T = X (yi − ni p)2 1 . p(1 − p) i=1 ni La distribución de dicho estadı́stico es una χ2 con k − 1 grados de libertad en el caso de no existir discrepancias entre los valores observados y los esperados a un nivel de confianza 1 − α. Se acepta H0 si T < χ2α (k − 1) REGIÓN DE ACEPTACIÓN. Se rechaza H0 si T ≥ χ2α (k − 1) REGIÓN DE RECHAZO. En el caso de que los elementos de las muestras se clasifiquen en más de dos categorı́as, el análisis se realiza como en el caso de un test de independencia o dependencia entre variables, donde la tabla que se obtendrı́a serı́a similar a la anterior, por filas aparecen las muestras y por columnas las distintas categorı́as. El estadı́stico serı́a el mismo que en el caso de independencia de variables y los valores esperados se calcuları́an de igual forma y la hipótesis nula será H0 : todas las distribuciones se distribuyen homogéneamente. A la hora de analizar un población se ha de tener en cuenta si la población puede ser subdividida en subpoblaciones que sigan manteniendo la heterogeneidad de la población de partida, de lo contrario podemos llegar a resultados totalmente erróneos. Consideremos, por ejemplo, los siguientes datos que recogen el número de alumnos y alumnas en un municipio admitidos en los cursos de formación empresarial Hombres Mujeres No de solicitudes 1000 1000 No de admitidos 470 570 13 Proporción admitidos 0.47 0.57 Si suponemos que la población es homogénea llegarı́amos a la conclusión de que existe una diferencia significativa entre hombres y mujeres, a favor de las mujeres, a la hora de ser admitidas en los cursos de formación. Ahora bien, si los datos se analizan por separado según el curso de formación empresarial A, B y C, se tiene: Curso A Curso B Curso C Hombres Mujeres Hombres Mujeres Hombres Mujeres No de solicitudes 150 400 350 50 500 550 No de admitidos 112 280 70 8 288 282 Proporción admitidos ( %) 74.66666 70 70 20 57.6 51.272727 Como se observa, la discriminación es favorable al hombre en todos los cursos. Por tanto, las conclusiones serán distintas si se agrupan los datos. Este fenómeno se conoce como paradoja de Simpson. 1.6. Inferencia bayesiana Al principio del capı́tulo hemos visto que existe otro enfoque para la inferencia que considera que tenemos unas probabilidades a priori a partir de las cuales se calculan unas probabilidades a posteriori. Es lo que se conoce como inferencia bayesiana. Vamos a hacer un breve resumen sobre los fundamentos de estos métodos. El método de inferencia bayesiano se basa en el teorema de Bayes, en el cual, a partir de unas probabilidades a priori y verosimilitudes, se calculan unas probabilidades a posteriori; supone que el parámetro poblacional no es una constante desconocida, sino que es una variable aleatoria con distribución conocida. El procedimiento de estimación toma de partida los conocimientos a priori y verosimilitudes derivados de observaciones anteriores, de manera que al tomar una nueva muestra se estiman de nuevo los parámetros, actualizando los valores anteriores con los nuevos. El método clásico y el bayesiano no difieren demasiado si el tamaño de la muestra es suficientemente grande o la información de la que se dispone a priori es prácticamente nula, es más, llegan a idénticas conclusiones; en cambio, para tamaños de muestra pequeños pueden llegar a conclusiones totalmente dispares. En general, los métodos bayesianos son más complicados que los clásicos, aunque más satisfactorios en muchos casos. Se obtienen intervalos más pequeños, valores estimados de puntos más confiables y pruebas de hipótesis más apropiadas. Por ejemplo, dada una población N (µ0 , σ0 ) si tomamos una muestra de tamaño n y hallamos la media muestral, los parámetros de la población se actualizan con los nuevos valores calculados por la siguiente expresión: s 1 µ + σn2 x 1 σ02 0 x . N (µ1 , σ1 ) = N 1 , n 1 n + + 2 2 2 2 σ σ σ σ 0 x 0 x En general, la media posterior es una combinación entre la media a priori y la media a posteriori de la muestra: µ1 = Kµ0 + (1 − K)x. De igual forma podemos aplicar la inferencia bayesiana al cálculo de intervalos de confianza y los contrastes paramétricos incorporando la información obtenida de la muestra a la fórmula final. Por ejemplo, el intervalo de confianza para la media de una población normal con desviación tı́pica conocida serı́a (µ1 − zα/2 σ1 , µ1 + zα/2 σ1 ) donde µ1 y σ1 son los valores calculados anteriormente. 14 Capı́tulo 2 Un ejemplo de aplicación de la inferencia 2.1. Para una población Hemos obtenido una muestra aleatoria de tamaño 25 de nuestra población, un centro con 558 alumnos. Tenemos que realizar un estudio que pretende tres objetivos: 1. Una de las cosas que pretendemos realizar es hacer camisetas del centro y venderlas para ganar dinero para el viaje de fin de curso. Aprovecharemos nuestros datos para hallar un intervalo de confianza para la media de la paga de los alumnos del centro, que nos oriente sobre cuánto podemos pedir por la camiseta a los compañeros del centro. 2. Los últimos estudios hablan de que los jóvenes dedican la mayorı́a de su tiempo a conectarse a internet y ver la televisión. ¿podemos decir que los alumnos de nuestro centro dedican más de una hora diaria a conectarse a internet? 3. Queremos ver si para nuestra población es cierto el dato, que se suele manejar, de que aproximadamente hay un 10 % de zurdos. Tenemos pues los datos de 25 individuos sobre las variables ya mencionadas y son los siguientes: 15 Observación 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 Paga 0 12 12 5 8 8 0 40 21 0 9 4.5 20 0 15 0 0 0 12 9.4 10 2 5 3.5 10 Internet 0 10 10 90 90 0 30 60 0 60 45 15 0 30 60 30 0 0 30 60 60 120 90 150 60 Zurdos 0 0 0 0 0 1 0 0 1 0 0 0 0 0 0 0 0 0 1 0 1 1 0 0 0 Vamos a ir resolviendo lo que nos hemos propuesto. Comenzamos por el primer objetivo: 1. Intervalo de confianza para la media de la paga Comenzamos por buscar los lı́mites entre los que se encontrará la media de la paga. Debemos fijar un nivel de confianza o un error. Vamos a fijar un nivel de confianza del 90 %. ¿Cuál es la situación en la que nos encontramos? Suponemos que la población en la que nos encontramos es normal. ¿Conocemos σ? La respuesta es que no. Entonces estamos en el caso de una población normal con σ desconocida. Recordamos que el intervalo de confianza para la media en esta situación era: Sc Sc , x − t α2 (n − 1) √ , x + t α2 (n − 1) √ n n para el caso del q muestreo con reemplazamiento. Como hemos hecho muestreo sin reemplazamiento, aplicaremos el −n factor de corrección N N −1 , de donde nos queda: ! r r Sc N − n Sc N − n , x + t α2 (n − 1) √ . x − t α2 (n − 1) √ n N −1 n N −1 Luego los datos que necesitamos son los siguientes: x = 8,256, Sc = 8,895, t α2 (n − 1) = t0,05 (24) = 1,711, y el intervalo queda 8,895 8,256 − 1,711 √ 25 r 558 − 25 8,895 , 8,256 + 1,711 √ 558 − 1 25 r 558 − 25 558 − 1 ! = (5,2785, 11,2335). Entonces nos sale que unos lı́mites apropiados serı́an entre 5.27 euros y 11.23 euros para las camisetas. 2. Tiempo que dedican los jóvenes a internet Nos preguntamos ahora si podemos decir que los alumnos de este centro pasan de media, más de una hora al dı́a conectados a internet. ¿Qué técnica podemos usar para obtener respuesta a nuestra pregunta? Utilizaremos un contraste 16 de hipótesis unilateral, en el que intentaremos probar si la media de nuestra variable es mayor o igual que una hora (60 minutos). ¿Cuál es nuestra situación ahora? Volvemos a suponer que nos encontramos en una población normal, y de nuevo, σ es desconocida. Elegimos un nivel de confianza, digamos el 95 %. El contraste que queremos realizar tiene la siguientes hipótesis nula y alternativa H0 : la media de tiempo diario en internet es igual o superior a 60 minutos. H1 : la media de tiempo diario en internet es inferior a 60 minutos. Nuestro estadı́stico de contraste, dado que nos encontramos en el caso σ desconocida, es: T = x − µ0 Sc √ n , y si tenemos que x = 44, tα (n − 1) = t0,05 (24) = 1,711, Sc = 40,224, nuestro estadı́stico vale: T = 44 − 60 40,224 5 = −1,9888. La región crı́tica para este contraste es T < t1−α (24) = −1,711. Luego nuestro valor se encuentra en la región crı́tica, lo que quiere decir que debemos rechazar la hipótesis nula. No podemos decir que los alumnos del centro dediquen más de una hora al dı́a a conectarse a internet. 3. Proporción de zurdos en la población Tratemos ahora de ver si podrı́amos decir que en nuestra población hay un 10 % de zurdos. De nuevo responderemos a esta pregunta a través de un contraste de hipótesis. Como en este caso manejamos una variable que sólo toma los valores 0 ó 1, no nos encontramos en el caso de una población normal, sino que estamos intentando realizar estimaciones sobre el parámetro p de una binomial. La hipótesis nula y alternativa para este caso serı́an: H0 : La proporción de zurdos es igual a 0.1. H1 : La proporción de zurdos no es igual a 0.1. Realizaremos el contraste con un nivel de confianza del 95 %. Recordamos que nuestro estadı́stico de contraste es: p − p0 T =q , p0 (1−p0 ) n donde p = 0,2, p0 = 0,1, n = 25. Luego el valor de nuestro estadı́stico es: 0,2 − 0,1 T =q = 1, b 6. 0,1(1−0,1) 25 La región crı́tica para este contraste viene dada por la expresión |T | ≥ z α2 = z0,025 = 1,96, luego no podemos rechazar la hipótesis de que en nuestro centro haya un 10 % de zurdos. 17 2.2. Para dos poblaciones Dos alumnos del centro han obtenido una muestra cada uno de su correspondiente nivel, 1o de Bachillerato y 4o de ESO. Han medido, entre otras cosas, la altura, y a la vista de los resultados, el alumno de 4o opina que en media, los chicos de 4o son más altos, porque su media muestral es mayor. El de 1o no está de acuerdo, cree que lo que ocurre es que hay más variabilidad en la población de 1o y por eso la muestra de los chicos de primero ha dado una media menor. ¿Podemos resolverles la duda? Ellos nos facilitan sus datos, que son Para 1o de bachillerato tenemos: 187 161 169 168 170 165 173 160 175 158 175 164 158 161 158 171 175 170 185 158 163 160 169 158 155 168, mientras que los datos para 4o de ESO son: 170 174 164 171 177 163 170 165 160 175 178 174 162 164 170 155 183 176 158 160 160 173 171 152 170, Lo que vamos a hacer para resolver la duda que se nos plantea son dos contrastes de hipótesis. En uno plantearemos si es cierta la hipótesis del chico de 4o que dice que en media los de 1o son más bajos, y luego plantearemos que pueda ocurrir que la varianza de la variable altura de los de 1o de bachillerato es mayor que la de los de 4o de ESO. Haremos todos los contrastes con un nivel de confianza del 95 %. Vamos a comenzar por el segundo contraste, veamos si podemos decir que hay una varianza mayor que otra. Nuestras hipótesis nula y alternativa son: H0 : La varianza de la altura de los alumnos de 1o de bachillerato (σx2 ) es mayor o igual que la de los alumnos de 4o de ESO (σy2 ). H1 : La varianza de la altura de los alumnos de 1o de bachillerato (σx2 ) es menor que la de los alumnos de 4o de ESO 2 (σy ). Estamos en el caso de dos poblaciones normales con media desconocida, luego nuestro estadı́stico será T = 2 Scx . 2 Scy Y como tenemos 2 Scx = 66,982, 2 Scy = 58,72, entonces T = 1,14, tenemos la región crı́tica T < F1−α (nx − 1, ny − 1) = 0,50909, luego no podemos rechazar que sea mayor o igual. Pero el chico de primero quiere saber si es mayor, no igual. Si vemos la región crı́tica para el contraste bilateral (σx2 = σy2 ) T < F1− α2 (nx − 1, ny − 1) = 0,44599 ó T > F α2 (nx − 1, ny − 1) = 2,2574, llegamos a la conclusión de que tampoco podemos rechazar la hipótesis de que sean iguales, luego no podemos asegurar el hecho de que la varianza sea estrictamente mayor. Hagamos ahora el contraste para la media. Supondremos σ desconocida pero igual en ambos casos (el contraste anterior dice que no podrı́amos rechazar esa hipótesis). Las hipótesis nula y alternativa en este caso son: H0 :La media de los de 1o (µx ) es menor o igual que la de los de 4o (µy ) µx − µy ≤ 0. H1 :La media de los de 1o (µx ) es mayor que la de los de 4o (µy ) µx − µy > 0. Para nuestro caso, el estadı́stico de contraste es: T =q x−y−a 2 +(n −1)S 2 (nx −1)Scx y cy nx +ny −2 q , 1 nx + y tenemos, que además de los datos de antes, es x = 166,692, y = 167,8. 18 1 ny Si sustituimos T =q 166,692 − 167,8 − 0 q (26−1)66,982+(25−1)58,72 26+25−2 = −1,69957. 1 26 + 1 25 La región crı́tica es T > tα (nx + ny − 2) = 1,6766, luego no podemos rechazar la hipótesis. Pero, la realidad es que si nos fijamos en el contraste bilateral (µx − µy = 0) y en su región crı́tica |T | ≥ t α2 (nx + ny − 2) = 2,0096, tampoco podrı́amos rechazar la hipótesis nula, luego tampoco podemos decir que sean más bajos los de 1o de Bachillerato. Nuestra conclusión es que no llevan razón, en principio, ninguno de los dos. Las diferencias entre las medias y las varianzas de las dos poblaciones no son significativas. 19