Documento de apoyo

Anuncio

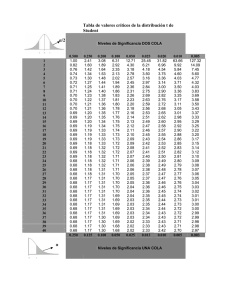

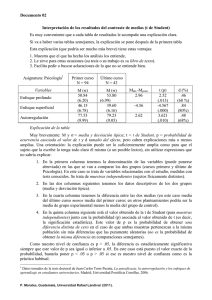

PRÁCTICA 2 DE PSICOLOGÍA DE LA MEMORIA: Cuál es su diseño y cómo analizarlo, informarlo e interpretarlo Marcos Ruiz UNED: CENTRO ASOCIADO DE MADRID (Jacinto Verdaguer) [email protected] Fecha de creación: 2015-11-16 Fecha de la última modificación: 2016-05-21 Versión 5 RESUMEN Este documento asume que el alumno ya ha obtenido los datos para cumplimentar la Tabla 2.3 del formulario PEC de la práctica (también en el Cuaderno de Prácticas). Se caracteriza aquí el tipo de diseño experimental al que nos enfrentamos, así como la prueba estadística que necesitamos. Se hace referencia a una página de internet en la que bastará con introducir los datos, para que la página nos haga los cálculos del análisis estadístico. Luego se describe cómo se deben informar los resultados estadísticos y se da un ejemplo de ello. Y, finalmente, se hacen algunas sugerencias sobre cuáles son los razonamientos admisibles al interpretar los resultados estadísticos. En la Versión 4 se añadió un Apéndice B sobre la posibilidad de considerar el diseño de la práctica como un diseño factorial, donde se trata qué consecuencias se derivan de ello en cuanto a la selección del análisis estadístico requerido. En la Versión 5 se ha añadido un Apéndice C sobre el tamaño del efecto. ¿Cómo es el diseño experimental de la Práctica 2? Propiamente hablando, el procedimiento de la práctica es se ajusta a un diseño experimental de dos grupos aleatorios e independientes, en el que la forma de presentación de las listas en la fase de adquisición es la variable independiente (es decir, lo que manipula el experimentador): Lista organizada (o bloqueada) en adquisición vs. lista aleatoria, con un grupo para cada tipo de lista. Por su parte, el priming de cada sujeto (ver Tabla 2.3) es la variable dependiente (lo que mide el experimentador): cada sujeto aporta un valor. Hay que notar que se trata de una puntuación diferencial: La diferencia entre proporción de ejemplares aportados por el sujeto de la lista presentada en adquisición menos la proporción de los aportados de la lista no presentada en adquisición 1. Tabulación de los datos para el análisis de la Práctica 2 Si seguimos las instrucciones de la práctica sobre la tabulación de datos, en las celdas de la Tabla 2.3 tendremos las puntuaciones diferenciales (priming) de las proporciones de palabras aportadas por cada individuo de una y de otra lista. Las proporciones directas correspondientes a cada tipo de lista son necesarias para calcular estas puntuaciones diferenciales, pero no entran en el análisis. ¿ Qué contraste de medias nos piden para el análisis estadístico ? To the extent that the category-production test involves conceptually driven processing, it should be improved by conditions that encourage organization. Therefore, we expected parallel effects of organization on category production and free and cued recall. En la Tabla 2.4 debemos poner las medias de cada grupo en proporciones de palabras aportadas de cada lista y sus diferencias correspondientes. Nótese que la diferencia entre las dos medias de un grupo debe coincidir con la media de priming de sus miembros, calculada a partir de los datos que figuran en la Tabla 2.3. Nuestra situación ahora es la siguiente: tenemos dos grupos, cada uno de los cuales nos da una media (promedio) de priming. ¿Qué tipo de contraste debemos hacer para comparar estas dos medias? El tipo de contraste no viene determinado por el capricho de una persona, sino por las razones que lo justifican. El problema se plantea como una elección entre dos posibilidades (contraste de una o de dos colas) y hay que elegir una de ellas. Lo correcto es siempre elegir aquella que esté justificada; en este caso, como son excluyentes, si elegimos una, descartamos la otra. ¿Cuál de las dos está justificada? Es sencilla la respuesta a esta pregunta: aquella que se desprenda de la forma de plantear la hipótesis en la PEC: • • Si se plantea la hipótesis como una búsqueda de diferencia entre los dos grupos, sin especificar el sentido de la diferencia, entonces el contraste debe ser de dos colas (bilateral). Si se plantea la hipótesis como una búsqueda de la superioridad (más priming) del grupo de lista organizada, es decir, especificando en su formulación el sentido de la diferencia, entonces el contraste ha de ser necesariamente unilateral (de una cola). Visto así, el problema se traslada ahora a cómo planteamos la hipótesis, porque esto determinará el contraste aplicable. Es decir, lo que tenemos que decidir no es el tipo de contraste, sino el tipo de hipótesis. Comencemos por el hecho cierto de que hacemos un experimento que pretende encontrar diferencia entre los dos tratamientos. Al hacerlo hay que plantearse preguntas como estas: 1. ¿Tengo (a) razones teóricas y/o (b) datos obtenidos por otros investigadores que me permitan esperar que haya menos priming en el grupo de lista organizada? 2. ¿Tengo (a) razones teóricas y/o (b) datos obtenidos por otros investigadores que me permitan esperar que haya más priming en el grupo de lista organizada? Si la respuesta es afirmativa para ambas preguntas, entonces el contraste es bilateral (dos colas). Si no es afirmativa para ambas preguntas, entonces es unilateral (una cola). Veamos qué razones podemos encontrar nosotros para responder estas preguntas. 1 Es posible a lo largo de toda la práctica hablar de proporciones o porcentajes, puesto que son conceptos análogos (porcentaje es la proporción normalizada a 100). Pero es exigible ser consistente a lo largo de todo el informe: hacer referencia siempre a proporciones o siempre a porcentajes. Esto vale también para los datos que se introducen para el análisis estadístico. La pregunta que se plantea en el libro de prácticas es “... cuál de las dos condiciones de organización del material a la hora de su presentación en la fase de adquisición produjo el mejor resultado” (Ballesteros, 2010b, pág. 83). Por tanto, nos pide comparar la media de un grupo (lista organizada) y la media del otro (lista aleatoria). En cierto modo la pregunta está mal planteada y esto es importante en nuestro diseño. ¿Veamos por qué? Razones basadas en supuestos teóricos Leemos en el cuaderno de prácticas que, desde la hipótesis del procesamiento apropiado para la transferencia, “... alguna prueba de memoria implícita puede estar dirigida conceptualmente...” (Ballesteros, 2010b, pág. 70). Y sabemos que la organización conceptual favorece el rendimiento en las pruebas dirigidas conceptualmente (Ballesteros, 2010a, caps. 4 y 5). Por tanto, tenemos razones teóricas para esperar que el grupo de listas organizadas tenga más priming. Es decir, tenemos razones teóricas para plantear nuestra hipótesis especificando un sentido para la diferencia esperada, como así lo hicieron Rappold y Hashtroudi (1991)2 Razones basadas en hechos empíricos (razones basadas en datos) En las páginas de presentación de la práctica del cuaderno de prácticas leemos que Rappold y Hashtroudi (1991) “... comprobaron que, en participantes sanos y normales, la organización categórica del material en la fase de adquisición influyó favorablemente … en la recuperación implícita … de la información.” (Ballesteros, 2010, pág. 70). Pues bien, como nuestra práctica es una replicación de parte del Experimento 1 de Rappold y Hashtroudi (1991), nosotros nos debemos formular la pregunta en términos de “si la organización influye favorablemente” en la recuperación implícita. Es decir, nuestra pregunta no debe ser “cuál de las dos condiciones de organización” es mejor, sino “¿es la condición de lista organizada superior a la de lista aleatoria en nuestra tarea de recuperación implícita?”. En otras palabras, es un planteamiento de la hipótesis en el que se marca claramente el sentido de la diferencia que esperamos. El resumen de estas razones, es que no parece que haya justificación alguna para esperar menos priming en el grupo de lista organizada. Con ello la primera de nuestras preguntas ha de recibir una respuesta negativa. En el epígrafe que sigue veremos cómo se aplica la prueba estadística que nos piden. Pero no olvide que La diferencia entre una forma de plantear la hipótesis (bidireccional) y otra (monodireccional) es clave para el tipo de prueba estadística. La primera pregunta exige una prueba de dos colas y la segunda de una sola cola. ¿Qué prueba estadística debemos aplicar? Como en esta práctica comparamos dos medias (priming del grupo de lista organizada vs. grupo de lista aleatoria), nos piden que apliquemos una prueba t de student. Ahora bien, para elegir el tipo de t de student debemos tener en cuenta dos propiedades de la prueba t: • debemos tener en cuenta si se trata de medias independientes entre sí o relacionadas • debemos tener en cuenta si nuestras muestras tienen varianzas iguales o desiguales • y debemos tener en cuenta si nuestra hipótesis es direccional (una cola) o no (dos colas) Observamos que son dos grupos o muestras independientes (independent samples en Inglés) las que se comparan; es decir, se trata aquí de dos medias independientes. En segundo lugar, debemos mirar si Vassarstat (ver más abajo) nos dice si son varianzas iguales o desiguales y actuar en consecuencia. Por otro lado, a partir de lo dicho en el epígrafe anterior sobre el tipo de pregunta, nuestra predicción es direccional: se espera mejor rendimiento en la prueba implícita del grupo que tuvo lista organizada en adquisición. Por tanto, nuestra prueba debe ser de una sola cola. En resumen, para este diseño -para responder a su pregunta- necesesitamos una prueba t de student de una cola (direccional) para medias independientes. Aunque es posible analizar los datos a partir de las proporciones directas en una y otra lista, en lugar de su diferencia (priming), si nos ajustamos a las instrucciones que nos dan en el Cuaderno de Prácticas , nos 2 En su artículo podemos leer: “To the extent that the category-production test involves conceptually driven processing, it should be improved by conditions that encourage organization...” [trad.: En la medida en que la prueba de producción categórica implique procesamiento guiado por los conceptos, debería verse favorecida por cualquier circunstancia que fomente la organización.] (Rappold y Hashtroudi, 1991, pág. 104). debemos limitar a hacer una t de student sobre las diferencias en priming. No obstante, para aquellos interesados, en el Apéndice B he añadido un resumen del planteamiento que habría que hacer para un ANOVA. Herramienta en línea para calcular la t de student Aunque entre los materiales de la asignatura se recomienda el uso de Calc o Excel para hacer los cálculos estadísticos, dada la popularidad y sencillez de la t de student, hay calculadoras en internet que nos permiten calcularla en línea. La que yo recomiendo está en esta página: http://vassarstats.net/tu.html. Algunas observaciones a tener en cuenta en relación con esta página: • Creo que el navegador debe configurarse con permiso para ejecutar javascript. • Se debe introducir los decimales con punto decimal (no con coma decimal). • La página tiene traducción en Español, pero sólo (me) funciona en Inglés a día de hoy. Es decir, los botones no funcionan en Español. Así que se recomienda leer la página en Español, pero actuar sobre la página en Inglés. • Es muy importante asegurarnos de que no pulsamos [Return] 3 al introducir el último dato de cada columna, porque esto añade un 0 (cero) a la fila siguiente, falseando la media al incluir en ella un dato fantasma. Después de calcular el estadístico compruebe que el n que le da la página al pie de cada columna coincide con el número de datos introducido en esa columna. En el Apéndice A de este documento hay una imagen que muestra parte de los resultados que nos ofrece esta página, así como un esquema de los pasos que hay que seguir, para hacer nuestro análisis con esta herramienta en línea. ¿ Qué importa de los resultados del análisis estadístico ? Debemos comenzar mirando el valor de la p asociada con nuestra t de student., cualquiera que haya sido la prueba finalmente elegida. Y se pueden dar tres resultados: – Si p < .05, entonces la diferencia “es significativa”. – Si .05 ≤ p < .10, (p está entre .05 y .10) entonces se dice que la diferencia es “marginalmente signficativa”. – Si p ≥ .10, entonces se dice que “no hubo diferencia significativa”. Además de la prueba de contraste, conviene que tomemos buena nota del tamaño del efecto. Consúltese sobre este concepto el Apéndice C. ¿ Cómo informar los resultados estadísticos ? Aunque no existe una forma única de informar los resultados del análisis estadístico, existen ciertos estándares que debemos seguir. Así, en nuestro caso los datos relevantes son: • las dos medias y sus desviaciones típicas. • El valor de t (no confundir con la probabilidad de t) • Los grados de libertad de t. • La probabilidad de t (no confundir con el valor de t). • El tamaño del efecto (ver Apéndice C) ¿Cómo se informa todo esto? Veamos un ejemplo en el que la prueba arroja resultados positivos: <<La Tabla 2.4. muestra los valores medios de priming del grupo expuesto a lista bloqueada (organizada) y el grupo expuesto a lista aleatoria (no organizada). La diferencia entre ambas medias resultó estadísticamente significativa con una prueba direccional t de student para grupos independientes t( x ) = z, p<0.05, d=w. ….>> Y ahora un caso en el que describimos resultados negativos: 3 Esta tecla también se conoce como [Enter] o [Intro]. <<La Tabla 2.4. muestra los valores medios de priming del grupo expuesto a lista bloqueada (organizada) y el grupo expuesto a lista aleatoria (no organizada). Aunque las medias son aparentemente diferentes, sin embargo la diferencia entre ellas no resultó estadísticamente significativa con una prueba direccional t de student para grupos independientes t( x ) = z, p>0.10, d = w ….>> En los párrafos anteriores x figura por el número de grados de libertad, que en nuestro ejemplo son 64, si es así que hemos pasado la prueba a 4 participantes de cada grupo. Y la z figura por el valor de t. Es muy importante observar aquí que la fórmula de la hoja de cálculo Calc que aparece en el video no nos da el valor de t, sino su probabilidad5. Por el contrario, la página de internet que he recomendado arriba sí dan el valor de t, además de su probabilidad. Finalmente, w figura por el tamaño del efecto, cuyo cálculo se define en el Apéndice C; en este caso hemos elegido el índice d de Cohen (1988). ¿ Cómo interpretar los resultados de las pruebas estadísticas ? Nuestra hipótesis de trabajo en el diseño es: El priming es mayor en el grupo de lista organizada. Pero, por la lógica de inferencia estadística, para comprobarlo, sometemos a prueba la hipótesis (nula) de que ambos grupos tiene el mismo grado de priming. Cuando la t es suficientemente grande (en valor absoluto), llega a ser estadísticamente significativa (p<.05). En este caso rechazamos la hipótesis nula (“son iguales en priming los dos grupos”) y nos quedamos con nuestra hipótesis de partida (“hay más priming en el grupo de lista organizada”). Argumentación válida para interpretar los resultados de la prueba estadística: • Si una diferencia es significativa (en la dirección esperada), hay diferencia de ese tipo. • Si una diferencia no es significativa (en la dirección esperada), nuestro procedimiento experimental no ha logrado detectar si hay diferencia o no de ese tipo 6. • Si una diferencia es significativa en la dirección inesperada (más priming en el grupo de lista aleatoria), es posible que nuestro procedimiento experimental sea un desastre para nuestros objetivos7. Si nuestras diferencias son marginalmente significativas, entonces conviene sacar las conclusiones con cautela y hacer la recomendación de que convendría repetir el experimento con muestras más grandes y ser más serios en la realización del procedimiento (por ejemplo, quitarle el móvil a nuestros sujetos experimentales durante la prueba para reducir la varianza de error). Sobre la interpretación del tamaño del efecto ver la tabla de referencia para r que figura en el Apéndice C. Otros enlaces de interés • • • Wikipedia sobre la prueba t de student (la recomendable para saber cómo calcularla y cuándo hay que usar la de grupos pareados o independientes) Wikipedia sobre la distribución t de student (el fundamento teórico de la prueba) Sobre los contraste unilaterales y bilaterales. Referencias Ballesteros, S. (2010). Psicología de la Memoria. Madrid: UNED/Universitas. Ballesteros, S. (2010). Prácticas de Psicología de la Memoria: Manual de prácticas y cuaderno de trabajo. Madrid: UNED/Universitas. 4 5 6 7 Los grados de libertad se dan en la página en Inglés como d.f. , iniciales de degrees of freedom. Para obtener el valor de t a partir de su probabilidad podemos usar en Calc la fórmula DISTR.T.INV. Aquí la conclusión “no hay diferencia de ese tipo” no es válida. ¡Cuidado con esto! Es importante no confundir la dirección de la diferencia entre las medias con el signo (positivo o negativo del valor de t). Este último solo depende de la columna en la que pongamos el grupo con la media más alta. En nuestro caso debemos poner en la columna de la izquierda los datos del grupo de lista organizada. Lo importante para nosotros es si la media del grupo de lista organizada es superior a la del grupo de lista aleatoria. En otras palabras, el signo de la t no debe interpretarse sin tener en cuenta dónde hemos puesto los datos del grupo que esperamos con media más alta. Rappold, V. A. y Hashtroudi , S. (1991). Does Organization Improve Priming? Journal of Experimental Psychology: Learning, Memory, and Cognition , 17, 103-114 . APÉNDICE A: ANÁLISIS t CON http://vassarstats.net/tu.html (DATOS FICTICIOS) Esta imagen tenemos una vista parcial de la página que realiza el análisis de la t de student. En la imagen se ven marcados los resultados que nos interesan si queremos una prueba de una cola para varianzas iguales. Los pasos a seguir trabajando con esta página para realizar el análisis que necesitamos son: 1. Introducir el diseño (independent samples) y los datos en VassarStats.net y pulsa [Calculate]. 2. Comprobar si las varianzas de los dos grupos son iguales (la página nos da directamente la prueba F): Las varianzas son desiguales si su p(F)<0.05. Se consideran iguales en caso contrario. 3. Tomar la prueba t que corresponda: la de varianzas iguales o la de varianzas desiguales(siempre para una cola). La diferencia entre una y otra pruebas se limita a sus grados de libertad y su p asociada a la t obtenida. Naturalmente, la diferencia entre medias y el valor de t son iguales en ambos casos. De la prueba t finalmente seleccionada debemos anotar el valor de t, sus grados de libertad (d.f.) y su probabilidad p. Con estos datos ya podemos crear un texto similar al ejemplo que se ha puesto arriba. APÉNDICE B: ANALIZAR LOS DATOS COMO DISEÑO FACTORIAL Es posible analizar los datos de esta práctica mediante una técnica estadística alternativa a la t de student recomendada. Esa otra técnica es conocida como análisis de varianza o ANOVA (del Inglés Analysis of Variance). No obstante, el análisis exigido para la práctica es la t de student, por lo que el estudiante que no esté interesado en complicarse la vida en esto puede prescindir completamente de este Apéndice. Veamos cómo sería el diseño analizado mediante ANOVA: Sería un diseño que en la nomenclatura tradicional se representaría A x ( B x S ); esto significa que tenemos dos variables independientes A y B, la primera de ellas manipulada entre sujetos y la segunda intrasujetos; esto último se indica asociando con un paréntesis la letra B con la letra S de subjects (se leería B por sujeto). ¿Cuáles son estas variables?: El tipo de orden de la lista (variable A: Orden) y el haber presentado o no la lista (variable B: Presentación). Hay que observar que, como refleja la nomenclatura, la primera se manipula entre sujetos (unos sujetos ven lista bloqueada y otros distintos ven lista aleatoria). Mientras que la segunda (presentación) se manipula intrasujeto (para cada sujeto tenemos una lista presentada y una no presentada) 8. También hay que observar que en ambas variables tenemos dos niveles: tenemos dos tipos de presentación y tenemos dos tipos de lista. Por tanto, nuestro diseño para el ANOVA se esquematiza como un diseño 2 x ( 2 x S ). Para ordenar las medias de nuestros datos en un diseño así, la tabla siguiente sería apropiada: Bloqueada Aleatoria Lista presentada [a] [b] Mediap Lista no presentada [c] [d] Medianp Mediab Mediaa Los datos de esta tabla ([a] … [d]) se corresponden exactamente con las medias de la Tabla 2.4 del formulario de la PEC, haciendo caso omiso de los datos de priming de aquella. Pues bien, un ANOVA sobre este diseño nos daría la siguiente información: 1. Efecto principal9 de Orden: Nos dice si la diferencia entre Mediab y Mediaa es estadísticamente significativa. Es decir, si el orden de las palabras tiene importancia, olvidándonos de si la lista se ha presentado o no (!). 2. Efecto principal de la Presentación: Nos dice si la diferencia entre Mediap y Medianp es estadísticamente significativa. Es decir, si el presentar o no la lista tiene importancia, olvidándonos de si la lista es bloqueada o aleatoria (!). 3. Efecto de interacción Orden por Presentación: Nos dice si la diferencia ( [a] – [b] ) es distinta de la diferencia ( [c] – [d] ). Si lo es la interacción será significativa. Nótese que nosotros esperamos que haya mejor rendimiento en lista bloqueada, pero solo si ha sido presentada10. Es decir, nosotros esperamos una interacción estadísticamente significativa. De hecho, si esto es así, los llamados efectos principales carecen de interpretación válida por sí mismos. En todo diseño factorial las interacciones son lo importante. Nótese también que esta interacción es precisamente lo que a fin de cuentas analizamos al hacer la t de student sobre las puntuaciones diferenciales de priming. La página VassarStats.net también ofrece la posibilidad de hacer un ANOVA como este. 8 Nótese aquí que propiamente hablando es falaz hablar de lista no presentada bloqueada o no bloqueada, porque, al no presentarse, la forma de ordenar sus elementos es pura fantasía. Sin embargo, sería el único modo de ajustar los datos a un ANOVA. Este puede ser un motivo sólido que justifique plenamente no hacer el ANOVA, sino la t de student en nuestro caso. 9 La denominación de este efecto puede resultar engañosa, si pensamos que los efetos principales son los efectos importantes. Por el contrario, debemos entender aquí principal como “relativo al principium”, es decir, como “fundamental, básico o elemental”, no como “relativo al princeps”, al más importante. 10 Sería absurdo esperar priming por el orden de una lista no presentada. Sería Parapsicología. APÉNDICE C: INFORMAR ACERCA DEL TAMAÑO DEL EFECTO Desde hace ya algunos años la APA (American Psychological Association) recomienda informar el tamaño del efecto, además de los resultados de los contrastes estadísticos correspondientes (como nuestra t de student). El concepto de “tamaño del efecto” alude a la importancia de la diferencia entre las medias. En efecto, la prueba estadística t nos dice si las diferencias son o no “estadísticamente significativas”. Nos lo dice mediante su probabilidad p asociada: si esta es muy baja (p<.05), la comunidad científica nos permite asumir que la diferencia entre nuestras medias es suficiente como para tenerla en consideración (es decir, como para rechazar la hipótesis nula de que no hay diferencia alguna). Sin embargo, una t significativa no nos dice si nuestra diferencia es “importante” por su magnitud o es despreciable de puro pequeña. Para entender bien la diferencia entre la significación estadística y el tamaño del efecto puede ayudar el siguiente ejemplo. Supongamos que queremos comparar los resultados obtenidos por nosotros mismos en nuestro experimento con los obtenidos en experimento idéntico por una compañera. En ambos casos tenemos una t con una p asociada tal que p<.05; es decir, en ambos casos el experimento ha sido un “éxito”, ya que la diferencia entre nuestras medias son estadísticamente significativas, en otras palabras: se ha producido el efecto experimental. Supongamos, además, que nuestra compañera presume de que su experimento “es mejor” porque su p es “más significativa”, ya que ha obtenido p=.001, mientras que nosotros hemos obtenido p=.022 (desde luego, ambas son p<.05). Esta forma de interpretar las probabilidades asociadas a los estadísticos de contraste es un error muy frecuente entre los estudiantes (y también, por desgracia, entre algunos profesionales). La forma correcta de saber si nuestro efecto experimental es, además de estadísticamente significativo, importante por su magnitud (es decir, por la magnitud de la diferencia entre las medias) es calculando lo que se conoce como “tamaño del efecto”. Calcular el tamaño del efecto a partir de la prueba t es fácil. Bastará con aplicar la siguiente fórmula: r² = t² / ( t² + g.l. ) A partir de aquí calculamos r simplemente como √r² (es decir, raíz cuadrada de r²). El valor resultante es un índice de la magnitud del efecto que nos permite comparar nuestro experimento con el de nuestra compañera a simple vista, con independencia de que se trate de muestras de diferentes tamaños o incluso diseños ligeramente diferentes (p.ej., longitudes de listas diferentes o intervalos de retención distintos). De hecho, la tabla siguiente muestra los criterios propuestos por Cohen (1988) para juzgar la magnitud de los efectos obtenidos: Límite bajo Consideración Varianza explicada r =.10 Efecto pequeño El efecto explica el 1% de la varianza total r = .30 Efecto medio El efecto explica el 9% de la varianza total r = .50 Efecto grande El efecto explica el 25% de la varianza total Existe otro índice de tamaño del efecto propuesto por Cohen (1988). El índice d se define como: d= donde x̄1+ x̄2 s x̄1 y x̄2 son nuestras medias y el denominador s se calcula así: √ (n1−1) s21 +(n 2−1) s 22 s= n1+ n2 −1 donde n1 y n2 son el número de sujetos del grupo 1 y 2, respectivamente. Obsérvese, para interpretar el valor de d, que se trata de la diferencia entre las medias en puntuaciones zeta, es decir, estandarizada en función de la desviación típica de la muestra total de participantes. Observemos finalmente que todos los datos que necesitamos para calcular estos índices nos los da la página VassarStats.net.