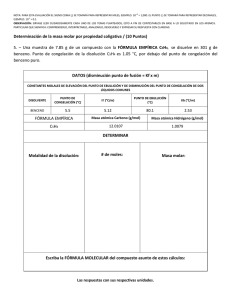

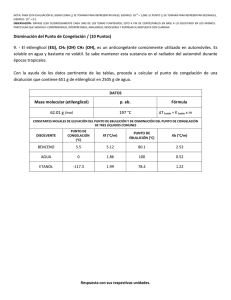

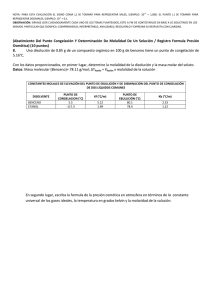

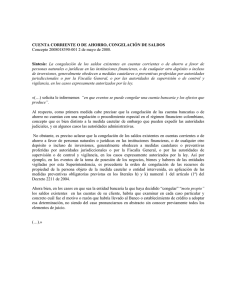

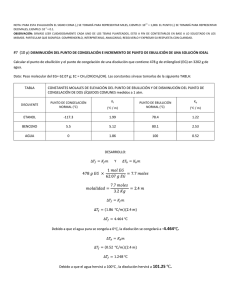

Número 1 - universidad tecnológica nacional :: facultad regional

Anuncio