Aplicaciones ópticas

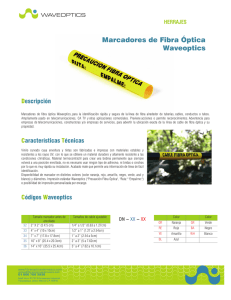

Anuncio