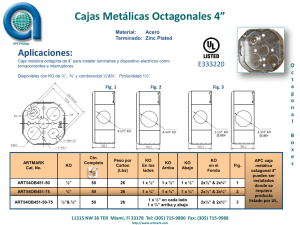

Ingeniería e Industria - Colegio y Asociación de Ingenieros

Anuncio