Ruidera - Universidad de Castilla

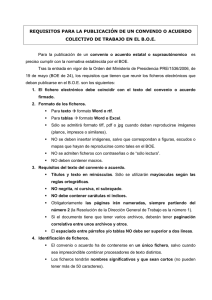

Anuncio