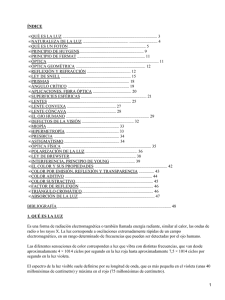

ÓPTICA TRADICIONAL Y MODERNA

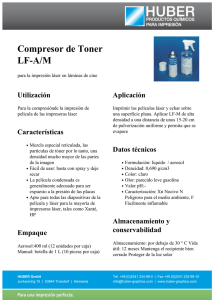

Anuncio