Demos Regresion Multiple

Anuncio

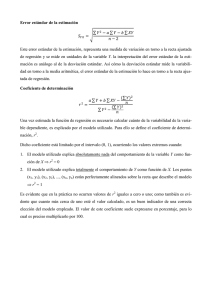

Demostraciones de Rgresión múltiple El modelo que se plantea en regresión múltiple es: y i = β 0 + β 1 x 1i + β 2 x 2i + ⋯ + β k x ki + u i # donde x 1 , x 2 , …, x k son las variables independientes o explicativas. La variable respuesta depende de las variables explicativas y de una componente de error, u i que se distribuye como una normal de media cero y varianza constante. u i N0, σ 2 # El ajuste del modelo se realiza por mínimos cuadrados o máxima verosimilitud. En el caso de distribución normal de errores ambos métodos coinciden como ya se vió en Regresión Simple. Denominando y i = β 0 + β 1 x 1i + β 2 x 2i + ⋯ + β k x ki al valor que el modelo estimado predice para la observación y i , el error cometido en esa previsión es: e i = y i − y i = y i − β 0 + β 1 x 1i + β 2 x 2i + ⋯ + β k x ki donde β 0 , β 1 , …, β k son los valores estimados del modelo. El criterio de mínimos cuadados asigna a β 0 , β 1 , …, β k el valor que minimiza la suma de errores al cuadrado de todas las observaciones. Vamos a trabajar en forma matricial. Notaciones y1 Y= y2 Y= , ⋮ yn β1 β = β2 ⋮ βk y1 y2 ⋮ yn β1 , β= β2 ⋮ βn # e1 e= e2 # ⋮ en X es la denominada matriz de diseño, de dimensión n × k + 1. X= 1 x 11 x 21 ⋯ x k1 1 x 12 x 22 ⋯ x k2 ⋮ ⋮ ⋮ ⋱ ⋮ 1 = 1, X 1 , X 2 , ⋯X k x 1n x 2n ⋯ x kn x 11 X1 = Siendo x 12 ⋮ x 1n El modelo puede escribirse en forma matricial como: Y = Xβ + U # Y= Xβ+e # Y el modelo estimado Ajuste por mínimos cuadrados e i = y i − y i = y i − β 0 + β 1 x 1i + β 2 x 2i + ⋯ + β k x ki donde β 0 , β 1 , …, β k son los valores estimados del modelo. El criterio de mínimos cuadados asigna a β 0 , β 1 , …, β k el valor que minimiza la suma de errores al cuadrado de todas las observaciones. La suma de errores es: S= n n i=1 i=1 ∑ e 2i = ∑y i − β 0 + β 1 x 1i + β 2 x 2i + ⋯ + β k x ki 2 Para calcular el mínimo de esta ecuación, hay que derivar respecto de β 0 , β 1 , …, β k . La solución que se obtiene debe expresarse en términos matriciales y es: δS = −X ′ Y − X ′ Y + 2X ′ X # β δβ # X ′ Y = X ′ X β β= X ′ X −1 X ′ Y donde β representa un vector columna de dimensión k + 1 que contiene los parámetros. Es # importante notar que X ′ X es una matriz simétrica y para que sea invertible su rango (que coincide con el rango de X debe ser máximo, es decir k+1. β1 β = β2 ⋮ βk La varianza residual tiene la expresión. n ∑ i=1 e 2i 2 sR = n−k−1 No vamos a demostrar que este estimador es centrado para σ 2 . Relaciones entre las variables. β = X ′ X −1 X ′ Y Y = Xβ= XX ′ X −1 X ′ Y = HY # # Donde la matriz H es idempotente, simétrica y del mismo rango que X, k + 1. H = XX ′ X −1 X ′ ′ −1 ′ # ′ −1 ′ H.H = XX X X XX X X = H # e = Y −Y= Y − HY = I − HY # La relación Y= HY indica que la matriz H (que es idempotente) transforma el vector de observaciones Y en el vector de valores ajustados Y. Una matriz idempotente realiza una proyección, por lo que la regresión va a ser una proyección. Para entender mejor cómo es esa proyección vamos estudiar las relaciones entre e, Y e Y. En primer lugar, vamos a demostrar que el vector de residuos e es perpenticular al vector de valores ajustados Y y a la matriz X. Para demostrar que e ⊥ Y debemos demostrar que e ′ Y = 0 e ′ Y = I − HY ′ HY = Y ′ I − HHY = Y ′ HY − Y ′ HHY = 0 ya que HH = H por la propiedad de idempotencia. Además (I-H) es simétrica y se puede demostrar que es también idempotente. # Para demostrar que e ⊥ X debemos demostrar que e ′ X = 0 e ′ X = I − HY ′ X = Y ′ I − HX = Y ′ X − XX ′ X −1 X ′ X = 0 # La interpretación geométrica es clara. Un matriz idempotente es una matriz de proyección. El modelo de regresión Y = HY proyecta el vector de observaciones sobre el subespacio vectorial de las columnas de la matriz X. Es decir sobre el subespacio de las variables independientes. El vector de residuos es perpenticular a las X y al vector Y . El gráfico muestra la proyección: Distribución de β β= X ′ X −1 X ′ Y = AY. El vector de observaciones Y se distribuye como una normal multivariante de media Xβ y de matriz de varianzas y covarianzas σ 2 I n . Y N n Xβ, σ 2 I n # Como β es una combinación lineal de las variables Y, podemos concluir que β se distribuye como una variable normal. Tendremos que calcular su esperanza y su varianza: ′ # E β = EX X −1 X ′ Y = X ′ X −1 X ′ EY = X ′ X −1 X ′ Xβ = β Por tanto β es un estimador centrado de β. var β = varAY = A.varYA ′ = X ′ X −1 X ′ VarYXX ′ X −1 = # ′ −1 ′ ′ X X X σ XX X 2 −1 ′ −1 ′ ′ = σ X X X XX X 2 −1 ′ = σ X X 2 −1 # β N k+1 β, σ 2 X ′ X −1 Una β correspondiente a una de las variables tendrá la distribución: β i Nβ i , σ 2 q ii # # donde q ii es elemento deiagonal correspondiente de la matriz X′X −1 q 00 q 11 X′X −1 = q 22 ⋱ q kk La estimación de σ 2 se hace mediante la varianza residual que es n ∑ i=1 e 2i 2 sR = n−k−1 de manera que vamos a estimar la varianza de β i Nβ i , σ 2 q ii mediante s 2R q ii Al producto s 2R q ii se le denomian Error Estándar en la estimación del coeficiente β i y lo proporciona el ordenador. 2 SEβ i = s 2R q ii # Se puede demostrar que n − k − 1 s 2R ∼ χ 2n−k−1 σ2 # Contraste t Hemos demostrado que β i ∼ Nβ i , σ 2 q ii # por tanto βi − βi ∼ N0, 1 σ q ii La definición de una t de k grados de libertad es: # N0, 1 1 2 χ k k tk = # La normal la tenemos en la distribución de β i y la χ 2n−k−1 la obtenemos de la distribución de s 2R . β i −β i σ q ii t n−k−1 = 1 n−k−1 n−k−1 2 sR σ2 β − βi = i s R q ii # Como ya se ha visto al término s R q ii = SEβi # se le denomina error estándar de β i. Es el valor del error estándar que proporciona el ordenador. El ”contraste t” va a testear la posibilidad de que βi = 0. Es decir que el valor de verdad de la población sea realmente cero. Si esto fuera cierto la variable X i no influiría sobre la variable Y. H 0 : βi = 0 H 1 : βi ≠ 0 Habíamos demostrado que β i − βi = t n−k−1 SEβ i Si se cumple la hipótesis nula de que β 1 = 0 resultará que β1 β1 − 0 = = t n−k−1 SEβ 1 SEβ 1 Por tanto si se cumple H 0 el valor de βi SEβ i deberá ser de una t n−k−1 . Esta distribución si n>30 deja entre −2; +2 el 95% de probabilidad. Por tanto si obtenenemos un número en ese rango es posible que efectivamente β i = 0. Si por el contrario el número es mayor que 2 en valor absoluto pensaremos que β i ≠ 0 y, consecuentemente, diremos que la varible influye. Este es el fundamento teórico del contraste t que proporciona el ordenador. Intervalo de confianza Como sabemos que β i −β i SEβ i ∼ t n−k−1 podemos establecer βi − βi ≤ t α/2 = 1 − α SEβ i Pβ i − t α/2 SEβ i ≤ β i ≤ β i + t α/2 SEβ i = 1 − α P−t α/2 ≤ # # Por tanto βi ∈ β i ± t α/2 SEβ i # con confianza 1-α. Si trabajamos con α = 0.05 y n>30, el intervalo se convierte en β i ∈ β i ± 2SEβ i Descomposición de variabilidad yi = y i + ei # restando y y elevando al cuadrado: y i − y 2 = y i − y 2 + e i 2 + 2 y i − ye i # sumando para todas las observaciones n ∑y i − y 2 = i=1 n n n i=1 i=1 i=1 ∑y i − y 2 + ∑ e i 2 + 2 ∑y i − ye i # El último término es cero como se demostró en regresión simple. Por tanto n n n i=1 i=1 ∑y i − y = ∑y i − y 2 + ∑ e i 2 2 i=1 VT = VE + VNE # # n VT = ∑y i − y 2 # ∑y i − y 2 # ∑ ei 2 # i=1 n VE = i=1 n VNE = i=1 Donde VT es la variación total VE es laVariación explciada y VNE es la variación no explicada. Coefeiciente de Determinación y coeficiente de determinación corregido por grados de libertad. El coeficiente de determinación, R 2 , proporciona la cantidad de variabilidad de y que explica la x. Se define n R 2 = VE = VT ∑y i − y 2 i=1 n ∑y i − y 2 n = ∑y i − y 2 i=1 ns 2y i=1 Sin embargo, el coeficiente de determinación así definido tiene el problema de que al incluir nuevas variable aumenta su valor, incluso cuando esas variables no sean significativas. Este problema hace que R 2 no se pueda utilizar como criterio válido para incluir o excluir variables. Para evitar este problema se define el Coeficiente de Determinación corregido por grados de 2 2 libertad, R . Se define R como 2 R = 1 − 1 − R 2 n−1 n−k+1 2 Este coeficiente R no tiene los inconvenientes de R 2 ya que al introducir más variables en el modelo no aumenta necesariamente su valor. Contraste de regresión F. El contraste de regresión en regresión múltiple sirve para comprobar si el modelo explica una parte significativa de la variabilidad de y. Se puede demostrar que si β 1 = β 2 = ⋯ = β k = 0, el cociente n VE/k − 1 = VNE/n − k − 1 ∑y i − y 2 i=1 1 n−2 n ∑ e 2i =F i=1 se distribuye como una F k−1,n−k−1 .Si el valor obtenido es un valor probable para una F k−1,n−k−1 llegaremos a la conclusión de que el modelo no explica conjuntamente nada. Si por el contrario el test indica que el valor obtenido no puede razonablemente provenir de una F, entonces el modelo explica una parte significativa de y.