“Fotoagnosis”: leer una fotografia para comprender la luz

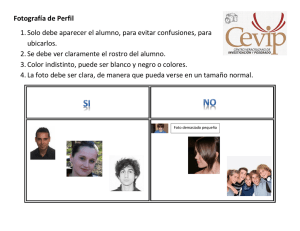

Anuncio