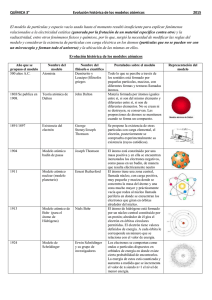

FISICA MODERNA II

Anuncio