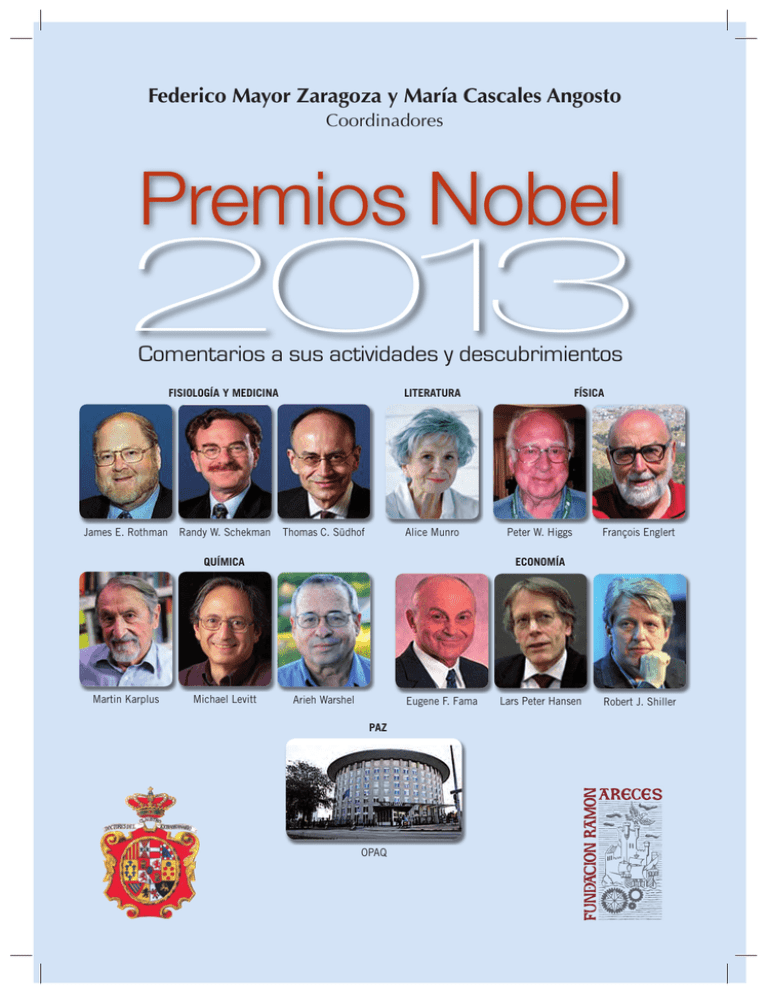

Premios Nobel - El Corte Inglés

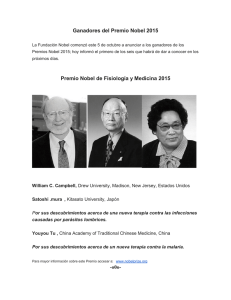

Anuncio