1997. Sencillamente Ciencia

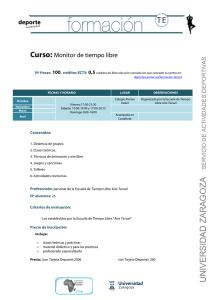

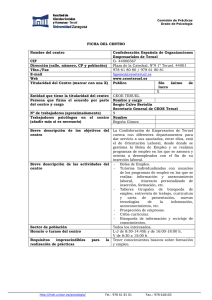

Anuncio