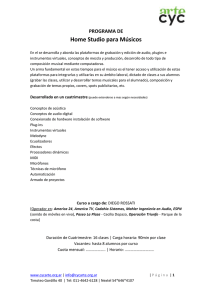

EL MANUAL DEL AUDIO EN LOS MEDIOS DE COMUNICACION

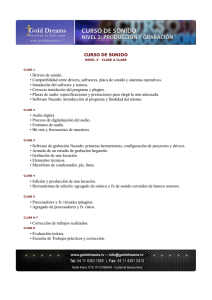

Anuncio