en otra ventana

Anuncio

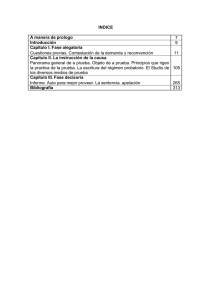

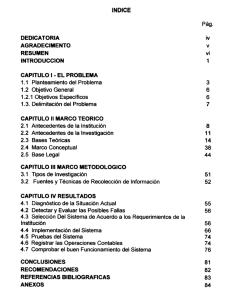

CAPÍTULO 2

MARCO TEORICO

CAPITULO 2. MARCO TEORÍCO

1. MARCO TEÓRICO

El objetivo de esta tesis requiere de algunos conceptos estadísticos que serán tratados en el

presente capítulo. Sería imposible abarcar todos aquellos puntos que el tema requiere,

recalcando que ese no es el objetivo de esta investigación, por lo que se hablará

fundamentalmente de aquellos que son los más relevantes.

Los conceptos a estudiar en el presente capítulo son:

1.-Diseño completamente al azar.

2.-Pruebas de rango múltiple.

∧

3.-Alfa Nominal (α) VS. Alfa Real ( α ).

4.-Problemas que se pueden presentar en las Pruebas de Rango Múltiple.

5.-La Prueba D.E. (Prueba de la Diferencia Estudentizada).

6.-Tipos de errores.

7.-Control de los diferentes tipos de error.

8.-La transformación integral.

9.-FORTRAN.

CAPITULO 2. MARCO TEORÍCO

1.1. Diseño completamente al Azar

Considere el siguiente ejemplo:

Se sabe que el contenido de algodón debe variar aproximadamente entre 10 y 40% para

que la tela resultante tenga las características de calidad que se desean. Se deciden probar

muestras a cinco niveles de porcentaje de algodón: 15, 20, 25, 30, y 35%.

Asimismo, se decide ensayar con cinco muestras a cada nivel de contenido de algodón.

Este es un ejemplo de experimento unífactorial con a = 5 niveles del factor y n = 5

repeticiones. Las 25 corridas deben hacerse en orden aleatorio. Los resultados obtenidos

pueden verse en la tabla 2.1

Porcentaje

Resistencia a la tensión observada

de

(16/in 2 )

algodón

1

2

3

4

5

15

7

7

15

11

9

20

12

17

12

18

18

25

14

18

18

19

19

30

19

25

22

19

23

35

7

10

11

15

11

Tabla 2.1 Resultados en los porcentajes.

La secuencia de prueba aleatorizada es necesaria para evitar que los resultados sean

contaminados por los efectos de variables desconocidas, que pueden salir de control

durante el experimento. (Montgomery 1999)

CAPITULO 2. MARCO TEORÍCO

1.1.1. Análisis de Varianza

Se desea comparar algunos niveles de un factor, para eso es útil describir las observaciones

mediante el modelo estadístico lineal:

y ij = µ + τ i + ∈ ij

En donde

y ij

{

i = 1 , 2 ,..., a

j = 1 , 2 ,..., n (3-1)

es la (j)-esima observación del (i)-esimo tratamiento, µ es un parámetro

común a todos los tratamientos de nominado media global, τ i , es un parámetro único para

el i-esimo tratamiento llamado efecto del tratamiento i-esimo, y ∈ij es la componente

aleatoria del error. Para probar las hipótesis, se supone que los errores del modelo son

variables aleatorias independientes con distribución normal, con medida 0 y variantes σ 2 .

Se supone que esta última es constante para todos los niveles del factor (Ver Montgomery

1999).

Este modelo se denomina análisis de varianza clasificado en un sentido por que solo

investiga un factor. El modelo estadístico, ecuación 3-1, describe dos situaciones con

respecto al efecto de los tratamientos. Primero, los tratamientos podrían haber sido

seleccionados específicamente por el experimentador. En esta situación se desea probar

hipótesis sobre las medidas de los tratamientos y las conclusiones se aplican solo a los

niveles del factor considerados en el análisis. También seria deseable estimar los

parámetros del modelo ( µ , τ i , σ 2 ). Este modelo se denomina modelo de efectos fijos. (Ver

Montgomery 1999).

1.1.2. Descomposición de la suma total de los cuadrados

El análisis de varianza resulta de descomponer la variabilidad total de los datos en las

partes que lo componen. La suma total de los cuadrados corregida:

CAPITULO 2. MARCO TEORÍCO

SS

Ι

=

a

⎛

⎜ y

⎝

n

∑

∑

i=1

j=1

⎞

− y .. ⎟

⎠

−

ij

2

Se usa como medida la variabilidad total de datos. Se debe observar que la suma total de los

cuadrados corregida SS T puede escribirse como:

a

n

i =1

j =1

−

⎛

⎞ a

⎜ y ij − y.. ⎟ = ∑

⎝

⎠ i =1

∑∑

n

∑

j =1

−

⎡⎛ − − ⎞ ⎛

⎞⎤

⎢⎜ y i. − y .. ⎟ + ⎜ y ij − y i. ⎟⎥

⎠ ⎝

⎠⎦⎥

⎣⎢⎝

2

(3-4)

O bien:

a

n

i =1

j =1

∑∑

2

2

a

a

−

⎛

⎞

⎛− − ⎞

−

=

−

+

y

y

n

y

y

⎜ ij

⎜ i. .. ⎟ ∑

∑

.. ⎟

⎝

⎠

⎠

i =1 ⎝

i =1

2

a

−

⎛

⎞

−

+

y

y

2

⎜ ij

∑

∑

i. ⎟

⎠

j =1 ⎝

i =1

n

−

⎛ − − ⎞⎛

⎞

⎜ y i. − y .. ⎟⎜ yij − yi. ⎟

⎝

⎠⎝

⎠

n

∑

j =1

(3-5)

El término del producto de cruz en la ecuación 3-5 es cero, ya que:

−

−

⎞

⎛

y

−

y

=

y

−

n

y

⎜ ij

∑

i.

i. ⎟

i . = yi . − n( y i . / n ) = 0

⎠

j =1 ⎝

n

Por lo que:

a

n

i =1

j =1

∑∑

2

2

a

a

−

−

⎛

⎞

⎛−

⎞

⎜ y ij − y .. ⎟ = n∑ ⎜ y i. − y .. ⎟ + ∑

⎝

⎠

⎠

i =1 ⎝

i =1

−

⎛

⎞

−

y

y

⎜

∑

ij

i. ⎟

⎠

j =1 ⎝

n

2

(3-6)

La diferencia de los promedios observados de los tratamientos y el promedio general

constituye una medida de la diferencia entre las medidas de tratamiento, por tanto,

simbólicamente la ecuación 3-6 puede ser escrita como

CAPITULO 2. MARCO TEORÍCO

SS T = SS Tratamientos + SS E

En donde SS Tratamientos se denomina suma de cuadrados debida a los tratamientos y SS E se

llama suma de cuadrados debida al error. SS T tiene N – 1 grados de libertad por que hay

un total de an=N observaciones. Por otra parte, existen a niveles de factor, de manera que

SS Tratamientos tiene a – 1 grados de libertad. Como hay tratamientos, se tienen a(n-1) = an – a

= N – angrados de libertad para el error.

2

2

a ⎡

−

−

⎛

⎞

⎛

⎞ ⎤

SS E = ∑∑ ⎜ yij − y i. ⎟ = ∑ ⎢ ⎜ yij − y i. ⎟ ⎥

⎠

⎠ ⎥⎦

i =1 j =1 ⎝

i =1 ⎢

⎣⎝

a

n

De esta forma es fácil observar que el termino ubicado entre los paréntesis, dividido entre n

-1, es la varianza muestral del i-esimo tratamiento, o

−

⎞

⎛

y

y

−

⎜

∑

ij

i. ⎟

⎠

i =η ⎝

S i2 =

n −1

n

2

i= 1.2,…,a

Es posible combinar a varianzas muéstrales para producir una estimación de la varianza

poblacional común como se muestra a continuación:

2

−

⎡ n ⎛

⎞ ⎤

−

y

y

∑ ⎢∑ ⎜ ij i. ⎟⎠ ⎥

(n − 1)S12 + (n − 1)S 22 + ... + (n − 1)S a2 = i=1 ⎢⎣ j =1 ⎝

SS e

⎥⎦

=

a

(n − 1) + (n − 1) + ... + (n − 1)

(N − a )

∑ (n − 1)

a

i =1

Por tanto, SS E /(N-a) es una estimación de la varianza común a cada uno de los a

tratamientos. (Ver Montgomery 1999).

CAPITULO 2. MARCO TEORÍCO

Utilizando el teorema de Cochran se concluye que SS Tratamiento / σ 2 y SS E / σ 2 son variables

aleatorias independientes con distribución ji cuadrada. Por tanto, el cociente:

F0=

SS Tratamiento / (a − 1) MS Tratamiento

(3-7)

=

SS E / ( N − a )

MS E

Tiene una distribución F con a – 1 y N –a grados de libertad. La ecuación 3-7, es la prueba

estadística qué se usa para probar la hipótesis de igualdad de las medidas de los

tratamientos, del valor esperado, de la medida de cuadrados. Se observa que, en general,

MS E es un estimador insesgado de σ 2 . En otras palabras, se rechaza H 0 si

F 0 > F α ,a −1, N − a

Donde F 0 se calcula usando la ecuación 3-7.

Las formulas de cálculo para las sumas de cuadrados al pueden ser escritas como:

a

n

SS T = ∑∑ yij2 −

i =1 j =1

a

SS Tratamiento = ∑

i =1

y 2 ..

N

yi2. y..2

−

n

N

(3-8)

(3-9)

La suma de cuadrados del error se obtiene por la diferencia:

SS E =SS T -SS Tratamiento

Estos resultados se pueden apreciar mejor en la tabla de análisis de varianza, Ver tabla 1.2.

CAPITULO 2. MARCO TEORÍCO

Fuente de

Suma de

Grados de

Media de

variación

cuadrados

libertad

cuadrados

Entre

SS Tratamiento

a-1

MS Tratamientos

SS E

N-a

MS E

SS T

N-1

F0

F0=

tratamientos

Error (dentro

MSTratamientos

MS E

del tratamiento)

total

Tabla 1.2 Tabla de análisis de varianza para el modelo de efectos fijos unífactoriales

Más sobre el experimento anterior. Aquí se producen los datos de la tabla anterior. Ver

tabla 2.3.

Porcentaje

Resistencia a la tensión observada

Totales

(16/in 2 )

y

de

algodón

15

20

25

30

35

1

2

3

4

5

7

12

14

19

7

7

17

18

25

10

15

12

18

22

11

11

18

19

19

15

9

18

19

23

11

Tabla 2.3. Tabla de resultados del análisis de varianza

La suma de los cuadrados se calcula:

5

5

SS T = ∑∑ yij2 −

i =1 j =1

Por lo que:

y..2

N

19

77

88

108

54

Y = 376

Promedios

−

yi

9.8

15.4

17.6

21.6

10.8

−

y =15.04

CAPITULO 2. MARCO TEORÍCO

2

(

376)

= (7 ) + (7 ) + (15) + ... + (15) + (11) −

2

2

2

2

2

25

= 636.96

Y la suma de cuadrados de tratamientos:

5

SS Tratamientos = ∑

i =1

yi2. y 2

−

n N

2

2

2

(

49) + ... + (54 ) (376)

=

−

5

25

= 475.76

Por lo que:

SS E =SS T -SS Tratamientos

=636.36-475.76=161.20

1.1.3. Análisis del modelo de efectos fijos

Se debe notar que la media de cuadrados entre tratamientos (118.94) es mayor que la media

de los cuadrados dentro de tratamientos (8.06). Esto indica que es poco probable que las

medias de tratamientos sean iguales. Es posible

calcular F 0 =118.94/8.06=14.76 y

compararla con F α 4.20. como F 01, 4, 20 = 4.43, debe rechazarse H 0 y concluir que la medias de

tratamientos son diferentes. Estos resultados se pueden apreciar mejor en la tabla 2.4

Fuente de variación

Suma

cuadrados

Porcentaje de algodón 475.76

de Grados

libertad

de Medida

cuadrados

4

118.94

8.06

Error

161.20

20

total

636.96

24

Tabla 2.4 Análisis de la variancia para los datos

de F 0

F 0 = 14.76

CAPITULO 2. MARCO TEORÍCO

1.2. Pruebas de Rango Múltiple.

El estudio de las comparaciones por pares se realiza a través de las pruebas de rango

múltiple, donde se desea probar la hipótesis nula:

H 0 : µi = µ j , i ≠ j

El criterio de rechazo es:

Y i. − Y

j.

> k (i , j , a , gl .error ) S y

Donde:

i= i – esimo tratamiento

j= j – esimo tratamiento

a= tratamientos

glerror= grados libres del error

Donde:

Sy =

CM E

n

y la k(i, j, a, glerror) varía dependiendo la prueba que desee utilizarse, así como los

parámetros i, j, a ó grados libres del error que se utilizan acorde a la prueba seleccionada

(Ver Ruelas 2004). En general todas las pruebas de rango múltiple se describen de esta

manera. A continuación se muestran las pruebas de rango múltiple más utilizadas y sus

respectivos estadísticos

CAPITULO 2. MARCO TEORÍCO

1.2.1. Comparaciones entre Pares

Aquí se estudiaran las diversas pruebas que pueden ser aplicadas para este estudio, las

pruebas que a continuación se presentan, son las más importantes en el estudio de la

comparación entre pares.

1.2.1.1.

Prueba DMS

Para probar la H 0 : µ i = µ j el estadístico utilizado es:

⎛1

1 ⎞

DMS = tα / 2, N − a CM E ⎜ + ⎟

⎜n n ⎟

j ⎠

⎝ i

Cuya regla de decisión es:

Rechazo Ho si: Y i. − Y

Donde t α

2

, N −a

j.

> DMS

⎛ α⎞

es el ⎜1 − ⎟100% cuantil de la distribución t N − a grados de libertad.

2⎠

⎝

1.2.1.2.

Prueba de Tukey

La Prueba de Tukey declara que dos medias son significativamente diferentes si el valor

absoluto de sus diferencias muestrales excede.

Tα = qα (a, f )

Donde q =

y max − y min

CM E n

CM E

n

, o mejor conocido como estadístico del rango estudentizado. Para

más detalles sobre los valores de q consultar Montgomery (2002).

CAPITULO 2. MARCO TEORÍCO

1.2.1.3.

Prueba de Duncan

El criterio de Duncan se muestra a continuación. La Prueba de Duncan declara que dos

medias son significativamente diferentes si el valor absoluto de sus diferencias muestrales

excede.

R p = rα ( p, f )

CM E

n

Donde los valores de rα(p,f) donde p son las medias involucradas; para p = 2,…,a se

obtienen de tablas; α es el nivel de significación y f el número de grados de libertad del

error. Para más detalles sobre los valores de R (Ver Montgomery 2002).

1.2.1.4.

Prueba de Bonferroni

La desigualdad de Bonferroni, especifica que la probabilidad de unión de eventos es menor

que la suma de las probabilidades de los eventos individuales, al especificar Bonferroni

únicamente una cota la convierte en un procedimiento de un solo paso. Su criterio se

muestra a continuación. Dos medias se declaran diferentes si el valor absoluto de la

diferencia es mayor que: (Ver Ruelas 2004)

t *α , f

CM E

n

Donde:

t *α , f = t α

2b

b = Número de comparaciones

,f

CAPITULO 2. MARCO TEORÍCO

f = Grados libres del error

t = Distribución de student con N-a grados de libertad.

1.2.1.5.

Prueba SNK

Procedimiento similar a la prueba de Duncan, salvo que las diferencias críticas entre las

medias se calculan en una forma un tanto diferente, su criterio es el siguiente:

Dos medias se declaran diferentes si el valor absoluto de la diferencia es mayor que: (Ver

Ruelas 2004)

K p = qα ( p , f )

CM E

n

1.2.2. Comparaciones con Contrastes

Ya que en la mayoría de los experimentos, no se sabe a ciencia cierta las comparaciones

que se desea realiza hasta que se haya hecho un examen preliminar de todos los datos, es

por eso que Scheffe propuso un método que compara todo tipo de contrastes.

1.2.2.1.

Prueba Scheffé

El método de Scheffé se utiliza para la comparación ya no solo entre pares de medias sino

de contrastes completos, es decir combinaciones de medias. El criterio utilizado es:

S α ,u = S Cu (a − 1) Fα ,a −1, N − a

Donde:

a

S Cu = CM E ∑

i =1

ciu2

ni

CAPITULO 2. MARCO TEORÍCO

Para mayores detalles de las pruebas anteriores Ver Montgomery 2002

∧

1.3. Alfa Nominal (α ) VS Alfa Real ( α )

La definición del alfa nominal, α , es aquel nivel de significancia que el investigador

∧

coloca al inicio de la prueba, el alfa real ( α ) es el verdadero tamaño al cual se está

realizando la prueba. Lo ideal para cualquier experimento es que tengan el mismo valor

El Valor P se define como el mínimo nivel de significancia que llevará al rechazo de la

hipótesis nula Ho. Según Montgomery (2002) el Valor P, es la probabilidad de que la

prueba estadística tomará en el valor que es al menos tan extremo como el valor observado

del estadístico cuando Ho es verdadera, por lo cual es posible asegurar que el Valor P cubre

mucha información acerca del peso de la evidencia en contra de Ho lo que permite elaborar

una conclusión con respecto a cualquier nivel de significancia. En otras palabras este

concepto se traduce como la probabilidad de que el valor de F de tablas sea mayor que el

valor de F calculada.

Obsérvese las figuras 2.3.1 y 2.3.2. En la figura 2.3-1, se ilustra el ejemplo de cuando la F

calculada cae en la zona de aceptación.

∧

Si α real > α nominal entonces la F Calcul|ada se encuentra en la zona de Aceptación.

CAPITULO 2. MARCO TEORÍCO

∧

α

Real

α Nominal

F

F.Calc

Zona de Aceptación

Figura 2.1

P.C

Zona de Rechazo

Caso en el que la F calculada cae en la zona de aceptación, donde el punto crítico (P.C) esta

definido por α nominal (Ver Ruelas 2004).

En la figura 2.2 se muestra el caso contrario donde F calculada cae en zona de rechazo; en

base al criterio de que si Valor P < α nominal entonces la F Calculada se encuentra en la

zona de Rechazo.

CAPITULO 2. MARCO TEORÍCO

α Nominal

∧

α Real

F

P.C

Zona de Aceptación

Figura 2.2.

F.Calc

Zona de Rechazo

Caso en el que la F calculada cae en la zona de rechazo, donde el punto crítico (P.C.) esta

definido por α nominal (Ver Ruelas 2004).

1.4. Problemas que se pueden presentar en las Pruebas de Rango Múltiple

La posibilidad de efectuar comparaciones múltiples ha recibido críticas importantes desde

diversas perspectivas (Dawkins, 1983; O'Neill, y Wetherill, 1971; Perry, 1986). Bastantes

críticas provienen de la pugna teórica entre las diversas concepciones y corrientes

estadísticas. Otras se refieren a principios de utilización incorrecta. Por ejemplo, otros

autores afirman que solamente cuando se desean realizar todas las comparaciones por pares

y si se quiere mantener la probabilidad del error de tipo I igual a α, es perfectamente

legítimo omitir la prueba F y usar uno de los procedimientos de contraste de medias. La

razón aducida es que la aplicación de las pruebas de comparación múltiple únicamente

después de una prueba F significativa es una estrategia que reduce la potencia y el nivel a

en una cantidad difícil de determinar.

La utilización incorrecta de Comparaciones Múltiples lleva a los investigadores a

conclusiones erróneas que se reflejan en ambos tipos de error (tipo I y tipo II). En un

CAPITULO 2. MARCO TEORÍCO

trabajo de Coward (1991) sobre la utilización de las pruebas de comparaciones múltiples en

Estados Unidos se detectan cuatro posibles situaciones que pueden conducir a error en la

aplicación de las pruebas: 1) utilizar pruebas de comparaciones de pares cuando lo correcto

es utilizar contrastes polinómicos, 2) usar comparaciones múltiples a posteriori en lugar de

a priori; 3) utilizar medias aritméticas en lugar de mínimo cuadráticas y 4) utilizar una

prueba demasiado "liberal"

En la mayoría de Pruebas de Rango Múltiple, que actualmente se presentan en la literatura,

siempre presentan una serie de deficiencias debido a la dependencia que existe entre los

datos a comparar, a continuación se muestran los comentarios hechos por Burguete,

Tamborero y García Pajares (1999).

1.4.1. Tukey

Caso parecido a SNK donde resulta una prueba exacta, pero únicamente comparando la

media mínima contra la máxima, esto resulta a que utiliza una misma métrica para

comparar todas las medias, lo cual hace que la prueba se vuelva restrictiva.

1.4.2. Bonferroni

Resulta una prueba restrictiva para cualquier comparación, esto debido a que la prueba

arroja el resultado de una cota.

1.4.3. SNK

Es una prueba adecuada

pero únicamente para comparar la media mínima contra la

máxima, para el resto de las medias se vuelve restrictiva.

CAPITULO 2. MARCO TEORÍCO

1.4.4. Duncan

Esta prueba resulta muy parecida a la prueba DMS, pero su demostración matemática es

incorrecta, Scheffé (1959).

1.4.5. DSM

∧

∧

Para medidas alejadas α real es mayor al α nominal y para medias cercanas el valor α

real es menor que el α nominal.

1.4.6. Scheffe

Restrictiva para cualquier comparación ya que usa un intervalo de confianza para el

contraste que concentra toda la suma de cuadrados de los tratamientos

1.5. La Prueba D.E (Prueba de la Diferencia Estudentizada)

Después de toda la problemática que se mostro y la complicación de las pruebas de rango

múltiple tanto en su planteamiento como en su demostración, Burguete, Tamborero y

Morales (2003) presentan una prueba de rango múltiple basada en la simulación, los

resultados

generados por la prueba son aproximados con la ventaja de ser una prueba de

planteamiento correcto, manteniendo el mismo nivel de confianza tanto para

comparaciones externas como internas, esto

debido al adecuado planteamiento de la

prueba.

A esta prueba se le llamará prueba D.E (Prueba de la Diferencia Estudentizada), debido a

que generaliza el rango estudentizado a cualquier comparación de dos medias. Burguete,

Tamborero y Morales (2003), elaboraron un programa computacional en lenguaje Fortran

para demostrar el funcionamiento de la prueba propuesta, dicho programa se basa en el

algoritmo que se muestra a continuación:

CAPITULO 2. MARCO TEORÍCO

1.-

Solicitud de datos de entrada.- número de tratamientos (a), número de

repeticiones (n), datos reales de un experimento que correspondan al número

de tratamientos y repeticiones dados y número de simulaciones (B).

2.-

Inicializar CONT = 0

3.-

Generar las diferencias estudentizadas de los datos reales (DE)

4.-

Generar a*n observaciones de una distribución N(0,1), los autores manejan

que es posible manejar una distribución N(µ,σ).

5.-

Aplicar Estadísticos de Orden

6.-

Calcular las Diferencias Estudentizadas de los datos simulados (DEs):

7.-

xi − x j

CMES

n

Si DEs > DE → CONT = CONT +1

DESij =

los pasos 4 al 7 se repiten un número determinado de veces = B

8.-

Se calcula:

ValorP =

CONT

B

La principal ventaja que muestra esta prueba, es que el Valor P se mantiene constante a lo

largo de todas las comparaciones, sin importan la distancia que exista entre las medias

analizadas. El algoritmo de la prueba D.E. se muestra a continuación en la figura 2.3.

CAPITULO 2. MARCO TEORÍCO

PRINCIPIO

Solicitud de datos de entrada. No. de

tratamientos (a), No. De repeticiones (n),

datos reales del experimento y numero

de simulaciones NTSIM= No. Total de

repeticiones

CONT = 0

Generar las diferencias Estudientizadas

de los datos reales

SIM = 0

SIM = SIM + 1

Generar a*n observaciones de una

distribución N(0,1), los autores manejan

que es posible manejar una distribución

N(µ,σ)

Aplicar estadísticos de orden

Calcular las Diferencias Estudentizadas

de los datos simulados (DES):

DESij =

DESij

xi − x j

CMES

n

>

DE

No

No

SIM = NTSIM

Si

Valor P = CONT / NTSIM

END

Figura 2.3 Diagrama de flujo del algoritmo de la prueba D.E.

CONT = CONT + 1

Si

CAPITULO 2. MARCO TEORÍCO

Para reforzar lo anterior se menciona el concepto de Estadísticos de Orden que se muestra a

continuación:

1.5.1. Un ejemplo de la Prueba D. E.

Se desea comparar la eficiencia de 3 operadores en el manejo de una maquina. Para esto se

toman 2 observaciones del número de errores de cada operador durante una hora. Se

considera que ningún otro factor influye en las supuestas observaciones, totales y medias

pueden verse en la tabla 2.5.

OBSERVACIONES OPERADORES

OP 1

OP 2

OP 3

1

3

5

2

2

1

3

4

TOTALES

4

8

6

MEDIAS

2

4

3

Tabla 2.5 Resultados del experimento

Suponga que se desea comparar al operador 1 con el 2, ó sea probar T = T2, usando

estadísticas de orden esto es equivalente a probar Ho T(1) = T(3), donde T(1) es la media

observada del operador que ocupa la posición 1 y T(3) es la media observada del operador

que ocupa la posición 3. nótese que T(1) es la media correspondiente al operador 1 y T(3) la

del operador 2.

Paso 1: Calcular el estadístico de prueba.

Se calcula el ANOVA:

FV

GL

CS

CM

FC

TRAT

2

4

2

1

Ftab ( α =0.05)

CAPITULO 2. MARCO TEORÍCO

ERROR

3

6

2

(como Fc < Ftab no se rechaza la H0:

TOTAL

5

T1=T2=T3

10

Como se desea probar Ho: T1 = T2 (Ho: T(1) = T(3)):

DE =

x (3) − x (1)

CM E

n

p-value

=

4−2

2

2

=2

X

2

De éste estadístico se desean hacer cuatro simulaciones (B=4).Se asigna el valor inicial de

cero al contador de puntos que caen en la zona de rechazo (CR).

CR

0

Paso 2: Simulaciones.

En las simulaciones, se generan números aleatorios normales (N (0,1)) se asignan a las

observaciones y se calcula el estadístico correspondiente Note: I(P) = 1, si p cierta; I(P) = 0,

si p establecida.

CAPITULO 2. MARCO TEORÍCO

SIMULACIÓN 1

T1

T2

T3

1

-0.27

2.4

0.17

2

1.54

1.59

-0.16

Totales

1.27

3.43

0.01

medias 0.635 1.865 0.005

El ANOVA correspondiente:

FV

GL

SC

TRAT

2

3.596

ERR

3

1.8438

TOTAL

5

5.4233

CM

0.6146

Se desea probar: Ho : T(1) = T(3), la DE 5i = i-ésima DE calcula por simulación.

DEi5 =

1.865 − 0.005

0.6146

2

=3.36

Se actualiza el contador de puntos que caen en la zona de rechazo.

CAPITULO 2. MARCO TEORÍCO

CR + I(3.36>2)

Å0+1

Å1

SIMULACIÓN 2: Mismo procedimiento que en la Simulación 1. Actualizando el

“contador de rechazo” al final.

T1

T2

T3

1

0.21

-2.14

1.57

2

-1.54

0.01

2.00

TOTALES

-1.33

-2.13

3.57

MEDIAS

-0.665

-1.065

1.785

ANOVA:

FV

GL

SC

TRAT

2

9.523

ERR

3

3.935

TOTAL

5

13.458

CM

1.3

CAPITULO 2. MARCO TEORÍCO

Probar: Ho : T(1) = T(3).

DEi5 =

1.785 − (−1.065)

1.312

2

=3.52

Se actualiza el contador de puntos que caen en la zona de rechazo.

CR + I(3.52>2)

Å1+1

Å2

SIMULACIÓN 3: Mismo procedimiento que en la Simulación 2. Actualizando el

“contador de rechazo” al final.

T1

T2

T3

1

0.5

-0.5

-0.1

2

1.5

2.29

1.96

TOTALES

2.00

1.79

1.86

MEDIAS

1.00

0.895

0.93

CAPITULO 2. MARCO TEORÍCO

ANOVA

FV

GL

SC

TRAT

2

0.011

ERR

3

6.514 2.171

TOTAL 5

CM

6.525

Probar: Ho : T(1) = T(3).

DEi5 =

1.00 − 0.895

2.171

2

=0.1

Se actualiza el contador.

CR + I(0.1>2)

Å2+0

Å2

Simulación 4: Mismo procedimiento que en la Simulación 2.

T1

T2

T3

1 1.13

0.14

-1.17

2 1.16

-1.59

-0.12

TOTALES 2.29

-1.45

-1.29

-0.725

-0.645

MEDIAS 1.145

CAPITULO 2. MARCO TEORÍCO

ANOVA

FV

GL

SC

TRAT

2

4.5716

ERR

3

2.0481 0.6827

TOTAL 5

CM

6.5197

Probar: Ho : T(1) = T(3).

DEi5 =

1.145 − (−0.725)

0.6827

2

=3.20

Se actualiza el contador.

CR + I(3.20>2)

Å2+1

Å3

Paso 3: Cálculo del valor P:

Valor de P =

=

CR

# total de sim( B)

3

4

=0.75

CAPITULO 2. MARCO TEORÍCO

1.5.2. Estadísticos de Orden

Los estadísticos de orden, son también conocidos como ordinales, y son indispensables

para el planteamiento y desarrollo dentro de las pruebas de rango múltiple ya que son

importantes para ordenar las muestras aleatorias de las diversas poblaciones utilizadas.

Como su nombre lo indica su principal fin es “ordenar los datos” que serán utilizados

dentro de los experimentos. Para el caso de la presente investigación se utiliza el concepto

de Mood y Graybill (1972):

“Sea X1,X2,…,Xn una muestra aleatoria procedente de la densidad f(x) y suponga que se

ordenan las Y1,Y2,…,Yn en donde las Yi son las mismas que las Xi dispuestas en orden de

magnitud creciente Y1<Y2<…<Yn. Las Y1,Y2,…,Yn son conocidas como los estadísticos de

orden u ordinales de la muestra aleatoria X1,X2,…,Xn “

Parzen (1960) comparte el criterio de orden creciente de Mood y Graybill (1972)

Los estadísticos de orden son necesarios en las PRM porque es información que debe ser

incorporada a la prueba, ya que el investigador toma los datos y conciente o

inconcientemente ordena las medias, para posteriormente hacer las PRM

1.6. Tipos de Errores

Los tipos de errores que se pueden presentar en este tipo de pruebas pueden ser variados

por lo que a continuación se explicaran errores mas comunes. Sea

F = Familia de inferencias

P =Procedimiento de comparación múltiple para esta familia.

M ( F , P ) = número aleatorio de inferencias equivocadas.

N ( F ) = cardinalidad de la familia F (la cual solo es cierta en familias finitas).

CAPITULO 2. MARCO TEORÍCO

1.6.1. Familiwise Error Rate (FWE)

Es la probabilidad de que por lo menos una de las comparaciones hechas dentro de la

familia esté equivocada, es decir, la probabilidad de que el No. aleatorio de inferencias

equivocadas sea mayor a cero:

FWE ( F , P ) = Pr{M ( F , P ) > 0 }

1.6.2. Per-Family Error Rate

Cantidad que representa el valor esperado de errores dentro de una familia de inferencias,

su representación acorde a la notación presentada es, la esperanza del número aleatorio de

inferencias equivocadas es decir:

PFE ( F , P ) = E {M( F , P )}

1.6.3. Per-Comparison Error Rate

Valor que representa la probabilidad de falla para cada una de las comparaciones en forma

individual sin considerar la familia completa, esto es la esperanza del numero aleatorio de

inferencias equivocadas sobre la cardinalidad de la familia F es decir:

PCE = E {M( F , P )}

N(F )

La relación de los errores anteriores puede ser vista como:

PCE ≤ FWE ≤ PFE

Lo anterior indica que el Per-Family resulta una cota superior para el Familiwise y el PerComparison representa una cota inferior para el mismo (Ver Ruelas 2004).

Para más detalles ver Hochberg y Tamhane (1987).

CAPITULO 2. MARCO TEORÍCO

1.7. Control de los diferentes tipos de error.

En el tema de los diferentes tipos de error, una de las preguntas más comunes a responder

es ¿Cuál error es el que se debe de controlar en un proceso de comparación múltiple?

La respuesta a dicha pregunta varía demasiado según el punto de vista de los diferentes

autores, por ejemplo Tukey (1953), después de examinar los diferentes tipos de errores

llega a la conclusión de que el Familiwise (FWE) es el que debe ser controlado,

argumentando: “El FWE debe ser un error estándar, por lo tanto rara vez cualquier otro

tipo de error será apropiado controlar”, Tukey rechaza la importancia del PCE basándose en

la idea de que los errores deben permitirse incrementar en proporción al número de

comparaciones hechas, recordando que el PCE es una medida promedio del error

encontrado en cada comparación (Ver Ruelas 2004)

Los argumentos que este autor utiliza para sustentar la defensa del FWE son:

1.- Cuando los requerimientos de correcciones simultaneas para todas las inferencias

sean satisfechas, el FWE es la única opción de control.

2.- Para una familia infinita el FWE puede ser controlado, caso contrario al PFE.

3.- El controlar el FWE para la familia entera de inferencias potenciales asegura que

la probabilidad de cualquier error en un conjunto de inferencias determinado, pueda

estar controlado.

Otro autor que se promueve a favor de la idea de Tukey es Mollet (1981) que recomienda el

FWE porque… “La idea de que todas las comparaciones están correctas con una alta

probabilidad parece dar serenidad al investigador, caso contrario lo que le provoca observar

un número esperado de errores” (Ver Ruelas 2004)

Spjotvoll (1972), recomienda el uso del PFE para el caso de familias finitas, sustentando

sus razones en los siguientes puntos:

1.- El PFE es técnicamente más fácil de trabajar que el FWE.

2.- El PFE impone una pena directa en base a la proporción de errores.

CAPITULO 2. MARCO TEORÍCO

3.- El PFE es un límite superior del FWE por lo cual el control de este último va

implícito en el control del PFE.

Para los casos relacionados con investigaciones exploratorias, la idea es centrarse

fundamentalmente en una validez estadística como argumentan Hochberg y Tamhane

(1987), que será estipulada por los resultados de la exploración y el tipo de familia. Por

validez estadística debe entenderse a los niveles de probabilidad del error Tipo I.

Cuando se incurre en el error Tipo I se comete el error de rechazar la hipótesis nula cuando

esta debe ser aprobada; como caso contrario a esto existe el error Tipo II, sin embargo se

emplea con mayor frecuencia el Tipo I debido a que es más fácil de analizar y controlar.

Una consideración importante es el recalcar que la familia deberá ser especificada con

antelación para poder controlar cualquier tipo de error Hochberg y Tamhane (1987).

Estos mismos autores argumentan que el FWE presenta una ventaja en el control por

encima del PCE y del PFE, esto para el caso de familias infinitas, ya que controlar el FWE

a un nivel α provee un límite superior de α en el conjunto de inferencias seleccionado, por

el contrario el PCE no garantiza que la proporción de errores sea controlada en todo el

conjunto de inferencias seleccionadas a ese nivel α y el PFE no es muy dócil de controlar

en familias infinitas (Ver Ruelas 2004).

Es importante recalcar que sin importar el tipo de error que se decida controlar el

experimentador tiene la facultad de elegir el nivel de α que desea emplear. Si este requiere

una alta validez estadística para controlar sus errores los niveles tradicionales de α para las

inferencias simples más comunes se encuentra en los rangos de 0.01≤ α≤0.10, cuando el

experimentador tolera una baja validez estadística puede controlar α a niveles más liberales

como 0.10≤ α≤0.25. (Rangos dados por Hochberg y Tamhane (1987) para controlar los

niveles del FWE)

Para concluir con el análisis anterior es posible decir que es necesario determinar con

claridad la naturaleza del experimento así como lo que se desea alcanzar con la

investigación, para que así se pueda conocer el error que se quiere controlar.

CAPITULO 2. MARCO TEORÍCO

1.8. La transformación Inversa

Según Meyer una muestra de una variable aleatoria X,

puede unirse para obtener

información acerca de parámetros desconocidos asociados con la distribución de

probabilidades de X.

Por ejemplo, suponiendo que X tiene una distribución N(0,1) y queremos estudiar la

variable aleatoria

P(0 ≤ Y ≤

1

2

Y= e

−x

sea X. en especial, supongamos que queremos calcular

). A fin de obtener la respuesta exacta, necesitamos encontrar G, la fda de Y y

luego calcular G ( 1 ) –G(0).

2

Encontraríamos mucha dificultad para hacer esto. Sin embargo, podemos usar otro enfoque

que esta basado en la idea de simular el experimento que da origen a la variante aleatoria Y.

Específicamente, supóngase que tenemos una muestra aleatoria de la variable aleatoria

anterior, cuya distribución esta completamente especificada, X 1 ,…, X n . para cada X i

definimos la variable aleatoria Y i = e − xi sea X i . Luego, evaluamos la frecuencia relativa

n A /n, en donde n A es igual al numero de valores de Y i , sean y i que satisfacen

0 ≤ yi ≤

1

1

. Luego en n A /n es la frecuencia relativa 0 ≤ yi ≤ , y si n es grande, esta

2

2

1⎤

⎡

frecuencia relativa esta aproximada a P ⎢0 ≤ Y ≤ ⎥ según la ley de los grandes números.

2⎦

⎣

Para aplicar el procedimiento anterior, debemos encontrar un medio de generar una muestra

aleatoria X 1 ,…, X n . de la variable aleatoria cuya distribución es N(0,1)

Teorema: Sea X una variable aleatoria con fdp f y fda F. (Se supone que f (x)=0, x ∉ (a,b)

). Sea Y la variable aleatoria definida por Y= F −1 (X).

Luego Y esta distribuida uniformemente en [0.1]

CAPITULO 2. MARCO TEORÍCO

Y= F(X)

y

x

F

−1

(y)

Podemos usar ahora el resultado anterior a fin de generar una muestra aleatoria de una

variable aleatoria con una distribución específica.

Ejemplo: Se desean números aleatorios de EXP (3) (F(x)= 1 − e −3 x , x > 0

u= 0.83 (Número aleatorio de U (0,1), se iguala: 0.83 = 1 − e −3 x

Y se resuelve para x:

X = - 1/3 Ln (1- 0.83)

Este numero x es un numero aleatorio de EXP(3). Para generar una muestra aleatoria de

EXP(3) basta con obtener una muestra aleatoria de U(0,1) y a cada numero aplicarle la

transformación.

1.9. FORTRAN

FORTRAN es lenguaje de propósito general, principalmente orientado a la computación

matemática, por ejemplo en ingeniería. FORTRAN es un acrónimo de FORMULA

TRANSLATOR, y originalmente fue escrito con mayúsculas como FORTRAN. Sin

embargo la tendencia es poner sólo la primera letra con mayúscula, por lo que se escribe

actualmente como FORTRAN.

FORTRAN fue el primer lenguaje de programación de alto nivel. El desarrollo de

FORTRAN inicio en la década de 1950 en IBM y han habido muchas versiones desde

entonces. Por convención, una versión de FORTRAN es acompañada con los últimos dos

dígitos del año en que se propuso la estandarización. Por lo que se tiene:

CAPITULO 2. MARCO TEORÍCO

•

Fortran 66

•

Fortran 77

•

Fortran 90 (95)

La versión más común de FORTRAN actualmente es todavía FORTRAN 77, sin embargo

FORTRAN 90 esta creciendo en popularidad. FORTRAN 95 es una versión revisada de

FORTRAN 90 la cual fue aprobada por ANSI en 1996. Hay también varias versiones de

FORTRAN para computadoras paralelas. La más importante es HPF (High Performance

FORTRAN), la cual es de hecho el estándar.

Los usuarios deben ser cuidadosos con los compiladores de FORTRAN 77, ya que pueden

manejar un súperconjunto de FORTRAN 77, por ejemplo contienen extensiones no

estandarizadas. En pocas palabras es un lenguaje cuyas ventajas principales son la de

compatibilidad y la de naturalidad, es por eso que se va a utilizar para el desarrollo de esta

tesis.