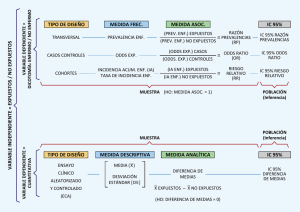

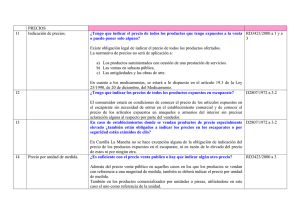

Tablas de contingencia

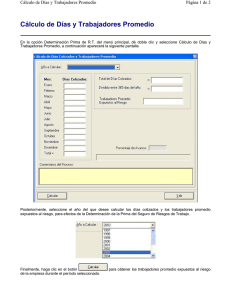

Anuncio