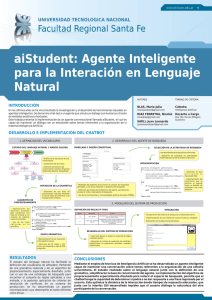

Comportamiento Adaptable de Chatbots Dependiente del Contexto

Anuncio