UNIVERSIDAD NACIONAL DE INGENIERÍA FACULTAD DE

Anuncio

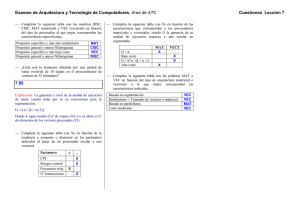

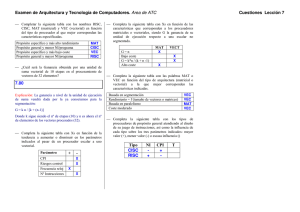

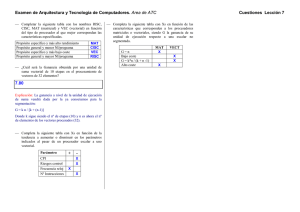

UNIVERSIDAD NACIONAL DE INGENIERÍA FACULTAD DE CIENCIAS SECCIÓN DE POSGRADO Y SEGUNDA ESPECIALIZACIÓN PROFESIONAL Tésis para Optar el Grado de Maestro en Ciencias con Mención en Matemática Aplicada TITULO Solución de una Ecuación Polinomial Matricial por el Método de Newton Por Julio César Barraza Bernaola Asesor Msc. William Carlos Echegaray Castillo Lima-Perú 2012 Tabla de Contenido 1 Preliminares 1.1 Producto de Kronecker . . . . . . . . . . . . . . . . . . . . . . . . . . . 1.2 Diagonalización Por Transformaciones Similares . . . . . . . . . . . . . 1.2.1 Descomposición de Schur . . . . . . . . . . . . . . . . . . . . . . 2 2 8 8 2 Cálculo Diferencial en Espacios Vectoriales Normados 2.1 Diferenciabilidad de Funcionales . . . . . . . . . . . . . . . . . . . . . . 2.1.1 Diferencial de Gateaux . . . . . . . . . . . . . . . . . . . . . . . 2.1.2 Diferencial de Fréchet . . . . . . . . . . . . . . . . . . . . . . . . 13 13 13 15 3 Teoría de Polinomios Matriciales 24 4 Cálculo de la Solvente de la Ecuación 4.1 Método de Newton . . . . . . . . . . 4.2 Convergencia del Método de Newton 4.3 Ejemplos Numéricos . . . . . . . . . Polinomial Matricial . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5 Aplicación 5.1 Grados de Libertad . . . . . . . . . . . . . . . . . . 5.2 Vibración Libre de un Edi…cio Simple . . . . . . . . 5.2.1 Ecuación de Rigidez para un Edi…cio Simple 5.2.2 Frecuencias Naturales . . . . . . . . . . . . . 6 Conclusiones . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 30 30 34 46 49 49 50 50 52 56 ii Dedicatoria El presente trabajo se la dedico a mi familia por todo el apoyo y las palabras de aliento. A mi madre, que Dios la tenga en su gloria, por sus enseñanzas y amor. A mi padre por brindarme los recursos para obtener una carrera y aconsejarme siempre. A mi esposa por estar a mi lado apoyándome siempre para cumplir mis objetivos. iii Agradecimientos Mi más sincero agradecimiento al Profesor Asesor Magister William Carlos Echegaray Castillo, al Ing. Leonardo Flores Gonzalez por su apoyo y colaboración en los problemas de vibraciones que aparecen en el campo de la ingeniería Civil. iv Resumen Sea P (X) = X m + A1 X m 1 + + Am 1 X + Am ; un polinomio matricial con Ai ; X matrices complejas de orden n n (i = 1; ; m) : En el presente trabajo de tesis implementaremos el método de Newton basado en la descomposición de Schur y la derivada de Fréchet para la resolución númerica de la ecuación polinomial matricial P (X) = 0; se da un teorema de existencia de la solvente de dicha ecuación y se prueba la convergencia del método cuando el punto inicial es próximo a una solvente simple. Presentamos un algoritmo y el programa que lo implementa, …nalmente utilizaremos el método propuesto para resolver un problema donde se presenta este tipo de ecuaciones v Abstract Let P (X) = X m + A1 X m 1 + + Am 1 X + Am ; a polynomial matrix with Ai ; X of complex matrices n n (i = 1; ; m) : This thesis will implement the Newton method based on the decomposition Schur and the derivative of Fréchet for the numerical resolution of equation polynomial matrix P (X) = 0; we give an existence theorem that the solvent equation and proves the convergence of especially when the point initial is close to a simple solvent. We present an algorithm and program that implements it, …nally we use the method proposed to resolve an issue where this type of equations. vi Notación A La conjugada transpuesta de A . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 8 coli A Columna i esima de la matriz A . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 2 diag (u) matriz diagonal formado por los elementos del vector u . . . . . . . . . . . . . . 29 DG T (x; h) Diferencial de Gateaux . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 13 Fm n Espacio de matrices de orden m n en el campo C ó R . . . . . . . . . . . . . . . . . 2 0 Derivada de Frechet de G en X y la dirección H . . . . . . . . . . . . . . . . . . . . 30 G (X) H Lf (x; h) Diferencial de frechet de la función f . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 20 L (X; Y ) Espacio de las transformaciones lineales del espacio X al espacio Y . . 17 P (X) Polinomio con coe…cientes matriciales con variable X . . . . . . . . . . . . . . . . . . 24 P( ) Matriz en lambda asociada al polinomio de matrices P (X). . . . . . . . . . . . . .24 [q1 ; q2 ; ; qn ] Matriz cuyas columnas son los elementos de los vectores qi : i = 1 n . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 25 T raz A Traza de la matriz A . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 2 vec A Vector formado por las columnas de la matriz A . . . . . . . . . . . . . . . . . . . . . . . . . 2 El producto de Kronecker . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3 k kF Norma de Frobenius . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 34 vii Introducción En el presente trabajo estudiamos las ecuaciones polinomiales matriciales del tipo: P (X) = A0 X m + A1 X m 1 + + Am 1 X + Am = 0 donde A0 ; A1 ; ; Am ; X 2 Cn n : Este tipo de ecuaciones polinomiales aparece en la teoría de sistemas de ecuaciones diferenciales, en el análisis dinámico de vibraciones [10], el estudio de los procesos casi aleatorio de nacimiento-muerte [8], en el problema con ruidos de Wiener-Hopf de las cadenas de Markov [3]. En el capítulo (1) y (2) introducimos los conceptos del producto de Kronecker y la descomposición de Schur, así como la derivada deFrechet en la cuál está basado el algoritmo del método de Newton para el cálculo de la solución de las ecuaciones polinomiales matriciales. En el capítulo (3) desarrollamos la teoria de los polinomios matriciales y su relación con las ecuaciones matriciales del tipo P ( ) = A0 m + A1 m 1 + + Am 1 + Am = 0 en la cuál se basa la aplicación que presentamos en la última parte de este trabajo En el capítulo (4) desarrollamos el Método de Newton para encontrar una solución de la ecuación polinomial matricial y hacemos el estudio de su convergencia. En el capítulo (5) se presenta un aporte del método propuesto para hallar el periodo de vibración de un edi…cio simple. 1 Capítulo 1 Preliminares 1.1 Producto de Kronecker Una noción que es bastante usado en el estudio de matrices y otras aplicaciones, es el producto Kronecker, producto directo ó producto tensor de matrices. Este producto es de…nido para dos matrices de tamaños arbitrarios sobre cualquier anillo. Estamos interesados en matrices sobre el campo de los escalares F = R ó C De…nición 1.1 ([1]). Sea la matriz A 2 F m n se de…ne el operador vec como 0 que pertenece a F nm 1 col1 A B C .. C vecA = B . @ A coln A Notamos que vecA es un vector columna de tamaño nm obtenido por el apilamiento de las columnas de la matriz A Proposición 1.1 ([1]). Sea A 2 F m n y B 2 Fn T raz (AB) = vecAT T m : Entonces, vecB = vecB T T vecA Prueba. De la de…nición de traza se tiene que T raz (AB) = T raz (AB) = n X f ili (A) coli (B) i=1 n X i=1 2 coli AT T coli (B) T raz (AB) = col1 AT T raz (AB) = vecAT T Proposición 1.2 ([1]). Sea A; B 2 F m n coln AT vecB 2 3 col1 (B) 6 7 .. 6 7 . 4 5 coln (B) : Entonces, vec (A + B) = vecA + vecB Prueba. De la de…nición 0 1 col1 (A + B) B C .. C vec (A + B) = B . @ A coln (A + B) 0 1 col1 A + col1 B B C .. C vec (A + B) = B . @ A coln A + col1 B 0 1 0 col1 A col1 B B C B . .. C+B .. vec (A + B) = B . @ A @ coln A col1 B vec (A + B) = vecA + vecB 1 C C A Ahora de…niremos el producto Kronecker De…nición 1.2. Sea A 2 F n m y B 2 F l k : Entonces, el producto Kronecker es denotado por A B y es de…nido por la matriz por bloques A a menudo denotaremos A 2 6 B=6 4 3 a11 B a12 B a1m B .. .. .. 7 .. . . . . 7 5 an1 B an2 B anm B B = (aij B) A diferencia del producto de matrices, el producto Kronecker A acerca del tamaño de la matriz A o de la matriz B. Observación 1.1. En general A B 6= B 3 A B no restringe Proposición 1.3 ([1]). Sea A; B 2 F n (A + B) C m y C 2 F l k : Entonces C = A B+B C (A + B) = C A+C B Prueba. De la de…nición (A + B) C = ((aij + bij ) C) (A + B) C = (aij C + bij C) (A + B) C = (aij C) + (bij C) (A + B) C = A de manera análoga se prueba C (A + B) = C Proposición 1.4 ([1]). Sea A 2 F n A B+B (B m ,B 2 F l C A+C k C) = (A B y C 2 F p q : Entonces B) C Prueba. De la de…nición 2 b11 C b12 C 6 . .. . C=6 . 4 . bl1 C bl2 C B luego t (B 3 b1k C .. 7 .. . . 7 5 blk C C) viene dado por t (B t (B 2 tb11 C tb12 C 6 . .. . C) = 6 . 4 . tbl1 C tbl2 C C) = (tB) C 3 tb1k C .. 7 .. . . 7 5 tblk C (1.1) tambien tenemos que A (B 2 6 C) = 6 4 a11 (B .. . C) a12 (B .. . C) an1 (B C) an2 (B C) 4 .. . a1m (B .. . C) anm (B C) 3 7 7 5 usando la ecuación (1.1) A (B A (B A (B 2 (a11 B) C (a12 B) C 6 .. .. C) = 6 . . 4 (an1 B) C (an2 B) C 2 a11 B a12 B a1m B 6 . . .. . . .. .. C) = 6 . 4 . an1 B an2 B anm B C) = (A B) C Proposición 1.5 ([1]). Sea A 2 F n (A m ,B 2 F l B) (C k .. . 3 7 7 5 (a1m B) .. . C (anm B) C 3 7 7 5 C y C 2 F m q ; y D 2 F k p : Entonces D) = AC BD Prueba. De la de…nición, tenemos (A B) (C 0 a11 B B . . D) = B @ . an1 B entonces el bloque ij de la matriz (A ((A ((A B) (C B) (C 10 a1m B c11 D B . .. C .. B . . . C A@ . anm B cm1 D D) es B) (C D))ij = h D))ij = m X 2 3 c D 1j i6 .. 7 7 aim B 6 4 . 5 cmj D ai1 B aik Bckj D = k=1 m X ((A B) (C D))ij = ((A B) (C D))ij = AC 1 c1p B .. C .. . . C A cmp D aik ckj k=1 ! m X aik ckj BD k=1 BD = (AC)ij BD BD lo cual prueba este teorema. Proposición 1.6. Si A 2 F n n y B 2 Fm (A B) 1 m =A 5 son matrices no singulares. Entonces 1 B 1 Prueba. Usando la proposición (1.5) tenemos (A B) A 1 B 1 = (A B) A 1 B 1 = I Proposición 1.7 ([1]). Sea x 2 F n 1 1 AA BB 1 I=I y y 2 F m 1 : Entonces xy T = x yT = yT x y vec xy T = y ; xn )T ; y = (y1 ; y2 ; Prueba. Sea x = (x1 ; x2 ; entonces xy xy T T 0 B B = B B @ 0 B B = B B @ (1.2) x ; ym )T x1 y 1 x1 y 2 x2 y 1 x2 y 2 .. . x1 ym x2 ym .. . xn y 1 xn y 2 1 x1 y T C x2 y T C .. C C=x . A xn ym 1 C C C C A (1.3) yT xn y T tambien de (1.3) xy T = y1 x y 2 x = yT ym x x aplicando la función vec a la última ecuación vec xy T Proposición 1.8 ([1]). Sea A 2 F n 0 B B =B B @ m y1 x y2 x .. . ym x 1 C C C=y C A ,B 2 F m vec (ABC) = C T Prueba. Considerando ei 2 Rl 1 con 1 en la i 6 l x y C 2 F l k : Entonces A vecB esima componente y ceros en los demas entonces coli BeTi = h 0 coli B 0 i de orden m l luego B= l X coli BeTi (1.4) i=1 por lo que ABC = A l X coli BeTi i=1 ABC = l X ! C= l X A coli BeTi i=1 A coli BeTi C i=1 aplicando la función vec tenemos l X vec (ABC) = vec A coli BeTi C i=1 ! de la proposición (1.2) tenemos vec (ABC) = vec (ABC) = l X i=1 l X vec A coli BeTi C vec A coli B C T ei T i=1 usando la ecuación (1.2) vec (ABC) = l X C T ei (A coli B) i=1 usando la proposición (1.5) tenemos vec (ABC) = l X CT A (ei coli B) i=1 vec (ABC) = C T A l X i=1 7 (ei coli B) ! C de (1.2) vec (ABC) = C T A l X vec coli BeTi i=1 vec (ABC) = C T A vec l X coli BeTi i=1 usando la ecuación (1.4) concluimos que vec (ABC) = C T 1.2 A vecB Diagonalización Por Transformaciones Similares Escoger o cambiar a un sistema de coordenadas mas apropiado es siempre deseable en el algebra lineal. Para un operador lineal L sobre un espacio de dimensión …nita V , el objetivo es encontrar una base B de V tal que la representación de L con respecto de la base B sea tan simple como sea posible. De…nición 1.3 ([14]). Dos matrices A y B de orden n n; se dice que son similares siempre que exista una matriz no-singular P tal que P 1 AP = B El problema fundamental es dada una matriz A, reducirla a la forma mas simple posible por medio de una transformación de similaridad. 1.2.1 Descomposición de Schur La descomposición de Schur usa una transformación de similaridad unitaria para transformar una matriz cuadrada arbitraria en una matriz triangular superior De…nición 1.4 ([13]). Sea A una matriz de orden m A es una matriz de orden n m 0 B B A =B B @ T a11 a21 a12 a22 .. .. . . a1n a2n 8 am1 am2 .. . amn n. La transpuesta de la matriz 1 C C C C A la conjugada transpuesta de A es la matriz 0 B B A =A =B B @ T a11 a21 a12 a22 .. .. . . a1n a2n am1 am2 .. . amn 1 C C C C A De…nición 1.5 ([13]). Sea u1 ; u2 ; ; uk 2 Cn : entonces los vectores ui son ortonormales si ( 0 si i = 6 j ui uj = 1 si i = j equivalentemente si U = [u1 u2 uk ] entonces U U = Ik donde Ik es la matriz identidad de orden k ortonormal. k: A la matriz U se le llama matriz De…nición 1.6 ([14]). Sea A una matriz de orden n n y sea U una matriz no-singular de orden n n: Entonces las matrices A y B = U 1 AU se dicen que son similares. También decimos que B es obtenido por una transformación de similardad. Teorema 1.9 ([14]). Sea A una matriz de orden n y B = U 1 AU similar a A. Entonces los valores propios de A y B son los mismos y tienen las mismas multiplicidades. Si ; x son un valor propio y vector propio correspondiente de A, entonces ; U 1 x son el valor propio y vector propio correspondiente de B. Prueba. Tenemos que det (U 1 1 ) det (U ) = det (U det ( I A) = det U det ( I A) = det det ( I A) = det ( I 1 U ) = det (I) = 1; luego det ( I I 1 U A) det (U ) AU B) Esto es, A y B tienen el mismo polinomio característico, y por tanto tienen los mismos valores propios y las mismas multiplicidades. Si ; x son un valor propio y vector propio correspondiente de A, entonces B U 1 x = 1 B U 1 x = U 1 B U 1 x = U U 9 AU Ax = U 1 x 1 U 1 x x así, de este modo ; U 1 x son el valor propio y vector propio correspondiente de B. Teorema 1.10 ([14]). Sea A 2 Cn n . Entonces existe una matriz unitaria U 2 Cn y una matriz triangular superior B 2 Cn n tal que n (1.5) A = U BU y los elementos de la diagonal de B son los valores propios de A Prueba. Sea 1 ; 2 ; ; n un ordenamiento de los valores propios de A. Sea x1 el vector propio correspondiente normalizado, esto es x x = 1: Podemos extender a una base de Cn ; y aplicando el proceso de Gram-Schmidt, obtener una matriz unitaria X = (x1 X2 ) : Entonces ! X AX = x1 X2 X AX = x1 X2 X AX = x1 Ax1 x1 AX2 X2 Ax1 X2 AX2 X AX = A ! x1 X 2 Ax1 AX2 1 x1 x1 1 X 2 x1 x1 AX2 X2 AX2 ! ! Dado que la matriz X es unitaria entonces x1 x1 = 1 y X2 x1 = 0; vector nulo de orden (n 1) 1: Luego ! AX x 1 2 1 X AX = 0 A1 Por tanto los valores propios de A1 son 2 ; ; n ; aplicando el mismo proceso a la matriz A1 2 C(n 1) (n 1) ; podemos obtener una matriz unitaria U2 tal que 2 U2 A1 U = 0 A2 1 0 0 U2 ! y haciendo V2 = ! tenemos que V2 es unitaria puesto que V2 V2 = 1 0 0 U2 U2 ! = 10 1 0 0 In 1 ! = In también XV2 es unitaria, puesto que (XV2 ) XV2 = V2 X XV2 (XV2 ) XV2 = I por lo que V2 X AXV2 es de la forma 0 B V2 X AXV2 = @ 1 1 0 2 0 A3 C A Continuando con la reduccón obtenemos matrices unitarias V3 ; V4 ; U = XV2 V3 ; ; Vn ; Vn 1 donde 1 es la matriz unitaria buscada y B = U AU Una versión estrictamente real del teorema (1.10) es enunciado en el siguiente teorema Teorema 1.11 ([14]). Si A 2 Rn 0 B B QT AQ = B B @ n ; existe una matriz ortogonal Q 2 Rn 1 A1 A2 0 donde cada Ai es una matriz real 1 propios complejos conjugados. ... Ak C C C 2 Rn C A n ;1 1; o una matriz real 2 k n tal que n 2 con un par de valores Prueba. Supongamos que la matriz A tiene un valor propio 2 C; y su vector propio correspondiente x 2 Cn ; por tanto y x son también valor y vector propio correspondiente de A; puesto que A 2 Rn n : Sea = + i ; x = u + iv: Entonces x+x ; 2 + = ; 2 vi = u = i= 11 x x 2 2 (1.6) (1.7) luego Au = A Au = x 2 Au = u Au = u x x x+x =A +A 2 2 2 x + = (u + iv) + (u 2 2 2 + + iv 2 2 v (de 1.7) iv) también x A (vi) = A 2 x 2 x 2 A (vi) = A (vi) = x 2 (u + iv) 2 (u iv) + 2 (de 1.7) A (vi) = u + iv 2 A (vi) = u i + iv de donde Av = u + v : Tenemos entonces Au = u v Av = u + v luego A u v = A u v = u v A u v = u v L Au Av donde ! L= notamos que los valores propios de L son u+ v = 12 +i y = i Capítulo 2 Cálculo Diferencial en Espacios Vectoriales Normados 2.1 Diferenciabilidad de Funcionales En este capítulo, trataremos la generalización de los conceptos de diferenciales, gradientes, para espacios normados, se introduce el diferencial de Gateaux de una transformación de un espacio vectorial a un espacio vectorial normado. 2.1.1 Diferencial de Gateaux Sea X un espacio de Banach, Y un espacio normado y T : D ! R una transformación de…nido sobre un dominio D X con rango R Y: De…nición 2.1 ([7]). Si T es una transformación de D hacia R; x 2 D X y sea h 2 X un elemento arbitrario, el diferencial de Gateaux DG T de T en x en la dirección h 2 X se de…ne como DG T (x; h) = lim T (x + h) !0 T (x) (2.1) cuando el límite existe. La existencia de la derivada Gateaux requiere la existencia de la diferencial de Gateaux. Pero también requiere que la derivada de…na un operador que sea lineal y acotada en la dirección que se toma la derivada. De…nición 2.2 ([7]). Sea T : X ! Y una transformación de un espacio vectorial X hacia un espacio vectorial normado Y: Una función DG T : X X ! Y es la derivada Gateaux en x 2 X y en la dirección y 2 X si 13 1. El diferencial de Gateaux DG T (x; h) = lim T (x + h) T (x) !0 existe para todo h 2 X 2. DG T (x; ) es lineal, y 3. La transformación DG T (x; ) es acotada La transformación T que usamos en el presente trabajo, actua desde un espacio vectorial normado X hacia un espacio vectorial normado Y T :X!Y y el diferencial de Gateaux DG T ( ; ) transforma DG T ( ; ) : X X!Y para cualquier x 2 X; la transformación DG T (x; ) : X ! Y es lineal y acotado. Frecuentemente usaremos la notación DG T (x; ) 2 L (X; Y ) Ejemplo 2.1. Se da X = Rn ; Y = R y f : X ! Y; si f (x) = f (x1 ; x2 ; ; xn ) con x = (x1 ; x2 ; ; xn ) 2 X es una funcional sobre Rn que tiene derivadas parciales continuas con respecto a cada variable xi . Entonces DG f (x; h) = lim f (x + h) f (x) !0 DG f (x; h) = rf (x) h por lo tanto la diferencial de Gateaux de f es DG f (x; h) = n X @f (x) i=1 14 @xi hi 2.1.2 Diferencial de Fréchet El diferencial de Gateaux generaliza el concepto de derivada direccional de las funciones reales en un espacio …nito-dimensional. La existencia del diferencial de Gateaux es un requerimento bastante débil dado que el diferencial de Gateaux puede existir y la derivada de Gateaux no, mientras que para que exista la derivada de Gateaux tiene que existir el diferencial de Gateaux, además el producto de dos funciones diferenciables Gateaux no necesariamente es diferenciable Gateaux , sin embargo, debido a que su de…nición no requiere de ninguna norma sobre X, es por lo que las propiedades del diferencial de Gateaux no son fácilmente relacionados con la continuidad. Cuando X es normado, una de…nición mas apropiada es dada por la diferencial de Fréchet. De…nición 2.3 ([7]). Sea T la transformación de…nida sobre un dominio abierto D X en un espacio vectorial normado X hacia un espacio vectorial normado Y: Si para un x 2 D …jo y para cada h 2 X existe una transformación lineal y acotada A tal que para todo > 0 existe > 0 = khk < =) kT (x + h) T (x) Ahk < khk (2.2) entonces se dice que T es diferenciable Fréchet en x y A se dice que es el diferencial Fréchet en x con incremento h: Esta de…nición es equivalente a decir que lim khk!0 kT (x + h) T (x) khk Ahk =0 (2.3) Proposición 2.1 ([9]). Si la transformación T tiene una diferencial de Fréchet, esta es única. Prueba. Supongamos que A1 y A2 son dos diferenciales de Fréchet de T: Como A1 y A2 son lineales y acotados entonces de la de…nicón (2.2) se tiene que para cada > 0 existe un > 0 tal que kT (x + h) T (x) A1 hk < khk kT (x + h) T (x) A2 hk < khk siempre que khk < 15 haciendo d (h) = T (x + h) T (x) tenemos kA1 h A2 hk = kd (h) kA1 h A2 hk k(d (h) kA1 h A2 hk 2 khk entonces A2 h (d (h) A1 h)k A1 )k + kd (h) A2 xk kA1 h A2 hk =0 h!0 khk lim Si u 2 D X; entonces tu ! 0; cuando t ! 0; donde u 6= 0; entonces kA1 (tu) A2 (tu)k =0 t!0 ktuk lim por la linealidad de A1 y A2 , A1 A2 es lineal kA1 (tu) A2 (tu)k ktuk kt (A1 A2 ) (u)k k(A1 A2 ) (tu)k = lim 0 = lim t!0 t!0 ktuk ktuk k(A1 A2 ) (u)k jtj k(A1 A2 ) (u)k = lim 0 = lim t!0 t!0 jtj kuk kuk k(A1 A2 ) (u)k 0 = kuk 0 = lim t!0 k(A1 A2 ) (u)k = 0 esto es para cualquier u 2 D X como T es acotado entonces T es continua ver [2] pag 25, entonces A1 A2 = 0 por tanto A1 = A2 : Teorema 2.2 ([2]). Si T es una transformación acotada en D una vecindad de x y si una transformación lineal A tiene la propiedad de la ecuación (2.3),entonces A es una transformación lineal y acotada, esto es, A es la derivada de Fréchet. Prueba. Como T es acotado existe un M > 0 tal que kT (x)k M para todo x 2 D: De la de…nición (2.2) se tiene que para = 1, existe un > 0 tal que k(T (x + h) T (x) 16 A (h))k khk entonces kAhk = kT (x + h) T (x) (T (x + h) T (x) kAhk kT (x + h)k + kT (x)k + k(T (x + h) kAhk 2M + khk ahora para kuk A (h))k T (x) A (h))k (2.4) 2M + 1, tenemos que k uk entonces kA ( u)k = kAuk 2M + luego tenemos kAuk 2M + (2.5) como kAk = sup (kAxk) kAxk kxk=1 tomando el supremo en la ecuación (2.5) sobre kuk kAk 1 2M + esto es, A es acotada. Teorema 2.3 ([2]). Si T es diferenciable en x, entonces es continua en x. Prueba. Sea A = T 0 (x) : entonces A 2 L (X; Y ) : Dado un > 0; elegimos un que < 1+kAk ; de aqui tenemos khk < entonces k(T (x + h) T (x) > 0 tal A (h))k < khk dado que T es diferenciable, luego kT (x + h) T (x)k = kT (x + h) T (x) Ah + Ahk kT (x + h) T (x)k kT (x + h) T (x) Ahk + kAhk kT (x + h) T (x)k khk + kAhk kT (x + h) T (x)k = khk (1 + kAk) < (1 + kAk) < khk + kAk khk por tanto T es continua en x: Teorema 2.4 ([2]). Sea f : Rn ! R Si cada derivada parcial Di f existe en un entorno 17 de x y es continuo en x entonces f 0 (x) existe y una fórmula para ello es f 0 (x) h = n X Di f (x) hi ; hn ) 2 Rn h = (h1 ; h2 ; i=1 Prueba. Sea ei = (0; 0; 0) el i-ésimo vector unitario y ; 1; 0; v0 = x vi = vi de aqui tenemos que los vectores v i y v i 1 1 + hi ei di…eren en una sola coordenada, entonces f (x) = f (v n ) f v 0 n X f vi f (x) = f vi f (x + h) f (x + h) 1 i=1 por el teorema del valor medio para funciones de una variable donde 0 < khk 1 i f vi f vi 1 = f vi f vi f vi 1 = hi Di f v i f vi + hi ei 1 1 + i hi ei < 1; entonces f (x + h) f (x) n X Di f (x) hi = i=1 khk khk 1 1 f (x + h) f (x) n X 1 n X hi Di f v i 1 + i hi ei i=1 Di f (x) hi n X Di f (x) hi i=1 = i=1 khk 1 n X i=1 18 hi Di f v i 1 + i hi ei Di f (x) usando la desigualdad triangular de Cauchy-Schwarz 1 khk f (x + h) n X f (x) Di f (x) hi i=1 v u n uX 1 khk khk t [Di f (v i 1 + i hi ei ) Di f (x)]2 i=1 1 khk f (x + h) n X f (x) v u n uX t [Di f (v i Di f (x) hi i=1 1 khk f (x + h) n X f (x) Di f (x) hi + i hi ei 1 + i hi ei Di f (x)]2 x)]2 i=1 como 1 + i hi ei ) i=1 v u n uX t [Di f (v i i=1 vi 1 x = k(h1 ; ; hi 1 ; i hi ; 0; ; 0)k khk cuando khk ! 0 y por la continuidad de Di f en x tenemos khk por tanto entonces n P 1 f (x + h) f (x) n X i=1 " 1 lim f (x + h) h!0 khk f (x) Di f (x) hi ! 0 n X # Di f (x) hi = 0 i=1 Di f (x) es la derivada de Fréchet. i=1 Teorema 2.5 ([2]). Sea f : Rn ! Rm ; y sea f1 ; f2 ; ; fn las componentes de la función f . Si todas las derivadas parciales Di f existen en un entorno de x y son continuas en x, entonces f 0 (x) existe, y 0 (f (x) h)i = n X Dj fi (x) hj j=1 para todo h 2 Rn Prueba. Sea J la matriz derivada de Fréchet en x : Jij = Di fj (x) Por la de…nición de la norma tenemos kf (x + h) f (x) khk2 Jhk2 " n 1 X = fi (x + h) khk2 i= 19 fi (x) n X j=1 Dj fi (x) hj #2 ahora como fi (x + h) fi (x) khk Pn j=1 Dj fi (x) hj entonces kf (x + h) por tanto lim h!0 Jhk2 f (x) khk2 kf (x + h) ! 0 para i = 1; f (x) khk !0 Jhk =0 esto es J es la derivada de Fréchet de f en x La derivada de Fréchet para una matriz de funciones f : Cn X es una transformación lineal L Cn n L ! Cn ;n n ! Cn n en el punto n E ! L (X; E) tal que para todo E 2 Cn n f (X + E) f (X) (2.6) L (X; E) = o (kEk) que es la derivada de Fréchet en X en la dirección E En adelante Lf denota la derivada de Frechet de la función f: A continuación demostraremos dos teoremas para obtener la suma y el producto de funciones f; g; h 2 Cn n Teorema 2.6 ([4]). Si g y h son diferenciable Fréchet en X entonces f = g + h es diferenciable Fréchet y Lf (X; E) = Lg (X; E) + Lh (X; E) Prueba. De la ecuación (2:6) f (X + E) f (X) = ( g + h) (X + E) f (X + E) f (X) = g (X + E) + h (X + E) f (X + E) f (X) = (g (X + E) f (X + E) f (X) = (o (kEk) + Lg (X; E)) + (o (kEk) + Lh (X; E)) f (X + E) f (X) = o (kEk) + o (kEk) + Lg (X; E) + Lh (X; E) 20 ( g + h) (X) g (X) g (X)) + (h (X + E) h (X) h (X)) entonces tenemos f (X + E) f (X) ( Lg (X; E) + Lh (X; E)) = o (kEk) + o (kEk) = o (kEk) por tanto existe la derivada de Fréchet y Lf (X; E) = Lg (X; E) + Lh (X; E) Teorema 2.7 ([4]). Si g; h son diferenciables Fréchet en X entonces f = gh es diferenciable Fréchet y Lf (X; E) = Lg (X; E) h (X) + g (X) Lh (X; E) Prueba. Tenemos f (X + E) = (gh) (X + E) f (X + E) = g (X + E) h (X + E) como g y h son diferenciable Fréchet entonces f (X + E) = (g (X) + Lg (X; E) + o (kEk)) (h (X) + Lh (X; E) + o (kEk)) f (X + E) = g (X) h (X) + g (X) Lh (X; E) + Lg (X; E) h (X) + o (kEk) f (X + E) = f (X) + g (X) Lh (X; E) + Lg (X; E) h (X) + o (kEk) por tanto f (X + E) f (X) (g (X) Lh (X; E) + Lg (X; E) h (X)) = o (kEk) por lo tanto f es diferenciable Fréchet y Lf (X; E) = Lg (X; E) h (X) + g (X) Lh (X; E) Proposición 2.8 ([6]). Sea f (X) = A0 X m + A1 X m 1 + Am donde Ai ; X 2 Cn con 0 i m: Entonces el diferencial de Fréchet viene dado por Lf (X; H) = m X i=1 ( m i X Aj X m j=0 Prueba. Lo haremos por inducción sobre m 21 (j+i) ! HX i 1 ) n (2.7) para m = 1; de la ecuación (2.7) Lf (X; H) = A0 H por lo tanto es verdadero Supongamos que se cumple para n = m, por tanto asumimos que Lf (X; H) = m X i=1 ( m i X Aj X m (j+i) j=0 ! HX i ) 1 (2.8) probaremos que es cierto para n = m + 1: Esto es para f (X) = A0 X m+1 + A1 X m + Am X + Am+1 probaremos que Lf (X; H) = m+1 X i=1 ( m+1 Xi Aj X m+1 (j+i) j=0 ! HX i 1 ) (2.9) de la ecuación polinómica f (X) = A0 X m+1 + A1 X m + f (X) = A0 X m + A1 X m 1 Am X + Am+1 + usando el teorema (2.6) con g = (A0 X m + A1 X m Am X + Am+1 1 + Am ) X y h = Am+1 : Entonces Lf (X; H) = Lg (X; H) + Lh (X; H) Lf (X; H) = Lg (X; H) ahora sea r = (A0 X m + A1 X m 1 Am ) y s = X; usando el teorema (2.7) tenemos + Lf (X; H) = Lr (X; H) s (X) + r (X) Ls (X; H) de la ecuación (2.8) Lr (X; H) = m X i=1 ( m i X Aj X m j=0 22 (j+i) ! HX i 1 ) además Ls (X; H) = H: entonces m X Lf (X; H) = i=1 m X Lf (X; H) = i=1 ( m i X Aj X m (j+i) j=0 ( m i X Aj X m (j+i) j=0 ! ! HX i 1 HX i ) ) X + A0 X m + A1 X m + A0 X m + A1 X m 1 1 + + Am H Am H haciendo un cambio de índice l = i + 1; tenemos Lf (X; H) = m+1 X l=2 ( m+1 Xl (j+l) ! m+1 (j+i) ! Aj X m+1 j=0 1 ) + A0 X m + A1 X m 1 + Am H i 1 ) + A0 X m + A1 X m 1 + Am H HX l entonces Lf (X; H) = m+1 X i=2 ( m+1 Xi Aj X j=0 HX (2.10) ahora de (2.9) tenemos que el primer término, esto es cuando i = 1; viene dado por m X j=0 m X j=0 m X Aj X m j HX 0 = m X Aj X m j H j=0 Aj X m j HX 0 = A0 X m H + A1 X m 1 H + Aj X m j HX 0 = A0 X m + A1 X m 1 + Am H Am H j=0 entonces en la ecuación (2.10) se tiene Lf (X; H) = m+1 X i=2 Lf (X; H) = ( m+1 X i=2 Lf (X; H) = ( m+1 X i=1 ( m+1 Xi Aj X m+1 (j+i) j=0 m+1 Xi Aj X m+1 (j+i) j=0 m+1 Xi Aj X m+1 (j+i) j=0 ! ! ! con lo cual queda probado la proposición. 23 HX i 1 HX i HX i 1 1 ) ) ) + m X Aj X m j HX 0 j=0 + m+1 X1 j=0 Aj X m+1 (j+1) HX 1 1 Capítulo 3 Teoría de Polinomios Matriciales P m En este capítulo se estudian los polinomios matriciales de la forma P (X) = m i=0 Ai X y la ecuación P (X) = 0; donde A0 ; A1 ; ; Am ; X son matrices de orden n n: Aquí se estudia algunos aspectos de la solución de la ecuación P (X) = 0, así como P m i su relación con la matriz de polinomios P ( ) = m i=0 Ai De…nición 3.1 ([11]). Una ecuación polinomial matricial se de…ne como sigue P (X) = A0 X m + A1 X m 1 + + Am 1 X + Am = 0 donde A0 ; A1 ; ; Am ; X 2 Cn n : Si A0 = I donde I es la matriz identidad de orden n es mónico. (3.1) n; entonces diremos que P (X) De…nición 3.2 ([11]). Una matriz S que satisface la ecuación (3.1) es llamado una solvente, o mas precisamente solvente derecha de P (X). En relación con el polinomio P (X) tenemos el polinomio matricial P ( ) = A0 m + A1 m 1 + + Am 1 + Am (3.2) el cuál nos lleva al problema de valores propios asociado a P ( ) P ( ) v = A0 m + A1 m 1 + + Am 1 + Am v = 0 (3.3) Si P ( 0 ) es singular, 0 es llamado valor propio polinomial y el vector propio v0 correspondiente a 0 es llamado vector propio polinomial de P ( ) ; esto es P ( 0 ) v0 = 0 24 (3.4) i Teorema 3.1 ([11]). Si un problema de valores propios polinomial (3.3) tiene un conjunto de n vectores propios linealmente independientes v1 ; v2 ; ; vn correspondientes a distintos valores propios 1 ; 2 ; ; n ; entonces Q Q 1 es una solvente de la matriz polinomial (3.1), donde Q = [v1 ; v2 ; ; vn ] y = diag ( 1 ; 2 ; ; n) Prueba. De la de…nición de P (X) P Q Q 1 = A0 Q Q P Q Q 1 = A0 Q P Q Q 1 = m Q m A0 Q 1 m 1 + A1 Q Q + A1 Q + A1 Q m 1 m 1 1 m 1 1 Q + + + + Am Q Q 1 1 + Am 1 Q Q + Am 1 Q + Am Q Q 1 + Am + Am QQ 1 1 Por otro lado tenemos que Am p Q p = [Am p p p 1 v1 ; Am p 2 v2 ; p p n vn ] ; Am para 0 p m entonces m X Am p Q p p=0 = " m X Am p p 1 v1 ; p=0 m X Am p p 2 v2 ; p=0 ; m X Am p=0 p p n vn # luego usando las ecuaciones (3.2) y (3.4) tenemos m X Am p Q p = A0 Q m + A1 Q m 1 + + Am 1 Q + Am Q = 0 p=0 por lo tanto P Q Q 1 =0 El siguiente teorema nos da información sobre el número de solventes de P (X) Teorema 3.2 ([11]). Supongamos que P ( ) en (3.3) tiene p valores propios distintos f i gpi=1 ; con n p mn; y el correspondiente conjunto de vectores p propios fvi gi=1 satisface la condición de Haar (cada conjunto de n vectores es linealmente independiente), entonces existe al menos np solventes diferentes de P (X) ; y exactamente igual si p = mn; que vienen dados por S = Qdiag ( i ) Q 1 ; Q = [q1 ; q2 ; ; qn ] donde el conjunto de valores y vectores propios f i ; qi gni=1 son elegidos de entre el conjunto de valores y vectores propios f i ; vi gpi=1 de P ( ) 25 Prueba. Como v1 ; v2 ; ; vp satisfacen la condición de Haar, entonces sean vi1 ; vi2 ; un subconjunto de n vectores propios asociados a los valores propios i1 ; i2 ; ; De…nimos la matrices Q y como Q = [vi1 ; vi2 ; ; vin ] = diag ( i1 ; i2 ; ; ; vin in in ) entonces del teorema (3.1) se tiene que Q Q 1 es una solvente de P (X) Ahora existen np conjuntos distintos de valores propios por tanto el polinomio P (X) tiene al menos np solventes. Si p = mn entonces P (X) tiene exactamente mn n solventes. Lema 3.1 ([11]). Sea el polinomio N ( ) = m P Rp m p ; Si Rp es una matriz triangular p=0 superior de orden n n, para p = 0; 1; ; m entonces n Y det (N ( )) = fj;j ( ) j=1 donde fj;j (t) = m P p=0 [Rp ]jj tm p Prueba. Como Rp es una matriz triangular superior entonces N ( ) es una matriz triangular superior, luego el det (N ( )) es el producto de los elementos de la diagonal, es decir n Y det (N ( )) = [N ( )]j;j j= además [N ( )]i;j = m X [Rp ]ij m p (3.5) p=0 para i = j tenemos [N ( )]j;j = m X [Rp ]jj m p p=0 [N ( )]j;j = fj;j ( ) por tanto det (N ( )) = n Y fj;j ( ) j=1 Teorema 3.3 ([11]). Sea P (X) = A0 X m + A1 X m 1 + + Am 1 X + Am una matriz polinomial con Ap = U Rp U para p = 0; 2; ; m; donde U es una matriz unitaria y las matrices Rp son triangulares superiores. Entonces, si para i; j = 1; 2; ; n; si;j 26 es una solución del polinomio de coe…cientes escalares fi;j (t) = m P p=0 [Rp ]ij tm p yi>j implica que fj;j (si;i ) 6= 0; entonces existe un solvente S de P (X) = 0 de la forma S = U RU para alguna matriz triangular superior R Prueba. De…namos N (X) = m X Rp X m p p=0 Si R es un solvente de N (X) = 0; esto es N (R) = 0 entonces P (U RU ) = A0 (U RU )m + A1 (U RU )m P (U RU ) = A0 U Rm U + A1 U Rm 1 U + 1 + + Am 1 U RU + Am + Am 1 U RU + Am U U por otro lado tenemos que Ap U = U Rp ; entonces P (U RU ) = U R0 Rm U + U R1 Rm 1 U + + U Rm 1 RU + U Rm U ! m X P (U RU ) = U Rp Rm p U = U (N (R)) U = 0 p=0 por lo tanto U RU es solución de P (X) = 0 Por tanto es su…ciente demostrar que existe una solvente de N (X) = 0 Para el problema de valores polinomial asociado N ( ) ; del lema (3.1) tenemos det (N ( )) = n Y fj;j ( ) j=1 luego la matriz N ( ) es singular si y solo si det (N ( )) = 0 esto es, el conjunto de todas las soluciones de fj;j ( ) = 0 para j = 1; ; n es tambien un conjunto de los valores propios de N ( ) : Para cada valor propio elegido i = si;i para i = 1; 2; ; n tenemos un vector propio asociado xi ; luego de la ecuación (3.3) podemos encontrar un vector propio xi resolviendo el sistema N ( i ) xi = 0 27 de la ecuación (3.5), obtenemos 0 B B B B N ( i ) xi = B B B @ 10 f1;1 ( i ) f1;2 ( i ) 0 .. . f2;2 ( i ) .. . 0 .. . fn 2;n 1 ( i) .. . fn 1;n 1 ( i) 0 0 .. . fn;n ( i ) CB CB CB CB CB CB CB A@ (i) x1 (i) x2 .. . (i) xn 1 0 C B C B C B C B C=B C B C B A @ 0 0 .. . 0 1 C C C C C C C A ahora como para i > j implica que fj;j (si;i ) 6= 0 entonces fjj ( i ) 6= 0 para j = 1; ;i 1 Como la matriz N ( i ) es triangular superior, podemos encontrar la solución del sistema usando el método de sustitución hacia atras. entonces fn;n ( i ) x(i) n = 0 (i) que xn = 0 es una solución trivial, continuando (i) fn 1;n 1 + fn ( i ) xn 1 fn ( i ) xn 1;n ( i ) x(i) n = 0 por lo anterior se tiene que (i) así xn 1 (i) 1;n 1 1 =0 = 0 es solución trivial, continuando de esta manera, obtenemos (i) xk = 0 en la ecuación i para k = i + 1; ;n (3.6) esima tenemos (i) (i) fi;i ( i ) xi + fi;i+1 ( i ) xi+1 + + fi;n ( i ) x(i) n = 0 usando (3.6) se tiene (i) fi;i ( i ) xi = 0 como i es valor propio de N ( ) ; se tiene que fi;i ( i ) = 0; luego (i) 0 xi = 0 (i) (i) luego xi es un escalar arbitrario, elegimos xi = 1 (i) para las ecuaciones k = i 1; i 2; ; 1 usando (3.6) y xi = 1; obtenemos el 28 sistema 0 B B B B B @ f1;1 ( i ) f1;2 ( i ) .. .. . . 0 .. .. . . 0 0 0 fi 0 .. . 1;i 1 (i) x1 1B B ... B (i) CB xi 1 CB B CB CB 1 .. CB . AB 0 fi 1;n ( i ) B B .. @ . .. . ( i) 0 1 C 0 C C B C B C B C B C=B C B C B C @ C C A 0 0 .. . 0 1 C C C C C C C A ahora como por hipótesis fk;k ( i ) 6= 0; entonces el sistema tiene rango igual a (i 1) (i) por lo que podemos obtener xk para k = i 1; i 2; ; 1. Por lo tanto para cada i = 1; 2; ; n el vector propio xi ; tiene la forma xi = (i) x1 (i) 1 (i) xi x2 Ahora con el conjunto de vectores x1 ; x2 ; formamos la matriz Q T 1 0 0 ; xn hallados por el método de arriba, Q = [x1 ; x2 ; ; xn ] 0 1 B B 0 1 B B . . Q = B .. . . 1 B . . .. B . . @ 0 0 0 1 1 C C C C C C C A el cual es no singular y por tanto los vectores fx1 ; x2 ; ; xn g forman un conjunto linealmente independiente. Por el teorema (3.1), la matriz triangular superior R el cual es solvente de N (X) = 0 puede ser obtenido por R = Qdiag( 1 ; 2 ; ; n )Q 1 Corolario 3.1 ([11]). Sea la ecuación polinomial matricial el cual tiene todos sus coe…cientes matriciales triangulares superiores ( o triangulares inferiores) y se cumplen las hipótesis del teorema (3.3). Entonces existe una solvente. Prueba. La prueba se induce directamente, pues en este caso Ap = Rp para p = 1; 2; ; m: 29 Capítulo 4 Cálculo de la Solvente de la Ecuación Polinomial Matricial Este capítulo trata de la resolución númerica de la ecuación P (X) = A0 X m + A1 X m 1 + + Am 1 X + Am = 0 El algoritmo utilizado es el método de Newton, el cálculo está basado en la derivada de Frechet y la descomposición de Schur, también trata acerca de la convergencia del método. 4.1 Método de Newton El método de Newton para una función real f : R ! R; es un proceso iterativo para resolver la ecuación f (x) = 0; basado en la existencia de la derivada de f en cada paso y en la elección de un punto inicial próximo que garantice la convergencia, esto es Dado x0 f (xk ) + f 0 (xk ) hk = 0 xk+1 = xk + hk 9 > = > ; k = 0; 1; El método iterativo de Newton, es también utilizado para encontrar la solución de la ecuación matricial no lineal G (X) = 0 (4.1) donde G : Cn n ! Cn n : De…nimos Hk 2 C n n como la solución de la ecuación lineal G (Xk ) + G0 (Xk ) Hk = 0 30 (4.2) donde el operador lineal G0 (X) H : Cn n ! C n n es la derivada de Fréchet de G en X y la dirección H. Entonces el método iterativo de Newton para la ecuación matricial no lineal (4.1) puede ser de…nido por 9 > Dado X0 = 0 k = 0; 1; G (Xk ) + G (Xk ) Hk = 0 > ; Xk+1 = Xk + Hk Por lo tanto, cada paso del método de Newton implica encontrar la solución H 2 Cn n de la ecuación lineal G0 (Xk ) Hk = G (Xk ) (4.3) Para la ecuación polinomial matricial P (X) = 0; usando la ecuación (2.7), se tiene que la ecuación (4.2) puede ser reemplazada por P 0 (X) H = m X i=1 ( m i X Aj X m (j+i) j=0 ! HX i 1 ) = (4.4) P (X) Encontraremos las solventes de la matriz polinomial resolviendo la ecuación lineal (4.4). Usaremos el producto de Kronecker y la función vec: Usando el operador vec, entonces vec (P 0 (X) H) es representado por + Bm HX m vec (P 0 (X) H) = vec B1 H + B2 HX + 1 usando la proposición (1.2) vec (P 0 (X) H) = vec (B1 HI) + vec (B2 HX) + + vec Bm HX m 1 usando la proposición (1.8) vec (P 0 (X) H) = (I vec (P 0 (X) H) = 0 vec (P (X) H) = vec (P 0 (X) H) = B1 ) vec (H) + X T I B1 + X T m X XT i=1 m X X i 1 T i 1 i=1 B2 vec (H) + + XT B2 + ! Bi + m 1 XT m 1 Bm vec (H) Bm vec (H) vec (H) m i X Aj X m (j+i) j=0 !! (4.5) vec (H) donde Bp = A0 X m p + A1 X m (p+1) + 31 + Ap ; p = 1; 2; ;m (4.6) y D= m X X m i X T i 1 i=1 Aj X m (j+i) j=0 ! entonces (4.7) Dvec (H) = vec ( P (X)) el cual es un sistema lineal de n2 n2 En el siguiente paso reduciremos el tamaño de la ecuación (4.7) a n Dado X 2 Cn n , calculamos la descomposición de Schur de X n: Q XQ = R donde Q es una matriz unitaria y R es una matriz triangular superior. Entonces QRk Q = X k k2Z sustituyendo esta ecuación en (4.4) tenemos P 0 (X) H = m X i=1 ( m i X Aj X m (j+i) j=0 ! HQRi 1 Q ) = P (X) ) = P (X) haciendo H 0 = HQ P 0 (X) H = m X i=1 ( m i X Aj X m (j+i) j=0 ! H 0 Ri 1 Q por tanto B1 H 0 Q + B2 H 0 RQ + + Bm H 0 Rm 1 Q = P (X) de donde obtenemos B1 H 0 + B2 H 0 R + + Bm H 0 Rm 1 = P (X) Q esto es P 0 (R) H 0 = B1 H 0 + B2 H 0 R + + Bm H 0 Rm P i m (j+i) donde C = P (X) Q; Bi = m : j=0 Aj X Ahora tomamos la función vec en la ecuación (4.8) 1 vec (P 0 (R) H 0 ) = vec B1 H 0 + B2 H 0 R + + Bm H 0 Rm m X i 1 0 0 RT Bi vec (H 0 ) vec (P (R) H ) = i=1 32 (4.8) =C 1 haciendo ~= D m X RT i 1 Bi i=1 ~ es una matriz de orden n2 donde D ~ =I D n2 ; tenemos B1 + RT + RT B2 + m 1 Bm luego ~ ij = Iij B1 + RT D ij B2 + ~ ij = Iji B1 + [R] D B2 + ji 0 ~ ij = Rji B1 + [R]ji B2 + D ~ ij = D m X Rk 1 ji + h RT + Rm + Rm m 1 1 ji i ij Bm Bm 1 ji Bm Bk k=1 ~ es una matriz triangular inferior por bloques, como R es triangular superior entonces D luego 0 1 ~ 11 D C B ~ ~ 22 C B D21 D ~ C B D=B . ... C . A @ . ~ n1 D ~ nn D por tanto nos queda el sistema ~ Dvec (H 0 ) = vec (C) usando la sustitución por bloques hacia adelante ~ 1 c1 h01 = D 11 0 ~ 1 c2 h = D ~ 1 h0 1 D 21 .. . ~ nn1 cn = D ~ n11 h0 1 D 2 h0n donde h0i y ci son la i 22 1 1 esima columna de la matriz H 0 y C respectivamente. Algoritmo 1. Dada las matrices R; B1 ; B2 ; y (4.8) y números positivos i; j (i j y i; j for r = 1 : m ~ ij ~ ij + Rr D D ~ n;n1 1 h0 n D (j; i) Br 33 ; Bm las cuales estan de…nidas en (4.6) ~ ij n) el siguiente algoritmo calcula D end Algoritmo 2. (Solución de la ecuación P 0 (X) H = P (X) por descomposición de Schur). Dado A0 ; ; Am ; X 2 Cn n y usando la descomposición de Schur de X; X = QRQ : El algoritmo encuentra H 2 Cn n el cual es solución de P 0 (X) H = P (X) en (4.4) Bm A0 ; R1 I for i = 1 : m 1 Bm i Bm i+1 X + Ai Ri+1 Ri R end C (B1 X + Am ) Q for i = 1 : n d 0 for j = 1 : i 1 ~ ij Use el algoritmo (1) y calcule D ~ ij H(:; j) d d+D end ~ ii Use el algoritmo (1) y calcule D ~ 1 (C (:; i) d) H(:; j) D ii end H HQ 4.2 Convergencia del Método de Newton En este sección se muestra que el método de Newton converge cuadráticamente cuando el punto inicial esta lo su…cientemente cerca de una solvente simple. Estableceremos primero que k k es la norma de Frobenius si se trata de matrices y la norma euclideana si se trata de vectores. De…nición 4.1 ([6]). Diremos que P 0 (X) es regular, si la transformación P 0 (X) es biyectiva. Proposición 4.1. P 0 (X) es regular si y solo si inf kHk=1 kP 0 (X) Hk > 0 Prueba. Dado que el operador P 0 (X) es regular si y solo es inyectivo, esto es si y solo si existe el operador inversa de P 0 (X) denotado por inv (P 0 (X)) entonces inf H2X 1 kP 0 (X) Hk = inf kP 0 (X) Hk = >0 kHk=1 kHk kinv (P 0 (X))k 34 Lema 4.1 ([6]). Dada las matrices Aj ; Bj ; A; B 2 Cn polinomial de…nido en (3.1) tenemos n y la correspondiente matriz 1. (a) kAk = kvec (A)k (b) vec ( A + B) = vec (A) + vec (B) para todo ; ! n n P P (c) vec Aj XBj = BjT Aj vec (X) j=1 2C j=1 2 (d) vec (P 0 (X) H) = P (X) vec (H) donde la matriz P (X) 2 Cn dado por ! m i m X X i 1 Aj X m (j+i) P (X) = XT n2 y esta j=0 i=1 (e) P 0 (X) es regular si y solo si P (X) es una matriz no singular, y entonces c = inf kP 0 (X) Hk = min kP (X) vec (H)k > 0 kHk=1 Prueba. kHk=1 1. (a) De la de…nición de norma de frobenius tenemos kAk = por otro lado n X n X a2ij i=1 j=1 ! 12 0 1 col1 A B C .. C vec (A) = B . @ A coln A tomando la norma euclideana ! 21 kvec (A)k = n X kvec (A)k = n X n X kaij k ! 12 kvec (A)k = n X n X kaij k2 ! 12 j=1 kcolj Ak2 j=1 i=1 i=1 j=1 2 (b) Tenemos que vec ( A) = vec (A) y usando la proposición (1.2) vec ( A + B) = vec ( A) + vec( B) vec ( A + B) = 35 vec (A) + vec(B) (c) Usando la proposición (1.2) tenemos que vec n X Aj XBj = j=1 n X vec (Aj XBj ) j=1 por otro lado de la proposición (1.8) se tiene que vec (ABC) = C T entonces n X n X vec (Aj XBj ) = j=1 A vecB BjT Aj j=1 ! vec (X) con lo que se prueba que vec n X n X Aj XBj = j=1 BjT Aj j=1 ! vec (X) (d) Este item ya fue probado, ver la ecuación (4.5) (e) De la de…nición P 0 (X) H es regular si y solo si la transformación P 0 (X) es biyectiva esto es si y solo si la transformación P 0 (X) tiene inversa si y solo si la ecuación vec (P 0 (X) H) = P (X) vec (H) = P (X) tiene una única solución, esto es si y solo si P (X) es una matriz no-singular, entonces c = inf kP 0 (X) Hk > 0 kHk=1 de la proposición (4.1). Proposición 4.2 ([6]). Sean m 2 N; y A; B; C 2 Cn 1. (a) kAm (b) Am Bmk Bm c kA m P Cj Bk donde c = m P1 (A B) C m j kA j=1 con m X m c1 = kA j j=2 Bk j 2 kAk 36 m j matrices. Entonces kAkj kBkm j=0 1 n ; 1 j Bk (c1 kA c2 = m m X2 j=0 Bk + c2 kA kCkj kAkm j 2 Ck) Prueba. El primer item lo haremos por inducción matemática sobre m para m = 1; tenemos que kAm B m k = kA kA Bk Bk con c = 1 Suponiendo que se cumple para m entonces debemos probar que se cumple para m + 1 Am+1 B m+1 = 1 2Am+1 2 2B m+1 sumando y restando los términos Am B; B m A y agrupando convenientemente Am+1 Am+1 Am+1 Am+1 B m+1 = 1 Am+1 Am B B m+1 B m A + Am+1 + Am B B m+1 + B m A 2 1 m+1 B = kAm (A B) B m (B + A) + Am (A + B) + B m (A B)k 2 1 m+1 = k(Am + B m ) (A B) + (Am B m ) (A + B)k B 2 1 m+1 B k(Am + B m )k k(A B)k + k(Am B m )k k(A + B)k 2 usando la hipótesis de inducción Am+1 B m+1 Am+1 B m+1 Am+1 B m+1 Am+1 B m+1 Am+1 B m+1 1 k(Am + B m )k k(A B)k + c kA Bk k(A + B)k 2 1 k(A B)k (kAm + B m k + c kA + Bk) 2 1 k(A B)k (kAkm + kBkm + (kAk + kBk) c) 2 m X1 1 k(A B)k kAkm + kBkm + (kAk + kBk) kAkj kBkm 2 j=0 1 k(A 2 B)k kAkm + 1 k(A = 2 1 = k(A 2 1 k(A = 2 B)k m X1 j=0 m X j=0 B)k m X j=0 B)k m X j=0 kAkj kBkm kAkj kBkm kAkj kBkm j j j m j kAk kBk 37 j + kBkm + + kBkm + + kBkm + + m X j=0 j m X1 j=0 m X1 j=0 m X j=1 kAkj+1 kBkm kAkj+1 kBkm kAkj kBkm m j kAk kBk ! j 1 j ! 1 j 1 j ! ! ! de donde Am+1 B m+1 k(A m X B)k j=0 kAkj kBkm j ! con lo cuál queda establecido el item (a) Ahora probaremos el item (b) Sea E = B A; entonces desarrollando el binomio de Newton B m = (A + E)m tenemos que término 1 : Am X término 2 : términos que contienen a E X término 3 : términos que contienen a E; E y todos los demás términos, entonces B m = (A + E)m = Am + m X1 Ai EAm 1 i i=0 + X Al EAi EAj + l+i+j=m 2 luego m m A B = m X1 Ai EAm X 1 i i=0 Am Bm m X Cj 1 (A Al EAi EAj + l+i+j=m 2 B) C m j m X1 = j=1 Ai EAm 1 i i=0 X m X Cj 1 B) C m (A j j=1 Al EAi EAj + l+i+j=m 2 m A B m m X C j 1 (A B) C m j = j=1 m X1 i A (A m 1 i B) A i=0 X m X A B m X Cj 1 (A j=1 38 B) C m j (A A EAi EAj + tomando la norma de Frobenius m 1 j=1 l l+i+j=m 2 m Cj r1 + r2 B) C m j donde m X1 r2 = Ai (A B) Am m X 1 i i=0 Cj 1 (A B) C m j Cj 1 (A B) C m j Aj 1 + Aj j=1 haciendo j = i + 1 m X r2 = A j 1 m X m j (A B) A j=1 m X r2 = j 1 A (A j=1 B) A m X m j j=1 m X r2 = Cj 1 1 (A Aj 1 B) C m j j=1 j 1 A (A B) A m X m j j=1 Aj 1 B) C m j B) C m (A j j=1 m X Cj 1 Aj 1 (A j=1 m X r2 = Aj 1 (A B) Am j Cm m X j j=1 Cj 1 (A B) C m (A B) C m j j=1 entonces tenemos r2 m X Aj 1 B) Am (A j Cm j + j=1 r2 kA m X Cj 1 Aj 1 j j=1 Bk m X j=1 kAkj 1 Am j Cm j + kA Bk m X Aj 1 Cj j=1 usando la parte (a) de esta proposición convenientemente, tenemos que m j 1 A m j Aj 1 C m j Cj 1 kA Ck kA Ck X l=0 j 2 X l=0 39 kCkl kAkm kCkl kAkj 2 l j 1 l 1 kCkm j entonces r2 kA Bk kA Ck m X j=1 + kA r2 kA Bk kA Ck m X j=1 m j 1 kAkj X 1 l=0 Bk kA "m j 1 X l=0 Ck kA Bk kA m X2 + t=m j r2 kA kCkl kAkm + m X2 l=m j r2 donde c2 = m kA Ck m X j=1 Ck j=1 Ck # j=1 Bk kA Ck m r2 kA Bk kA Ck c2 l=0 # m X kA kCkl kAkm m j j 2 X l=0 + j 2 X l=0 40 l=0 m X2 m X2 l=0 2 l l=0 "m j 1 X 2 l r2 m P2 2 l "m j 1 X 2 t m X kCkl kAkm Bk kA kCk j 1 l l kCk kAk kCkl+m j; tenemos kCkt kAkm Bk kA m X j=1 haciendo el cambio de variable t = l + m r2 kCkl kAkm ! l=0 kCkl kAkm 2 l kCkl kAkm 2 l l m 2 l kCk kAk kCkl kAkm 2 l ! j j 2 l kAkj ! 2 l # tambien X r1 = Al EAi EAj + l+i+j=m 2 X r1 l+i+j=m 2 X r1 l+i+j=m 2 kAkl kEk kAki kEk kAkj + kAkl+i+j kEk2 + r1 kA Bk kA r1 kA Bk (c1 kA donde c1 = Pm j=2 m j kAkm j m X Bk l+i+j=m 3 m kAkm j j=2 kA X kAkl+i+j kEk3 + j Bkj 2 P 0 (Y ) Hk m P Am i X i y las matrices i=0 X; Y; H 2 Cn n y b = max fkXk ; kY k ; kHkg. Si el max1 l m kAl k = a entonces P (X) 2 Bk) Teorema 4.3 ([6]). Dada la matriz polinomial P (X) = kP (X + H) Bkj kA ! 2m+1 abm 2 kHk (kHk + kX Y k) si b 1 y P (X + H) = P (X) + P 0 (Y ) H + O kHk2 cuando kHk ! 0 Prueba. Tenemos que P (X + H) P (X) = m X Am i (X + H)i Xi i=1 además P 0 (Y ) H = m X Am i=1 i i X Y j 1 HY i j j=1 luego entonces kP (X + H) kP (X + H) P (X) 0 P (Y ) Hk = m X Am i i (X + H) X i X i i=1 P (X) P 0 (Y ) Hk = m X = Am i i=2 Am i (X + H)i i X Xi Y j 1 HY i j j=1 X i i (X + H) i X j=1 41 HY i j j=1 i=2 m X Y j 1 Y j 1 ( H) Y i j ! ! ! kP (X + H) P (X) P 0 (Y ) Hk m X i=2 Xi kAm i k i X (X + H)i Yj 1 Yj 1 ( H) Y i j j=1 aplicando la proposición (4.2) con A = X; Xi (X + H) i X i B = X + H; ( H) Y i j C=Y kHk (c1 kHk + c2 kX j=1 ! Y k) entonces kP (X + H) 0 P (X) a kHk P (Y ) Hk m X i=2 " i X i kHk kHkj j j=2 + kX como kXk ; kY k ; kHk kP (X + H) ahora bi P (X) Y ki i 2 X j=0 2 kXki j kY kj kXki j 2 # b con b > 1 entonces P 0 (Y ) Hk a kHk m X i=2 " i X i i kHk b j j=2 2 + kX Y ki i 2 X bi 2 j=0 # bn 2 , luego 2 kP (X + H) P (X) P 0 (Y ) Hk a kHk bn a kHk bn a kHk bn 2 2 m X i=2 2 m X i=2 " " " i X i kHk j j=2 i X i kHk j j=2 m X i X i kHk j i=2 j=2 + kX + kX + kX Yk Y ki i 2 X j=0 Y k i (i m X i (i # 1 # 1) # 1) i=2 por propiedades de sumatorias i X i j j=2 y que i (i 1) kP (X + H) 2i para todo i P (X) P 0 (Y ) Hk = 2i 1 i 1 entonces a kHk bn 42 2 " kHk m X i=2 2i 1 i + kX Yk m X i=2 2i # como m X m X i 2 i=2 m X 2i 1 i=0 m X i i=2 2i = 2m+1 2i 1 2m+1 y 2m+1 i=2 entonces kP (X + H) P (X) P 0 (Y ) Hk kP (X + H) P (X) P 0 (Y ) Hk a kHk bn kHk 2m+1 + kX 2 abn 2 2m+1 kHk (kHk + kX Y k 2m+1 Y k) para la otra aseveración hacemos Y = X; entonces kP (X + H) P 0 (X) Hk P (X) abn 2 2m+1 kHk2 con lo que queda probado el teorema. Teorema 4.4 ([6]). Supongase que S 2 Cn n es una solvente simple de la ecuación polinomial P (X) = 0 y P0 (S) es regular. Entonces, si la matriz inicial X0 esta su…cientemente cerca de S, el algoritmo Xk+1 = Xk Q (Xk ) con P 0 (Xk ) Q (Xk ) = P (Xk ) converge cuadraticamente a S. Mas precisamente. Si kX0 SkF = "0 < " = min n c0 o ; c donde c = 2m+1 a (1 + kSk)m 2 con a = maxr=1;:::;m fkAr kg y c0 = inf fkP 0 (Xk ) Hk ; kHkF = 1; kX Sk g > 0 para 2 (0; 1] su…cientemente pequeño, entonces tenemos 1. (a) i. lim Xk = S k!1 ii. kXk iii. kXk+1 Sk Sk "0 q k con q = c c0 kXk Prueba. Sea b = 1 + kSkF y X 2 Cn Por propiedad de normas kX SkF = kvec (X c " c0 0 2 < 1 para k = 0; 1; 2; : : : ; Sk para k = 0; 1; 2; : : : ; n tal que kX SkF < " S)k = kvec (X) 43 vec (S)k " tambien jkvec (X)k vec kSkj < kvec (X) vec (S)k " por lo tanto kvec (X)k vec kSk + " luego kXkF kSkF + " 1 + kSkF = b Como c0 > 0, por la proposición (4.1) la derivada de Fréchet es regular en fX 2 Cn n = kX SkF < "g ; luego la función (X) está bien de…nido por (X) = X P 0 (X) Q (X) = P (X) Q (X) ; para toda X tal que kX SkF < " Como S es solvente de P (X) ; usando el lema (4.1) y el teorema (4.3) k (X) Sk = kX Q (X) = kX k (X) S Sk Q (X)k = kvec (X S = kvec (X S) vec (Q (X))k = vec (X S) vec P 0 (X) = vec (X S) P (X) Sk = P (X) 1 Q (X))k 1 1 P (X) vec (P (X)) (P (X) vec (X S) vec (P (X))) usando la proposición (4.1) k (X) Sk k (X) Sk k (X) Sk k (X) Sk k (X) Sk 1 c0 1 c0 1 c0 1 c0 1 c0 kP (X) vec (X S) kvec (P 0 (X) (X S)) kvec (P 0 (X) (X S) P (S) P 0 (X) (X vec (P (X))k P (X))k kP 0 (X) (X S) P (X)kF kP 0 (X) (X S) P (X) + P (S)kF usando el teorema (4.3) con H = (X kP (X) vec (P (X))k S) entonces c kX S)kF c kX 44 Sk (kX Sk2 Sk + kX Xk) por tanto k (X) c kX c0 Sk Sk2 (4.9) La prueba del item (ii) y (iii) se sigue por inducción sobre i: Por hipótesis, kX0 SkF = "0 < " y por lo tanto X1 = X0 Q (X0 ) c "0 ; como por de…nición c0 esta bien de…nido, sea q = "0 < c c0 ! "0 < 1 ! q < 1 c c0 de la ecuación (4.9) se tiene que k (X0 ) Sk kX1 Sk c kX0 c0 c kX0 c0 Sk2 Sk2 y tambien tenemos que kX1 Sk = kX1 Sk c c kX0 Sk2 = "20 c0 c0 c "0 "0 = "0 q < " 0 c0 Suponiendo que la a…rmación del item (ii) y (iii) es valida para i probaremos que es valida para i + 1 kXi+1 SkF = k (Xi ) SkF ahora por la ecuación (4.9) kXi+1 como c kXi c0 c kXi c0 SkF Sk2 c kXi c0 Sk2 Sk kXi Sk por hipotesis de inducción c kXi c0 Sk kXi Sk c kXi Sk "0 q i c0 q kXi Sk q"0 q i = "0 q i+1 entonces kXi+1 SkF 45 "0 q i+1 esto prueba los item (ii) y (iii) Ahora para la prueba del item (i), teniendo en cuenta que q < 1 kXi+1 "0 q i+1 < "0 < " SkF lo cuál prueba que la sucesión de matrices fXi+1 g es convergente y converge a S 4.3 Ejemplos Numéricos En esta sección presentamos algunos resultados de la solución de ecuaciones polinomiales matriciales, los cuales fueron hechos con Matlab, las iteraciones para el método de Newton son terminados cuando el error residual de P (Xk ) kA0 kF kXk km F donde u = 1:1 (10 16 kP (Xk )kF + kA1 kF kXk km F 1 + kAm kF + < nu ) y n es el orden de las matrices. Ejemplo 4.1. Sea el polinomio matricial 1 2 2 P (X) = X + 6 9 ! 0 12 2 14 X+ ! utilizando el punto inicial 11:6517 0 0 11:6517 X0 = se obtiene la solución S1 = 4 0 2 2 ! y S2 = ! 1 2 0 3 ! respectivamente, ambos con 10 iteraciones. Ejemplo 4.2. Sea el polinomio matricial P (X) = 10000 10000 ! 193638:3089074608 0 0 193638:3089074608 ! 51:6 0 0 100 ! X2 17500 10000 utilizando el punto inicial X0 = 46 se obtiene la solución S= 17:6255 3:8341 7:4304 8:4564 ! la cual converge con 21 iteraciones. Ejemplo 4.3. Sea el polinomio 0 1 0 1 0 0 0 1 1 1 0 B C B C B P (X) = X 4 + @ 0 0 0 A X 2 + @ 0 1 1 A X + @ 1 0 0 1 0 1 20 2 1 2 20 0 1 1 C 0 A 20 utilizando el punto inicial X0 = 0 1 38:6488 0 0 B C 0 38:6488 0 @ A 0 0 38:6488 se obtiene la solución 0 2:056 B S1 = @ 0:057 0:088 0:113 2:054 0:003 0 1 0:149 2:170 B C 0:063 A y S2 = @ 0:048 2:062 0:197 1 0:142 C 0:049 A 2:169 0:004 2:170 0:00003 respectivamente, ambos con 16 iteraciones. Usando los puntos iniciales 0 38:6488 0 B X0 = @ 0 38:6488 0 0 1 0 C 0 A 38:6488 0 38:6488 B X0 = @ 0 0 0 38:6488 0 1 0 C 0 A 38:6488 se obtiene la solución 0 0:797 3:736 B S3 = @ 0:067 1:673 1:616 4:674 1 0 2:170 0:545 C B 0:137 A y S4 = @ 0:197 0:390 1:941 respectivamente, ambos con 30 iteraciones. 47 0:065 2:176 0:055 1 2:150 C 0:157 A 0:365 Ejemplo 4.4. Sea el polinomio P (X) = X 2 0 B B 327:35 B B @ 2 1 0 0 1 2 1 0 0 1 2 1 0 0 1 1 1 C C C C A utilizando el punto inicial X0 = 0 B B B B @ 1 108:841 0 0 0 0 108:841 0 0 0 0 108:841 0 0 0 0 108:841 C C C C A se obtiene la solución S1 S2 0 B B = B B @ 0 B B = B B @ 24:5502 7:0714 1:2673 0:6140 7:0714 23:2829 7:6853 1:8813 1:2673 7:6853 22:6689 8:9527 0:6140 1:8813 8:9527 15:5976 24:5502 7:0714 1:267 3 0:6140 7:071 4 23:283 7:685 3 1:881 3 respectivamente ambos con 10 iteraciones 48 1:267 3 7:685 3 22:669 8:952 7 1 C C C y C A 0:6140 1:881 3 8:952 7 15:598 1 C C C C A Capítulo 5 Aplicación 5.1 Grados de Libertad En dinámica estructural [10], el número de coordenadas independientes necesario para especi…car la con…guración o posición de un sistema en cualquier instante de tiempo se conoce como el número de grados de libertad. Toda estructura continua tiene un número in…nito de grados de libertad. En la idealización mediante un modelo matemático el número de grados de libertad es …nito. A continuación mostramos algunas estructuras con diversos grados de libertad Ejemplo 5.1. Estructuras que pueden ser representadas con un grado de libertad Y Estructura con un grado de libertad Ejemplo 5.2. Grá…co que representa a una estructura con dos grados de libertad Y2 Y1 Estructura con dos grados de libertad 49 5.2 Vibración Libre de un Edi…cio Simple Cuando una estructura no está sometida a excitación externa (fuerza o desplazamiento del soporte) y su movimiento esta gobernado solo por las condiciones iniciales, se considera que esta en vibración libre. Existen, ocasionalmente, circunstancias en la que es necesario determinar el movimiento de la estructura en condiciones de vibración libre, pero son casos especiales. No obstante, el análisis de la estructura en movimiento libre proporciona las propiedades dinámicas más importantes de la estructura que son las frecuencias naturales y los correspondientes modos normales 5.2.1 Ecuación de Rigidez para un Edi…cio Simple Un edi…cio simple puede ser de…nido como un edi…cio en el cuál no se producen rotaciones en los mienbros horizontales a la altura de los pisos. Para obtener la deformación horizontal en un edi…cio debemos suponer las siguientes condiciones 1. Toda la masa de la estructura esta concentrada al nivel de los pisos 2. Las viga en los pisos son in…nitamente rigidas, con relación a la rigidez de las columnas 3. La deformación de la estructura es independiente de las fuerzas axiales presentes en las columnas. La primera condición transforma el problema, de un sistema de in…nitos grados de libertad (debido a la masa uniformemente distribuido) a un sistema que tiene solamente tantos grados de libertad como números de masas concentradas a nivel de los pisos La segunda condición introduce el requisito de que las uniones entre las vigas y las columnas estén …jas sin rotación La tercera condición establece que las vigas rígidas en los pisos permanezcan horizontales durante el movimiento de la estructura La …gura representa el modelo de un edi…cio 50 Y3 m3 F3(t) k3 F2(t) Y2 m2 k2 F1(t) Y1 m1 k1 Una alternativa para representar un edi…cio simple es adoptar un modelo de resortes y masas como se muestra en el grá…co (5.1) y1 F 3 (t) y2 F 2 (t) m1 F 2 (t) m2 k2 k1 y3 m3 k3 Grá…co 5.1: Modelo de masas concentradas y resortes para representar un edi…cio F 1 (t) k1y1 y3 y2 y1 F 2 (t) m1y´´ F 3 (t) m2y´´ k 2 (y 2 -y 1 ) m3y´´ k 3 (y 3 -y 2 ) Debe tenerse en cuenta que las representaciones que aparecen en las …guras son equivalentes. En consecuencia, las ecuaciones del movimiento, se pueden obtener de cualquiera de ellos, así tenemos: m1 y•1 + k1 y1 m2 y•2 + k2 (y2 k2 (y2 y1 ) F1 (t) = 0 k3 (y3 y2 ) F2 (t) = 0 m3 y•3 + k3 (y3 y2 ) F3 (t) = 0 y1 ) este sistema de ecuaciones constituye la formulación de rigidez de las ecuaciones del movimiento de un edi…cio simple de tres pisos. Utilizando la forma matricial este sistema puede escribirse como M y• + Ky = F (t) 51 donde M y K son respectivamente las matrices de masas y de rigidez, dadas por 0 1 m1 0 0 B C M = @ 0 m2 0 A 0 0 m3 0 k1 + k2 k2 B K=@ k2 k2 + k3 0 k3 1 0 C k3 A k3 y donde y; y•; F; son, respectivamente, los vectores de desplazamiento, aceleración y fuerzas dadas por 0 1 y1 B C y = @ y2 A ; y3 5.2.2 0 1 y•1 B C y• = @ y•2 A ; y•3 0 1 F1 (t) B C F = @ F2 (t) A F3 (t) Frecuencias Naturales El problema de vibración libre requiere que el vector fuerza [F ] sea igual a cero en cualquiera de las formulaciones de las ecuaciones del movimiento. La ecuación que modela este comportamiento es la siguiente M y• + Ky = F entonces para la ecuación de la rigidez tenemos la ecuación M y• + Ky = 0 Buscamos soluciones reales que representan la parte real de p = qei t donde q es independiente de t. Luego tenemos que p• = q 2 i t e por lo tanto la ecuación queda determinado por Mq 2 i t e + Kqei t = 0 2 + Kq ei t = 0 luego Mq 52 el cuál tiene soloción si y solo si 2 M K q=0 Proposición 5.1. Sea S una solvente de la ecuación polinomial matricial P (X) = M X 2 K entonces el par ( ; q) valor y vector propio de S es solución de la ecuación M 2 K q = 0 Prueba. Tenemos que Sv = v entonces reemplazando M 2 K q = M 2 M 2 K q = M ( q) Kq = M (Sq) Kq M 2 K q = M S ( q) Kq = M S (Sq) Kq M 2 K q = M S 2q q Kq Kq = M S 2 K q como S es solvente de la ecuación polinomial entonces 2 M K q=0 Por tanto proponemos resolver la ecuación polinomica matricial, para encontrar el par ( ; q) que resuelve el problema de la ecuación diferencial Algoritmo 3. Dada la ecuación diferencial M y• + Ky = F (t) Paso 1. Resolver M X 2 K = 0 Paso 2. Calcular Xv = v Paso 3. Hacer y = V u donde V = [v1 ; v2 ; ; vn ] es la matriz de vectores propios de X Paso 4 Resolver D1 u• + D2 u = c donde D1 = V T M V; D2 = V T KV; c = V TF Paso 6. La solución viene dado por y = u1 (t) v1 + u2 (t) v2 + + un (t) vn Los siguientes ejemplos determinan el cálculo de los valores y vectores propios que determinan la solución Ejemplo 5.3 ([10] pag 256). El grá…co (5.2) muestra un edi…cio simple, de iguales propiedades en todos sus pisos. Para esta estructura hallaremos sus frecuencias 53 naturales m Y4 k m Y3 k m Y2 k m Y1 k Grá…co 5.2: Edi…cio simple donde kp:seg 2 cm kp k = 327:25 cm m = 1 y para todos los pisos para esta edi…cio la matriz de masa M y de rígidez K vienen dado por 0 B B M =B B @ 1 0 0 0 0 1 0 0 0 0 1 0 0 0 0 1 1 C C C C A 0 B B K = 327:35 B B @ 2 1 0 0 1 2 1 0 0 1 2 1 0 0 1 1 de acuerdo a la ecuación resolveremos el siguiente problema M X2 K=0 el cual tiene como solución la matriz 0 24:5502 7:0714 1:2673 0:6140 B B 7:0714 23:2829 7:6853 1:8813 X=B B 1:2673 7:6853 22:6689 8:9527 @ 0:6140 1:8813 8:9527 15:5976 54 1 C C C C A 1 C C C C A hallando sus valores y vectores propios tenemos 0 0:2280 0:4285 0:5774 0:6565 0:5774 0:5774 0:0000 0:5774 0:6565 0:2280 0:5774 0:4285 0:4285 B B 0:6565 V = B B 0:5774 @ 0:2280 0 1 6:2836 0 0 0 B C B C 0 18:0928 0 0 B C D = B C 0 0 27:7198 0 @ A 0 0 0 34:0034 donde las frecuencias naturales vienen dado por 1 f= 2 0 B B B B @ 6:2836 18:0928 27:7198 34:0034 1 0 C B C B C=B C B A @ 55 1:0001 2:8796 4:4118 5:4119 1 C C C C A 1 C C C C A Capítulo 6 Conclusiones La principal ventaja de este método es que es de convergencia cuadrática cuando el punto inicial es próximo y la derivada de frechet es no-singular, sin embargo cada iteración es bastante extensa. Uno de los aspectos sensibles del método de Newton es la elección del punto inicial, la aproximación inicial que se utiliza es empírica, se utilizó la regla establecida por [6] la cuál establece iniciar como punto inicial la matriz kI; donde k es de…nida para el caso cuadrático P (X) = AX 2 + BX + C como k= q kBkF + kBk2F + 4 kAkF kCkF 2 kAkF y en el caso general k = maxf1; m X i=1 kAi kF g sin embargo, muchas veces el punto inicial es dado por el investigador. El método propuesto trabaja correctamente cuando la derivada de Frechet es no singular, hay estudios para casos particulares cuando la derivada de frechet es singular, como en el cálculo de las solventes de la ecuación polinomial matricial para una matriz simétrica y centro-simétrica generalizada ver [15] 56 Bibliografía [1] Bernstein, Dennis S.Matrix Mathematics:Theory, Facts, and Formulas (Second Edition) Published by Princeton University Press, 2009. [2] Cheney, Ward. Analysis for Applied Mathematics, Springer 2001 [3] Chun-Hua Guo. On a quadratic matrix equation associated with an M-matrix, IMA Journal of Numerical Analysis (2003) 23 (1): 11-27. [4] Higham, Nicholas. Functions of Matrices, Siam 2008 [5] Horn Roger y Johnson Charles, Matrix Analysis, Cambridge University Press 1990 [6] Kratz y Stickel, Numerical Solution of matrix polynomial equations by Newton’s method, IMA J. Numer. Anal., 7(1987), 355-369 [7] Kurdila Andrew y Zabarankin Michael. Convex Functional Analysis, Birkhäuser Verlag 2005 [8] Latouche and Ramaswami, Introduction to Matrix Analytic Methods in Stochastic Modeling, SIAM, Philadelphia, PA, 1999. [9] Luenberger, David. Optimization by Vector Space Methods, John Wiley, New York, 1969. [10] Paz Mario, Structural Dynamics, Theory and Computation, Van Nostrand Reinhold Company, Second Edition,1985 [11] Seo Jong y Kim Hyun, Solving Matrix Polynomials by Newton’s Method With Exact Line Searches. [12] Spivak Michael, Calculus on Manifolds, Addison-Wesley Publishing Company 1965 [13] Stewart G.W. Matrix Algorithms Vol I, Siam Philadelphia 1998 [14] Stewart G. W. Matrix Algorithms Vol II, Siam Philadelphia 2001 57 [15] Yin Huan Han and Hyun Min Kim, Solving Matrix Polynomikal by Newton’s Method, KSIAM Vol 14 No 12, 113-124, 2010 58