2011. Ciencia contra la crisis

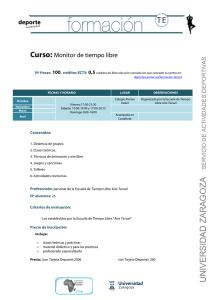

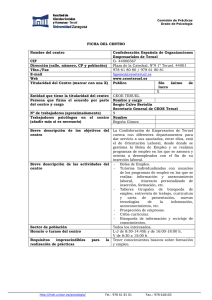

Anuncio