NUESTRO HOGAR EN EL ESPACIO

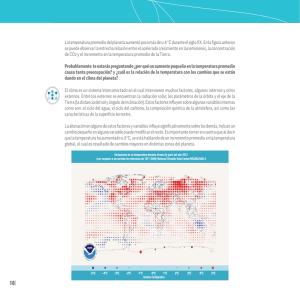

Anuncio