Master`s Thesis - Pàgina inicial de UPCommons

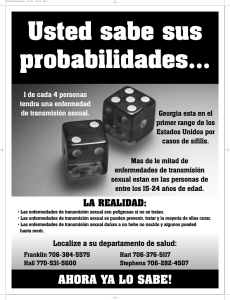

Anuncio